Monitoramento da qualidade de dados em escala com IA agentiva

Criado no Unity Catalog para detectar problemas logo no início e resolvê-los rapidamente

Summary

• A qualidade de dados manual e baseada em regras não escala à medida que os patrimônios de dados crescem para analítica e AI.

• O monitoramento agêntico da qualidade de dados aprende os padrões de dados esperados e detecta problemas em datasets críticos.

• Sinais nativos da plataforma, como a linhagem do Unity Catalog, ajudam as equipes a resolver problemas mais rapidamente em escala empresarial.

O desafio da qualidade de dados em grande escala

À medida que as organizações criam mais produtos de dados e IA, manter a qualidade dos dados se torna mais difícil. Os dados alimentam tudo, desde painéis executivos até bots de Q&A para toda a empresa. Uma tabela desatualizada leva a respostas desatualizadas ou até mesmo incorretas, afetando diretamente os resultados de negócios.

A maioria das abordagens de qualidade de dados não se adapta a essa realidade. As equipes de dados dependem de regras definidas manualmente aplicadas a um pequeno conjunto de tabelas. À medida que os patrimônios de dados crescem, eles criam pontos cegos e limitam a visibilidade da saúde geral.

As equipes adicionam continuamente novas tabelas, cada uma com seus próprios padrões de dados. Manter verificações personalizadas para cada dataset não é sustentável. Na prática, apenas algumas tabelas críticas são monitoradas, enquanto a maior parte do patrimônio de dados permanece sem verificação.

O resultado é que as organizações têm mais dados do que nunca, mas menos confiança para usá-los.

Apresentando o Monitoramento Agêntico da Qualidade de Dados

Hoje, a Databricks anuncia o Public Preview do Monitoramento da Qualidade de Dados no AWS, Azure Databricks e GCP.

O monitoramento da qualidade de dados substitui as verificações manuais e fragmentadas por uma abordagem agêntica desenvolvida para escala. Em vez de limites estáticos, os agentes de IA aprendem padrões de dados normais, se adaptam a mudanças e monitoram o patrimônio de dados continuamente.

A integração profunda com a Databricks Platform vai além da detecção.

- A causa raiz é apontada diretamente nos jobs e pipelines upstream do Lakeflow. As equipes podem ir do monitoramento da qualidade de dados diretamente para o job afetado e aproveitar os recursos de observabilidade integrados do Lakeflow para obter um contexto mais aprofundado sobre as falhas e resolver os problemas mais rapidamente.

- Os problemas são priorizados usando a linhagem do Unity Catalog e tags certificadas, garantindo que os conjuntos de dados de alto impacto sejam abordados primeiro.

Com o monitoramento nativo da plataforma, as equipes detectam problemas mais cedo, se concentram no que é mais importante e resolvem problemas mais rapidamente em escala empresarial.

“Nosso objetivo sempre foi que nossos dados nos avisassem quando houvesse um problema. O monitoramento da Qualidade dos Dados do Databricks finalmente faz isso por meio de sua abordagem orientada por AI. Ele se integra perfeitamente à UI, com o monitoramento de todas as nossas tabelas com uma abordagem automatizada e sem necessidade de configuração, o que sempre foi um fator limitante em outros produtos. Em vez de os usuários relatarem problemas, nossos dados os sinalizam primeiro, melhorando a qualidade, a confiança e a integridade em nossa plataforma.” — Jake Roussis, Engenheiro de dados líder da Alinta Energy

Como o Monitoramento da Qualidade de Dados funciona

O monitoramento da qualidade de dados oferece percepções acionáveis por meio de dois métodos complementares.

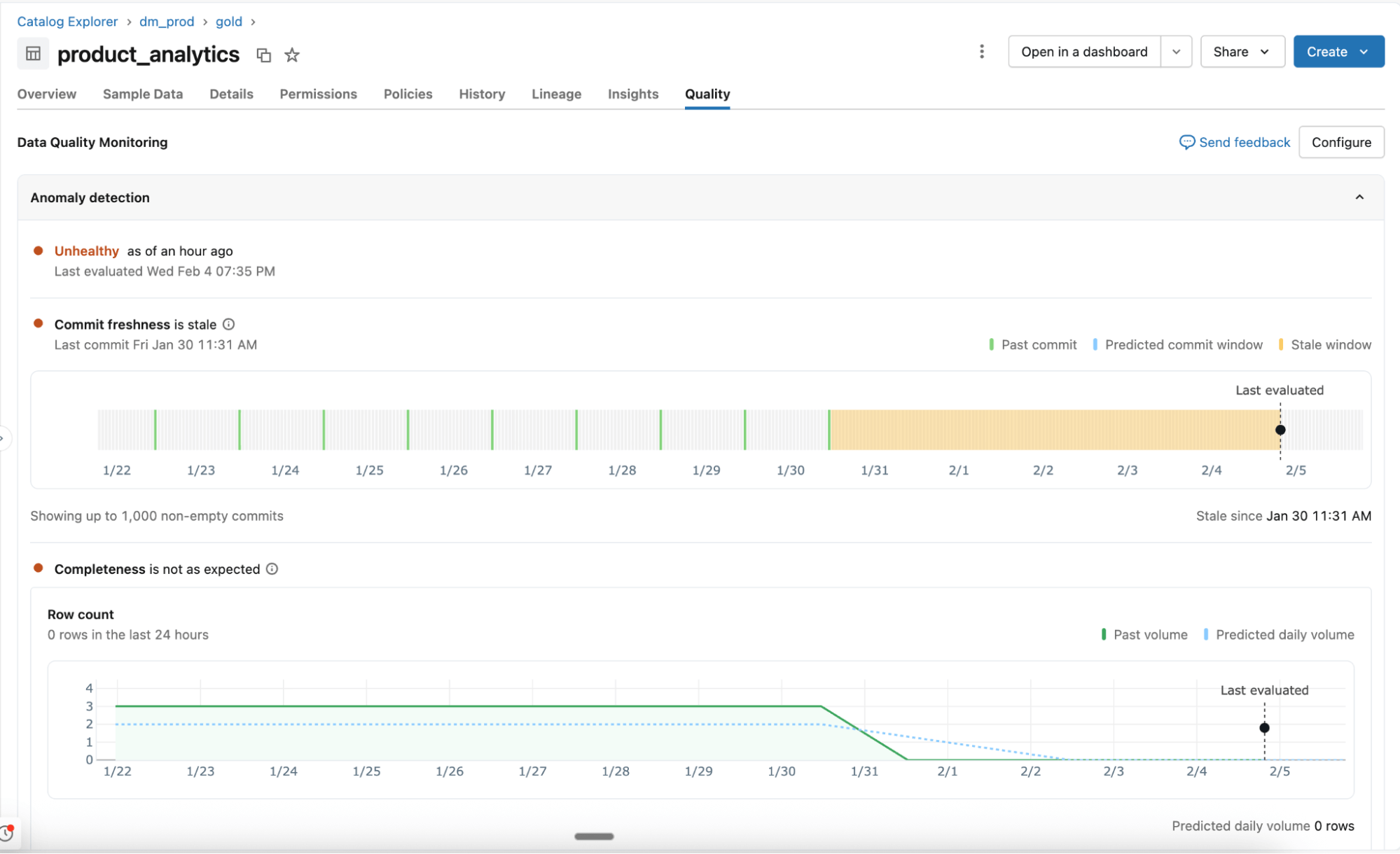

Detecção de anomalia

Habilitada no nível do esquema, a detecção de anomalias monitora todas as tabelas críticas sem configuração manual. Agentes de IA aprendem padrões históricos e comportamento sazonal para identificar mudanças inesperadas.

- Comportamento aprendido, não regras estáticas: Os agentes se adaptam à variação normal e monitoram os principais sinais de qualidade, como atualização e completude. O suporte para verificações adicionais, incluindo percentual de nulos, exclusividade e validade, virá em seguida.

- Escaneamento inteligente para escala: Todas as tabelas em um esquema são escaneadas uma vez e depois revisitadas com base na importância da tabela e na frequência de atualização. A linhagem e a certificação do Unity Catalog determinam quais tabelas são mais importantes. As tabelas usadas com frequência são escaneadas com mais frequência, enquanto as tabelas estáticas ou obsoletas são ignoradas automaticamente.

- Tabelas do sistema para visibilidade e relatórios: A integridade da tabela, os limiares aprendidos e os padrões observados são registrados em tabelas do sistema. As equipes usam esses dados para alertas, relatórios e análises mais aprofundadas.

Perfilamento de dados

Habilitado no nível da tabela, o perfil de dados captura estatísticas de resumo e rastreia suas alterações ao longo do tempo. Essas métricas fornecem contexto histórico e serão fornecidas à detecção de anomalias para que você possa identificar problemas facilmente.

“Na OnePay, nossa missão é ajudar as pessoas a alcançar o progresso financeiro, capacitando-as a economizar, gastar, tomar empréstimos e fazer seu dinheiro render. Dados de alta qualidade em todos os nossos datasets são essenciais para cumprir essa missão. Com o Monitoramento da Qualidade de Dados, podemos detectar problemas com antecedência e tomar medidas rápidas. Conseguimos garantir a precisão em nossa analítica, relatórios e no desenvolvimento de modelos de ML robustos, o que contribui para atendermos melhor nossos clientes.” — Nameet Pai, Head de Engenharia de Plataforma e Dados da OnePay

Gartner®: Databricks, líder em banco de dados em nuvem

Garanta a qualidade de um patrimônio de dados em constante crescimento

Com o monitoramento de qualidade automatizado implementado, as equipes da plataforma de dados podem acompanhar a saúde geral de seus dados e garantir a resolução oportuna de quaisquer problemas.

Monitoramento agêntico com um clique: Monitore esquemas inteiros sem a necessidade de criar regras manuais e configurar limites. O monitoramento da qualidade de dados aprende padrões históricos e comportamentos sazonais (por exemplo, quedas de volume nos fins de semana, período de imposto de renda etc.) para detectar anomalias de forma inteligente em todas as suas tabelas.

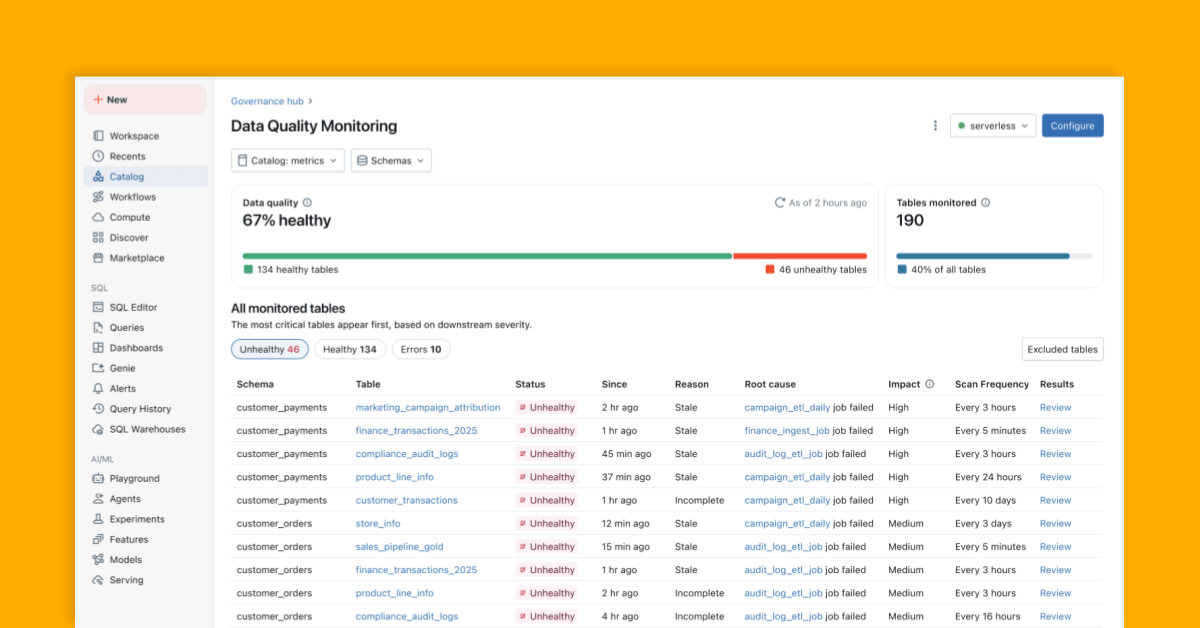

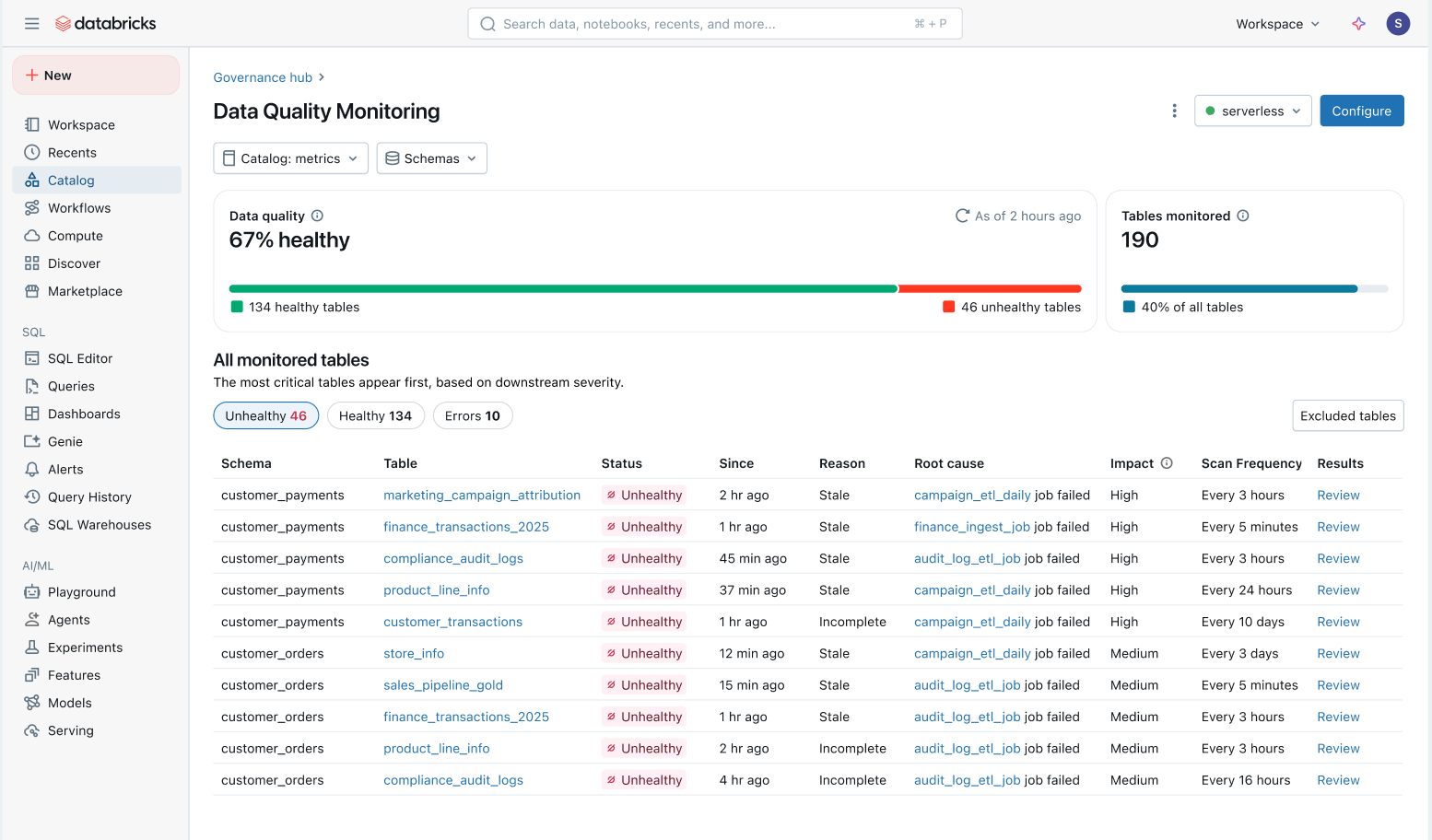

Visão holística da integridade dos dados: Acompanhe facilmente a integridade de todas as tabelas em uma visão consolidada e garanta que os problemas sejam corrigidos.

- Problemas priorizados por impacto downstream: Todas as tabelas são priorizadas com base em sua linhagem downstream e volume de query. Problemas de qualidade em suas tabelas mais importantes são sinalizados primeiro.

- Tempo de resolução mais rápido: No Unity Catalog, o monitoramento da qualidade de dados rastreia problemas diretamente até os Lakeflow Jobs e Spark Declarative Pipelines upstream. As equipes podem ir do catálogo para o job afetado para investigar falhas específicas, alterações de código e outras causas raiz.

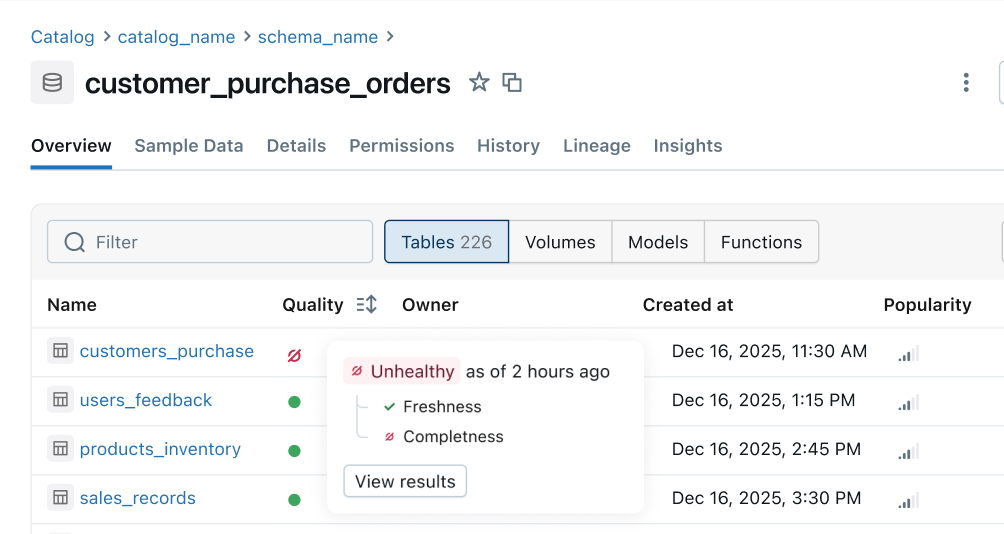

Indicador de integridade: Sinais de qualidade consistentes são populados de pipelines de upstream para superfícies de negócios de downstream. As equipes de engenharia de dados são notificadas primeiro sobre os problemas, e os consumidores podem saber instantaneamente se os dados são seguros para uso.

O que vem a seguir

Veja o que está em nosso roteiro para os próximos meses:

- Mais regras de qualidade: Suporte para mais verificações, como porcentagem de nulos, exclusividade e validade.

- Alertas automatizados e análise de causa raiz: Receba alertas automaticamente e resolva problemas rapidamente com indicadores inteligentes de causa raiz integrados diretamente em seus jobs e pipelines.

- Indicador de integridade em toda a plataforma: veja sinais de integridade consistentes no Unity Catalog, Lakeflow Observability, Lineage, Notebooks, Genie etc.

- Filtre e coloque dados incorretos em quarentena: Identifique proativamente dados incorretos e impeça que cheguem aos consumidores.

Primeiros passos: Public Preview

Experimente o monitoramento inteligente em grande escala e crie uma plataforma de dados self-service confiável. Experimente o Public Preview hoje mesmo:

- Habilite o monitoramento da Qualidade de Dados na tab Detalhes do Esquema no Unity Catalog

- Obtenha uma visão holística de todas as tabelas monitoradas diretamente no produto.

- Configure alertas com este padrão

(Esta publicação no blog foi traduzida utilizando ferramentas baseadas em inteligência artificial) Publicação original

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura