Integração de dados do SAP e Salesforce para analítica de fornecedores no Databricks

Use o SAP Business Data Cloud Connect e o Lakeflow Connect para unificar dados de CRM e ERP para analítica de fornecedores.

Summary

- Conecte os dados do SAP S/4HANA e do Salesforce diretamente no Databricks

- Use o Lakeflow Connect e o SAP BDC para acesso incremental e sem cópia

- Crie uma camada ouro governada para analítica e percepções conversacionais

Como criar analítica de fornecedores com a integração Salesforce SAP no Databricks

Os dados de fornecedores afetam quase todas as partes de uma organização — desde compras e gestão da cadeia de suprimentos até finanças e analítica. No entanto, eles geralmente estão espalhados por sistemas que não se comunicam entre si. Por exemplo, o Salesforce contém perfis de fornecedores, contatos e detalhes de contas, e o SAP S/4HANA gerencia faturas, pagamentos e lançamentos contábeis. Como esses sistemas operam de forma independente, as equipes não têm uma visão abrangente dos relacionamentos com os fornecedores. O resultado é uma reconciliação lenta, registros duplicados e oportunidades perdidas para otimizar os gastos.

A Databricks resolve isso conectando ambos os sistemas em uma única plataforma de dados & IA governada. Usando o Lakeflow Connect for Salesforce para ingestão de dados e o SAP Business Data Cloud (BDC) Connect, as equipes podem unificar dados de CRM e ERP sem duplicação. O resultado é uma visão única e confiável de fornecedores, pagamentos e métricas de desempenho que oferece suporte a casos de uso de compras e finanças, bem como à analítica.

Neste tutorial, você aprenderá a conectar as duas fontes de dados, construir um pipeline combinado e criar uma camada ouro que alimenta analítica e entendimentos conversacionais por meio de Dashboards de AI/BI e do Genie.

Por que a integração de dados Zero-Copy entre SAP e Salesforce funciona

A maioria das empresas tenta conectar o SAP e o Salesforce por meio de ETL tradicional ou de ferramentas de terceiros. Esses métodos criam várias cópias de dados, introduzem latência e dificultam a governança. O Databricks adota uma abordagem diferente.

Acesso SAP sem cópia: O SAP BDC Connector for Databricks oferece a você acesso governado e em tempo real aos produtos de dados do SAP S/4HANA por meio do Delta Sharing. Sem exportações ou duplicação.

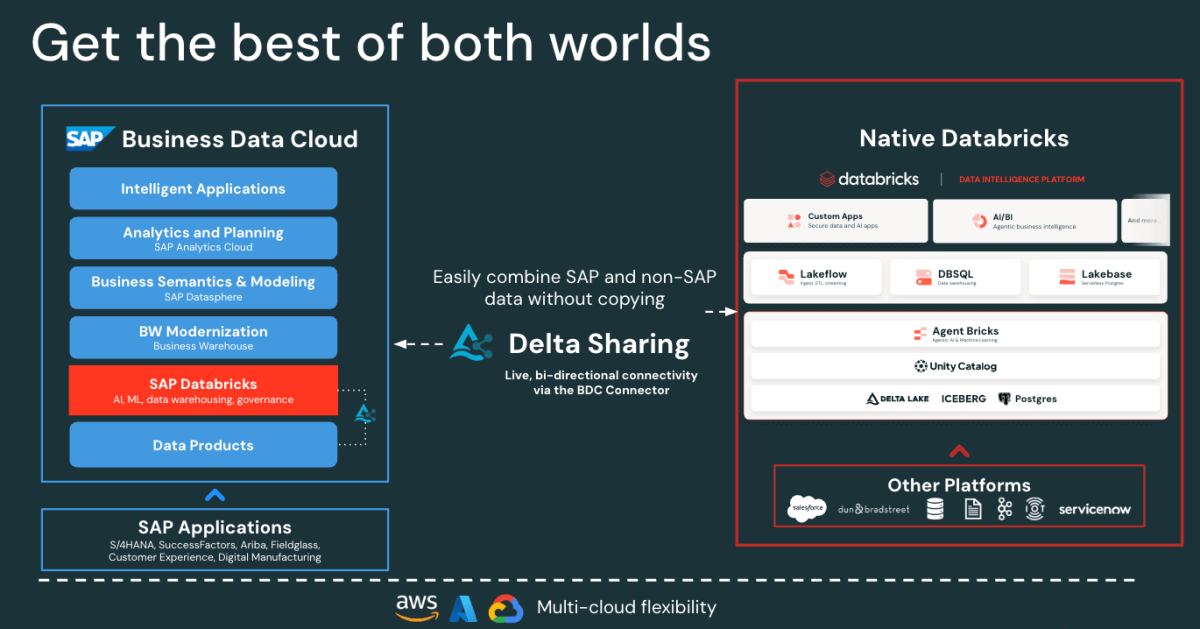

Figure: SAP BDC Connector to Native Databricks(Bi-directional) - Ingestão incremental rápida do Salesforce: o Lakeflow se conecta e ingere dados do Salesforce continuamente, mantendo seus conjuntos de dados atualizados e consistentes.

- Governança unificada: O Unity Catalog impõe permissões, linhagem e auditoria nas fontes de dados SAP e Salesforce.

- Pipelines declarativos: o Lakeflow Spark Declarative Pipelines simplifica o design e a orquestração de ETL com otimizações automáticas para um melhor desempenho.

Juntas, essas funcionalidades permitem que os engenheiros de dados combinem dados do SAP e do Salesforce em uma única plataforma, reduzindo a complexidade e mantendo a governança de nível empresarial.

Gartner®: Databricks, líder em banco de dados em nuvem

Arquitetura de integração de dados SAP e Salesforce na Databricks

Antes de criar o pipeline, é útil entender como esses componentes se encaixam na Databricks.

Em linhas gerais, o SAP S/4HANA publica dados de negócios como produtos de dados selecionados, prontos para uso e gerenciados pela SAP no SAP Business Data Cloud (BDC). O SAP BDC Connect for Databricks permite acesso seguro e sem cópia a esses produtos de dados usando o Delta Sharing. Enquanto isso, o Lakeflow Connect gerencia a ingestão do Salesforce, capturando dados de contas, contatos e oportunidades por meio de pipelines incrementais.

Todos os dados recebidos, sejam do SAP ou do Salesforce, são governados no Unity Catalog para governança, linhagem e permissões. Os engenheiros de dados então usam Lakeflow Declarative Pipelines para unir e transformar esses conjuntos de dados em uma arquitetura medalhão (camadas bronze, silver e ouro). Por fim, a camada de ouro serve como base para analítica e exploração nos Dashboards de AI/BI e no Genie.

Essa arquitetura garante que os dados de ambos os sistemas permaneçam sincronizados, governados e prontos para analítica e IA, sem a sobrecarga de replicação ou de ferramentas de ETL externas.

Como construir uma analítica unificada de fornecedores

Os passos a seguir descrevem como conectar, combinar e analisar dados do SAP e do Salesforce no Databricks.

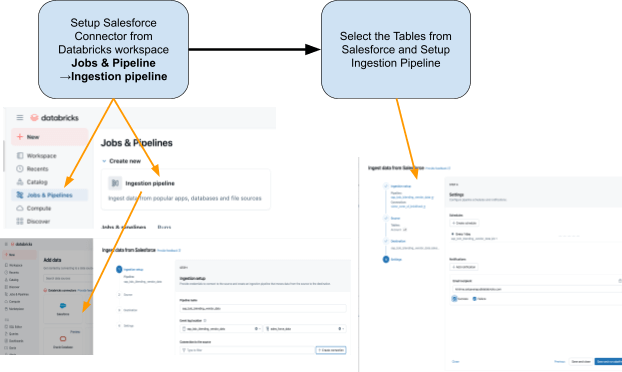

Etapa 1: Ingestão de dados do Salesforce com o Lakeflow Connect

Use o Lakeflow Connect para trazer os dados do Salesforce para a Databricks. Você pode configurar pipelines pela UI ou API. Esses pipelines gerenciam atualizações incrementais automaticamente, garantindo que os dados permaneçam atualizados sem a necessidade de refreshes manuais.

O conector é totalmente integrado com a governança do Unity Catalog, os Lakeflow Spark Declarative Pipelines para ETL e os Lakeflow Jobs para orquestração.

Estas são as tabelas que planejamos ingerir do Salesforce:

- account: detalhes do fornecedor (os campos incluem: AccountId, Name, Industry, Type, BillingAddress)

- Contato: Contatos do fornecedor (os campos incluem: ContactId, AccountId, FirstName, LastName, Email)

Etapa 2: Acessar os dados do SAP S/4HANA com o Conector SAP BDC

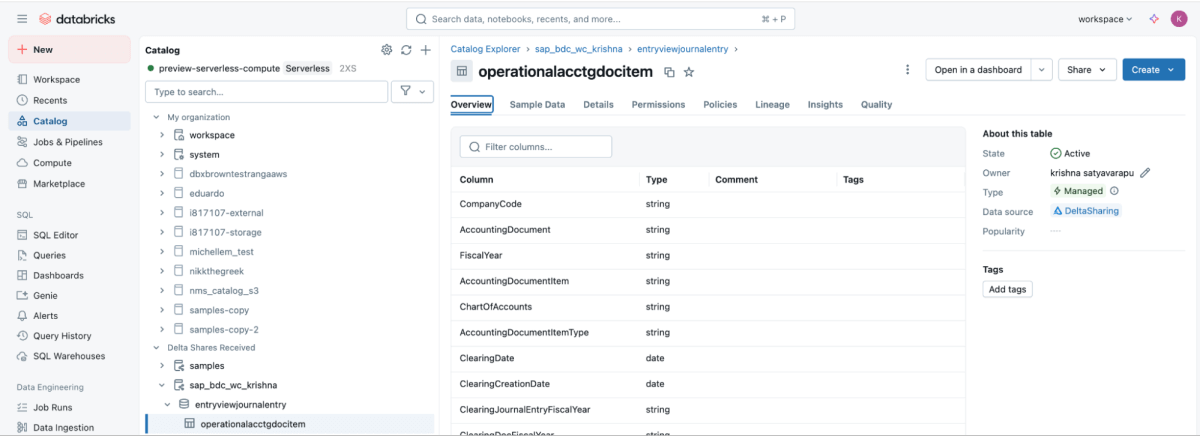

O SAP BDC Connect fornece acesso em tempo real e governado aos dados de pagamento de fornecedores do SAP S/4HANA diretamente na Databricks, eliminando o ETL tradicional ao aproveitar o produto de dados do SAP BDC sap_bdc_working_capital.entryviewjournalentry.operationalacctgdocitem, a view de item de linha do Universal Journal.

Este produto de dados BDC mapeia diretamente para a view CDS do SAP S/4HANA I_JournalEntryItem (Item do documento contábil operacional) em ACDOCA.

Para o contexto do ECC, as estruturas físicas mais próximas eram BSEG (itens de linha de FI) com cabeçalhos em BKPF, lançamentos de CO em COEP, e índices abertos/compensados BSIK/BSAK (fornecedores) e BSID/BSAD (clientes). No SAP S/4HANA, esses objetos BS** fazem parte do modelo de dados simplificado, onde os itens de linha de fornecedor e de contas de G/L são centralizados no Universal Journal (ACDOCA), substituindo a abordagem do ECC, que geralmente exigia a junção de várias tabelas financeiras separadas.

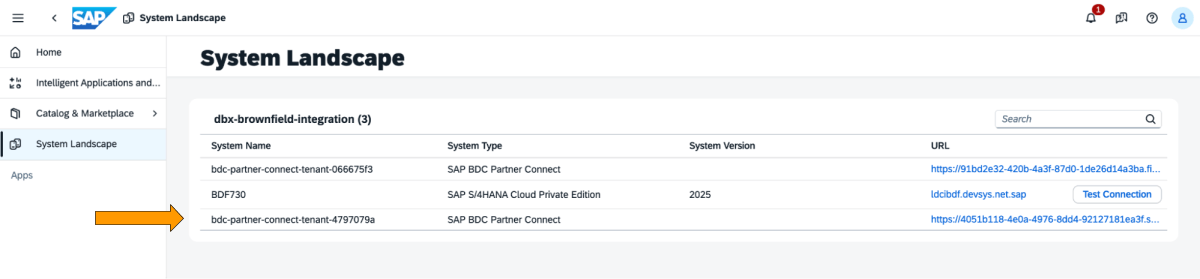

Estes são os passos que precisam ser executados no cockpit do SAP BDC.

1: Faça login no cockpit do SAP BDC e verifique a formação do SAP BDC no System Landscape. Conecte-se ao Native Databricks por meio do conector delta compartilhamento do SAP BDC. Para obter mais informações sobre como conectar o Native Databricks ao SAP BDC para que ele se torne parte de sua formação.

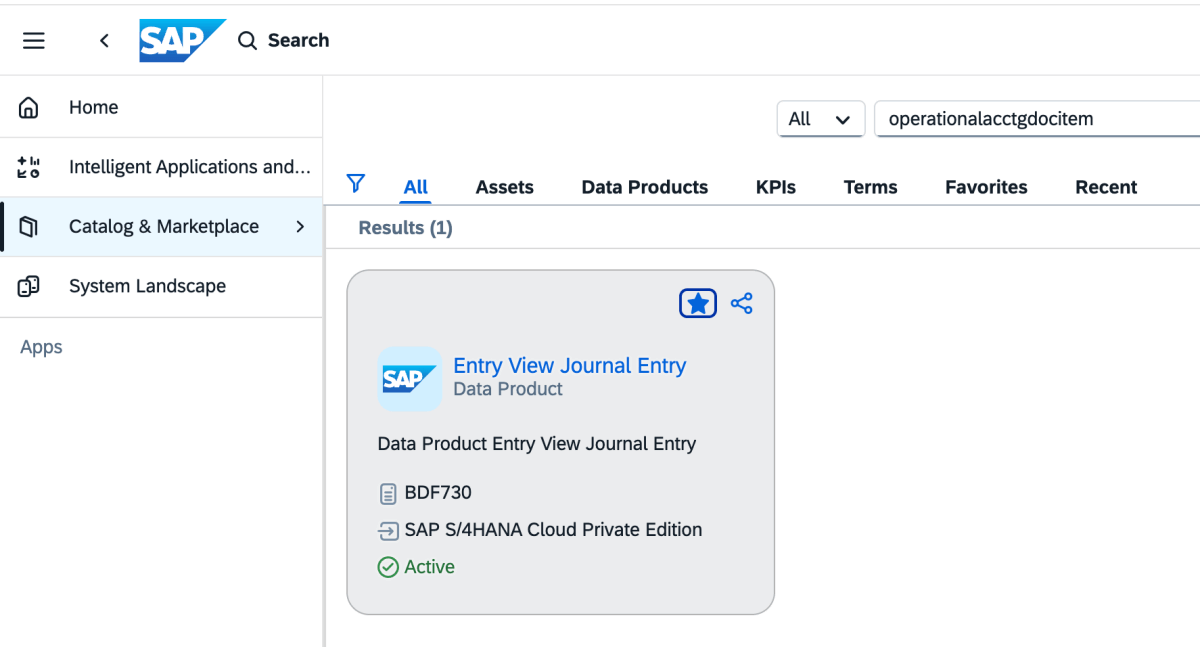

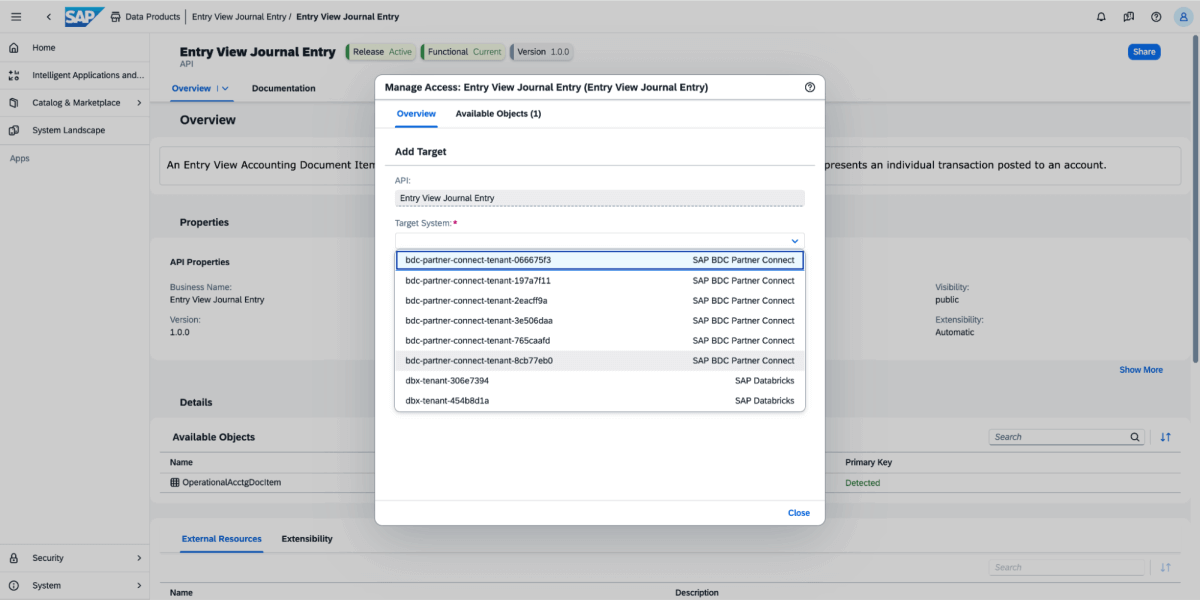

2: Vá para o Catálogo e procure por Data produto Entry View Journal Entry, conforme mostrado abaixo

3: No produto de dados, selecione Compartilhar e, em seguida, selecione o sistema de destino, conforme mostrado na imagem abaixo.

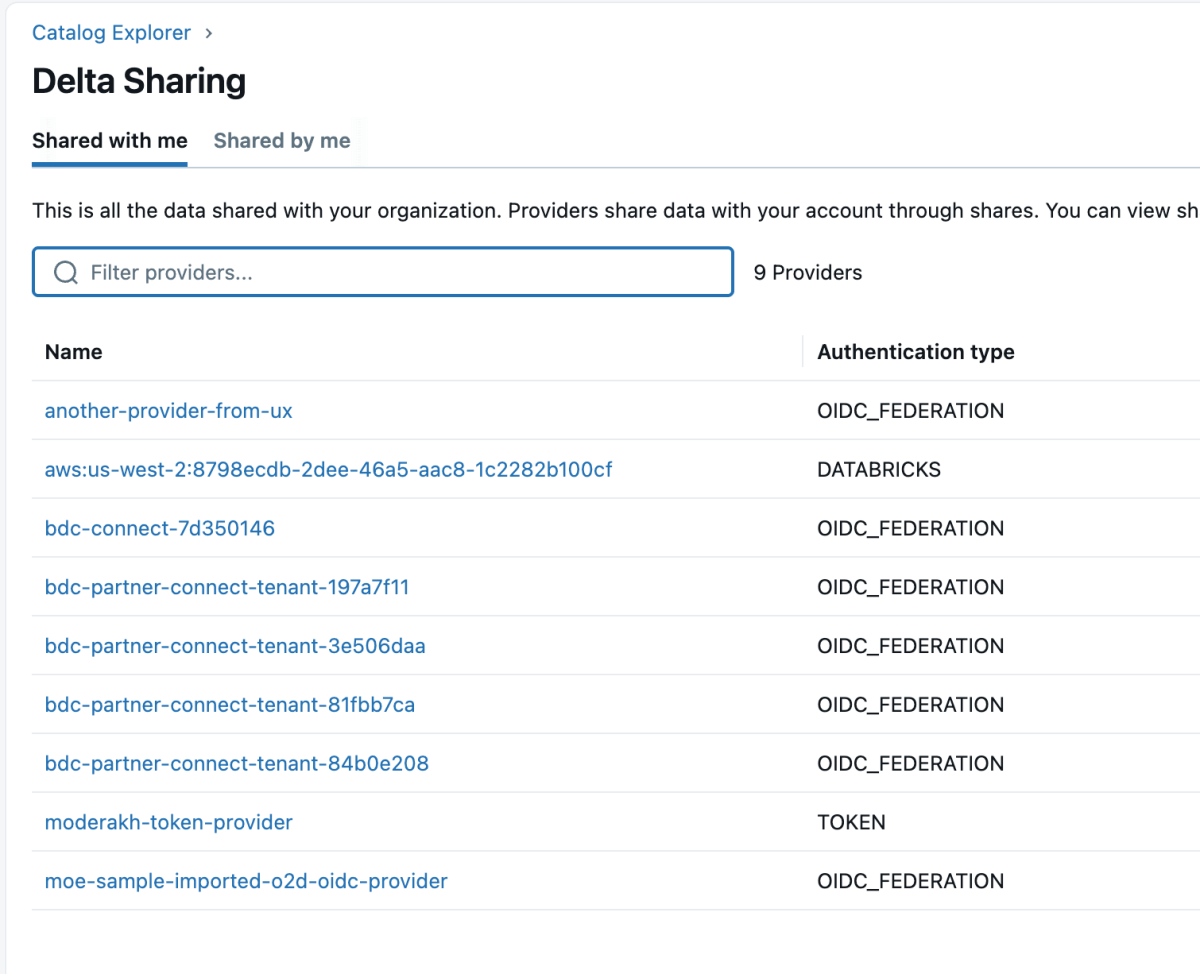

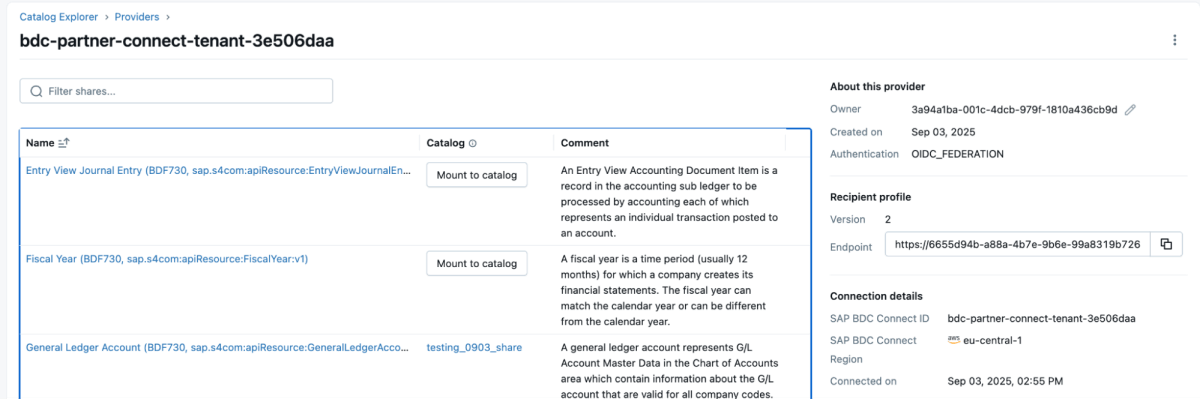

4: Depois que o produto de dados for compartilhado, ele aparecerá como um compartilhamento delta no workspace da Databricks, conforme mostrado abaixo. Certifique-se de que você tenha acesso para “Usar provedor” para poder ver esses provedores.

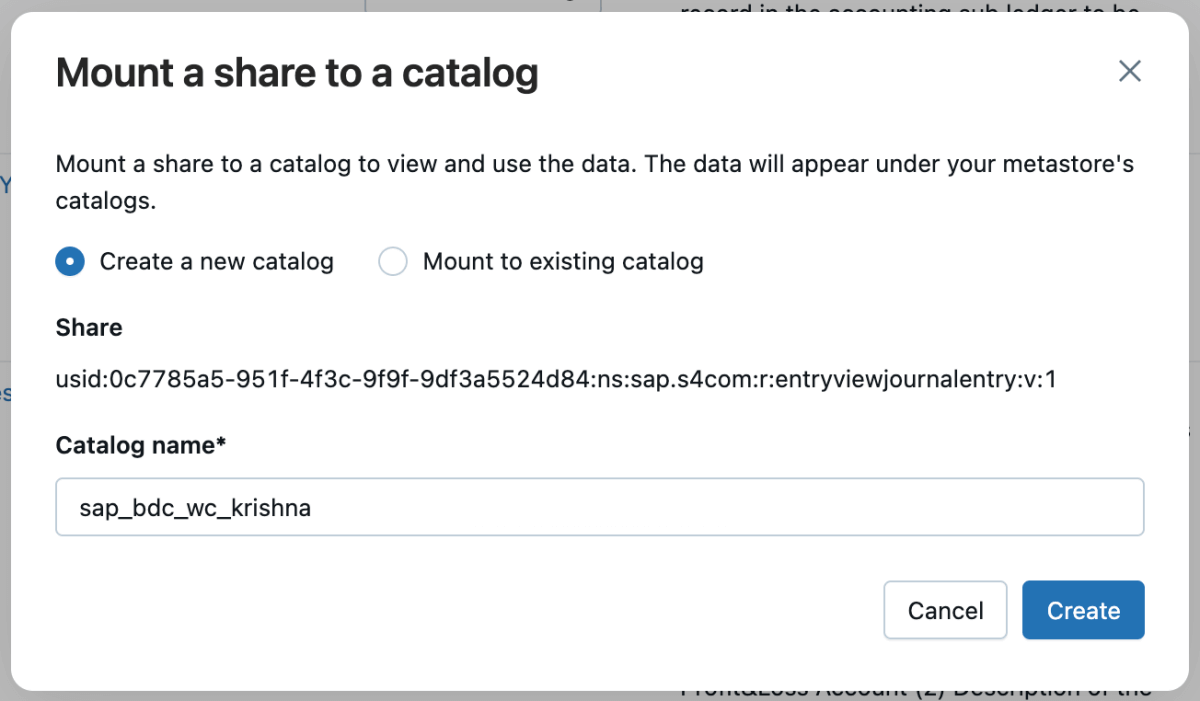

5: Em seguida, você pode montar esse compartilhamento no catálogo e criar um novo catálogo ou montá-lo em um catálogo existente.

6: Assim que o compartilhamento for montado, ele será refletido no catálogo.

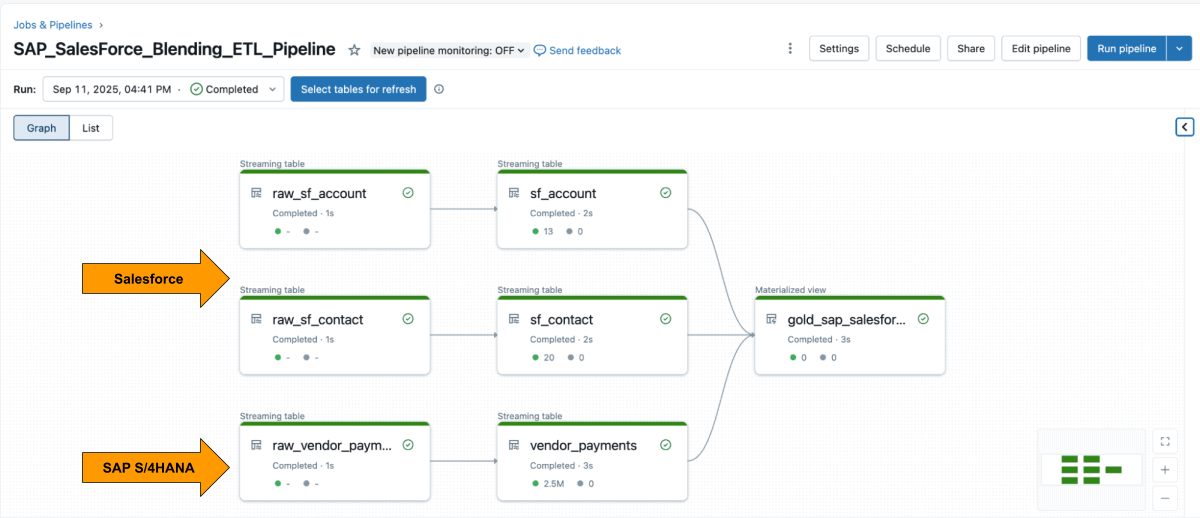

o passo 3: Combinando o pipeline de ETL no Databricks usando Lakeflow Declarative Pipelines

Com ambas as fontes disponíveis, use o Lakeflow Declarative Pipelines para criar um pipeline de ETL com dados do Salesforce e da SAP.

A tabela Account do Salesforce geralmente inclui o campo SAP_ExternalVendorId__c, que corresponde ao ID do fornecedor no SAP. Isso se torna a chave de junção principal para sua camada silver.

Os Lakeflow Spark Declarative Pipelines permitem que você defina a lógica de transformação em SQL, enquanto o Databricks lida com a otimização automaticamente e orquestra os pipelines.

Exemplo: Crie tabelas selecionadas de nível de negócios

Esta query cria uma view materializada selecionada de nível de negócios que unifica os registros de pagamento de fornecedores do SAP com os detalhes de fornecedores do Salesforce, pronta para analítica e relatórios.

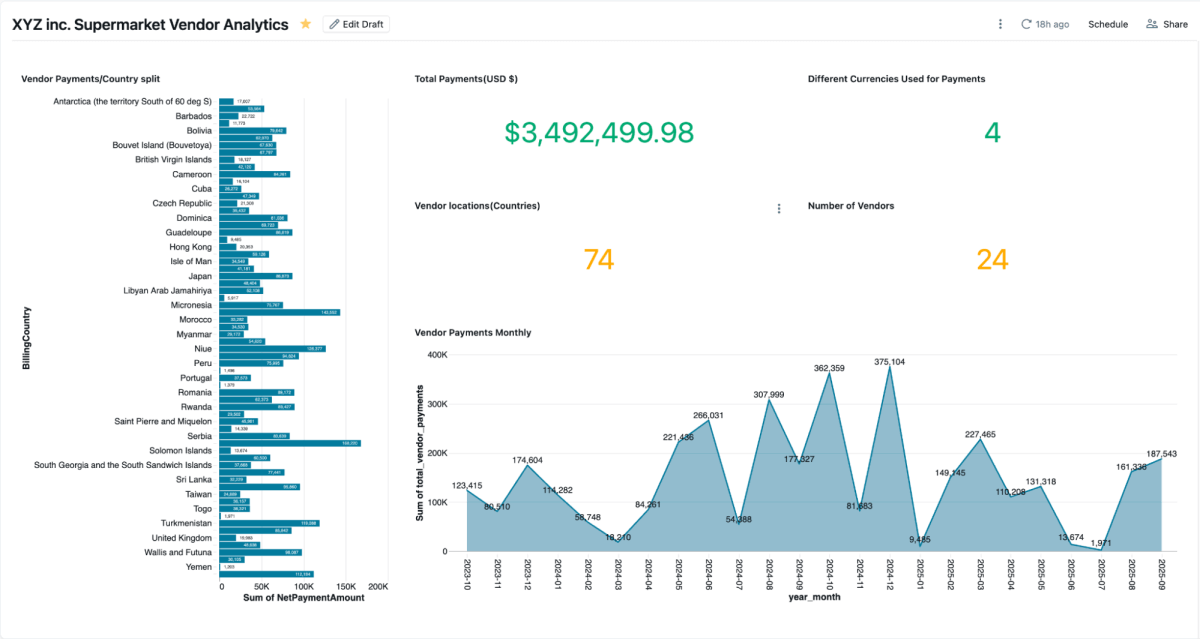

O passo 4: analisar com dashboards de IA/BI e o Genie

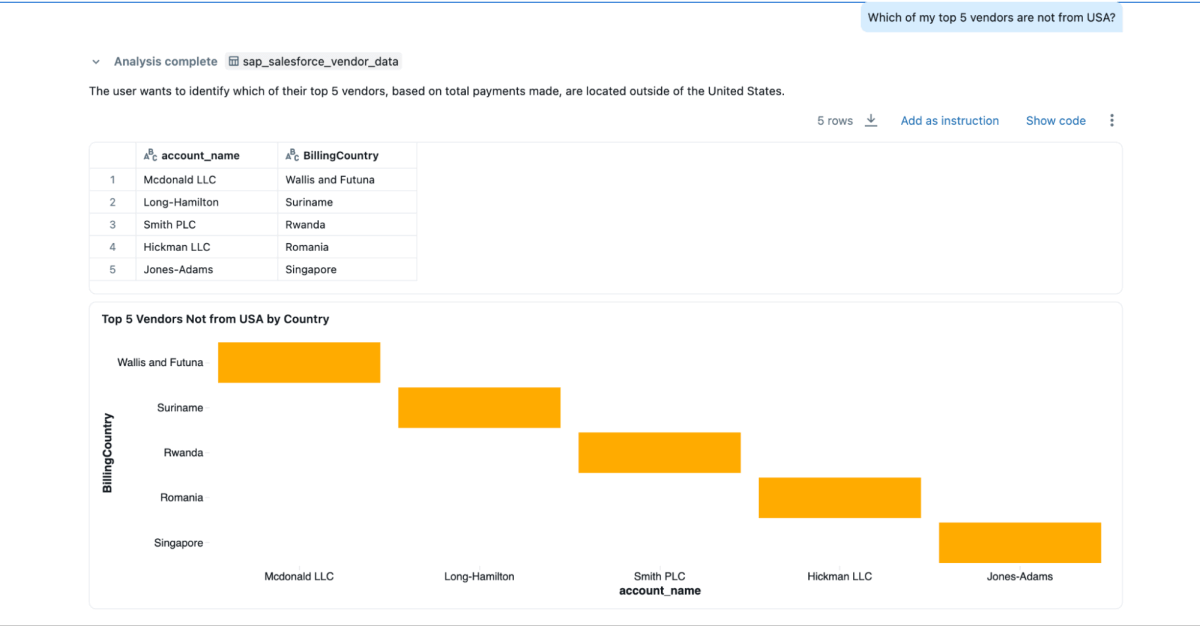

Depois que a visualização materializada for criada, você pode explorá-la diretamente nos AI/BI Dashboards, que permitem às equipes visualizar pagamentos de fornecedores, saldos pendentes e gastos por região. Eles oferecem suporte a filtragem dinâmica, pesquisa e colaboração, tudo governado pelo Unity Catalog. O Genie permite explorar os mesmos dados em linguagem natural.

Você pode criar espaços Genie com esses dados combinados e fazer perguntas, o que não poderia ser feito se os dados estivessem isolados no Salesforce e no SAP.

- “Quais são os meus 3 principais fornecedores para os quais eu mais pago e também quero as informações de contato deles?”

- “Quais são os endereços de faturamento dos 3 principais fornecedores?”

- “Quais dos meus 5 principais fornecedores não são dos EUA?”

Resultados de negócios

Ao combinar dados do SAP e do Salesforce no Databricks, as organizações obtêm uma visão completa e confiável do desempenho, dos pagamentos e dos relacionamentos com os fornecedores. Essa abordagem unificada oferece benefícios operacionais e estratégicos:

- Resolução de disputas mais rápida: as equipes podem visualizar detalhes de pagamento e informações de contato do fornecedor lado a lado, facilitando a investigação e a rápida resolução de problemas.

- Economia por pagamento antecipado: com prazos de pagamento, datas de compensação e valores líquidos em um só lugar, as equipes financeiras podem identificar facilmente oportunidades de descontos por pagamento antecipado.

- Dados mestres de fornecedores mais limpos: A junção no campo

SAP_ExternalVendorId__cajuda a identificar e resolver registros de fornecedores duplicados ou incompatíveis, mantendo assim dados de fornecedores precisos e consistentes entre os sistemas. - Governança pronta para auditoria: o Unity Catalog garante que todos os dados sejam governados com linhagem, permissões e auditoria consistentes, para que a analítica, modelos de IA e relatórios se baseiem na mesma fonte confiável.

Juntos, esses resultados ajudam as organizações a otimizar o gerenciamento de fornecedores e a melhorar a eficiência financeira, enquanto mantêm a governança e a segurança necessárias para sistemas empresariais.

Conclusão

Unificar os dados de fornecedores entre o SAP e o Salesforce não precisa significar reconstruir pipelines ou gerenciar sistemas duplicados.

Com o Databricks, as equipes podem trabalhar a partir de uma base única e governada que integra perfeitamente dados de ERP e CRM em tempo real. A combinação de acesso zero-copy ao SAP BDC, ingestão incremental do Salesforce, governança unificada e pipelines declarativos substitui a sobrecarga da integração por insights.

O resultado vai além de relatórios mais rápidos. Ele oferece uma connected view do desempenho do fornecedor que melhora as decisões de compra, fortalece o relacionamento com os fornecedores e gera economias mensuráveis. E como foi desenvolvido na Databricks Data Intelligence Platform, os mesmos dados do SAP que alimentam pagamentos e faturas também podem impulsionar dashboards, modelos de AI e analítica conversacional — tudo a partir de uma única fonte confiável.

Os dados do SAP são frequentemente a espinha dorsal das operações empresariais. Ao integrar o SAP Business Data Cloud, o Delta Sharing e o Unity Catalog, as organizações podem estender essa arquitetura para além da analítica de fornecedores, abrangendo a otimização do capital de giro, o gerenciamento de estoque e a previsão de demanda.

Essa abordagem transforma os dados do SAP de um sistema de registro em um sistema de inteligência, onde cada dataset está ativo, é governado e está pronto para uso em toda a empresa.

(Esta publicação no blog foi traduzida utilizando ferramentas baseadas em inteligência artificial) Publicação original