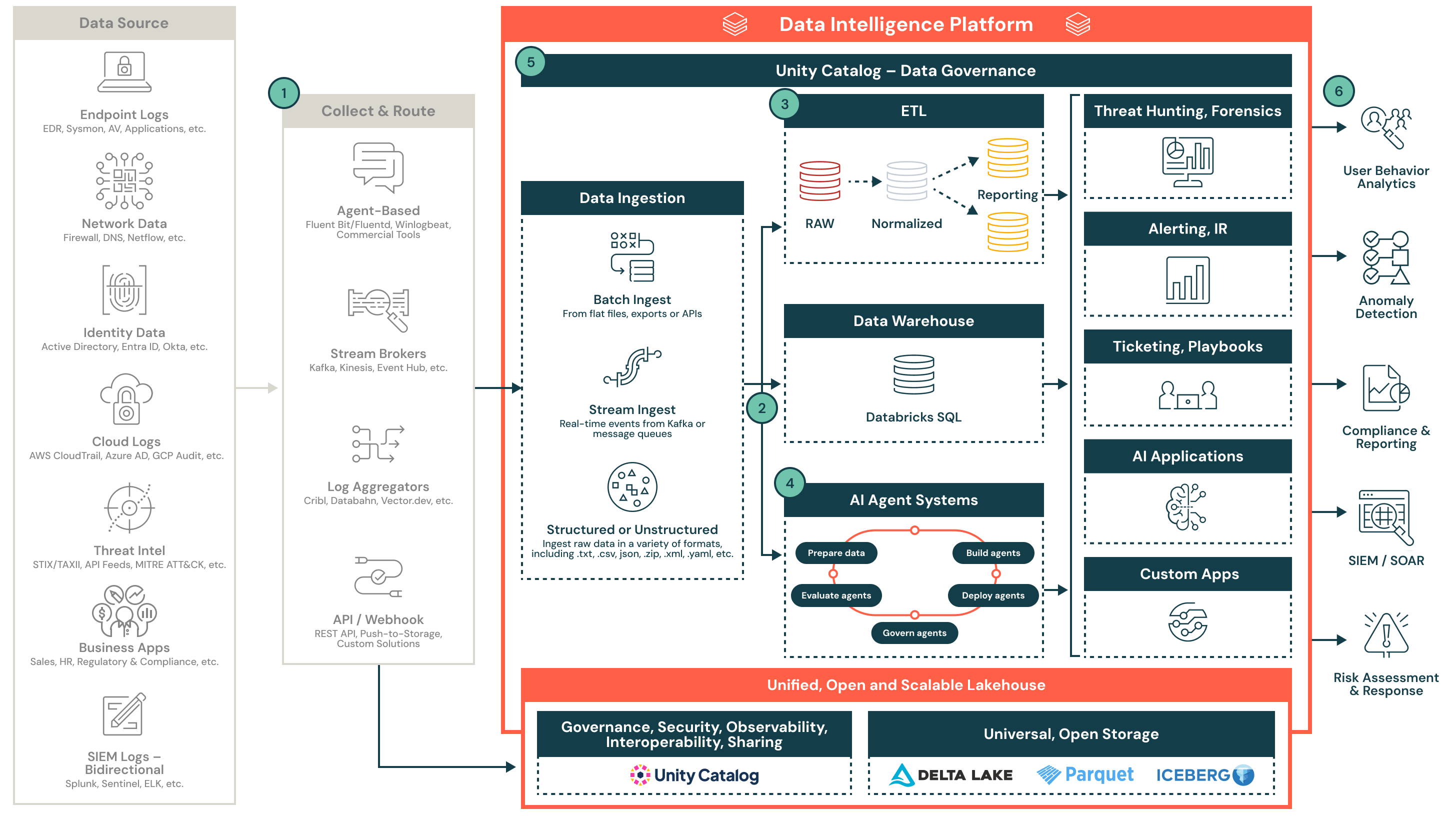

Arquitetura de Referência para um Lakehouse de Segurança

Esta arquitetura demonstra como centralizar dados de segurança e operacionalizar detecção, resposta e relatórios com o ecossistema Databricks lakehouse.

Operacionalizando telemetria de segurança em escala com o Databricks lakehouse

Esta arquitetura de referência demonstra como as equipes de segurança podem coletar, normalizar e operacionalizar telemetria diversa em grande escala usando o lakehouse Databricks. Ele suporta análises em tempo real, engenharia de detecção, relatórios de conformidade e integração com ferramentas SOC downstream.

Visão geral da arquitetura

A telemetria de segurança é complexa, de alto volume e origina-se de muitos sistemas. Arquiteturas legadas muitas vezes lutam com custo, retenção e correlação entre fontes. O lakehouse de segurança da Databricks ajuda as equipes de segurança a centralizar e operacionalizar esses dados usando formatos abertos, pipelines governados e um motor de cálculo flexível.

Esta arquitetura delineia um design modular e nativo da nuvem para ingestão de dados de segurança estruturados e não estruturados de endpoints, sistemas de identidade, provedores de nuvem, feeds de ameaças, SIEMs e aplicações de negócios. Uma vez ingeridos e normalizados, esses dados alimentam casos de uso downstream, incluindo detecção de ameaças, triagem, investigação impulsionada por IA e relatórios.

1. Coletar e rotear

Os dados de segurança são coletados de várias fontes, incluindo endpoints, plataformas em nuvem, sistemas de identidade e feeds de ameaças. Os dados são roteados através de coletores baseados em agentes, corretores de stream, agregadores de log ou APIs diretas. Essas ferramentas suportam formatos estruturados e não estruturados e podem operar em tempo real ou em lote.

Alguns exemplos incluem:

- Fluentd, Vector ou remetentes de log comerciais

- Kafka, Event Hub ou Kinesis

- Cribl, Databahn ou pipelines baseados em webhook

2. Ingerir e aterrissar

Os dados entram no lakehouse via ingestão em lote estruturada ou streaming em tempo real. Os dados ingeridos são escritos em tabelas Delta Lake Bronze para preservar a fidelidade e rastreabilidade. O Catálogo Unity garante que os dados sejam governados e descobertos desde o início do pipeline.

Principais características incluem:

- Suporte para arquivos planos, JSON, CSV e formatos aninhados

- Ingestão de stream do Kafka ou outros corretores

- Governança e descobrimento através do Catálogo Unity

3. Normalize e transforme

Os dados brutos são analisados, achatados e enriquecidos em formatos estruturados para análise e detecção. Esta etapa utiliza a arquitetura de medalhão (Bronze, Prata, Ouro) para criar tabelas reutilizáveis e consultáveis que alimentam a engenharia de detecção e a geração de relatórios.

Tarefas de normalização incluem:

- Alinhamento de esquema (por exemplo, OCSF ou modelos personalizados)

- Enriquecimento com metadados ou inteligência de ameaças

- Deduplicação, análise e alinhamento de timestamp

4. Habilitar IA e análises avançadas

Os feeds de dados normalizados alimentam os frameworks de agentes de IA nativos do Databricks que suportam casos de uso de segurança. Esses agentes podem detectar anomalias, triar alertas e automatizar fluxos de trabalho de investigação. A plataforma suporta o gerenciamento do ciclo de vida do agente, do desenvolvimento à produção.

As capacidades incluem:

- Preparando dados para treinamento e inferência

- Implantação e gerenciamento de agentes de detecção

- Pontuação e avaliação do desempenho do modelo em produção

5. Operações de segurança de energia

O lakehouse permite funções SOC centrais como caça a ameaças, alertas, resposta a incidentes e automação. Saídas estruturadas alimentam painéis, tickets, fluxos de trabalho SOAR e sistemas downstream.

Os resultados incluem:

- Investigações mais rápidas e redução da fadiga de alerta

- Visão unificada da telemetria através de fontes

- Colaboração aprimorada através de notebooks e SQL

6. Entregar resultados de segurança

Insights curados fluem para ferramentas e equipes que precisam deles. Os produtos de dados suportam conformidade, relatórios, análise de comportamento do usuário, detecção de anomalias e pontuação de risco. O SIEM torna-se um consumidor downstream de alertas refinados e contexto.

Exemplos de consumo downstream:

- Painéis de relatórios de conformidade

- Pipelines de detecção de UEBA e anomalias

- Enriquecimento do SIEM e playbooks SOAR