Chegou a hora de reavaliar sua relação com o Hadoop

Com as empresas forçadas a se adaptar a uma força de trabalho remota e distribuída no último ano, a adoção da nuvem acelerou a um ritmo sem precedentes em +14%, resultando em 2% ou US$ 13 bilhões acima das previsões pré-pandemia para 2020, com possivelmente mais de US$ 600 bilhões em migrações on-premise para a nuvem nos próximos anos. Essa mudança para a cloud dá uma importância crescente a uma nova geração de plataformas de dados e analytics para impulsionar a inovação e concretizar as estratégias de transformação digital corporativa. No entanto, muitas organizações ainda enfrentam dificuldades com a complexidade, a infraestrutura não escalável e os altos custos de manutenção de seus ambientes legados do Hadoop e, por fim, sacrificam o valor de seus dados e, consequentemente, arriscam sua vantagem competitiva. Para enfrentar esse desafio e desbloquear mais oportunidades (às vezes ocultas) em seus dados, as organizações estão recorrendo a plataformas de dados e analítica abertas, simples e colaborativas baseadas na cloud, como a Databricks Lakehouse Platform. Neste blog, você aprenderá sobre os desafios que levam as organizações a explorar soluções modernas baseadas na cloud e o papel que a arquitetura lakehouse desempenha em desencadear a próxima onda de inovação data-driven.

Promessas não cumpridas do Hadoop

O sistema de arquivos distribuído (HDFS) do Hadoop foi uma tecnologia revolucionária quando lançado e continuará sendo um ícone na história dos dados. Devido ao seu surgimento, as organizações não estavam mais limitadas aos bancos de dados relacionais, o que deu origem ao armazenamento moderno de big data e, eventualmente, aos data lakes na nuvem. Apesar de toda a sua glória e alarde até 2015, o Hadoop teve dificuldades para suportar o potencial em evolução de todos os tipos de dados, especialmente em escala empresarial. Em última análise, à medida que o cenário de dados e as necessidades de negócios associadas evoluíram, o Hadoop teve dificuldades para continuar a cumprir suas promessas. Como resultado, as empresas começaram a explorar alternativas baseadas na cloud, e a taxa de migração do Hadoop para a cloud só aumenta.

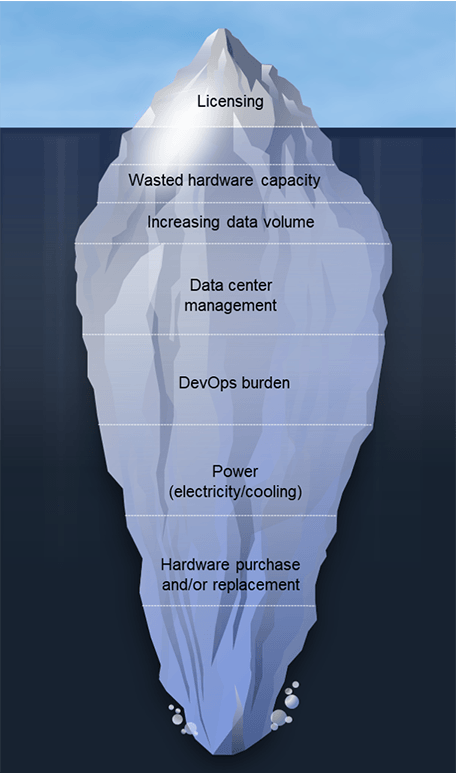

As equipes migram do Hadoop por vários motivos; geralmente é uma combinação de fatores de “pressão” e “atração”. Limitações dos sistemas Hadoop existentes e os altos custos de licenciamento e administração estão levando as equipes a explorar alternativas. Eles também estão sendo atraídos pelas novas possibilidades oferecidas pelas arquiteturas modernas de dados em nuvem. Embora os requisitos de arquitetura variem de acordo com a organização, vemos vários fatores em comum que levam os clientes a perceber que é hora de começar a dizer adeus. Isso inclui:

- Capacidade de hardware desperdiçada: O excesso de capacidade é uma característica comum em implementações on-premises para que você possa escalar para atender às suas necessidades de pico, mas o resultado é que grande parte dessa capacidade fica parada, embora continue a aumentar os custos operacionais e de manutenção.

- Os custos de escalabilidade aumentam rapidamente: não é possível dissociar o armazenamento e o compute em um ambiente Hadoop on-premises, portanto, os custos aumentam com os conjuntos de dados. Some-se a isso a rápida digitalização resultante da pandemia de COVID-19 e a taxa de crescimento global. Pesquisas indicam que a quantidade total de dados criados, capturados, copiados e consumidos no mundo tem previsão de aumento de 152,5% de 2020 a 2024, para 149 Zettabytes. Em um mundo de hipercrescimento de dados, os custos descontrolados podem disparar rapidamente.

- Sobrecarga de DevOps: com base na experiência de nossos clientes, você pode estimar de 4 a 8 funcionários em tempo integral para cada 100 nós.

- Aumento nos custos de energia: Espere pagar até US$ 800 por servidor anualmente com base no consumo e no resfriamento. Isso representa US$ 80 mil por ano para um cluster Hadoop de 100 nós!

- Custos de hardware novo e de reposição: Isso representa ~20% do TCO, o que equivale aos custos de administração dos clusters Hadoop.

- Atualizações de versão de software: Essas atualizações são muitas vezes obrigatórias para garantir a manutenção do contrato de suporte, e esses projetos levam meses, entregam poucas funcionalidades novas e consomem a preciosa capacidade das equipes de dados.

Além de toda a gama de desafios acima, há uma preocupação genuína sobre a viabilidade a longo prazo do Hadoop. Em 2019, o mundo viu um desmantelamento massivo na esfera do Hadoop. O Google, cujo seminal artigo sobre o MapReduce de 2004 fundamentou a criação do Apache Hadoop, parou de usar o MapReduce por completo, conforme tuitado por Urs Hölzle, SVP de Infraestrutura Técnica do Google. Houve também algumas fusões e aquisições de grande destaque no mundo do Hadoop. Além disso, em 2020, um dos principais provedores de Hadoop deixou de centrar seu conjunto de produtos no Hadoop, já que o Hadoop agora é considerado “mais uma filosofia do que uma tecnología”. Por fim, em 2021, a Apache Software Foundation anunciou a descontinuação de dez projetos do ecossistema Hadoop. Esse conjunto crescente de preocupações, juntamente com a necessidade acelerada de digitalização, incentivou muitas empresas a reavaliar sua relação com o Hadoop.

Gartner®: Databricks, líder em banco de dados em nuvem

A mudança para a arquitetura lakehouse

Uma arquitetura lakehouse é a arquitetura de dados ideal para organizações data-driven. Ela combina as melhores qualidades de data warehouses e data lakes para fornecer uma única solução de alto desempenho para todas as cargas de trabalho de dados. A arquitetura Lakehouse oferece suporte a uma variedade de casos de uso, como análise de dados de transmissão para BI, ciência de dados e IA. Por que os clientes amam a plataforma Databricks Lakehouse?

- É simples. Combine todos os seus dados, análises e IA em uma única plataforma

- É aberto. Unifique seu ecossistema de dados com padrões e formatos abertos.

- É colaborativo. Unifique suas equipes de dados

para colaborar em todos os workflows de dados e IA

Uma arquitetura de lakehouse pode oferecer ganhos significativos em comparação com os ambientes Hadoop legados, o que “puxa” as empresas para a adoção da cloud. Isso também inclui clientes que tentaram usar o Hadoop na cloud, mas não estão obtendo os resultados esperados ou desejados. Como R. Tyler Croy, Diretor de Engenharia da Scribd, explica “A Databricks alegou uma otimização de 30% a 50% para a maioria das cargas de trabalho tradicionais do Apache Spark™. Por curiosidade, refatorei meu modelo de custos para levar em conta o preço do Databricks e as possíveis otimizações de tarefas do Spark. Depois de ajustar os números, descobri que, com uma taxa de otimização de 17%, o Databricks reduziria tanto o custo da nossa infraestrutura da Amazon Web Services (AWS) que pagaria o custo da própria plataforma Databricks. Após nossa avaliação inicial, eu já estava convencido dos recursos e das melhorias na velocidade do desenvolvedor que o Databricks ofereceria. Quando analisei os números no meu modelo, descobri que não podia me dar ao luxo de não adotar o Databricks!”

O Scribd não está sozinho; outros clientes que migraram do Hadoop para a Databricks Lakehouse Platform incluem:

- A H&M processa volumes massivos de dados de mais de 5.000 lojas em mais de 70 mercados com milhões de clientes todos os dias. A arquitetura deles baseada em Hadoop criou desafios para os dados. Tornou-se custoso e com uso intensivo de recursos para escalar, apresentou problemas de segurança de dados, teve dificuldades para escalar operações para apoiar os esforços de ciência de dados de várias fontes de dados isoladas e retardou o tempo de lançamento no mercado devido a atrasos significativos de DevOps. Às vezes, levava um ano inteiro para ir da ideia ao resultado do produto. Com o Databricks, a H&M se beneficia de uma eficiência operacional aprimorada, reduzindo os custos operacionais em 70%, melhorando a colaboração entre equipes e aumentando o impacto nos negócios com um tempo de obtenção de percepções mais rápido.

- Viacom18 precisa processar terabytes de dados diários de visualizadores para otimizar a programação. O data lake Hadoop on-premises deles não conseguia processar 90 dias de dados contínuos dentro dos SLAs, limitando a capacidade de atender às necessidades de negócios. Com a Databricks, eles reduziram os custos significativamente com tempos de consulta mais rápidos e menos DevOps, apesar do aumento dos volumes de dados. A Viacom18 também melhorou a produtividade da equipe em 26% com uma plataforma totalmente gerenciada que oferece suporte a ETL, analítica e ML em escala.

- Reckitt Benckiser Group (RB) enfrentava dificuldades com a complexidade de prever a demanda em 500.000 lojas. Eles processam mais de 2 TB de dados todos os dias em 250 pipelines. A infraestrutura legada do Hadoop mostrou-se complexa, pesada, cara para escalar e tinha dificuldades de desempenho. Com o Databricks, a RB obteve 10x mais capacidade para suportar o volume de negócios, compressão de dados de 98% de 80 TB para 2 TB, reduzindo os custos operacionais, e desempenho 2x mais rápido do pipeline de dados para jobs 24x7.

O Hadoop nunca foi projetado para ser executado em ambientes de cloud. Embora os serviços Hadoop baseados em nuvem apresentem melhorias incrementais em comparação com seus equivalentes on-premises, ambos ainda ficam defasados em comparação com a arquitetura lakehouse. Ambas as instâncias do Hadoop apresentam baixo desempenho, baixa produtividade, altos custos e sua incapacidade de lidar com casos de uso de dados mais sofisticados em escala.

Garanta o futuro do seu crescimento impulsionado por dados, análises e IA

As decisões de migração para a cloud são decisões de negócios. Elas forçam as empresas a analisar profundamente a realidade da entrega de seus sistemas atuais e a avaliar o que precisam alcançar para atingir metas de curto e longo prazo. À medida que o investimento em IA continua a ganhar força, os líderes de dados, analytics e tecnología precisam desempenhar um papel fundamental ao pensar além da arquitetura Hadoop existente com a pergunta “isso nos levará aonde precisamos ir?”

Com a clareza dos objetivos, surgem detalhes técnicos críticos, como o mapeamento de tecnologia, a avaliação da utilização de recursos de cloud e do custo-desempenho, e a estruturação de um projeto de migração que minimize erros e riscos. Mas, o mais importante, você precisa ter a convicção data-driven de que é hora de reavaliar seu relacionamento com o Hadoop. Saiba mais sobre como a migração do Hadoop pode acelerar os resultados de negócios em seus casos de uso de dados.

1. Fonte: Gartner Market Databook, Goldman Sachs Global Investment Research

(Esta publicação no blog foi traduzida utilizando ferramentas baseadas em inteligência artificial) Publicação original

Nunca perca uma postagem da Databricks

O que vem a seguir?

Líder de dados

4 de dezembro de 2025/3 min de leitura

Construindo a empresa pronta para AI: líderes compartilham soluções e práticas de AI do mundo real

Líder de dados

29 de dezembro de 2025/4 min de leitura