Melhores práticas de governança de IA: como criar programas de IA responsáveis e eficazes

Summary

- A governança de IA empresarial gerencia riscos, conformidade e confiança à medida que os sistemas de IA passam a ter uso de alto risco e em produção, baseando as decisões em princípios como justiça, transparência, responsabilidade, privacidade, segurança e proteções integradas.

- Frameworks de governança eficazes alinham a supervisão com o risco do negócio, definem funções e políticas multifuncionais claras, incorporam pontos de verificação em todo o ciclo de vida da IA e se baseiam em avaliações de risco estruturadas, monitoramento, resposta a incidentes e documentação padronizada.

- Programas escaláveis usam padrões centralizados com execução federada, human-in-the-loop para decisões de alto risco, acompanhamento proativo da evolução das regulamentações e forte patrocínio do C-level para que a governança se torne um facilitador para a inovação responsável em AI, em vez de um gargalo.

Por que a governança de AI empresarial é importante agora

A adoção de IA empresarial está se acelerando rapidamente, impulsionada pelos avanços em IA generativa. Esses modelos aprendem com os dados, mudam conforme as entradas mudam e evoluem com as técnicas de treinamento e os datasets.

Mas mesmo com os modelos se tornando mais sofisticados e precisos, os LLMs e projetos de AI de última geração ainda apresentam riscos empresariais, especialmente quando implantados em produção. O impacto é que a governança de IA é mais importante do que nunca e as empresas devem ter uma estratégia robusta e multifacetada implementada.

Os principais pilares da governança incluem:

- Controles de acesso a dados e permissões

- Linhagem de dados e observabilidade total

- Mecanismos de proteção de AI integradas para proteger PII e bloquear conteúdo impróprio

- compliance e requisitos regulatórios

Quais são os objetivos de uma estrutura de governança de IA?

As melhores práticas de governança de IA fornecem uma forma estruturada de garantir que os sistemas de IA sejam desenvolvidos, implantados e operados de forma responsável. Além disso, essas práticas se alinham aos objetivos de negócio, gerenciam o risco em todo o ciclo de vida da IA e constroem a confiança com usuários e partes interessadas.

A pressão regulatória sobre o uso de IA também está aumentando. Governos e órgãos de normalização estão introduzindo novas discussões sobre transparência, responsabilização e supervisão de sistemas de IA, oferecendo aos usuários um conjunto de estruturas teóricas e práticas para construir sua governança. Por exemplo, os Princípios de IA da OCDE fornecem uma base fundamentada em valores para uma estrutura de governança de IA, enquanto a Lei de IA da União Europeia estabelece uma estrutura baseada em riscos com requisitos elevados para casos de uso de IA de alto risco.

Além da compliance, a governança de AI tem valor comercial direto. As organizações com estruturas de governança claras estão mais bem posicionadas para:

- Ganhe a confiança das partes interessadas nas decisões orientadas por IA

- Reduza o risco operacional e jurídico

- Dimensione sistemas de IA com mais eficiência entre equipes e casos de uso

- Demonstrar responsabilização e controle à medida que os programas de IA amadurecem

Desafios comuns que impulsionam a necessidade de governança

Muitas empresas enfrentam desafios semelhantes à medida que a adoção da IA cresce:

- Propriedade pouco clara: a responsabilidade pelos resultados de IA costuma ser fragmentada entre as equipes de dados, engenharia, jurídico e negócios. As equipes podem lançar modelos, mas nenhuma equipe é dona dos resultados.

- Ferramentas em rápida evolução: novas AI e GenAI estão melhorando rapidamente, e a velocidade e o ritmo do desenvolvimento delas significam que podem não ter os controles e processos adequados.

- Dados e processos fragmentados: dados, treinamento, implantação e monitoramento podem existir em sistemas separados, dificultando a supervisão e a documentação consistente.

- Auditabilidade limitada: provar como um sistema de IA foi treinado, avaliado e implantado pode ser demorado ou impossível sem artefatos de governança.

Esses desafios ressaltam por que a governança deve ser intencional e incorporada aos processos centrais desde o início, em vez de ser adaptada depois que os problemas surgem.

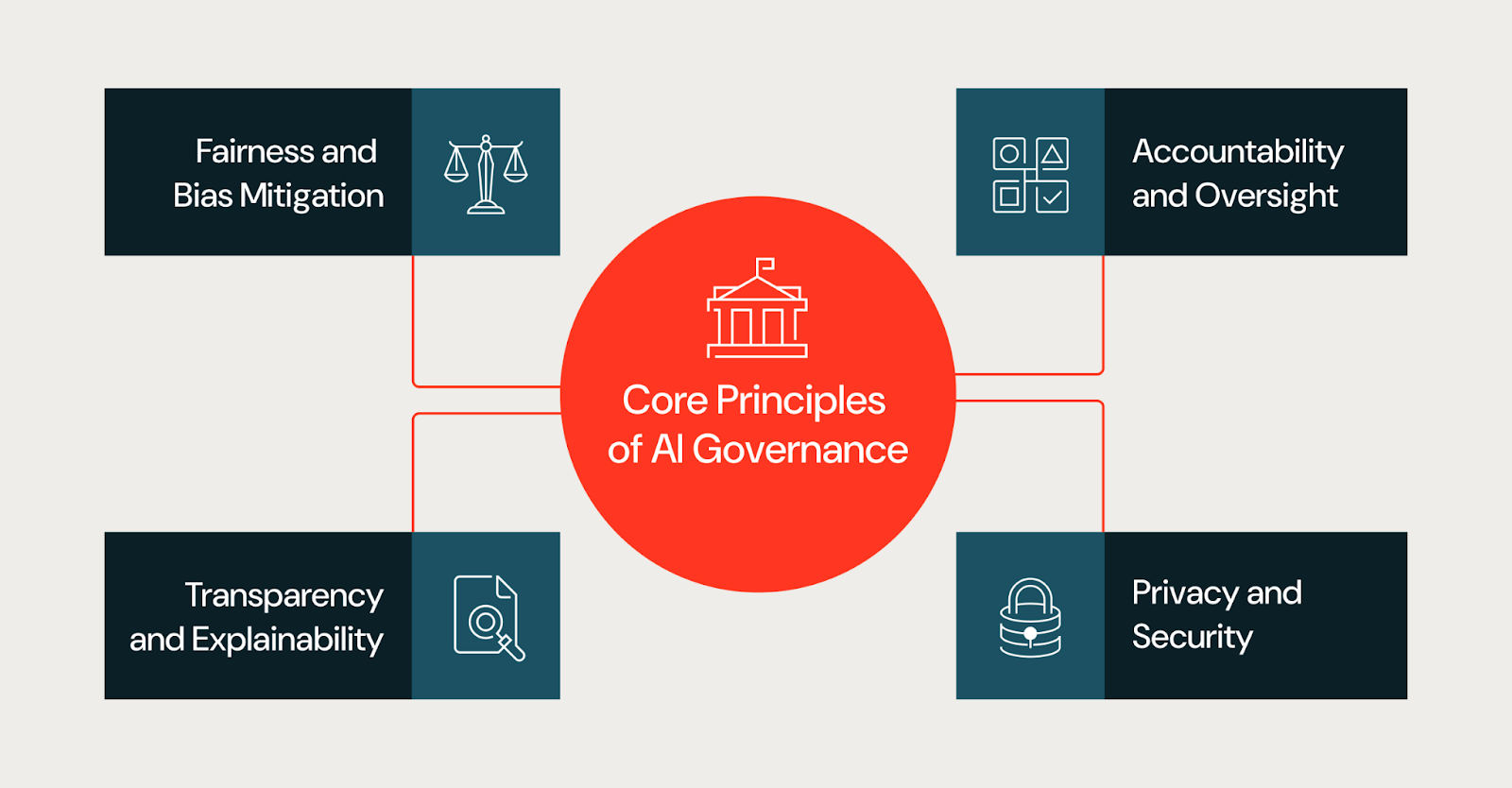

Princípios Fundamentais da Governança de IA Eficaz

A governança se aplica aos sistemas de IA como um todo, incluindo dados, prompts, fluxos de trabalho, pontos de decisão humana e aplicações posteriores, e não apenas a modelos individuais. Muitos riscos empresariais surgem da forma como esses componentes interagem, e não do modelo em si. As melhores práticas de governança de IA se baseiam em um conjunto consistente de princípios fundamentais. Esses princípios orientam as decisões em todo o ciclo de vida da AI e fornecem uma estrutura compartilhada para equipes com diferentes responsabilidades.

Equidade e Mitigação de Viés

O viés pode ser introduzido por meio de dados de treinamento, seleção de recursos ou contexto de implantação e levar a resultados díspares entre as populações. Os programas de governança devem exigir que as equipes avaliem os riscos de imparcialidade desde o início, documentem as limitações conhecidas e monitorem vieses não intencionais à medida que os modelos evoluem em produção.

Na prática, as equipes avaliam a equidade examinando os dados de treinamento em busca de lacunas de representação, testando os resultados do modelo em diferentes grupos demográficos e definindo métricas de equidade antes da implantação. As abordagens comuns incluem avaliação desagregada, auditorias de viés durante o desenvolvimento e monitoramento contínuo de drift em produção. As equipes também devem documentar as limitações conhecidas e os casos extremos em que o modelo pode ter um desempenho inferior.

Transparência e Explicabilidade

A transparência ajuda as partes interessadas a entender como os sistemas de IA são construídos e como eles influenciam os resultados. Isso não significa exigir visibilidade total da arquitetura de modelo proprietária de um fornecedor ou de seus dados de treinamento, já que os fornecedores de modelos fechados normalmente não divulgam esses detalhes. Em vez disso, a transparência se concentra no que uma organização pode controlar e documentar.

Isso inclui clareza sobre quais modelos e versões uma equipe pode estar usando, quais dados estão sendo passados para eles, como estão fazendo o prompting ou o ajuste fino deles e quais critérios de avaliação uma equipe pode aplicar antes da implantação. As equipes também devem documentar a lógica de decisão na camada do aplicativo para explicar como os resultados do modelo são usados, filtrados ou substituídos em fluxos de trabalho posteriores. Para as partes interessadas que precisam de explicações, como reguladores, executivos ou usuários afetados, o objetivo é fornecer o contexto apropriado sobre como o sistema chega a seus resultados, mesmo quando o modelo subjacente é uma caixa-preta.

Responsabilização e Supervisão

Uma governança eficaz define uma responsabilidade clara para os sistemas de IA. Todo modelo ou aplicação de IA deve ter indivíduos ou equipes responsáveis pelos resultados, gerenciamento de riscos e compliance com as políticas internas. Os mecanismos de supervisão garantem que a responsabilidade persista após a implantação, em vez de desaparecer quando um modelo é lançado.

Privacidade e segurança

Sistemas de IA geralmente processam dados sensíveis ou regulamentados, e a governança deve garantir que as proteções de privacidade e os controles de segurança sejam aplicados de forma consistente, incluindo gerenciamento de acesso baseado em função, filtros de PII e filtragem contra resultados inseguros. As considerações de privacidade e segurança devem ser integradas durante todo o ciclo de vida da IA, e não abordadas apenas no momento da implantação.

Salvaguardas integradas

Sistemas de IA precisam de salvaguardas que impeçam resultados prejudiciais ou não intencionais. As salvaguardas integradas incluem validação de entrada para detectar queries malformadas ou adversárias, filtros de saída que bloqueiam conteúdo inseguro ou inadequado, detecção de PII para evitar a exposição de dados e moderação de conteúdo para aplicações voltadas para o usuário. Esses controles devem ser configuráveis por nível de risco; uma ferramenta interna de baixo risco pode precisar de salvaguardas mais leves do que um agente voltado para o cliente.

Acesso unificado para modelos e projetos de IA

À medida que as organizações expandem a adoção de IA, o acesso a modelos e projetos de IA deve ser governado por meio de uma estrutura centralizada. Controles de acesso unificados garantem permissões consistentes nos ambientes de desenvolvimento, homologação e produção. Isso inclui acesso baseado em função para definir quem pode visualizar, modificar ou implantar modelos; trilhas de auditoria que rastreiam alterações e uso; e integração com sistemas de gerenciamento de identidade. O acesso centralizado reduz o risco de projetos de "shadow AI" e torna a compliance mais fácil de demonstrar. Sem controles de acesso unificados, as organizações geralmente enfrentam dificuldades com a "shadow AI" (modelos e aplicações implantados fora da supervisão formal), que se torna uma das maiores barreiras para a governança consistente em escala.

Construindo uma Estrutura Prática de Governança de IA

Embora os princípios de governança possam definir o que é uma boa governança, as estruturas (frameworks) são o que definem como essas organizações implementam seus processos. Em outras palavras, uma estrutura prática de governança de IA traduz metas de alto nível em funções, políticas e controles específicos que se encaixam na estrutura geral e na tolerância a riscos de uma organização.

Consulte o Databricks AI Governance Framework para ver um exemplo de uma abordagem estruturada para definir os pilares da governança e as principais considerações.

Alinhe a governança com os objetivos de negócios

As organizações alcançam melhores resultados quando a governança se alinha com o impacto nos negócios e o risco. Nem todo sistema de IA precisa do mesmo nível de supervisão. Um chatbot que resume documentos externos apresenta um risco diferente de um modelo que aprova empréstimos ou prioriza casos médicos.

Estabelecer Funções e Estruturas de Governança

Para que a governança de AI seja mais eficaz, ela deve ser multifuncional. Isso envolve a colaboração contínua e intencional entre as equipes de dados e IA, jurídico e de compliance, privacidade e segurança e as partes interessadas de negócios. As estruturas comuns incluem:

- Comitês de governança multifuncionais

- Modelos RACI claramente definidos

- Requisitos de intervenção humana para decisões de alto risco

- Controle de acesso baseado na função

Essas estruturas esclarecem os direitos de decisão e reduzem a ambiguidade à medida que a escala dos programas de AI aumenta.

Definir Políticas, Padrões e Controles de IA

Padrões claros reduzem o atrito. Estruturas de governança eficazes especificam:

- Documentação e artefatos necessários

- Critérios de classificação de risco de IA

- Limites de aprovação por nível de risco

- Monitoramento, resposta a incidentes e expectativas de auditoria

Quando os padrões permanecem vagos, as equipes inventam interpretações locais. Quando os padrões permanecem concretos, as equipes avançam mais rápido e com menos surpresas.

Operacionalização da Governança de IA

A governança de IA deve ser integrada à própria estrutura do fluxo de trabalho, como a forma como as equipes projetam, lançam e operam sistemas de IA. No entanto, ela precisa ser mais do que apenas uma teoria; a governança operacional deve responder a perguntas práticas, como quem decide, quais evidências as equipes devem produzir e como os sistemas permanecem em conformidade ao longo do tempo. O resultado é um processo explícito que as equipes podem seguir para integrar a governança de AI em seus fluxos de trabalho.

Integre a governança ao ciclo de vida de desenvolvimento de AI

A maioria das organizações não está construindo modelos de base do zero. Elas estão combinando modelos existentes com dados proprietários para criar projetos, agentes e aplicações de IA. A governança deve refletir essa realidade, incorporando pontos de verificação diretamente no ciclo de vida de desenvolvimento. Por exemplo, um assistente de IA interno que resume documentos externos pode ser inicialmente classificado como de baixo risco. Se esse mesmo sistema for posteriormente exposto a clientes ou usado para embasar decisões regulamentadas, seu perfil de risco muda, exigindo novas aprovações, salvaguardas e monitoramento.

- Defina o escopo e a intenção. Antes do início do desenvolvimento, documente o uso pretendido do sistema, os usos proibidos e o contexto da decisão. Isso evita o desvio de escopo, em que os sistemas são reutilizados em cenários de maior risco sem revisão.

- Documente as fontes de dados. Registre a propriedade dos dados, as restrições de consentimento e as limitações conhecidas. Se as equipes não conseguirem explicar de onde os dados vieram e por que são apropriados, elas não devem usá-los para construir ou ajustar um sistema.

- Estabelecer critérios de avaliação. Concordar com as métricas, os limites e as concessões aceitáveis antes dos testes. As equipes devem documentar por que escolheram métricas específicas e quais modos de falha observaram. Isso transforma a avaliação em um registro de decisão para referência futura.

- Aplique portões de liberação. Exija responsáveis designados, documentação completa e aprovação alinhada ao nível de risco do sistema. Defina critérios de reversão para que as equipes saibam quando retirar um sistema da produção.

- Monitore e revise. Após a implantação, revise o comportamento em produção, validando suposições em relação ao uso real e documentando as alterações ao longo do tempo.

Realizar avaliações de risco de AI

A avaliação de risco é o cerne da governança prática. Ela determina de quanto controle um sistema precisa e onde as equipes devem concentrar a atenção. À medida que as equipes implantam avaliações eficazes, elas devem se concentrar em um pequeno conjunto de perguntas:

- Quem este sistema afeta?

- Quais decisões ele influencia ou automatiza?

- O que acontece quando ele falha?

- Com que facilidade os humanos podem intervir?

- Qual sensibilidade de dados isso envolve?

Depois que as equipes reúnem as respostas para essas perguntas, elas podem atribuir um nível de risco, que é uma forma de traduzir o julgamento em ação. Por exemplo, uma ferramenta interna de baixo risco pode exigir documentação simplificada e revisão periódica, enquanto que um sistema de alto risco pode exigir supervisão humana frequente, aprovação formal e monitoramento contínuo.

As avaliações de risco devem acontecer cedo e estar sujeitas a atualizações contínuas ao longo do tempo. À medida que os sistemas se expandem para novos usuários ou casos de uso, o perfil de risco deles geralmente muda. Os processos de governança devem ser projetados para levar em conta essa evolução.

Definir caminhos de aprovação e escalonamento

A governança operacional depende de caminhos de decisão claros. As equipes precisam saber quem pode aprovar um sistema, quando o escalonamento é necessário e como resolver discordâncias. Como resultado, as organizações normalmente definem os seguintes caminhos de decisão:

- autoridades de aprovação por nível de risco

- Gatilhos de escalonamento para questões não resolvidas

- cronogramas para análise e resposta

- critérios para interromper ou reverter sistemas

Sem caminhos definidos, a governança pode se tornar confusa e as equipes podem sofrer paralisia à medida que as decisões estagnam, a responsabilidade se difunde e as equipes contornam os controles para continuar avançando. Estabelecer caminhos claros reduz a ambiguidade e aumenta a compliance, pois as equipes entendem como proceder.

Implementar Controles de monitoramento e compliance

Dado o desenvolvimento rápido e contínuo dos sistemas de IA, a governança de IA não pode ser estática. Com o tempo, os dados mudam, os padrões de uso se alteram e o desempenho se degrada. É crucial que as equipes monitorem o comportamento da IA em produção, concentrando-se em:

- desempenho em relação a métricas definidas

- drift de dados e alterações na distribuição

- entradas ou saídas inesperadas

- uso do sistema fora do escopo pretendido

A governança define o que as equipes devem monitorar, com que frequência elas revisam os resultados e quais ações elas tomam quando os limites são violados. Essas ações podem incluir retreinamento, restrição de uso, escalonamento para órgãos de revisão ou o desligamento de sistemas. Ao transformar o monitoramento em um ciclo de feedback, as organizações podem garantir que estão maximizando os benefícios de seus processos internos.

Estabeleça processos de resposta e remediação a incidentes

Além de criar uma cultura de feedback e responsabilidade, frameworks de governança robustos devem prever falhas. Mesmo sistemas bem projetados falham ou se degradam com o tempo.

Outro passo para a governança é definir como uma equipe responde a incidentes de IA, incluindo resultados enviesados, comportamento inseguro, exposição de dados ou preocupações regulatórias. As equipes precisam de playbooks predefinidos que especifiquem:

- Como identificar e classificar incidentes

- Quem é o responsável pela resposta e comunicação

- Como conter danos

- Como documentar as causas raiz e a remediação

As revisões pós-incidente podem ajudar a incorporar novos aprendizados ou atualizações na governança estabelecida, ajudando a atualizar as avaliações de risco, melhorar os controles e refinar as políticas. Esse ciclo garante que a governança evolua com a experiência do mundo real.

Padronizar artefatos de governança

À medida que as equipes desenvolvem sua governança, a documentação padronizada é importante para evidências e consistência em todo o sistema. A documentação consistente também pode ajudar em auditorias e reduzir a necessidade de esforços duplicados na reprodução de documentos. As organizações priorizam os seguintes documentos padronizados:

- Resumos do sistema que definem o propósito e o escopo

- Documentação de dados que registra fontes e limitações

- Resumos de avaliação que capturam o desempenho e as limitações

- Planos de monitoramento que definem a supervisão contínua

Escala a governança entre equipes e domínios

À medida que a adoção de IA continua a crescer, a governança de uma organização precisa escalar sem introduzir gargalos. Muitas equipes usam um modelo centralizado-federado, no qual um grupo central define padrões, estruturas de risco e políticas, enquanto as equipes de domínio os aplicam localmente e permanecem responsáveis pelos resultados. Este modelo ajuda a encontrar um equilíbrio entre consistência e velocidade.

A expansão também requer treinamento. À medida que os sistemas de governança evoluem e se desenvolvem, as equipes precisam entender o que a governança exige e a melhor forma de cumprir os requisitos.

Gartner®: Databricks, líder em banco de dados em nuvem

Garantindo transparência, confiança e explicabilidade

A confiança é um resultado central da governança de AI eficaz. As partes interessadas têm maior probabilidade de adotar e confiar nos sistemas de AI quando entendem como as decisões são tomadas e como os riscos são gerenciados ao longo do ciclo de vida da AI.

Supervisão com Intervenção Humana

Para casos de uso de alto risco ou confidenciais, os humanos devem manter a autoridade final sobre as decisões orientadas por IA. Os frameworks de governança devem definir quando a revisão humana é necessária, como as intervenções ocorrem e como as decisões são documentadas.

Comunicação de decisões de IA para as partes interessadas

Diferentes stakeholders exigem diferentes níveis de explicação. As equipes técnicas podem precisar de métricas de avaliação detalhadas, enquanto executivos e reguladores podem se basear em resumos, model cards ou justificativas de decisão. Uma comunicação clara gera confiança e apoia a responsabilização.

Acompanhando o ritmo das mudanças regulatórias e do setor

A governança de AI nunca está concluída. Leis e regulamentações evoluem, os padrões amadurecem e os recursos de IA avançam mais rápido do que os ciclos de políticas.

Manter-se atualizado sobre padrões e atualizações

As organizações se mantêm atualizadas atribuindo responsabilidades claras para o monitoramento de mudanças regulatórias e de padrões. Programas eficazes criam um pequeno grupo multifuncional que inclui profissionais das áreas jurídica, de compliance, privacidade, segurança e IA, em vez de depender de atualizações ad hoc.

O monitoramento funciona melhor em uma cadência fixa, como trimestralmente, em vez de atualizações reativas. Para se manterem proativas, as equipes devem avaliar cada mudança perguntando:

- Isso afeta os sistemas de IA existentes ou apenas os novos?

- Isso introduz nova documentação ou novas expectativas de supervisão?

- Isso se aplica globalmente ou apenas em regiões específicas?

Essas verificações de impacto ajudam as equipes a usar e aprimorar os processos de governança existentes em vez de criar controles paralelos.

Preparando-se para os futuros requisitos de governança de IA

Os requisitos futuros de governança de IA provavelmente ampliarão as expectativas em torno de explicabilidade, auditabilidade e documentação. As organizações podem preparar seus processos agora, sem esperar por mandatos detalhados.

Rastreabilidade e explicabilidade: as equipes devem definir quais explicações exigem por nível de risco e público, desde análises técnicas até resumos executivos e regulatórios.

Auditabilidade: é importante manter registros de decisão que mostrem para que um sistema foi projetado, como ele foi avaliado, quem o aprovou e como ele mudou após a implantação.

Documentação: a padronização da sua documentação é crucial. Garanta que suas equipes de governança documentem resumos de sistema, avaliações de risco, registros de avaliação e planos de monitoramento – e os mantenham continuamente atualizados.

Superando as Barreiras Comuns à Adoção da Governança de IA

Apesar de seus benefícios, a governança de AI apresenta seu próprio conjunto de desafios dentro das organizações. As barreiras comuns incluem:

Sustentabilidade. Quando os incentivos organizacionais recompensam o lançamento de modelos o mais rápido possível, as equipes podem ver a governança como um obstáculo. As equipes de dados e AI se concentram em implantar modelos rapidamente, enquanto os requisitos de governança aparecem mais tarde como ciclos de revisão inesperados ou trabalho de documentação.

Propriedade fragmentada. Quando a responsabilidade pelos resultados da IA é distribuída entre várias equipes, as responsabilidades de governança podem não ser claras. Nenhuma equipe única é dona do resultado, então ninguém é dono dos controles.

Dívida técnica legada. Pipelines e modelos mais antigos geralmente não têm os metadados, o monitoramento ou a documentação que a governança espera. A adaptação desses sistemas exige um esforço que compete com as novas prioridades de desenvolvimento.

Estratégias para Aumentar a Adoção

Programas de governança bem-sucedidos focam na proatividade, e não em reformas reativas. Deve haver uma mensagem consistente da diretoria executiva sobre por que a governança é importante. Comunicação e treinamentos claros ajudam os profissionais a entender como a governança se encaixa nos fluxos de trabalho existentes, em vez de adicionar processos paralelos. Enquanto isso, iniciativas-piloto desempenham um papel fundamental ao demonstrar que a governança reduz o retrabalho, evita incidentes de produção e acelera as aprovações uma vez que os padrões estejam estabelecidos. Juntas, essas estratégias transformam a governança de um obstáculo percebido em uma base prática para escalar a IA de forma responsável.

Como começar a construir uma estratégia de governança de IA

Uma governança de IA robusta ajuda as organizações a escalar a adoção de IA com confiança. Atributos como propriedade clara, controles baseados em risco e supervisão contínua reduzem surpresas e mantêm os sistemas alinhados com as expectativas de negócios e regulatórias.

As equipes devem começar com uma base prática: inventariar os casos de uso de AI atuais, classificá-los por risco e atribuir proprietários responsáveis. Pilote os controles de governança em um pequeno conjunto de sistemas de alto impacto para estabelecer padrões e refinar processos. À medida que as equipes ganham experiência, elas podem estender a governança para outros casos de uso e domínios, fortalecendo a supervisão enquanto preservam a velocidade e a flexibilidade necessárias para sustentar a inovação em IA.

(Esta publicação no blog foi traduzida utilizando ferramentas baseadas em inteligência artificial) Publicação original

Nunca perca uma postagem da Databricks

O que vem a seguir?

IA

7 de janeiro de 2025/8 min de leitura