Anúncio da disponibilidade geral da disponibilização de modelos do Databricks

ML de produção simplificado na Databricks Lakehouse Platform

Temos o prazer de anunciar a disponibilidade geral do Databricks Model Serving. O Model Serving implanta modelos do machine learning como uma API REST, permitindo que você crie aplicações de ML em tempo real, como recomendações personalizadas, chatbots de atendimento ao cliente, detecção de fraudes e muito mais, tudo isso sem o transtorno de gerenciar a infraestrutura de serviço.

Com o lançamento do Databricks Model Serving, agora você pode implantar seus modelos junto com sua infraestrutura de dados e treinamento existente, simplificando o ciclo de vida de ML e reduzindo os custos operacionais.

"Ao servindo modelos na mesma plataforma onde nossos dados residem e onde ensinamos modelos, conseguimos acelerar as implantações e reduzir a manutenção, o que, em última análise, nos ajuda a entregar os melhores resultados para nossos clientes e a promover uma vida mais agradável e sustentável em todo o mundo."— Daniel Edsgärd, diretor de data science da Electrolux

Desafios na construção de sistemas de ML em tempo real

Os sistemas de machine learning em tempo real estão revolucionando a forma como as empresas operam, fornecendo a capacidade de fazer previsões ou ações imediatas com base nos dados recebidos. Aplicações como chatbots, detecção de fraudes e sistemas de personalização dependem de sistemas em tempo real para fornecer respostas instantâneas e precisas, melhorando as experiências do cliente, aumentando a receita e reduzindo o risco.

No entanto, implementar tais sistemas continua sendo um desafio para as empresas. Sistemas de ML em tempo real precisam de uma infraestrutura de serviço rápida e escalável, que requer conhecimento especializado para construir e manter. A infraestrutura não deve apenas oferecer suporte ao serviço, mas também incluir consultas de recursos, monitoramento, implantação automatizada e retreinamento de modelos. Isso geralmente faz com que as equipes integrem ferramentas díspares, o que aumenta a complexidade operacional e cria sobrecarga de manutenção. As empresas muitas vezes acabam gastando mais tempo e recursos na manutenção da infraestrutura em vez de integrar ML em seus processos.

Gartner®: Databricks, líder em banco de dados em nuvem

Model Serving de produção no Lakehouse

O Databricks Model Serving é a primeira solução de serving serverless e em tempo real desenvolvida em uma plataforma unificada de dados e IA. Esta solução de serviço exclusiva acelera o caminho das equipes de ciência de dados para a produção, simplificando as implantações e reduzindo erros por meio de ferramentas integradas.

Elimine as sobrecargas de gerenciamento com o Model Serving em tempo real

O Databricks Model Serving oferece um serviço serverless altamente disponível e de baixa latência para implantar modelos por trás de uma API. Você não precisa mais lidar com a complicação e o fardo de gerenciar uma infraestrutura escalável. Nosso serviço totalmente gerenciado cuida de todo o trabalho pesado para você, eliminando a necessidade de gerenciar instâncias, manter a compatibilidade de versões e aplicar patches de versões. Os Endpoints escalam automaticamente para cima ou para baixo para atender às mudanças na demanda, economizando custos de infraestrutura e otimizando o desempenho da latência.

"O dimensionamento automático rápido mantém os custos baixos e nos permite dimensionar à medida que a demanda de tráfego aumenta. Nossa equipe agora dedica mais tempo para criar modelos e resolver problemas dos clientes, em vez de depurar problemas relacionados à infraestrutura." — Gyuhyeon Sim, CEO da Letsur.ai

Acelere as implantações através do Lakehouse-Unified Model Serving.

O Databricks Model Serving acelera as implantações de modelos de ML ao fornecer integrações nativas com vários serviços. Agora você pode gerenciar todo o processo de ML, desde a ingestão de dados e o treinamento até a implantação e o monitoramento, tudo em uma única plataforma, criando uma view consistente em todo o ciclo de vida de ML que minimiza erros e acelera a depuração. Model Serving se integra a vários serviços do Lakehouse, incluindo

- Integração com o Feature Store: Integra-se de forma transparente com o Databricks Feature Store, fornecendo consultas online automatizadas para evitar a distorção online/offline. Você define os recursos uma vez durante o treinamento e nós recuperaremos e uniremos automaticamente os recursos relevantes para completar o payload de inferência.

- Integração com o MLflow: conecta-se nativamente ao MLflow Model Registry, permitindo a implantação rápida e fácil de modelos. Basta nos fornecer o modelo, e prepararemos automaticamente um contêiner pronto para produção e o implantaremos em compute serverless.

- Qualidade e Diagnóstico (em breve): Capture automaticamente solicitações e respostas em uma tabela Delta para monitorar e depurar modelos ou gerar datasets de treinamento.

- Governança unificada: gerencie e governe todos os dados e ativos de ML, incluindo os consumidos e produzidos pelo servindo modelo, com o Unity Catalog.

"Ao fazer a disponibilização de modelos em uma plataforma unificada de dados e IA, conseguimos simplificar o ciclo de vida do ML e reduzir a sobrecarga da manutenção. Isso nos permite redirecionar nossos esforços para expandir o uso de IA em mais áreas da nossa empresa." - Vincent Koc, chefe de dados do hipages Group

Capacite as equipes com implantação simplificada

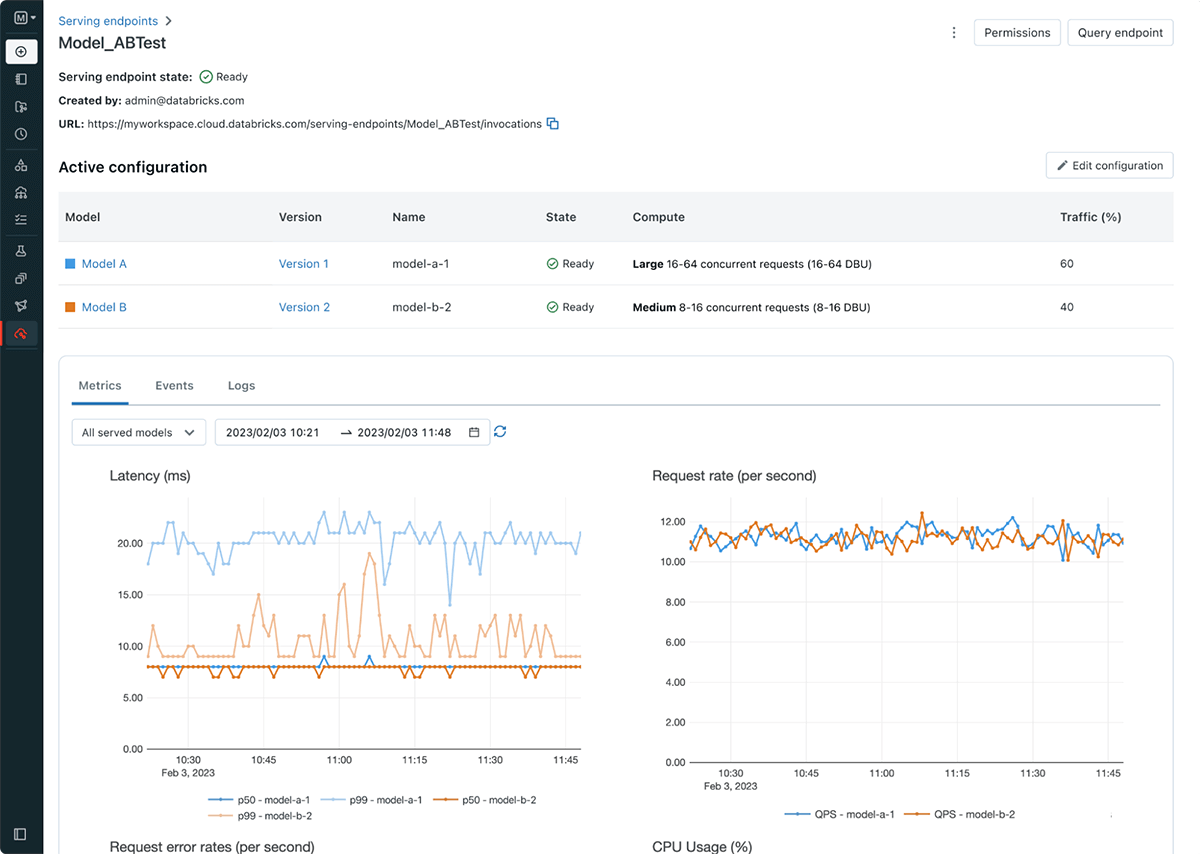

O Databricks Model Serving simplifica o fluxo de trabalho de implantação de modelos, capacitando cientistas de dados a implantar modelos sem a necessidade de conhecimento ou experiência complexa em infraestrutura. Como parte do lançamento, também estamos introduzindo Endpoints de serviço, que desacoplam o registro de modelo e o URI de pontuação, resultando em implantações mais eficientes, estáveis e flexíveis. Por exemplo, agora você pode implantar vários modelos por trás de um único endpoint e distribuir o tráfego conforme desejado entre os modelos. A nova UI de serviço e as APIs facilitam a criação e o gerenciamento de endpoints. Os endpoints também fornecem métricas e logs integrados que você pode usar para monitorar e receber alertas.

Primeiros passos com o Databricks Model Serving

- Inscreva-se na próxima conferência para saber como o Databricks Model Serving pode ajudar a criar sistemas em tempo real e obter percepções de clientes.

- Experimente! Comece a implantar modelos de ML como uma API REST

- Aprofunde-se na documentaçãodo Databricks Model Serving.

- Confira o guia para migrar do Fornecimento de Modelo do MLflow Legado para o Fornecimento de Modelo do Databricks

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura