A nova maneira de criar pipelines no Databricks: apresentando o IDE para engenharia de dados

Uma nova experiência de desenvolvimento criada especificamente para a criação de Pipelines declarativos do Lakeflow Spark

Summary

- Spark Declarative Pipelines agora têm uma experiência dedicada de IDE para desenvolvedores no Databricks Workspace.

- O novo IDE melhora a produtividade e a depuração com recursos como gráficos de dependência, pré-visualizações e percepções de execução.

- O IDE oferece suporte para integração rápida e casos de uso avançados, como integração com Git, CI/CD e observabilidade.

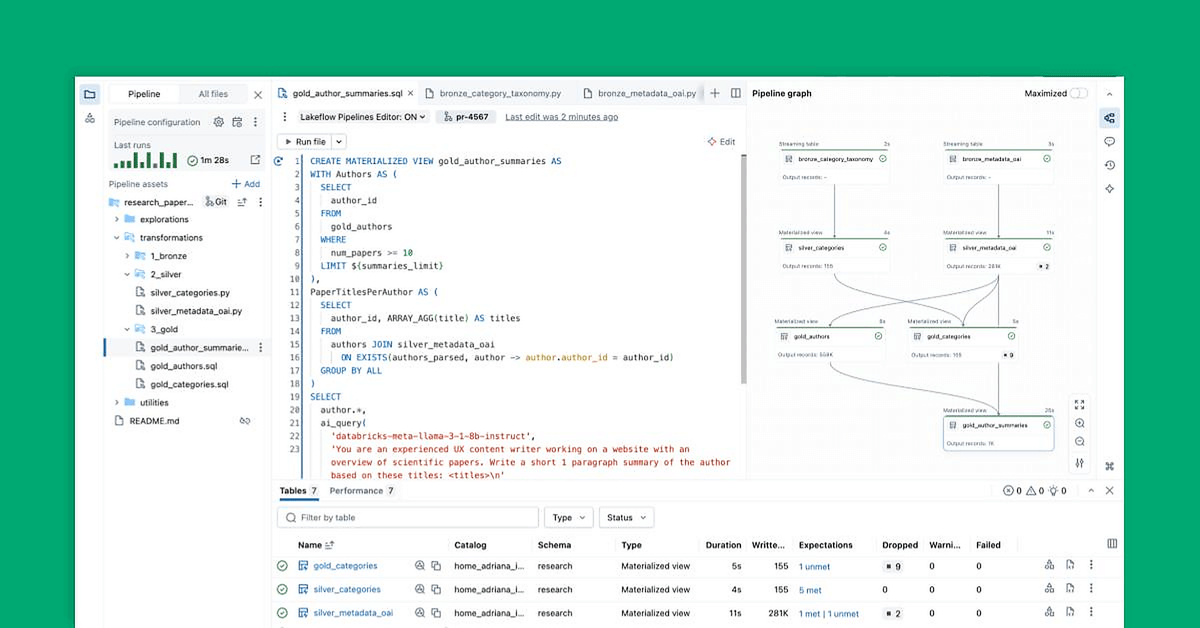

No Data + AI Summit deste ano, apresentamos o IDE para Engenharia de Dados: uma nova experiência de desenvolvedor criada especificamente para a criação de pipeline de dados diretamente no Databricks Workspace. Como a nova experiência de desenvolvimento padrão, o IDE reflete nossa abordagem opinativa para a engenharia de dados: declarativa por default, com estrutura modular, integrada ao Git e assistida por AI.

Em resumo, o IDE para Engenharia de Dados é tudo o que você precisa para criar e testar pipelines de dados, tudo em um só lugar.

Com esta nova experiência de desenvolvimento disponível em pré-visualização pública, gostaríamos de usar este blog para explicar por que os pipelines declarativos se beneficiam de uma experiência de IDE dedicada e destacar os principais recursos que tornam o desenvolvimento de pipeline mais rápido, organizado e fácil de depurar.

A engenharia de dados declarativa ganha uma experiência de desenvolvedor dedicada

Pipelines declarativos simplificam a engenharia de dados, permitindo que você declare o que deseja alcançar em vez de escrever instruções detalhadas passo a passo sobre como construí-lo. Embora a programação declarativa seja uma abordagem extremamente poderosa para criar pipeline de dados, trabalhar com vários datasets e gerenciar todo o ciclo de vida de desenvolvimento pode se tornar difícil de lidar sem ferramentas dedicadas.

É por isso que criamos uma experiência de IDE completa para pipelines declarativos diretamente no Databricks Workspace. Disponível como um novo editor para Lakeflow Spark Declarative Pipelines, ele permite declarar datasets e restrições de qualidade em arquivos, organizá-los em pastas e view as conexões por meio de um gráfico de dependência gerado automaticamente e exibido ao lado do código. O editor avalia seus arquivos para determinar o plano de execução mais eficiente e permite que você itere rapidamente executando novamente arquivos únicos, um conjunto de datasets alterados ou o pipeline inteiro.

O editor também apresenta percepções de execução, oferece visualizações de dados integrada e inclui ferramentas de depuração para ajudar você a refinar seu código. Ele também se integra com controle de versão e execução agendada com o Lakeflow Jobs. Dessa forma, você pode realizar todas as tarefas relacionadas ao seu pipeline em uma única interface.

Ao consolidar todos esses recursos em uma única interface semelhante a um IDE, o editor oferece as práticas e a produtividade que os engenheiros de dados esperam de um IDE moderno, mantendo-se fiel ao paradigma declarativo.

O vídeo incorporado abaixo mostra esses recursos em ação, com mais detalhes nas seções a seguir.

"O novo editor reúne tudo em um só lugar - código, gráfico de pipeline, resultados, configuração e solução de problemas. Chega de alternar entre tabs do navegador ou perder o contexto. O desenvolvimento fica mais focado e eficiente. Posso ver diretamente o impacto de cada alteração de código. Um clique me leva à linha exata do erro, o que torna a depuração mais rápida. Tudo se conecta: código a dados; código a tabelas; tabelas ao código. Alternar entre pipelines é fácil, e recursos como pastas de utilidades autoconfiguradas removem a complexidade. É assim que o desenvolvimento de pipelines deveria funcionar."— Chris Sharratt, Engenheiro de Dados, Rolls-Royce

"Na minha opinião, o novo Editor de Pipelines é uma grande melhoria. Acho muito mais fácil gerenciar estruturas de pastas complexas e alternar entre arquivos graças à experiência de múltiplas tabs. A view de DAG integrada realmente me ajuda a acompanhar pipelines complexos, e o tratamento de erros aprimorado é um divisor de águas: me ajuda a identificar problemas rapidamente e otimiza meu fluxo de trabalho de desenvolvimento."— Matt Adams, desenvolvedor sênior de plataformas de dados, PacificSource Health Plans

Facilidade para começar

Projetamos o editor para que até mesmo usuários novos no paradigma declarativo possam criar rapidamente o primeiro pipeline.

- A configuração guiada permite que novos usuários comecem com um código de exemplo, enquanto os usuários existentes podem definir configurações avançadas, como pipelines com CI/CD integrado via Bundles de Ativos Databricks.

- Estruturas de pastas sugeridas fornecem um ponto de partida para organizar os ativos sem impor convenções rígidas, para que as equipes também possam implementar seus próprios padrões organizacionais estabelecidos. Por exemplo, você pode agrupar transformações em pastas para cada estágio da arquitetura medallion, com um dataset por arquivo.

- As Default settings permitem que os usuários escrevam e façam a execução do primeiro código sem a sobrecarga de uma configuração inicial pesada e ajustem as configurações mais tarde, assim que a carga de trabalho de ponta a ponta for definida.

Esses recursos ajudam os usuários a se tornarem produtivos rapidamente e a transformar o trabalho deles em pipelines prontos para produção.

Eficiência no ciclo de desenvolvimento interno

A criação de pipelines é um processo iterativo. O editor otimiza esse processo com recursos que simplificam a criação e agilizam o teste e o refinamento da lógica:

- A geração de código com tecnologia de AI e os padrões de código aceleram as definições do dataset e as restrições de qualidade dos dados, além de removerem os passos repetitivos.

- Execução seletiva permite executar uma única tabela, todas as tabelas em um arquivo ou o pipeline inteiro.

- O gráfico de pipeline interativo fornece uma visão geral das dependências do dataset e oferece ações rápidas, como visualizações de dados, novas execuções, navegação para o código ou adição de novos datasets com código-padrão gerado automaticamente.

- As visualizações de dados integradas permitem inspecionar os dados da tabela sem sair do editor.

- Os erros contextuais aparecem ao lado do código relevante, com correções sugeridas pelo Databricks Assistant.

- Os painéis de percepções de execução exibem métricas do dataset, expectativas e desempenho de query, com acesso a perfis de query para ajuste de desempenho.

Esses recursos reduzem a troca de contexto e mantêm os desenvolvedores focados na criação da lógica do pipeline.

Gartner®: Databricks, líder em banco de dados em nuvem

Uma interface única para todas as tarefas

O desenvolvimento de pipelines envolve mais do que escrever código. A nova experiência do desenvolvedor reúne todas as tarefas relacionadas em uma única superfície, da modularização do código para facilitar a manutenção à configuração de automação e observabilidade:

- Organize o código adjacente, como Notebooks exploratórios ou módulos Python reutilizáveis, em pastas dedicadas, edite arquivos em várias tabs e faça a execução separadamente da lógica do pipeline. Isso mantém o código relacionado localizável e seu pipeline organizado.

- O controle de versão integrado por meio de pastas do Git permite um trabalho seguro e isolado, revisões de código e pull requests em shared repository.

- O CI/CD com suporte do Databricks Asset Bundles para pipelines conecta o desenvolvimento de loop interno à implantação. Os administradores de dados podem aplicar testes e automatizar a promoção para a produção usando padrões e arquivos de configuração, tudo sem adicionar complexidade ao fluxo de trabalho de um profissional de dados.

- Automação e observabilidade integradas permitem a execução agendada de pipelines e fornecem acesso rápido a execuções anteriores para monitoramento e solução de problemas.

Ao unificar esses recursos, o editor otimiza o desenvolvimento do dia a dia e as operações de pipeline de longo prazo.

Confira o vídeo abaixo para ver más detalles sobre todos esses recursos em ação.

O que vem a seguir

Não vamos parar por aqui. Aqui está uma prévia do que estamos explorando no momento:

- Suporte nativo para testes de dados em Lakeflow Spark Declarative Pipelines e executores de teste no editor

- Geração de testes assistida por AI para acelerar a validação

- Experiência de agente para Lakeflow Spark Declarative Pipelines.

Conte para a gente o que mais você gostaria de ver — seu feedback impulsiona o que construímos.

Comece a usar a nova experiência de desenvolvedor hoje mesmo

O IDE para engenharia de dados está disponível em todas as clouds. Para habilitá-lo, abra um arquivo associado a um pipeline existente, clique no banner 'Lakeflow Pipelines Editor: OFF' e ative-o. Você também pode habilitá-lo durante a criação do pipeline com uma alternância semelhante ou na página de Configurações do usuário.

Saiba mais usando estes recursos:

- Confira a documentação.

- Assista à palestra Criação de pipelines de dados com o novo editor no Data + AI Summit 2025.

- Confira Lakeflow em Produção: CI/CD, Testes e Monitoramento em Escala no Data + AI Summit 2025.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura