Acelerador de Soluções: LLMs para Manufatura

Publicado: 21 de setembro de 2023

por Bloqueará, Ramdas Murali, Nicole Lu e Bala Amavasai

Desde a publicação do artigo seminal sobre transformers por Vaswani et. al. do Google, os modelos de linguagem grandes (LLMs) passaram a dominar o campo da IA generativa. Sem dúvida, o surgimento do ChatGPT da OpenAI trouxe a publicidade tão necessária e levou ao aumento do interesse no uso de LLMs, tanto para uso pessoal quanto para aqueles que atendem às necessidades corporativas. Nos últimos meses, o Google lançou o Bard e a Meta, com seus modelos Llama 2, demonstraram uma intensa competição por parte das grandes empresas de tecnologia.

As indústrias de manufatura e energia são desafiadas a entregar maior produtividade, o que é agravado pelo aumento dos custos operacionais. Empresas orientadas a dados estão investindo em AI e, mais recentemente, em LLMs. Em essência, as empresas orientadas a dados estão gerando um valor imenso a partir desses investimentos.

A Databricks acredita na democratização das tecnologias de IA. Acreditamos que toda empresa deveria ter a capacidade de ensinar seus próprios LLMs e ser proprietária de seus dados e modelos. Nos setores de manufatura e energia, muitos processos são proprietários, e esses processos são essenciais para manter a liderança ou melhorar as margens operacionais diante de uma concorrência acirrada. As fórmulas secretas são protegidas ao serem mantidas como segredos comerciais, em vez de serem disponibilizadas publicamente por meio de patentes ou publicações. Muitos dos LLMs disponíveis publicamente não atendem a este requisito básico, que exige a entrega de conhecimento.

Em termos de casos de uso, a questão que muitas vezes surge nesta indústria é como aprimorar a força de trabalho atual sem sobrecarregá-la com mais aplicativos e mais dados. Aí reside o desafio de construir e entregar mais aplicativos com AI para a força de trabalho. No entanto, com o surgimento da IA generativa e dos LLMs, acreditamos que esses aplicativos com tecnologia de LLM podem reduzir a dependência de vários aplicativos e consolidar as capacidades de aumento de conhecimento em menos aplicativos.

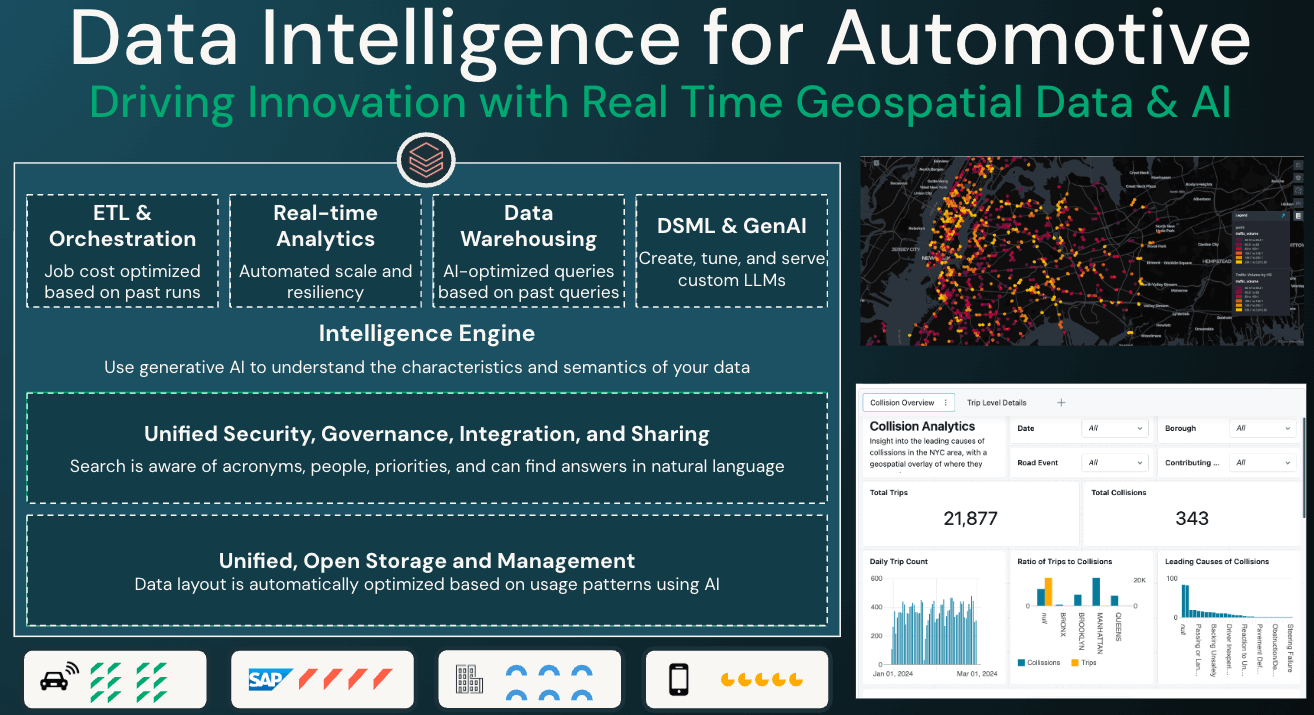

A inteligência de dados transforma indústrias

Vários casos de uso na indústria poderiam se beneficiar dos LLMs. Estes incluem, mas não se limitam a:

- Capacitando os agentes de suporte ao cliente. Os agentes de suporte ao cliente querem poder query quais problemas em aberto/não resolvidos existem para o cliente em questão e fornecer um roteiro guiado por IA para ajudar o cliente.

- Capturando e disseminando conhecimento de domínio por meio de treinamento interativo. A indústria é dominada por um profundo know-how que é frequentemente descrito como conhecimento "tribal". Com o envelhecimento da força de trabalho, vem o desafio de capturar esse conhecimento de domínio permanentemente. Os LLMs poderiam atuar como reservatórios de conhecimento que podem ser facilmente disseminados para treinamento.

- Aumentando a capacidade de diagnóstico dos engenheiros de serviço de campo. Os engenheiros de serviço de campo frequentemente enfrentam o desafio de acessar inúmeros documentos interligados. Ter um LLM para reduzir o tempo de diagnóstico do problema acabará por aumentar a eficiência.

Neste acelerador de soluções, focamos no item (3) acima, que é o caso de uso de capacitar engenheiros de serviço de campo com uma base de conhecimento na forma de uma sessão de Q/A interativa e sensível ao contexto. O desafio que os fabricantes enfrentam é como estruturar e incorporar dados de documentos proprietários em LLMs. O treinamento de LLMs do zero é um exercício muito caro, que custa centenas de milhares, se não milhões de dólares.

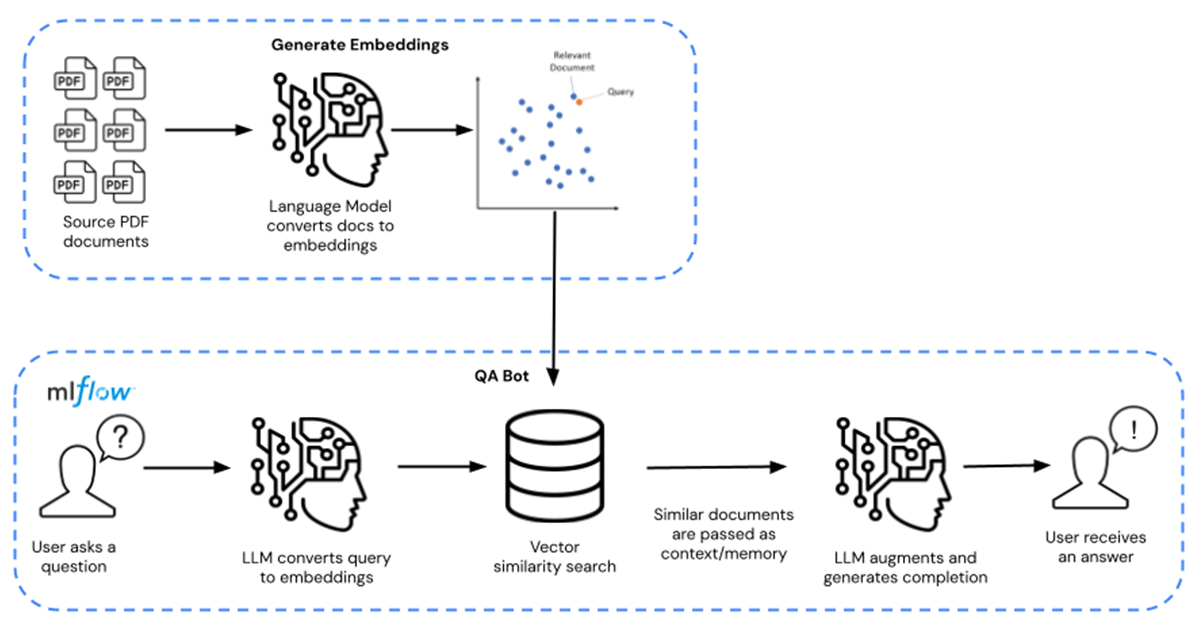

Em vez disso, as empresas podem aproveitar modelos de LLM fundamentais pré-treinados (como o MPT-7B e o MPT-30B da MosaicML) e aprimorar e fazer o ajuste fino desses modelos com seus dados proprietários. Isso reduz os custos para dezenas, se não centenas de dólares, representando uma economia de custos de 10.000x. O caminho completo para o ajuste fino é mostrado da esquerda para a direita, e o caminho para consulta de Q/A é mostrado da direita para a esquerda na Figura 1 abaixo.

Neste acelerador de solução, o LLM é aprimorado com fichas técnicas de produtos químicos disponíveis publicamente e distribuídas no formato de documentos PDF. Isso pode ser substituído por quaisquer dados proprietários de sua escolha. As fichas técnicas são transformadas em embeddings e usadas como um recuperador para o modelo. LangChain foi então usado para compilar o modelo, que é hospedado no MLflow do Databricks. A implantação é feita como um endpoint do Model Serving do Databricks com capacidade de inferência de GPU.

Aprimore sua empresa hoje download destes ativos aqui. Entre em contato com seu representante da Databricks para entender melhor por que a Databricks é a plataforma de escolha para criar e entregar LLMs.

Explore o acelerador de soluções aqui.

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produção industrial

30 de outubro de 2025/9 min de leitura

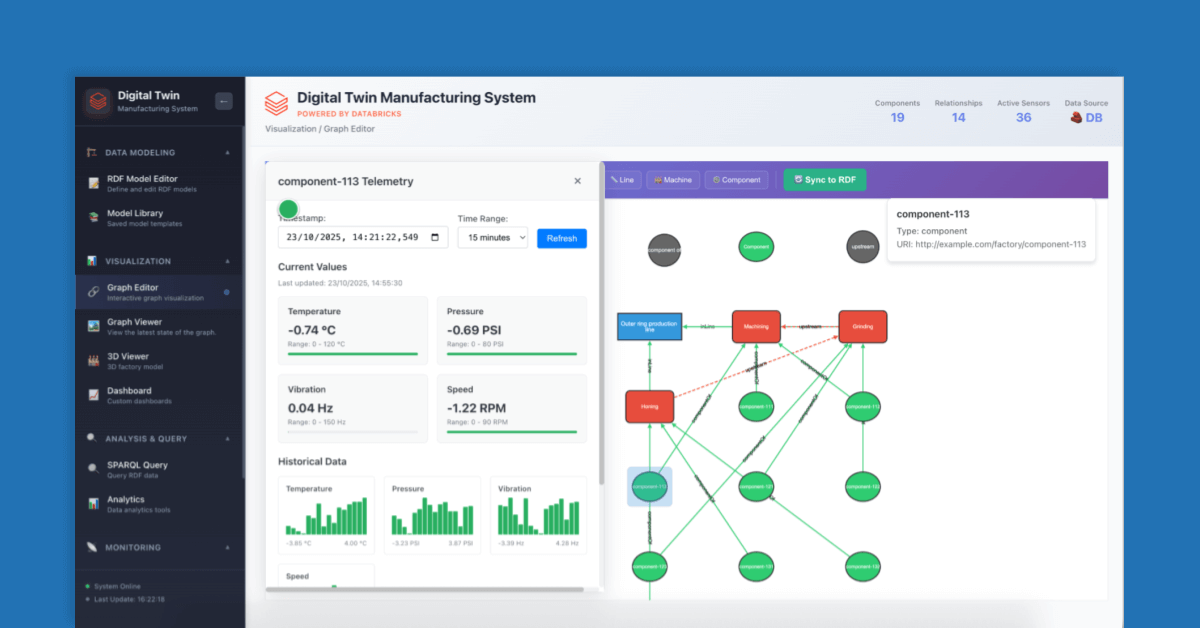

Como construir Gêmeos Digitais para eficiência operacional

Produção industrial

11 de novembro de 2025/9 min de leitura