O que é o Protocolo de Contexto de Modelo (MCP)? Um guia prático para a integração de IA

Introdução: Entendendo o Protocolo de Contexto do Modelo

O Protocolo de Contexto de Modelo (MCP) é um padrão aberto que permite que aplicativos de AI se conectem perfeitamente a fontes de dados, ferramentas e sistemas externos. Pense no Model Context Protocol como uma porta USB-C para sistemas de IA. Assim como uma porta USB-C padroniza a forma como os dispositivos se conectam aos computadores, o MCP padroniza a forma como os agentes de AI acessam recursos externos como bancos de dados, APIs, sistemas de arquivos e bases de conhecimento.

O protocolo de contexto aborda um desafio crítico na construção de agentes de IA: o "problema de integração N×M." Sem um protocolo padronizado, cada aplicativo de IA deve se integrar diretamente a cada serviço externo, criando N×M integrações separadas, onde N representa o número de ferramentas e M representa o número de clientes. Essa abordagem rapidamente se torna impossível de escalar. O Protocolo de Contexto de Modelo (MCP) resolve isso exigindo que cada cliente e cada servidor MCP implementem o protocolo apenas uma vez, reduzindo o total de integrações de N×M para N+M.

Ao permitir que os sistemas de AI acessem dados tempo-real além dos dados de treinamento do LLM, o MCP ajuda os modelos de AI a fornecer respostas precisas e atualizadas, em vez de depender apenas de dados de treinamento estáticos de sua fase inicial de aprendizado.

Continue explorando

O que é um protocolo de contexto de modelo?

O Protocolo de Contexto do Modelo é um padrão unificado de código aberto para interoperabilidade que permite que os desenvolvedores criem aplicativos de AI com reconhecimento de contexto. O MCP complementa as LLMOps ao expor a integração em Runtime, a observabilidade e os controles de governança que simplificam a implantação, o monitoramento e o gerenciamento do ciclo de vida de aplicativos LLM.

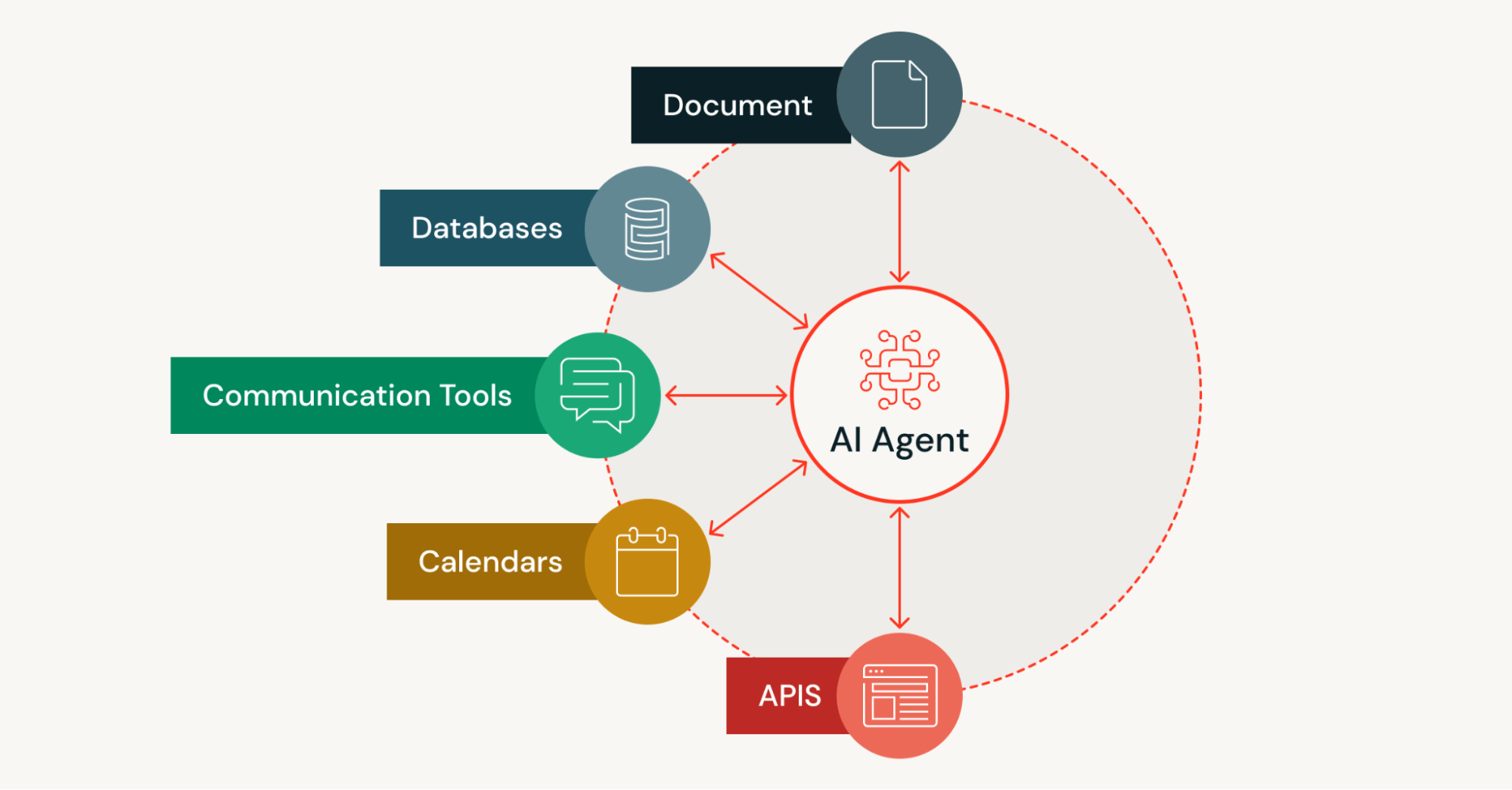

As aplicações de IA precisam de acesso a ativos como recursos locais, bancos de dados, pipelines de dados (transmissão/lotes), mecanismos de pesquisa, calculadoras e fluxos de trabalho para condicionamento de prompts e geração de embasamento. O protocolo de contexto padroniza como os aplicativos se conectam a esses ativos por meio de uma forma estruturada que reduz o código de integração repetitivo.

O problema da escalabilidade significa que os modelos de AI (grandes modelos de linguagem em particular) normalmente precisam depender de dados pré-existentes e estáticos para o treinamento. Isso pode levar a respostas imprecisas ou desatualizadas, porque modelos treinados em datasets estáticos precisam de atualizações adicionais para incorporar novas informações. Ao abordar a escalabilidade, o MCP permite que os aplicativos de AI sejam cientes do contexto e forneçam resultados atualizados que não são restringidos pelas limitações dos dados de treinamento estáticos.

O que é MCP e por que ele é usado?

O Model Context Protocol (MCP) serve como uma forma padronizada para que os aplicativos de IA descubram e interajam com ferramentas e fontes de dados externas em Runtime. Em vez de codificar conexões para cada serviço externo, os agentes de IA que usam o MCP podem descobrir dinamicamente as ferramentas disponíveis, entender suas capacidades por meio de chamadas estruturadas e invocá-las com as permissões de ferramenta adequadas.

O MCP é usado porque transforma a forma como as ferramentas com tecnologia de AI acessam informação. Os sistemas de IA tradicionais são limitados pelos seus dados de treinamento, que se tornam desatualizados rapidamente. O protocolo de contexto permite que os desenvolvedores criem agentes de IA que podem executar tarefas usando dados em tempo real de sistemas empresariais populares, ambientes de desenvolvimento e outras fontes externas, tudo por meio de um único protocolo padronizado.

O protocolo aberto também reduz o código de integração repetitivo. Em vez de escrever conectores personalizados para cada nova integração, os desenvolvedores implementam o MCP uma vez, tanto no lado do cliente quanto no do servidor. Essa abordagem é especialmente valiosa para sistemas de IA agênticos que precisam descobrir e usar de forma autônoma várias ferramentas em diferentes contextos.

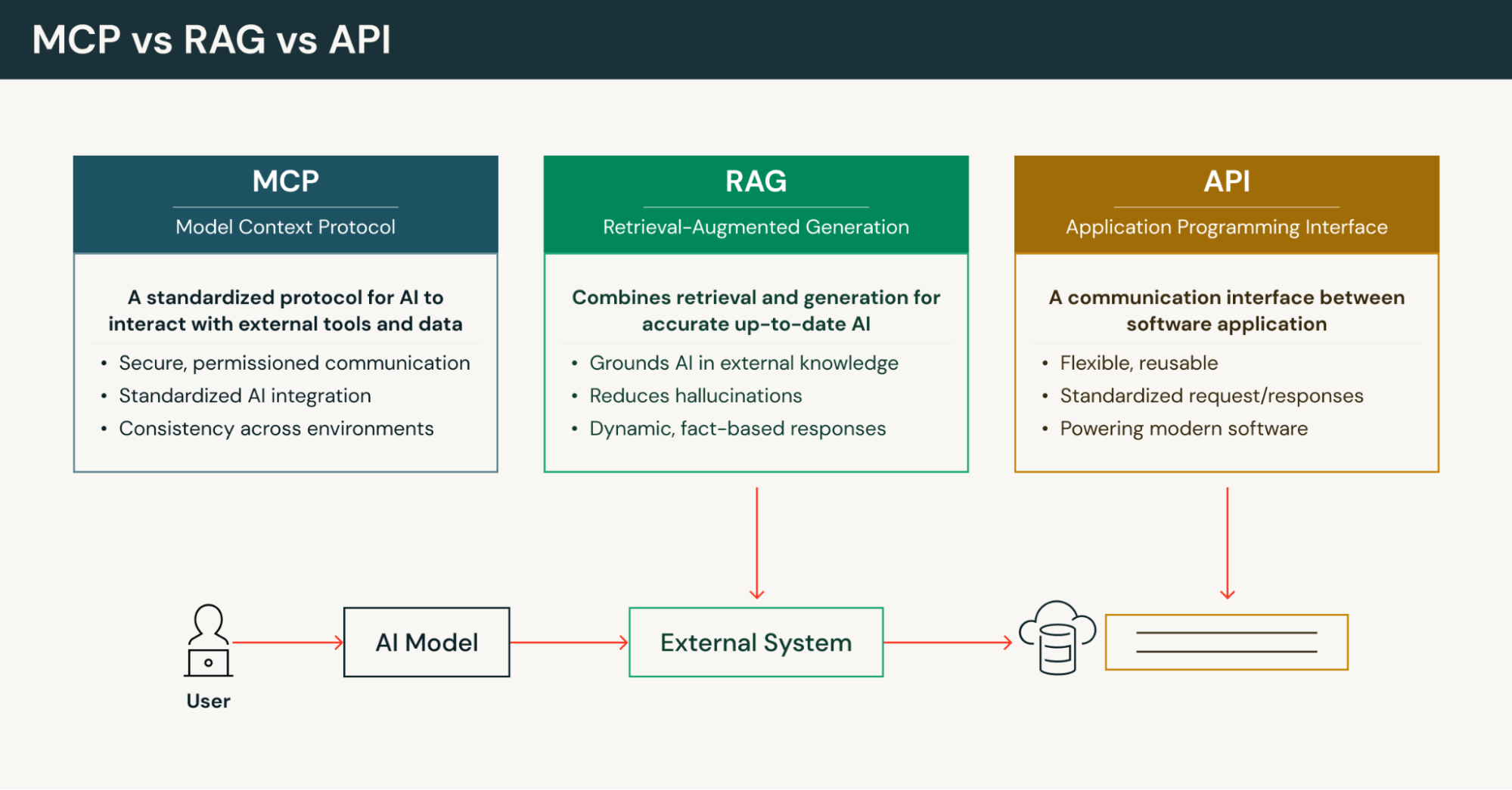

O que é MCP vs. API?

Limitações das APIs tradicionais

APIs tradicionais expõem endpoints com parâmetros tipados que os clientes devem codificar e atualizar sempre que uma API muda. A junção de contexto se torna responsabilidade do cliente, pois as APIs fornecem orientação semântica mínima sobre como os dados retornados devem ser usados. Uma solicitação de API geralmente segue um padrão simples de solicitação-resposta, sem manter estado ou contexto entre as chamadas.

Como o Protocolo de Contexto do Modelo se diferencia

O MCP define uma abordagem diferente das APIs tradicionais. Em vez de Endpoints fixos, os servidores MCP expõem uma superfície de capacidade legível por máquina, detectável em Runtime. Os sistemas de IA podem consultar ferramentas, recurso e prompts disponíveis em vez de depender de conexões predefinidas. O Protocolo de Contexto do Modelo padroniza os formatos de recurso (documentos, linhas de banco de dados, arquivos), reduzindo a complexidade da serialização para que os modelos de IA recebam um contexto relevante e otimizado para o raciocínio.

As implementações de MCP suportam comunicação bidirecional com estado e com semântica de transmissão. Isso permite que os servidores MCP enviem atualizações e notificações de progresso diretamente para o loop de contexto de um agente de IA, dando suporte a fluxos de trabalho de várias etapas e resultados parciais que as APIs tradicionais não conseguem fornecer nativamente. Essa arquitetura cliente-servidor permite padrões de uso de ferramentas mais sofisticados em sistemas agênticos.

MCP versus RAG: abordagens complementares

A Geração Aumentada por Recuperação (RAG) melhora a precisão da IA ao converter documentos em embeddings, armazená-los em bancos de dados vetoriais e recuperar informações relevantes durante a geração. No entanto, o RAG geralmente se baseia em fontes estáticas e indexadas de repositórios de conteúdo. O Protocolo de Contexto do Modelo fornece acesso sob demanda a APIs, bancos de dados e transmissões ao vivo, retornando um contexto oficial e atualizado quando a atualização dos dados é importante.

Diferentemente do RAG, que retorna principalmente um contexto somente leitura, o protocolo de contexto separa os recursos das ferramentas para que os agentes de AI possam buscar dados e executar tarefas em sistemas externos com esquemas controlados. O MCP atende a necessidades de integração mais amplas — permitindo fluxos de trabalho agênticos, orquestração de várias etapas, descoberta de recursos em Runtime e governança multitenant — que o RAG não fornece nativamente.

O MCP pode complementar as implementações de RAG. As organizações podem usar o RAG para indexar conteúdo perene para recuperação rápida, enquanto usam o Model Context Protocol para pesquisas transacionais, execução de queries SQL e ações que exigem o contexto certo de sistemas ativos. Essa abordagem híbrida oferece velocidade e precisão.

O valor da padronização no ecossistema MCP

Como um protocolo bidirecional e detectável em Runtime, o Protocolo de Contexto de Modelo transforma ferramentas e dados externos díspares em recursos endereçáveis e ações chamáveis. Um único cliente MCP pode descobrir uniformemente arquivos, linhas de banco de dados, trechos de vetores, transmissões ao vivo e Endpoints de API. Coexistindo com caches RAG indexados, o MCP oferece buscas autoritativas e em tempo real, além de semântica de ação.

O resultado prático é menos conectores personalizados, menos código customizado, integrações mais rápidas e sistemas de agentes mais confiáveis com tratamento de erros adequado e trilhas de auditoria. Essa forma padronizada de conectar assistentes de IA a recursos remotos acelera os ciclos de desenvolvimento, mantendo os controles de segurança empresariais. O ecossistema MCP se beneficia dessa padronização à medida que mais implementações de servidores MCP se tornam disponíveis para sistemas empresariais populares.

Arquitetura principal do MCP: entendendo o modelo cliente-servidor

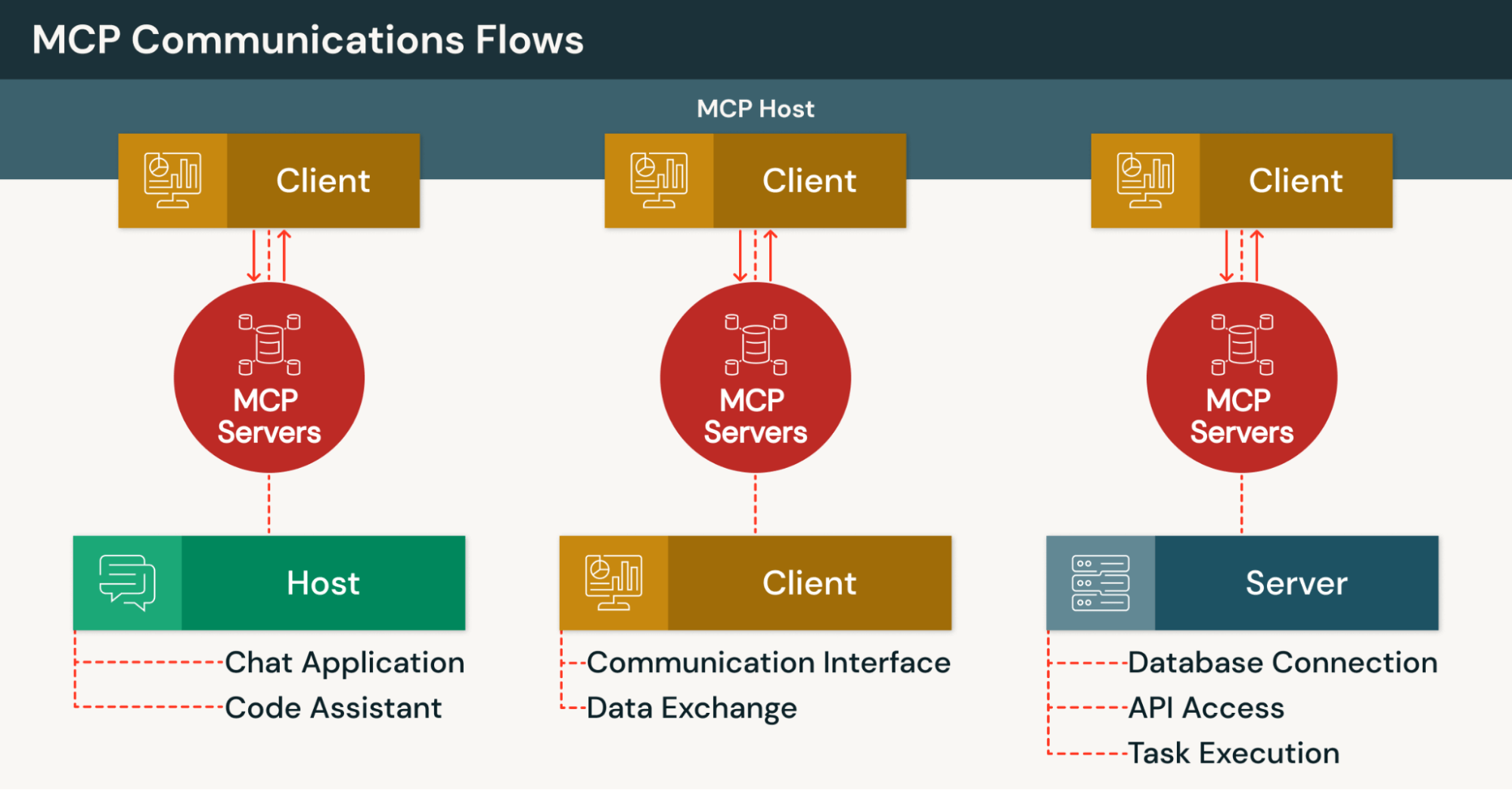

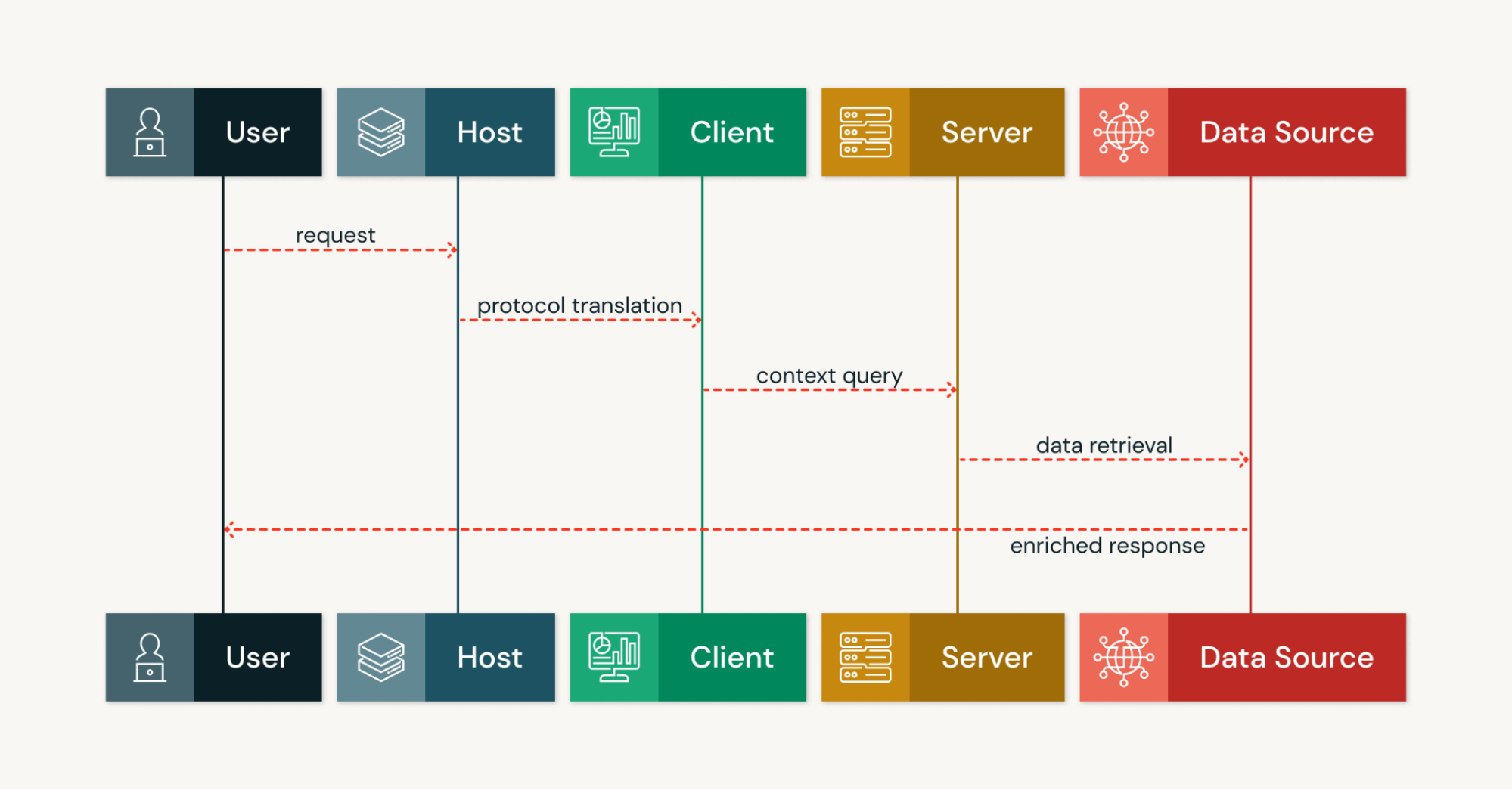

A arquitetura MCP organiza as integrações em torno de três papéis principais — servidores MCP, clientes MCP e hosts MCP — conectados por meio de canais de comunicação persistentes. Essa arquitetura cliente-servidor permite que as ferramentas de AI executem fluxos de trabalho com estado e de várias etapas, em vez de interações de solicitação-resposta isoladas.

O que os servidores MCP fazem

Os servidores MCP expõem dados e ferramentas por meio de interfaces padronizadas e podem ser executados em ambientes de nuvem, on-premises ou híbridos. Cada servidor publica uma superfície de capacidade de recursos nomeados, ferramentas chamáveis, prompts e ganchos de notificação. Os recursos podem incluir documentos, linhas de banco de dados, arquivos e saídas de pipeline.

As implementações de servidor MCP usam métodos e notificações JSON-RPC 2.0, suportam transmissão para operações de longa duração e fornecem descoberta legível por máquina através da camada de transporte. Isso permite que hosts MCP e modelos de IA consultem as capacidades em Runtime sem exigir conhecimento prévio das ferramentas disponíveis.

Implementações de servidor MCP populares conectam sistemas de IA a serviços externos como Google Drive, Slack, GitHub e bancos de dados PostgreSQL. Esses servidores MCP gerenciam autenticação, recuperação de dados e execução de ferramentas, apresentando uma interface consistente por meio do protocolo padronizado. Cada servidor no ecossistema MCP pode atender a vários clientes simultaneamente.

Como os clientes MCP funcionam

Clientes MCP são componentes em aplicativos host que traduzem as intenções do usuário ou do modelo em mensagens de protocolo. Cada cliente normalmente mantém uma conexão um para um com um servidor MCP e gerencia o ciclo de vida, a autenticação e os detalhes de transporte de forma estruturada.

Os clientes MCP serializam solicitações como chamadas estruturadas usando JSON-RPC, lidam com notificações assíncronas e transmissões parciais e apresentam uma API local unificada para reduzir a complexidade da integração. Vários clientes podem operar a partir do mesmo host MCP, cada um se conectando a diferentes servidores MCP simultaneamente.

Esses clientes permitem que os agentes de AI interajam com fontes de dados externas sem entender os detalhes de implementação de cada serviço externo. O cliente lida com todos os protocolos de comunicação, tratamento de erros e lógica de repetição automaticamente.

O papel dos Hosts MCP

Os hosts MCP fornecem a camada de aplicação de IA que coordena os clientes MCP e os recursos do servidor. Os exemplos incluem o Claude Desktop, o Claude Code, IDEs com tecnologia de IA e outras plataformas em que os agentes de IA operam. O host MCP agrega prompts, estado de conversação e respostas do cliente para orquestrar fluxos de trabalho de múltiplas ferramentas.

O host do MCP decide quando chamar ferramentas, solicitar entradas adicionais ou exibir notificações. Essa orquestração centralizada permite que os modelos de IA funcionem em servidores MCP heterogêneos sem código personalizado por serviço, apoiando o objetivo do ecossistema MCP de interoperabilidade universal na conexão de assistentes de IA a diversos sistemas.

Fluxo de contexto e comunicação bidirecional

A comunicação cliente-servidor no Protocolo de Contexto do Modelo é bidirecional e orientada por mensagens, usando JSON-RPC 2.0 na camada de transporte. Os clientes MCP chamam métodos para buscar recursos ou invocar ferramentas, enquanto os servidores MCP retornam resultados, transmitem saídas parciais e enviam notificações com informações relevantes.

Os servidores MCP também podem iniciar solicitações, pedindo aos hosts MCP para amostrar opções ou solicitar a entrada do usuário por meio de mecanismos de chamada de função. Essa capacidade bidirecional distingue o protocolo de contexto dos padrões de API unidirecionais tradicionais. As consultas autoritativas em tempo real do MCP complementam o RAG, fornecendo registros just-in-time com metadados de procedência para rastreabilidade.

Transportes persistentes preservam a ordem das mensagens e permitem atualizações em tempo real, permitindo que sistemas de IA iterem sobre saídas intermediárias e executem loops de agentes que tornam possíveis os agentes de IA autônomos.

Quais são os requisitos para o Protocolo de Contexto do Modelo?

Requisitos de segurança e proteção contra ameaças

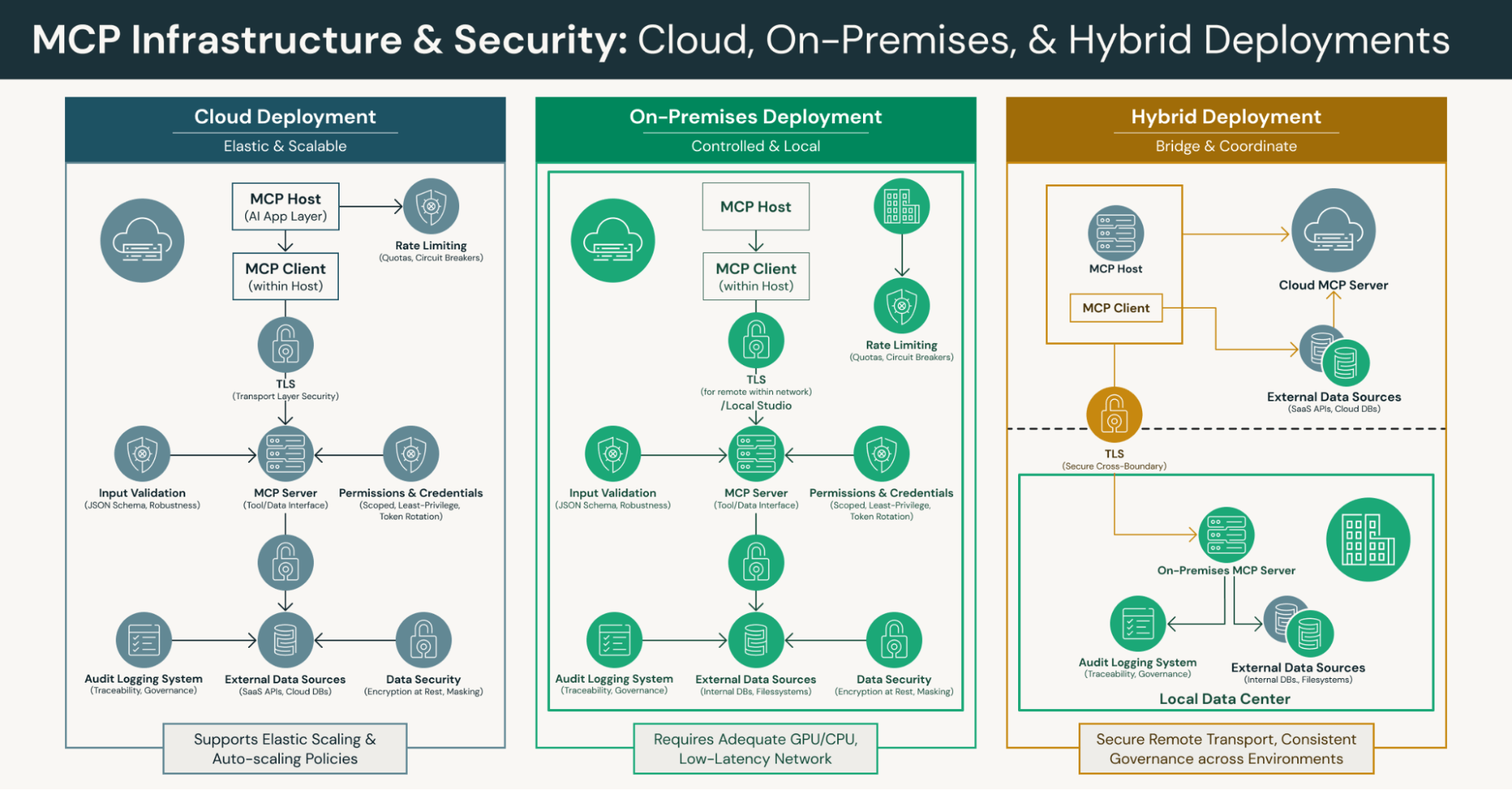

As implementações do MCP devem impor Transport Layer Security (TLS) para transportes remotos, permissões de ferramenta rigorosas e credenciais com escopo definido para proteção contra ameaças de segurança. O protocolo requer rate limiting e validação de entrada robusta por meio da imposição de esquema JSON tanto nos clientes quanto nos servidores MCP para evitar ataques de injeção e solicitações malformadas.

Registro de auditoria, rotação de token e concessões de privilégio mínimo são requisitos essenciais para governar canais de longa duração. Essas medidas de segurança protegem contra o acesso não autorizado, ao mesmo tempo que preservam os recursos de integração detectáveis que o Protocolo de Contexto de Modelo possibilita. As organizações devem implementar criptografia em trânsito e em repouso, mascaramento e permissões com escopo definido para canais MCP de longa duração para garantir a segurança dos dados.

Requisitos de infraestrutura e sistema

As organizações que implementam o MCP precisam de uma infraestrutura de compute e rede que possa hospedar modelos de linguagem grandes, servidores MCP e fontes de dados conectadas. Isso inclui capacidade adequada de GPU/CPU, memória, E/S de disco e caminhos de rede de baixa latência entre os componentes na arquitetura cliente-servidor.

As plataformas de cloud devem suportar o dimensionamento elástico de instâncias de modelo e servidores MCP. As equipes devem definir políticas de autoscale para transmissões concorrentes e operações de longa duração. A camada de transporte deve suportar tanto STDIO local para componentes incorporados quanto canais de transmissão remotos como HTTP/SSE ou WebSocket para implantações distribuídas.

Requisitos de implementação para o funcionamento do MCP

O trabalho com MCP requer a implementação de mensagens JSON-RPC 2.0, endpoints de descoberta e esquemas de recurso/ferramentas. Os servidores MCP devem publicar suas capacidades em um formato legível por máquina por meio do protocolo padrão. Isso permite que os desenvolvedores criem integrações baseadas em descoberta que suportam a descoberta de ferramentas sem conexões codificadas.

Tratamento de erros, estratégias de reconexão e gerenciamento de contrapressão são requisitos críticos de implementação para a confiabilidade da produção. As organizações devem implementar a observabilidade para transmissões persistentes, latências de métodos e uso de recurso usando métricas, rastreamentos e logs. Limitadores de taxa, disjuntores e cotas protegem os sistemas downstream contra sobrecarga.

Benefícios práticos: acesso a dados tempo-real e redução de alucinações

Com o Protocolo de Contexto do Modelo, os modelos de IA recuperam registros em tempo real, saídas de pipeline, respostas de API e arquivos sob demanda, em vez de dependerem apenas de embeddings armazenados em cache ou dos dados de treinamento estáticos do LLM. Isso baseia as respostas em fontes de dados atuais e autoritativas e reduz as alucinações, em que os sistemas de IA geram informações incorretas.

Os recursos retornados no momento da query incluem metadados de procedência, como IDs de origem e Timestamps, permitindo que os hosts MCP registrem as origens e tornem as saídas rastreáveis. Essa transparência é crucial quando os agentes de IA executam tarefas que exigem auditabilidade em indústrias regulamentadas. O protocolo de contexto garante que o contexto relevante esteja sempre disponível a partir de sistemas externos autoritativos.

Suporte para fluxos de trabalho de IA agêntica

Como os servidores MCP publicam recursos, ferramentas e prompts de forma padronizada, os modelos de AI podem descobrir e chamar serviços sem Endpoints fixos. O padrão aberto suporta a solicitação iniciada pelo servidor e respostas de transmissão de servidores MCP, permitindo o raciocínio em várias etapas, o esclarecimento de entradas e a iteração sobre resultados parciais.

As ferramentas expõem entradas/saídas definidas por JSON Schema com permissões de ferramenta com escopo definido, permitindo que agentes de AI executem ações controladas, como criar tíquetes, executar queries SQL ou executar fluxos de trabalho. Essa descoberta autônoma de ferramentas, interação bidirecional e proteções integradas fornecem a base para uma IA agentiva confiável em sistemas externos.

O Protocolo de Contexto de Modelo (MCP) permite explicitamente fluxos de trabalho agênticos que dependem da descoberta dinâmica de ferramentas e de primitivas de ação para perceber, decidir e agir em todos os sistemas. Isso possibilita a criação de agentes de IA que operam de forma autônoma, mantendo os devidos controles de governança.

Desenvolvimento simplificado com integrações padronizadas

O protocolo de contexto permite que os desenvolvedores implementem uma única superfície de servidor que os hosts MCP e os modelos de IA podem reutilizar com descoberta e semântica de chamada consistentes. Isso elimina conectores separados para serviços comuns, reduzindo o esforço de engenharia necessário para conectar assistentes de IA a novas fontes de dados.

Recursos tipados e o JSON Schema reduzem o código personalizado de serialização, validação e tratamento de erros que, de outra forma, seria necessário. Transportes locais de STDIO ou transmissão remota permitem que as equipes escolham implantações on-premises, na cloud ou híbridas sem alterar a lógica do host MCP. Essa flexibilidade acelera a forma como as equipes criam agentes de IA em diferentes ambientes de desenvolvimento.

O MCP oferece uma maneira prática de padronizar as integrações uma única vez, em vez de criar adaptadores personalizados para cada nova integração. Essa abordagem de protocolo padronizado beneficia todo o ecossistema MCP à medida que mais organizações adotam o padrão.

Maior Potencial de Automação para Fluxos de Trabalho Complexos

Os canais persistentes e com estado do MCP permitem que os sistemas de AI combinem pesquisas, transformações e efeitos colaterais em vários serviços externos em um único loop contínuo. Para operações de longa duração, os servidores MCP podem transmitir resultados parciais para que os agentes de IA tomem decisões intermediárias, bifurquem fluxos de trabalho ou solicitem a intervenção humana quando necessário.

A combinação da recuperação indexada para repositórios de conteúdo perene com as buscas autoritativas sob demanda do Protocolo de Contexto do Modelo permite respostas rápidas e precisas. Essa abordagem híbrida mantém os controles de governança e, ao mesmo tempo, permite que ferramentas com AI acessem tanto bases de conhecimento estáticas quanto fontes de dados externas dinâmicas.

O suporte do protocolo de contexto para orquestração de várias etapas permite que sistemas agênticos lidem com fluxos de trabalho complexos que exigem coordenação entre várias ferramentas e fontes de dados. Esse potencial de automação transforma a forma como as organizações implantam aplicativos de IA em ambientes de produção.

Melhores práticas de implementação: Preparação do sistema

Valide se sua infraestrutura pode suportar a hospedagem de LLM, servidores MCP e fontes de dados conectadas. Garanta recursos de GPU/CPU, alocação de memória e largura de banda de rede adequados para a arquitetura cliente-servidor. Escolha plataformas de cloud que suportem escalonamento elástico para usuários concorrentes e defina políticas de escalonamento autoscale.

Padronize transportes seguros usando TLS para todas as conexões remotas entre clientes e servidores MCP. Documente o gerenciamento do ciclo de vida da conexão, incluindo estratégias de reconexão e métricas observáveis de integridade da transmissão. Implemente limites de taxa, disjuntores (circuit breakers) e cotas para proteger os sistemas externos downstream contra sobrecarga.

As organizações devem padronizar os canais de transmissão (HTTP/SSE, WebSocket), além do STDIO local para componentes incorporados. Valide as cargas úteis e o esquema JSON tanto no servidor quanto no cliente para evitar ataques de injeção e garantir o tratamento adequado de erros em todo o sistema.

Aproveitamento de Recursos de Código Aberto em Linguagens de Programação

O ecossistema MCP inclui SDKs da comunidade em várias linguagens de programação que aceleram o desenvolvimento de clientes e servidores. Esses SDKs fornecem padrões estabelecidos para mensagens JSON-RPC, transmissão e validação de esquemas, eliminando a necessidade de reimplementar a estrutura básica do protocolo.

Os desenvolvedores podem reutilizar implementações de servidor MCP existentes para sistemas empresariais populares e estendê-las para casos de uso específicos do domínio por meio do padrão aberto. Construir simuladores que imitam notificações, transmissões de longa duração e condições de erro ajuda as equipes a testar sistemas agênticos antes da implantação em produção.

Adote recursos da comunidade para acelerar o trabalho com MCP e evitar a recriação de funcionalidades comuns. Essas ferramentas de código aberto permitem que os desenvolvedores se concentrem na lógica de negócios em vez dos detalhes de implementação do protocolo.

Estratégia de integração para implantação em produção

Comece com casos de uso de alto impacto que demonstrem ROI mensurável, como assistentes de IA com reconhecimento de contexto ou fluxos de trabalho automatizados usando agentes de IA. Limite os escopos e as permissões iniciais das ferramentas, colete telemetria e feedback do usuário e, em seguida, expanda os recursos após estabilizar a funcionalidade principal.

Equilibre a latência e a atualidade dos dados combinando as buscas ao vivo do MCP com o RAG para grandes corpora estáticos de repositórios de conteúdo. Defina SLAs, trilhas de auditoria e procedimentos de escalonamento antes da implantação em produção em larga escala. Essa abordagem em fases reduz o risco ao mesmo tempo que aumenta a confiança organizacional em implantações de IA agentiva.

O MCP atende à necessidade de planos de integração estruturados que escalam à medida que mais servidores e clientes MCP são adicionados ao ecossistema. As organizações devem documentar sua arquitetura de integração e suas políticas de governança no início do processo de implantação.

Equívocos comuns: o MCP não é apenas mais um framework de API

Realidade: O Model Context Protocol (Protocolo de Contexto de Modelo) padroniza a integração no nível do protocolo com gerenciamento de contexto persistente e descoberta de capacidade dinâmica. Diferentemente das chamadas REST ou RPC, o MCP define como os agentes de AI descobrem capacidades, se inscrevem em transmissões e mantêm o estado contextual entre as interações por meio do protocolo padrão.

Este protocolo padronizado significa que você pode criar ferramentas uma vez e expô-las uniformemente a vários agentes de IA e provedores de modelos por meio do ecossistema MCP. Em vez de tratar o contexto do modelo como uma carga efêmera, o protocolo de contexto aborda o contexto como um recurso de primeira classe e versionado com gerenciamento de ciclo de vida adequado.

Ferramentas e Agentes São Componentes Diferentes

Realidade: as ferramentas são recursos discretos expostos por meio de servidores MCP, como acesso a banco de dados, operações de arquivo ou integrações de API. Os agentes de AI são programas de computador para tomada de decisões que descobrem, orquestram e invocam as ferramentas disponíveis para executar tarefas de forma autônoma.

O protocolo de contexto permite que agentes de IA descubram metadados de ferramentas dinamicamente, invoquem interfaces de ferramentas com segurança com semântica de chamada de função e integrem os resultados nas conversas por meio de clientes MCP. Essa separação permite que diferentes sistemas agênticos usem o mesmo catálogo de ferramentas, enquanto os proprietários das ferramentas atualizam as interfaces independentemente da lógica do agente.

O MCP Gerencia a Conectividade Abrangente de Dados

Realidade: o Protocolo de Contexto do Modelo gerencia a conectividade abrangente com fontes de dados externas, além do simples uso de ferramentas. Ele suporta notificações por transmissão, acesso autenticado a repositórios de conteúdo e bancos de vetores, e semântica consistente para operações de longa duração e tratamento de erros.

O MCP oferece uma maneira prática de unificar o acesso a recursos locais, recursos remotos, query de dados ao vivo e ações operacionais de forma estruturada. Essa abordagem unificada ajuda a governança, a observabilidade e o controle de acesso a escalar junto com as capacidades de IA em ambientes corporativos. O protocolo de contexto lida com outras ferramentas e serviços externos por meio de uma interface consistente.

Direções de Pesquisa Futuras e Evolução

À medida que o padrão aberto amadurece, as futuras direções de pesquisa incluem estruturas de segurança aprimoradas para implantações multilocatário, semântica de transmissão aprimorada para fluxos de trabalho agênticos complexos e padrões padronizados para integração com linguagens de programação e ambientes de desenvolvimento adicionais.

O crescente ecossistema MCP continua a se expandir com novas implementações de servidor MCP para ferramentas e plataformas externas emergentes. As contribuições da comunidade para SDKs, adaptadores e arquiteturas de referência aceleram a adoção, ao mesmo tempo que mantêm o objetivo principal do protocolo: permitir que qualquer aplicativo de AI se conecte a qualquer serviço externo de forma padronizada.

As organizações que exploram o Model Context Protocol devem monitorar os desenvolvimentos do ecossistema, contribuir para as implementações do MCP e participar de grupos de trabalho que moldam a evolução da conexão de assistentes de AI a sistemas externos. Essa abordagem colaborativa garante que as implementações do MCP permaneçam interoperáveis à medida que os sistemas de AI e os serviços externos continuam a avançar. As futuras direções de pesquisa provavelmente se concentrarão em expandir as capacidades do protocolo, mantendo sua simplicidade central.

Conclusão: o Protocolo de Contexto do Modelo como base para a AI moderna

O Protocolo de Contexto do Modelo representa uma mudança fundamental na forma como as aplicações de AI acessam fontes de dados e ferramentas externas. Ao fornecer um protocolo aberto para integração baseada em descoberta, o protocolo de contexto permite que os desenvolvedores criem agentes de IA com reconhecimento de contexto que podem executar tarefas usando dados em tempo real de sistemas empresariais populares sem a necessidade de um extenso código de integração repetitivo.

O protocolo padronizado reduz a complexidade por meio da arquitetura cliente-servidor, acelera os ciclos de desenvolvimento e permite que os sistemas de AI superem as limitações dos dados de treinamento estáticos dos LLMs. Por meio de sua comunicação bidirecional entre clientes e servidores MCP e do suporte para fluxos de trabalho de IA agentiva, o Protocolo de Contexto de Modelo (MCP) estabelece a base para ferramentas de IA mais capazes e autônomas em diversos ambientes.

À medida que o ecossistema MCP cresce com novas implementações de servidores MCP e integrações, as organizações podem criar agentes de AI sofisticados que descobrem e orquestram vários serviços externos, mantendo as permissões de ferramenta, os controles de segurança e as trilhas de auditoria adequados. Essa abordagem padronizada para conectar sistemas de IA com ferramentas e fontes de dados externas continuará a moldar como as empresas implantam aplicações de IA em produção. O protocolo de contexto fornece a infraestrutura essencial que permite aos desenvolvedores criar aplicações de AI de última geração com confiança.