Neste blog, mergulhamos no Aprendizado de Agente a partir de Feedback Humano (ALHF) — um novo paradigma de aprendizado de máquina onde os agentes aprendem diretamente de feedbacks mínimos em linguagem natural, não apenas recompensas numéricas ou rótulos estáticos. Isso possibilita uma adaptação de agente mais rápida e intuitiva para aplicações empresariais, onde as expectativas são frequentemente especializadas e difíceis de formalizar.

O ALHF alimenta o produto Agent Bricks da Databricks. Em nosso estudo de caso, analisamos o Agent Bricks Assistente de Conhecimento (KA) - que melhora continuamente suas respostas através do feedback de especialistas. Como mostrado na Figura 1, o ALHF aumenta drasticamente a qualidade geral da resposta no Databricks DocsQA com apenas 4 registros de feedback. Com apenas 32 registros de feedback, quadruplicamos a qualidade da resposta em relação às linhas de base estáticas. Nosso estudo de caso demonstra a eficácia do ALHF e abre uma nova direção interessante para a pesquisa de agentes.

A Promessa de Agentes de IA Ensináveis

Ao trabalhar com clientes corporativos da Databricks, um desafio chave que vimos é que muitos casos de uso de IA corporativa dependem de lógica de negócios altamente especializada, dados proprietários e expectativas intrínsecas, que não são conhecidos externamente (veja nosso Benchmark de Inteligência de Domínio para saber mais). Portanto, mesmo os sistemas mais avançados ainda precisam de ajustes substanciais para atender ao limiar de qualidade dos casos de uso corporativos.

Para ajustar esses sistemas, as abordagens existentes dependem de saídas de verdade absoluta explícitas, que são caras para coletar, ou modelos de recompensa, que fornecem apenas sinais binários/escalares. Para resolver esses desafios, descrevemos Aprendizado de Agente a partir de Feedback Humano (ALHF), um paradigma de aprendizado onde um agente adapta seu comportamento incorporando uma pequena quantidade de feedback em linguagem natural de especialistas. Este paradigma oferece um canal natural e econômico para interação humana e permite que o sistema aprenda a partir de sinais de expectativa ricos.

Exemplo

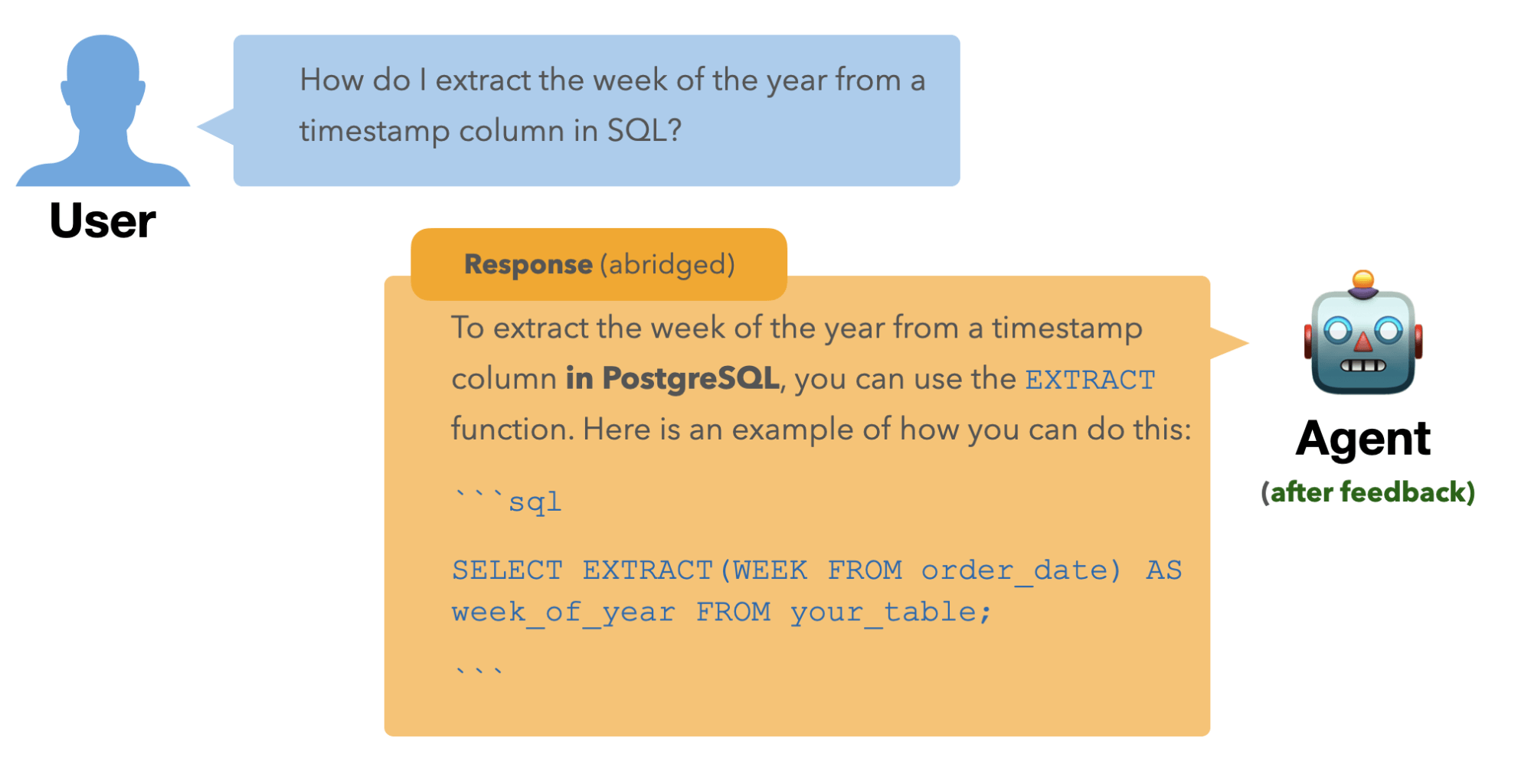

Digamos que criamos um agente de Resposta a Perguntas (QA) para responder perguntas para uma empresa de banco de dados hospedado. Aqui está um exemplo de pergunta:

O agente sugeriu o uso da função weekofyear(), suportada em várias versões de SQL (MySQL, MariaDB, etc.). Esta resposta está correta, pois quando usada adequadamente, weekofyear() atinge a funcionalidade desejada. No entanto, ela não é suportada em PostgreSQL, a versão de SQL preferida pelo nosso grupo de usuários. Nosso Especialista no Assunto (SME) pode fornecer feedback em linguagem natural sobre a resposta para comunicar essa expectativa como acima, e o agente se adaptará de acordo:

O ALHF adapta as respostas do sistema não apenas para esta única pergunta, mas também para perguntas em conversas futuras onde o feedback é relevante, por exemplo:

Como este exemplo mostra, o ALHF oferece aos desenvolvedores e SMEs uma maneira intuitiva e sem atritos de direcionar o comportamento de um agente usando linguagem natural - alinhando-o com suas expectativas.

ALHF em Agent Bricks

Vamos usar um caso de uso específico do produto Agent Bricks - Assistente de Conhecimento - como um estudo de caso para demonstrar o poder do ALHF.

Assistente de Conhecimento (KA) fornece uma abordagem declarativa para criar um chatbot sobre seus documentos, fornecendo respostas de alta qualidade e confiáveis com citações. KA utiliza o ALHF para aprender continuamente as expectativas dos especialistas a partir do feedback em linguagem natural e melhorar a qualidade de suas respostas.

O KA primeiro pede instruções de tarefa de alto nível. Uma vez conectado às fontes de conhecimento relevantes, ele começa a responder perguntas. Os especialistas podem então usar o modo Melhorar Qualidade para revisar as respostas e deixar feedback, que o KA incorpora através do ALHF para refinar as respostas futuras.

Avaliação

Para demonstrar o valor do ALHF no KA, avaliamos o KA usando DocsQA – um conjunto de dados de perguntas e respostas de referência na documentação do Databricks, parte do nosso Benchmark de Inteligência de Domínio. Para este conjunto de dados, também temos um conjunto de expectativas de especialistas definidas. Para um pequeno conjunto de respostas candidatas geradas pelo KA, criamos um feedback conciso em linguagem natural (como no exemplo acima) com base nessas expectativas e fornecemos o feedback ao KA para refinar suas respostas. Em seguida, medimos a qualidade da resposta em várias rodadas de feedback para avaliar se o KA se adapta com sucesso para atender às expectativas dos especialistas.

Note que, embora as respostas de referência reflitam correção factual — se uma resposta contém informações relevantes e precisas para responder à pergunta — elas não são necessariamente ideais em termos de alinhamento com as expectativas do especialista. Como ilustrado em nosso exemplo anterior, a resposta inicial pode ser factualmente correta para muitos tipos de SQL, mas ainda pode ser insuficiente se o especialista espera uma resposta específica para PostgreSQL.

Considerando essas duas dimensões de correção, avaliamos a qualidade de uma resposta usando dois juízes LLM:

- Completude da Resposta: Quão bem a resposta se alinha com a resposta de referência do conjunto de dados. Isso serve como uma medida base de correção factual.

- Feedback Adesão: Quão bem a resposta satisfaz as expectativas específicas do especialista. Isso mede a capacidade do agente de personalizar sua saída com base em critérios personalizados.

Resultados

A Figura 2 mostra como a qualidade do KA melhora com o aumento das rodadas de feedback do especialista no DocsQA. Nós reportamos resultados para um conjunto de testes separado.

- Completude da Resposta: Sem feedback, o KA já produz respostas de alta qualidade comparáveis aos principais sistemas concorrentes. Com até 32 peças de feedback, a Completude da Resposta do KA melhora em 12 pontos percentuais, superando claramente os concorrentes.

- Adesão ao Feedback: A distinção entre Adesão ao Feedback e Completude da Resposta é evidente - todos os sistemas começam com baixas pontuações de adesão sem feedback. Mas aqui é onde o ALHF brilha: com feedback, a pontuação de adesão do KA salta de 11,7% para quase 80%, mostrando o impacto dramático do ALHF.

No geral, o ALHF é um mecanismo eficaz para refinar e adaptar o comportamento de um sistema para atender às expectativas específicas do especialista. Em particular, é altamente eficiente em termos de amostra: você não precisa de centenas ou milhares de exemplos, mas pode ver ganhos claros com uma pequena quantidade de feedback.

ALHF: o desafio técnico

Esses resultados impressionantes são possíveis porque o KA aborda com sucesso dois desafios técnicos centrais do ALHF.

Aprendendo Quando Aplicar Feedback

Quando um especialista dá feedback sobre uma pergunta, como o agente sabe quais futuras perguntas devem se beneficiar dessa mesma percepção? Este é o desafio do escopo — determinar o escopo de aplicabilidade correto para cada feedback. Ou, colocando de outra forma, determinar a relevância de um feedback para uma pergunta.

Considere nosso exemplo PostgreSQL. Quando o especialista diz "a resposta deve ser compatível com PostgreSQL", esse feedback não deve apenas corrigir aquela resposta. Isso deve informar todas as futuras perguntas relacionadas ao SQL. Mas isso não deve afetar consultas não relacionadas, como "Devo usar matplotlib ou seaborn para este gráfico?"

Adotamos uma abordagem de memória do agente que registra todo o feedback anterior e permite que o agente recupere eficientemente o feedback relevante para uma nova pergunta. Isso permite que o agente determine dinâmica e holisticamente quais insights são mais relevantes para a pergunta atual.

Adaptando os Componentes Corretos do Sistema

O segundo desafio é atribuição — descobrir quais partes do sistema precisam mudar em resposta ao feedback. KA não é um único modelo; é um pipeline de vários componentes que gera consultas de pesquisa, recupera documentos e produz respostas. ALHF eficaz requer a atualização dos componentes certos das maneiras certas.

O KA é projetado com um conjunto de componentes alimentados por LLM que são parametrizados por feedback. Cada componente é um módulo que aceita feedback relevante e adapta seu comportamento de acordo. Tomando o exemplo anterior, onde o SME fornece o seguinte feedback sobre o exemplo de extração de data:

Depois, o usuário faz uma pergunta relacionada — “Como obtenho a diferença entre duas datas em SQL?”. Sem receber nenhum feedback novo, o KA aplica automaticamente o que aprendeu com a interação anterior. Ele começa modificando a consulta de pesquisa na etapa de recuperação, adaptando-a ao contexto:

Então, ele produz uma resposta específica para PostgreSQL:

Ao direcionar precisamente o feedback para os componentes de recuperação e geração de resposta apropriados, o ALHF garante que o agente aprenda e generalize efetivamente a partir do feedback do especialista.

O que o ALHF Significa para Você: Dentro do Agent Bricks

Aprendizado do Agente a partir do Feedback Humano (ALHF) representa um grande avanço na capacidade dos agentes de IA de realmente entender e se adaptar às expectativas dos especialistas. Ao permitir que o feedback em linguagem natural modele incrementalmente o comportamento de um agente, o ALHF fornece um mecanismo flexível, intuitivo e poderoso para direcionar os sistemas de IA para necessidades corporativas específicas. Nosso estudo de caso com o Assistente de Conhecimento mostra como o ALHF pode aumentar drasticamente a qualidade da resposta e a adesão às expectativas dos especialistas, mesmo com feedback mínimo. Como disse Patrick Vinton, Diretor de Tecnologia da Analytics8, um cliente da KA:

“Usando o Agent Bricks, a Analytics8 alcançou um aumento de 40% na precisão das respostas com tempos de implementação 800% mais rápidos para nossos casos de uso, que vão desde assistentes de RH simples até assistentes de pesquisa complexos em cima de documentos técnicos e multimodais extremamente técnicos. Após o lançamento, também observamos que a qualidade da resposta continua a subir.”

O ALHF agora é uma capacidade integrada dentro do produto Agent Bricks, permitindo que os clientes da Databricks implementem soluções de IA corporativas altamente personalizadas. Encorajamos todos os clientes interessados em aproveitar o poder da IA ensinável a se conectar com suas Equipes de Contas Databricks e experimentar KA e outros casos de uso do Agent Bricks para explorar como o ALHF pode transformar seus fluxos de trabalho de IA generativa.

Veronica Lyu e Kartik Sreenivasan contribuíram igualmente

(This blog post has been translated using AI-powered tools) Original Post