Anunciando a Disponibilidade Geral do Databricks Lakeflow

A abordagem unificada para a engenharia de dados abrangendo ingestão, transformação e orquestração

Summary

- O Databricks Lakeflow resolve os desafios da engenharia de dados apresentados por pilhas fragmentadas, oferecendo uma solução unificada para ingestão, transformação e orquestração na plataforma de inteligência de dados.

- Lakeflow Connect adiciona mais conectores a bancos de dados, fontes de arquivos, aplicações empresariais e armazéns de dados. Zerobus introduz gravações diretas de alta capacidade com baixa latência.

- Lakeflow Declarative Pipelines, construído com base no novo padrão aberto Spark Declarative Pipelines, apresenta uma nova IDE para engenheiros de dados para um melhor desenvolvimento de pipeline ETL.

Estamos animados em anunciar que o Lakeflow, a solução unificada de engenharia de dados da Databricks, agora está Disponível Geralmente. Ele inclui conectores de ingestão expandidos para fontes de dados populares, um novo "IDE para engenharia de dados" que facilita a construção e depuração de pipelines de dados, e capacidades expandidas para operacionalizar e monitorar ETL.

No Data + AI Summit do ano passado, apresentamos o Lakeflow - nossa visão para o futuro da engenharia de dados - uma solução de ponta a ponta que inclui três componentes principais:

- Lakeflow Connect: Ingestão confiável e gerenciada de aplicativos empresariais, bancos de dados, sistemas de arquivos e fluxos em tempo real, sem a sobrecarga de conectores personalizados ou serviços externos.

- Pipelines Declarativos Lakeflow: Pipelines ETL escaláveis construídos no padrão aberto de Pipelines Declarativos Spark, integrados com governança e observabilidade, e proporcionando uma experiência de desenvolvimento simplificada através de um moderno "IDE para engenharia de dados".

- Trabalhos Lakeflow: Orquestração nativa para a Plataforma de Inteligência de Dados, suportando fluxo de controle avançado, gatilhos de dados em tempo real e monitoramento abrangente.

Ao unificar a engenharia de dados, o Lakeflow elimina a complexidade e o custo de juntar diferentes ferramentas, permitindo que as equipes de dados se concentrem em criar valor para o negócio. Lakeflow Designer, o novo construtor de pipeline visual alimentado por IA, capacita qualquer usuário a construir pipelines de dados de nível de produção sem escrever código.

Foi um ano agitado, e estamos super animados para compartilhar o que há de novo agora que o Lakeflow alcançou a Disponibilidade Geral.

As equipes de engenharia de dados lutam para acompanhar as necessidades de dados de suas organizações

Em todas as indústrias, a capacidade de uma empresa extrair valor de seus dados por meio de análises e IA é sua vantagem competitiva. Os dados estão sendo utilizados em todas as facetas da organização - para criar visões de Cliente 360° e novas experiências para o cliente, para habilitar novas fontes de receita, para otimizar operações e para capacitar funcionários. À medida que as organizações procuram utilizar seus próprios dados, acabam com um emaranhado de ferramentas. Os engenheiros de dados acham difícil lidar com a complexidade das tarefas de engenharia de dados enquanto navegam por pilhas de ferramentas fragmentadas que são dolorosas para integrar e caras para manter.

Um desafio chave é a governança de dados - ferramentas fragmentadas tornam difícil impor padrões, levando a lacunas na descoberta, linhagem e observabilidade. Um recente estudo do The Economist descobriu que "metade dos engenheiros de dados dizem que a governança consome mais tempo do que qualquer outra coisa". Essa mesma pesquisa perguntou aos engenheiros de dados o que traria os maiores benefícios para sua produtividade, e eles identificaram "‘simplificar as conexões de fontes de dados para ingestão de dados', ‘usar uma única solução unificada em vez de várias ferramentas' e ‘melhor visibilidade nos pipelines de dados para encontrar e corrigir problemas' entre as principais intervenções".

Uma solução unificada de engenharia de dados incorporada à Plataforma de Inteligência de Dados

Lakeflow ajuda as equipes de dados a enfrentar esses desafios, fornecendo uma solução de engenharia de dados de ponta a ponta na Plataforma de Inteligência de Dados. Os clientes da Databricks podem usar o Lakeflow para todos os aspectos da engenharia de dados - ingestão, transformação e orquestração. Como todas essas capacidades estão disponíveis como parte de uma única solução, não há tempo gasto em integrações de ferramentas complexas ou custos extras para licenciar ferramentas externas.

Além disso, o Lakeflow está integrado à Plataforma de Inteligência de Dados e, com isso, vem maneiras consistentes de implantar, governar e observar todos os casos de uso de dados e IA. Por exemplo, para governança, o Lakeflow se integra ao Unity Catalog, a solução unificada de governança para a Plataforma de Inteligência de Dados. Através do Unity Catalog, os engenheiros de dados ganham total visibilidade e controle sobre cada parte do pipeline de dados, permitindo-lhes entender facilmente onde os dados estão sendo usados e identificar a causa raiz dos problemas à medida que surgem.

Seja versionando código, implantando pipelines CI/CD, protegendo dados ou observando métricas operacionais em tempo real, o Lakeflow aproveita a Plataforma de Inteligência de Dados para fornecer um único e consistente local para gerenciar as necessidades de engenharia de dados de ponta a ponta.

Lakeflow Connect: Mais conectores, e gravações diretas rápidas para o Unity Catalog

No ano passado, vimos uma forte adoção do Lakeflow Connect com mais de 2.000 clientes usando nossos conectores de ingestão para desbloquear valor de seus dados. Um exemplo é a Porsche Holding Salzburg que já está vendo os benefícios de usar o Lakeflow Connect para unificar seus dados de CRM com análises para melhorar a experiência do cliente.

“Usar o conector Salesforce do Lakeflow Connect nos ajuda a fechar uma lacuna crítica para a Porsche do lado dos negócios em termos de facilidade de uso e preço. Do lado do cliente, conseguimos criar uma experiência completamente nova para o cliente que fortalece o vínculo entre a Porsche e o cliente com uma jornada do cliente unificada e não fragmentada.” — Lucas Salzburger, Gerente de Projeto, Porsche Holding Salzburg

Hoje, estamos expandindo a amplitude de fontes de dados suportadas com mais conectores integrados para ingestão simples e confiável. Os conectores do Lakeflow são otimizados para extração eficiente de dados, incluindo o uso de métodos de captura de dados de alteração (CDC) personalizados para cada respectiva fonte de dados.

Esses conectores gerenciados agora abrangem aplicações empresariais, fontes de arquivos, bancos de dados e data warehouses, sendo lançados em vários estados de lançamento:

- Aplicações empresariais: Salesforce, Workday, ServiceNow, Google Analytics, Microsoft Dynamics 365, Oracle NetSuite

- Fontes de arquivo: SFTP, SharePoint

- Bancos de dados: Microsoft SQL Server, Oracle Database, MySQL, PostgreSQL

- Armazéns de dados: Snowflake, Amazon Redshift, Google BigQuery

Além disso, um caso de uso comum que vemos dos clientes é a ingestão de dados de eventos em tempo real, normalmente com infraestrutura de ônibus de mensagens hospedada fora de sua plataforma de dados. Para tornar este caso de uso simples no Databricks, estamos anunciando o Zerobus, uma API do Lakeflow Connect que permite aos desenvolvedores escrever dados de eventos diretamente em seu lakehouse com uma taxa de transferência muito alta (100 MB/s) e latência quase em tempo real (<5 segundos). Esta infraestrutura de ingestão simplificada oferece desempenho em escala e é unificada com a Plataforma Databricks para que você possa aproveitar ferramentas de análise e IA mais amplas imediatamente.

“A Joby consegue usar nossos agentes de fabricação com o Zerobus para enviar gigabytes por minuto de dados de telemetria diretamente para nosso lakehouse, acelerando o tempo para insights - tudo com o Databricks Lakeflow e a Plataforma de Inteligência de Dados.” — Dominik Müller, Líder de Sistemas de Fábrica, Joby Aviation Inc.

Gartner®: Databricks, líder em banco de dados em nuvem

Lakeflow Pipelines Declarativas: Desenvolvimento ETL acelerado baseado em padrões abertos

Após anos operando e evoluindo o DLT com milhares de clientes em petabytes de dados, pegamos tudo o que aprendemos e criamos um novo padrão aberto: Spark Declarative Pipelines. Esta é a próxima evolução no desenvolvimento de pipeline - declarativa, escalável e aberta.

E hoje, estamos animados em anunciar a Disponibilidade Geral de Pipelines Declarativos Lakeflow, trazendo o poder dos Pipelines Declarativos Spark para a Plataforma de Inteligência de Dados Databricks. É 100% compatível com o padrão aberto, então você pode desenvolver pipelines uma vez e executá-los em qualquer lugar. Ele também é 100% compatível com os pipelines DLT, então os usuários existentes podem adotar as novas capacidades sem reescrever nada. Os Lakeflow Declarative Pipelines são uma experiência totalmente gerenciada no Databricks: computação serverless sem intervenção, integração profunda com o Unity Catalog para governança unificada, e um IDE para Engenharia de Dados construído com propósito.

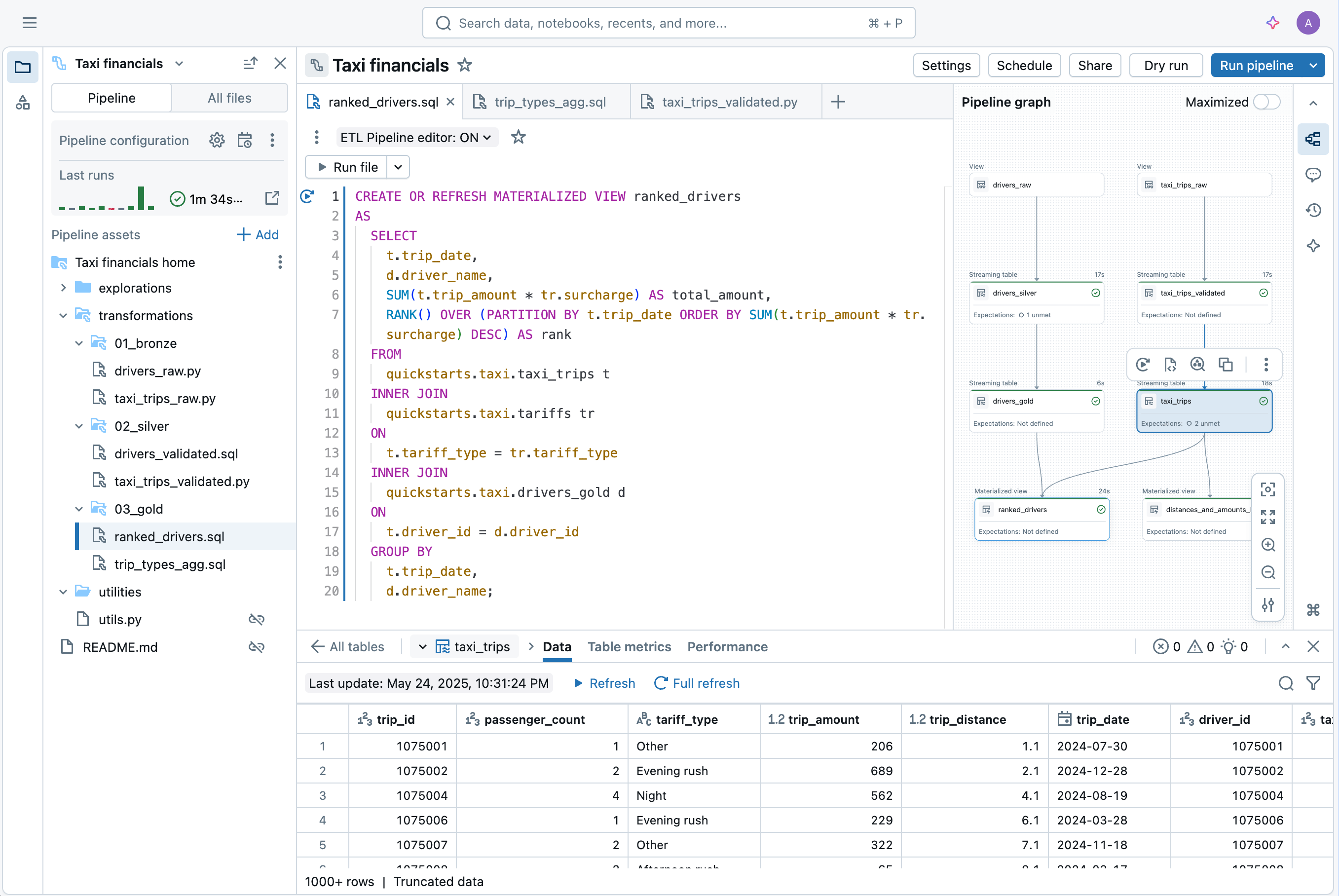

O novo IDE para Engenharia de Dados é um ambiente integrado moderno construído para simplificar a experiência de desenvolvimento de pipeline. Inclui

- Código e DAG lado a lado, com visualização de dependência e pré-visualizações de dados instantâneas

- A depuração consciente do contexto que apresenta problemas inline

- Integração Git integrada para desenvolvimento rápido

- Autoria e configuração assistida por IA

“O novo editor traz tudo para um só lugar - código, gráfico de pipeline, resultados, configuração e solução de problemas. Chega de alternar abas do navegador ou perder o contexto. O desenvolvimento parece mais focado e eficiente. Posso ver diretamente o impacto de cada alteração de código. Um clique me leva à linha de erro exata, o que torna a depuração mais rápida. Tudo se conecta - código aos dados; código às tabelas; tabelas ao código. Alternar entre pipelines é fácil, e recursos como pastas de utilitários autoconfiguradas removem a complexidade. Isso parece ser a maneira como o desenvolvimento de pipeline deveria funcionar.” — Chris Sharratt, Engenheiro de Dados, Rolls-Royce

Lakeflow Declarative Pipelines são agora a maneira unificada de construir pipelines escaláveis, governados e continuamente otimizados no Databricks - seja você trabalhando em código ou visualmente através do Lakeflow Designer, uma nova experiência sem código que permite a profissionais de dados de qualquer habilidade técnica construir pipelines de dados confiáveis.

Trabalhos do Lakeflow: Orquestração confiável para todas as cargas de trabalho com observabilidade unificada

Databricks Workflows tem sido confiável para orquestrar fluxos de trabalho críticos, com milhares de clientes confiando em nossa plataforma para pipelines executarem mais de 110 milhões de trabalhos todas as semanas. Com o GA do Lakeflow, estamos evoluindo os Workflows para os Trabalhos Lakeflow, unificando este maduro, orquestrador nativo com o resto da pilha de engenharia de dados.

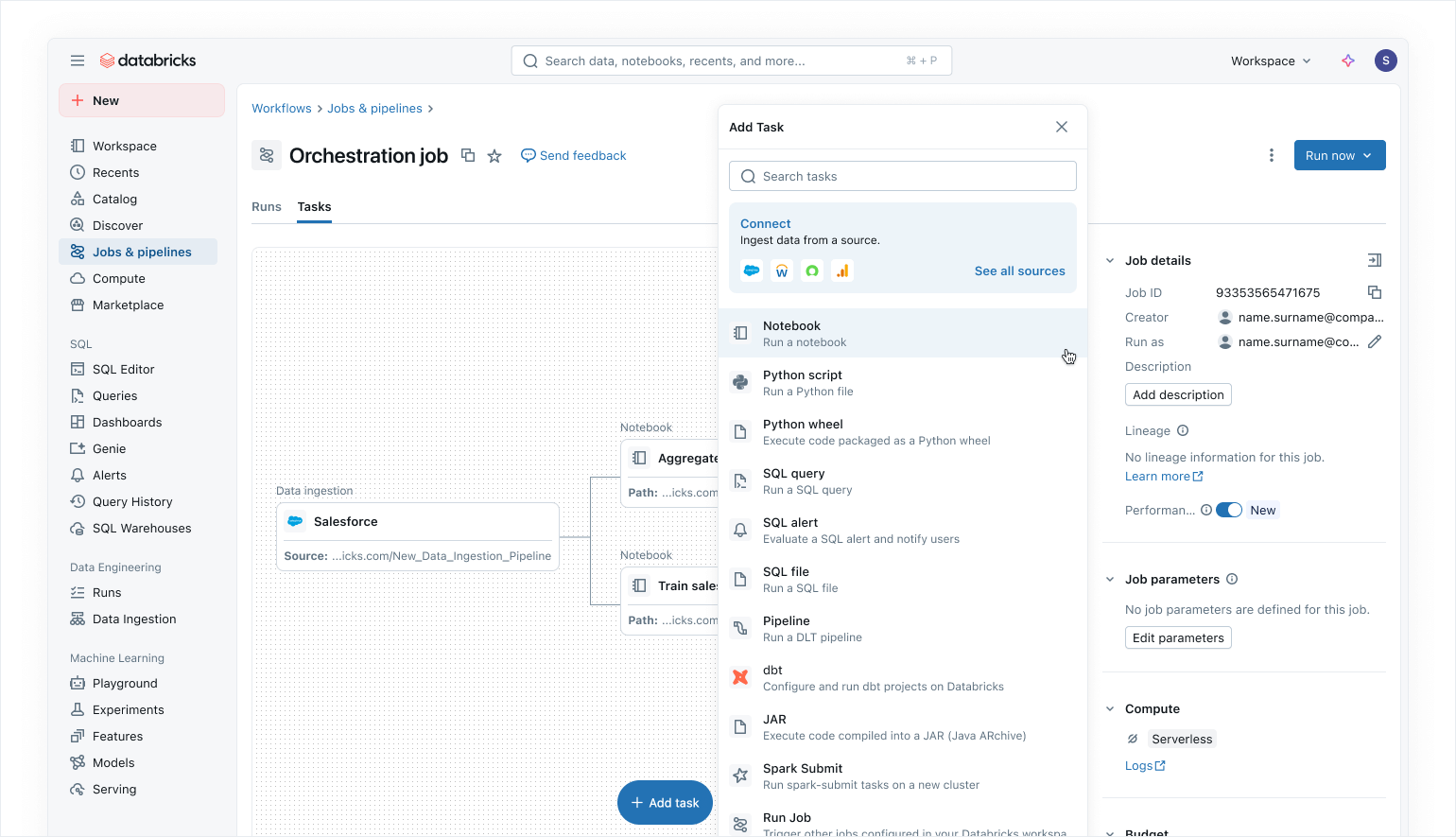

Lakeflow Jobs permite que você orquestre qualquer processo na Plataforma Inteligente de Dados com um conjunto crescente de capacidades, incluindo:

- Suporte para uma coleção abrangente de tipos de tarefas para orquestrar fluxos que incluem Pipelines Declarativos, notebooks, consultas SQL, transformações dbt e até mesmo publicação de painéis de AI/BI ou para o Power BI.

- Recursos de controle de fluxo como execução condicional, loops e definição de parâmetros no nível da tarefa ou do trabalho.

- Disparadores para execuções de trabalhos além do agendamento simples com disparadores de chegada de arquivo e os novos disparadores de atualização de tabela, que garantem que os trabalhos só sejam executados quando novos dados estiverem disponíveis.

- Trabalhos serverless que fornecem otimizações automáticas para melhor desempenho e menor custo.

“Com os trabalhos Lakeflow sem servidor, conseguimos uma melhoria de 3-5x na latência. O que costumava levar 10 minutos agora leva apenas 2-3 minutos, reduzindo significativamente os tempos de processamento. Isso nos permitiu fornecer loops de feedback mais rápidos para jogadores e treinadores, garantindo que eles obtenham os insights de que precisam em tempo quase real para tomar decisões acionáveis.” — Bryce Dugar, Gerente de Engenharia de Dados, Cincinnati Reds

Como parte da unificação do Lakeflow, o Lakeflow Jobs traz observabilidade de ponta a ponta em todas as camadas do ciclo de vida dos dados, desde a ingestão de dados até a transformação e a orquestração complexa. Um conjunto de ferramentas diversificado atende a todas as necessidades de monitoramento: ferramentas de monitoramento visual fornecem busca, status e rastreamento de relance, ferramentas de depuração como perfis de consulta ajudam a otimizar o desempenho, alertas e tabelas de sistema ajudam a identificar problemas e oferecer insights históricos e as expectativas de qualidade de dados impõem regras e garantem altos padrões para suas necessidades de pipeline de dados.

Comece com o Lakeflow

Lakeflow Connect, Lakeflow Declarative Pipelines e Lakeflow Jobs estão todos Geralmente Disponíveis para todos os clientes Databricks hoje. Saiba mais sobre o Lakeflow aqui e visite a documentação oficial para começar com o Lakeflow em seu próximo projeto de engenharia de dados.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura