Anunciando Endpoints Otimizados para Armazenamento para Pesquisa de Vetores

Escala de Vetores Multi-bilionária, custo 7x menor

Summary

- Apresentando a Busca Vetorial otimizada para armazenamento: Escala de bilhões de vetores, até 7x menor custo, indexação 20x mais rápida, filtragem familiar estilo SQL.

- Desbloqueie mais valor dos dados não estruturados para IA: Construa sistemas de RAG, resolução de entidades e busca semântica de alto desempenho em documentos, imagens e mais.

- Pronto para empresas e fácil de adotar: Apoiado pela governança do Catálogo Unity e integrado com ferramentas como o AI Playground para prototipagem rápida de RAG e políticas de orçamento para gerenciamento de custos.

A maioria das empresas possui uma quantidade massiva de dados não estruturados - documentos, imagens, áudio, vídeo - mas apenas uma fração se transforma em insights acionáveis. Aplicativos potencializados por IA como geração aumentada por recuperação (RAG), resolução de entidades, motores de recomendação e busca consciente de intenções podem mudar isso, mas rapidamente esbarram em barreiras familiares: limites de capacidade rígidos, custos crescentes e indexação lenta.

Hoje, estamos anunciando a Prévia Pública do pontos finais otimizados para armazenamento do Mosaic AI Vector Search—nosso novo motor de busca vetorial, construído especificamente para dados em escala de petabytes. Ao desacoplar o armazenamento do processamento e aproveitar a escala massiva e o paralelismo do Spark dentro da Plataforma de Inteligência de Dados Databricks, ele oferece:

- Capacidade de multi-bilhões de vetores

- Até 7x menor custo

- Indexação 20x mais rápida

- Filtragem estilo SQL

Melhor de tudo, é uma verdadeira substituição para as mesmas APIs que suas equipes já usam, agora superpotencializadas para RAG, busca semântica e resolução de entidades em produção real. Além disso, para apoiar ainda mais as equipes empresariais, também estamos introduzindo novos recursos projetados para simplificar o desenvolvimento e melhorar a visibilidade dos custos.

O que há de novo na pesquisa de vetores otimizada para armazenamento

Pontos finais otimizados para armazenamento foram construídos em resposta direta ao que as equipes empresariais nos disseram que mais precisam: a capacidade de indexar e pesquisar em lagos de dados não estruturados inteiros, infraestrutura que escala sem aumentar exorbitantemente os custos, e ciclos de desenvolvimento mais rápidos.

Escala de Vetores Multi-bilionária, custo 7x menor

A escala não é mais uma limitação. Enquanto nossa oferta padrão suportava algumas centenas de milhões de vetores, a otimização de armazenamento é construída para bilhões de vetores a um custo razoável, permitindo que as organizações executem cargas de trabalho completas de data lake sem a necessidade de amostragem ou filtragem. Clientes que executam grandes cargas de trabalho estão vendo até 7x menores custos de infraestrutura, tornando finalmente viável executar o GenAI em produção em conjuntos de dados não estruturados massivos.

Para comparação, o preço otimizado para armazenamento seria de ~$900/mês para 45M de vetores e ~$7K/mês para 1.3B de vetores. O último representa uma economia significativa em comparação com ~$47K/mês em nossa oferta padrão.

Até 20x mais rápido na indexação

Desbloqueie ciclos de iteração rápidos que antes eram impossíveis. Nossa re-arquitetura alimenta uma das melhorias mais solicitadas - indexação dramaticamente mais rápida. Agora você pode construir um índice de 1 bilhão de vetores em menos de 8 horas, e índices menores de 100M de vetores ou menos são construídos em minutos.

"A melhoria na velocidade de indexação com otimização de armazenamento é enorme para nós. O que antes levava cerca de 7 horas agora leva apenas uma hora, uma melhoria de 7-8x." — Ritabrata Moitra, Sr. Lead ML Engineer, CommercelIQ

Filtragem estilo SQL

Filtre registros facilmente sem aprender uma sintaxe desconhecida. Além do desempenho e da escala, também nos concentramos na usabilidade. A filtragem de metadados agora é feita usando sintaxe intuitiva, estilo SQL, tornando simples restringir os resultados da pesquisa usando critérios com os quais você já está familiarizado.

Mesmas APIs, Backend totalmente novo

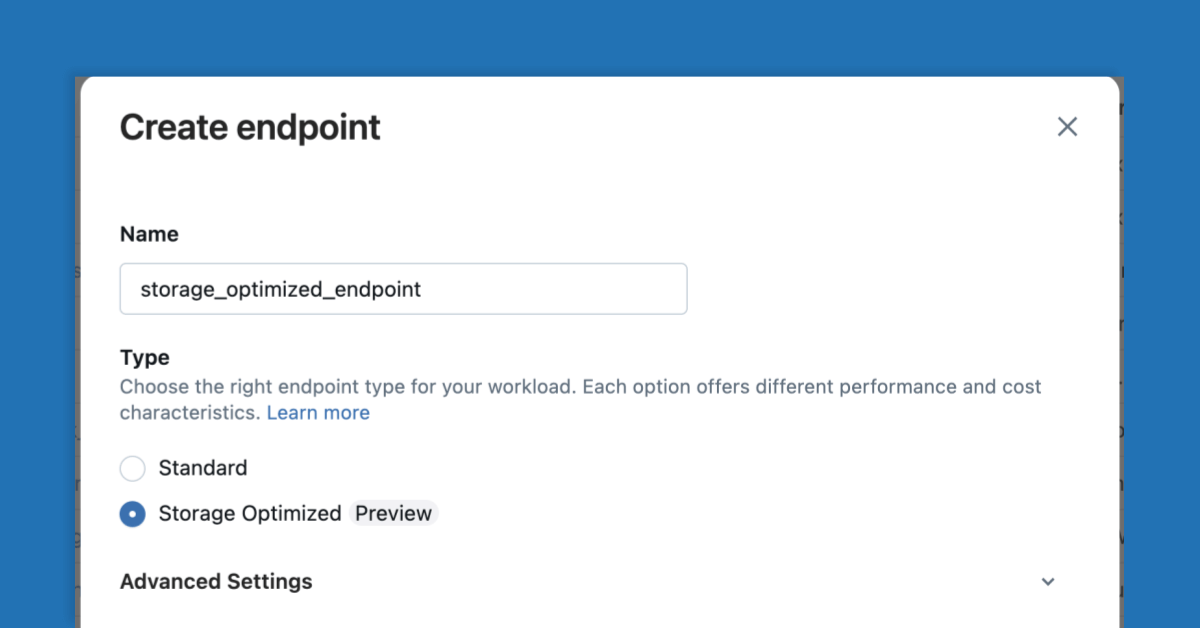

Migrar para endpoints otimizados para armazenamento é fácil - basta selecioná-lo ao criar um novo endpoint e criar um novo índice em sua tabela. A API de pesquisa de similaridade permanece a mesma, então não há necessidade de grandes mudanças de código.

"Vemos a Pesquisa de Vetores otimizada para armazenamento como essencialmente uma substituição direta para a oferta padrão. Ela desbloqueia a escala de que precisamos para suportar centenas de investidores internos consultando dezenas de milhões de documentos diariamente, sem comprometer a latência ou a qualidade." — Alexandre Poulain, Diretor, Equipe de Ciência de Dados & AI, PSP Investments

Porque essa capacidade faz parte da plataforma Mosaic AI, ela vem com total governança alimentada pelo Unity Catalog. Isso significa controles de acesso adequados, auditorias e rastreamento de linhagem em todos os seus ativos de Busca Vetorial - garantindo a conformidade com as políticas de dados e segurança empresariais desde o primeiro dia.

Recursos Avançados para Otimizar Seu Fluxo de Trabalho

Para apoiar ainda mais as equipes empresariais, estamos introduzindo novas capacidades que facilitam a experimentação, implantação e gerenciamento de cargas de trabalho de Pesquisa de Vetores em escala.

As equipes agora podem testar e implantar um agente de chat apoiado por um índice de Busca Vetorial como uma base de conhecimento em dois cliques - um processo que costumava exigir um código personalizado significativo. Com a integração direta no Agent Playground agora em Visualização Pública, selecione seu índice de Busca Vetorial como uma ferramenta, teste seu agente RAG e exporte, implante e avalie agentes sem escrever uma única linha de código. Isso reduz drasticamente o caminho do protótipo para a produção.

Nossa melhor visibilidade de custos com a política de etiquetagem de orçamento do endpoint permite que os proprietários de plataformas e as equipes de FinOps rastreiem e entendam facilmente os gastos em várias equipes e casos de uso, alocem orçamentos e gerenciem custos à medida que o uso cresce. Mais suporte para marcação de índices e recursos de computação está a caminho.

Gartner®: Databricks, líder em banco de dados em nuvem

Isso é apenas o começo

O lançamento de endpoints otimizados para armazenamento é um marco importante, mas já estamos trabalhando em melhorias futuras:

- Escala para Zero: Reduza automaticamente os recursos de computação quando não estiverem em uso para reduzir ainda mais os custos

- Suporte a Alta QPS: Infraestrutura para lidar com milhares de consultas por segundo para aplicações em tempo real exigentes

- Além da Pesquisa Semântica: Capacidades eficientes de recuperação não-semântica para cargas de trabalho apenas com palavras-chave.

Nosso objetivo é simples: construir a melhor tecnologia de pesquisa de vetores disponível, totalmente integrada à Plataforma de Inteligência de Dados Databricks na qual você já confia.

Comece a Construir Hoje

Os endpoints otimizados para armazenamento transformam a maneira como você trabalha com dados não estruturados em escala. Com capacidade massiva, melhor economia, indexação mais rápida e filtragem familiar, você pode construir com confiança aplicações de IA mais poderosas.

Tudo pronto para começar?

- Experimente a Pesquisa de Vetores Mosaic AI gratuitamente: a configuração expressa oferece acesso instantâneo e créditos gratuitos para servidores.

- Confira nossa documentação para ver como é feito!

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura