Construindo juízes de LLM personalizados para a acurácia de agentes de AI

MLflow apresenta novos recursos LLM-como-um-Juiz que simplificam a criação de juízes específicos de domínio e aprimoram o Agent Bricks

Summary

- Use os Avaliadores Ajustáveis para alinhar sistematicamente os avaliadores específicos do domínio que correspondam aos seus especialistas de domínio

- O Agente como Avaliador simplifica o processo de criação de avaliadores complexos, tudo em linguagem natural

- Use todos esses recursos e muito mais no Construtor de Avaliadores, um fluxo de trabalho visual e intuitivo que simplifica a criação e a manutenção de avaliadores

À medida que os agentes de AI passam do protótipo para a produção, as organizações devem garantir a qualidade e escala seus processos de avaliação para evitar riscos à reputação quando os agentes se comportam de maneira imprevisível. O MLflow ajuda a enfrentar esse desafio com juízes de LLM integrada e baseados em pesquisa que avaliam dimensões key como exatidão, relevância e segurança. Ainda assim, muitas aplicações do mundo real exigem mais do que marcadores de qualidade genéricos, necessitando de avaliações específicas do domínio, adaptadas ao seu contexto exclusivo. Por exemplo, os critérios para avaliar um chatbot de atendimento ao cliente diferem muito dos usados para avaliar um assistente de diagnóstico médico ou um bot de consultoria financeira.

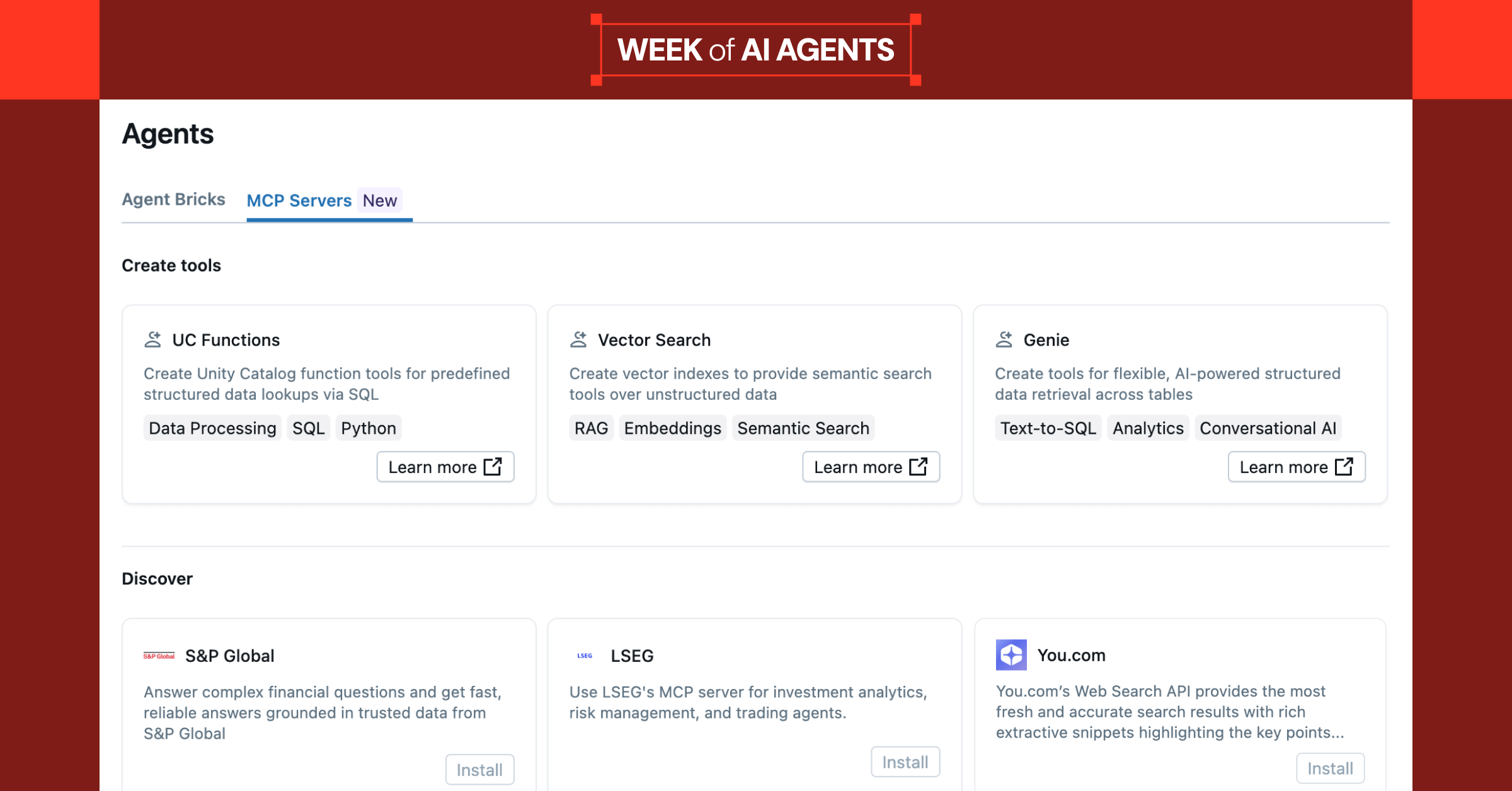

Anteriormente, criar uma lógica de avaliação personalizada era demorado e exigia uma colaboração estreita entre desenvolvedores e especialistas no domínio (especialistas com profundo conhecimento do contexto de negócios, regulamentações e padrões de qualidade), criando um gargalo no ciclo de desenvolvimento. Como parte da Databricks Week of Agents, estamos apresentando três novas funcionalidades baseadas em MLflow no Agent Bricks projetadas para tornar esse processo mais rápido e escalável:

- Juízes ajustáveis possibilitam o alinhamento sistemático com especialistas do domínio

- Agent-as-a-Judge determina automaticamente quais partes do rastreamento avaliar, eliminando a sobrecarga de implementação manual para métricas complexas

- Judge Builder reúne todos esses recursos em um fluxo de trabalho visual e intuitivo que otimiza a colaboração entre desenvolvedores e especialistas de domínio.

Em conjunto, esses recursos impulsionados pelo MLflow permitem que o Agent Bricks simplifique como as equipes desenvolvem, monitoram e aprimoram continuamente agentes de AI de alta qualidade.

Criando juízes ajustáveis

Com o novo SDK make_judge introduzido no MLflow 3.4.0, você pode criar facilmente juízes de LLM personalizados e adaptados ao seu caso de uso específico, usando instruções em linguagem natural em vez de uma lógica programática complexa. Basta definir seus critérios de avaliação, e o MLflow cuida dos detalhes da implementação.

Depois de criar seus primeiros judges, as ferramentas de ajuste e alinhamento do MLflow ajudam a incorporar o feedback de especialistas no assunto ao ciclo. Você pode usar comentários ou dados de pontuação de especialistas de domínio e alimentá-los diretamente em seus avaliadores personalizados, para que a lógica de avaliação aprenda o que significa “bom” para seu caso de uso específico. Melhorar a qualidade não é uma tarefa única; é um ciclo. Cada vez que você coleta feedback e retreina ou ajusta seus avaliadores, eles se tornam mais consistentes e mais próximos de como os usuários reais medem o sucesso. Com o tempo, esse ajuste contínuo é o que mantém suas avaliações confiáveis e seus agentes melhorando em escala.

“Para realizar o futuro da otimização de marketing, precisamos ter confiança absoluta em nossos agentes de AI. A API make_judge fornece o controle programático para alinhar continuamente nossos avaliadores específicos do domínio, garantindo o mais alto nível de acurácia e confiança em nossa modelagem de atribuição.”— Tjadi Peeters, CTO, Billy Grace

Para começar, crie seu primeiro juiz personalizado:

Para alinhar seu juiz com o conhecimento de especialistas humanos, colete rastros com feedback humano e, em seguida, use a otimização de alinhamento do MLflow:

Explore a documentação completa para saber mais sobre como definir seu LLM judge ajustável e alinhar o juiz. Depois, você pode registrar o juiz em um experimento e usá-lo para monitoramento da qualidade em produção:

Você pode usar o avaliador com a mesma facilidade em avaliações offline:

Saiba mais sobre como usar pontuadores na avaliação e para monitoramento contínuo da qualidade em produção.

Primeiros passos com o Agent-como-um-Juiz

O Agent-como-um-Juiz adiciona inteligência ao processo de avaliação, identificando automaticamente quais partes de um trace são relevantes, eliminando a necessidade de uma lógica complexa de percurso manual do trace! Basta incluir a variável {{ trace }} nas instruções do seu juiz, e o Agent-como-um-Juiz buscará os dados corretos para a avaliação.

Para muitos cenários de avaliação, como verificar se uma ferramenta específica foi chamada, se os argumentos eram válidos ou se foram feitas chamadas redundantes, os frameworks de avaliação tradicionais exigem a escrita de código personalizado para pesquisar e filtrar manualmente na estrutura de rastreamento. Esse código pode se tornar complexo e frágil à medida que seu agente ou os requisitos de avaliação evoluem. Com o agente como avaliador, seu avaliador pode focar diretamente na intenção e no resultado, e não no tratamento manual de dados:

Essa abordagem declarativa mantém os juízes legíveis e adaptáveis. Você pode estender o mesmo padrão para verificar a validade de argumentos, chamadas de ferramentas redundantes ou qualquer outra lógica personalizada. Por exemplo, você pode adicionar uma condição como “Garanta que os argumentos da chamada da ferramenta sejam razoáveis, considerando o contexto anterior, e que a ferramenta não seja chamada de forma redundante”.

O Agent-as-a-Judge suporta as mesmas funcionalidades de alinhamento que qualquer outro juiz, para que você possa ajustá-los com feedback humano usando a sintaxe mostrada anteriormente. Saiba mais sobre o Agent-as-a-Judge aqui.

Gartner®: Databricks, líder em banco de dados em nuvem

Apresentando o Judge Builder

Para simplificar ainda mais o processo de criação e alinhamento de judges, o Judge Builder oferece uma interface visual para gerenciar todo o ciclo de vida do judge. Especialistas do domínio podem dar feedback diretamente por meio de uma experiência de revisão intuitiva, enquanto as pessoas desenvolvedoras usam esse feedback para alinhar automaticamente os judges com os padrões do domínio. Isso preenche a lacuna entre a implementação técnica e o conhecimento do domínio, otimizando a coleta de feedback, o alinhamento de judges e o gerenciamento do ciclo de vida, tudo com base nos recursos existentes do MLflow e integrado aos seus experimentos do MLflow.

Para começar a usar o Judge Builder, acesse o Databricks Marketplace e instale o aplicativo Judge Builder no seu workspace. Saiba mais aqui, ou entre em contato com seu representante do Databricks para mais informações.

Conclusão

Com os juízes ajustáveis, o Agent-as-a-Judge e o Judge Builder, você pode criar juízes de LLM específicos do domínio que correspondam aos seus padrões de especialista e que melhoram continuamente com o feedback humano. Juntos, esses recursos facilitam a criação de agentes de AI de alta qualidade em escala com o MLflow. Vale destacar que esses mesmos recursos formam o mecanismo de avaliação abrangente que impulsiona o Agent Bricks.

Esteja você nos estágios iniciais de prototipagem ou gerenciando agentes em produção que atendem a milhões de usuários, o MLflow e o Agent Bricks fornecem as ferramentas necessárias para criar agentes de alta qualidade e implantá-los em produção com confiança.

Comece hoje mesmo!

- Join-se a nós em 11/11 para “O futuro da AI: construa agentes que funcionam” com Sam Altman e Ali Ghodsi.

- Explore avaliadores ajustáveis

- Saiba mais sobre o Agent-as-a-Judge

- Comece com o Judge Builder

- Confira os outros anúncios que fizemos na Week of Agents

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura