Anúncios da Mosaic AI no Data + AI Summit 2025

Summary

- Agent Bricks: Construa agentes de alta qualidade e específicos para o domínio, descrevendo a tarefa - Agent Bricks gera automaticamente avaliações e otimiza para qualidade e custo.

- MLflow 3.0: Redesenhado para GenAI com observabilidade de agente, versionamento de prompt e monitoramento multiplataforma - mesmo para agentes que funcionam fora da Databricks.

- Computação GPU Serverless: Execute treinamento e inferência sem gerenciar infraestrutura - GPUs totalmente gerenciadas e com auto-escala agora disponíveis em beta.

No ano passado, nós revelamos a inteligência de dados - IA que pode raciocinar sobre os dados da sua empresa - com a chegada do conjunto de ferramentas Mosaic AI da Databricks para construir e implantar sistemas de agentes. Desde então, tivemos milhares de clientes trazendo a IA para produção. Este ano, no Data and AI Summit, estamos animados para anunciar vários produtos chave:

Agent Bricks em Beta

Agent Bricks é uma nova maneira de construir agentes de alta qualidade que são auto-otimizados em seus dados. Basta fornecer uma descrição de alto nível da tarefa do agente e conectar seus dados corporativos - Agent Bricks cuida do resto. Agent Bricks é otimizado para casos de uso comuns da indústria, incluindo extração de informações estruturadas, assistência de conhecimento confiável, transformação de texto personalizada e construção de sistemas multi-agentes. Usamos o mais recente em pesquisa agente do time de pesquisa de IA da Databricks Mosaic para construir automaticamente avaliações e otimizar a qualidade do agente. Para mais detalhes, veja o blog detalhado do Agent Bricks.

MLflow 3.0

Estamos lançando o MLflow 3, que foi redesenhado do zero para a IA Generativa, com o que há de mais recente em monitoramento, avaliação e gerenciamento de ciclo de vida. Agora com o MLflow 3, você pode monitorar e observar agentes que são implantados em qualquer lugar, mesmo fora do Databricks. Agentes implantados na AWS, GCP ou até mesmo em sistemas locais agora podem ser conectados ao MLflow 3 para observabilidade do agente.

Também incluímos no MLflow 3 um registro de prompts, permitindo que você registre, versione, teste e implemente diferentes prompts LLM para seus sistemas de agentes.

Funções de IA em SQL: Agora Mais Rápidas e Multi-Modais

As Funções de IA permitem que os usuários acessem facilmente o poder da IA gerativa diretamente do SQL. Este ano, estamos animados em compartilhar que as Funções de IA agora têm melhorias significativas de desempenho e capacidades multi-modais expandidas. As Funções de IA agora são até 3x mais rápidas e 4x mais baratas do que outros fornecedores em cargas de trabalho em grande escala, permitindo que você processe transformações de dados em grande escala com velocidade sem precedentes.

Além do desempenho, as Funções de IA agora suportam capacidades multimodais, permitindo que você trabalhe de forma integrada entre texto, imagens e outros tipos de dados. Novas funções como ai_parse_document tornam fácil extrair informações estruturadas de documentos complexos, desbloqueando insights de conteúdo empresarial anteriormente difícil de processar.

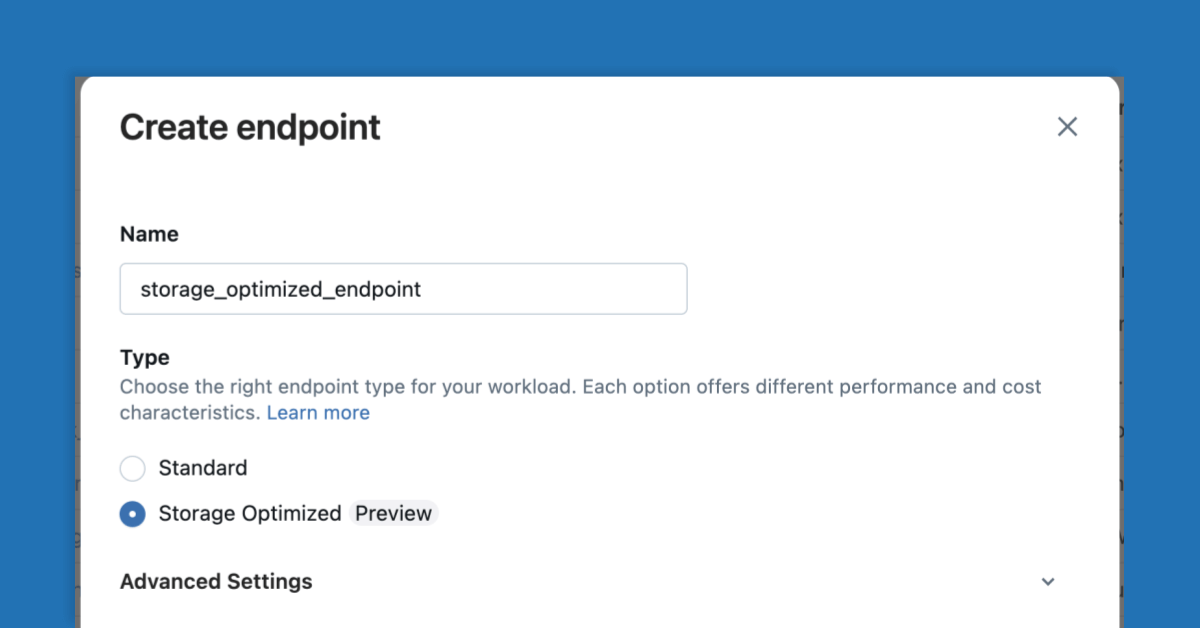

Pesquisa Vetorial Otimizada para Armazenamento em Visualização Pública

A Pesquisa de Vetores Mosaic AI forma a espinha dorsal de muitos sistemas de recuperação, e especialmente agentes RAG, e nosso produto de Pesquisa de Vetores é um dos produtos de crescimento mais rápido na Databricks. Agora, reescrevemos completamente a infraestrutura do zero com os princípios de separar computação e armazenamento. Nossa nova Pesquisa de Vetores Otimizada para Armazenamento pode escalar bilhões de vetores enquanto oferece um custo 7x menor. Este avanço torna economicamente viável construir aplicações RAG sofisticadas e sistemas de busca semântica em todo o seu conjunto de dados. Seja para alimentar chatbots de suporte ao cliente ou habilitar a descoberta avançada de documentos, agora você pode escalar sem os custos proibitivos. Veja nosso post detalhado no blog para um mergulho técnico profundo e benchmarks de desempenho.

Gartner®: Databricks, líder em banco de dados em nuvem

Computação GPU Serverless em Beta

Estamos anunciando um grande avanço no cálculo sem servidor com a introdução do suporte a GPU na plataforma sem servidor Databricks. As cargas de trabalho de IA alimentadas por GPU estão agora mais acessíveis do que nunca, com este serviço totalmente gerenciado eliminando a complexidade do gerenciamento de GPU. Seja você treinando modelos, executando inferências ou processando transformações de dados em grande escala, o cálculo GPU sem servidor fornece o desempenho de que você precisa sem o overhead operacional. Totalmente integrado à plataforma Databricks, o cálculo GPU Serverless permite acesso sob demanda a A10g (Beta hoje) e H100s (em breve), sem estar preso a reservas de longo prazo. Execute notebooks em GPUs sem servidor e envie como trabalhos, com a governança completa do Catálogo Unity.

Serviço de Modelo em Alta Escala

As aplicações de IA empresarial de hoje exigem maior throughput e latências mais baixas para prontidão de produção. Nossa infraestrutura de Serviço de Modelo aprimorada agora suporta mais de 250.000 consultas por segundo (QPS). Traga suas cargas de trabalho de ML online em tempo real para o Databricks, e deixe-nos lidar com os desafios de infraestrutura e confiabilidade para que você possa se concentrar no desenvolvimento do modelo de IA.

Com o serviço LLM, lançamos agora um novo motor de inferência proprietário interno em todas as regiões. O motor de inferência contém muitas de nossas inovações privadas e kernels personalizados para acelerar a inferência do Meta Llama e outros LLMs de código aberto. Em cargas de trabalho comuns, nosso motor de inferência é até 1,5x mais rápido do que motores de código aberto adequadamente configurados, como o vLLM-v1. Juntamente com o resto de nossa infraestrutura de serviço LLM, essas inovações significam que servir LLMs no Databricks é mais fácil, mais rápido e muitas vezes de menor custo total, do que soluções de serviço DIY.

De chatbots a motores de recomendação, seus serviços de IA agora podem escalar para lidar até mesmo com as cargas de trabalho empresariais mais exigentes.

Suporte MCP no Databricks

O Protocolo de Contexto de Modelo (MCP) da Anthropic é um protocolo popular para fornecer ferramentas e conhecimento a grandes modelos de linguagem. Agora integramos o MCP diretamente na plataforma Databricks. Servidores MCP podem ser hospedados com os Apps Databricks, proporcionando uma maneira perfeita de implantar e gerenciar serviços compatíveis com MCP sem gerenciamento adicional de infraestrutura. Você pode interagir e testar modelos habilitados para MCP diretamente em nosso ambiente Playground, facilitando a experimentação com diferentes configurações e capacidades de modelo.

Além disso, agora você pode conectar seus agentes para aproveitar o Databricks com o lançamento de servidores MCP hospedados pelo Databricks para funções UC, Genie e Vector Search. Para saber mais, veja nossa documentação.

AI Gateway está Geralmente Disponível

Mosaic AI Gateway agora está disponível para todos. Este ponto de entrada unificado para todos os seus serviços de IA fornece governança centralizada, registro de uso e controle em todo o seu portfólio de aplicações de IA. Também adicionamos uma série de novas capacidades, desde ser capaz de alternar automaticamente entre diferentes provedores, até PII e guardrails de segurança. Com o AI Gateway, você pode implementar políticas de limite de taxa, rastrear uso e impor guardrails de segurança, em cargas de trabalho de IA, seja elas executadas na Databricks ou através de serviços externos.

Começar

Esses anúncios representam nosso compromisso contínuo em tornar a IA corporativa mais acessível, performática e econômica. Cada inovação se baseia em nossa plataforma de inteligência de dados, garantindo que suas aplicações de IA possam aproveitar todo o poder de seus dados corporativos, mantendo os padrões de governança e segurança que sua organização exige.

Pronto para explorar essas novas capacidades? Comece com nosso nível gratuito ou entre em contato com seu representante da Databricks para saber como essas inovações podem acelerar suas iniciativas de IA.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura

Apresentando o AI/BI: analítica inteligente para dados do mundo real

IA

7 de janeiro de 2025/8 min de leitura