Um Framework Prático de Governança de IA para Empresas

Um guia completo para implementar ferramentas e programas de governança de IA de forma responsável e eficaz

Summary

- Para organizações que buscam desenvolver e documentar uma governança de AI rigorosa, desenvolvemos uma estrutura de governança de AI que descreve uma abordagem estruturada para o desenvolvimento responsável de AI.

- As melhores práticas de governança de IA, incluindo gerenciamento de riscos, compliance legal, supervisão ética e monitoramento operacional, são essenciais para apoiar sistemas de IA transparentes e responsáveis.

- A estrutura de governança de IA destina-se a ajudar as empresas a escalar programas de IA enquanto gerenciam as expectativas regulatórias, reduzem os riscos e mantêm a confiança das partes interessadas.

À medida que as organizações adotam AI em escala, cresce a necessidade de uma governança formal. As empresas devem alinhar o desenvolvimento de AI com as metas de negócios, cumprir as obrigações legais e levar em conta os riscos éticos.

Apresentamos o Framework de Governança de IA da Databricks para fornecer uma abordagem estruturada e prática para governar a adoção de IA em toda a empresa. Esta estrutura foi projetada para apoiar o desenvolvimento, a implantação e a melhoria contínua de programas de governança de IA.

Introdução à Governança de IA

O termo "governança de IA" refere-se aos tipos de estruturas, processos e supervisão que os sistemas de IA exigem para serem desenvolvidos e implantados de forma responsável em uma empresa. À medida que as organizações escalam a IA generativa, a governança se torna um princípio fundamental para questões como alinhar as iniciativas de IA com os objetivos de negócio, gerenciar obrigações éticas e regulatórias e confirmar que os modelos se comportam de maneira consistente e previsível enquanto estão em produção.

Além disso, a governança de IA tem um impacto significativo no ROI de IA. Sem propriedade, políticas e controles de risco claros, os programas de IA podem frequentemente estagnar, enfrentar incidentes de segurança evitáveis ou simplesmente não conseguir conquistar a confiança das partes interessadas. Pesquisas do setor mostram que os desafios de governança são uma barreira primária para a escalabilidade da IA, enquanto mais da metade dos líderes aponta a falta de clareza na propriedade, controles de risco inadequados ou a falta de compliance como as causas principais de projetos de IA malsucedidos. Além disso, problemas como viés de modelo, vazamento de dados e comportamento não autorizado de modelos têm aumentado, o que exige práticas de governança mais robustas. Esses números destacam como a governança é um pré-requisito crucial para o valor da IA, e não apenas uma reflexão tardia.

Também é importante distinguir governança de segurança. Enquanto a segurança se concentra em proteger dados, modelos e infraestrutura contra ameaças, a governança, por sua vez, define como as decisões são tomadas sobre o desenvolvimento e o uso de IA.

Isso inclui questões como estabelecer responsabilidade, definir políticas, avaliar riscos e garantir operações éticas e transparentes. Juntas, governança e segurança formam a base para uma IA segura и escalável. Com o Databricks AI Governance Framework, as empresas obtêm uma abordagem estruturada para desenvolver essas capacidades antes de escalar a IA em produtos e fluxos de trabalho.

Por que a governança de IA não pode esperar

De acordo com uma pesquisa global de 2024 com 1.100 executivos e engenheiros de tecnologia conduzida pela Economist Impact, 40% dos entrevistados acreditavam que o programa de Governança de AI de sua organização era insuficiente para garantir a segurança e o compliance de seus ativos e casos de uso de AI. Além disso, a privacidade de dados e as violações de segurança foram a principal preocupação de 53% dos arquitetos corporativos, enquanto a segurança e a governança são os aspectos mais desafiadores da engenharia de dados para os engenheiros.

Além disso, de acordo com o Gartner, o gerenciamento de confiança, risco e segurança de IA é a principal tendência estratégica em 2024 que influenciará as decisões de negócios e tecnologia, e até 2026, os modelos de IA de organizações que operacionalizam a transparência, a confiança e a segurança da IA alcançarão um aumento de 50% em termos de adoção, metas de negócios e aceitação do usuário.

É evidente que a falta de programas de governança de IA em nível empresarial está se tornando rapidamente um obstáculo chave para a obtenção de retorno sobre o valor dos investimentos em AI e para a adoção da AI como um todo.

Por isso, desenvolvemos um framework de orientação abrangente que as empresas podem aproveitar para criar programas eficazes de governança de IA.

Uma Abordagem Estruturada para a Governança de IA

As melhores práticas para implementar a governança de IA exigem uma metodologia estruturada e repetível que alinhe pessoas, processos e tecnologia em toda a organização. A Estrutura de Governança da Databricks AI desenvolve uma abordagem holística que começa com o estabelecimento de objetivos de negócios claros, a definição de responsabilidades e a criação de modelos de governança que se integram perfeitamente às estruturas empresariais existentes. Os programas de governança são bem-sucedidos quando são tratados como extensões das estratégias organizacionais, práticas de risco e processos de gestão de dados existentes.

Um aspecto chave desta abordagem é incorporar as responsabilidades de governança entre as equipes, em vez de centralizá-las em um único grupo. Os líderes de negócios definem a direção estratégica articulando as metas de IA, definindo os níveis de risco aceitáveis e garantindo o alinhamento com as prioridades da empresa.

Equipes como engenharia de dados, ciência de dados e engenharia de ML operacionalizam essas diretrizes implementando padrões para qualidade de dados, documentação de modelos, linhagem, reprodutibilidade e controles de acesso. As equipes jurídica, de compliance e de segurança desempenham um papel adicional e paralelo para garantir a prontidão regulatória, a adesão às políticas e a proteção de dados dos ativos de dados e modelos ao longo de todo o ciclo de vida.

Integrar a governança com sistemas operacionais proporciona consistência e escalabilidade. Por exemplo, soluções unificadas de governança de dados como o Unity Catalog podem padronizar políticas de acesso, impor a linhagem e centralizar metadados para avaliação de riscos e auditabilidade. Enquanto isso, práticas sólidas de engenharia de dados garantem que os programas de IA sejam construídos sobre bases de dados confiáveis e bem governadas, com pipelines reprodutíveis e transformações transparentes que podem ser monitoradas ao longo do tempo.

A governança de IA eficaz não é um exercício único. Processos contínuos de monitoramento e avaliação são necessários para acompanhar o desempenho do modelo, avaliar o drift de dados, detectar vieses, confirmar a compliance de políticas e identificar riscos emergentes. Esse ciclo de feedback contínuo garante que os modelos permaneçam alinhados com as expectativas de negócios e os requisitos regulatórios à medida que as condições evoluem. Revisões regulares por equipes multifuncionais também ajudam as organizações a ajustar políticas proativamente, retreinar modelos e aprimorar os processos de governança.

Ao adotar uma abordagem estruturada, colaborativa e orientada ao ciclo de vida, as organizações podem criar programas de governança que escalam de forma confiável, reduzem o risco e aceleram a adoção segura de AI em toda a empresa.

Os cinco pilares fundamentais para a governança de IA

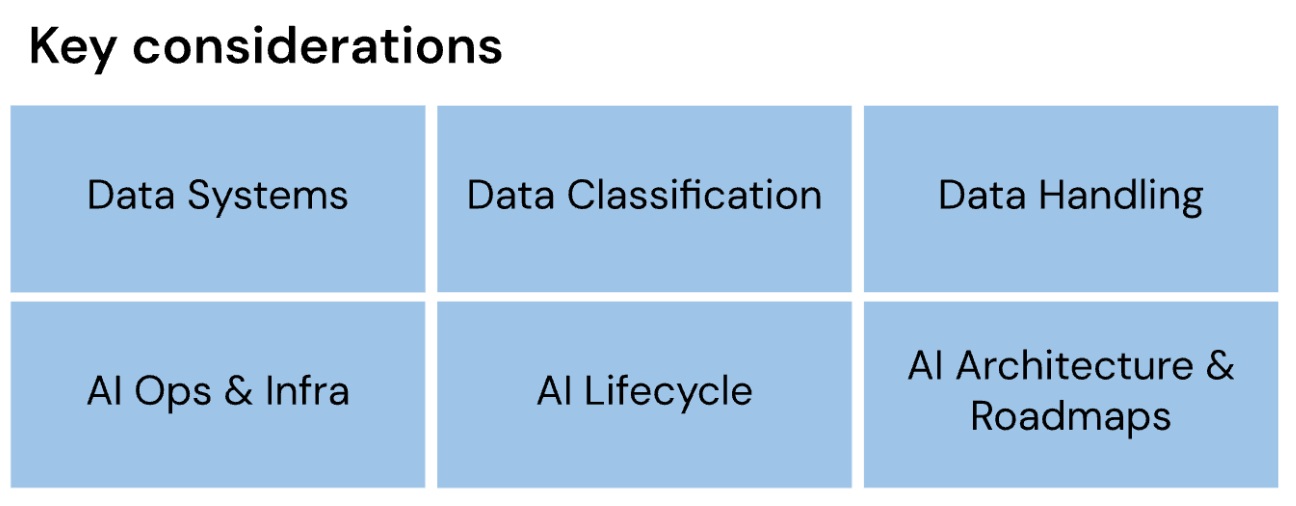

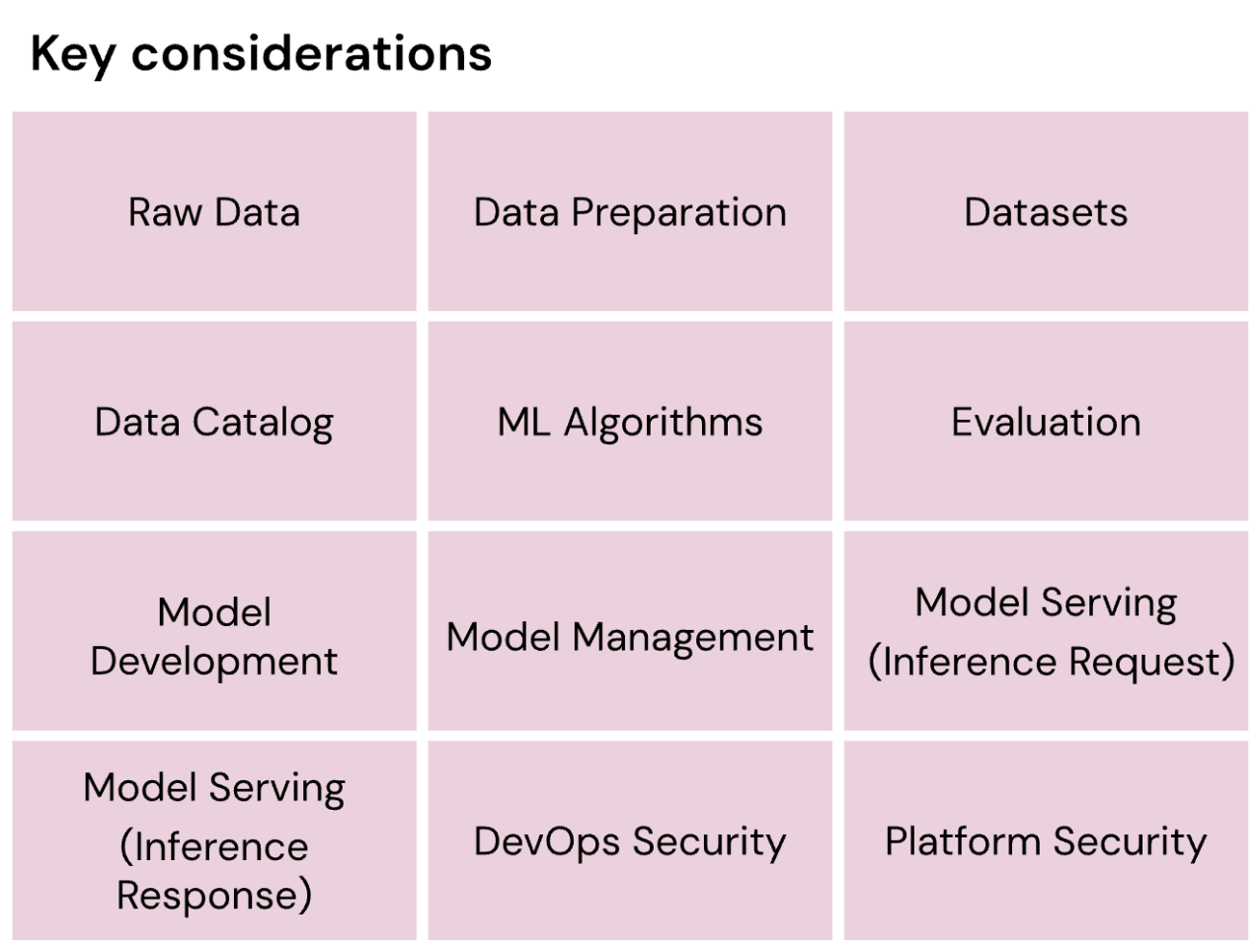

Nesta estrutura, apresentamos 43 considerações chave que são essenciais para toda empresa entender (e implementar conforme apropriado) para governar efetivamente suas jornadas de IA.

As principais considerações para a governança de IA são agrupadas logicamente em cinco pilares fundamentais, projetados e sequenciados para refletir as estruturas organizacionais e personas empresariais típicas.

- Organização de IA

- compliance legal e regulatória

- Ética, transparência e interpretabilidade

- Dados, AI Ops e infraestrutura

- Segurança de IA

Gartner®: Databricks, líder em banco de dados em nuvem

Uma estrutura para a governança de AI

Organização de IA

A Organização de IA incorpora a governança de IA na estratégia de governança mais ampla da organização. Isso underscore a base para um programa de IA eficaz por meio de melhores práticas, como objetivos de negócios claramente definidos e a integração das práticas de governança apropriadas que supervisionam as pessoas, os processos, a tecnología e os dados da organização. Explica como as organizações podem estabelecer a supervisão necessária para alcançar suas metas estratégicas e, ao mesmo tempo, reduzir os riscos.

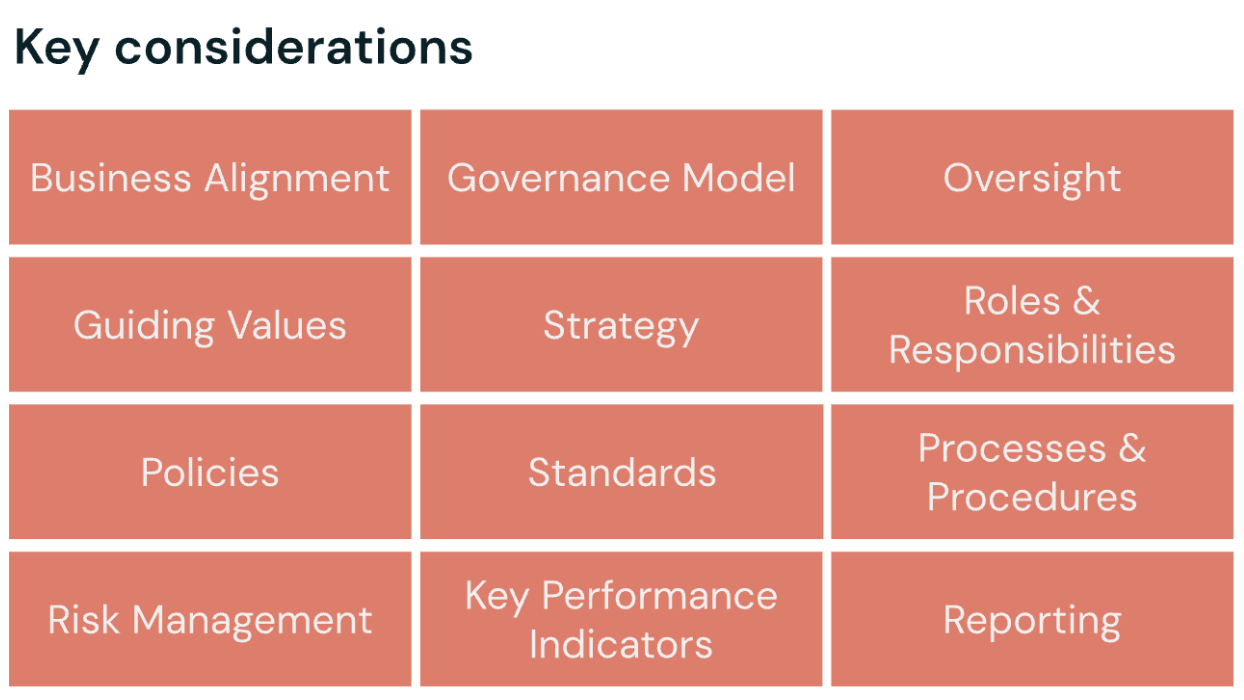

Principais considerações para uma organização eficaz de governança de IA

- Alinhamento de negócios

- Modelo de governança

- Supervisão

- Valores orientadores

- Estratégia

- Funções & responsabilidades

- Políticas

- Padrão

- Processos & procedimentos

- Gerenciamento de riscos

- Indicadores-chave de desempenho

- Relatórios

Faça o Download do AI Governance Framework para obter os passos para começar.

Compliance Legal e Regulatória de Iniciativas de AI

O pilar de Conformidade Legal e Regulatória ajuda as organizações a alinhar as iniciativas de IA com as leis e regulamentações aplicáveis. Ele orienta o gerenciamento de riscos legais, a interpretação de requisitos específicos do setor e a adaptação de estratégias de compliance em resposta a cenários regulatórios em evolução. O resultado é que os programas de AI são desenvolvidos e implantados dentro de um framework legal e regulatório robusto.

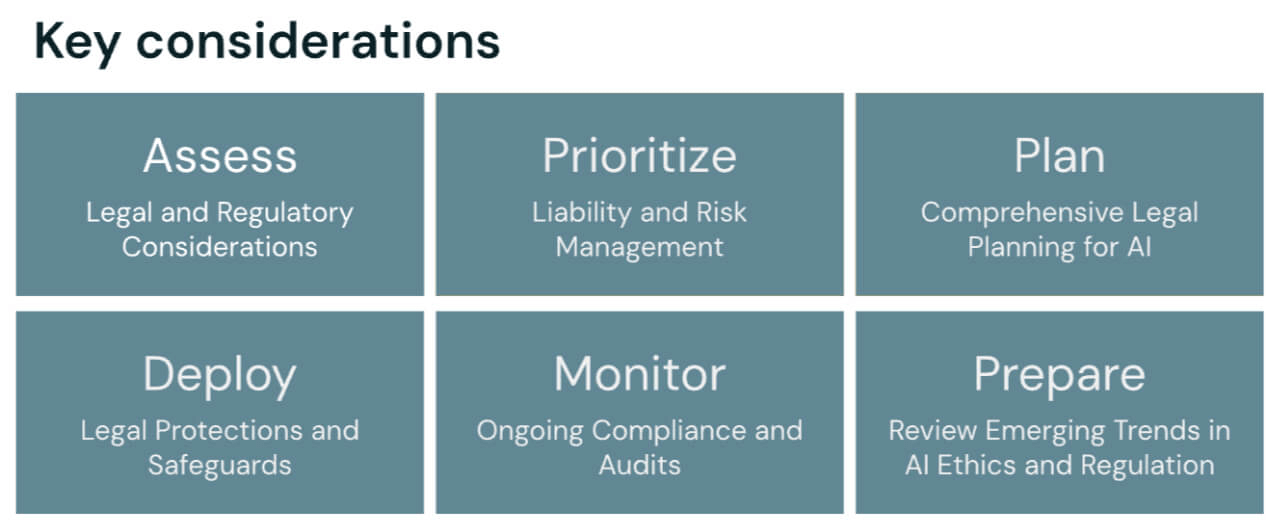

Os passos para alinhar as iniciativas de AI com leis e regulamentações

- Avaliar considerações legais e regulatórias

- Priorizar a gestão de responsabilidade e risco

- Planejar uma revisão jurídica abrangente

- Implantar proteções e salvaguardas legais

- Monitorar a compliance contínua e realizar auditorias regulares

- Revisar tendências emergentes em ética e regulamentação de AI

Ética, Transparência e Interpretabilidade de Programas de IA

Em organizações que criam sistemas de IA confiáveis e responsáveis, é importante aderir a princípios éticos como justiça, responsabilidade e supervisão humana, enquanto se promove a explicabilidade e o engajamento das partes interessadas. Este pilar na estrutura de governança de IA fornece métodos para estabelecer responsabilidade e estrutura dentro das equipes organizacionais, ajudando a garantir que as decisões de IA sejam interpretáveis, alinhadas com os padrões éticos em evolução e promovendo a confiança a longo prazo e a aceitação social.

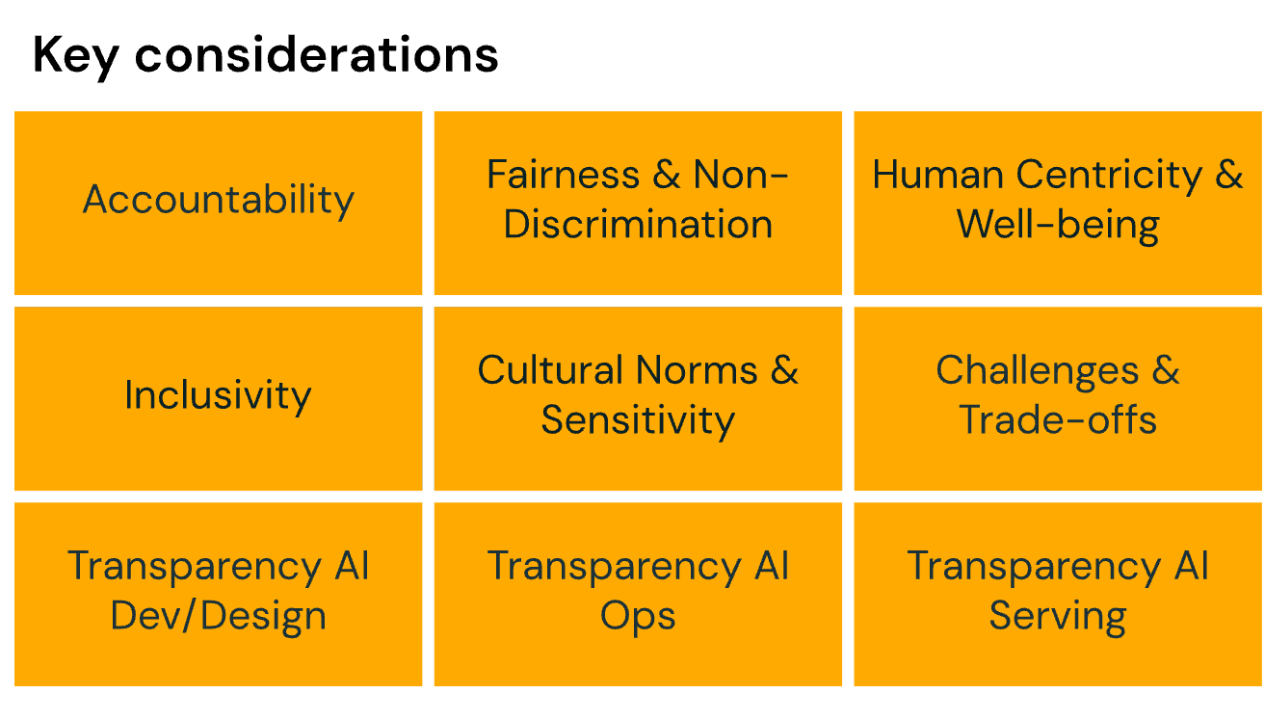

Ao projetar programas de IA e implementar ferramentas de governança de IA, considere como você abordará:

- Responsabilidade

- Justiça e não discriminação

- Centralidade no ser humano e bem-estar

- Inclusividade

- Normas culturais e sensibilidade

- Desafios e trade-offs de tudo o que foi mencionado acima

- Transparência no desenvolvimento e design de AI

- Transparência nas operações de IA

- Transparência no fornecimento de IA

Dados, Operações de IA e Infraestrutura para Governança de IA

O pilar de Dados, Operações de IA (AIOps) e Infraestrutura define a base que apoia as organizações na implantação e manutenção completas da IA. Você precisará de diretrizes para criar uma infraestrutura de IA escalável e confiável, gerenciar o ciclo de vida de machine learning e garantir a qualidade, segurança e compliance dos dados. Este pilar também enfatiza as melhores práticas para operações de AI, incluindo treinamento, avaliação, implantação e monitoramento de modelos, para que os sistemas de AI sejam confiáveis, eficientes e alinhados com os objetivos de negócios.

Pilar V: Segurança de IA

O pilar de Segurança de IA apresenta o Databricks AI Security Framework (DASF), um framework abrangente para entender e mitigar os riscos de segurança em todo o ciclo de vida da IA. Ele abrange áreas críticas como proteção de dados, gerenciamento de modelos, servindo modelo seguro e a implementação de medidas robustas de cibersegurança para proteger os ativos de AI.

Relacionado: Veja um passo a passo de exemplo de como uma organização pode aproveitar o framework de governança de IA para criar responsabilidades claras e alinhamento em todo o ciclo de vida do programa de IA. Assista a esta apresentação feita durante o 2025 Data + AI Summit.

Estrutura de Governança de AI

O whitepaper do AI Governance Framework está disponível para organizações que buscam desenvolver sua própria governança de IA.

Entre em contato conosco pelo email [email protected] para qualquer dúvida ou feedback. Se você tiver interesse em contribuir para futuras atualizações desta estrutura (e outros artefatos futuros) juntando-se à nossa comunidade de revisores, adoraríamos ouvir de você também!

Princípios Chave para uma Governança de IA Eficaz

A governança de IA depende de um conjunto consistente de princípios fundamentais que operam em todas as fases do ciclo de vida da IA. Esses princípios garantem que os sistemas de IA sejam desenvolvidos e implantados de forma responsável, ao mesmo tempo que fornecem uma estrutura necessária para as organizações atenderem às expectativas regulatórias, manterem a confiança das partes interessadas e mitigarem os riscos à medida que a adoção aumenta. Princípios como transparência, responsabilidade, justiça e supervisão humana estão no cerne de qualquer estratégia eficaz.

A transparência começa com uma documentação clara e acessível das fontes de dados, premissas do modelo, metodologias de treinamento e processos de avaliação. Uma prática de transparência requer o acompanhamento sistemático da linhagem, do versionamento e dos comportamentos do modelo para que as equipes possam rastrear como as decisões são tomadas e identificar os fatores contribuintes quando surgem problemas. Ferramentas de governança que centralizam metadados, trilhas de auditoria e políticas de acesso apoiam este trabalho, tornando os detalhes operacionais visíveis e verificáveis entre as equipes.

A governança de IA também deve priorizar medidas de responsabilização para que todo sistema de IA tenha proprietários claramente definidos, responsáveis pelos resultados, gerenciamento de riscos e adesão aos padrões de governança. Uma estrutura de responsabilização eficaz estabelelece funções entre os grupos de negócios, técnicos, jurídicos e de compliance; distribui os direitos de tomada de decisão; e cria mecanismos de escalonamento quando surgem comportamentos inesperados do modelo ou preocupações éticas. Além disso, a criação de KPIs e limites de desempenho pode fornecer aos líderes benchmarks mensuráveis para avaliar os sistemas de AI ao longo do tempo.

Um princípio de equidade exige a identificação e mitigação proativa de vieses durante a coleta de dados, o treinamento de modelos e o monitoramento da produção. Técnicas como análise de impacto díspar, métricas de detecção de viés e estratégias de amostragem representativa podem ajudar as equipes a entender como os resultados do modelo variam entre os grupos de usuários. As avaliações contínuas de equidade permitem que as organizações identifiquem drift ou desigualdades à medida que o uso no mundo real evolui.

Finalmente, a supervisão humana ajuda os sistemas de IA a se alinharem com os valores organizacionais e os requisitos regulatórios. Este passo envolve definir onde a revisão humana é necessária, projetar procedimentos de fallback claros e garantir que especialistas no assunto possam intervir quando as saídas do modelo forem ambíguas, de alto risco ou confidenciais. Os mecanismos de supervisão devem ser integrados tanto nos fluxos de trabalho de desenvolvimento quanto nas operações de produção para que as salvaguardas permaneçam ativas durante todo o ciclo de vida da IA.

Implementando práticas de IA responsável

As práticas de IA Responsável são as diretrizes que garantem que os sistemas de IA atendam às pessoas, às empresas e à sociedade de maneiras seguras, justas e alinhadas com os valores organizacionais. A implementação dessas práticas exige uma abordagem holística em todo o ciclo de vida da IA. Da coleta de dados e desenvolvimento de modelos à implantação, monitoramento e eventual desativação, cada estágio é uma oportunidade para incorporar proteções. Em resumo, o objetivo de qualquer prática de IA responsável é reduzir danos, fortalecer a confiança e melhorar o desempenho do sistema ao longo do tempo.

Um componente crítico da IA responsável é alinhar o comportamento do sistema com os valores humanos e os princípios organizacionais. Isso começa com a definição do uso pretendido de um modelo, incluindo quaisquer cenários sensíveis ou de alto impacto, e o estabelecimento de requisitos relacionados à privacidade, equidade, segurança e explicabilidade. É crucial incorporar esses critérios no início do processo de design para que as equipes abordem explicitamente as considerações éticas, em vez de simplesmente responder de forma reativa. Técnicas específicas ajudam os sistemas de IA a operar de forma consistente com as expectativas do usuário e as normas sociais, como ferramentas de interpretabilidade de modelos, datasets de treinamento representativos e processos de revisão com intervenção humana.

Além disso, a identificação e mitigação de riscos devem ser integradas diretamente nos fluxos de trabalho de desenvolvimento. As organizações devem avaliar riscos como viés, drift do modelo, alucinações, vazamento de dados e saídas inseguras, e desenvolver estratégias de mitigação vinculadas a cada um. Essas estratégias também podem incluir privacidade diferencial, filtragem de prompts e saídas, testes adversariais e exercícios de red-teaming adaptados a riscos específicos do domínio. À medida que esse teste avança, as equipes devem documentar as avaliações e os controles de risco para fornecer transparência e apoiar os requisitos de auditoria regulatória e interna.

A implementação de práticas de IA responsável é um job contínuo. Até mesmo modelos bem governados podem se degradar à medida que as distribuições de dados mudam ou novos requisitos surgem. As equipes devem estabelecer pipelines de monitoramento automatizados para ajudá-las a acompanhar métricas de desempenho, indicadores de justiça e compliance de políticas em produção. Quando surgem problemas, procedimentos de retreinamento, revisões de incidentes estruturadas e documentação atualizada garantem que os sistemas de IA evoluam de forma responsável.

É importante que qualquer equipe equilibre a inovação com a cautela. As equipes devem criar caminhos que permitam a experimentação, como ambientes de sandbox ou implantações piloto controladas, enquanto mantêm barreiras de proteção que evitem danos não intencionais. Esse equilíbrio capacita as organizações a explorar novos recursos de IA generativa, ao mesmo tempo que aderem às expectativas de governança e aos padrões éticos.

Começando com a implementação do DAGF

A implementação do Databricks AI Governance Framework (DAGF) começa com um roteiro claro e prático que orienta as organizações desde o planejamento inicial até as operações em escala empresarial. O primeiro o passo é estabelecer estruturas de governança fundamentais: definindo papéis e responsabilidades, documentando casos de uso de IA e avaliando a prontidão organizacional em termos de qualidade de dados, práticas de desenvolvimento de modelos e requisitos de compliance. Esse alinhamento inicial garante que os esforços de governança apoiem diretamente as prioridades de negócios e a tolerância a riscos.

Um modelo de maturidade pode ajudar as organizações a avaliar sua situação atual e a identificar os próximos passos em sua jornada de governança. Por exemplo, programas em estágio inicial se concentram em documentar ativos de IA, centralizar os controles de acesso e estabelecer políticas de base para uso de dados, desenvolvimento de modelos e revisão. À medida que isso amadurece, as organizações podem começar a introduzir fluxos de trabalho padronizados, linhagem e monitoramento automatizados e comitês multifuncionais que supervisionam o risco e compliance da AI. Finalmente, programas totalmente maduros operacionalizam a governança em todo o ciclo de vida, o que inclui pipelines reprodutíveis, avaliação contínua de modelos e processos bem definidos para retreinamento, auditoria e resposta a incidentes.

Não importa o quão cuidadosamente um framework de governança seja implementado, existem algumas armadilhas comuns que as organizações enfrentam. Por exemplo, muitos têm dificuldades quando a governança é tratada como uma reflexão tardia ou atribuída a uma única equipe sem responsabilidade clara. Outros podem subestimar o papel dos dados de alta qualidade e não implementar algumas práticas fundamentais, como imposição de esquema, rastreamento de linhagem e acesso controlado. Essas lacunas podem parecer pequenas superficialmente, mas podem criar desafios posteriores em transparência, reprodutibilidade e auditabilidade. Estabelecer a responsabilidade compartilhada entre as equipes de negócios, técnicas e de compliance, bem como basear a governança em sólidas práticas de engenharia de dados, pode ajudar a evitar esse problema em toda a organização.

Para medir o sucesso, as organizações devem acompanhar o progresso e medir o impacto dos investimentos em governança. As métricas podem incluir reduções em incidentes de modelo e detecções de viés, melhora na reprodutibilidade do modelo, aumento na completude da documentação, ciclos de revisão mais curtos, aprovações mais rápidas para novos casos de uso de IA e maior adoção de pipelines e ferramentas padronizadas. Com o tempo, esses indicadores demonstram como a governança é uma função essencial para confiabilidade, conformidade e eficiência operacional.

A implementação da governança deve ser uma abordagem em fases que ajude as organizações a se alinharem cuidadosamente com seus recursos e metas. Muitos começam com casos de uso de alto impacto, aplicando controles de governança aos modelos mais confidenciais ou críticos para os negócios antes de expandir para programas mais amplos. No entanto, iterar e escalar incrementalmente pode ajudar as organizações a construir uma base de governança durável que apoie a adoção de IA segura, transparente e confiável em toda a organização.

Por que a Databricks está liderando esse esforço

Como líder do setor no espaço de dados e IA, com mais de 15.000 clientes em diversas geografias e segmentos de mercado, a Databricks continuou a cumprir seu compromisso com os princípios de desenvolvimento responsável e inovação de código aberto. Mantivemos esses compromissos por meio de nosso:

- Engajamento com a indústria e o governo nos esforços para promover a inovação e defender o uso de IA segura e confiável

- Workshops interativos para educar as organizações sobre como conduzir com sucesso sua jornada de AI de uma maneira consciente dos riscos

- Código aberto de inovações key de governança, como MLFlow e Unity Catalog, as únicas soluções unificadas do setor para governança de dados e AI entre clouds, formatos de dados e plataformas de dados.

Esses programas nos ofereceram uma visibilidade única sobre os problemas práticos que as empresas e os reguladores enfrentam hoje em governança de AI. Para aprofundar nosso compromisso de ajudar todas as empresas a terem sucesso e acelerarem sua jornada de Dados e IA, decidimos aproveitar essa visibilidade para construir (e disponibilizar gratuitamente) uma Estrutura de Governança de IA abrangente, estruturada e acionável.

(Esta publicação no blog foi traduzida utilizando ferramentas baseadas em inteligência artificial) Publicação original

Nunca perca uma postagem da Databricks

O que vem a seguir?

IA

7 de janeiro de 2025/8 min de leitura