Uma Abordagem Unificada para Proteção contra Exfiltração de Dados no Databricks

Estrutura abrangente e recomendações para mitigar o movimento de dados não autorizado no Databricks.

Summary

- Introduz um framework unificado de três requisitos para contextualizar a exfiltração de dados para plataformas de dados.

- Fornece 19 controles de segurança priorizados organizados por urgência de implementação, desde a gestão de identidade até as restrições do espaço de trabalho.

- Controles unificados em Databricks na AWS, Azure Databricks e Databricks no GCP.

Visão geral

A exfiltração de dados é um dos riscos de segurança mais sérios que as organizações enfrentam hoje. Isso pode expor informações sensíveis do cliente ou da empresa, levando a danos à reputação e penalidades regulatórias sob leis como o GDPR. O problema é que a exfiltração pode ocorrer de muitas maneiras - através de invasores externos, erros internos ou insiders mal-intencionados e muitas vezes é difícil de detectar até que o dano esteja feito.

As equipes de segurança e nuvem devem proteger contra esses riscos, permitindo que os funcionários usem ferramentas SaaS e serviços em nuvem para realizar seu trabalho. Com centenas de serviços em jogo, analisar todos os possíveis caminhos de exfiltração pode parecer esmagador.

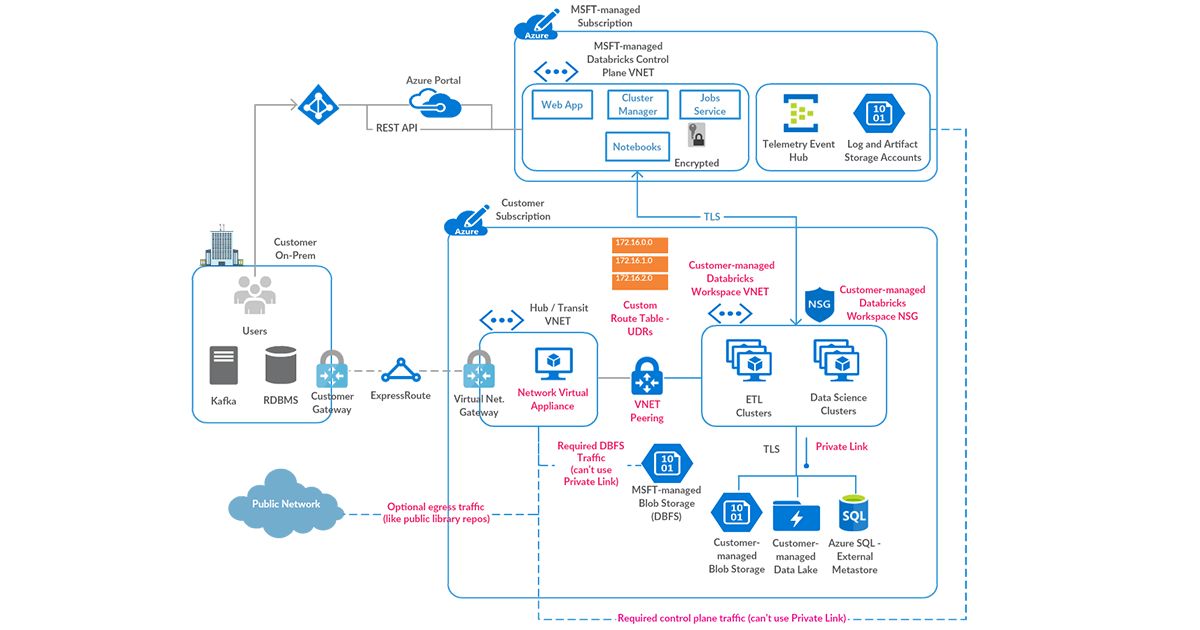

Neste blog, apresentamos uma abordagem unificada para proteger contra a exfiltração de dados no Databricks em AWS, Azure e GCP. Começamos com três requisitos de segurança fundamentais que formam uma estrutura para avaliar o risco. Em seguida, mapeamos esses requisitos em dezenove controles práticos, organizados por prioridade, que você pode aplicar seja construindo sua primeira estratégia de segurança Databricks ou fortalecendo uma já existente.

Uma Estrutura para Categorizar Controles de Proteção contra Exfiltração de Dados:

Começaremos definindo os três principais requisitos empresariais que formarão um framework abrangente para mapear os controles de proteção relevantes contra a exfiltração de dados:

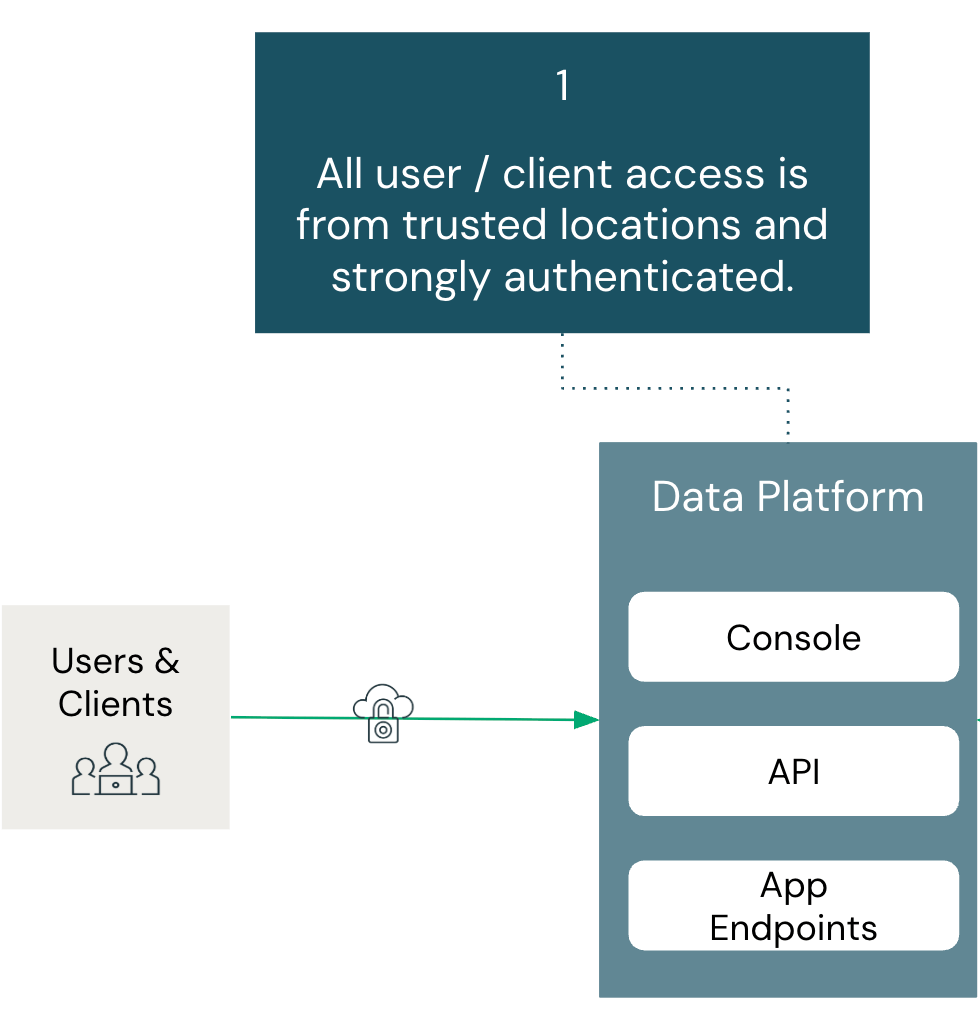

- Todo acesso do usuário/cliente é de locais confiáveis e fortemente autenticados:

- Todo acesso deve ser autenticado e originar de locais confiáveis, garantindo que usuários e clientes só possam alcançar sistemas a partir de redes aprovadas através de controles de identidade verificados.

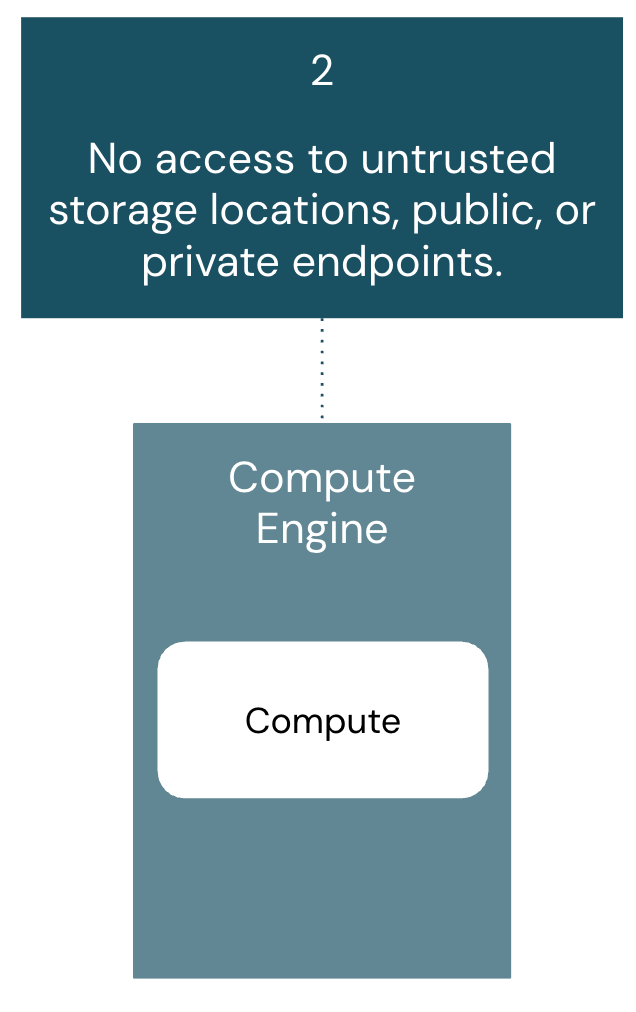

- Sem acesso a locais de armazenamento não confiáveis, públicos ou privados:

- Os motores de cálculo devem acessar apenas o armazenamento e os endpoints aprovados pelo administrador, prevenindo a exfiltração de dados para destinos não autorizados enquanto protegem contra serviços maliciosos.

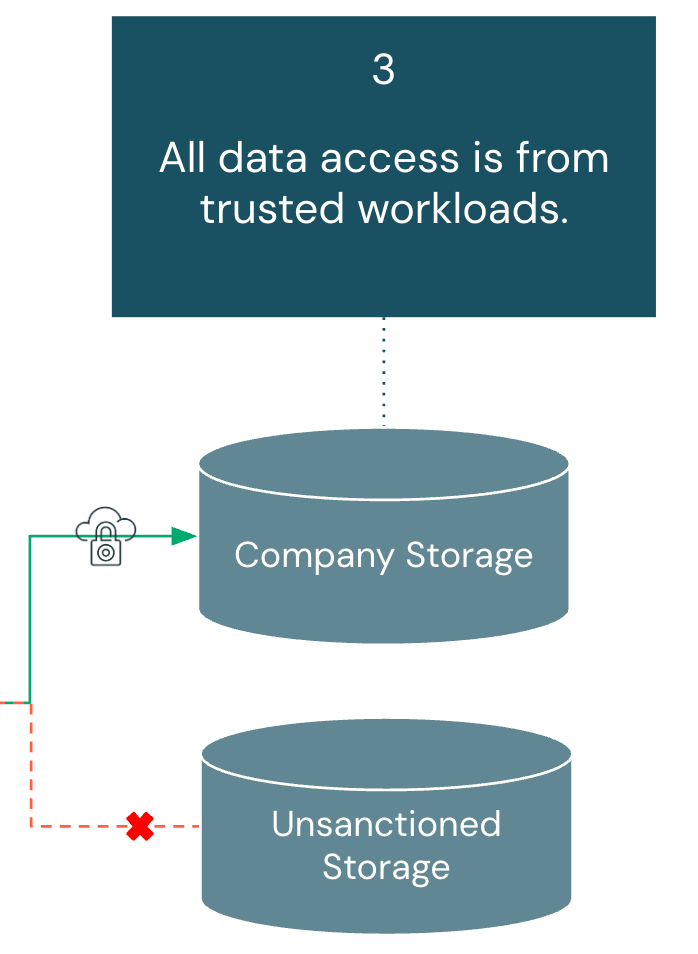

- Todo o acesso aos dados é proveniente de cargas de trabalho confiáveis:

- Os sistemas de armazenamento devem aceitar acesso apenas de recursos computacionais aprovados, criando uma camada final de verificação mesmo se as credenciais forem comprometidas em sistemas não confiáveis.

No geral, esses três requisitos trabalhando juntos abordam comportamentos do usuário que poderiam facilitar o movimento não autorizado de dados para fora do perímetro de segurança da organização. No entanto, é crucial que consideremos cada um desses três requisitos como um todo. Se houver uma lacuna nos controles em um dos requisitos, isso prejudica a postura de segurança de toda a arquitetura.

Nas seções seguintes, examinaremos os controles específicos mapeados para cada requisito individual.

Estratégias de Proteção contra Exfiltração de Dados para Databricks:

Para legibilidade e simplicidade, cada controle sob o requisito relevante é organizado por: componente de arquitetura, cenário de risco, mitigação correspondente, prioridade de implementação e documentação específica da nuvem.

A legenda para a priorização da implementação é a seguinte:

- ALTO - Implemente imediatamente. Esses controles são essenciais para todas as implantações do Databricks, independentemente do ambiente ou caso de uso.

- MÉDIO - Avalie com base na tolerância ao risco de sua organização e nos padrões específicos de uso do Databricks.

- BAIXO - Avalie com base no ambiente de trabalho (desenvolvimento, QA, produção) e nos requisitos de segurança organizacional.

NOTA: Antes de implementar controles, certifique-se de que você está na camada de plataforma correta para esse recurso. Os níveis necessários são observados nos links de documentação relevantes.

Todo Acesso do Usuário e Cliente é de Locais Confiáveis e Fortemente Autenticados:

Resumo

Os usuários devem se autenticar através de métodos aprovados e acessar o Databricks apenas de redes autorizadas. Isso estabelece a base para mitigar o acesso não autorizado.

Os componentes da arquitetura abordados nesta seção incluem: Provedor de Identidade, Console de Conta e Espaço de Trabalho.

Por que esse requisito é importante?

Garantir que todos os usuários e clientes se conectem de locais confiáveis e sejam fortemente autenticados é a primeira linha de defesa para mitigar a exfiltração de dados. Se uma plataforma de dados não pode confirmar que as solicitações de acesso se originam de redes aprovadas ou que os usuários são validados por meio de várias camadas de autenticação (como MFA), então todo controle subsequente é enfraquecido, deixando o ambiente vulnerável.

| Componente da Arquitetura: | Risco: | Controle: | Prioridade para Implementar: | Documentação |

|---|---|---|---|---|

| Provedor de Identidade e Console de Conta | Os usuários podem tentar contornar os controles de identidade corporativa usando contas pessoais ou métodos de login que não são de single-sign-on (SSO) para acessar os espaços de trabalho do Databricks. | Implemente o Login Unificado para aplicar a proteção de login único (SSO) em todos, ou selecionados, espaços de trabalho na conta Databricks. NOTA: Recomendamos a ativação da autenticação de múltiplos fatores (MFA) em seu Provedor de Identidade. Se você não pode usar SSO, pode configurar o MFA diretamente no Databricks. | ALTO | AWS, Azure, GCP |

| Provedor de Identidade | Ex-usuários podem tentar fazer login no espaço de trabalho após a saída da empresa. | Implemente o SCIM ou Gerenciamento Automático de Identidade para lidar com o desprovisionamento automático de usuários. | ALTO | AWS, Azure, GCP |

| Console da conta | Os usuários podem tentar acessar o console da conta a partir de redes não autorizadas. | Implemente listas de controle de acesso IP (ACLs) do console da conta | ALTO | AWS, Azure, GCP |

| Espaço de trabalho | Os usuários podem tentar acessar a área de trabalho a partir de redes não autorizadas. | Implemente controles de acesso à rede usando uma das seguintes abordagens: - Conectividade Privada - ACLs de IP | ALTO | Conectividade Privada: AWS, Azure, GCP ACLs de IP: AWS, Azure, GCP |

Gartner®: Databricks, líder em banco de dados em nuvem

Sem Acesso a Locais de Armazenamento Não Confiáveis, Públicos ou Privados:

Resumo

Os recursos de computação devem acessar apenas locais de armazenamento e pontos de extremidade pré-aprovados. Isso mitiga a exfiltração de dados para destinos não autorizados e protege contra serviços externos maliciosos.

Componentes de arquitetura abordados nesta seção incluem: Computação Clássica, Computação Serverless e Catálogo Unity.

Por que esse requisito é importante?

A exigência de que o computador acesse apenas locais de armazenamento e pontos de extremidade confiáveis é fundamental para preservar o perímetro de segurança de uma organização. Tradicionalmente, os firewalls serviam como a principal salvaguarda contra a exfiltração de dados, mas à medida que os serviços em nuvem e os pontos de integração SaaS se expandem, as organizações devem levar em conta todos os vetores potenciais que poderiam ser explorados para mover dados para destinos não confiáveis.

| Componente da Arquitetura: | Risco: | Controle: | Prioridade para Implementar: | Documentação |

|---|---|---|---|---|

| Computação Clássica | Os usuários podem executar códigos que interagem com endpoints públicos maliciosos ou não aprovados. | Implemente um firewall de saída na rede do seu provedor de nuvem para filtrar o tráfego de saída apenas para domínios e endereços IP aprovados. Caso contrário, para certos provedores de nuvem, remova todo o acesso de saída para a internet. | ALTO | AWS, Azure, GCP |

| Computação Clássica | Os usuários podem executar códigos que exfiltram dados para recursos de nuvem não monitorados, aproveitando a conectividade de rede privada para acessar contas de armazenamento ou serviços fora de seu escopo pretendido. | Implemente o acesso orientado por políticas (por exemplo, políticas de ponto de extremidade do VPC, políticas de ponto de extremidade de serviço, etc.) e a segmentação de rede para restringir o acesso ao cluster apenas a recursos e contas de armazenamento na nuvem pré-aprovados. | ALTO | AWS, Azure, GCP |

| Compute serverless | Os usuários podem executar códigos que exfiltram dados para serviços externos não autorizados ou pontos de extremidade maliciosos através de conexões públicas à internet. | Implemente controles de saída sem servidor para restringir o tráfego de saída apenas para contas de armazenamento pré-aprovadas e pontos de extremidade públicos verificados. | ALTO | AWS, Azure, GCP |

| Unity Catalog | Os usuários podem tentar acessar contas de armazenamento não confiáveis para exfiltrar dados fora do perímetro de dados aprovado pela organização. | Permita apenas que os administradores criem credenciais de armazenamento e locais externos. Dê aos usuários permissões para usar os securáveis do Catálogo Unity aprovados. Pratique o princípio do menor privilégio para políticas de acesso à nuvem (por exemplo, IAM) para credenciais de armazenamento. | ALTO | AWS, Azure, GCP |

| Unity Catalog | Os usuários podem tentar acessar bancos de dados não confiáveis para ler e escrever dados não autorizados. | Permita apenas que administradores criem conexões de banco de dados usando a Federação Lakehouse. Dê aos usuários permissões para usar conexões aprovadas. | MÉDIO | AWS, Azure, GCP |

| Unity Catalog | Os usuários podem tentar acessar recursos de nuvem não confiáveis que não sejam de armazenamento (por exemplo, serviços de streaming gerenciados) usando credenciais não autorizadas. | Permita apenas que os administradores criem credenciais de serviço para serviços em nuvem externos. Dê aos usuários permissões para usar credenciais de serviço aprovadas. Pratique o princípio do menor privilégio para políticas de acesso à nuvem (por exemplo, IAM) para credenciais de serviço. | MÉDIO | AWS, Azure, GCP |

Todo Acesso aos Dados é de Cargas de Trabalho Confiáveis:

Resumo

O armazenamento de dados deve aceitar acesso apenas de cargas de trabalho Databricks aprovadas e fontes de computação confiáveis. Isso mitiga o acesso não autorizado tanto aos dados do cliente quanto aos artefatos da área de trabalho, como notebooks e resultados de consultas. Os componentes da arquitetura abordados nesta seção incluem: Conta de Armazenamento, Computação Serverless, Catálogo Unity e Configurações de Espaço de Trabalho.

Por que esse requisito é importante?

À medida que as organizações adotam mais ferramentas SaaS, as solicitações de dados se originam cada vez mais fora das redes tradicionais de nuvem. Essas solicitações podem envolver armazenamentos de objetos em nuvem, bancos de dados ou plataformas de streaming, cada uma criando possíveis vias para exfiltração. Para reduzir esse risco, o acesso deve ser consistentemente aplicado através de camadas de governança aprovadas e restrito a ferramentas de dados sancionadas, garantindo que os dados sejam usados dentro de ambientes controlados.

| Componente da Arquitetura: | Risco: | Controle: | Prioridade para Implementar: | Documentação |

|---|---|---|---|---|

| Conta de armazenamento | Os usuários podem tentar acessar contas de armazenamento do provedor de nuvem através de computação não governada pelo Catálogo Unity. | Implemente firewalls ou políticas de bucket nas contas de armazenamento para aceitar tráfego apenas de destinos de origem aprovados. | ALTO | AWS, Azure, GCP |

| Unity Catalog | Os usuários podem tentar ler e escrever dados de diferentes ambientes (por exemplo, espaço de trabalho de desenvolvimento lendo dados de produção) | Implemente ligações de espaço de trabalho para catálogos. | ALTO | AWS, Azure, GCP |

| Compute serverless | Os usuários podem precisar de acesso a recursos na nuvem através de computação sem servidor, forçando os administradores a expor serviços internos a um acesso de rede mais amplo do que o pretendido. | Implemente regras de pontos de extremidade privados no objeto de Configuração de Conectividade de Rede [AWS, Azure, GCP [Não disponível atualmente] | MÉDIO | AWS, Azure, GCP [Não disponível atualmente] |

| Configurações do workspace | Os usuários podem tentar baixar os resultados do notebook para sua máquina local. | Desative o download dos resultados do Notebook na configuração de segurança do administrador da Área de Trabalho. | BAIXO | AWS, Azure, GCP |

| Configurações do workspace | Os usuários podem tentar baixar arquivos de volume para sua máquina local. | Desative o Download de Arquivos de Volume na configuração de segurança do administrador do Workspace. | BAIXO | Documentação não disponível. Alternar para desativar encontrado nas configurações de segurança do administrador do espaço de trabalho sob saída e entrada. |

| Configurações do workspace | Os usuários podem tentar exportar notebooks ou arquivos da área de trabalho para sua máquina local. | Desative a opção Exportação de Notebook e Arquivo na configuração de segurança do administrador do Workspace. | BAIXO | AWS, Azure, GCP |

| Configurações do workspace | Os usuários podem tentar baixar os resultados do SQL para sua máquina local. | Desative o download de resultados SQL na configuração de segurança do administrador do Espaço de Trabalho. | BAIXO | AWS, Azure, GCP |

| Configurações do workspace | Os usuários podem tentar baixar artefatos de execução do MLflow para sua máquina local. | Desative o download do artefato de execução do MLflow na configuração de segurança do administrador da Área de Trabalho. | BAIXO | Documentação não disponível. Alternar para desativar encontrado nas configurações de segurança do administrador do espaço de trabalho sob saída e entrada. |

| Configurações do workspace | Os usuários podem tentar copiar dados tabulares para a área de transferência através da interface do usuário. | Desative o recurso de prancheta da tabela de resultados na configuração de segurança do administrador da Área de Trabalho. | BAIXO | AWS, Azure, GCP |

Monitoramento Proativo de Exfiltração de Dados:

Enquanto os três requisitos corporativos principais nos permitem estabelecer os controles preventivos necessários para proteger sua Plataforma de Inteligência de Dados Databricks, o monitoramento fornece as capacidades de detecção necessárias para validar que esses controles estão funcionando conforme o esperado. Mesmo com autenticação robusta, acesso de computação restrito e armazenamento seguro, você precisará de visibilidade sobre os comportamentos dos usuários que podem indicar tentativas de contornar seus controles estabelecidos.

A Databricks oferece tabelas de sistema abrangentes para monitoramento de controle de acesso [AWS, Azure, GCP]. Usando essas tabelas de sistema, os clientes podem configurar alertas com base em atividades potencialmente suspeitas para aumentar os controles existentes no workspace.

Para consultas prontas para uso que podem gerar insights acionáveis, visite este post do blog: Melhore o Monitoramento de Segurança do Lakehouse usando Tabelas de Sistema no Catálogo Unity do Databricks. Logs específicos da nuvem [AWS, Azure, GCP] podem ser ingeridos e analisados para aumentar os dados das tabelas de sistema Databricks.

Conclusão

Agora que cobrimos os riscos e controles associados a cada requisito de segurança que compõem essa estrutura, temos uma abordagem unificada para mitigar a exfiltração de dados em seu deployment do Databricks.

Embora prevenir o movimento não autorizado de dados seja um trabalho diário, isso fornecerá aos seus usuários uma base para desenvolver e inovar enquanto protege um dos ativos mais importantes da sua empresa: seus dados.

Para continuar a jornada de proteção da sua Plataforma de Inteligência de Dados, recomendamos fortemente a visita ao Centro de Segurança e Confiança para uma visão holística das Melhores Práticas de Segurança no Databricks.

- Os guias de Melhores Práticas fornecem uma visão detalhada dos principais controles de segurança que recomendamos para ambientes típicos e altamente seguros.

- Os Modelos Terraform - Arquitetura de Referência de Segurança facilitam a criação automática de ambientes Databricks que seguem as melhores práticas descritas neste blog.

- A Ferramenta de Análise de Segurança monitora continuamente a postura de segurança da sua Plataforma de Inteligência de Dados Databricks de acordo com as melhores práticas.

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura