O que há de novo: Lakeflow Jobs oferece uma orquestração de dados mais eficiente

O Lakeflow Jobs agora vem com um novo conjunto de capacidades e atualizações de design construídas para aprimorar a orquestração de fluxo de trabalho e melhorar a eficiência do pipeline.

Summary

- Descubra as mais recentes melhorias de UI/UX para Lakeflow Jobs que proporcionam aos usuários uma aparência e sensação mais limpas e intuitivas, melhorando sua experiência geral.

- Saiba sobre as últimas capacidades adicionadas que proporcionam flexibilidade e controle adicionais sobre os fluxos de trabalho.

- Saiba mais sobre o Lakeflow Connect em Jobs, uma nova e mais centralizada maneira de ingerir dados em seu pipeline.

Nos últimos meses, introduzimos atualizações empolgantes para Lakeflow Jobs (anteriormente conhecido como Databricks Workflows) para melhorar a orquestração de dados e otimizar o desempenho do fluxo de trabalho.

Para os recém-chegados, Lakeflow Jobs é o orquestrador integrado para Lakeflow, uma solução unificada e inteligente para engenharia de dados com desenvolvimento e operações de ETL simplificados, construídos na Plataforma de Inteligência de Dados. Lakeflow Jobs é o orquestrador mais confiável para o Lakehouse e cargas de trabalho de produção, com mais de 14.600 clientes, 187.000 usuários semanais e 100 milhões de trabalhos executados todas as semanas.

Desde melhorias na interface do usuário até um controle de fluxo de trabalho mais avançado, confira as últimas novidades na solução nativa de orquestração de dados do Databricks e descubra como os engenheiros de dados podem otimizar sua experiência de pipeline de dados de ponta a ponta.

Interface do usuário atualizada para uma experiência de usuário mais focada

Nós redesenhamos nossa interface para dar ao Lakeflow Jobs uma aparência fresca e moderna. O novo layout compacto permite uma jornada de orquestração mais intuitiva. Os usuários irão desfrutar de uma paleta de tarefas que agora oferece atalhos e um botão de pesquisa para ajudá-los a encontrar e acessar suas tarefas mais facilmente, seja um Pipeline Lakeflow, um painel de AI/BI, um notebook, SQL, ou mais.

Para monitoramento, os clientes agora podem facilmente encontrar informações sobre os tempos de execução de seus trabalhos no painel direito em Detalhes de execução de trabalho e tarefa, permitindo que eles monitorem facilmente os tempos de processamento e identifiquem rapidamente quaisquer problemas no pipeline de dados.

Também melhoramos a barra lateral, permitindo que os usuários escolham quais seções (Detalhes do trabalho, Agendas & Disparadores, Parâmetros do trabalho, etc.) ocultar ou manter abertas, tornando sua interface de orquestração mais limpa e relevante.

No geral, os usuários do Lakeflow Jobs podem esperar um fluxo de trabalho de orquestração mais simplificado, focado e simplificado. O novo layout está atualmente disponível para usuários que optaram pela visualização e ativaram a alternância na página de trabalhos.

Fluxos de dados mais controlados e eficientes

Nosso orquestrador está constantemente sendo aprimorado com novos recursos. A última atualização introduz controles avançados para a orquestração do pipeline de dados, dando aos usuários maior comando sobre seus fluxos de trabalho para maior eficiência e desempenho otimizado.

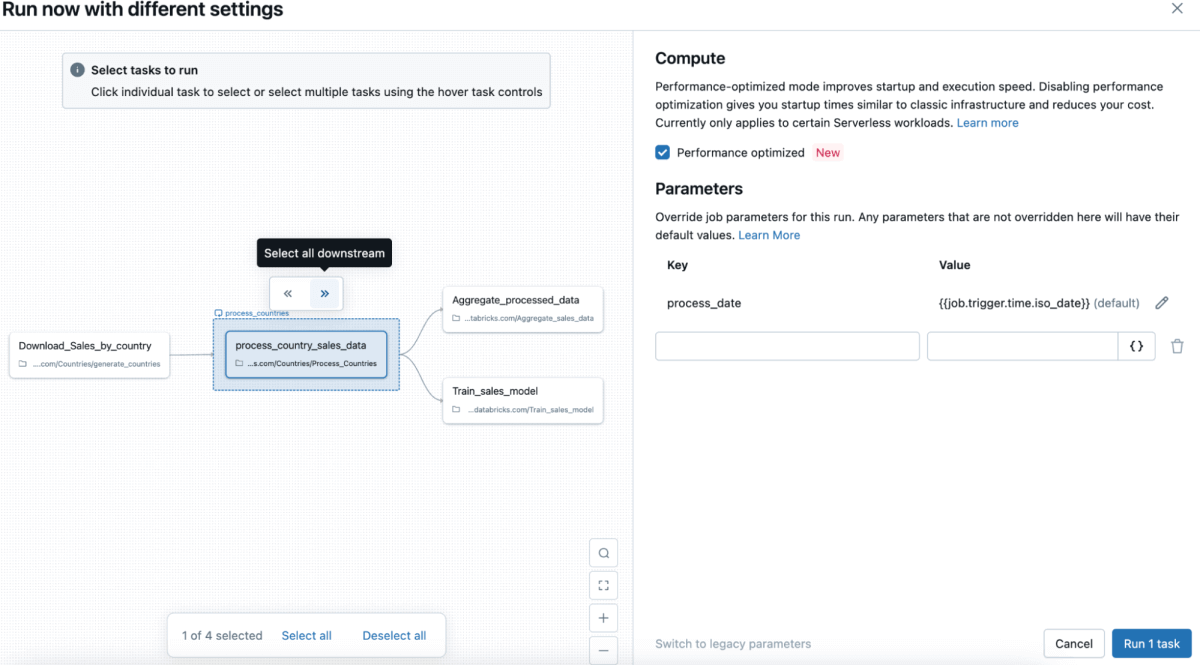

Execuções parciais permitem aos usuários selecionar quais tarefas executar sem afetar outras. Anteriormente, testar tarefas individuais exigia a execução do trabalho inteiro, o que poderia ser computacionalmente intensivo, lento e caro. Agora, na página Jobs & Pipelines, os usuários podem selecionar "Executar agora com configurações diferentes" e escolher tarefas específicas para executar sem impactar outras, evitando desperdício computacional e altos custos. Da mesma forma, Reparos parciais permitem um depuração mais rápida, permitindo aos usuários corrigir tarefas individuais que falharam sem ter que executar o trabalho inteiro novamente.

Com mais controle sobre seus fluxos de execução e reparo, os clientes podem acelerar os ciclos de desenvolvimento, melhorar o tempo de atividade do trabalho e reduzir os custos de computação. Ambas as execuções parciais e reparos estão geralmente disponíveis na UI e na Jobs API.

Para todos os fãs de SQL, temos ótimas notícias para vocês! Nesta última rodada de atualizações, os clientes poderão usar consultas SQL’ saídas como parâmetros no Lakeflow Jobs para orquestrar seus dados. Isso facilita para os desenvolvedores SQL passar parâmetros entre tarefas e compartilhar contexto dentro de um trabalho, resultando em uma orquestração de pipeline de dados mais coesa e unificada. Este recurso também está agora geralmente disponível.

Gartner®: Databricks, líder em banco de dados em nuvem

Início rápido com Lakeflow Connect em Jobs

Além desses aprimoramentos, também estamos tornando rápido e fácil a ingestão de dados no Lakeflow Jobs, integrando mais estreitamente os Jobs com o Lakeflow Connect, a solução de ingestão de dados gerenciada e confiável do Databricks Lakeflow, com conectores integrados.

Os clientes já podem orquestrar pipelines de ingestão do Lakeflow Connect que se originam do Lakeflow Connect, usando qualquer um dos conectores totalmente gerenciados (por exemplo, Salesforce, Workday, etc.) ou diretamente dos notebooks. Agora, com o Lakeflow Connect em Jobs, os clientes podem facilmente criar um pipeline de ingestão diretamente de dois pontos de entrada em sua interface de Jobs, tudo dentro de um ambiente de apontar e clicar. Como a ingestão é geralmente o primeiro passo no ETL, essa nova integração perfeita com o Lakeflow Connect permite que os clientes consolidem e simplifiquem sua experiência de engenharia de dados, de ponta a ponta.

Lakeflow Connect em Jobs agora está disponível para os clientes. Saiba mais sobre este e outros lançamentos recentes do Lakeflow Connect.

Uma única orquestração para todas as suas cargas de trabalho

Estamos constantemente inovando no Lakeflow Jobs para oferecer aos nossos clientes uma experiência de orquestração moderna e centralizada para todas as suas necessidades de dados em toda a organização. Mais recursos estão chegando aos Jobs - em breve revelaremos uma maneira dos usuários acionarem trabalhos com base em atualizações de tabelas, forneceremos suporte para tabelas de sistema e expandiremos nossas capacidades de observabilidade, então fique ligado!

Para aqueles que querem continuar aprendendo sobre Lakeflow Jobs, confira nossas sessões sob demanda do nosso Data+AI Summit e explore o Lakeflow em uma variedade de casos de uso, demonstrações e muito mais!

- Saiba mais sobre Lakeflow Jobs

- Crie seu primeiro trabalho com nosso Guia de Início Rápido

- Ative a nova interface do usuário usando a alternância na página de Trabalhos & Pipelines (apenas para clientes de visualização)

- Não conseguiu participar do Data+AI Summit? Assista às sessões do Lakeflow Jobs sob demanda

(This blog post has been translated using AI-powered tools) Original Post

Nunca perca uma postagem da Databricks

O que vem a seguir?

Produto

12 de junho de 2024/11 min de leitura