Simplificación de los pipelines de datos confiables

Simplifica el ETL por lotes y de transmisión con confiabilidad automatizada y calidad de datos i

LOS MEJORES EQUIPOS TRIUNFAN CON PIPELINES DE DATOS INTELIGENTESMejores prácticas de pipelines de datos codificadas

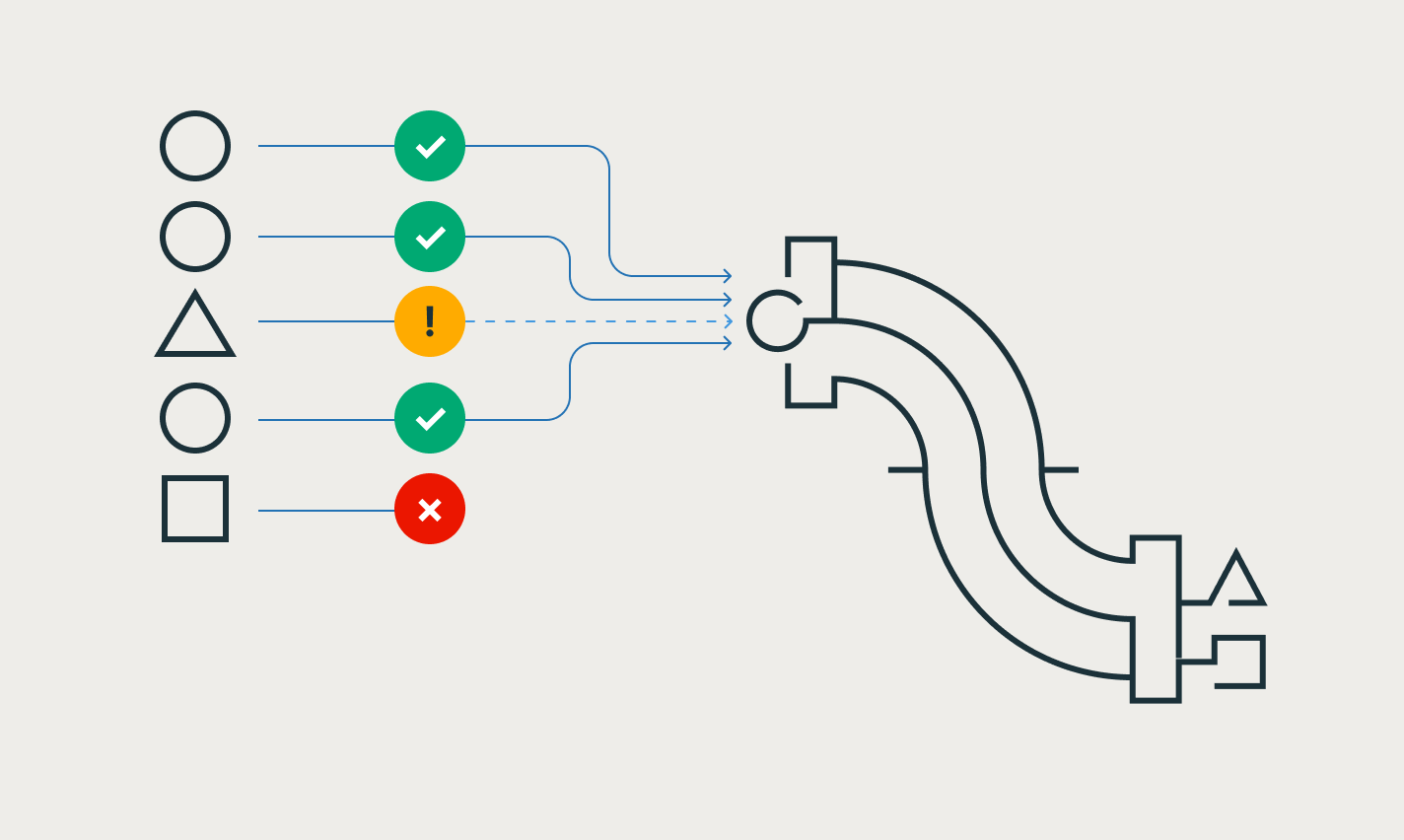

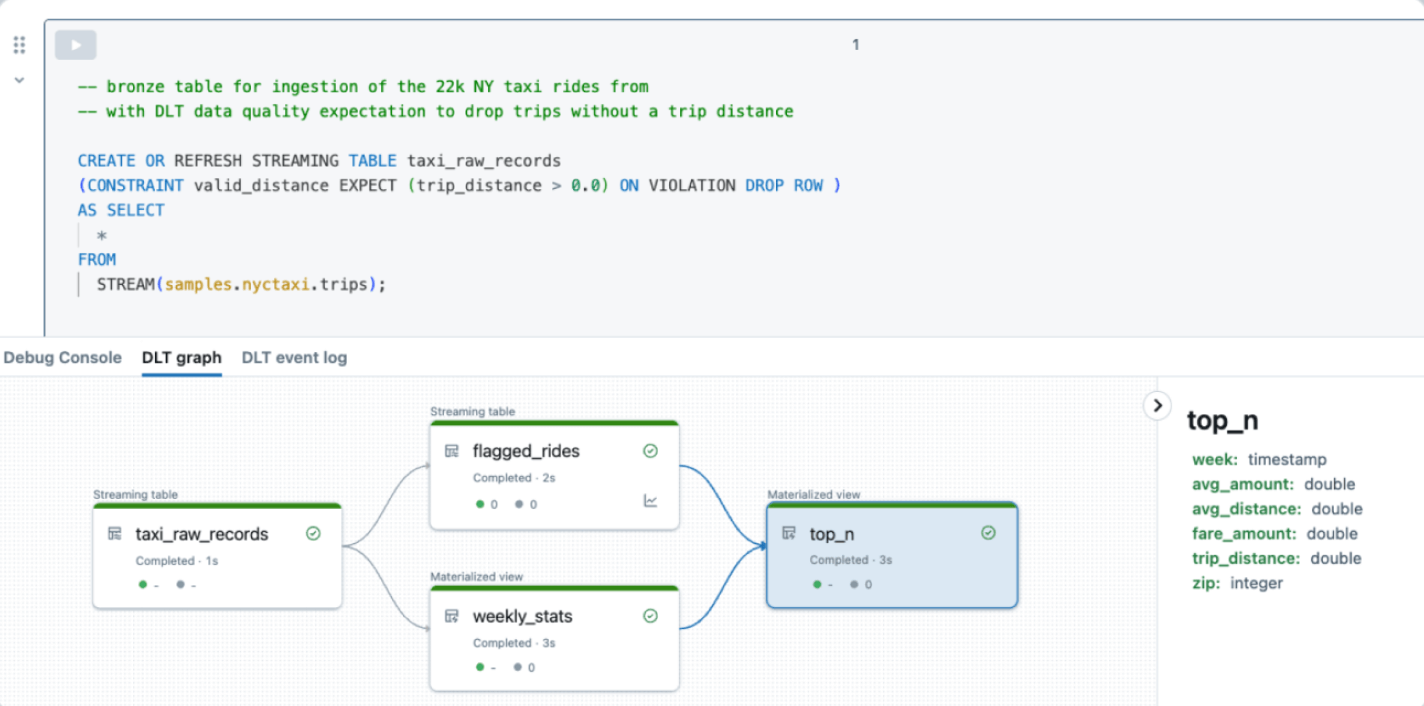

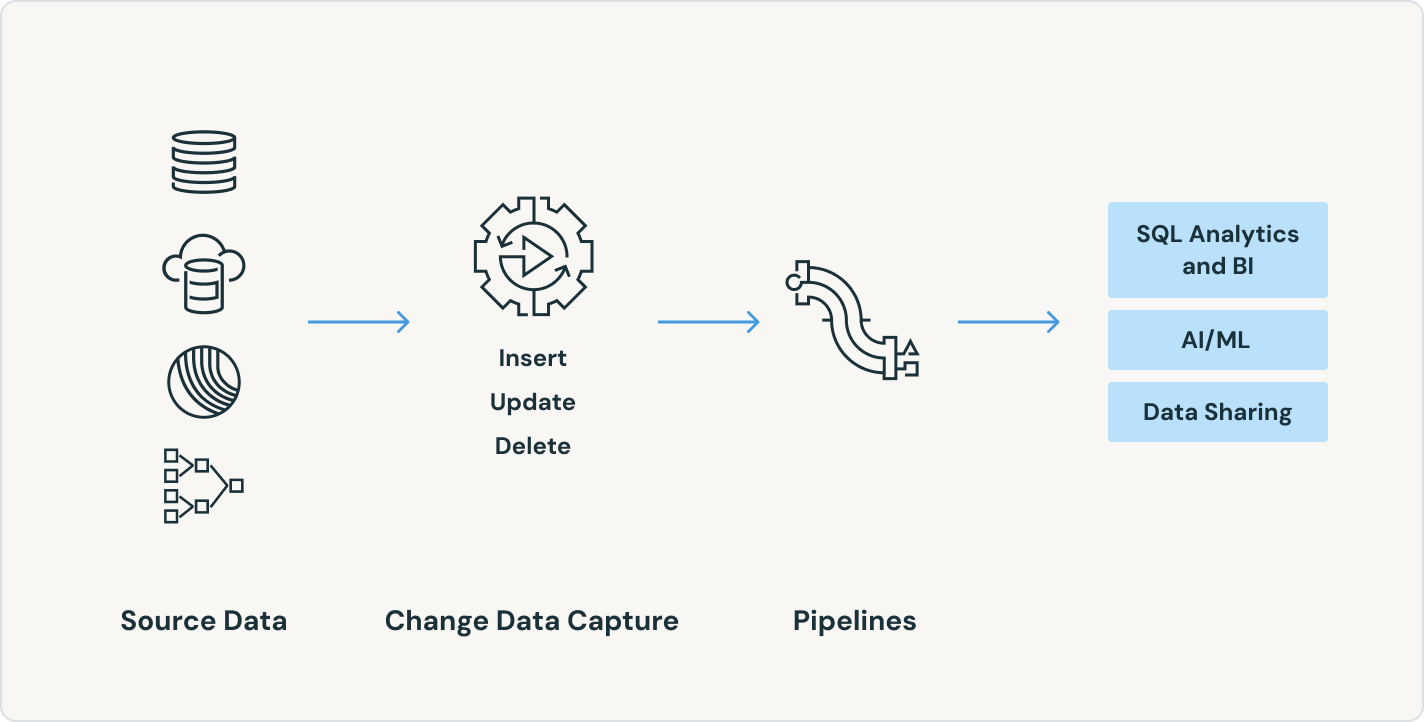

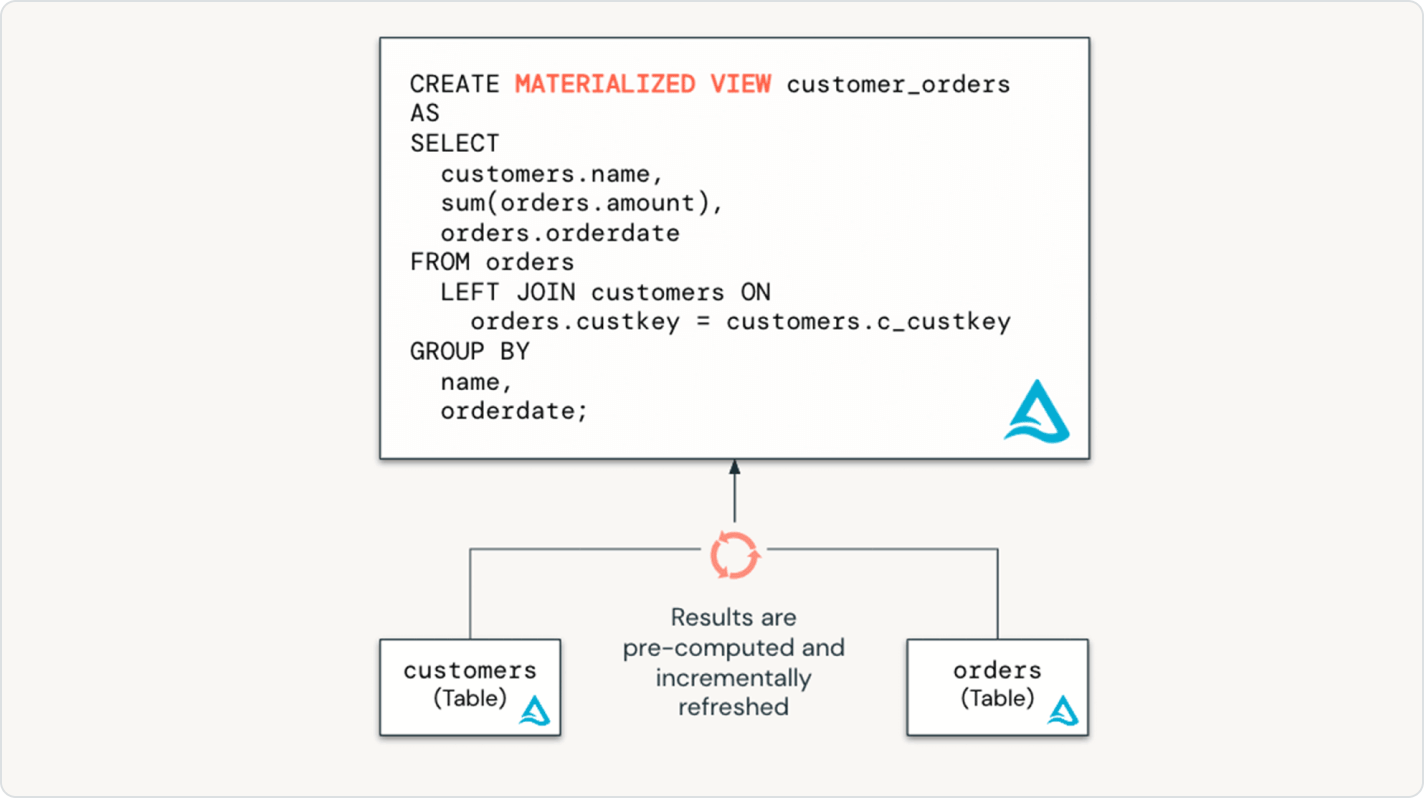

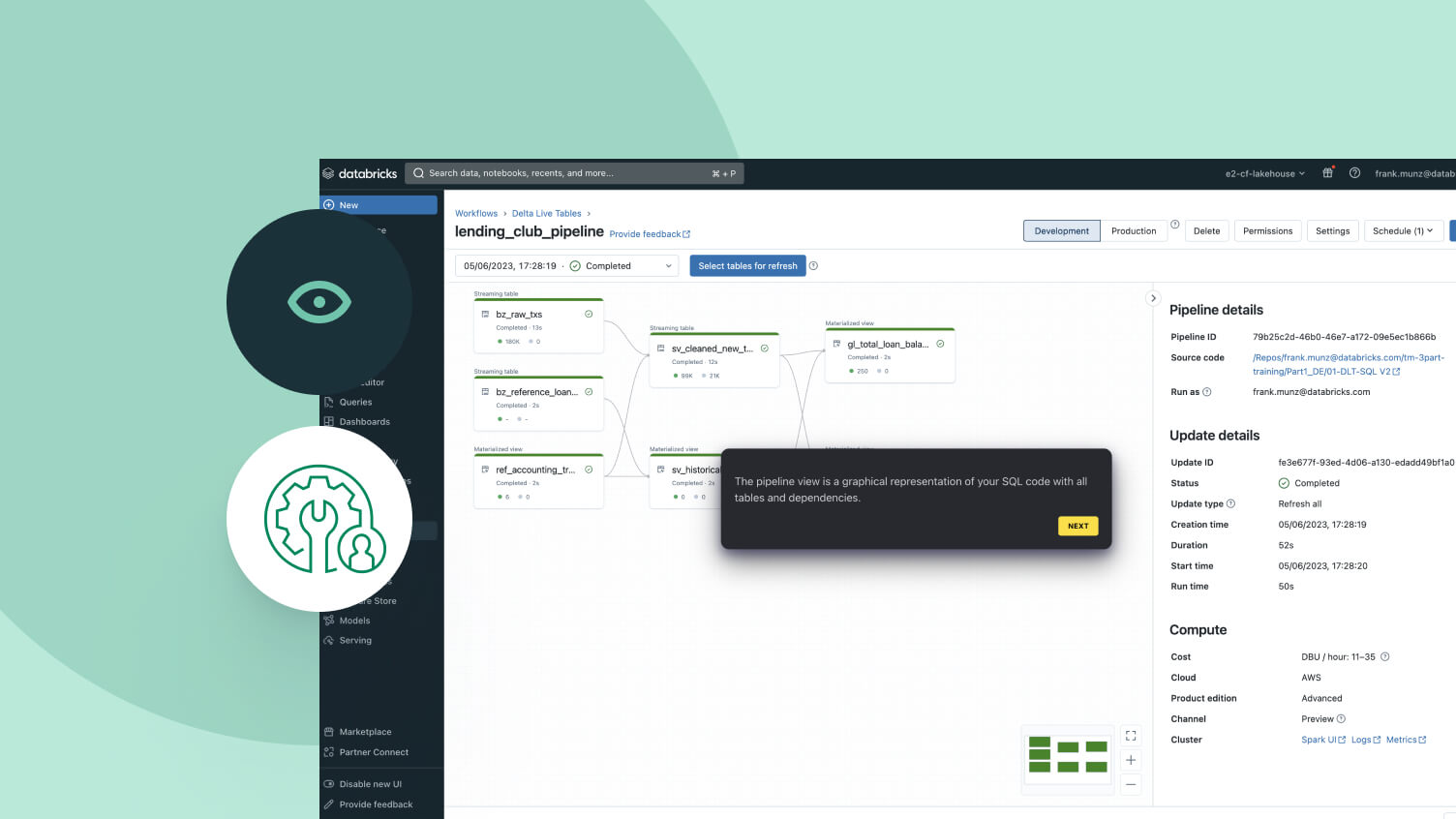

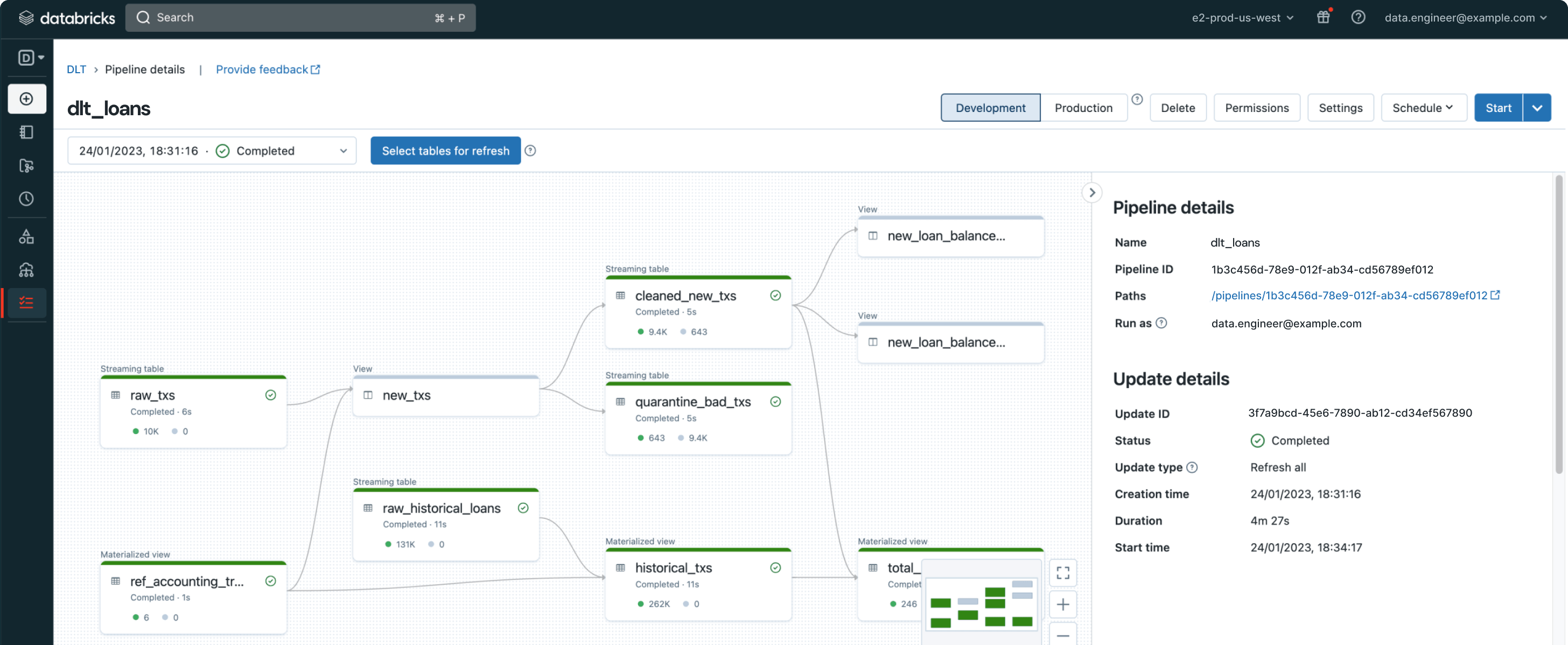

Solo tienes que declarar las transformaciones de datos que necesitas, y los pipelines DLT gestionarán lo demás.Diseñado para simplificar el pipeline de datos

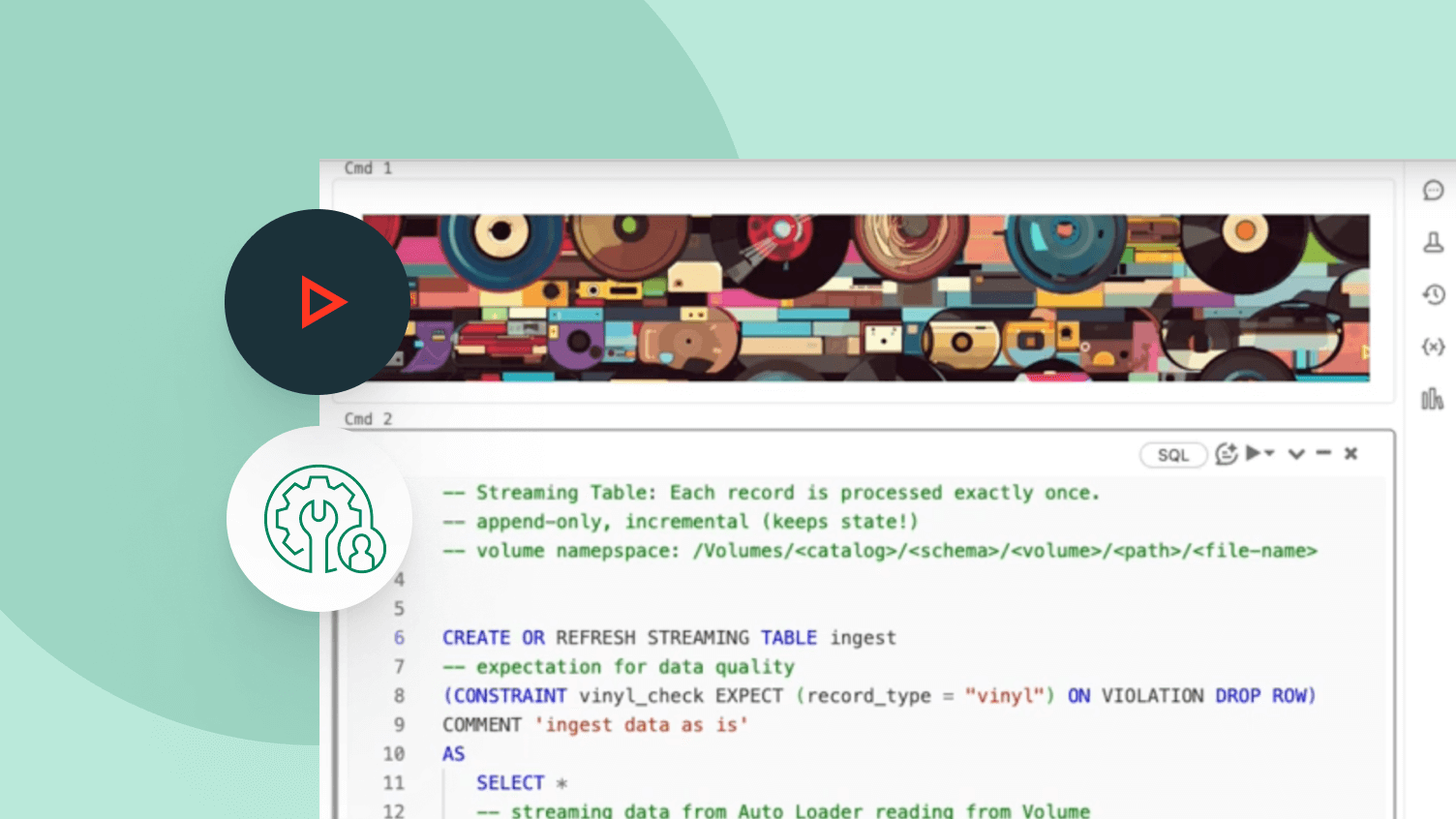

Diseñar y operar pipelines de datos puede ser difícil, pero no tiene por qué serlo. DLT está diseñado para ofrecer una simplicidad potente, permitiéndote realizar ETL robusto con solo unas pocas líneas de código.Al aprovechar la API unificada de Spark para el procesamiento por lotes y de transmisión, los pipelines DLT te permiten alternar fácilmente entre los modos de procesamiento.

Más características

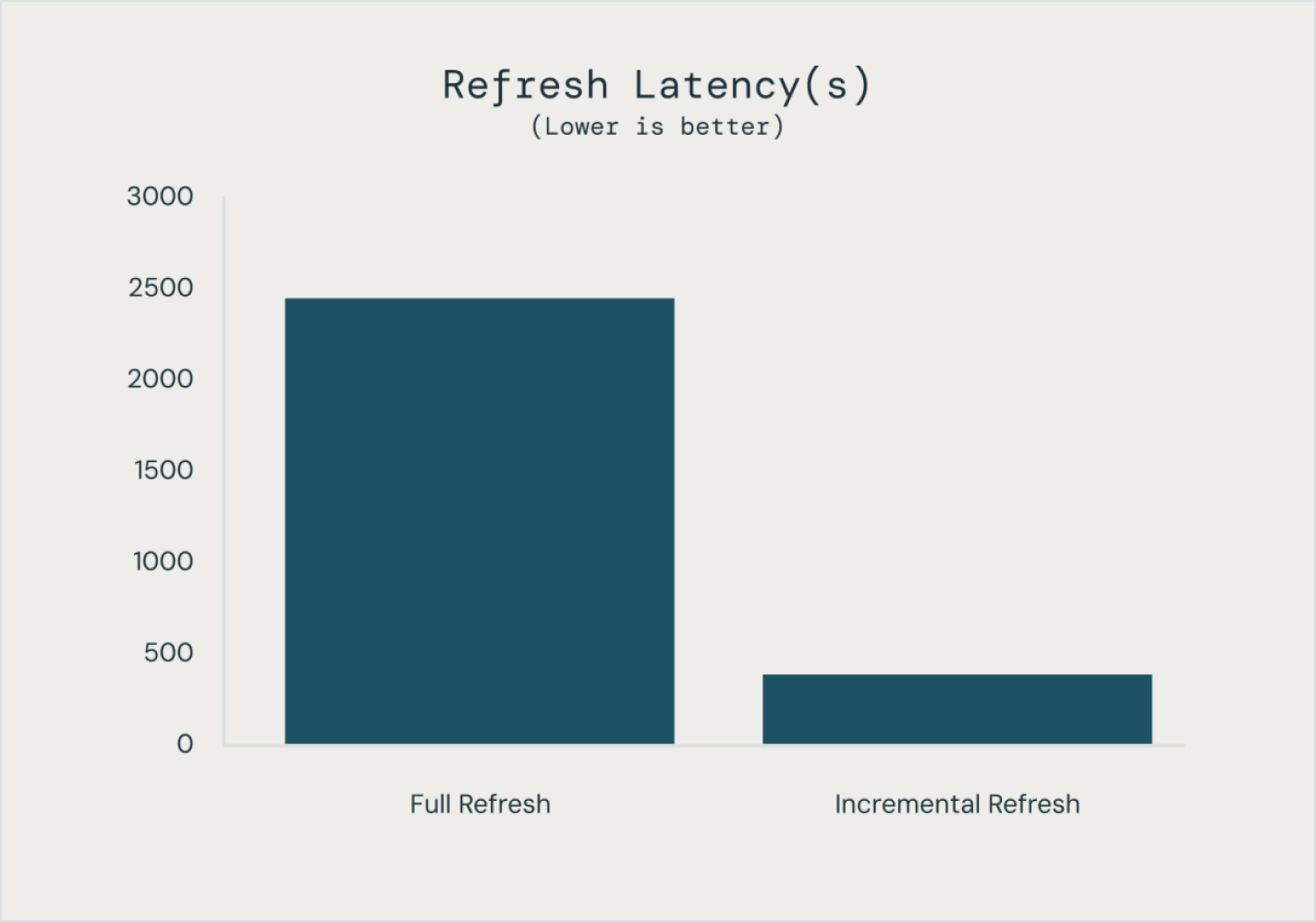

Optimiza tus pipelines de datos

Simplifica las fuentes, las transformaciones y los destinos

La programación declarativa significa que puedes aprovechar el poder de ETL en la plataforma de inteligencia de datos con solo unas pocas líneas de código.

Explorar las demostraciones de DLT

Los precios basados en el uso mantienen el gasto bajo control

Paga solo por los productos que usas, con granularidad por segundo.Descubre más

Explora otras ofertas integradas e inteligentes en la plataforma de inteligencia de datos.Lakeflow Connect

Los conectores de ingesta de datos eficientes de cualquier fuente y la integración nativa con la plataforma de inteligencia de datos desbloquean un fácil acceso a la analítica y la IA, con una gobernanza unificada.

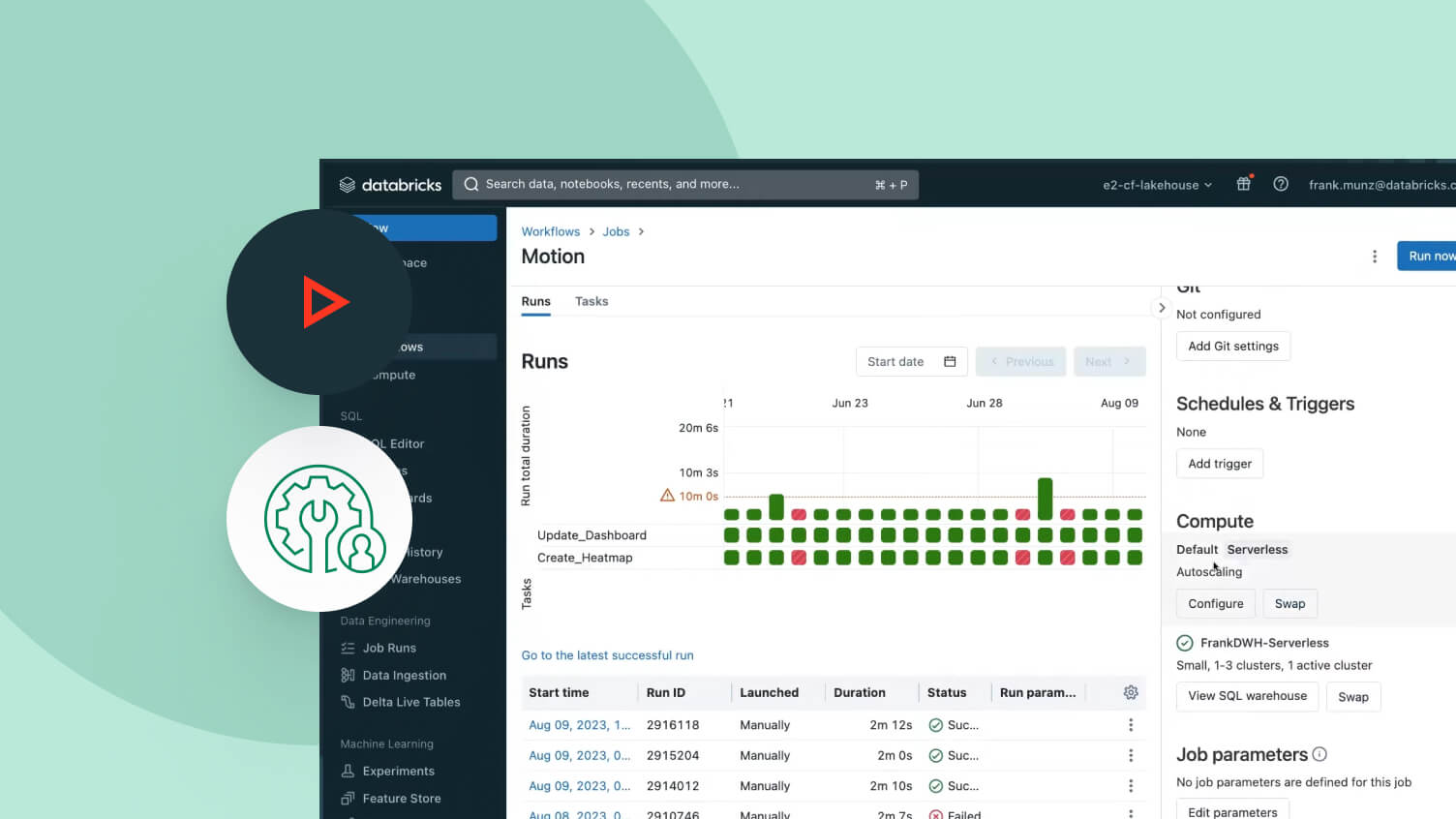

Flujos de trabajo

Define, gestiona y supervisa fácilmente flujos de trabajo multitarea para pipelines de ETL, analítica y aprendizaje automático. Con una amplia gama de tipos de tareas compatibles, capacidades de observabilidad profundas y alta confiabilidad, tus equipos de datos están capacitados para automatizar y orquestar mejor cualquier pipeline y ser más productivos.

Almacenamiento en lakehouse

Unifica los datos en tu lakehouse, en todos los formatos y tipos, para todas tus cargas de trabajo de analítica e IA.

Unity Catalog

Controla sin problemas todos tus activos de datos con la única solución de gobernanza abierta y unificada de la industria para datos e IA, integrada en la plataforma de inteligencia de datos de Databricks.

La plataforma de inteligencia de datos

Descubre cómo Databricks Data Intelligence Platform habilita tus cargas de trabajo de datos e IA.

Da el siguiente paso

Contenido relacionado

Preguntas frecuentes sobre DLT

¿Estás listo para convertirte en una empresa de datos e IA?

Da los primeros pasos en tu transformación