El mejor almacén de datos es un lakehouse

Elimina los costos de almacenamiento heredados y reduce el TCO con un almacenamiento de datos in

LOS MEJORES EQUIPOS TRIUNFAN CON UN ALMACÉN DE DATOS INTELIGENTERendimiento y simplicidad impulsados por IA

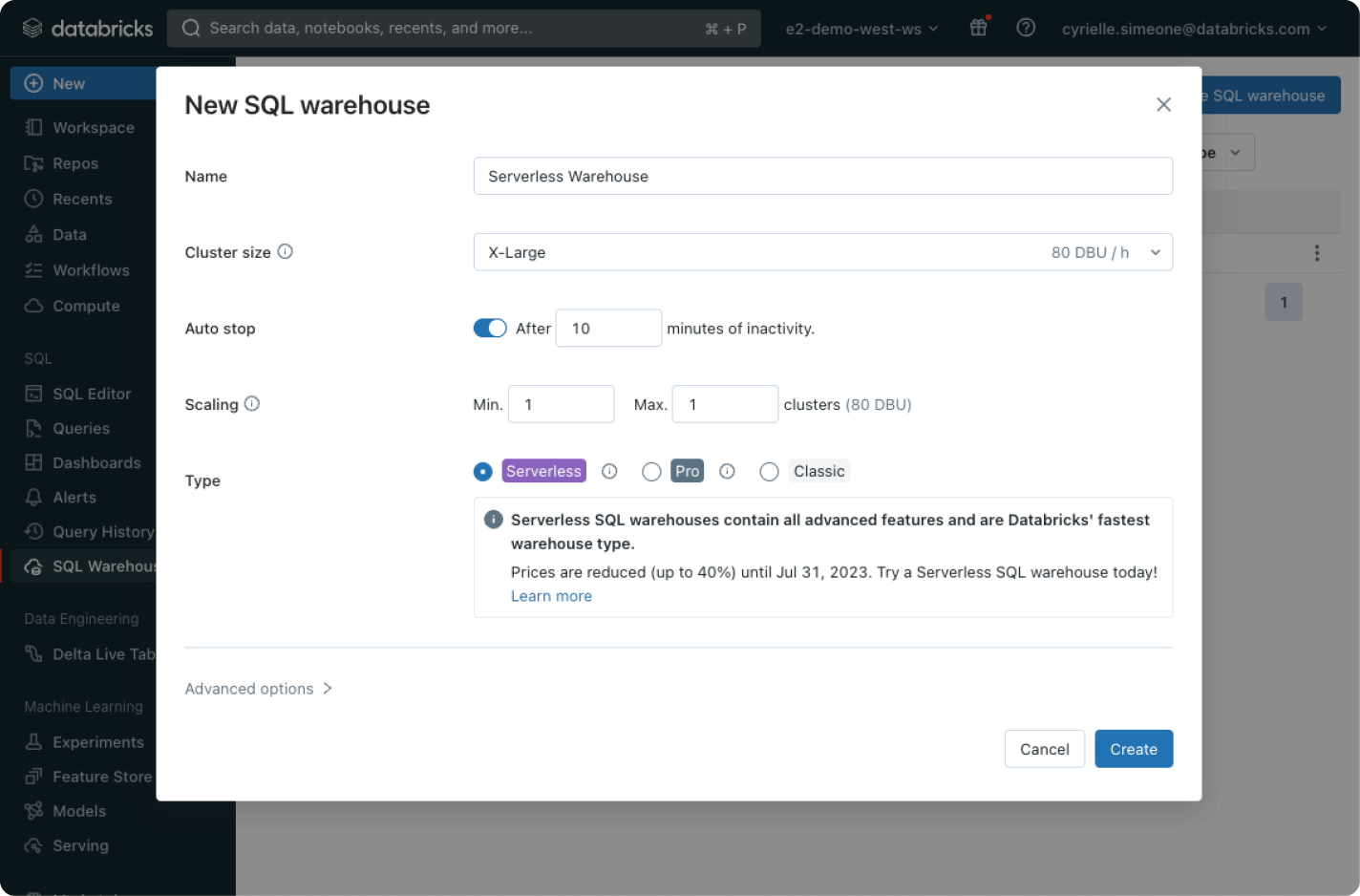

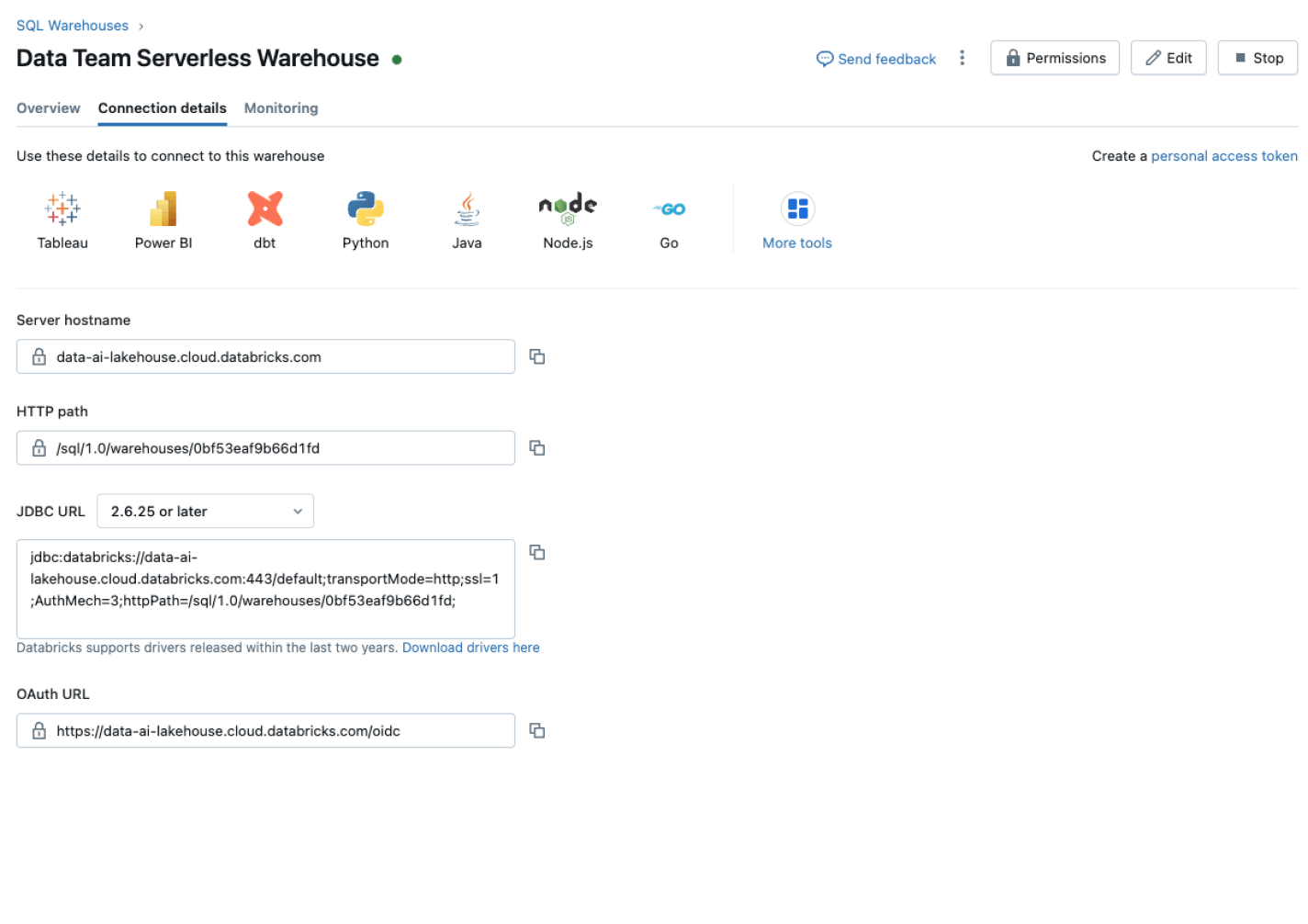

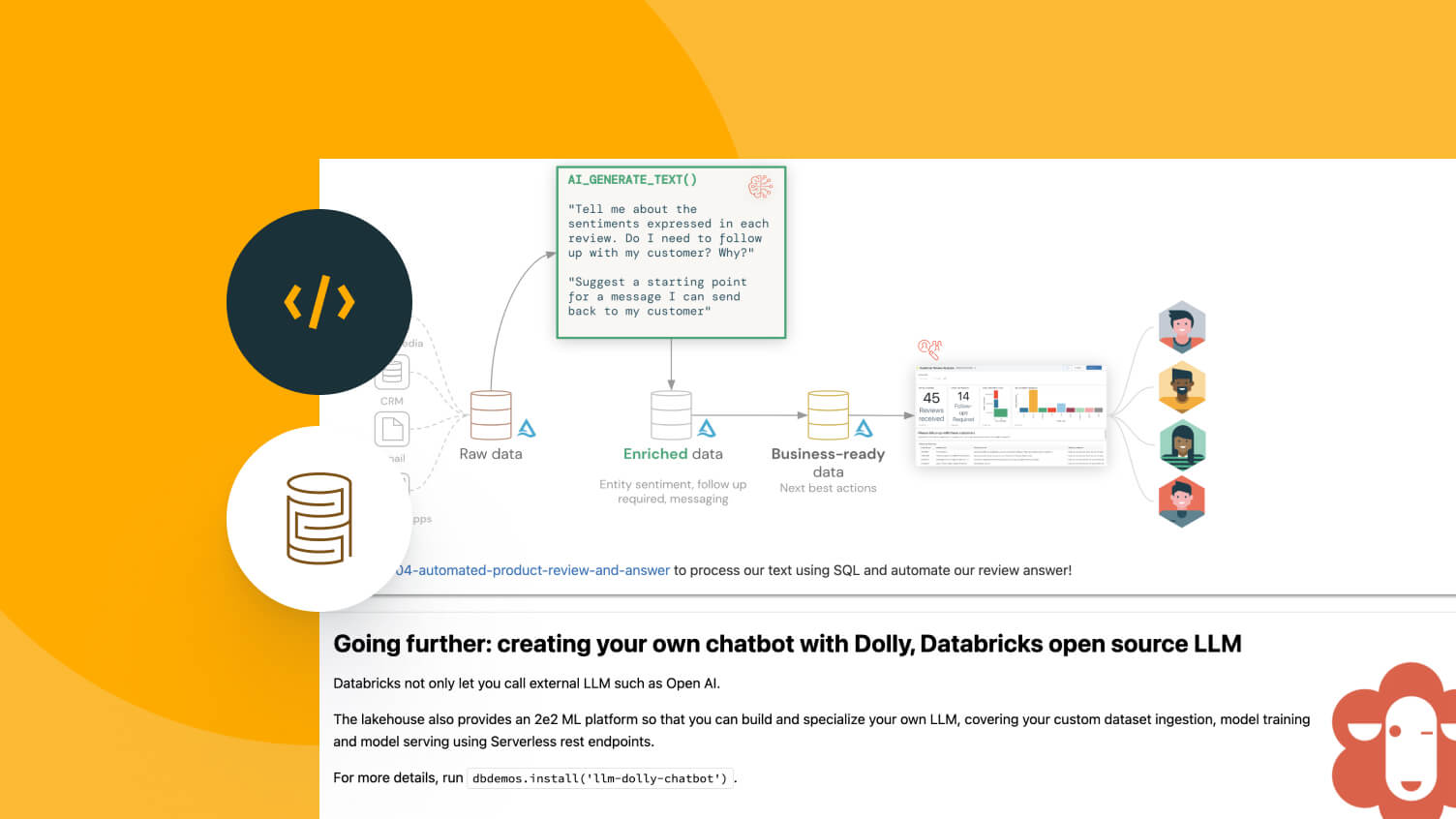

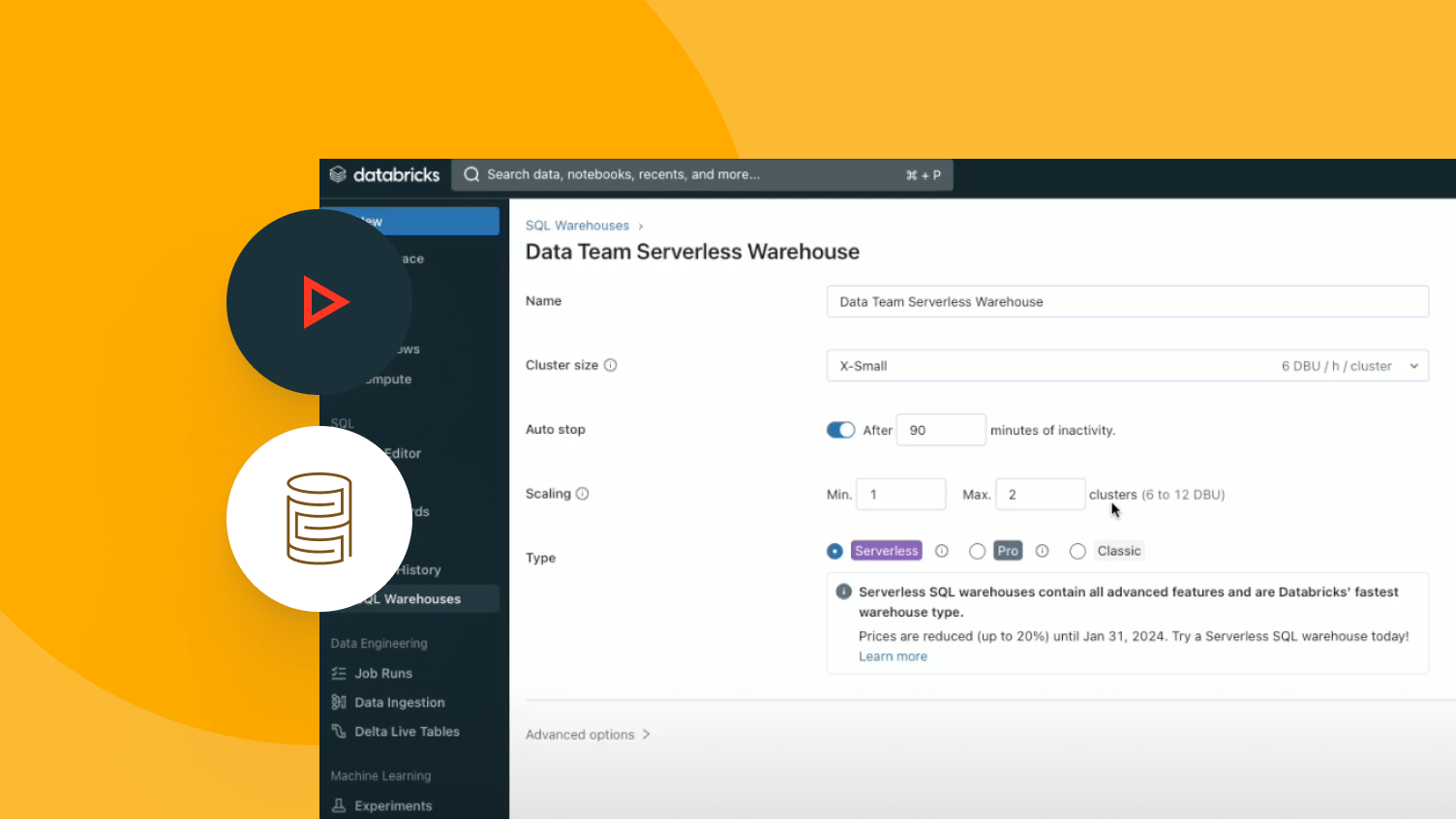

Elimina el costo y la complejidad de los almacenamientos de datos heredados con Databricks SQL, un almacenamiento de datos sin servidor creado con una arquitectura lakehouse que integra la IA de forma nativa.Lakehouse con inteligencia artificial

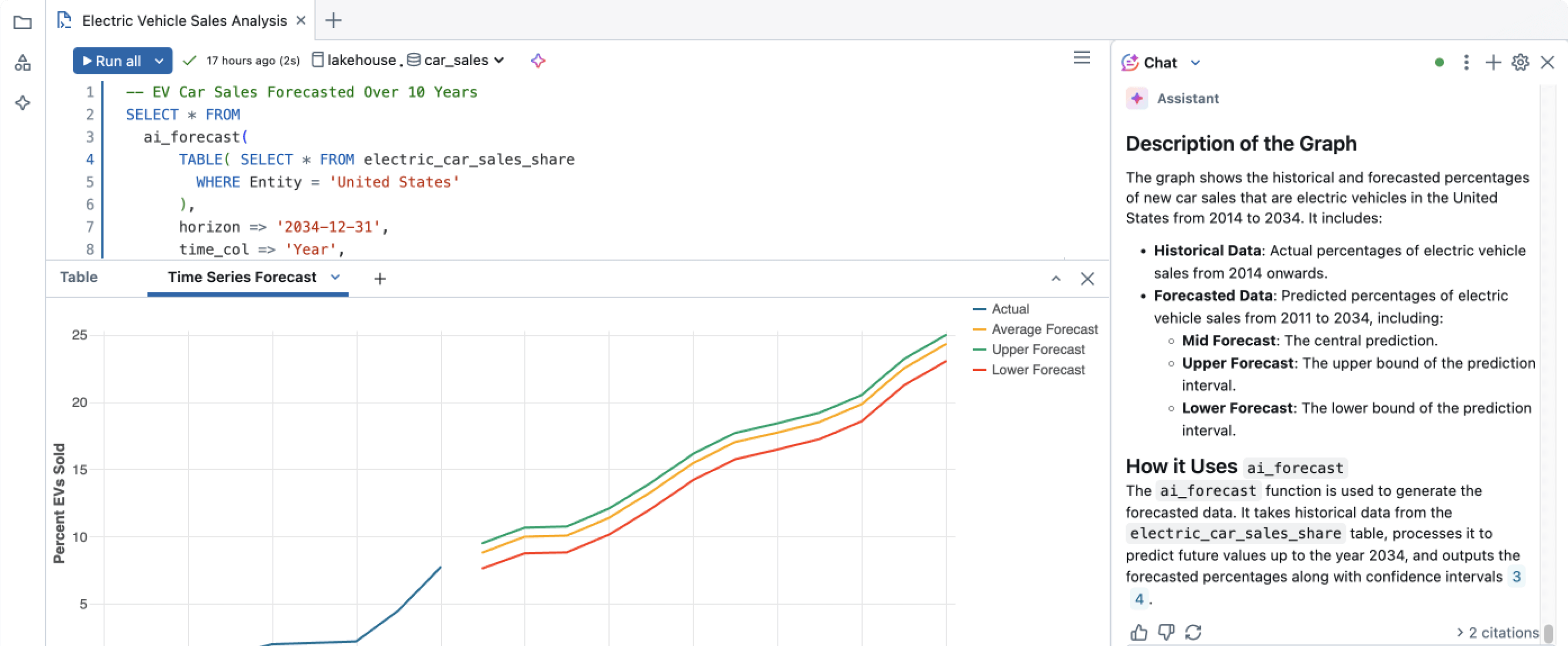

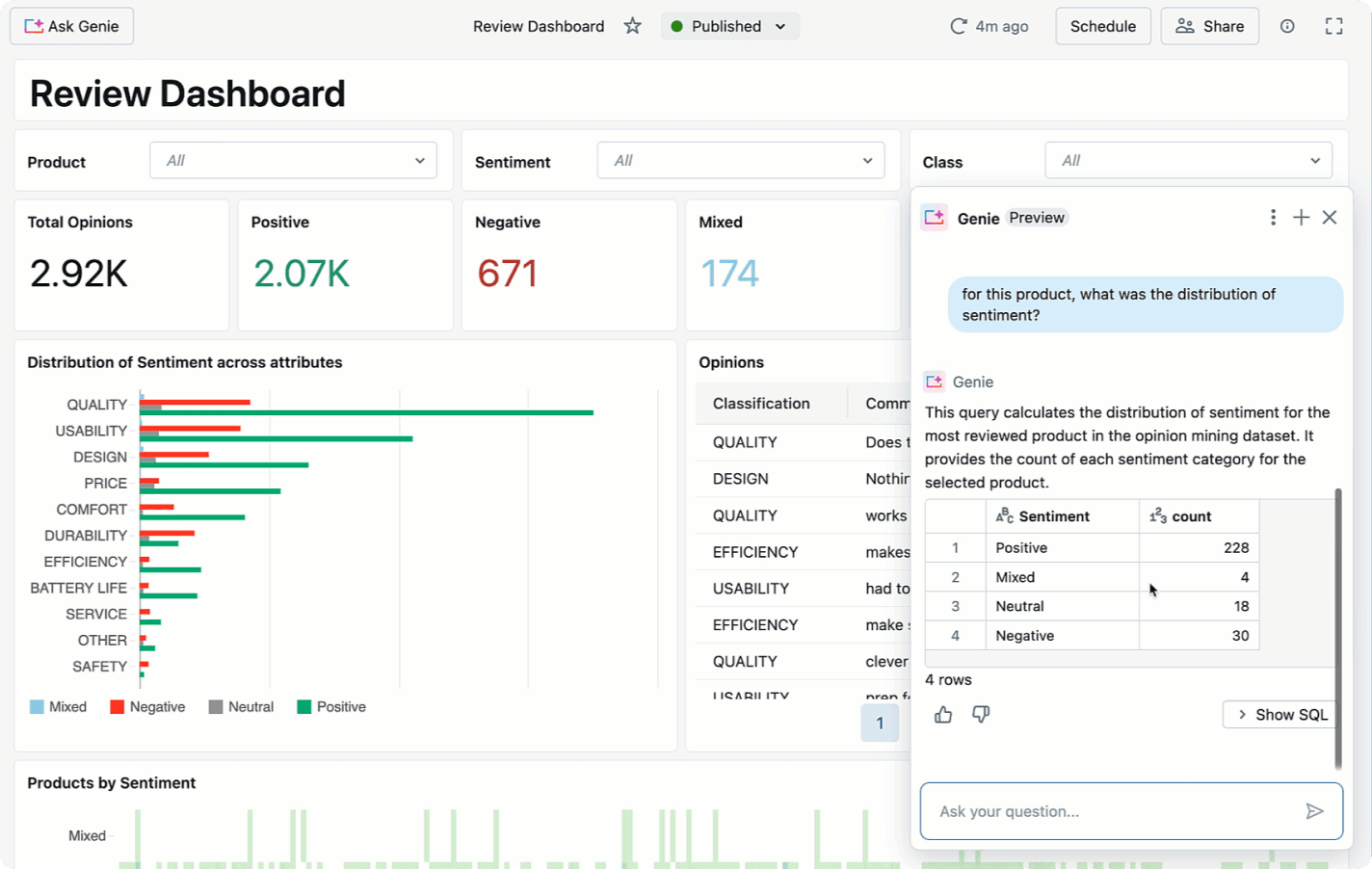

Menos ajustes en tus almacenamientos de datos y más respuestas a partir de tus datos con una relación precio-rendimiento líder en el mercado.Democratiza la analítica y el conocimiento en toda tu organización. Responde con precisión a tus preguntas sobre datos con IA/BI, que comprende tus datos y mejora continuamente.

Más características

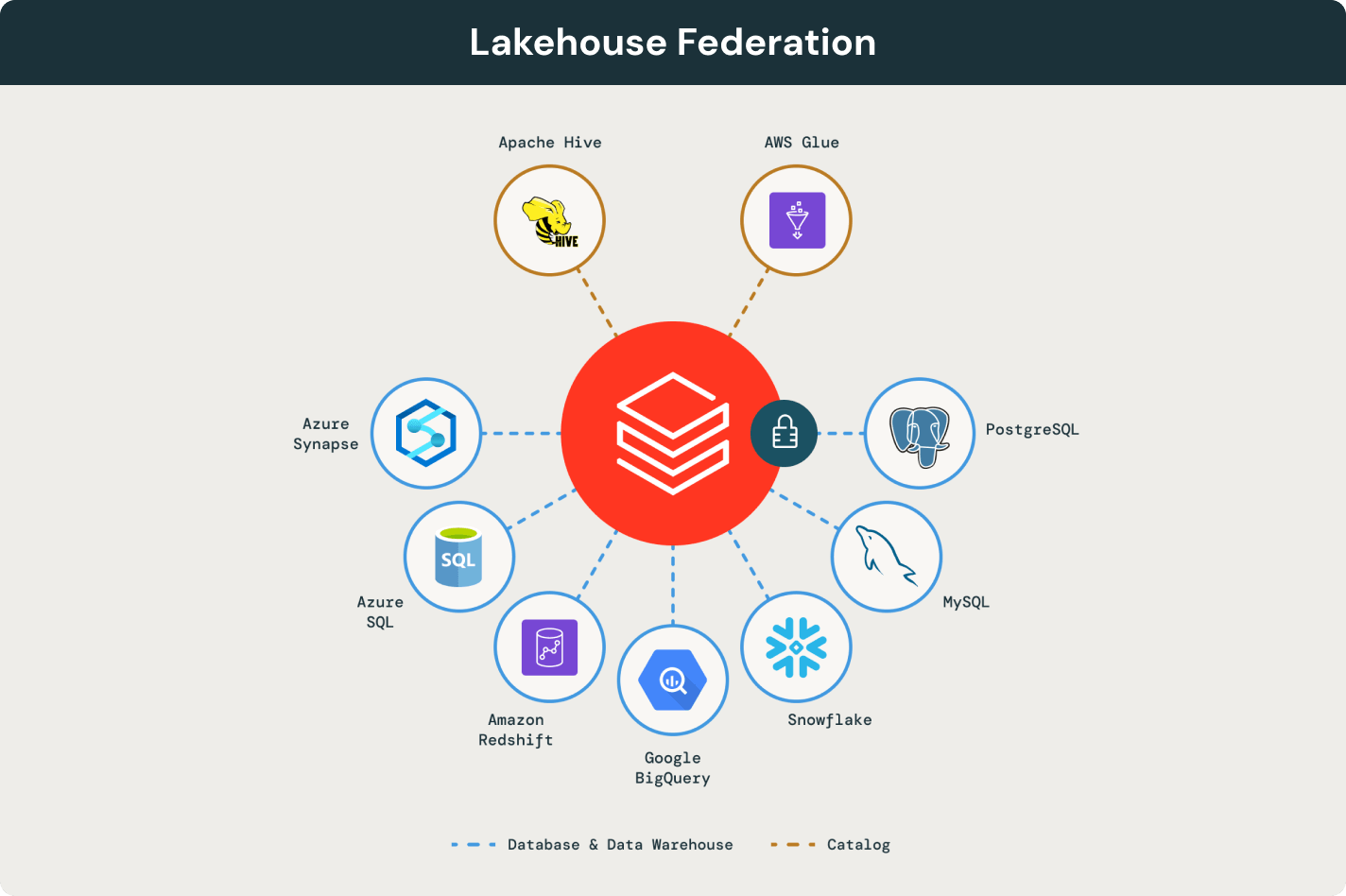

Un enfoque abierto y unificado para tus cargas de trabajo de datos, BI e IA

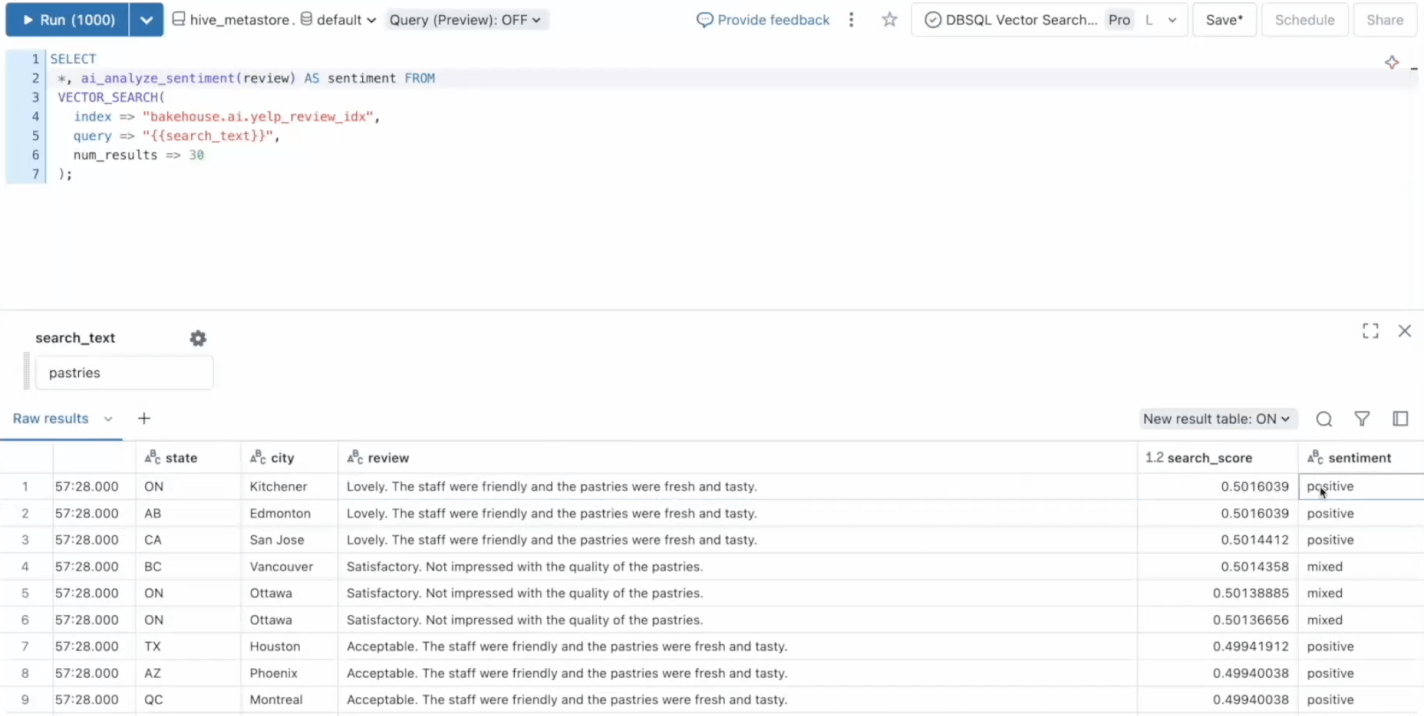

Permite que cualquier persona extraiga información con consultas SQL

Permite que los analistas de datos y los usuarios empresariales respondan preguntas de forma independiente y libera a los profesionales de datos para tareas más complejas

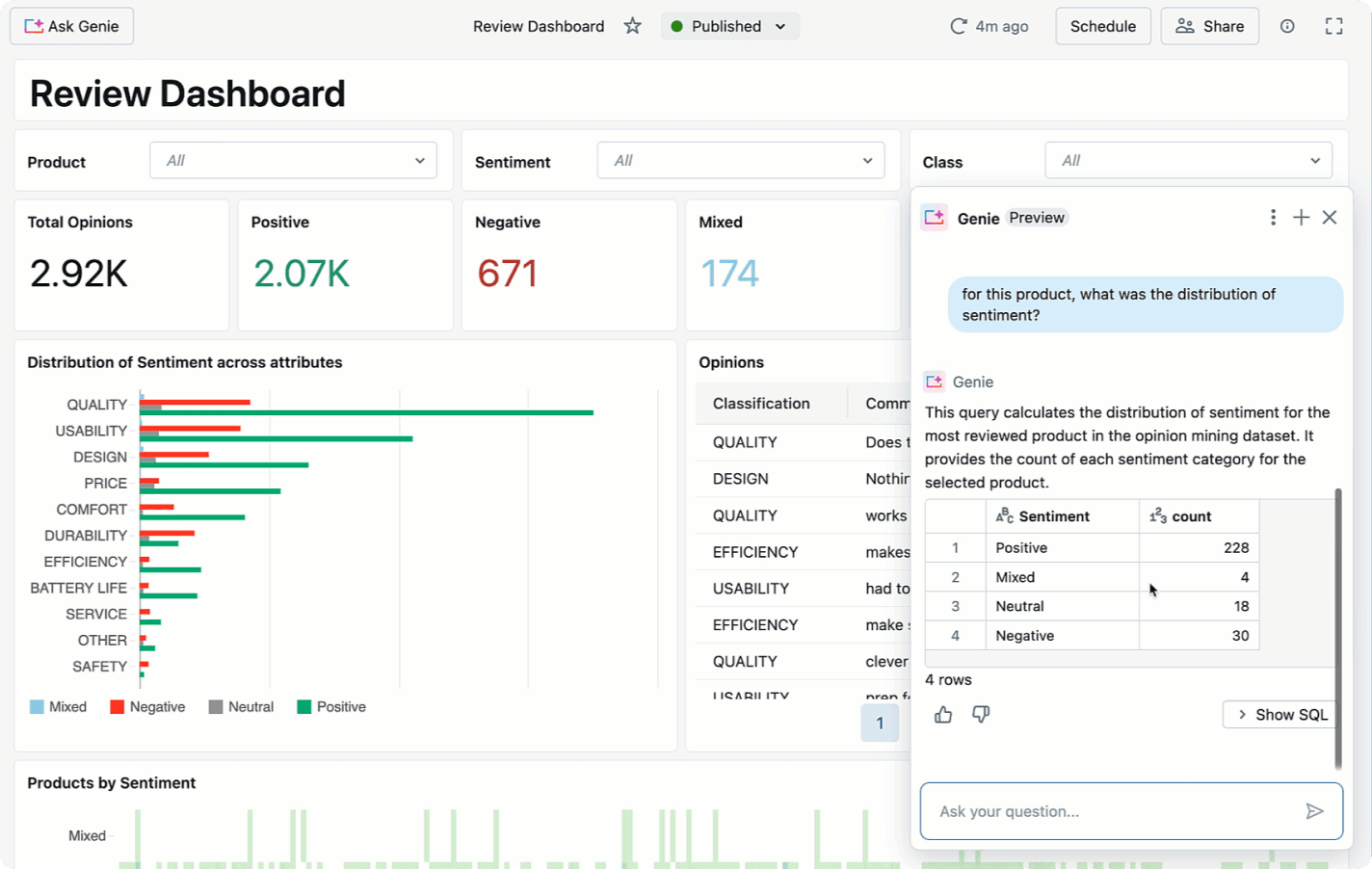

- Paneles de control impulsados por IA

- Interfaces conversacionales para conversar con tus datos

- Un sistema en evolución que se vuelve más inteligente cada vez que lo usas

Explora las demostraciones de Databricks SQL

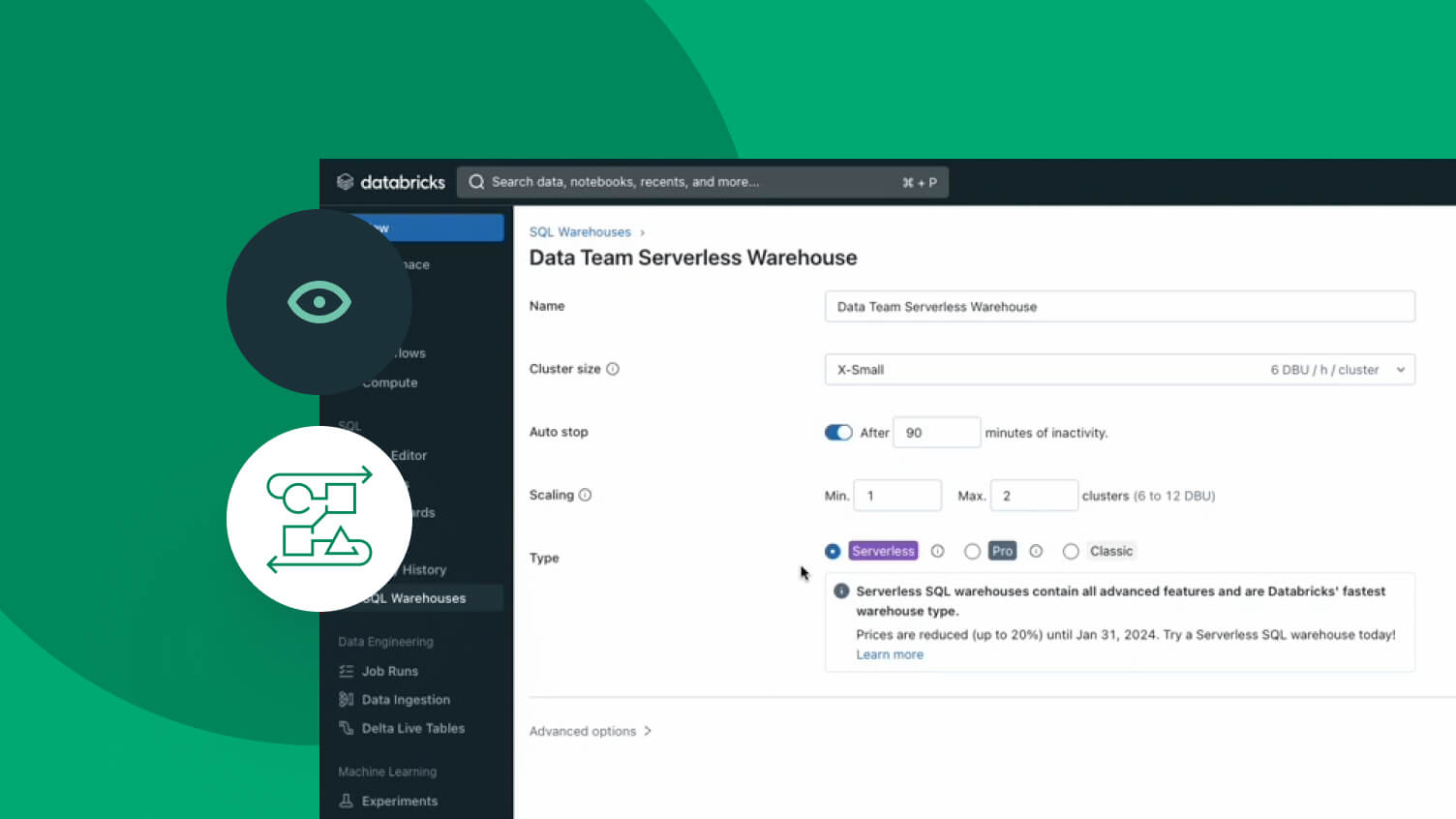

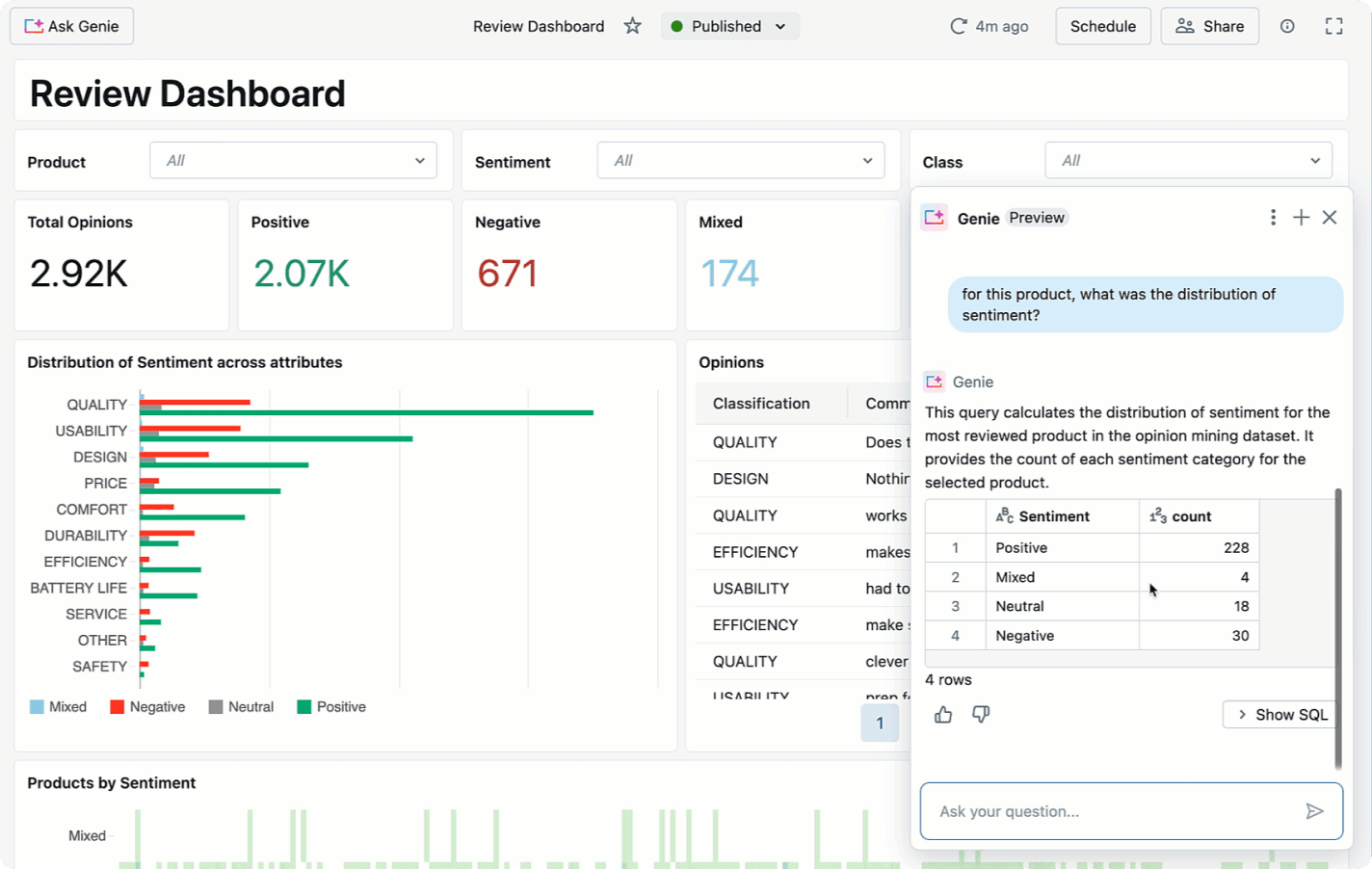

Rendimiento optimizado por IA

Databricks SQL usa sistemas de inteligencia artificial en toda la plataforma que analizan las cargas de trabajo y mejoran automáticamente la eficiencia y el rendimiento. Las consultas de los clientes ya son 5 veces más rápidas que hace tres años.

- Nueve veces mejor relación precio-rendimiento en ETL

- El motor de consultas Photon ofrece un rendimiento extremadamente rápido y a bajo costo para consultas

- Procesa un gran número de consultas de forma rápida y rentable con una administración inteligente de la carga de trabajo

- Reescribir automáticamente los archivos de datos para mejorar la disposición de los datos

- Mantén tanto un alto rendimiento como una gran simultaneidad de consultas de BI

- Capacidad de procesamiento 4 veces mejor con ai_query()

Los precios basados en el uso mantienen el gasto bajo control

Paga solo por los productos que usas, con granularidad por segundo.Descubre más

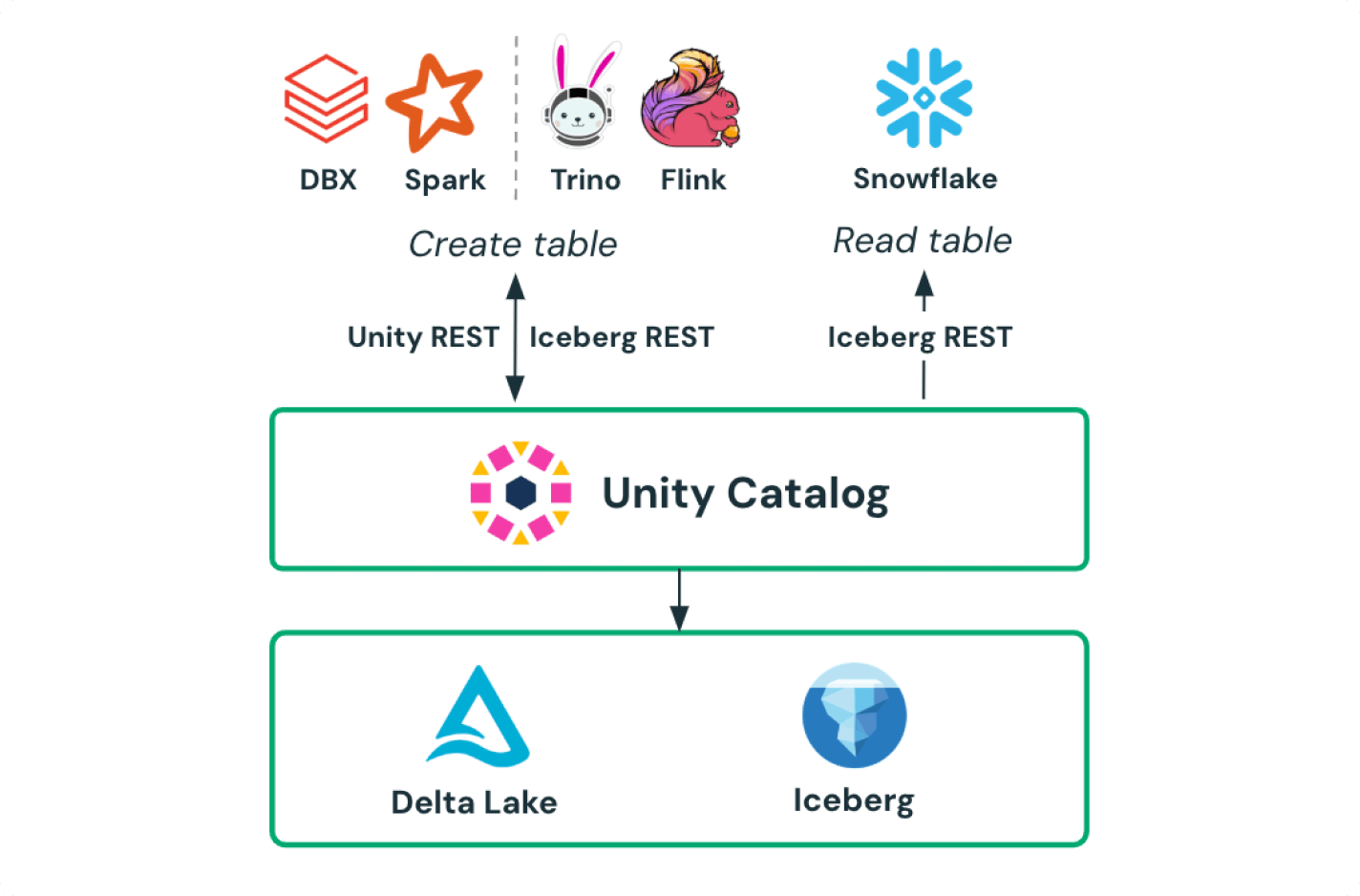

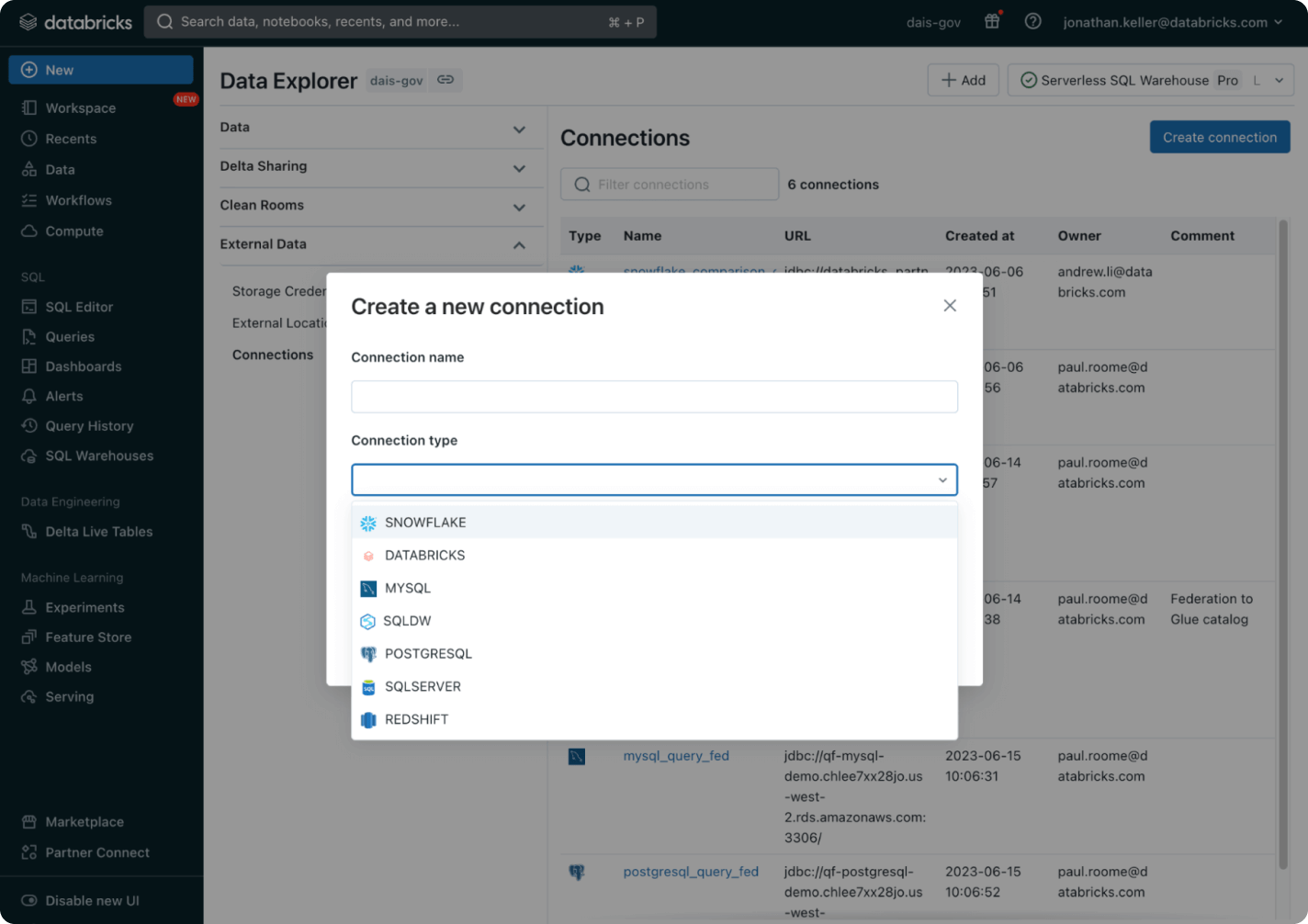

Obtén más información sobre las características integradas de Databricks SQL.Unity Catalog

Gobernanza y seguridad unificadas para administrar de forma centralizada los recursos y el acceso con Unity Catalog integrado.

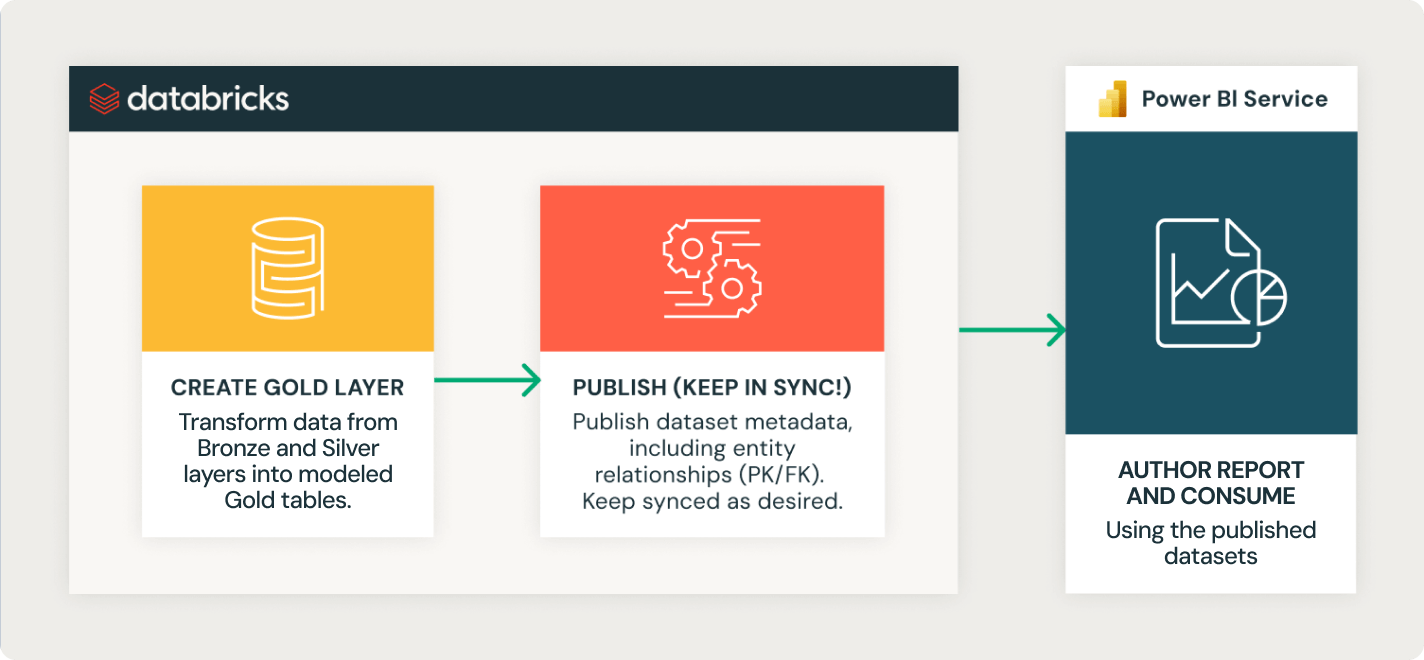

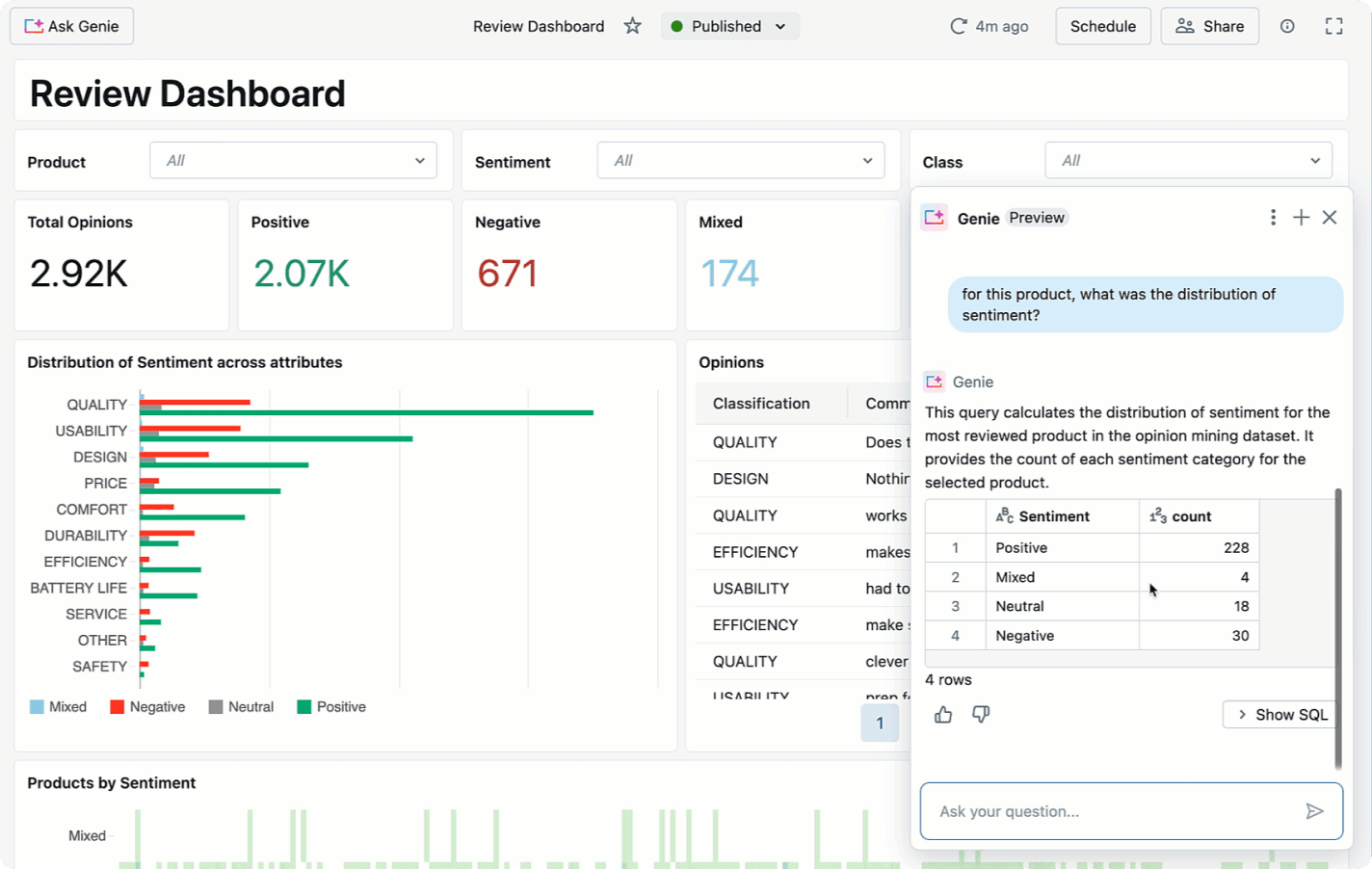

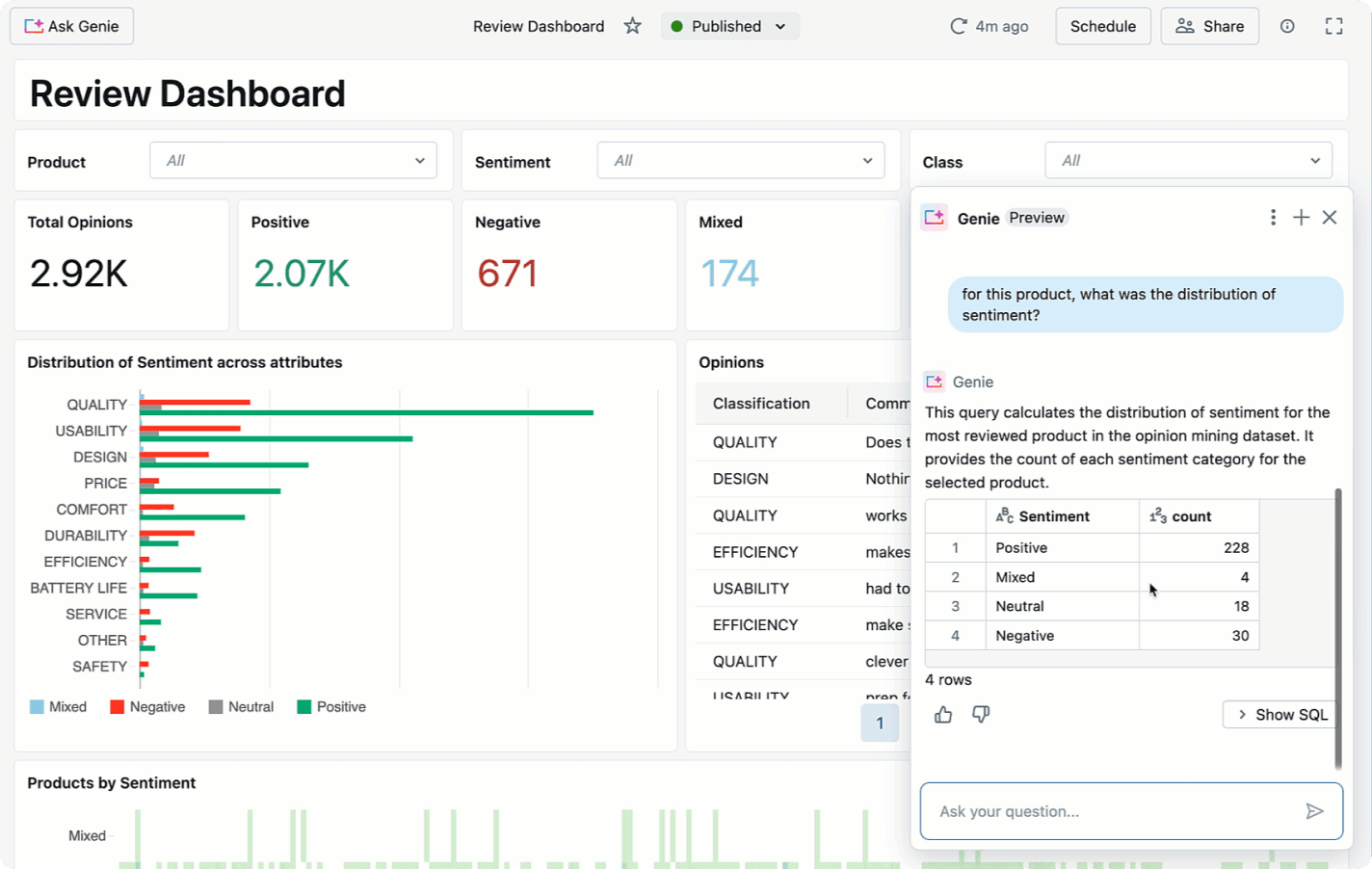

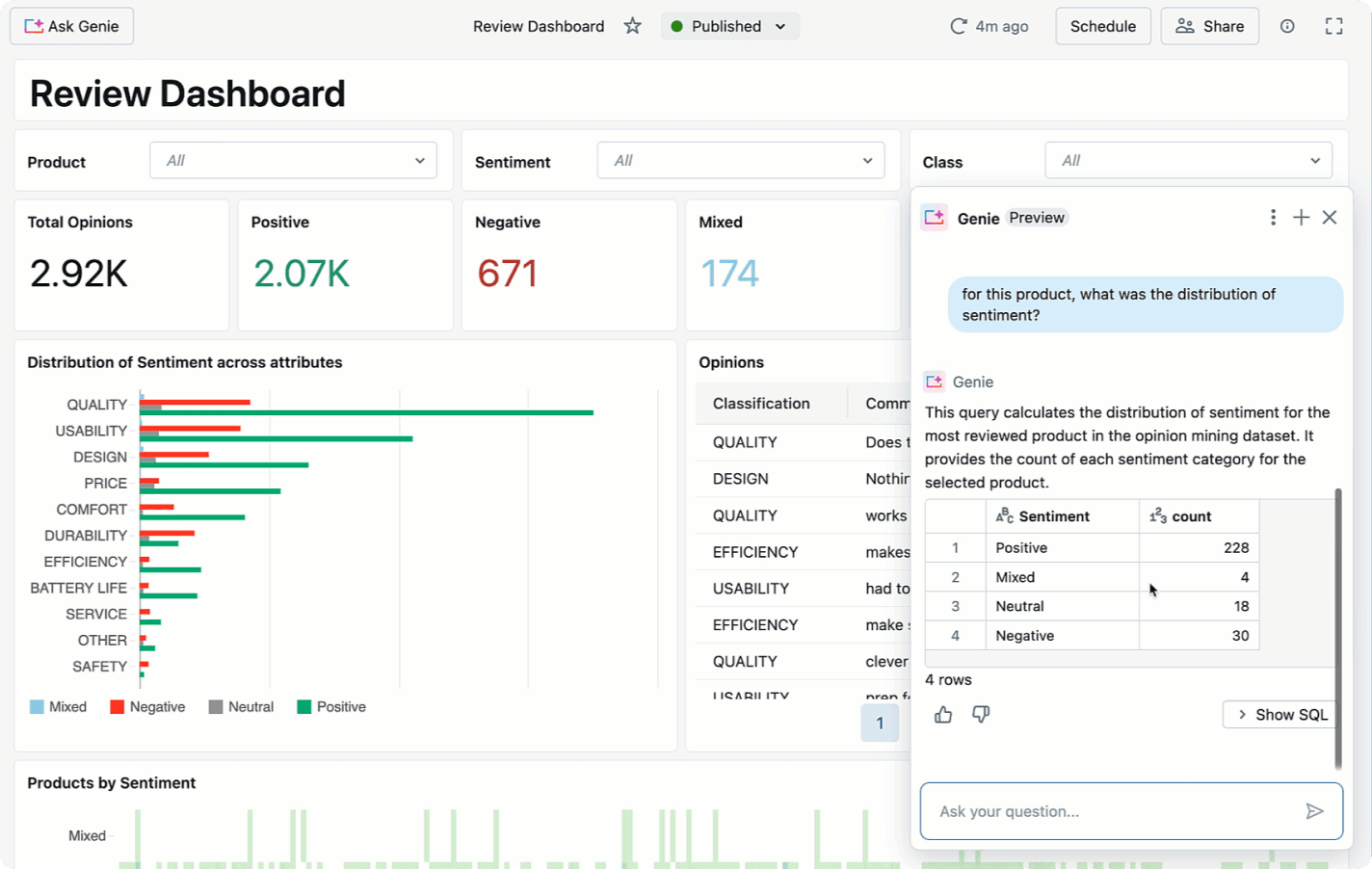

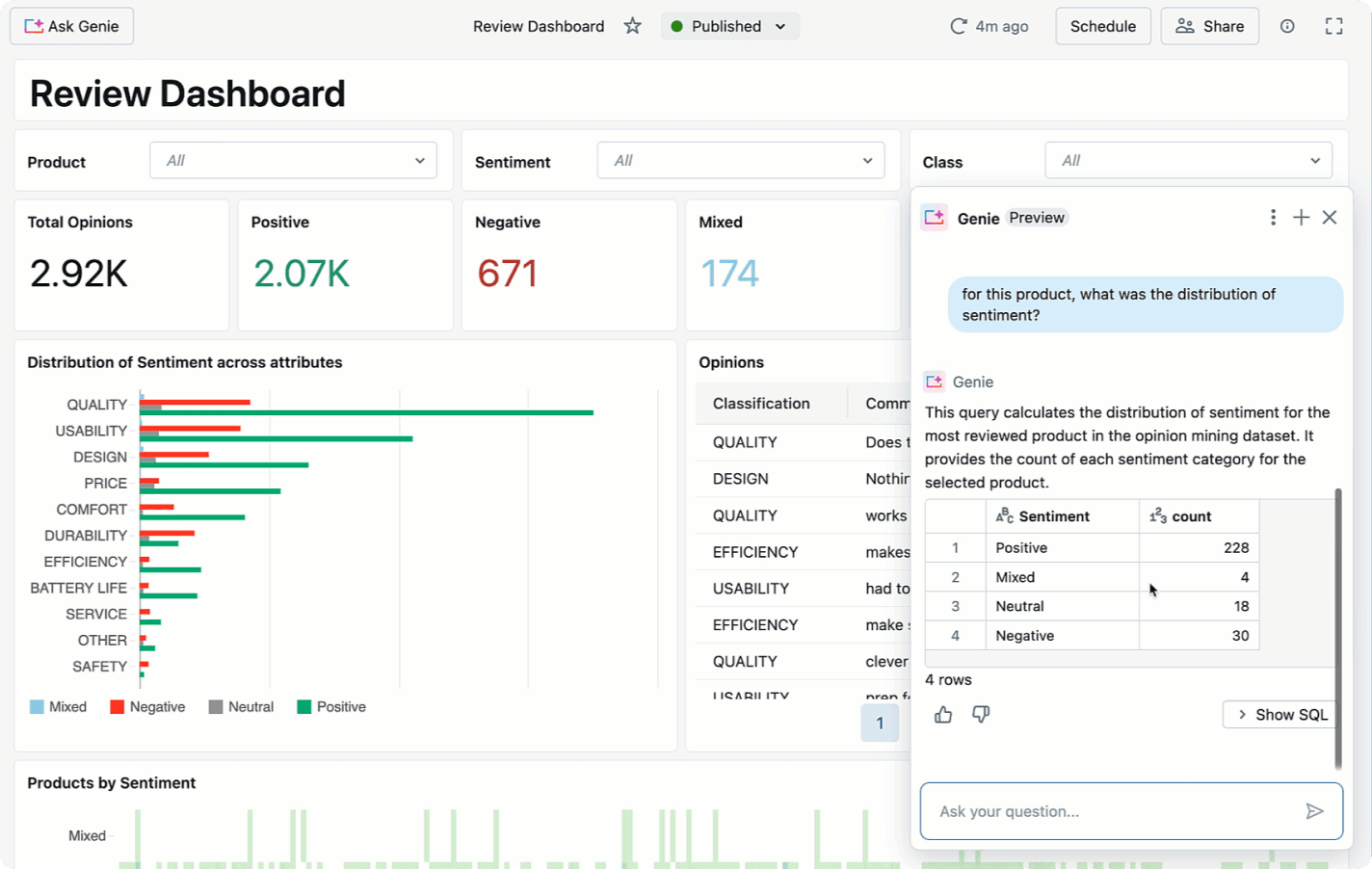

IA/BI

Los paneles proporcionan una experiencia con poco código para los analistas. Genie ayuda a los usuarios empresariales a hacer preguntas sobre sus datos y brinda autoservicio para que hagan sus propios análisis.

Delta Sharing

El enfoque de código abierto de Delta Sharing te permite compartir datos en vivo a través de plataformas, nubes y regiones sin sacrificar una seguridad y una gobernanza sólidas.

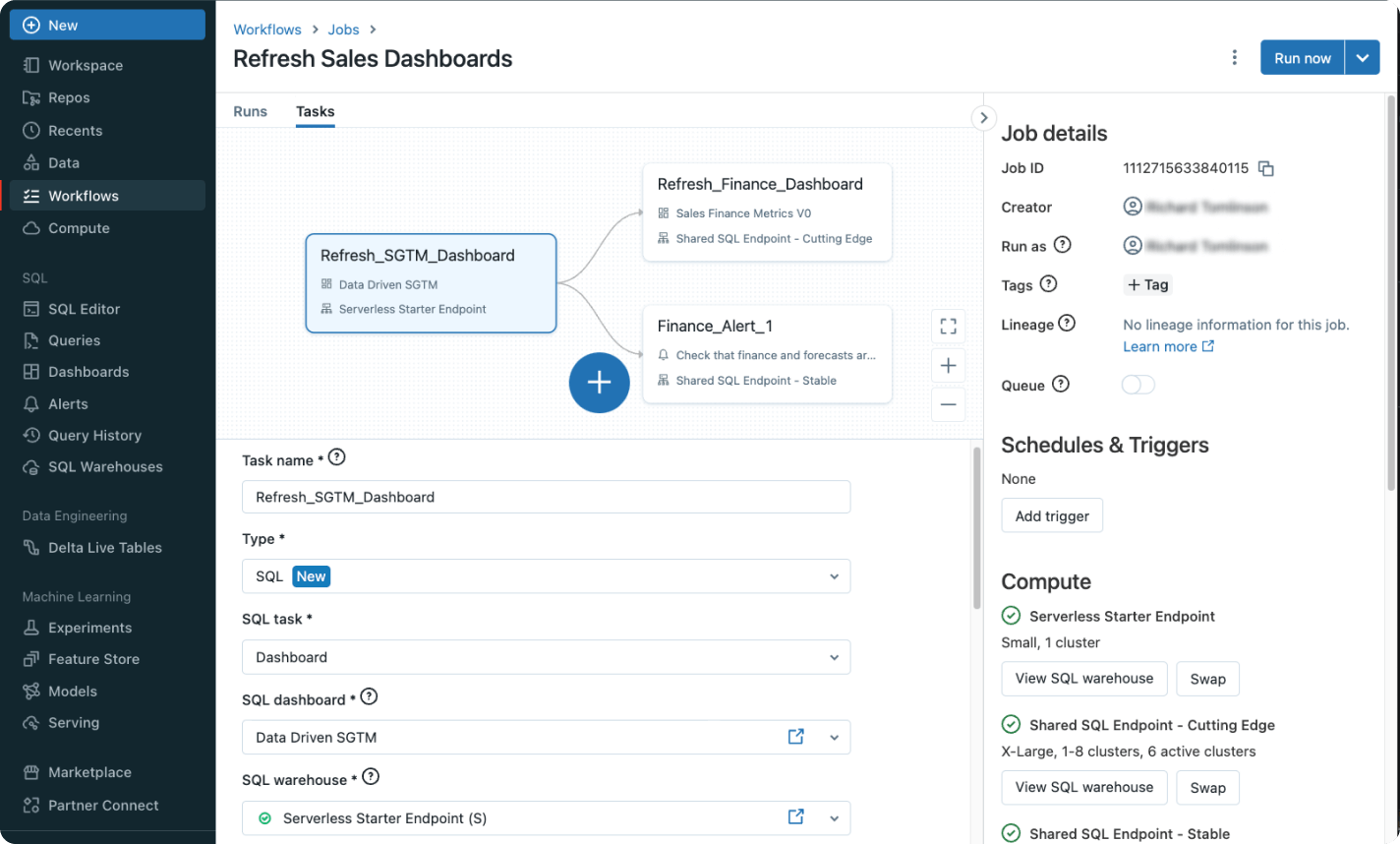

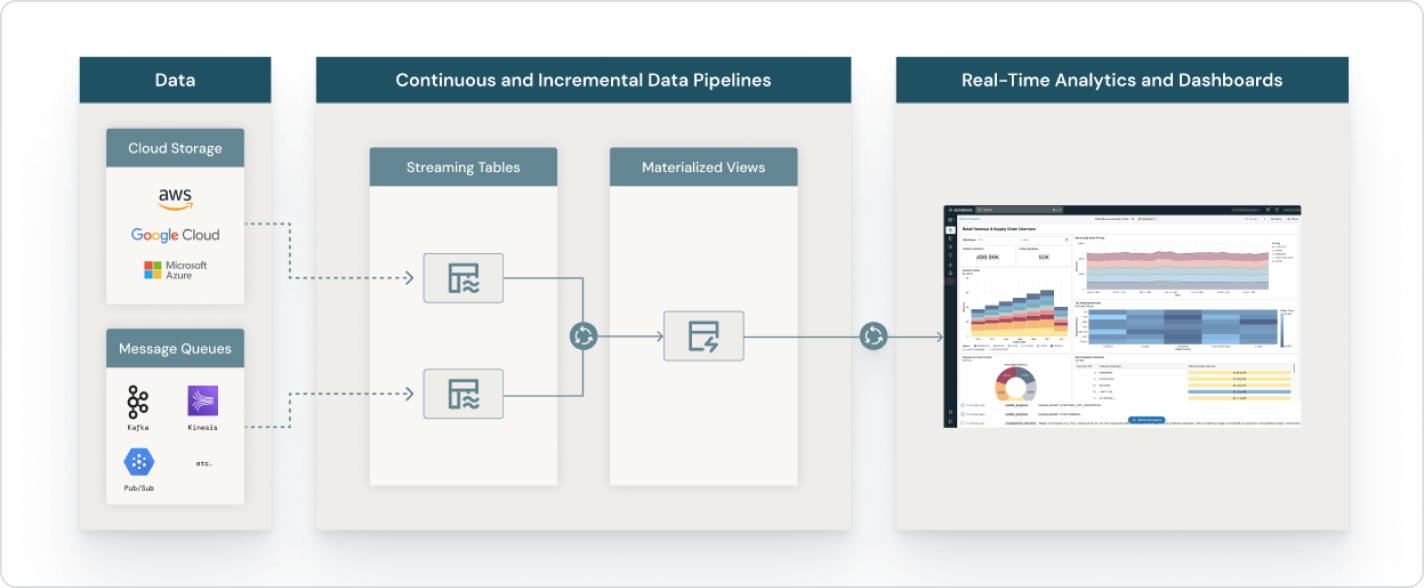

Lakeflow

Define, administra y monitorea flujos de trabajo multitarea con Lakeflow Jobs, un servicio de orquestación completamente administrado que está totalmente integrado en Databricks SQL.

Fotón

Photon es el motor de próxima generación integrado en Databricks SQL que proporciona un rendimiento de consulta extremadamente rápido a bajo costo.

Databricks Data Intelligence Platform

Explora la gama completa de herramientas disponibles en Databricks Data Intelligence Platform para integrar sin problemas los datos y la inteligencia artificial en toda tu organización.

Da el siguiente paso

Explora la documentación de Databricks SQL

Todo lo que necesitas para empezar a usar Databricks SQL en AWS, Microsoft Azure o Google Cloud Platform.

Migra tu almacenamiento de datos a Databricks

Escala según lo requiera tu empresa y controla los costos con analítica y cargas de trabajo de IA en una única plataforma de datos unificada.

Contenido relacionado

¿Estás listo para convertirte en una empresa de datos e IA?

Da los primeros pasos en tu transformación de datos