Ingesta eficiente de datos en tu lakehouse

Da el primer paso para desbloquear la innovación con inteligencia de datos.

Libera el valor de tus datos en solo unos pocos pasos sencillos

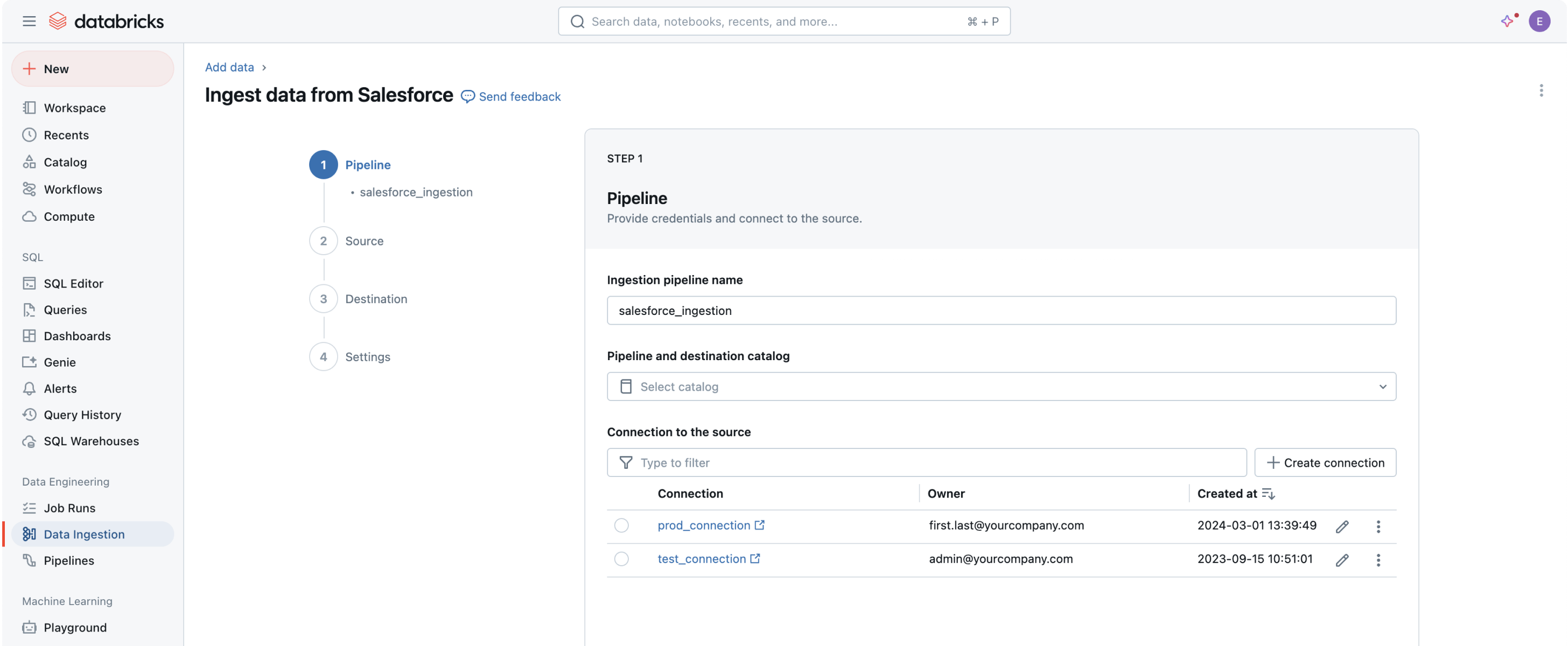

Los conectores de datos integrados están disponibles para aplicaciones empresariales populares, fuentes de archivos y bases de datos.Capacidades robustas de ingesta para fuentes de datos populares

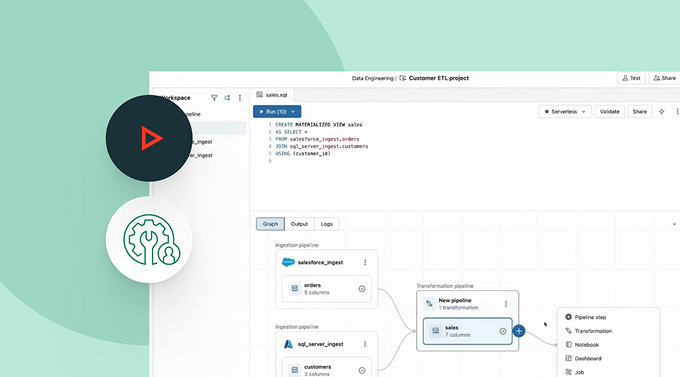

El primer paso para extraer valor y ayudar a resolver los problemas de datos más complejos de tu organización es incorporar todos tus datos a la plataforma de inteligencia de datos.La interfaz de usuario (IU) sin código o una API simple les da a los profesionales de datos la capacidad de autoservicio, lo que ahorra horas de programación.

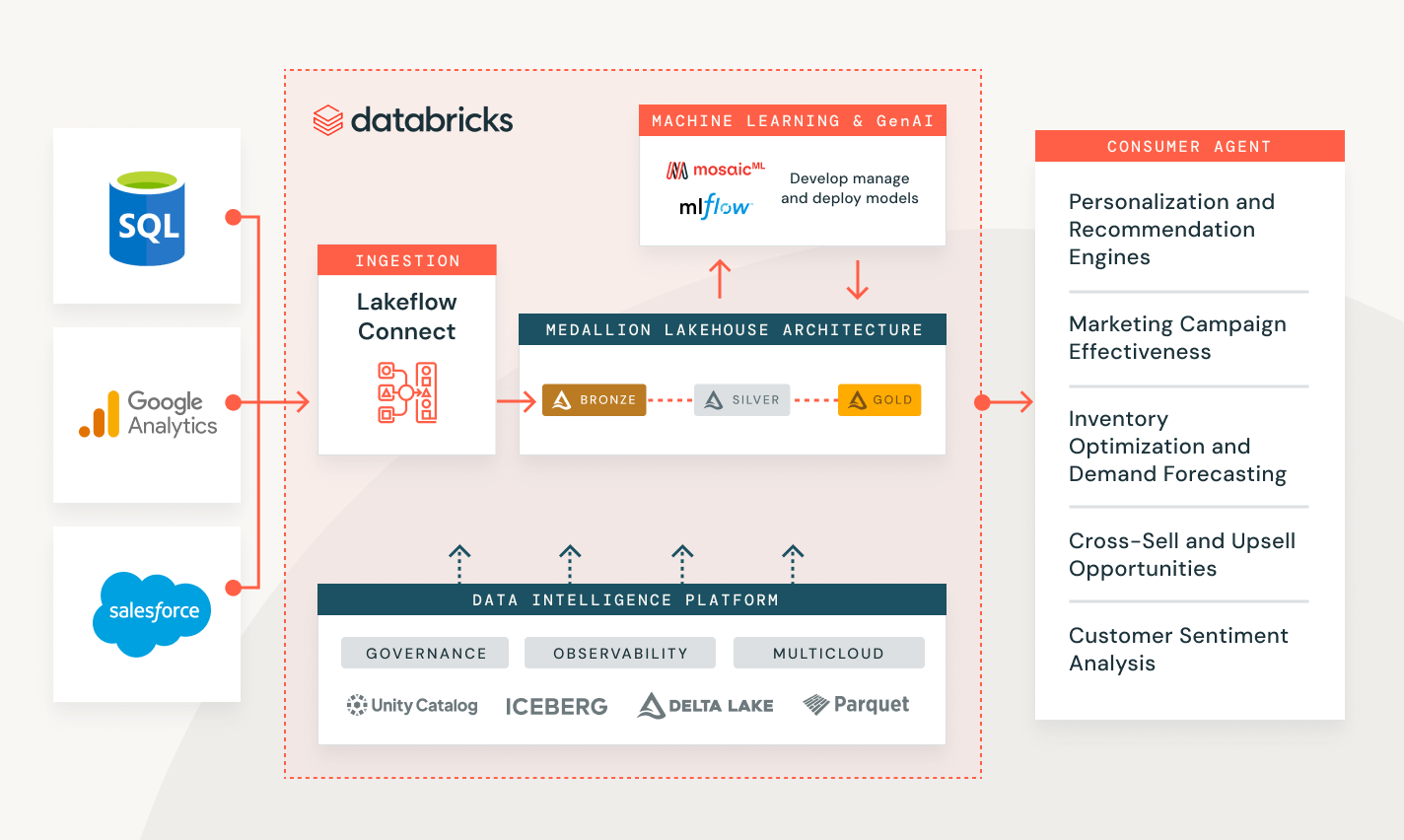

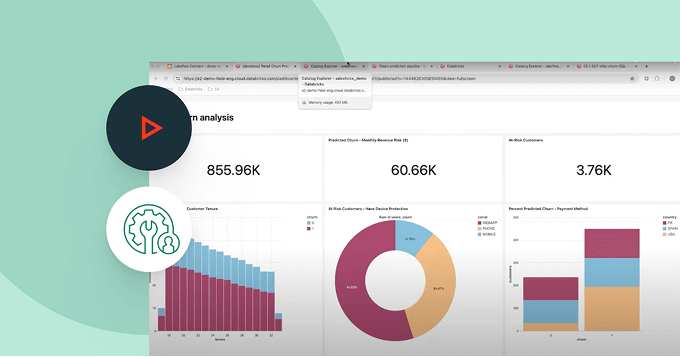

Ingesta de datos con Databricks

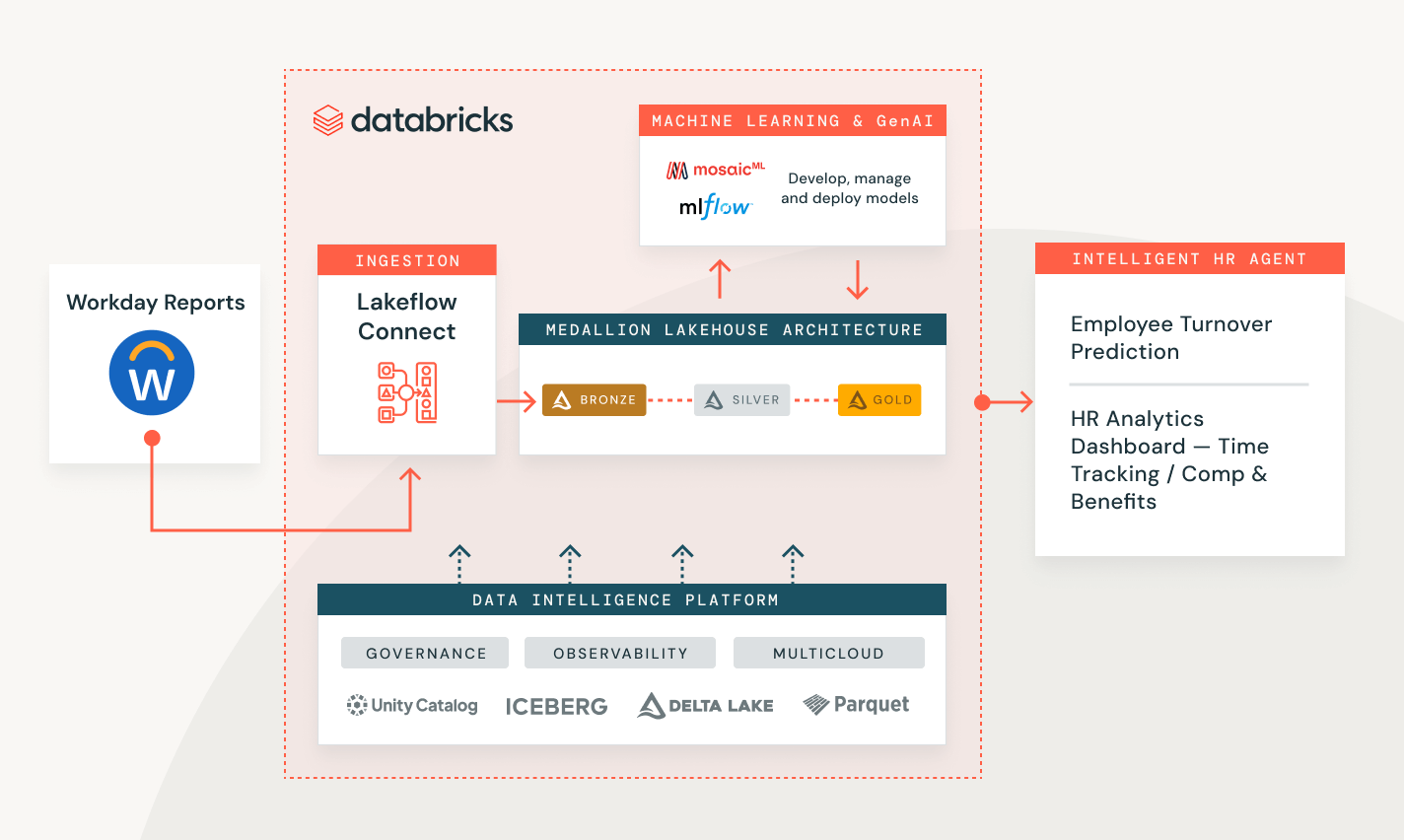

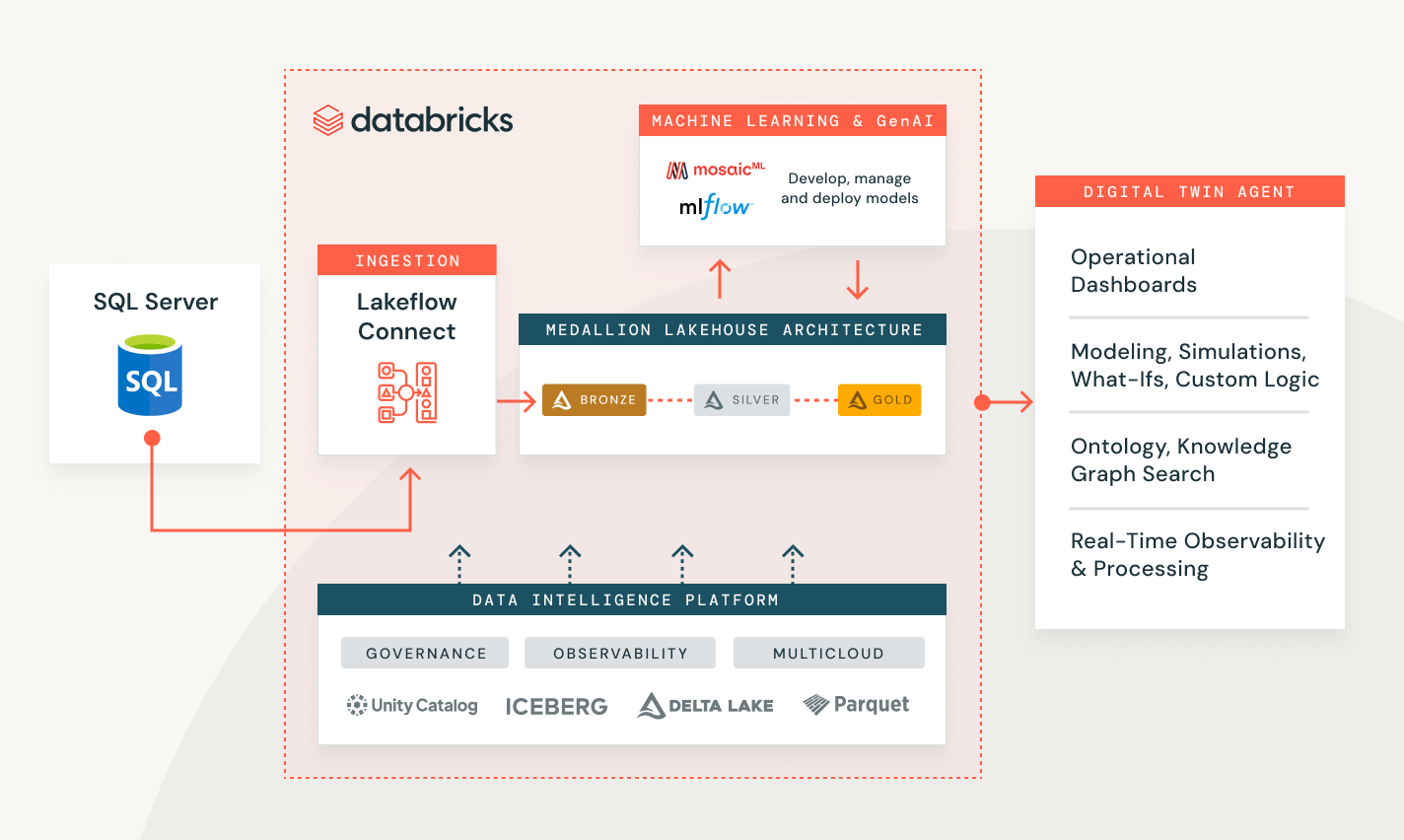

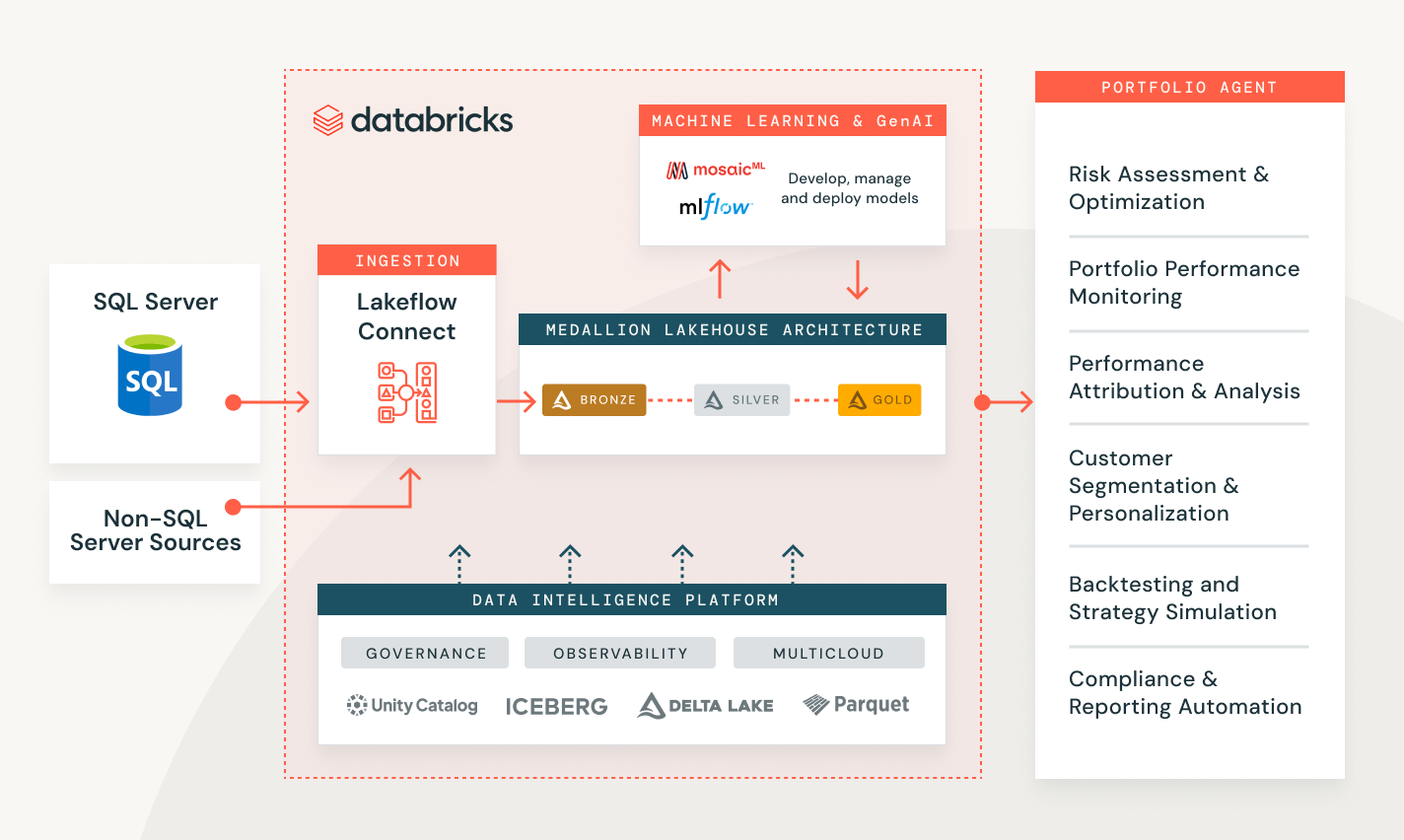

Resolver los problemas de los clientes en una variedad de industrias

Mide el rendimiento de la campaña y la puntuación de clientes potenciales

Crea una solución integral para transformar, proteger y analizar los datos de tus clientes y ayudarte a predecir su comportamiento futuro.

Explora las demostraciones de ingesta de datos

Los precios basados en el uso mantienen el gasto bajo control

Paga solo por los productos que usas, con granularidad por segundo.Descubre más

Explora otras ofertas integradas e inteligentes en la plataforma de inteligencia de datos.Trabajos de Lakeflow

Dota a tus equipos de herramientas para automatizar y orquestar mejor cualquier flujo de trabajo de ETL, análisis e IA con una profunda observabilidad, alta confiabilidad y amplio soporte de tipos de tareas.

Pipelines Declarativos de Spark

Simplifica el ETL por lotes y de transmisión con calidad de datos automatizada, captura de datos modificados (CDC), ingesta de datos, transformación y gobernanza unificada.

Unity Catalog

Controla sin problemas todos tus activos de datos con la única solución de gobernanza abierta y unificada de la industria para datos e IA, integrada en la plataforma de inteligencia de datos de Databricks.

Delta Lake

Unifica los datos en tu lakehouse, en todos los formatos y tipos, para todas tus cargas de trabajo de analítica e IA.

Comenzar

Explorar la documentación sobre la ingesta de datos

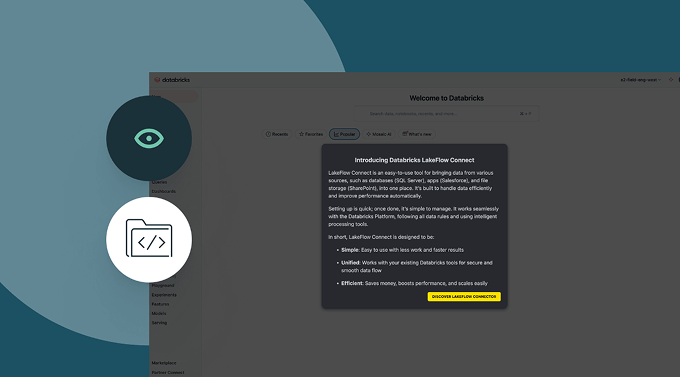

Ingiere datos de diferentes fuentes, a través de las nubes y mediante Lakeflow Connect.

Tour de Lakeflow Connect

Lakeflow Connect ya está disponible de forma general para Salesforce, Workday y SQL Server.

Para obtener acceso en versión preliminar a otros conectores, ponte en contacto con tu equipo de cuenta de Databricks.

Contenido relacionado

Preguntas frecuentes sobre la ingesta de datos

¿Estás listo para convertirte en una empresa de datos e IA?

Da los primeros pasos en tu transformación de datos