Tutoriales

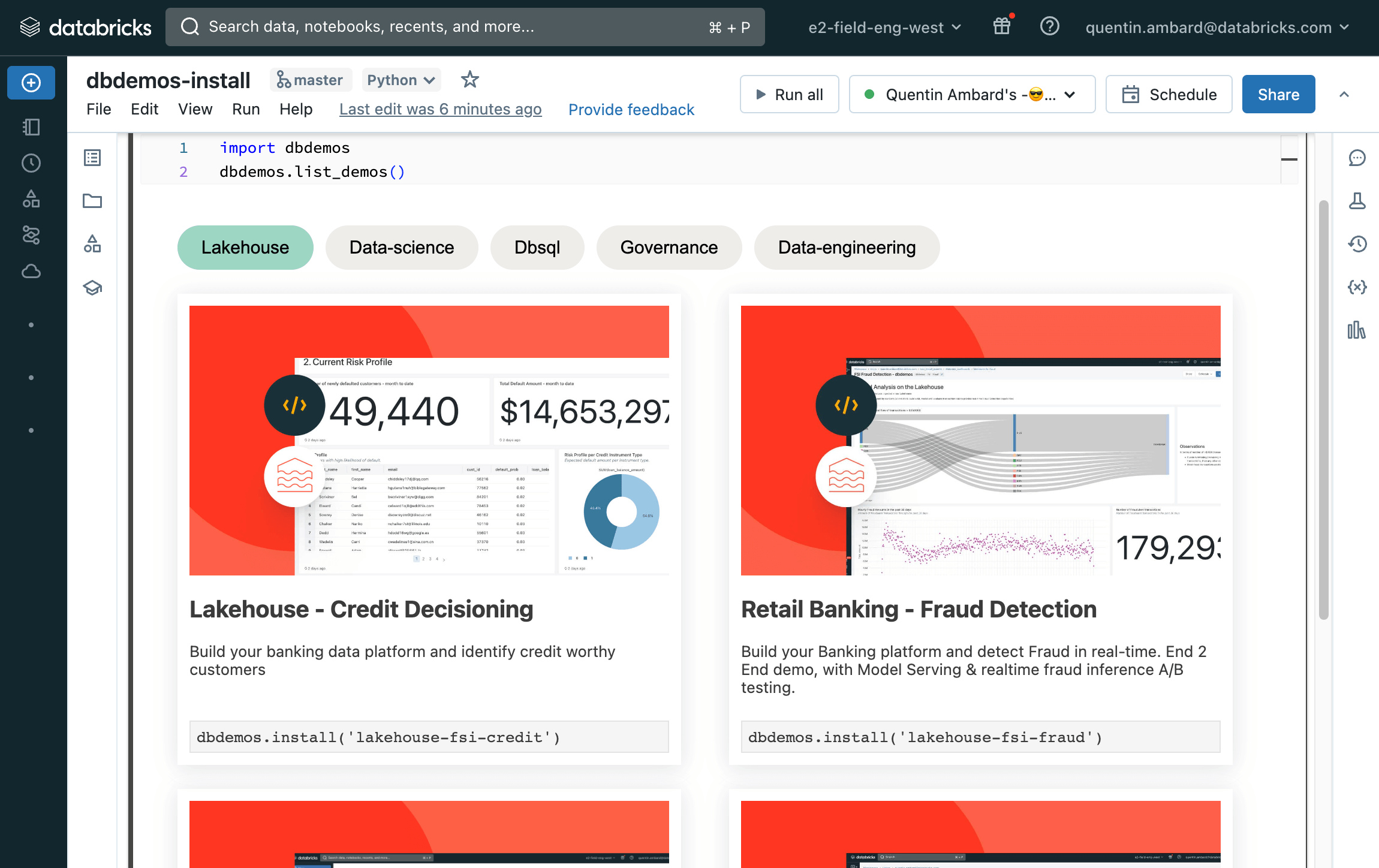

Descubra el poder de Lakehouse. Instala demos en tu espacio de trabajo para acceder rápidamente a las mejores prácticas de ingesta de datos, gobernanza, seguridad, ciencia de datos y almacenamiento de datos.

Tutoriales de inicio rápido

Instale demos directamente desde sus notebooks de Databricks

Carga el paquete dbdemos en una celda

Liste e instale cualquier demo

Explore todos los tutoriales

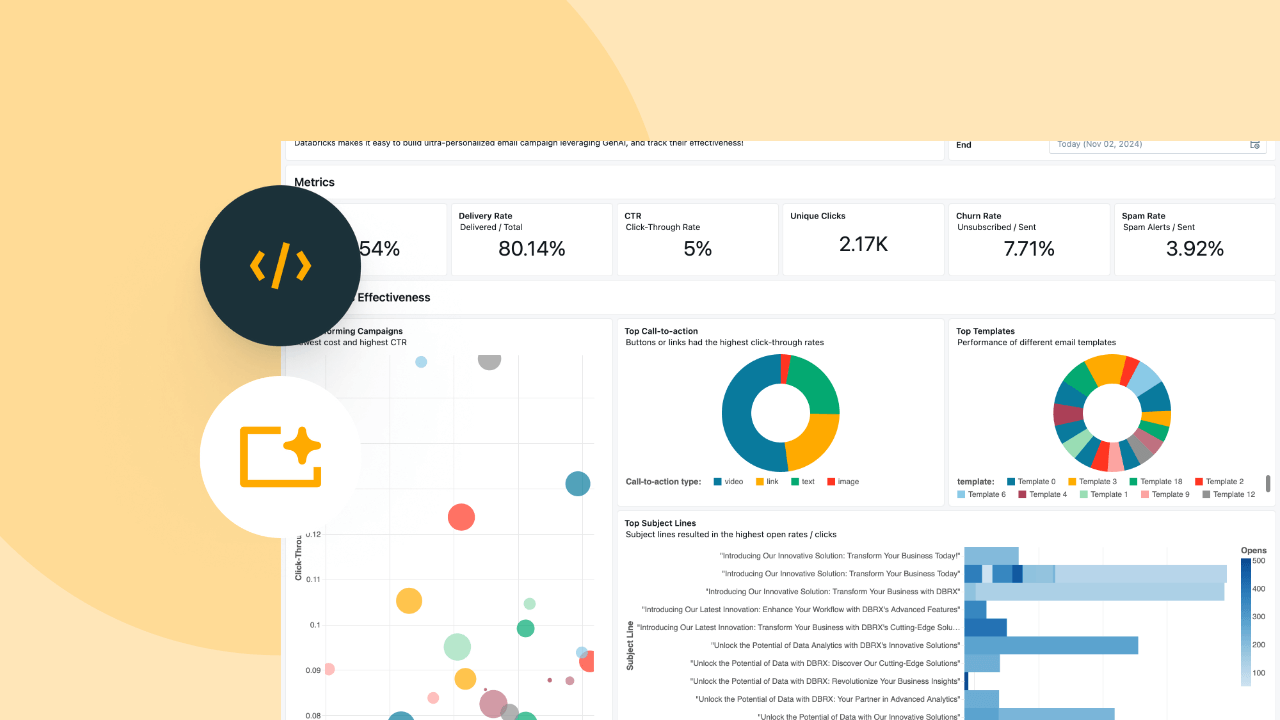

Databricks Intelligence Platform para C360: reducir la rotación de clientes

Centralice los datos de los clientes y reduzca la rotación: Ingesta (Pipelines declarativos de Spark), BI, Mantenimiento predictivo (ML), Gobernanza (UC) y Orquestación.

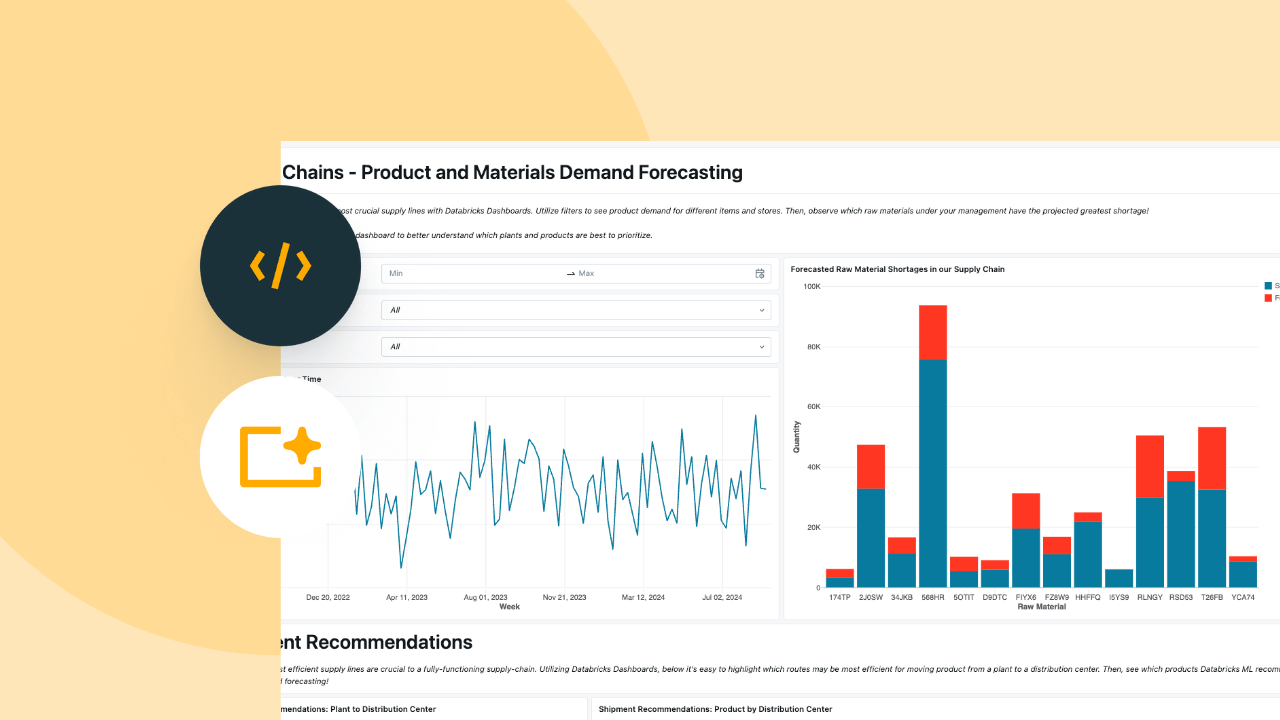

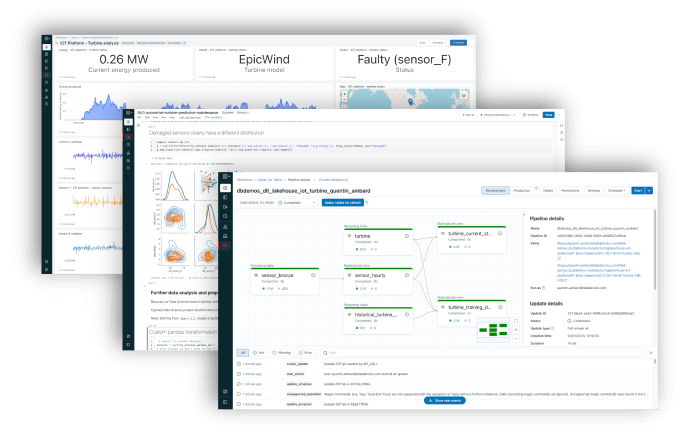

Databricks Intelligence Platform para IoT: mantenimiento predictivo

Detección de turbinas eólicas defectuosas: ingesta (Spark Declarative Pipelines), BI, mantenimiento predictivo (ML), gobernanza (UC) y orquestación.

Databricks Intelligence Platform para banca minorista: detección de fraudes

Cree su plataforma bancaria y detecte fraudes en tiempo real. Demo de extremo a extremo, con Model Serving e inferencia de fraude en tiempo real con pruebas A/B.

Databricks Intelligence Platform para FSI: toma de decisiones de crédito

Cree su plataforma de datos bancarios e identifique clientes con solvencia crediticia.

Databricks Intelligence Platform para HLS: readmisión de pacientes

Crea tu plataforma de datos y atención médica personalizada para reducir el riesgo de readmisión

Plataforma de inteligencia de datos para FSI: Reclamaciones inteligentes

Acelere y automatice el procesamiento de sus reclamos de seguros con la Plataforma de inteligencia de datos.

dbdemos se distribuye como un proyecto de GitHub

Para obtener más detalles, por favor, abra el archivo README.md de GitHub y siga la documentación.

dbdemos se proporciona tal cual. Consulte la Licencia para obtener más información. Databricks no ofrece soporte oficial para dbdemos ni para los activos asociados.

Si tiene algún problema, abra un issue y el equipo de demostración lo analizará haciendo su mejor esfuerzo. Consulte el Aviso para obtener más información.