Pruebas unitarias de pipelines declarativos de Lakeflow Spark para flujos de trabajo de nivel de producción.

Tipo de demostración

Tutorial del producto

Duración

A tu propio ritmo

Contenido relacionad

Lo que aprenderás

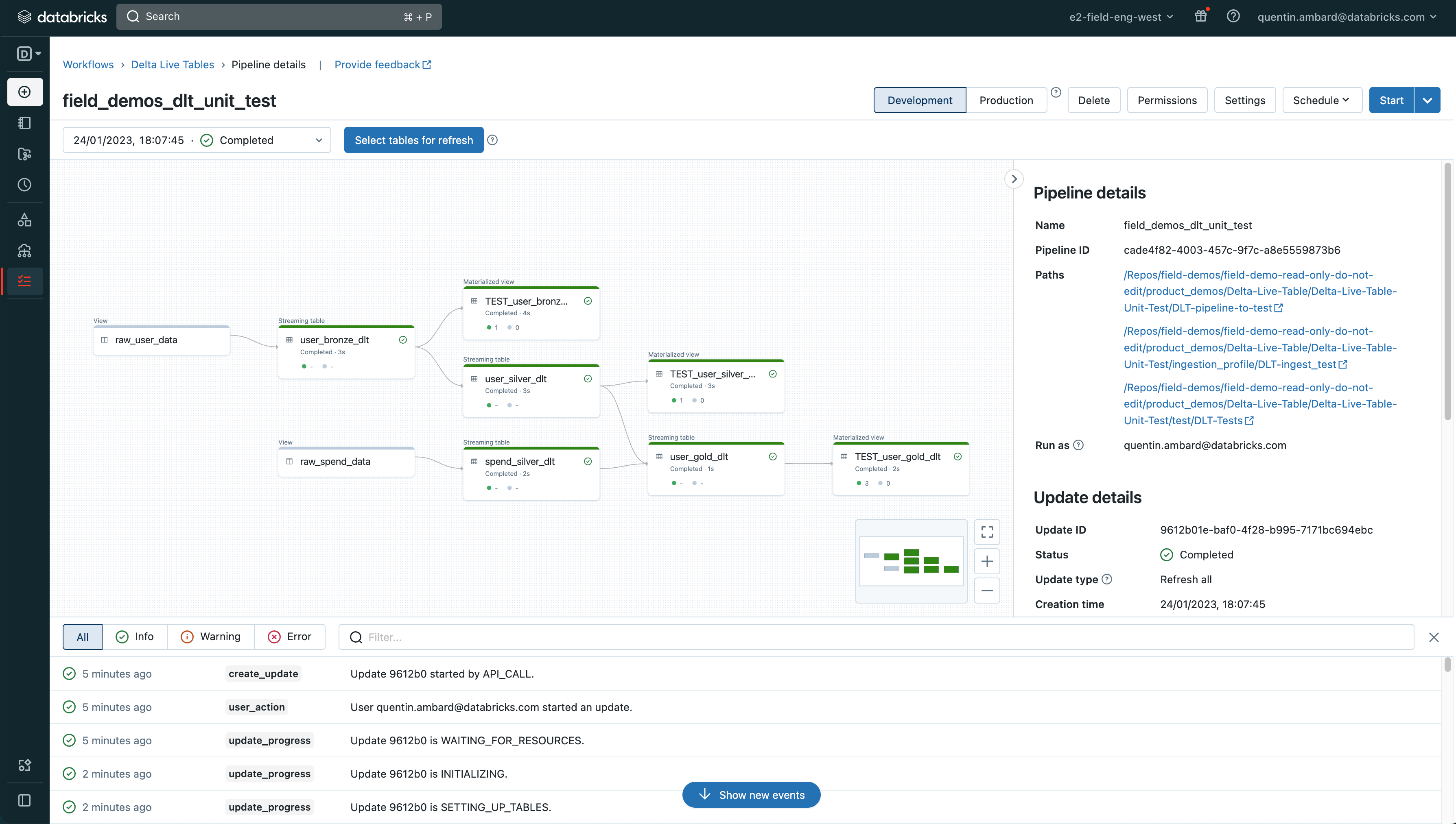

Las canalizaciones de nivel de producción requieren pruebas unitarias para garantizar su robustez. Declarative Pipelines te permite hacer un seguimiento de la calidad de los datos de tu canalización mostrando las expectativas en una tabla.

Estas expectativas también se pueden aprovechar para escribir pruebas de integración y crear pipelines robustos.

En este demo, te mostraremos cómo probar tu Declarative Pipeline y hacerlo componible, intercambiando fácilmente los datos de entrada con tus datos de prueba.

Para instalar la demo, obtenga un espacio de trabajo gratuito de Databricks y ejecute los siguientes dos comandos en un notebook de Python.

Dbdemos es una biblioteca de Python que instala demos completos de Databricks en sus áreas de trabajo. Dbdemos cargará e iniciará notebooks, Declarative Pipeline, clústeres, paneles de Databricks SQL, modelos de warehouse… Consulte cómo usar dbdemos.

Dbdemos se distribuye como un proyecto de GitHub.

Para más detalles, consulta en GitHub el archivo README.md y sigue la documentación.

Dbdemos se proporciona tal cual. Consulte la Licencia y el Aviso para obtener más información.

Databricks no ofrece soporte técnico oficial para dbdemos ni para los recursos asociados.

Si tiene algún problema, abra un ticket y el equipo de demostración lo revisará en la medida de lo posible.

Nota: Databricks Lakeflow unifica la ingeniería de datos con Lakeflow Connect, Lakeflow Spark Declarative Pipelines (antes conocido como DLT) y Lakeflow Jobs (antes conocido como Workflows).

Estos activos se instalarán en estas demostraciones de Databricks: