Introducción a la canalización declarativa de Spark en Lakeflow: Bicicletas

Tipo de demostración

Tutorial del producto

Duración

A tu propio ritmo

Contenido relacionad

Lo que aprenderás

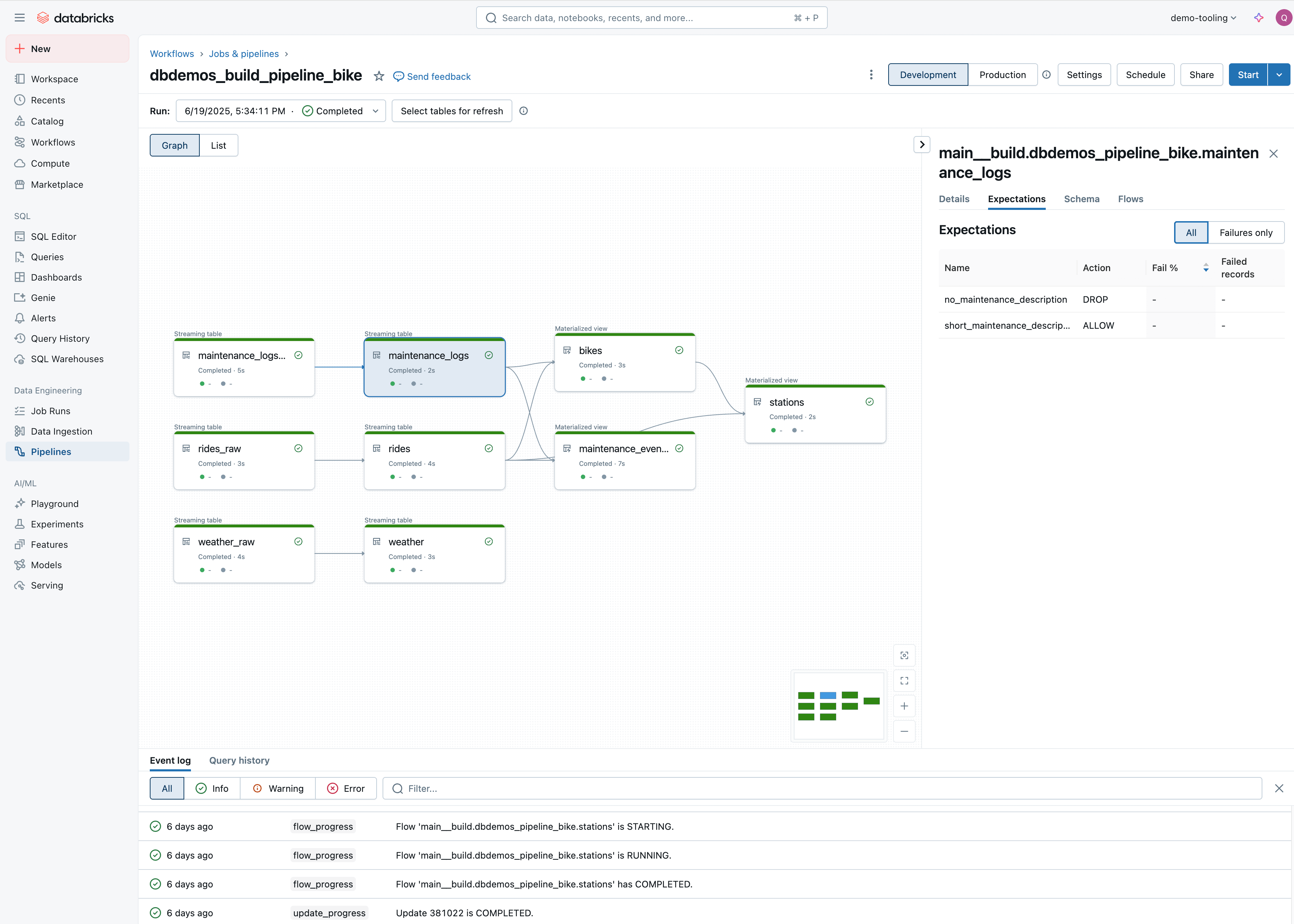

Este demo es una introducción a Spark Declarative Pipeline, un framework de ETL que hace que la ingeniería de datos sea accesible para todos. Simplemente declare sus transformaciones en SQL o Python, y Declarative Pipeline se encargará de la complejidad de la ingeniería de datos por usted:

- Acelere el desarrollo de ETL: Permita que los analistas y los ingenieros de datos innoven rápidamente con un desarrollo y mantenimiento sencillos de las canalizaciones

- Elimine la complejidad operativa: al automatizar tareas administrativas complejas y obtener una mayor visibilidad de las operaciones del pipeline

- Confíe en sus datos: Con controles y monitoreo de calidad integrados para garantizar BI, ciencia de datos y ML precisos y útiles

- Potencia tus datos con IA: Realiza una transformación de última generación con las consultas de IA de Databricks SQL

- Simplifica el procesamiento por lotes y de streaming: con canalizaciones de datos de autooptimización y autoescalado para el procesamiento por lotes o de streaming

En esta demostración, usaremos como entrada un conjunto de datos sin procesar que contiene información sobre nuestro sistema de alquiler de bicicletas. Nuestro objetivo es ingerir estos datos casi en tiempo real y crear tablas para nuestro equipo de analistas, garantizando al mismo tiempo la calidad de los datos.

Para instalar la demostración, obtenga un espacio de trabajo gratuito de Databricks y ejecute los siguientes dos comandos en un notebook de Python

Dbdemos es una biblioteca de Python que instala demos completos de Databricks en sus áreas de trabajo. Dbdemos cargará e iniciará notebooks, canalizaciones de DLT, clústeres, paneles de Databricks SQL, modelos de almacén… Consulte cómo usar dbdemos

Dbdemos se distribuye como un proyecto de GitHub.

Para obtener más detalles, consulta el archivo README.md y sigue la documentación.

Dbdemos se proporciona tal cual. Consulta la Licencia y el Aviso para obtener más información.

Databricks no ofrece soporte oficial para dbdemos ni para los activos asociados.

Si tienes algún problema, abre un ticket y el equipo de demostraciones lo revisará en la medida de lo posible.

Nota: Databricks Lakeflow unifica la ingeniería de datos con Lakeflow Connect, las canalizaciones declarativas de Lakeflow Spark (antes conocidas como DLT) y los trabajos de Lakeflow (antes conocidos como flujos de trabajo).

Estos recursos se instalarán en estas demostraciones de Databricks: