Es hora de reevaluar tu relación con Hadoop (blog)

Con las empresas obligadas a adaptarse a una fuerza laboral remota y distribuida durante el último año, la adopción de la nube se ha acelerado a un ritmo sin precedentes de +14%, lo que ha dado lugar a 2% o 13 000 millones de dólares por encima de las previsiones previas a la pandemia para 2020, con la posibilidad de que se produzcan más de 600 000 millones de dólares en migraciones de instalaciones locales a la nube en los próximos años. Este cambio hacia la nube confiere una importancia cada vez mayor a una nueva generación de plataformas de datos y análisis para impulsar la innovación y llevar a cabo las estrategias de transformación digital de las empresas. Sin embargo, muchas organizaciones siguen luchando con la complejidad, la infraestructura no escalable y los elevados gastos generales de mantenimiento de sus entornos Hadoop heredados y, finalmente, sacrifican el valor de sus datos y, a su vez, ponen en riesgo su ventaja competitiva. Para hacer frente a este reto y aprovechar más oportunidades (a veces ocultas) en sus datos, las organizaciones están recurriendo a plataformas de datos y análisis abiertas, sencillas y colaborativas basadas en la nube, como la plataforma Databricks Lakehouse. En este blog, descubrirás los retos que llevan a las organizaciones a explorar soluciones modernas basadas en la nube y el papel que desempeña la arquitectura lakehouse en el impulso de la próxima ola de innovación basada en datos.

Las promesas incumplidas de Hadoop

El sistema de archivos distribuido de Hadoop (HDFS) fue una tecnología revolucionaria cuando se lanzó y seguirá siendo un ícono en los anales de la historia de los datos. Gracias a su llegada, las organizaciones dejaron de estar limitadas por los confines de las bases de datos relacionales, y esto dio lugar al almacenamiento moderno de big data y, finalmente, a los data lakes en la nube. A pesar de toda su gloria y fanfarria hasta 2015, Hadoop tuvo dificultades para admitir el potencial evolutivo de todos los tipos de datos, especialmente a escala empresarial. Finalmente, a medida que el panorama de los datos y las necesidades empresariales asociadas evolucionaban, a Hadoop le costó seguir cumpliendo sus promesas. Como resultado, las empresas han comenzado a explorar alternativas basadas en la nube, y la tasa de migración de Hadoop a la nube no hace más que aumentar.

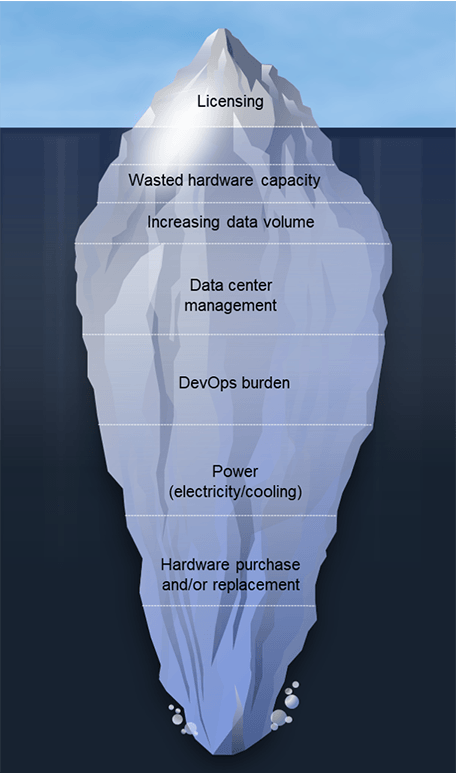

Los equipos migran de Hadoop por diversas razones; a menudo es una combinación de factores de “empuje” y “atracción”. Las limitaciones de los sistemas Hadoop existentes y los altos costos de licencias y administración están empujando a los equipos a explorar alternativas. También se ven atraídos por las nuevas posibilidades que ofrecen las arquitecturas de datos modernas en la nube. Aunque los requisitos de la arquitectura varían según la organización, vemos varios factores comunes que llevan a los clientes a darse cuenta de que es hora de empezar a decir adiós. Entre estas se incluyen las siguientes:

- Capacidad de hardware desperdiciada: El exceso de capacidad es un hecho en las implementaciones on-premises para poder escalar según las necesidades de los momentos pico, pero el resultado es que gran parte de esa capacidad permanece inactiva y sigue sumando a los costos operativos y de mantenimiento.

- Los costos de escalado aumentan rápidamente: No es posible desacoplar el almacenamiento y el cómputo en un entorno de Hadoop local, por lo que los costos aumentan con los conjuntos de datos. Súmale a eso la rápida digitalización resultante de la pandemia de COVID-19 y la tasa de crecimiento global. Las investigaciones indican que la cantidad total de datos creados, capturados, copiados y consumidos en el mundo aumentará, según las previsiones, un 152.5 % entre 2020 y 2024, hasta alcanzar los 149 zettabytes. En un mundo de hipercrecimiento de datos, los costos descontrolados pueden dispararse rápidamente.

- Carga de DevOps: Según la experiencia de nuestros clientes, puede suponer de 4 a 8 empleados de tiempo completo por cada 100 nodos.

- Mayores costos de energía: Espere pagar hasta $800 por servidor al año en función del consumo y la refrigeración. ¡Eso representa $80 000 al año para un clúster de Hadoop de 100 nodos!

- Costos de hardware nuevo y de reemplazo: Esto representa aproximadamente el 20 % del TCO, lo que equivale a los costos de administración de los clústeres de Hadoop.

- Actualizaciones de la versión del software: Estas actualizaciones suelen ser obligatorias para garantizar que se mantenga el contrato de soporte, y esos proyectos tardan meses en realizarse, ofrecen poca funcionalidad nueva y consumen el valioso ancho de banda de los equipos de datos.

Además de la gama completa de desafíos anteriores, existe una preocupación genuina sobre la viabilidad a largo plazo de Hadoop. En 2019, el mundo fue testigo de un desmoronamiento masivo en el ámbito de Hadoop. Google, cuyo artículo fundamental de 2004 sobre MapReduce sentó las bases para la creación de Apache Hadoop, dejó de usar MapReduce por completo, según tuiteó el vicepresidente sénior de Infraestructura Técnica de Google, Urs Hölzle. También hubo algunas fusiones y adquisiciones de muy alto perfil en el mundo de Hadoop. Además, en 2020, un proveedor líder de Hadoop modificó su conjunto de productos para que dejara de centrarse en Hadoop, ya que ahora se considera a Hadoop como “más una filosofía que una tecnología”. Por último, en 2021, la Apache Software Foundation anunció el retiro de diez proyectos del ecosistema de Hadoop. Este conjunto creciente de inquietudes, junto con la necesidad acelerada de digitalización, ha impulsado a muchas empresas a reevaluar su relación con Hadoop.

Gartner®: Databricks, líder en bases de datos en la nube

El cambio hacia la arquitectura lakehouse

Una arquitectura de lakehouse es la arquitectura de datos ideal para las organizaciones basadas en datos. Combina las mejores cualidades de los almacenes de datos y los lagos de datos para ofrecer una única solución de alto rendimiento para todas las cargas de trabajo de datos. La arquitectura de lakehouse admite una variedad de casos de uso, como el análisis de datos de streaming para BI, la ciencia de datos y la IA. ¿Por qué a los clientes les encanta la plataforma Lakehouse de Databricks?

- Es simple. Unifique sus datos, análisis e IA en una sola plataforma.

- Está abierto. Unifica tu ecosistema de datos con estándares y formatos abiertos.

- Es colaborativo. Unifica a tus equipos de datos para que colaboren en todo el flujo de trabajo de datos e IA.

Una arquitectura lakehouse puede ofrecer ganancias significativas en comparación con los entornos Hadoop heredados, que “impulsan” a las empresas hacia la adopción de la nube. Esto también incluye a los clientes que han intentado usar Hadoop en la nube, pero no están obteniendo los resultados esperados o deseados. Como explica R. Tyler Croy, director de Ingeniería de Scribd: “Databricks afirmó una optimización del 30 % al 50 % para la mayoría de las cargas de trabajo tradicionales de Apache Spark™. Por curiosidad, refactoricé mi modelo de costos para tener en cuenta el precio de Databricks y las posibles optimizaciones de los trabajos de Spark. Después de ajustar las cifras, descubrí que con una tasa de optimización del 17 %, Databricks reduciría tanto el costo de nuestra infraestructura de Amazon Web Services (AWS) que pagaría el costo de la propia plataforma de Databricks. Después de nuestra evaluación inicial, ya estaba convencido de las características y las mejoras en la velocidad de los desarrolladores que ofrecería Databricks. Cuando corrí los números en mi modelo, me di cuenta de que no podía permitirme no adoptar Databricks”.

Scribd no es el único; entre los clientes adicionales que han migrado de Hadoop a la plataforma lakehouse de Databricks se incluyen:

- H&M procesa volúmenes masivos de datos de más de 5000 tiendas en más de 70 mercados con millones de clientes cada día. Su arquitectura basada en Hadoop creaba desafíos para los datos. Se volvió costosa y de uso intensivo de recursos para escalar, presentaba problemas de seguridad de los datos, tenía dificultades para escalar las operaciones a fin de respaldar los esfuerzos de la ciencia de datos desde varias fuentes de datos aisladas y ralentizaba el tiempo de comercialización debido a importantes retrasos de DevOps. Llevaba todo un año pasar de la ideación a la producción. Con Databricks, H&M se beneficia de una mayor eficiencia operativa al reducir los costos operativos en un 70 %, mejorar la colaboración entre equipos e impulsar el impacto empresarial con un tiempo de obtención de información más rápido.

- Viacom18 necesita procesar terabytes de datos diarios de los espectadores para optimizar la programación. Su data lake de Hadoop local no podía procesar 90 días de datos continuos dentro de los SLA, lo que limitaba su capacidad para satisfacer las necesidades del negocio. Con Databricks, redujeron significativamente los costos con tiempos de consulta más rápidos y menos DevOps a pesar del aumento de los volúmenes de datos. Viacom18 también mejoró la productividad del equipo en un 26 % con una plataforma totalmente administrada que admite ETL, análisis y ML a escala.

- Reckitt Benckiser Group (RB) tenía dificultades con la complejidad de pronosticar la demanda en 500 000 tiendas. Procesan más de 2 TB de datos todos los días a través de 250 pipelines. La infraestructura heredada de Hadoop demostró ser compleja, engorrosa, costosa de escalar y tenía problemas de rendimiento. Con Databricks, RB logró una capacidad 10 veces mayor para soportar el volumen del negocio, una compresión de datos del 98 % de 80 TB a 2 TB, lo que redujo los costos operativos, y un rendimiento 2 veces más rápido de los pipelines de datos para trabajos 24x7.

Hadoop nunca se creó para ejecutarse en entornos de nube. Si bien los servicios de Hadoop basados en la nube presentan mejoras incrementales en comparación con sus equivalentes on-premise, ambos siguen estando rezagados en comparación con la arquitectura de lakehouse. Ambas instancias de Hadoop ofrecen bajo rendimiento, baja productividad y altos costos, y son incapaces de abordar casos de uso de datos más sofisticados a escala.

Garantice el futuro de su crecimiento impulsado por los datos, el análisis y la IA.

Las decisiones de migración a la nube son decisiones de negocio. Obligan a las empresas a analizar en detalle la realidad de la entrega de sus sistemas actuales y a evaluar lo que necesitan lograr para sus objetivos a corto y largo plazo. A medida que la inversión en IA sigue cobrando impulso, los líderes en datos, análisis y tecnología deben desempeñar un papel fundamental a la hora de pensar más allá de la arquitectura Hadoop existente y plantearse la pregunta: «¿Esto nos llevará a donde necesitamos llegar?».

Con la claridad de los objetivos, surgen detalles técnicos críticos, como el mapeo de la tecnología, la evaluación del uso de los recursos de la nube y la relación costo-rendimiento, y la estructuración de un proyecto de migración que minimice los errores y los riesgos. Pero, lo que es más importante, debe tener la convicción basada en datos de que es hora de reevaluar su relación con Hadoop. Obtenga más información sobre cómo la migración desde Hadoop puede acelerar los resultados empresariales en todos sus casos de uso de datos.

1. Fuente: Gartner Market Databook, Goldman Sachs Global Investment Research

(Esta entrada del blog ha sido traducida utilizando herramientas basadas en inteligencia artificial) Publicación original

No te pierdas ninguna publicación de Databricks.

¿Qué sigue?

Líder de dados

4 de diciembre de 2025/3 min de lectura

Construindo a empresa pronta para AI: líderes compartilham soluções e práticas de AI do mundo real

Líder de dados

29 de diciembre de 2025/4 min de lectura