Mejores prácticas de gobernanza de la IA: Cómo crear programas de IA responsables y eficaces

Summary

- La gobernanza de la IA empresarial gestiona el riesgo, el cumplimiento y la confianza a medida que los sistemas de IA pasan a un uso de producción de alto riesgo, basando las decisiones en principios como la equidad, la transparencia, la rendición de cuentas, la privacidad, la seguridad y las salvaguardias integradas.

- Los marcos de gobernanza eficaces alinean la supervisión con el riesgo empresarial, definen roles y políticas interfuncionales claros, integran puntos de control en todo el ciclo de vida de la IA y se basan en evaluaciones de riesgos estructuradas, supervisión, respuesta a incidentes y documentación estandarizada.

- Los programas escalables utilizan estándares centralizados con ejecución federada, intervención humana para decisiones de alto riesgo, seguimiento proactivo de las normativas en evolución y un fuerte patrocinio de los altos directivos, de modo que la gobernanza se convierte en un facilitador para la innovación responsable en IA en lugar de un cuello de botella.

Por qué ahora es importante la gobernanza de la IA empresarial

La adopción de la IA empresarial se está acelerando rápidamente, impulsada por los avances en la IA generativa. Estos modelos aprenden de los datos, cambian a medida que cambian las entradas y avanzan con las técnicas y los conjuntos de datos de entrenamiento.

Pero incluso a medida que los modelos se vuelven más sofisticados y precisos, los LLM y los proyectos de IA de última generación siguen presentando riesgos empresariales, especialmente cuando se implementan en producción. La consecuencia es que la gobernanza de la IA es más importante que nunca, y las empresas deben contar con una estrategia sólida y multifacética.

Los pilares clave de la gobernanza incluyen:

- Controles y permisos de acceso a los datos

- Linaje de datos y observabilidad total

- Protecciones de IA integradas para proteger la PII y bloquear contenido no seguro

- Cumplimiento y requisitos normativos

¿Cuáles son los objetivos de un marco de gobernanza de la IA?

Las mejores prácticas de gobernanza de la IA proporcionan una forma estructurada para garantizar que los sistemas de IA se desarrollen, implementen y operen de manera responsable. Además, estas prácticas se alinean con los objetivos de negocio, gestionan el riesgo en todo el ciclo de vida de la IA y generan confianza con los usuarios y las partes interesadas.

La presión regulatoria sobre el uso de la IA también est�á aumentando. Los gobiernos y los organismos de normalización están introduciendo nuevos debates en torno a la transparencia, la rendición de cuentas y la supervisión de los sistemas de IA, lo que proporciona a los usuarios un conjunto de marcos teóricos y prácticos sobre los que construir su gobernanza. Por ejemplo, los Principios de IA de la OCDE proporcionan una base basada en valores para un marco de gobernanza de la IA, mientras que la Ley de IA de la Unión Europea establece un marco basado en el riesgo con requisitos más estrictos para los casos de uso de IA de alto riesgo.

Más allá del cumplimiento, la gobernanza de la IA tiene un valor comercial directo. Las organizaciones con estructuras de gobernanza claras están en una mejor posición para:

- Gane la confianza de las partes interesadas en las decisiones impulsadas por la IA

- Reduzca el riesgo operativo y legal

- Escale los sistemas de IA de manera más eficiente entre equipos y casos de uso

- Demostrar responsabilidad y control a medida que los programas de IA maduran

Desafíos comunes que impulsan la necesidad de gobernanza

Muchas empresas enfrentan desafíos similares a medida que crece la adopción de la IA:

- Propiedad poco clara: la responsabilidad de los resultados de la IA suele estar fragmentada entre los equipos de datos, ingeniería, legales y de negocios. Los equipos pueden lanzar modelos, pero ningún equipo es dueño de los resultados.

- Herramientas que evolucionan rápidamente: La IA y la IA generativa nuevas mejoran rápidamente, y la velocidad y el ritmo de su desarrollo implican que pueden carecer de los controles y procesos adecuados.

- Datos y procesos fragmentados: Los datos, el entrenamiento, la implementación y el monitoreo pueden residir en sistemas separados, lo que dificulta la supervisión y la documentación coherente.

- Auditabilidad limitada: demostrar cómo se entrenó, evaluó e implementó un sistema de IA puede llevar mucho tiempo o ser imposible sin artefactos de gobernanza.

Estos desafíos subrayan por qué la gobernanza debe ser intencional e integrarse en los procesos centrales desde el principio, en lugar de adaptarse después de que surjan los problemas.

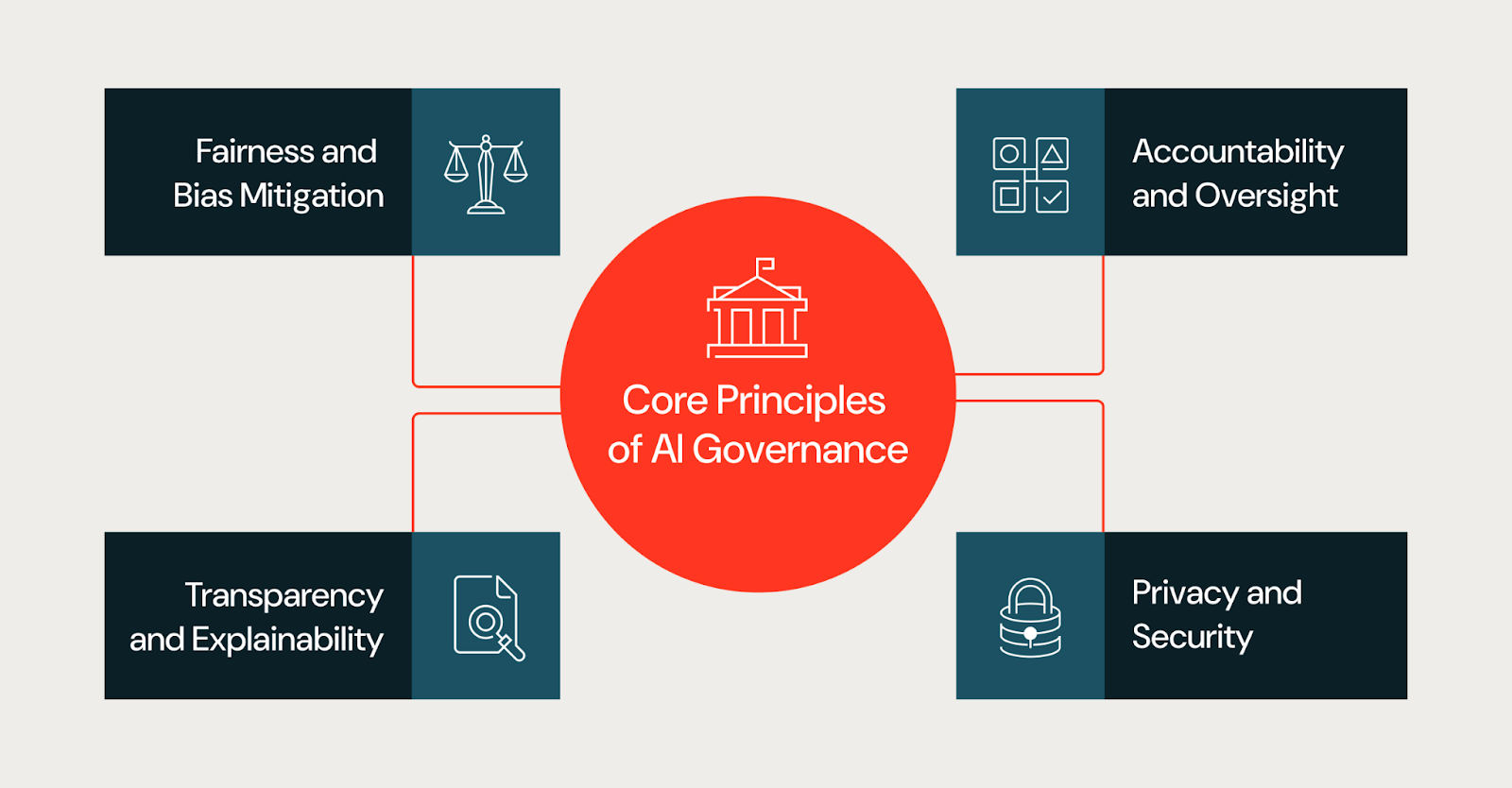

Principios fundamentales para una gobernanza de la IA eficaz

La gobernanza se aplica a los sistemas de IA en su conjunto, incluidos los datos, los prompts, los flujos de trabajo, los puntos de decisión humanos y las aplicaciones posteriores, no solo a los modelos individuales. Muchos riesgos empresariales surgen de la interacción de estos componentes, en lugar de surgir del modelo en sí. Las mejores prácticas de gobernanza de la IA se basan en un conjunto coherente de principios fundamentales. Estos principios guían las decisiones a lo largo del ciclo de vida de la IA y proporcionan un marco compartido para equipos con diferentes responsabilidades.

Equidad y mitigación de sesgos

El sesgo puede introducirse a través de los datos de entrenamiento, la selección de características o el contexto de implementación y dar lugar a resultados dispares entre las poblaciones. Los programas de gobernanza deben exigir que los equipos evalúen los riesgos de equidad de forma temprana, documenten las limitaciones conocidas y supervisen los sesgos no deseados a medida que los modelos evolucionan en producción.

En la práctica, los equipos evalúan la equidad examinando los datos de entrenamiento para detectar brechas de representación, probando los resultados de los modelos en diferentes grupos demográficos y definiendo métricas de equidad antes de la implementación. Los enfoques comunes incluyen la evaluación desagregada, las auditorías de sesgo durante el desarrollo y la supervisión continua de la deriva en producción. Los equipos también deben documentar las limitaciones conocidas y los casos extremos en los que el modelo puede tener un rendimiento inferior.

Transparencia y explicabilidad

La transparencia ayuda a las partes interesadas a comprender cómo se construyen los sistemas de IA y cómo influyen en los resultados. Esto no significa exigir una visibilidad total de la arquitectura del modelo propietario de un proveedor o de los datos de entrenamiento, ya que los proveedores de modelos cerrados no suelen revelar esos detalles. En cambio, la transparencia se centra en lo que una organización puede controlar y documentar.

Esto incluye claridad sobre qué modelos y versiones podría estar usando un equipo, qué datos les están pasando, cómo los están instruyendo o ajustándolos finamente, y qué criterios de evaluación podría aplicar un equipo antes de la implementación. Los equipos también deben documentar la lógica de decisión en la capa de la aplicación para explicar cómo se usan, filtran o anulan los resultados del modelo en los flujos de trabajo posteriores. Para las partes interesadas que necesitan explicaciones, como los reguladores, los ejecutivos o los usuarios afectados, el objetivo es proporcionar el contexto adecuado sobre cómo el sistema llega a sus resultados, incluso cuando el modelo subyacente es una caja negra.

Responsabilidad y supervisión

Una gobernanza eficaz define responsabilidades claras para los sistemas de IA. Cada modelo o aplicación de IA debe tener personas o equipos responsables de los resultados, la gestión de riesgos y el cumplimiento de las políticas internas. Los mecanismos de supervisión garantizan que la responsabilidad persista después de la implementación en lugar de desaparecer una vez que se lanza un modelo.

Privacidad y seguridad

Los sistemas de IA suelen procesar datos sensibles o regulados, y la gobernanza debe garantizar que las protecciones de privacidad y los controles de seguridad se apliquen de forma coherente, lo que incluye la gestión de acceso basada en roles, los filtros de PII y el filtrado de resultados no seguros. Las consideraciones sobre privacidad y seguridad deben integrarse en todo el ciclo de vida de la IA, y no abordarse únicamente en el momento de la implementación.

Salvaguardias integradas

Los sistemas de IA necesitan barreras de protección que eviten resultados dañinos o no deseados. Las protecciones integradas incluyen la validación de entradas para detectar consultas malformadas o adversariales, filtros de salida que bloquean contenido inseguro o inapropiado, detección de PII para evitar la exposición de datos y moderación de contenido para aplicaciones orientadas al usuario. Estos controles deben ser configurables por nivel de riesgo; una herramienta interna de bajo riesgo puede necesitar protecciones más ligeras que un agente de cara al cliente.

Acceso unificado para modelos y proyectos de IA

A medida que las organizaciones escalan la adopción de la IA, el acceso a los modelos y proyectos de IA debe regirse a través de un marco centralizado. Los controles de acceso unificados garantizan permisos coherentes en los entornos de desarrollo, de preparación y de producción. Esto incluye el acceso basado en roles para definir quién puede ver, modificar o implementar modelos; los registros de auditoría que rastrean los cambios y el uso; y la integración con sistemas de gestión de identidades. El acceso centralizado reduce el riesgo de proyectos de IA paralelos y facilita la demostración del cumplimiento. Sin controles de acceso unificados, las organizaciones a menudo luchan con la 'IA en la sombra' (modelos y aplicaciones implementados sin supervisión formal), que se convierte en una de las mayores barreras para una gobernanza consistente a escala.

Construir un marco práctico de gobernanza de la IA

Si bien los principios de gobernanza pueden definir cómo es una buena gobernanza, los marcos son lo que define cómo esas organizaciones implementan sus procesos. En otras palabras, un marco práctico de gobernanza de la IA traduce los objetivos de alto nivel en roles, políticas y controles específicos que se ajustan a la estructura general y la tolerancia al riesgo de una organización.

Consulte el Databricks AI Governance Framework para ver un ejemplo de un enfoque estructurado para definir los pilares de la gobernanza y las consideraciones clave.

Alinear la gobernanza con los objetivos empresariales

Las organizaciones obtienen mejores resultados cuando la gobernanza se alinea con el impacto empresarial y el riesgo. No todos los sistemas de IA necesitan el mismo nivel de supervisión. Un chatbot que resume documentos externos conlleva un riesgo diferente al de un modelo que aprueba préstamos o prioriza casos médicos.

Establecer roles y estructuras de gobernanza

Para que la gobernanza de la IA sea más eficaz, debe ser multifuncional. Esto implica una colaboración continua e intencionada entre los equipos de datos e IA, los de asuntos legales y cumplimiento, privacidad y seguridad, y las partes interesadas del negocio. Las estructuras comunes incluyen:

- Comités de gobernanza multifuncionales

- Modelos RACI claramente definidos

- Requisitos de intervención humana para las decisiones de alto riesgo

- Controles de acceso basados en roles

Estas estructuras aclaran los derechos de decisión y reducen la ambigüedad a medida que los programas de IA se escalan.

Definir políticas, estándares y controles de IA

Los estándares claros reducen la fricción. Los marcos de gobernanza eficaces especifican:

- Documentación y artefactos requeridos

- Criterios de clasificación de riesgos de la IA

- Umbrales de aprobación por nivel de riesgo

- Expectativas de monitoreo, respuesta a incidentes y auditoría

Cuando los estándares son vagos, los equipos inventan interpretaciones locales. Cuando los estándares son concretos, los equipos avanzan más rápido y con menos sorpresas.

Operacionalización de la gobernanza de la IA

La gobernanza de la IA debe integrarse en la estructura misma del flujo de trabajo, como la forma en que los equipos diseñan, implementan y operan los sistemas de IA. Sin embargo, debe ser más que una simple teoría; la gobernanza operativa debe responder a preguntas prácticas, como quién decide, qué evidencia deben producir los equipos y cómo los sistemas se mantienen en cumplimiento a lo largo del tiempo. El resultado es un proceso explícito que los equipos pueden seguir para integrar la gobernanza de la IA en sus flujos de trabajo.

Integrar la gobernanza en el ciclo de vida del desarrollo de la IA

La mayoría de las organizaciones no están creando modelos fundacionales desde cero. Están combinando modelos existentes con datos propios para crear proyectos, agentes y aplicaciones de IA. La gobernanza debe reflejar esta realidad incorporando puntos de control directamente en el ciclo de vida del desarrollo. Por ejemplo, un asistente de IA interno que resume documentos externos puede clasificarse inicialmente como de bajo riesgo. Si ese mismo sistema se expone más tarde a los clientes o se utiliza para fundamentar decisiones reguladas, su perfil de riesgo cambia, lo que requiere nuevas aprobaciones, salvaguardias y monitoreo.

- Definir el alcance y la intención. Antes de que comience el desarrollo, documente el uso previsto del sistema, los usos prohibidos y el contexto de decisión. Esto evita la ampliación del alcance, por la que los sistemas se reutilizan en escenarios de mayor riesgo sin una revisión previa.

- Documentar las fuentes de datos. Registrar la titularidad de los datos, las restricciones de consentimiento y las limitaciones conocidas. Si los equipos no pueden explicar de dónde provienen los datos y por qué son apropiados, no deberían usarlos para construir o hacer el ajuste fino de un sistema.

- Establecer criterios de evaluación. Acordar las métricas, el umbral y las compensaciones aceptables antes de hacer las pruebas. Los equipos deben documentar por qué eligieron métricas específicas y qué modos de falla observaron. Esto convierte la evaluación en un registro de decisiones para referencia futura.

- Hacer cumplir las puertas de lanzamiento. Exigir propietarios designados, documentación completa y aprobación alineada con el nivel de riesgo del sistema. Definir criterios de reversión para que los equipos sepan cuándo retirar un sistema de producción.

- Monitorear y revisar. Después de la implementación, revise el comportamiento en producción, valide las suposiciones con el uso real y documente los cambios a lo largo del tiempo.

Realizar evaluaciones de riesgo de la IA

La evaluación de riesgos es el corazón de la gobernanza práctica. Esta determina cuánto control necesita un sistema y dónde deben centrar su atención los equipos. A medida que los equipos implementan evaluaciones eficaces, deben centrarse en un pequeño conjunto de preguntas:

- ¿A quién afecta este sistema?

- ¿Qué decisiones influye o automatiza?

- ¿Qué sucede cuando falla?

- ¿Con qué facilidad pueden intervenir los humanos?

- ¿Qué sensibilidad de datos implica?

Una vez que los equipos reúnen las respuestas a estas preguntas, pueden asignar un nivel de riesgo, que es una forma de traducir el juicio en acción. Por ejemplo, una herramienta interna de bajo riesgo puede requerir documentación ligera y revisión periódica, mientras que un sistema de alto riesgo puede requerir supervisión humana frecuente, aprobación formal y monitoreo continuo.

Las evaluaciones de riesgos deben realizarse en una etapa temprana y estar sujetas a actualizaciones continuas a lo largo del tiempo. A medida que los sistemas se expanden a nuevos usuarios o casos de uso, su perfil de riesgo suele cambiar. Los procesos de gobernanza deben diseñarse para tener en cuenta esa evolución.

Definir las rutas de aprobación y escalamiento

La gobernanza operativa depende de rutas de decisión claras. Los equipos necesitan saber quién puede aprobar un sistema, cuándo se requiere un escalamiento y cómo resolver los desacuerdos. Como resultado, las organizaciones suelen definir las siguientes rutas de decisión:

- autoridades de aprobación por nivel de riesgo

- desencadenantes de escalamiento para problemas no resueltos

- cronogramas de revisión y respuesta

- criterios para detener o revertir sistemas

Sin rutas definidas, la gobernanza puede volverse confusa y los equipos pueden sufrir parálisis a medida que las decisiones se estancan, la responsabilidad se difumina y los equipos eluden los controles para seguir avanzando. Establecer rutas claras reduce la ambigüedad y aumenta el cumplimiento porque los equipos entienden cómo avanzar.

Implementar controles de monitoreo y cumplimiento

Dado el desarrollo rápido y continuo de los sistemas de IA, la gobernanza de la IA no puede ser estática. Con el tiempo, los datos cambian, los patrones de uso varían y el rendimiento se degrada. Es fundamental que los equipos supervisen el comportamiento de la IA en producción centrándose en:

- rendimiento frente a métricas definidas

- desviación de datos y cambios en la distribución

- entradas o salidas inesperadas

- Uso del sistema fuera del alcance previsto

La gobernanza define qué deben monitorear los equipos, con qué frecuencia revisan los resultados y qué acciones toman cuando se superan los umbrales. Estas acciones pueden incluir el reentrenamiento, la restricción del uso, la remisión a los órganos de revisión o el cierre de los sistemas. Al convertir el monitoreo en un ciclo de retroalimentación, las organizaciones pueden asegurarse de que están maximizando los beneficios de sus procesos internos.

Establecer procesos de respuesta a incidentes y de remediación

Además de crear una cultura de retroalimentación y rendición de cuentas, los marcos de gobernanza sólidos deben tener en cuenta los fallos. Incluso los sistemas bien diseñados se estropean o se degradan con el tiempo.

Otro paso para la gobernanza es definir cómo un equipo responde a los incidentes de la IA, incluidos los resultados sesgados, el comportamiento inseguro, la exposición de datos o las inquietudes regulatorias. Los equipos necesitan guías predefinidas que especifiquen:

- Cómo identificar y clasificar incidentes

- ¿Quién es el responsable de la respuesta y la comunicación?

- Cómo contener el daño

- Cómo documentar las causas raíz y la remediación

Las revisiones posteriores a los incidentes pueden ayudar a reincorporar nuevos aprendizajes o actualizaciones a la gobernanza establecida, lo que ayuda a actualizar las evaluaciones de riesgos, mejorar los controles y perfeccionar las políticas. Este ciclo garantiza que la gobernanza evolucione con la experiencia del mundo real.

Estandarizar los artefactos de gobernanza

A medida que los equipos desarrollan su gobernanza, la documentación estandarizada es importante para la evidencia y la coherencia en todo el sistema. La documentación coherente también puede ayudar en las auditorías y reducir la necesidad de duplicar esfuerzos para reproducir documentos. Las organizaciones priorizan los siguientes documentos estandarizados:

- Resúmenes del sistema que definen el propósito y el alcance

- Documentación de datos que registra fuentes y restricciones

- Resúmenes de evaluación que recogen el rendimiento y las limitaciones

- Planes de supervisión que definen la vigilancia continua

Escalar la gobernanza entre equipos y dominios

A medida que la adopción de la IA sigue creciendo, la gobernanza de una organización debe escalar sin introducir cuellos de botella. Muchos equipos utilizan un modelo centralizado-federado, en el que un grupo central define los estándares, los marcos de riesgo y las políticas, mientras que los equipos de dominio los aplican localmente y siguen siendo responsables de los resultados. Este modelo ayuda a encontrar un equilibrio entre la coherencia y la velocidad.

El escalamiento también requiere capacitación. A medida que los sistemas de gobernanza evolucionan y se desarrollan, los equipos necesitan entender qué requiere la gobernanza y cómo cumplir mejor con los requisitos.

Gartner®: Databricks, líder en bases de datos en la nube

Garantizar la transparencia, la confianza y la explicabilidad

La confianza es un resultado central de una gobernanza de la IA eficaz. Es más probable que las partes interesadas adopten los sistemas de IA y confíen en ellos cuando entienden cómo se toman las decisiones y cómo se gestionan los riesgos a lo largo del ciclo de vida de la IA.

Supervisión con intervención humana

Para los casos de uso de alto riesgo o sensibles, los humanos deben conservar la autoridad final sobre las decisiones impulsadas por la IA. Los marcos de gobernanza deben definir cuándo es necesaria la revisión humana, cómo se producen las intervenciones y cómo se documentan las decisiones.

Comunicación de las decisiones de la IA a las partes interesadas

Las diferentes partes interesadas requieren diferentes niveles de explicación. Los equipos técnicos pueden necesitar métricas de evaluación detalladas, mientras que los ejecutivos y los reguladores pueden confiar en resúmenes, tarjetas de modelo o fundamentos de decisión. La comunicación clara genera confianza y respalda la rendición de cuentas.

Mantenerse al día con los cambios regulatorios y de la industria

La gobernanza de la IA nunca termina. Las leyes y regulaciones evolucionan, los estándares maduran y las capacidades de la IA avanzan más rápido que los ciclos de políticas.

Mantenerse al día con los estándares y las actualizaciones

Las organizaciones se mantienen actualizadas asignando una responsabilidad clara para el monitoreo de los cambios regulatorios y de los estándares. Los programas eficaces crean un pequeño grupo multifuncional que incluye a profesionales del área legal, de cumplimiento, de privacidad, de seguridad y de la IA, en lugar de depender de actualizaciones ad hoc.

El monitoreo funciona mejor con una cadencia fija, como trimestralmente, en lugar de actualizaciones reactivas. Para mantenerse proactivos, los equipos deben evaluar cada cambio preguntando:

- ¿Esto afecta a los sistemas de IA existentes o solo a los nuevos?

- ¿Introduce nueva documentación o expectativas de supervisión?

- ¿Se aplica a nivel mundial o solo en regiones específicas?

Estas comprobaciones de impacto ayudan a los equipos a utilizar y perfeccionar los procesos de gobernanza existentes en lugar de crear controles paralelos.

Prepararse para los futuros requisitos de gobernanza de la IA

Los futuros requisitos de gobernanza de la IA probablemente ampliarán las expectativas en torno a la explicabilidad, la auditabilidad y la documentación. Las organizaciones pueden preparar sus procesos ahora sin esperar mandatos detallados.

Trazabilidad y explicabilidad: Los equipos deben definir qué explicaciones requieren por nivel de riesgo y público, desde revisiones técnicas hasta resúmenes ejecutivos y regulatorios.

Auditabilidad: Es importante mantener registros de las decisiones que muestren para qué fue diseñado un sistema, cómo se evaluó, quién lo aprobó y cómo cambió después de su implementación.

Documentación: La estandarización de su documentación es crucial. Asegúrese de que sus equipos de gobernanza documenten los resúmenes del sistema, las evaluaciones de riesgos, los registros de evaluación y los planes de monitoreo, y que los mantengan continuamente actualizados.

Cómo superar las barreras comunes para la adopción de la gobernanza de la IA

A pesar de sus beneficios, la gobernanza de la IA presenta su propio conjunto de desafíos dentro de las organizaciones. Las barreras comunes incluyen:

Sostenibilidad. Cuando los incentivos de la organización recompensan el lanzamiento de modelos lo más rápido posible, los equipos pueden ver la gobernanza como un obstáculo. Los equipos de datos e IA se centran en implementar modelos rápidamente, mientras que los requisitos de gobernanza aparecen más tarde como ciclos de revisión inesperados o trabajo de documentación.

Propiedad fragmentada. Cuando la responsabilidad por los resultados de la IA se reparte entre varios equipos, las responsabilidades de la gobernanza pueden ser poco claras. Ningún equipo es dueño del resultado, por lo que nadie es dueño de los controles.

Deuda técnica heredada. Los pipelines y modelos más antiguos suelen carecer de los metadatos, la supervisión o la documentación que exige la gobernanza. La adaptación de estos sistemas requiere un esfuerzo que compite con las nuevas prioridades de desarrollo.

Estrategias para aumentar la adopción

Los programas de gobernanza exitosos se centran en la proactividad, no en las reformas reactivas. Debe haber un mensaje coherente por parte de la alta dirección sobre por qué es importante la gobernanza. La comunicación y la formación claras ayudan a los profesionales a comprender cómo encaja la gobernanza en los flujos de trabajo existentes, en lugar de añadir procesos paralelos. Mientras tanto, las iniciativas piloto desempeñan un papel fundamental al demostrar que la gobernanza reduce el retrabajo, evita los incidentes de producción y acelera las aprobaciones una vez que se han establecido los estándares. En conjunto, estas estrategias convierten la gobernanza de un obstáculo percibido en una base práctica para escalar la IA de forma responsable.

Cómo empezar a construir una estrategia de gobernanza de IA

Una gobernanza de IA sólida ayuda a las organizaciones a escalar la adopción de la IA con confianza. Atributos como la propiedad clara, los controles basados en el riesgo y la supervisión continua reducen las sorpresas y mantienen los sistemas alineados con las expectativas comerciales y regulatorias.

Los equipos deben comenzar con una base práctica: hacer un inventario de los casos de uso de IA actuales, clasificarlos por riesgo y asignar propietarios responsables. Poner a prueba los controles de gobernanza en un pequeño conjunto de sistemas de alto impacto para establecer estándares y refinar procesos. A medida que los equipos adquieren experiencia, pueden extender la gobernanza a casos de uso y dominios adicionales, fortaleciendo la supervisión y preservando al mismo tiempo la velocidad y la flexibilidad necesarias para sostener la innovación en IA.

(Esta entrada del blog ha sido traducida utilizando herramientas basadas en inteligencia artificial) Publicación original

No te pierdas ninguna publicación de Databricks.

¿Qué sigue?

IA

7 de enero de 2025/8 min de lectura