Acelerador de soluciones: LLM para la industria manufacturera

Desde la publicación del artículo seminal sobre los transformadores de Vaswani et. al. de Google, los modelos de lenguaje grandes (LLM) han llegado a dominar el campo de la IA generativa. Sin duda, la llegada de ChatGPT de OpenAI ha traído la tan necesaria publicidad y ha provocado el aumento del interés en el uso de los LLM, tanto para uso personal como para satisfacer las necesidades de la empresa. En los últimos meses, Google ha lanzado Bard y Meta sus modelos Llama 2, lo que demuestra la intensa competencia de las grandes empresas de tecnología.

Las industrias de la manufactura y la energía tienen el reto de ofrecer una mayor productividad, lo que se ve agravado por el aumento de los costos operativos. Las empresas que priorizan los datos están invirtiendo en IA y, más recientemente, en los LLM. En esencia, las empresas que priorizan los datos están obteniendo un enorme valor de estas inversiones.

Databricks cree en la democratización de las tecnologías de IA. Creemos que toda empresa debería tener la capacidad de entrenar sus LLM y ser propietaria de sus datos y sus modelos. En las industrias de manufactura y energía, muchos procesos son de propiedad exclusiva y son fundamentales para mantener una ventaja o mejorar los márgenes operativos frente a una fuerte competencia. Las fórmulas secretas se protegen al mantenerlas como secretos comerciales, en lugar de hacerse públicas a través de patentes o publicaciones. Muchos de los LLM disponibles públicamente no cumplen este requisito básico, que exige la cesión de conocimientos.

En cuanto a los casos de uso, la pregunta que suele surgir en esta industria es cómo potenciar a la fuerza laboral actual sin sobrecargarla con más aplicaciones y más datos. Ahí radica el desafío de crear y ofrecer más aplicaciones impulsadas por IA a la fuerza laboral. Sin embargo, con el auge de la IA generativa y los LLM, creemos que estas aplicaciones impulsadas por LLM pueden reducir la dependencia de múltiples aplicaciones y consolidar las capacidades de aumento de conocimiento en menos aplicaciones.

La inteligencia de datos remodela las industrias

Varios casos de uso en la industria podrían beneficiarse de los LLM. Estos incluyen, entre otros:

- Potenciar a los agentes de atención al cliente. Los agentes de atención al cliente quieren poder consultar qué problemas abiertos o sin resolver existen para el cliente en cuestión y proporcionar un guion guiado por IA para ayudarlo.

- Captura y difusión del conocimiento del dominio a través de la capacitación interactiva. La industria está dominada por un profundo conocimiento técnico que a menudo se describe como conocimiento "tribal". Con el envejecimiento de la fuerza laboral, surge el desafío de capturar este conocimiento del dominio de forma permanente. Los LLM podrían actuar como reservorios de conocimiento que luego pueden difundirse fácilmente para la capacitación.

- Aumentar la capacidad de diagnóstico de los ingenieros de servicio de campo. Los ingenieros de servicio de campo a menudo se enfrentan al desafío de acceder a toneladas de documentos que están interrelacionados. Tener un LLM para reducir el tiempo que se tarda en diagnosticar el problema aumentará la eficiencia inadvertidamente.

En este acelerador de soluciones, nos centramos en el punto (3) anterior, que es el caso de uso para apoyar a los ingenieros de servicio de campo con una base de conocimientos en forma de una sesión interactiva de preguntas y respuestas (Q/A) adaptada al contexto. El reto al que se enfrentan los fabricantes es cómo crear e incorporar datos de documentos propios en los LLM. Entrenar LLM desde cero es un ejercicio muy costoso, que cuesta cientos de miles, si no millones, de dólares.

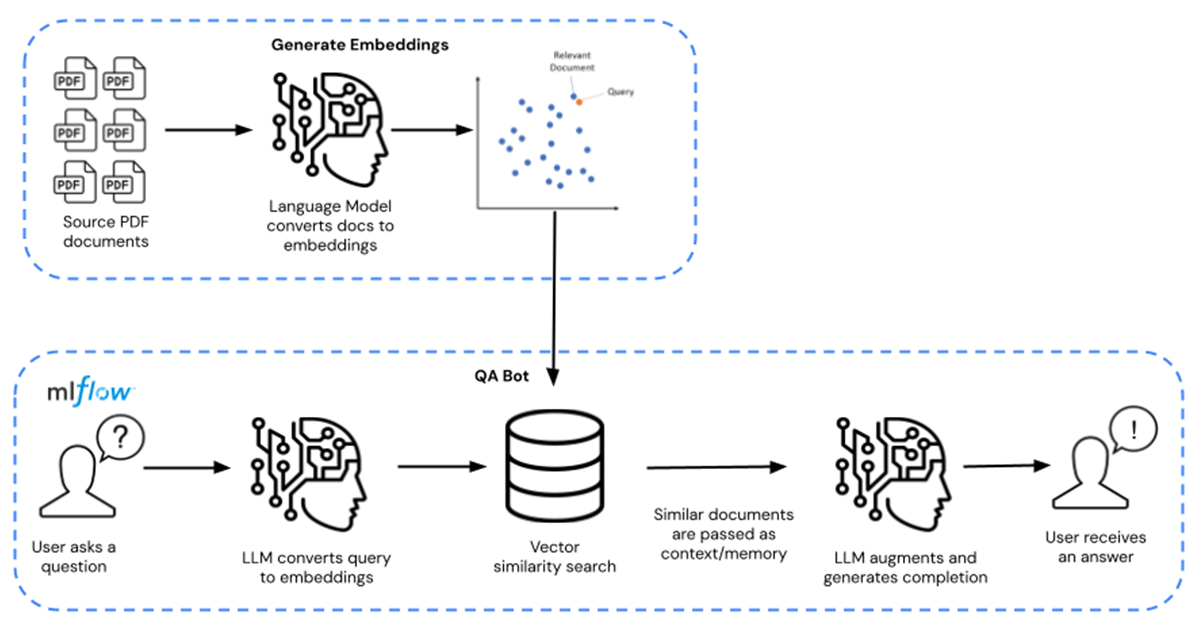

En su lugar, las empresas pueden aprovechar los modelos de LLM fundacionales preentrenados (como MPT-7B y MPT-30B de MosaicML) y aumentar y ajustar con precisión estos modelos con sus datos de propiedad exclusiva. Esto reduce los costos a decenas, si no cientos de dólares, lo que representa un ahorro de 10 000 veces. La ruta completa para el ajuste de precisión se muestra de izquierda a derecha, y la ruta para las consultas de PyR se muestra de derecha a izquierda en la Figura 1 a continuación.

En este acelerador de soluciones, el LLM se aumenta con fichas técnicas químicas distribuidas como documentos PDF de acceso público. Esto se puede reemplazar con cualquier dato propietario de su elección. Las hojas de datos se transforman en embeddings y se utilizan como un recuperador para el modelo. Luego, se utilizó Langchain para compilar el modelo, que después se aloja en Databricks MLflow. El despliegue adopta la forma de un endpoint de Model Serving de Databricks con capacidad de inferencia en GPU.

Potencie su empresa hoy descargando estos activos aquí. Póngase en contacto con su representante de Databricks para comprender mejor por qué Databricks es la plataforma preferida para crear y entregar LLM.

Explore el acelerador de soluciones aquí.

No te pierdas ninguna publicación de Databricks.

¿Qué sigue?

Produção industrial

30 de octubre de 2025/9 min de lectura

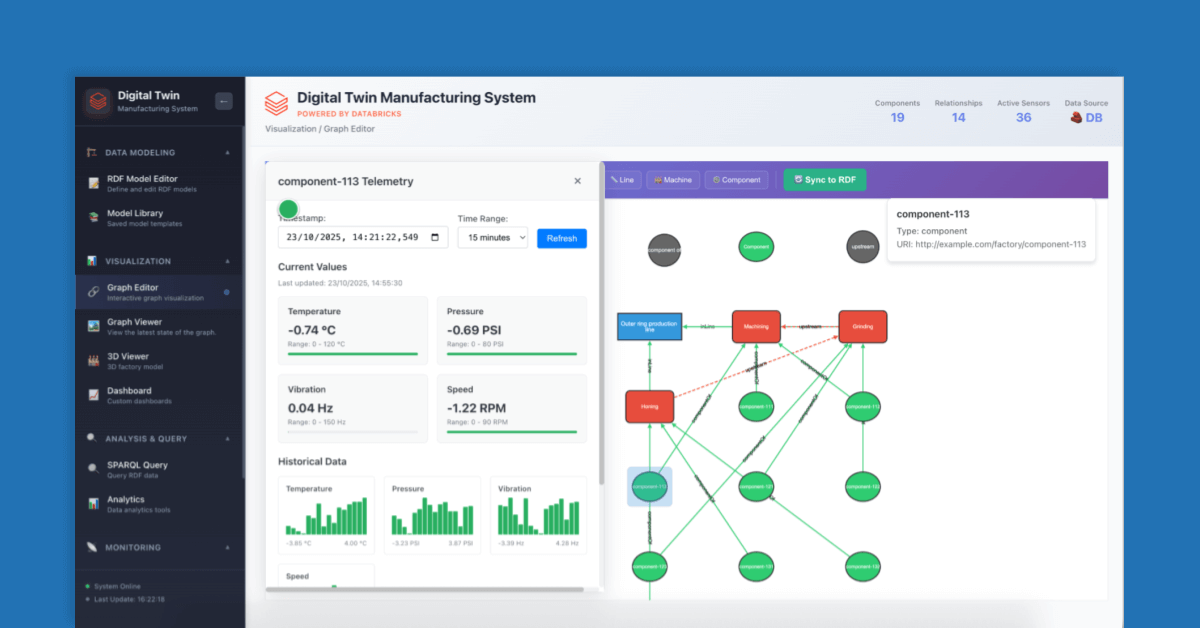

Como construir Gêmeos Digitais para eficiência operacional

Produção industrial

11 de noviembre de 2025/9 min de lectura