Data Lakehouse

¿Qué es un Data Lakehouse?

Un data lakehouse es una nueva arquitectura de gestión de datos abierta que combina la flexibilidad, la rentabilidad y la escalabilidad de los lagos de datos con la gestión de datos y las transacciones ACID de los almacenes de datos, lo que permite aplicar la inteligencia empresarial (BI) y el aprendizaje automático (ML) a todos los datos.

Más temas para descubrir

Data Lakehouse: simplicidad, flexibilidad y bajo costo

Los data lakehouses se habilitan mediante un nuevo diseño de sistema abierto. Implementan estructuras de datos y características de gestión de datos similares a las de un almacén de datos, directamente en el tipo de almacenamiento de bajo costo utilizado para los lagos de datos. Fusionarlos en un solo sistema significa que los equipos de datos pueden moverse más rápido, ya que pueden usar datos sin necesidad de acceder a varios sistemas. Los data lakehouses también garantizan que los equipos dispongan de los datos más completos y actualizados para proyectos de ciencia de datos, aprendizaje automático y análisis de negocio.

Tecnología clave que habilita el data lakehouse

Hay algunos avances tecnológicos clave que hicieron posible el data lakehouse:

- capas de metadatos para lagos de datos

- Diseños de motores de consulta nuevos que ofrecen una ejecución de SQL de alto rendimiento en lagos de datos.

- Acceso optimizado para herramientas de ciencia de datos y aprendizaje automático.

Capas de metadatos, al igual que Delta Lake de código abierto, estas se encuentran en la parte superior de los formatos de archivo abiertos (p. ej: Archivos Parquet). Las capas rastrean qué archivos son parte de diferentes versiones de tablas para ofrecer funciones de administración avanzadas como transacciones compatibles con ACID. Las capas de metadatos admiten otras características comunes en los data lakehouses, como el soporte para la transmisión de E/S (lo que elimina la necesidad de buses de mensajes como Kafka), y permiten el viaje en el tiempo a versiones antiguas de tablas, la aplicación y evolución de esquemas, y la validación de datos. El rendimiento es clave para que los data lakehouses se conviertan en la arquitectura de datos predominante que las empresas utilizan en la actualidad, ya que es una de las principales razones por las que existen los almacenes de datos en la arquitectura de dos niveles. Mientras que los lagos de datos que utilizan almacenes de objetos de bajo costo solían ser lentos para poder acceder a ellos, los nuevos diseños de motores de consulta permiten un análisis SQL de alto rendimiento. Estas optimizaciones incluyen el almacenamiento en caché de datos activos en RAM/SSD (posiblemente transcodificados a formatos más eficientes), optimizaciones de la disposición de los datos para agrupar los datos de acceso compartido, estructuras de datos auxiliares como estadísticas e índices, y ejecución vectorizada en CPU modernas. La combinación de estas tecnologías permite que los data lakehouses logren un rendimiento en grandes conjuntos de datos que rivaliza con los almacenes de datos populares, según los puntos de referencia TPC-DS. Los formatos de datos abiertos utilizados por los data lakehouses (como Parquet), hacen que acceder a los datos en el lakehouse sea muy fácil para los científicos de datos e ingenieros de aprendizaje automático. Pueden usar herramientas populares en el ecosistema de DS/ML como pandas, TensorFlow, PyTorch y otras que ya pueden acceder a fuentes como Parquet y ORC. Spark DataFrames incluso ofrece interfaces declarativas para estos formatos abiertos que permiten una mayor optimización de E/S. Las otras características de un data lakehouse, como el historial de auditoría y el viaje en el tiempo, también ayudan a mejorar la reproducibilidad en el aprendizaje automático. Para obtener más información sobre los avances tecnológicos que sustentan la transición al data lakehouse, consulte el documento CIDR Lakehouse: A New Generation of Open Platforms that Unify Data Warehousing and Advanced Analytics (Lakehouse: Una nueva generación de plataformas abiertas que unifican el almacenamiento de datos y la analítica avanzada) y otro documento académico Delta Lake: High-Performance ACID Table Storage over Cloud Object Stores (Delta Lake: Almacenamiento de tablas ACID de alto rendimiento sobre almacenes de objetos en la nube).

Historia de las arquitecturas de datos

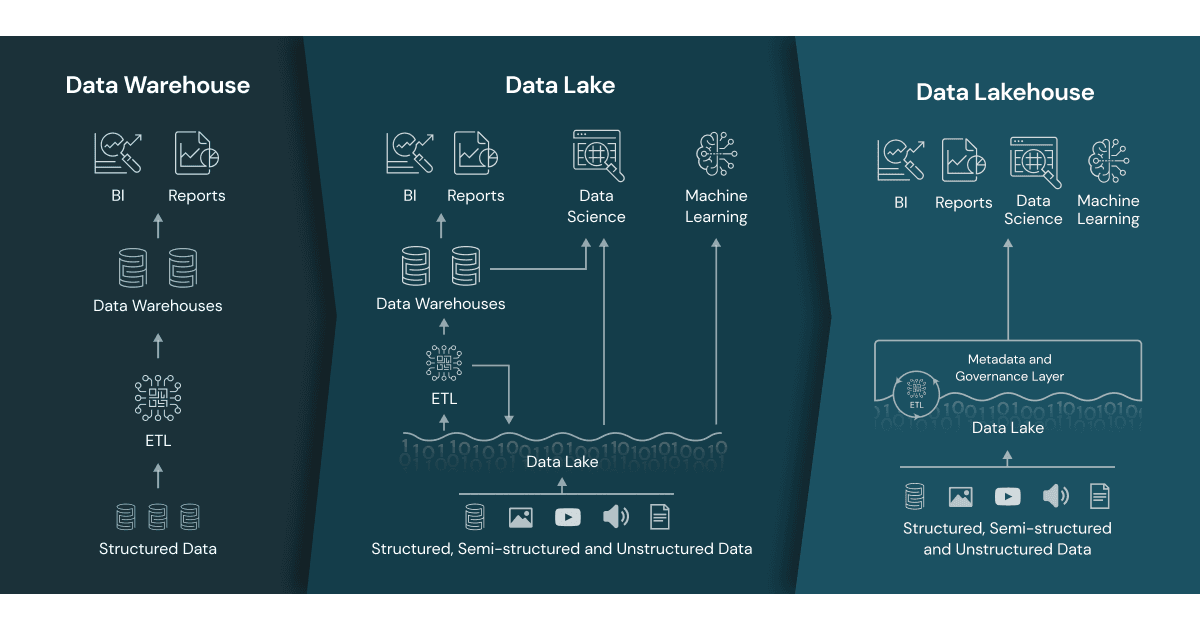

Información general sobre almacenes de datos

Los data warehouses tienen una larga trayectoria en el soporte de decisiones y aplicaciones de inteligencia empresarial, aunque no fueran adecuados o resultaran costosos para manejar datos no estructurados, semiestructurados y datos con gran variedad, velocidad y volumen.

Surgimiento de los lagos de datos

Luego surgieron los lagos de datos para manejar datos sin procesar en una variedad de formatos en almacenamiento económico para la ciencia de datos y el aprendizaje automático, aunque carecían de características críticas del mundo de los almacenes de datos. No admiten transacciones, no garantizan la calidad de los datos y su falta de consistencia y aislamiento hace que sea casi imposible mezclar anexos y lecturas, así como trabajos por lotes y de transmisión.

Arquitectura de datos común de dos niveles

En consecuencia, los equipos de datos integran estos sistemas para habilitar BI y ML en los datos de ambos sistemas, lo que genera datos duplicados, costos adicionales de infraestructura, desafíos de seguridad y costos operativos significativos. En una arquitectura de datos de dos niveles, los datos se extraen, transforman y cargan (ETL) desde las bases de datos operativas hacia un lago de datos. Este lago almacena los datos de toda la empresa en un almacenamiento de objetos de bajo costo y en un formato compatible con herramientas comunes de aprendizaje automático, pero a menudo no está bien organizado ni tiene mantenimiento. A continuación, un pequeño segmento de los datos críticos del negocio se somete nuevamente a ETL para cargarse en el almacén de datos con fines de inteligencia empresarial y análisis de datos. Debido a los distintos pasos de ETL, esta arquitectura de dos niveles requiere un mantenimiento regular y suele generar datos obsoletos, lo que supone una preocupación importante tanto para los analistas de datos como para los científicos de datos, según encuestas recientes de Kaggle y Fivetran. Obtén más información sobre los problemas comunes con la arquitectura de dos niveles.

Recursos adicionales

- ¿Qué es un Lakehouse? - Blog

- Arquitectura de Lakehouse: de la visión a la realidad

- Introducción a Lakehouse y SQL Analytics

- Lakehouse: una nueva generación de plataformas abiertas que unifican el almacenamiento de datos y la analítica avanzada

- Delta Lake: la base de tu Lakehouse

- La plataforma Databricks Lakehouse

- Vidcast de Data Brew: Temporada 1 sobre Data Lakehouses

- El surgimiento del paradigma de Lakehouse

- La plataforma de Data Lakehouse para principiantes