Mosaic AI Agent Framework

Crie aplicativos de geração aumentada de recuperação (RAG) com qualidade de produção

A geração aumentada de recuperação (RAG) é um padrão de aplicação de IA generativa que encontra dados/documentos relevantes para uma pergunta ou tarefa e os fornece como contexto para grandes modelos de linguagem (LLMs) darem respostas mais precisas.

O Mosaic AI Agent Framework é um conjunto de ferramentas projetado para ajudar os desenvolvedores a criar e implantar aplicativos de IA generativa de alta qualidade usando a RAG para obter resultados que são consistentemente medidos e avaliados para serem precisos, seguros e controlados. Com o Mosaic AI Agent Framework, é mais fácil para os desenvolvedores avaliar a qualidade de um aplicativo RAG, iterar rapidamente com a capacidade de testar hipóteses, reimplantar o aplicativo com facilidade e ter a governança e as barreiras apropriadas para garantir a qualidade contínua.

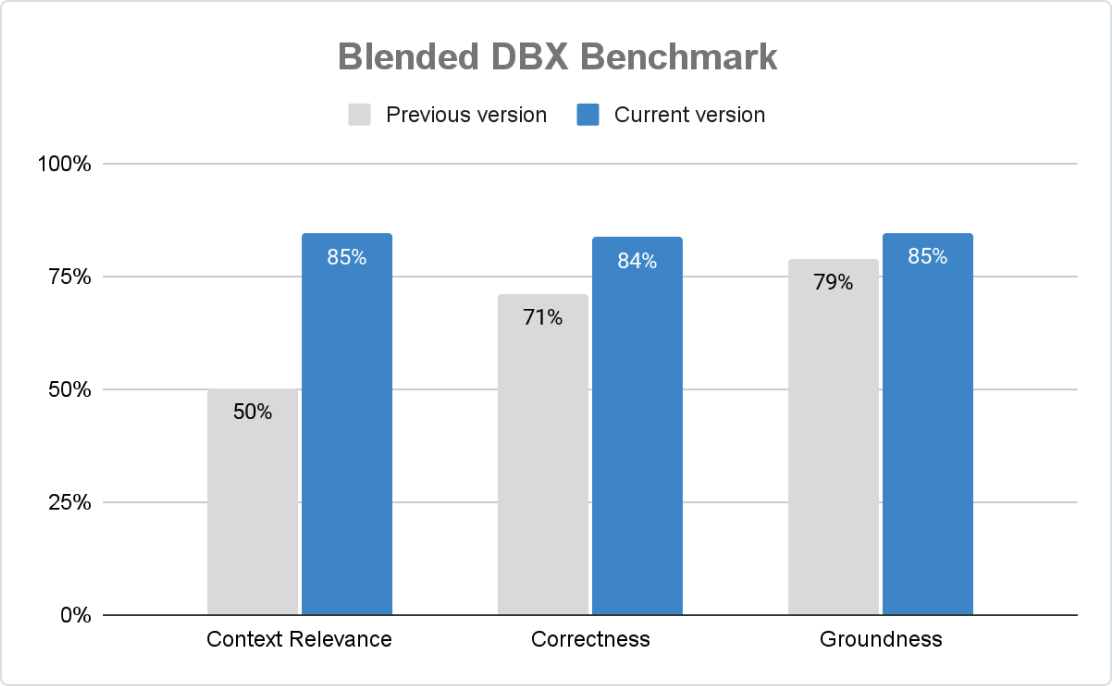

A mais alta qualidade de produção

O Agent Framework oferece aplicativos de GenAI precisos, seguros e governados em escala. Com o Mosaic AI Agent Evaluation, as organizações podem personalizar a pontuação por meio de verificações baseadas em regras, juízes de LLM e feedback humano, enquanto a avaliação orientada por AI integrada e uma interface de usuário intuitiva geram melhorias contínuas.

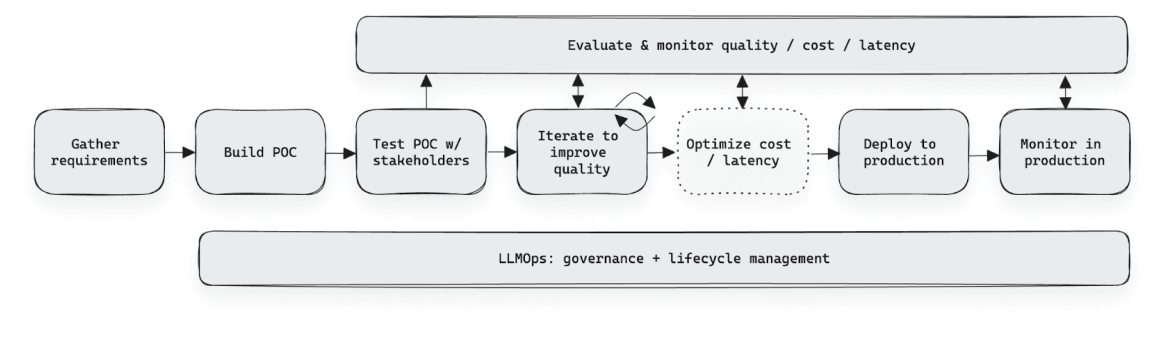

Rápida iteração de desenvolvimento

O Agent Framework acelera o desenvolvimento da GenAI ao simplificar a coleta e a avaliação de feedback. O aplicativo Agent Evaluation Review permite que os especialistas avaliem, rotulem e definam critérios — sem necessidade de planilhas ou ferramentas personalizadas. O feedback estruturado ajuda as equipes a aprimorar o desempenho, aumentar a precisão e fazer reimplementações com facilidade e sem alterar código, garantindo a governança e segurança.

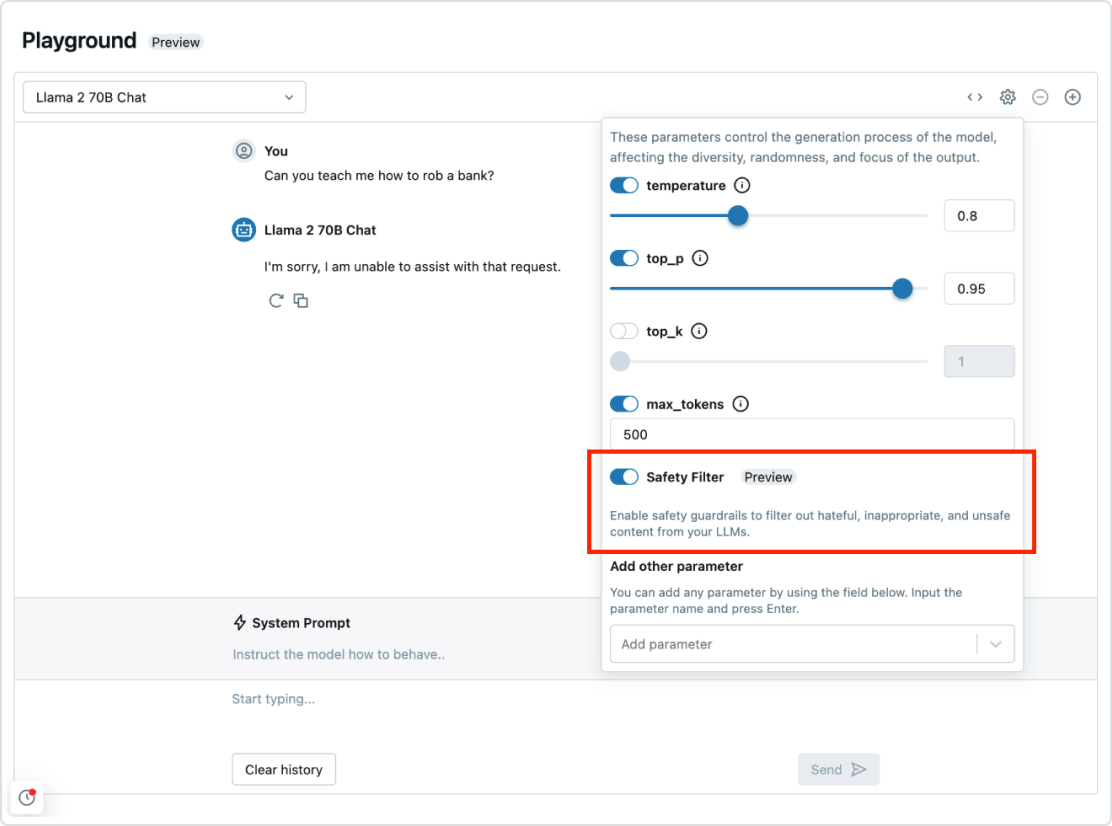

Governança e proteções

O Mosaic AI Agent Framework é perfeitamente integrado ao restante da Databricks Data Intelligence Platform. Isso significa que você tem tudo o que precisa para implantar um sistema RAG de ponta a ponta, de segurança e governança até integração de dados, bancos de dados vetoriais, avaliação de qualidade e implantação otimizada com um clique. Com a governança e as barreiras implementadas, você também pode evitar respostas tóxicas e garantir que seu aplicativo siga as políticas da sua organização.

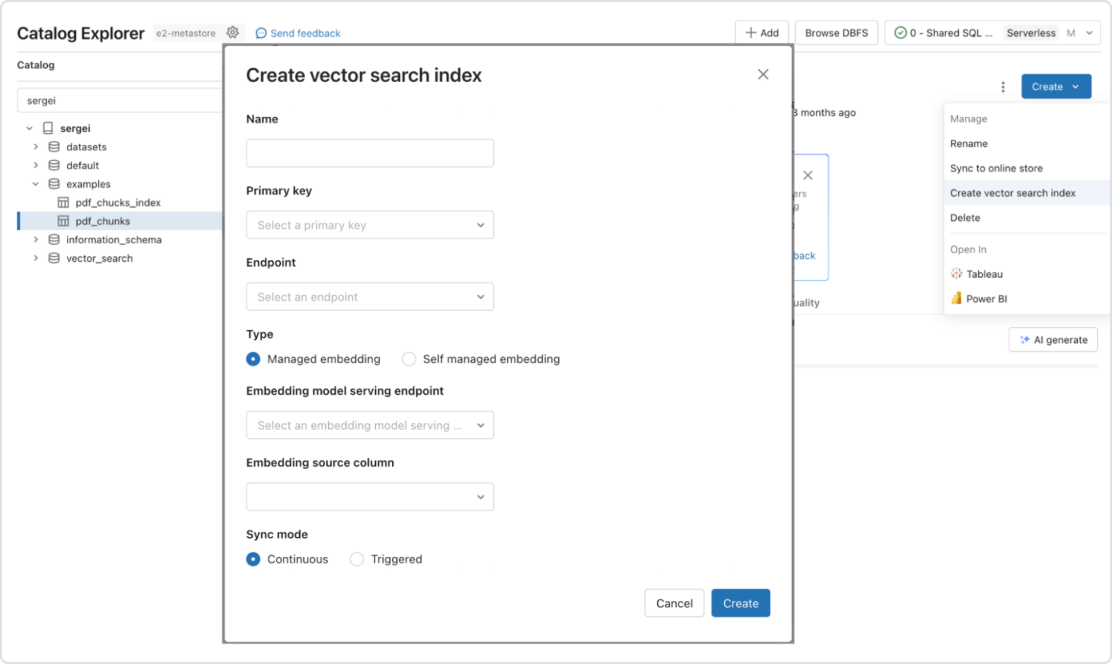

Pipelines automatizados em tempo real para qualquer tipo de dados

O Mosaic AI oferece suporte nativo à exibição e indexação dos seus dados para recuperação online. Para dados não estruturados (texto, imagens e vídeo), o Vector Search indexa e disponibiliza dados automaticamente, tornando-os acessíveis para aplicativos RAG sem a necessidade de criar pipelines de dados separados. Nos bastidores, o Vector Search gerencia falhas, lida com novas tentativas e otimiza os tamanhos de batch para fornecer o melhor desempenho, rendimento e custo. Para dados estruturados, a disponibilização de recursos e funções fornece queries de milissegundos de dados contextuais, como dados do usuário ou da conta, que as empresas muitas vezes desejam injetar em prompts para personalizá-los com base nas informações do usuário.