Anuncio de la disponibilidad general del servicio de modelos de IA de Mosaic

ML de producción simplificado en la plataforma Lakehouse de Databricks

Evento virtual de ML

Nos complace anunciar la disponibilidad general de Databricks Model Serving. Model Serving implementa modelos de machine learning como una API de REST, lo que te permite crear aplicaciones de ML en tiempo real, como recomendaciones personalizadas, chatbots de servicio al cliente, detección de fraudes y más, todo sin la molestia de tener que administrar la infraestructura de servicio.

Con el lanzamiento de Databricks Model Serving, ahora puede implementar sus modelos junto con su infraestructura de datos y entrenamiento existente, lo que simplifica el ciclo de vida de ML y reduce los costos operativos.

"Al realizar el servicio de modelos en la misma plataforma donde residen nuestros datos y donde entrenamos los modelos, hemos podido acelerar las implementaciones y reducir el mantenimiento, lo que en última instancia nos ayuda a cumplir con nuestros clientes e impulsar una vida más agradable y sostenible en todo el mundo".— Daniel Edsgärd, Jefe de Ciencia de Datos, Electrolux

Desafíos en la creación de sistemas de ML en tiempo real

Los sistemas de machine learning en tiempo real están revolucionando la forma en que operan las empresas, ya que brindan la capacidad de hacer predicciones o tomar acciones inmediatas con base en los datos entrantes. Las aplicaciones como los chatbots, la detección de fraudes y los sistemas de personalización se basan en sistemas en tiempo real para proporcionar respuestas instantáneas y precisas, lo que mejora las experiencias del cliente, aumenta los ingresos y reduce el riesgo.

Sin embargo, implementar dichos sistemas sigue siendo un desafío para las empresas. Los sistemas de ML en tiempo real necesitan una infraestructura de servicio rápida y escalable que requiere conocimientos especializados para construir y mantener. La infraestructura no solo debe admitir el servicio, sino también incluir búsquedas de características, monitoreo, implementación automatizada y reentrenamiento de modelos. Esto a menudo resulta en que los equipos integren herramientas dispares, lo que aumenta la complejidad operativa y crea una sobrecarga de mantenimiento. Las empresas a menudo terminan dedicando más tiempo y recursos al mantenimiento de la infraestructura en lugar de integrar el ML en sus procesos.

Gartner®: Databricks, líder en bases de datos en la nube

Servicio de modelos en producción en la Lakehouse

Databricks Model Serving es la primera solución de servicio sin servidor y en tiempo real desarrollada en una plataforma unificada de datos e IA. Esta solución de servicio única acelera el camino de los equipos de ciencia de datos hacia la producción al simplificar las implementaciones y reducir los errores mediante herramientas integradas.

Elimine las sobrecargas de gestión con el servicio de modelos en tiempo real

Databricks Model Serving ofrece un servicio de alta disponibilidad, baja latencia y sin servidor para implementar modelos detrás de una API. Ya no tienes que lidiar con la molestia y la carga de administrar una infraestructura escalable. Nuestro servicio totalmente gestionado se encarga de todo el trabajo pesado por usted, lo que elimina la necesidad de gestionar instancias, mantener la compatibilidad de versiones y aplicar parches a las versiones. Los endpoints se escalan automáticamente para satisfacer los cambios en la demanda, lo que ahorra costos de infraestructura y optimiza el rendimiento de la latencia.

"El rápido escalado automático mantiene los costos bajos mientras nos permite escalar conforme aumenta la demanda de tráfico. Nuestro equipo ahora dedica más tiempo a crear modelos que resuelvan problemas de los clientes en lugar de depurar problemas relacionados con la infraestructura". — Gyuhyeon Sim, CEO de Letsur.ai

Acelere las implementaciones a través del servicio de modelos unificado de Lakehouse.

Model Serving de Databricks acelera las implementaciones de modelos de ML, puesto que proporciona integraciones nativas con varios servicios. Ahora puede gestionar todo el proceso de ML, desde la ingesta y el entrenamiento de datos hasta la implementación y el monitoreo, todo en una única plataforma, lo que crea una vista coherente en todo el ciclo de vida de ML que minimiza los errores y acelera la depuración. Model Serving se integra con varios servicios de Lakehouse, entre ellos:

- Integración con el Feature Store: se integra a la perfección con Databricks Feature Store, lo que proporciona búsquedas en línea automatizadas para evitar el sesgo en línea/fuera de línea. Usted define las características una vez durante el entrenamiento y nosotros recuperaremos y uniremos automáticamente las características relevantes para completar la carga útil de inferencia.

- Integración con MLflow: Se conecta de forma nativa al MLflow Model Registry, lo que permite desplegar modelos de forma rápida y sencilla. Solo tienes que proporcionarnos el modelo y prepararemos automáticamente un contenedor listo para producción y lo desplegaremos en un cómputo sin servidor.

- Calidad y diagnóstico (próximamente): Capture automáticamente solicitudes y respuestas en una tabla Delta para monitorear y depurar modelos o generar conjuntos de datos de entrenamiento.

- Gobernanza unificada: administre y gobierne todos los datos y los activos de ML, incluidos los que consume y produce el servicio de modelos, con Unity Catalog.

"Al servir modelos en una plataforma unificada de datos e IA, pudimos simplificar el ciclo de vida del ML y reducir los gastos generales de mantenimiento. Esto nos permite reorientar nuestros esfuerzos hacia la expansión del uso de la IA en una mayor parte de nuestra empresa". — Vincent Koc, jefe de datos de hipages Group

Capacite a los equipos con la implementación simplificada

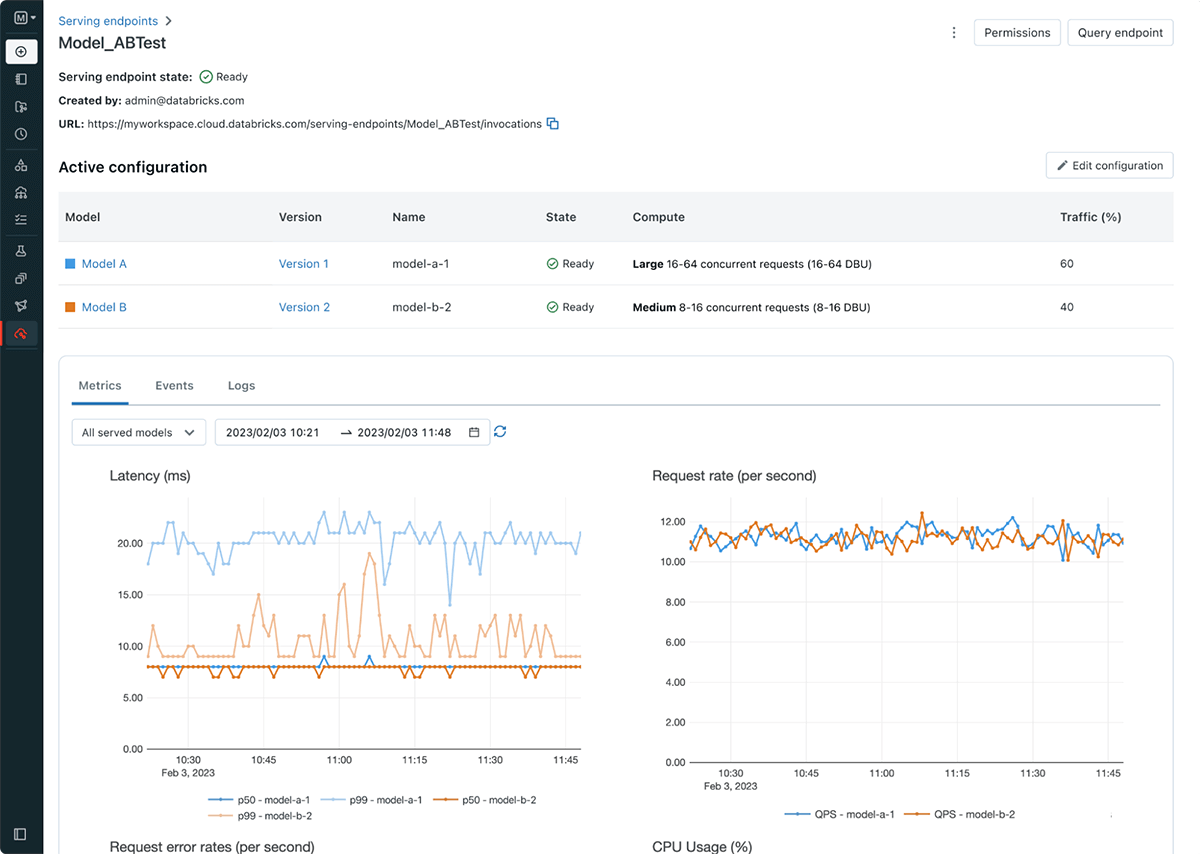

Databricks Model Serving simplifica el flujo de trabajo de implementación de modelos, lo que permite a los científicos de datos implementar modelos sin la necesidad de tener conocimientos o experiencia complejos en infraestructura. Como parte del lanzamiento, también presentamos los endpoints de servicio, que desacoplan el registro de modelos y el URI de puntuación, lo que da como resultado implementaciones más eficientes, estables y flexibles. Por ejemplo, ahora puede implementar varios modelos detrás de un único endpoint y distribuir el tráfico como desee entre los modelos. La nueva interfaz de usuario de servicio y las API facilitan la creación y la gestión de endpoints. Los endpoints también proporcionan métricas y registros integrados que puede utilizar para supervisar y recibir alertas.

Introducción al servicio de modelos de Databricks

- Regístrese en la próxima conferencia para aprender cómo el servicio de modelos de Databricks puede ayudarlo a construir sistemas en tiempo real y obtener información de los clientes.

- ¡Pruébelo! Comience a implementar modelos de ML como una API de REST

- Profundice en la documentaciónde Databricks Model Serving

- Consulte la guía para migrar de Legacy MLflow Model Serving a Databricks Model Serving

No te pierdas ninguna publicación de Databricks.

¿Qué sigue?

Produto

12 de junio de 2024/11 min de lectura