Model Serving

Implementación y gobernanza unificadas para todos los modelos y agentes de IA

Introducción

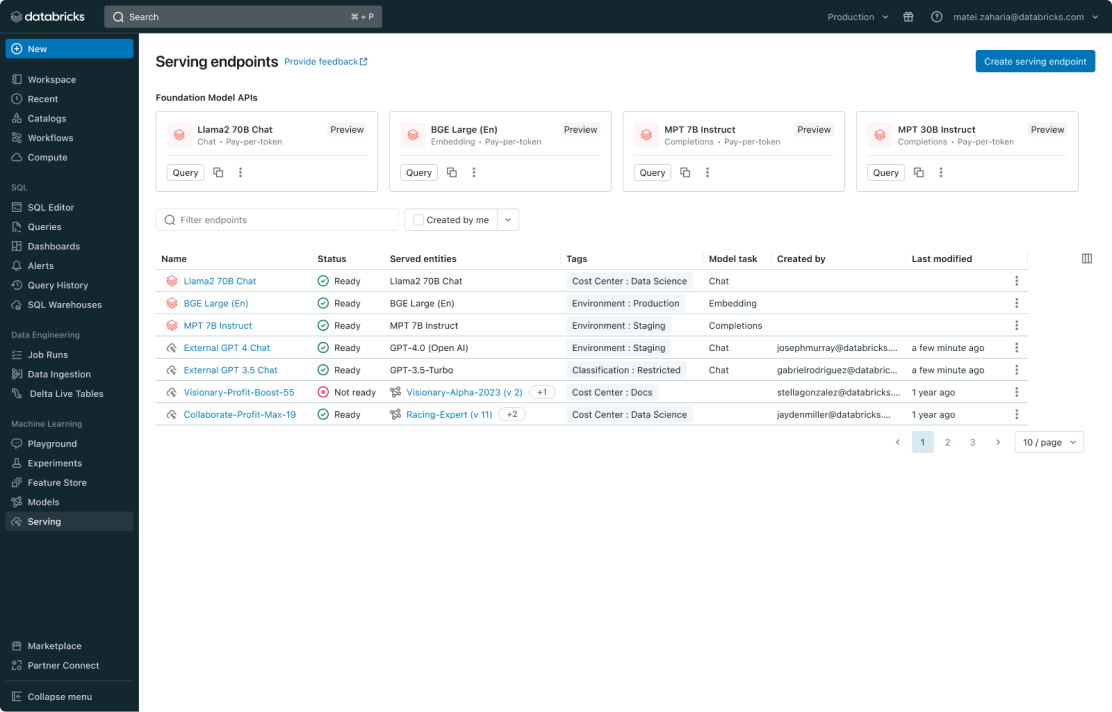

Mosaic AI Model Serving les ofrece a las empresas una solución robusta para implementar formas clásicas de modelos de ML, modelos de IA generativa y agentes de IA. Es compatible con modelos propietarios como Azure OpenAI, AWS Bedrock y Anthropic, así como con modelos de código abierto como Llama y Mistral. Los clientes también pueden servir modelos de código abierto ajustados o modelos clásicos de ML entrenados con sus propios datos. Además, pueden usar fácilmente los modelos servidos como puntos de conexión en sus flujos de trabajo, como inferencia por lotes a gran escala o aplicaciones en tiempo real. Model Serving también viene con funciones integradas de gobernanza, linaje y monitoreo para garantizar resultados de alta calidad.

Testimonios de clientes

Implementación simplificada para todos los modelos y agentes de IA

Implementa cualquier tipo de modelo, desde modelos de código abierto preentrenados hasta modelos personalizados basados en tus propios datos, tanto en CPU como en GPU. La creación automatizada de contenedores y la administración de la infraestructura reducen los costos de mantenimiento y aceleran la implementación para que puedas centrarte en crear tus sistemas de agentes de IA y lograr valor más rápido para tu empresa.

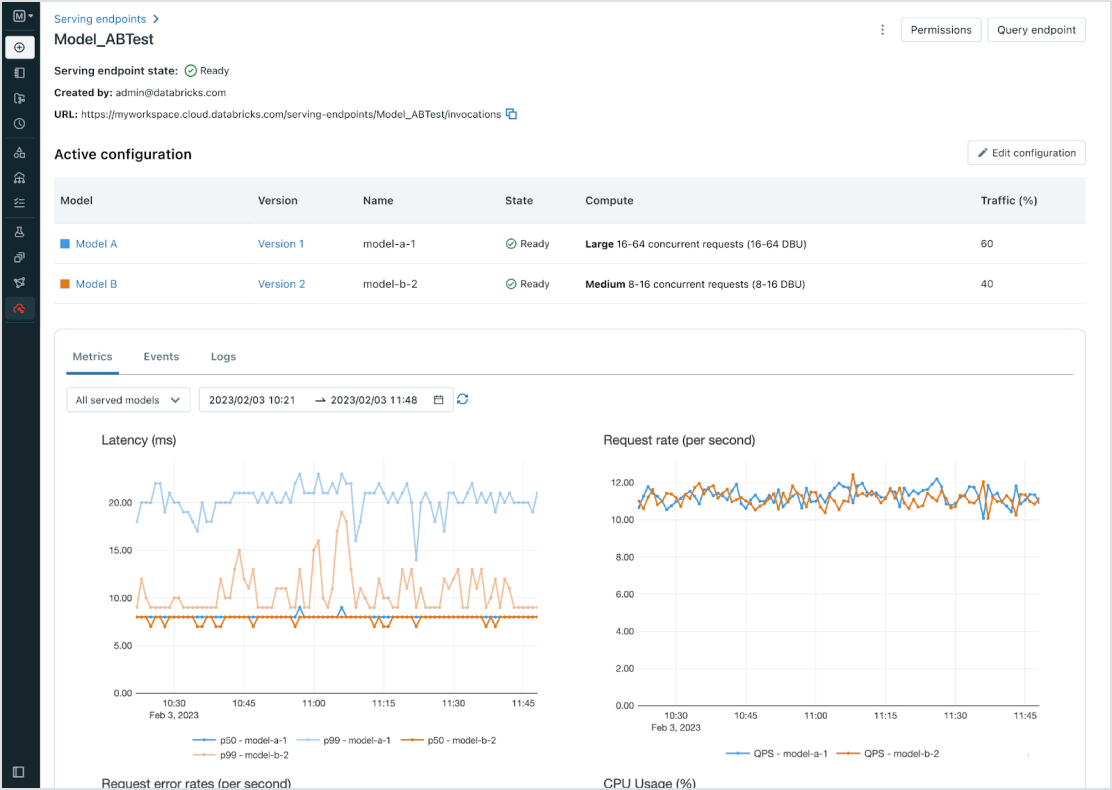

Gestión unificada para todos los modelos

Administra todos los modelos, incluidos los modelos personalizados de ML como PyFunc, scikit-learn y LangChain, los modelos fundacionales (FM) de Databricks como Llama 3, MPT y BGE, y los modelos fundacionales alojados en otros lugares como ChatGPT, Claude 3, Cohere y Stable Diffusion. Model Serving hace que se pueda acceder a todos los modelos en una interfaz de usuario y API unificadas, incluidos los modelos hospedados por Databricks o por otro proveedor de modelos en Azure o AWS.

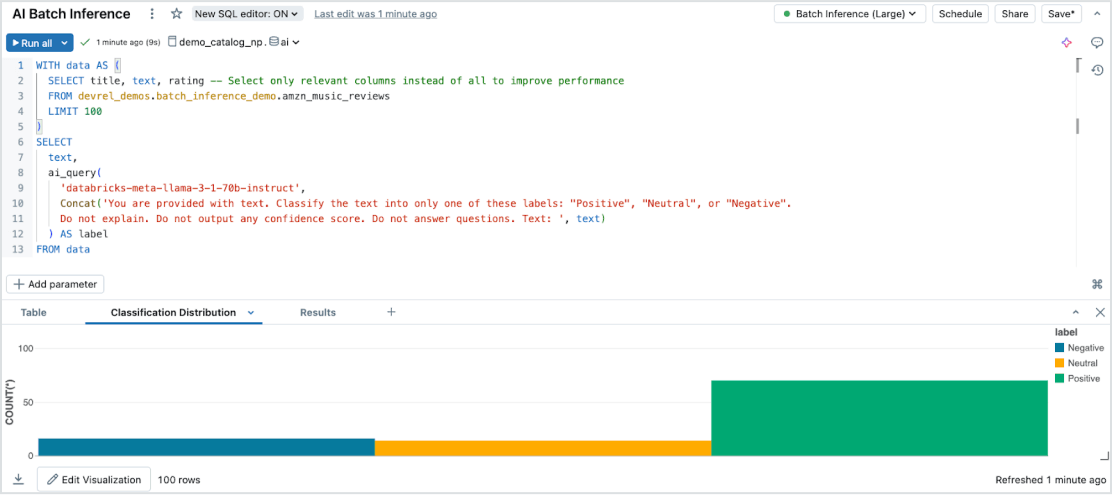

Inferencia por lotes sin esfuerzo

Model Serving permite una inferencia de IA eficiente y sin servidor en grandes conjuntos de datos de todos los tipos y modelos. Intégralo sin problemas con Databricks SQL, Notebooks y Workflows para aplicar la IA a gran escala. Con las funciones de IA, ejecuta la inferencia por lotes a gran escala al instante, sin administración de infraestructura, lo que garantiza velocidad, escalabilidad y control.

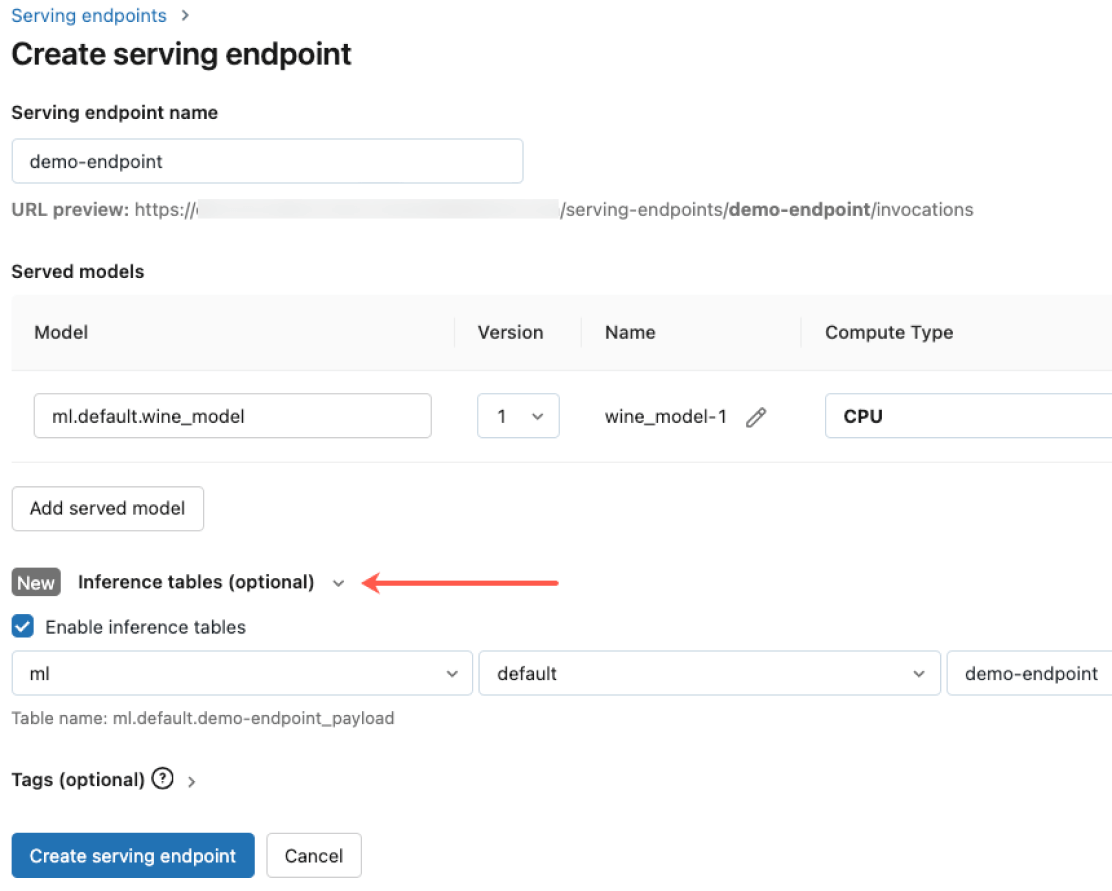

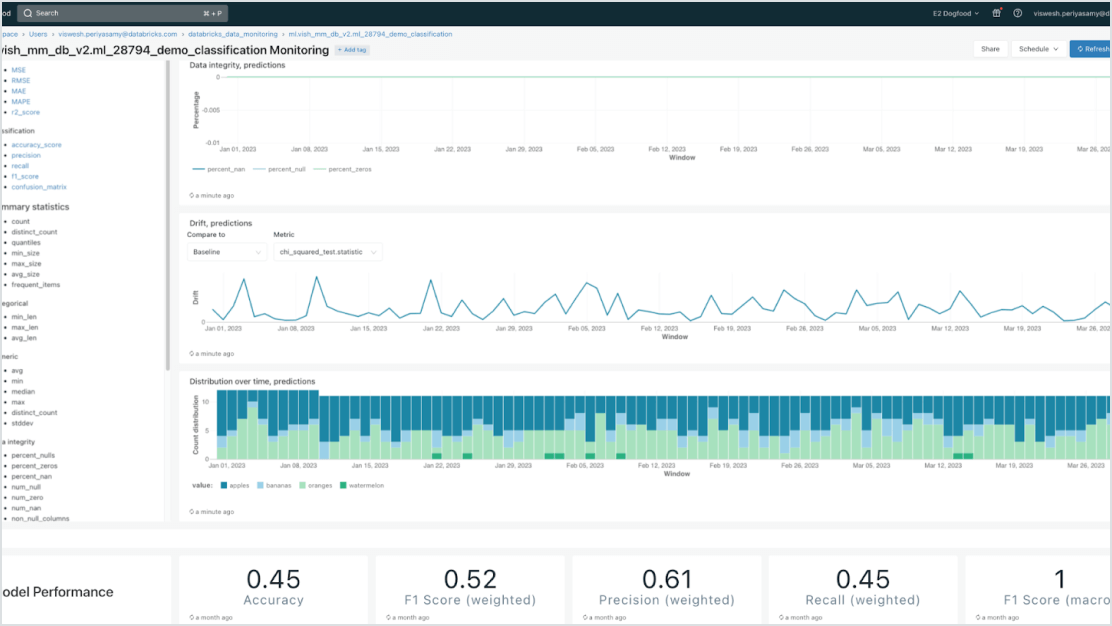

Gobernanza incorporada

Intégralo con Mosaic AI Gateway para cumplir con los estrictos requisitos de seguridad y gobernanza avanzada. Puedes aplicar los permisos adecuados, monitorear la calidad del modelo, establecer límites de volumen y realizar un seguimiento del linaje en todos los modelos, tanto si están alojados en Databricks o en cualquier otro proveedor de modelos.

Modelos centrados en datos

Acelera las implementaciones y reduce los errores a través de una profunda integración con Data Intelligence Platform. Puedes alojar fácilmente varios modelos tradicionales de ML e IA generativa, aumentados (RAG) o ajustados con tus datos empresariales. Model Serving ofrece búsquedas, monitoreo y gobernanza automatizados en todo el ciclo de vida de la IA.

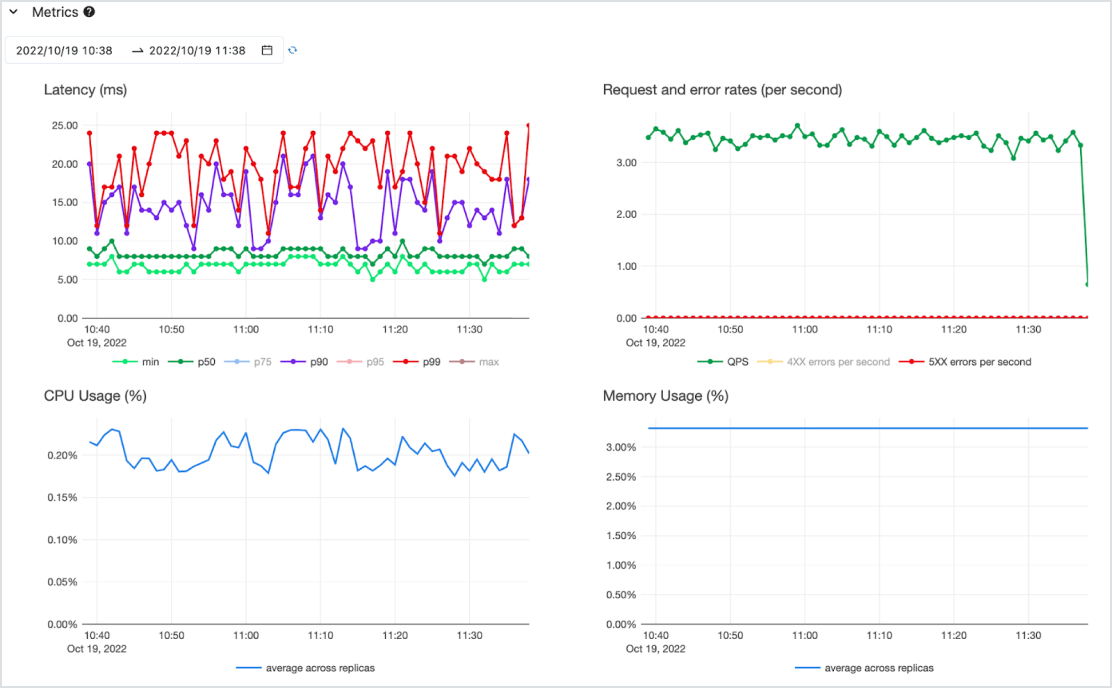

Rentable

Sirve modelos como una API de baja latencia en un servicio sin servidor de alta disponibilidad con soporte para CPU y GPU. Escala sin esfuerzo desde cero para satisfacer tus necesidades más críticas y reduce a medida que cambien los requisitos. Puedes comenzar rápidamente con uno o más modelos preimplementados y pagar por token (bajo demanda, sin compromisos) o pagar por cargas de trabajo de procesamiento aprovisionadas para un rendimiento garantizado. Databricks se encargará de la administración de la infraestructura y los costos de mantenimiento para que tú puedas concentrarte en lograr valor para tu empresa.