Del caos a la escala: creación de plantillas para pipelines declarativos de Spark con DLT-META

Un framework de metadatos para crear pipelines consistentes, automatizados y gobernados a escala

Summary

- El escalamiento de las canalizaciones de datos introduce sobrecarga, desviaciones y una lógica inconsistente entre los equipos.

- Estas brechas ralentizan la entrega, aumentan los costos de mantenimiento y dificultan la aplicación de estándares compartidos.

- Este blog muestra cómo la metaprogramación impulsada por metadatos elimina la duplicación y crea canalizaciones de datos automatizadas y coherentes a escala.

Los pipelines declarativos brindan a los equipos una forma basada en la intención de crear flujos de trabajo por lotes y de streaming. Usted define lo que debe suceder y deja que el sistema gestione la ejecución. Esto reduce el código personalizado y admite patrones de ingeniería repetibles.

A medida que crece el uso de datos en las organizaciones, las canalizaciones se multiplican. Los estándares evolucionan, se agregan nuevas fuentes y más equipos participan en el desarrollo. Incluso las pequeñas actualizaciones de esquemas se propagan a través de docenas de notebooks y configuraciones. La metaprogramación impulsada por metadatos aborda estos problemas trasladando la lógica de la canalización a plantillas estructuradas que se generan en tiempo de ejecución.

Este enfoque mantiene el desarrollo consistente, reduce el mantenimiento y escala con un esfuerzo de ingeniería limitado.

En este blog, aprenderá a crear canalizaciones impulsadas por metadatos para las canalizaciones declarativas de Spark utilizando DLT-META, un proyecto de Databricks Labs, que aplica plantillas de metadatos para automatizar la creación de canalizaciones.

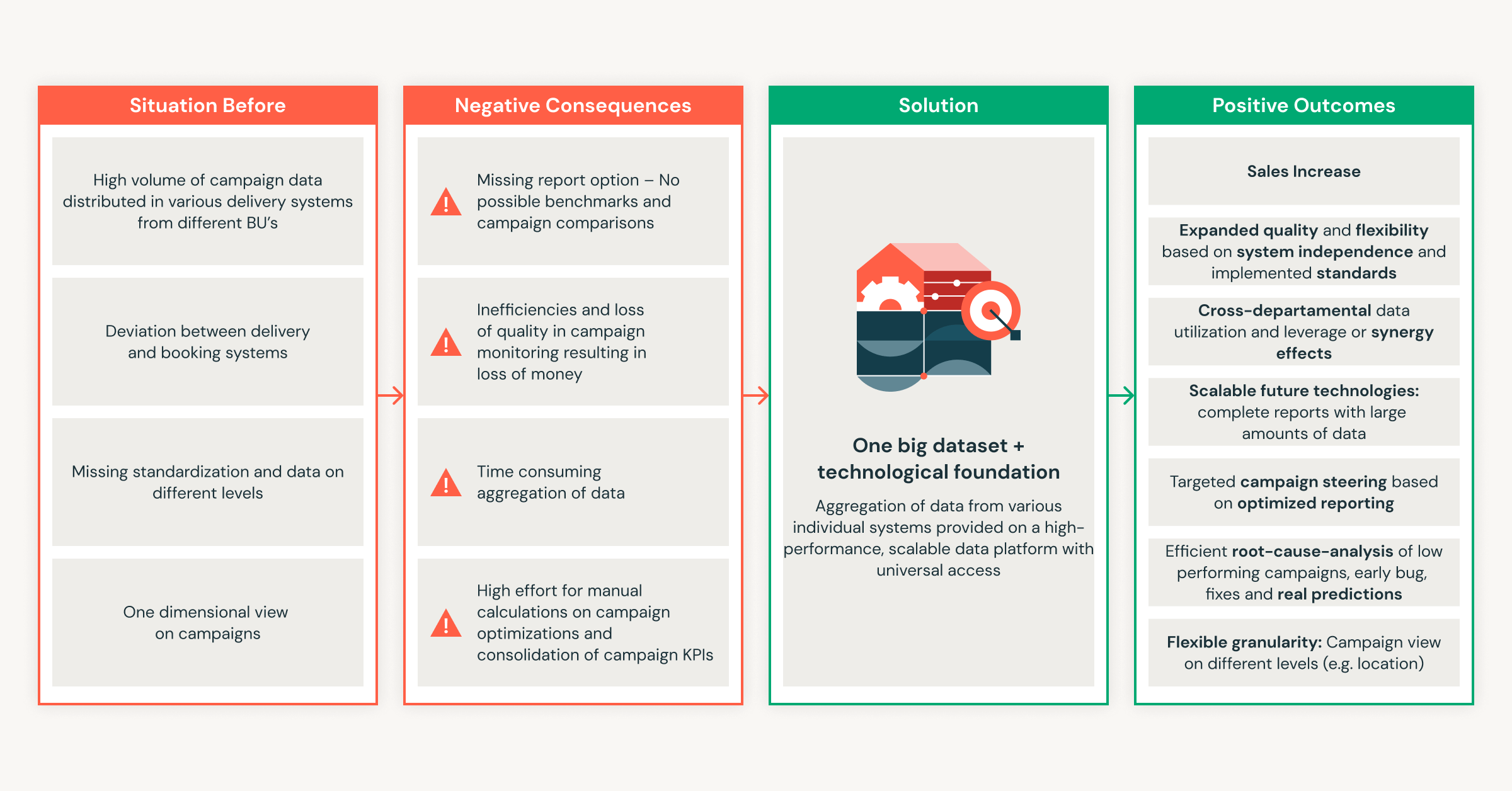

Por muy útiles que sean los pipelines declarativos, el trabajo necesario para darles soporte aumenta rápidamente cuando los equipos agregan más fuentes y amplían el uso en toda la organización.

Por qué las canalizaciones manuales son difíciles de mantener a escala

Los pipelines manuales funcionan a pequeña escala, pero el esfuerzo de mantenimiento crece más rápido que los propios datos. Cada nueva fuente agrega complejidad, lo que conduce a una deriva lógica y a retrabajo. Los equipos terminan parchando los pipelines en lugar de mejorarlos. Los ingenieros de datos enfrentan constantemente estos desafíos de escalamiento:

- Demasiados artefactos por origen: cada conjunto de datos requiere nuevos notebooks, configuraciones y scripts. La sobrecarga operativa crece rápidamente con cada feed incorporado.

- Las actualizaciones de la lógica no se propagan: los cambios en las reglas de negocio no se aplican a los pipelines, lo que da como resultado una desviación de la configuración y resultados inconsistentes en todos los pipelines.

- Calidad y gobernanza inconsistentes: los equipos crean comprobaciones y linajes personalizados, lo que dificulta la aplicación de estándares en toda la organización y hace que los resultados sean muy variables.

- Contribución segura limitada de los equipos de dominio: los analistas y los equipos de negocio quieren agregar datos; sin embargo, la ingeniería de datos todavía revisa o reescribe la lógica, lo que ralentiza la entrega.

- El mantenimiento se multiplica con cada cambio: los pequeños ajustes o las actualizaciones del esquema generan una enorme acumulación de trabajo manual en todos los pipelines dependientes, lo que frena la agilidad de la plataforma.

Estos problemas demuestran por qué es importante un enfoque basado en los metadatos. Reduce el esfuerzo manual y mantiene la coherencia de las canalizaciones a medida que escalan.

Cómo DLT-META aborda la escala y la consistencia

DLT-META resuelve problemas de escala y consistencia de los pipelines. Es un framework de metaprogramación impulsado por metadatos para Spark Declarative Pipelines. Los equipos de datos lo usan para automatizar la creación de pipelines, estandarizar la lógica y escalar el desarrollo con un mínimo de código.

Con la metaprogramación, el comportamiento del pipeline se deriva de la configuración, en lugar de notebooks repetidos. Esto brinda a los equipos beneficios claros.

- Menos código para escribir y mantener

- Incorporación más rápida de nuevas fuentes de datos

- Pipelines listas para producción desde el inicio

- Patrones consistentes en toda la plataforma

- Prácticas recomendadas escalables con equipos reducidos

Los pipelines declarativos de Spark y DLT-META trabajan juntos. Los pipelines declarativos de Spark definen la intención y gestionan la ejecución. DLT-META agrega una capa de configuración que genera y escala la lógica de los pipelines. En conjunto, reemplazan la codificación manual con patrones repetibles que respaldan la gobernanza, la eficiencia y el crecimiento a escala.

Cómo DLT-META aborda las necesidades reales de la ingeniería de datos

1. Configuración centralizada y basada en plantillas

DLT-META centraliza la lógica de los pipelines en plantillas compartidas para eliminar la duplicación y el mantenimiento manual. Los equipos definen reglas de ingesta, transformación, calidad y gobernanza en metadatos compartidos usando JSON o YAML. Cuando se agrega una nueva fuente o cambia una regla, los equipos actualizan la configuración una sola vez. La lógica se propaga automáticamente a través de los pipelines.

2. Escalabilidad instantánea y onboarding más rápido

Las actualizaciones impulsadas por metadatos facilitan el escalamiento de los pipelines y la incorporación de nuevas fuentes. Los equipos agregan fuentes o ajustan las reglas de negocio editando archivos de metadatos. Los cambios se aplican a todas las cargas de trabajo posteriores sin intervención manual. Las nuevas fuentes pasan a producción en minutos en lugar de semanas.

3. Contribución del equipo de dominio con estándares obligatorios

DLT-META permite a los equipos de dominio contribuir de forma segura a través de la configuración. Los analistas y los expertos en el dominio actualizan los metadatos para acelerar la entrega. Los equipos de plataforma e ingeniería mantienen el control sobre la validación, la calidad de los datos, las transformaciones y las reglas de cumplimiento.

4. Coherencia y gobernanza en toda la empresa

Los estándares de toda la organización se aplican automáticamente en todas las canalizaciones y consumidores. La configuración central aplica una lógica coherente para cada nueva fuente. Las reglas integradas de auditoría, linaje y calidad de los datos respaldan los requisitos regulatorios y operativos a escala.

Introducción a ETL

Cómo los equipos usan DLT-META en la práctica

Los clientes usan DLT-META para definir la ingesta y las transformaciones una vez y aplicarlas a través de la configuración. Esto reduce el código personalizado y acelera el onboarding.

Cineplex vio un impacto inmediato.

Usamos DLT-META para minimizar el código personalizado. Los ingenieros ya no escriben los pipelines de manera diferente para tareas simples. Los archivos JSON de incorporación aplican un framework consistente y se encargan del resto.— Aditya Singh, ingeniero de datos de Cineplex

PsiQuantum muestra cómo los equipos pequeños escalan de manera eficiente.

DLT-META nos ayuda a gestionar las cargas de trabajo de bronce y plata con un bajo mantenimiento. Admite grandes volúmenes de datos sin duplicar notebooks ni código fuente.— Arthur Valadares, ingeniero de datos principal, PsiQuantum

En todas las industrias, los equipos aplican el mismo patrón.

- Comercio minorista: centraliza los datos de las tiendas y de la cadena de suministro de cientos de fuentes

- Logística: estandariza la ingesta por lotes y en streaming para datos de IoT y flotas.

- Servicios financieros: garantiza la auditoría y el cumplimiento mientras incorpora las fuentes de datos más rápido.

- Cuidado de la salud mantiene la calidad y la auditabilidad en conjuntos de datos complejos

- Fabricación y telecomunicaciones escalan la ingesta mediante metadatos reutilizables y gobernados de forma centralizada

Este enfoque permite a los equipos aumentar la cantidad de pipelines sin aumentar la complejidad.

Cómo empezar a usar DLT-META en 5 sencillos pasos

No necesita rediseñar su plataforma para probar DLT-META. Empiece de a poco. Utilice unas pocas fuentes. Deje que los metadatos impulsen el resto.

1. Obtener el framework

Comience clonando el repositorio DLT-META. Esto le proporciona las plantillas, los ejemplos y las herramientas necesarias para definir pipelines usando metadatos.

2. Defina sus pipelines con metadatos

A continuación, defina qué deben hacer sus pipelines. Usted lo hace editando un pequeño conjunto de archivos de configuración.

- Use conf/onboarding.json para describir las tablas de entrada sin procesar.

- Use conf/silver_transformations.json para definir las transformaciones.

- Opcionalmente, agregue conf/dq_rules.json si desea aplicar reglas de calidad de datos.

En este punto, está describiendo la intención. No está escribiendo código de canalización.

3. Incorpore los metadatos en la plataforma

Antes de que los pipelines puedan ejecutarse, DLT-META necesita registrar sus metadatos. Este paso de incorporación convierte sus configuraciones en tablas delta de Dataflowspec que los pipelines leen en tiempo de ejecución.

Puede ejecutar la incorporación desde un notebook, un trabajo de Lakeflow o la CLI de DLT-META.

a. Incorporación manual a través de un notebook, p. ej., aquí

Use el notebook de incorporación proporcionado para procesar sus metadatos y aprovisionar los artefactos de su canalización:

b. Automatice el onboarding a través de Lakeflow Jobs con un Python wheel.

El ejemplo a continuación muestra la UI de trabajos de Lakeflow para crear y automatizar una canalización de DLT-META

c. Incorpore mediante los comandos de la CLI de DLT-META que se muestran en el repositorio: aquí.

La CLI de DLT-META le permite incorporar y desplegar en una terminal interactiva de Python.

4. Cree un pipeline genérico

Con los metadatos implementados, usted crea un solo pipeline genérico. Este pipeline lee desde las tablas de Dataflowspec y genera lógica de forma dinámica.

Use pipelines/dlt_meta_pipeline.py como punto de entrada y configúrelo para hacer referencia a sus especificaciones de bronce y plata.

Este pipeline no se modifica a medida que agrega fuentes. Los metadatos controlan el comportamiento.

5. Active y ejecute

Ahora está listo para ejecutar el pipeline. Actívelo como cualquier otro pipeline declarativo de Spark.

DLT-META crea y ejecuta la lógica del pipeline en tiempo de ejecución.

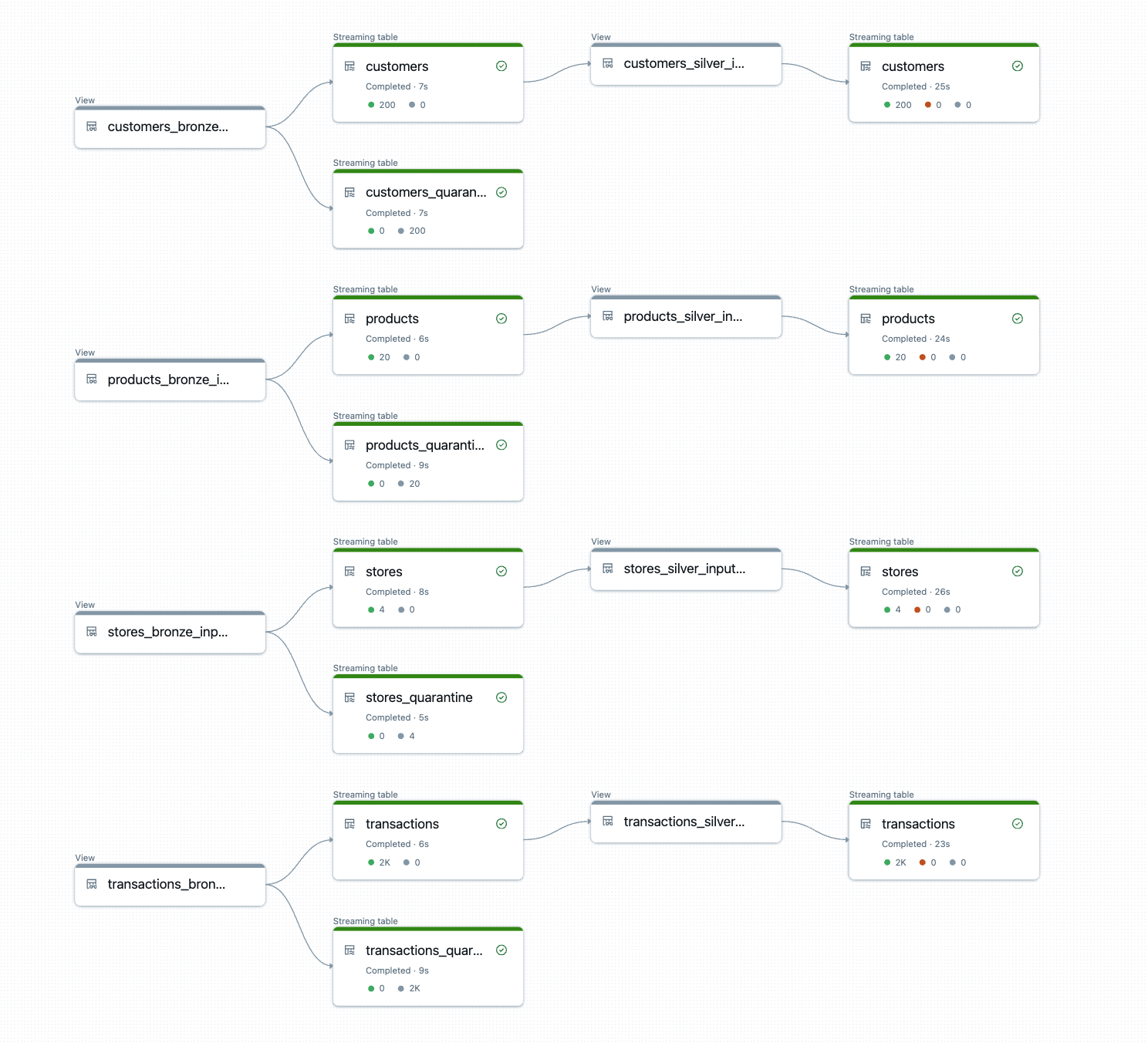

El resultado son tablas bronze y silver listas para producción con transformaciones consistentes, reglas de calidad y linaje aplicados automáticamente.

Pruébelo hoy

Para empezar, recomendamos iniciar una prueba de concepto utilizando sus pipelines declarativos de Spark existentes con unas pocas fuentes, migrando la lógica del pipeline a metadatos y dejando que DLT-META orqueste a escala. Comience con una pequeña prueba de concepto y observe cómo la metaprogramación impulsada por metadatos escala sus capacidades de ingeniería de datos más allá de lo que creía posible.

Recursos de Databricks

- Para empezar: https://github.com/databrickslabs/DLT-META#getting-started

- GitHub: github.com/databrickslabs/DLT-META

- Documentación de GitHub: databrickslabs.github.io/DLT-META

- Documentación de Databricks: https://docs.databricks.com/aws/en/dlt-ref/DLT-META

- Demos: databrickslabs.github.io/DLT-META/demo

- Última versión: https://github.com/databrickslabs/DLT-META/releases

(Esta entrada del blog ha sido traducida utilizando herramientas basadas en inteligencia artificial) Publicación original

No te pierdas ninguna publicación de Databricks.

Sign up

¿Qué sigue?

Soluções

30 de diciembre de 2025/5 min de lectura