Integración de datos de SAP y Salesforce para el análisis de proveedores en Databricks

Usa SAP Business Data Cloud Connect y Lakeflow Connect para unificar los datos de CRM y ERP para el análisis de proveedores.

Summary

- Conecte los datos de SAP S/4HANA y Salesforce directamente en Databricks

- Use Lakeflow Connect y SAP BDC para un acceso incremental y sin copias

- Cree una capa dorada gobernada para el análisis y la información conversacional

Cómo crear análisis de proveedores con la integración de Salesforce y SAP en Databricks

Los datos de los proveedores abarcan casi todas las áreas de una organización, desde las adquisiciones y la gestión de la cadena de suministro hasta las finanzas y el análisis. Sin embargo, a menudo están dispersos en sistemas que no se comunican entre sí. Por ejemplo, Salesforce contiene perfiles de proveedores, contactos y detalles de cuentas, y SAP S/4HANA gestiona facturas, pagos y asientos del libro mayor. Debido a que estos sistemas funcionan de forma independiente, los equipos carecen de una visión integral de las relaciones con los proveedores. El resultado es una lenta conciliación, registros duplicados y oportunidades perdidas para optimizar el gasto.

Databricks resuelve esto conectando ambos sistemas en una única plataforma gobernada de datos e IA. Mediante Lakeflow Connect for Salesforce para la ingesta de datos y SAP Business Data Cloud (BDC) Connect, los equipos pueden unificar los datos de CRM y ERP sin duplicarlos. El resultado es una vista única y fiable de los proveedores, los pagos y las métricas de rendimiento que respalda los casos de uso tanto de adquisiciones como de finanzas, así como la analítica.

En esta guía, aprenderá a conectar ambas fuentes de datos, a construir un pipeline combinado y a crear una capa de oro que potencie la analítica y los conocimientos conversacionales a través de los Dashboards de IA/BI y Genie.

Por qué funciona la integración de datos sin copias de SAP y Salesforce

La mayoría de las empresas intentan conectar SAP y Salesforce a través de herramientas ETL tradicionales o de terceros. Estos métodos crean múltiples copias de los datos, introducen latencia y dificultan la gobernanza. Databricks adopta un enfoque diferente.

Acceso a SAP sin copia: el conector SAP BDC para Databricks le proporciona acceso gobernado y en tiempo real a los productos de datos de SAP S/4HANA a través de Delta Sharing. Sin exportaciones ni duplicaciones.

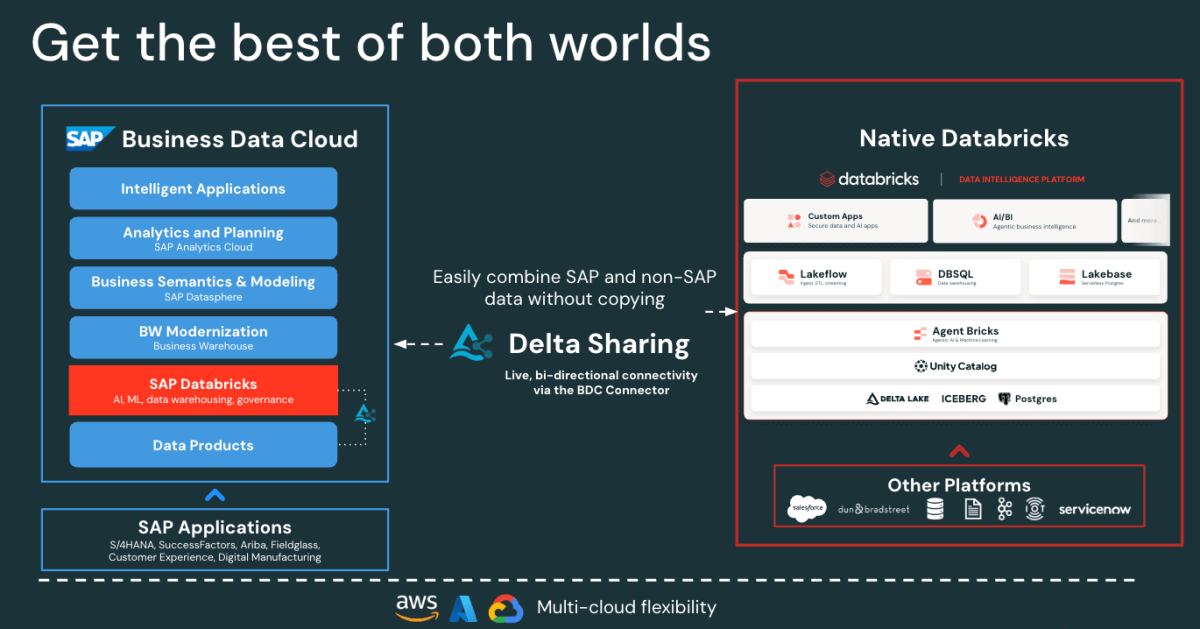

Figure: SAP BDC Connector to Native Databricks(Bi-directional) - Ingesta incremental rápida de Salesforce: Lakeflow se conecta e ingiere los datos de Salesforce de forma continua para mantener sus datasets actualizados y coherentes.

- Gobernanza unificada: Unity Catalog aplica los permisos, el linaje y la auditoría en los orígenes de SAP y Salesforce.

- Canalizaciones declarativas: Lakeflow Spark Declarative Pipelines simplifica el diseño y la orquestación de ETL con optimizaciones automáticas para un mejor rendimiento.

Juntas, estas capacidades permiten a los ingenieros de datos combinar los datos de SAP y Salesforce en una única plataforma, lo que reduce la complejidad y mantiene una gobernanza de nivel empresarial.

Gartner®: Databricks, líder en bases de datos en la nube

Arquitectura de integración de datos de SAP y Salesforce en Databricks

Antes de construir la canalización, es útil comprender cómo estos componentes encajan en Databricks.

A grandes rasgos, SAP S/4HANA publica datos empresariales como productos de datos seleccionados, listos para la empresa y gestionados por SAP en SAP Business Data Cloud (BDC). SAP BDC Connect para Databricks permite un acceso seguro y sin copias a esos productos de datos mediante Delta Sharing. Mientras tanto, Lakeflow Connect gestiona la ingesta de Salesforce, y captura datos de cuentas, contactos y oportunidades a través de canalizaciones incrementales.

Todos los datos entrantes, ya sea de SAP o Salesforce, se gobiernan en Unity Catalog para la gobernanza, el linaje y los permisos. Luego, los ingenieros de datos utilizan Lakeflow Declarative Pipelines para unir y transformar estos datasets en una arquitectura medallion (capas bronce, plata y oro). Finalmente, la capa gold sirve como base para el análisis y la exploración en los dashboards de IA/BI y Genie.

Esta arquitectura garantiza que los datos de ambos sistemas permanezcan sincronizados, gobernados y listos para el análisis y la IA, sin la sobrecarga de la replicación ni de las herramientas de ETL externas.

Cómo crear análisis unificados de proveedores

Los siguientes pasos describen cómo conectar, combinar y analizar datos de SAP y Salesforce en Databricks.

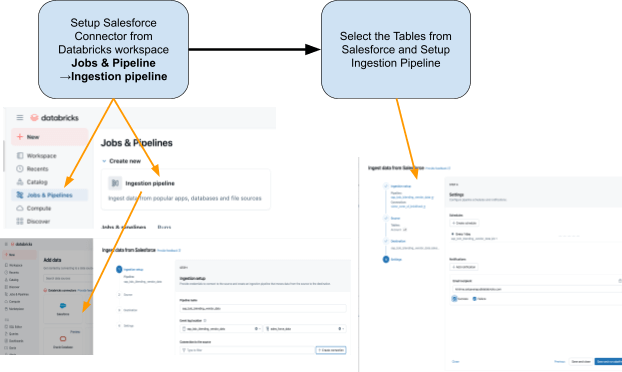

Paso 1: Ingesta de datos de Salesforce con Lakeflow Connect

Usa Lakeflow Connect para importar datos de Salesforce a Databricks. Puedes configurar las canalizaciones a través de la UI o la API. Estas canalizaciones administran las actualizaciones incrementales de forma automática, lo que garantiza que los datos se mantengan actualizados sin necesidad de actualizarlos manualmente.

El conector está totalmente integrado con la gobernanza de Unity Catalog, Lakeflow Spark Declarative Pipelines para ETL y Lakeflow Jobs para la orquestación.

Estas son las tablas que planeamos ingerir desde Salesforce:

- Cuenta: Detalles del proveedor (campos incluidos: AccountId, Name, Industry, Type, BillingAddress)

- Contacto: Contactos del proveedor (campos incluidos: ContactId, AccountId, FirstName, LastName, Email)

Paso 2: Accede a los datos de SAP S/4HANA con el conector SAP BDC.

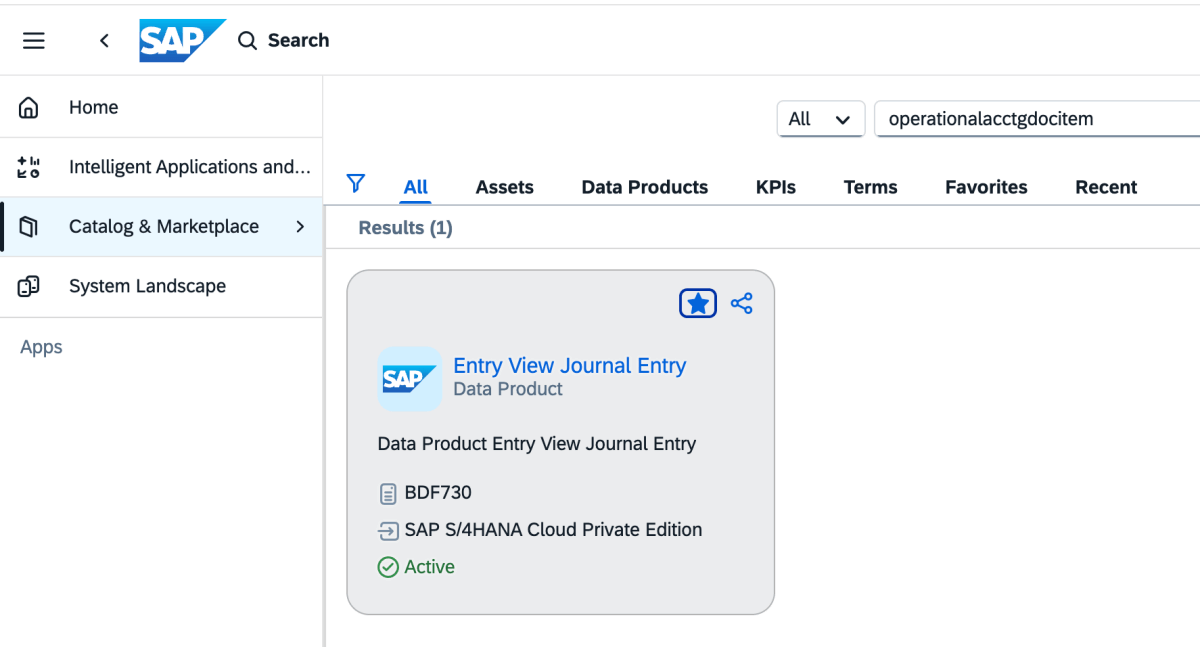

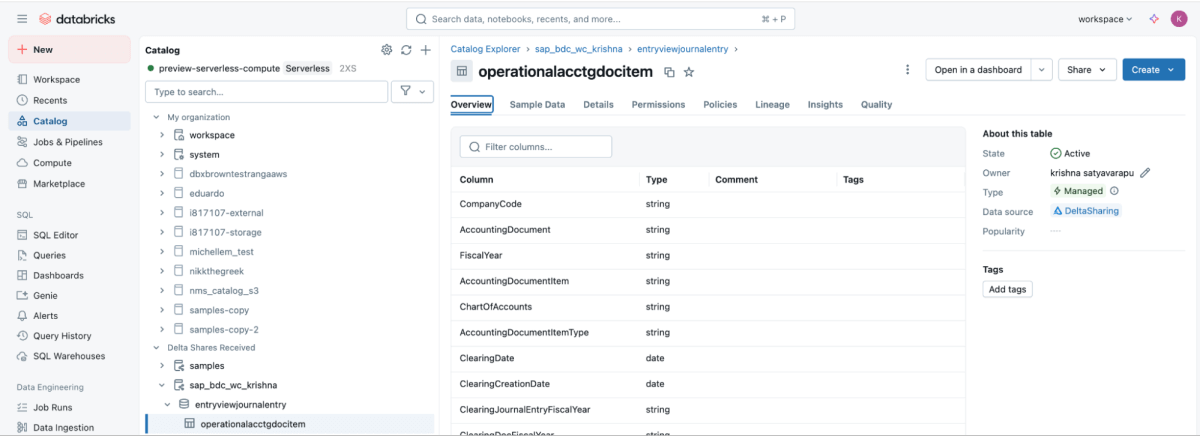

SAP BDC Connect proporciona acceso en vivo y gobernado a los datos de pago a proveedores de SAP S/4HANA directamente a Databricks —lo que elimina el ETL tradicional al aprovechar el producto de datos de SAP BDC sap_bdc_working_capital.entryviewjournalentry.operationalacctgdocitem—, la vista de partida individual del Diario universal.

Este producto de datos de BDC se asigna directamente a la vista CDS de SAP S/4HANA I_JournalEntryItem (elemento de documento contable operativo) en ACDOCA.

En el contexto de ECC, las estructuras físicas más cercanas eran BSEG (partidas individuales de FI) con cabeceras en BKPF, contabilizaciones de CO en COEP, e índices abiertos/compensados BSIK/BSAK (proveedores) y BSID/BSAD (clientes). En SAP S/4HANA, estos objetos BS** forman parte del modelo de datos simplificado, donde las partidas individuales de proveedores y de libro mayor (G/L) se centralizan en el Diario Universal (ACDOCA), lo que reemplaza el enfoque de ECC que a menudo requería unir varias tablas financieras separadas.

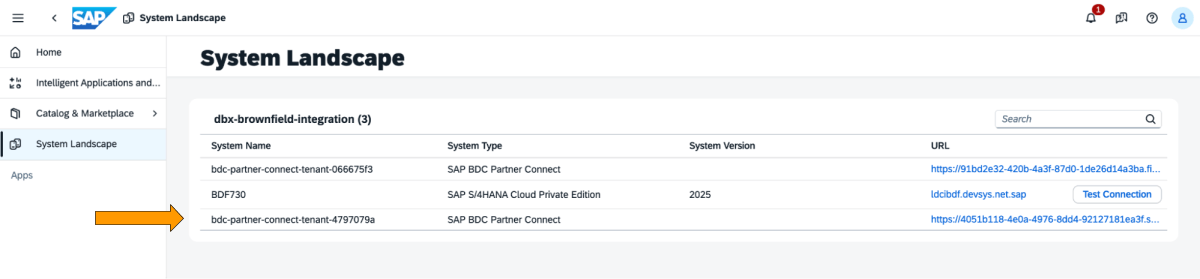

Estos son los pasos que se deben realizar en el cockpit de SAP BDC.

1: Inicie sesión en la cabina de SAP BDC y consulte la formación de SAP BDC en el Panorama de Sistemas. Conéctese a Databricks nativo a través del conector de delta sharing de SAP BDC. Para obtener más información sobre cómo conectar Native Databricks a SAP BDC para que forme parte de su configuración.

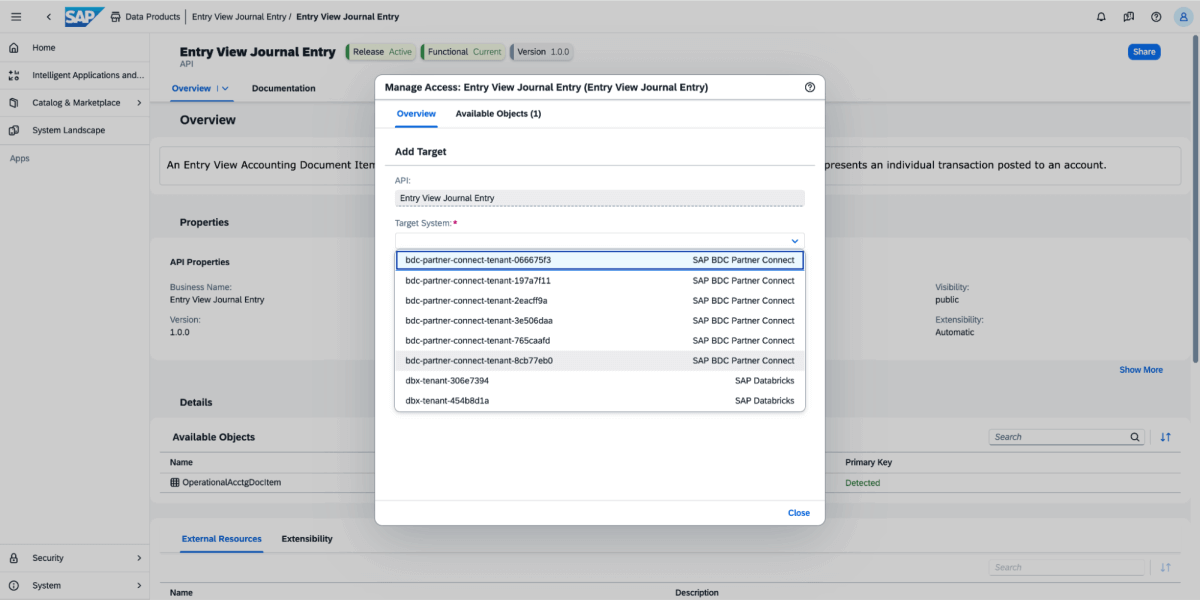

2: Vaya a Catálogo y busque la entrada del producto de datos View Journal Entry, como se muestra a continuación

3: En el producto de datos, seleccione Compartir y, luego, seleccione el sistema de destino, como se muestra en la imagen a continuación.

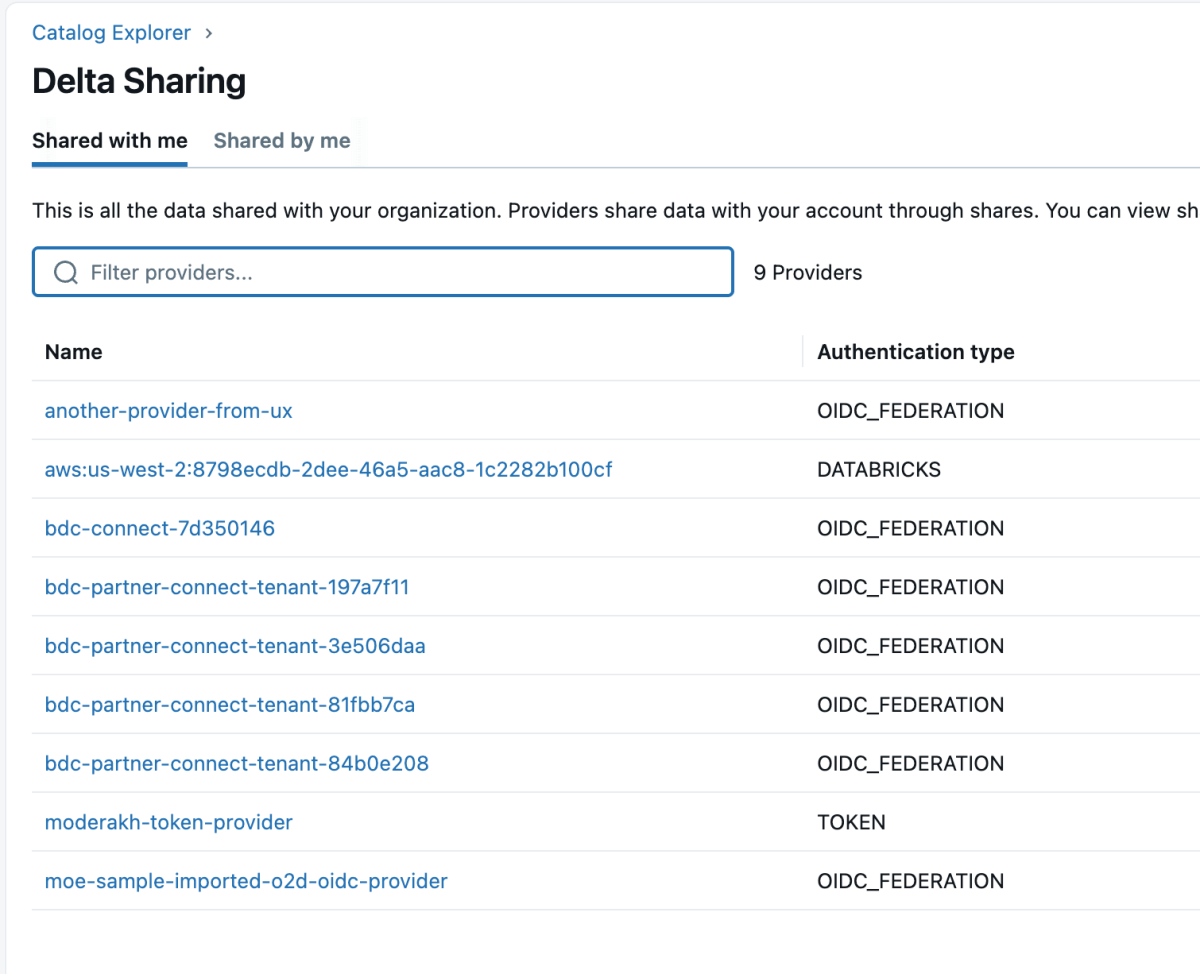

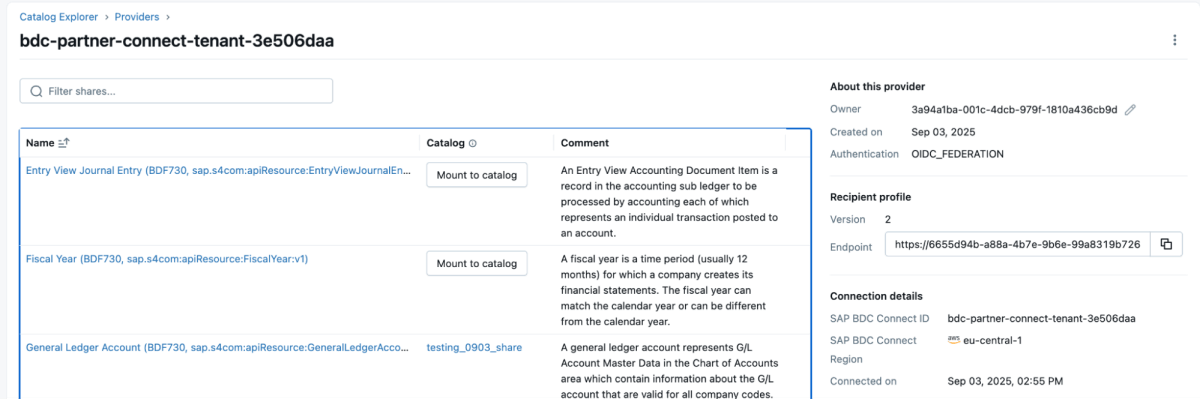

4: Una vez que se comparte el producto de datos, aparecerá como un delta share en el espacio de trabajo de Databricks, como se muestra a continuación. Asegúrese de tener acceso de “Usar proveedor” para poder ver a estos proveedores.

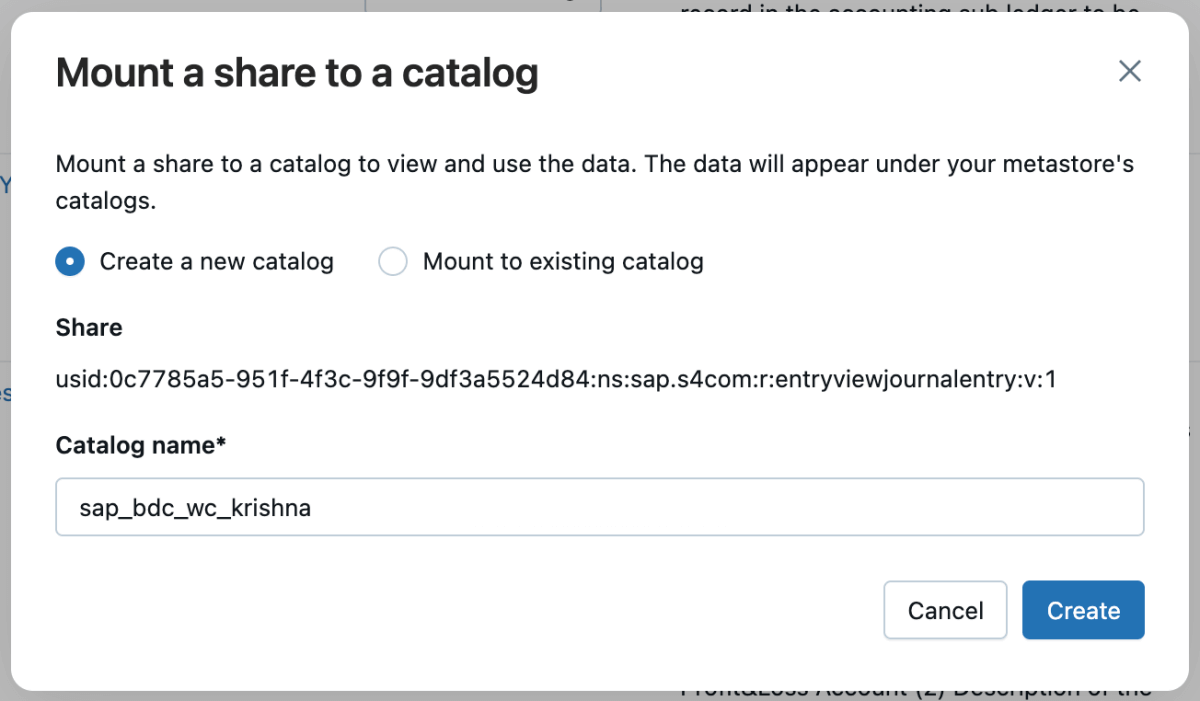

5: Luego, puede montar ese recurso compartido en el catálogo y crear un nuevo catálogo o montarlo en uno existente.

6: Una vez que el recurso compartido esté montado, se reflejará en el catálogo.

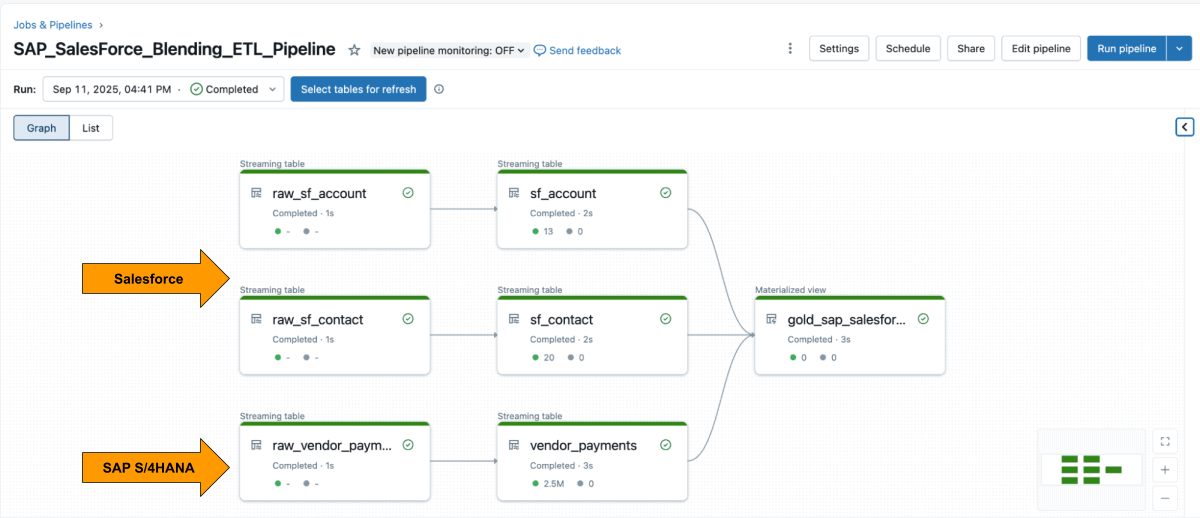

Paso 3: Combinación de la canalización de ETL en Databricks con las canalizaciones declarativas de Lakeflow

Con ambas fuentes disponibles, usa Lakeflow Declarative Pipelines para crear un pipeline de ETL con datos de Salesforce y SAP.

La tabla Account de Salesforce suele incluir el campo SAP_ExternalVendorId__c, que coincide con el ID de proveedor en SAP. Esta se convierte en la clave de unión principal para su capa Silver.

Las canalizaciones declarativas de Lakeflow Spark le permiten definir la lógica de transformación en SQL, mientras que Databricks se encarga de la optimización automáticamente y organiza las canalizaciones.

Ejemplo: Crear tablas seleccionadas de nivel empresarial

Esta consulta crea una vista materializada depurada a nivel empresarial que unifica los registros de pago a proveedores de SAP con los detalles de los proveedores de Salesforce, la cual está lista para el análisis y la generación de informes.

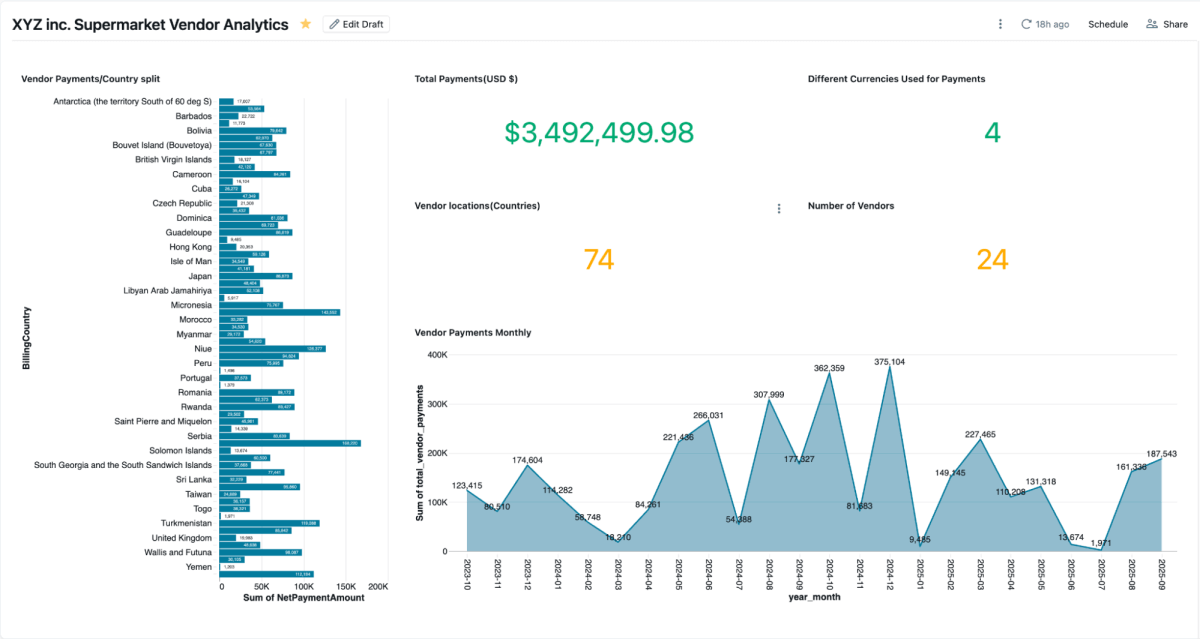

Paso 4: Analizar con tableros de IA/BI y Genie

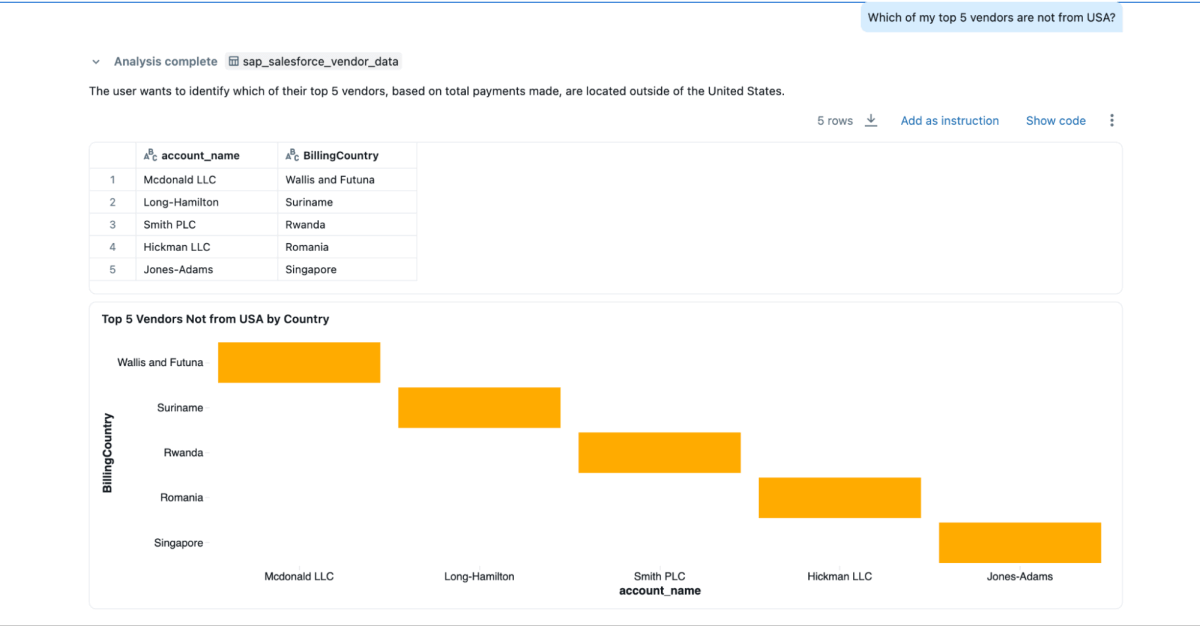

Una vez que se crea la vista materializada, puede explorarla directamente en los AI/BI Dashboards, que permiten a los equipos visualizar los pagos a proveedores, los saldos pendientes y los gastos por región. Admiten el filtrado dinámico, la búsqueda y la colaboración, todo ello regido por Unity Catalog. Genie permite la exploración de los mismos datos en lenguaje natural.

Puede crear espacios de Genie en estos datos combinados y hacer preguntas, lo que no podría hacerse si los datos estuvieran aislados en Salesforce y SAP.

- “¿Quiénes son mis 3 proveedores principales a los que más les pago y también quiero su información de contacto?”

- “¿Cuáles son las direcciones de facturación de los 3 proveedores principales?”

- “¿Cuáles de mis 5 proveedores principales no son de EE. UU.?”

Resultados de negocio

Al combinar los datos de SAP y Salesforce en Databricks, las organizaciones obtienen una vista completa y confiable del rendimiento, los pagos y las relaciones con los proveedores. Este enfoque unificado ofrece beneficios tanto operativos como estratégicos:

- Resolución de disputas más rápida: los equipos pueden ver los detalles de los pagos y la información de contacto de los proveedores de manera conjunta, lo que facilita la investigación y la rápida resolución de los problemas.

- Ahorros por pronto pago: Con las condiciones de pago, las fechas de compensación y los importes netos en un solo lugar, los equipos de finanzas pueden identificar fácilmente oportunidades de descuentos por pronto pago.

- Maestro de proveedores más limpio: La unión en el campo

SAP_ExternalVendorId__cayuda a identificar y resolver registros de proveedores duplicados o no coincidentes, lo que permite mantener datos de proveedores precisos y coherentes en todos los sistemas. - Gobernanza lista para auditorías: Unity Catalog garantiza que todos los datos se gobiernen con un linaje, permisos y auditoría coherentes, para que la analítica, los modelos de IA y los informes se basen en la misma fuente confiable.

En conjunto, estos resultados ayudan a las organizaciones a optimizar la gestión de proveedores y a mejorar la eficiencia financiera, al tiempo que mantienen la gobernanza y la seguridad necesarias para los sistemas empresariales.

Conclusión

Unificar los datos de los proveedores en SAP y Salesforce no tiene por qué significar reconstruir pipelines ni gestionar sistemas duplicados.

Con Databricks, los equipos pueden trabajar desde una base única y gobernada que integra a la perfección datos en tiempo real de ERP y CRM. La combinación de acceso SAP BDC sin copia, ingesta incremental de Salesforce, gobernanza unificada y canalizaciones declarativas reemplaza la sobrecarga de la integración por perspectivas.

El resultado va más allá de la generación de informes más rápida. Ofrece una vista conectada del rendimiento de los proveedores que mejora las decisiones de compra, fortalece las relaciones con los proveedores y permite obtener ahorros medibles. Y como está desarrollado sobre la Databricks Data Intelligence Platform, los mismos datos de SAP que alimentan los pagos y las facturas también pueden impulsar dashboards, modelos de IA y análisis conversacionales, todo desde una única fuente de confianza.

Los datos de SAP suelen ser la columna vertebral de las operaciones empresariales. Al integrar SAP Business Data Cloud, Delta Sharing y Unity Catalog, las organizaciones pueden ampliar esta arquitectura más allá del análisis de proveedores, hacia la optimización del capital de trabajo, la gestión de inventarios y la previsión de la demanda.

Este enfoque convierte los datos de SAP de un sistema de registro en un sistema de inteligencia, donde cada conjunto de datos está en vivo, gobernado y listo para su uso en toda la empresa.

(Esta entrada del blog ha sido traducida utilizando herramientas basadas en inteligencia artificial) Publicación original