Databricks 모델 서빙 정식 출시 발표

Databricks Lakehouse Platform에서 간소화된 프로덕션 ML

발행일: 2023년 3월 7일

작성자: Patrick Wendell, 아론 데이비슨, Sue Ann Hong, Kasey Uhlenhuth, 아흐메드 빌랄 , 조시 하트만

Databricks 모델 서빙의 정식 출시를 발표하게 되어 매우 기쁩니다. Model Serving은 머신 러닝 모델을 REST API로 배포하여 서빙 인프라를 관리하는 번거로움 없이 개인화된 추천, 고객 서비스 챗봇, 사기 탐지 등과 같은 실시간 ML 애플리케이션을 빌드할 수 있도록 지원합니다.

Databricks 모델 서빙 출시를 통해 이제 기존 데이터 및 학습 인프라와 함께 모델을 배포하여 ML 수명 주기를 단순화하고 운영 비용을 절감할 수 있습니다.

"데이터가 저장되고 모델을 훈련하는 동일한 플랫폼에서 모델 서빙을 수행함으로써 배포를 가속화하고 유지보수를 줄일 수 있었으며, 이는 궁극적으로 고객에게 더 나은 가치를 제공하고 전 세계적으로 더 즐겁고 지속 가능한 삶을 실현하는 데 도움이 됩니다."— Daniel Edsgärd, Electrolux 데이터 사이언스 부문 책임자

실시간 ML 시스템 구축의 과제

실시간 machine learning 시스템은 수신 데이터를 기반으로 즉각적인 예측이나 조치를 취할 수 있는 기능을 제공하여 비즈니스 운영 방식을 혁신하고 있습니다. 챗봇, 사기 탐지, �개인화 시스템과 같은 애플리케이션은 실시간 시스템을 통해 즉각적이고 정확한 응답을 제공함으로써 고객 경험을 개선하고 수익을 증대시키며 리스크를 줄입니다.

그러나 이러한 시스템을 구현하는 것은 기업에게 여전히 어려운 과제입니다. 실시간 ML 시스템에는 구축 및 유지 관리에 전문 지식이 필요한 빠르고 확장 가능한 서빙 인프라가 필요합니다. 인프라는 서빙을 지원할 뿐만 아니라 특성 조회, 모니터링, 자동 배포, 모델 재학습도 포함해야 합니다. 이로 인해 팀은 서로 다른 도구를 통합하게 되는 경우가 많으며, 이는 운영 복잡성을 높이고 유지보수 오버헤드를 발생시킵니다. 기업은 프로세스에 ML을 통합하는 대신 인프라 유지보수에 더 많은 시간과 리소스를 소비하는 경우가 많습니다.

Gartner®: Databricks 클라우드 데이터베이스 리더

Lakehouse의 프로덕션 Model Serving

Databricks Model Serving은 통합 데이터 및 AI 플랫폼에서 개발된 최초의 서버리스 실시간 서빙 솔루션입니다. 이 독창적인 서빙 솔루션은 통합 도구를 통해 배포를 간소화하고 실수를 �줄여 데이터 과학팀이 프로덕션으로 나아가는 길을 앞당겨 줍니다.

실시간 모델 서빙으로 관리 오버헤드 제거

Databricks Model Serving은 API를 통해 모델을 배포하기 위한 고가용성의 짧은 지연 시간을 지원하는 서버리스 서비스를 제공합니다. 더 이상 확장 가능한 인프라를 관리하는 번거로움과 부담을 감당할 필요가 없습니다. 당사의 완전 관리형 서비스가 모든 어려운 작업을 대신 처리하여 인스턴스 관리, 버전 호환성 유지, 버전 패치 등의 필요성을 없애줍니다. 엔드포인트는 수요 변화에 맞춰 자동으로 확장 또는 축소되어 인프라 비용을 절감하면서 지연 시간 성능을 최적화합니다.

"빠른 자동 확장(오토스케일링)을 통해 적은 비용으로 트래픽 수요 증가에 맞게 확장할 수 있습니다. 우리 팀은 이제 인프라 관련 문제를 디버깅하는 대신 고객 문제를 해결하는 모델을 구축하는 데 더 많은 시간을 할애하고 있습니다." — 심규현, Letsur.AI 대표이사

레이크하우스-Unified Model Serving을 통한 배포 가속화

Databricks 모델 서빙은 다양한 서비스와의 기본 통합을 제공하여 ML 모델 배포를 가속화합니다. 이제 단일 플랫폼에서 데이터 수집 및 훈련부터 배포, 모니터링까지 전체 ML 프로세스를 관리할 수 있습니다. 이를 통해 ML 수명 주기 전반에 걸쳐 일관된 뷰를 확보하여 오류를 최소화하고 디버깅 속도를 높일 수 있습니다. 모델 서빙은 다음을 포함한 다양한 Lakehouse 서비스와 통합됩니다.

- 특징점 통합: Databricks 특징점과 원활하게 통합되어 자동화된 온라인 조회를 제공함으로써 온라인/오프라인 편향을 방지합니다. 사용자가 학습 중에 특징점을 한 번 정의하면 관련 특징점을 자동으로 검색하고 결합하여 추론 페이로드를 완성합니다.

- MLflow 통합: MLflow Model Registry에 기본적으로 연결하여 모델을 빠르고 쉽게 배포할 수 있습니다. 모델만 제공하면 프로덕션용 컨테이너가 자동으로 준비되어 serverless compute에 배포됩니다.

- 품질 & 진단(출시 예정): Delta 테이블에 요청과 응답을 자동으로 캡처하여 모델을 모니터링 및 디버깅하거나 학습 데이터 세트를 생성합니다.

- 통합 거버넌스: Unity Catalog를 사용하여 모델 서빙에서 사용하고 생성하는 자산을 포함한 모든 데이터와 ML 자산을 관리하고 거버넌스합니다.

"통합 데이터 및 AI 플랫폼에서 모델을 함으로써 ML 수명 주기를 간소화하고 유지 관리 오버헤드를 줄일 수 있었습니다. 이를 통해 AI의 활용 범위를 확대하는 데 노력을 집중할 수 있습니다." — Vincent Koc, Hipages Group 데이터 책임자

간소화된 배포로 팀 역량 강화

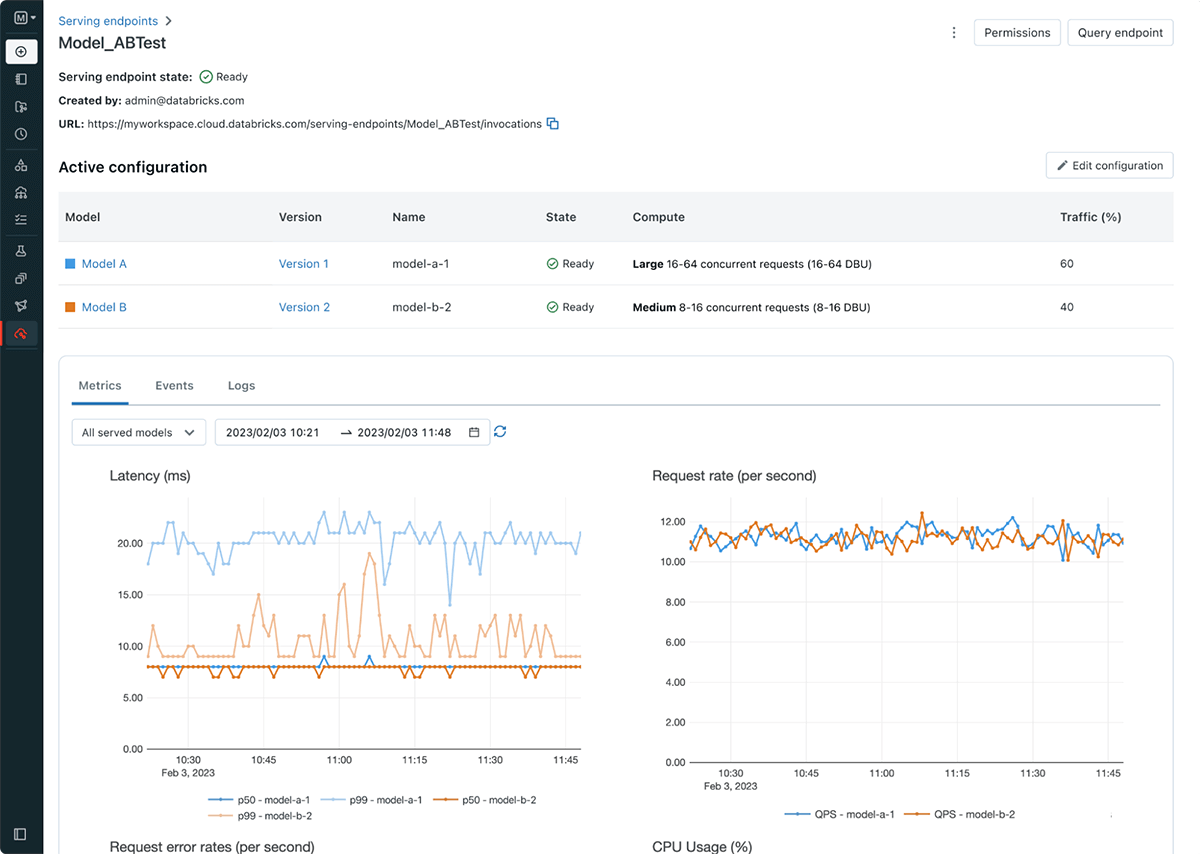

Databricks Model Serving은 모델 배포 워크플로를 간소화하여 데이터 사이언티스트가 복잡한 인프라 지식이나 경험 없이도 모델을 배포할 수 있도록 지원합니다. 이번 출시의 일환으로, 모델 레지스트리와 스코어링 URI를 분리하여 더 효율적이고 안정적이며 유연한 배포를 지원하는 서빙 엔드포인트도 도입합니다. 예를 들어 이제 단일 엔드포인트 뒤에 여러 모델을 배포하고 원하는 대로 모델 간에 트래픽을 분산할 수 있습니다. 새로운 서빙 UI 및 API를 사용하면 엔드포인트를 쉽게 생성하고 관리할 수 있습니다. Endpoint는 또한 모니터링하고 알림을 받는 데 사용할 수 있는 기본 내장 메트릭과 logs를 제공합니다.