페타바이트 규모에 맞게 조정된 Arctic Wolf의 리퀴드 클러스터링 아키텍처

Summary

- Arctic Wolf는 매일 1조 개 이상의 보안 이벤트를 처리하여 2600억 개 이상의 강화된 관찰 데이터를 생성하고 이를 페타바이트 규모의 Delta Lake에 유지합니다. 저희 아키텍처는 해당 데이터에 거의 실시간으로 액세스할 수 있도록 설계되었습니다.

- 저희는 최근 예측 최적화(PO)와 함께 Unity Catalog 관리 테이블에서 리퀴드 클러스터링을 사용하도록 마이그레이션하여, 더 나은 쿼리 성능을 위해 증분적, 워크로드 인식 클러스터링으로 기존의 파티션된 외부 테이블을 보완합니다.

- 리퀴드 클러스터링과 PO는 함께 테이블을 조정하여 쿼리 속도를 최대 8배까지 높이고 데이터 최신성을 몇 시간에서 몇 분으로 개선합니다.

매일 Arctic Wolf 는 1조 개가 넘는 이벤트를 처리하고 수십억 개의 강화된 레코드에서 보안 관련 인사이트를 추출합니다. 이는 60TB 이상의 압축된 원격 측정 데이터에 해당하며, AI 기반 위협 탐지 및 대응을 연중무휴 24시간 중단 없이 지원합니다. 실시간 위협 추적을 지원하기 위해, 저희는 대부분의 쿼리가 15초 내에 반환되는 것을 목표로 고객과 보안 운영 센터(Security Operation Center)에서 이 데이터를 최대한 빨리 사용할 수 있도록 해야 했습니다.

이전에는 파티셔닝 + z-ordering으로는 감당할 수 없었기 때문에 최신 데이터에 대한 액세스를 제공하�기 위해 다른 빠른 데이터 저장소를 활용해야 했습니다. 의심스러운 활동이 감지되면 저희 팀은 즉시 3개월간의 과거 컨텍스트를 활용하여 공격 패턴, 측면 이동, 전체 침해 범위를 파악할 수 있습니다. 3.8PB 이상의 압축 데이터에 대한 이러한 실시간 과거 분석은 최신 위협 헌팅에 매우 중요합니다. 침해를 몇 시간 만에 막느냐 며칠 만에 막느냐의 차이는 수백만 달러의 피해를 예방할 수 있음을 의미하기 때문입니다.

매 순간이 중요할 때 속도와 최신성은 매우 중요합니다. Arctic Wolf는 수집 비용을 높이거나 복잡성을 더하지 않으면서 방대한 데이터 세트에 대한 액세스 속도를 높여야 했습니다. 문제는 과도한 파일 I/O와 오래된 데이터로 인해 조사가 지연되었습니다. 데이터 구성 방식을 재고함으로써 저희 아키텍처는 소수의 고객이 대부분의 이벤트를 생성하는 다중 테넌트 데이터 스큐를 효율적으로 관리하는 동시에, 초기 수집 후 최대 몇 주 후에 나타날 수 있는 지연 도착 데이터도 수용합니다. 측정 가능한 이점으로는 파일 수를 4백만 개 이상에서 2백만 개로 줄이고, 백분위수 전반에 걸쳐 쿼리 시간을 약 50% 단축했으며, 90일 쿼리를 51초에서 단 6.6초로 단축한 것을 들 수 있습니다. 데이터 최신성이 몇 시간에서 몇 분으로 개선되어 보안 원격 측정 데이터에 거의 즉시 액세스할 수 있게 되었습니다.

liquid 클러스터링과 Unity Catalog 관리형 테이블이 대규모로 일관된 성능과 거의 실시간에 가까운 인사이트를 제공함으로써 어떻게 이것을 가능하게 했는지 자세히 알아보세요.

레거시 병목 현상: Arctic Wolf가 재구축한 이유

기존 테이블은 발생 날짜-시간으로 파티션되고 테넌트 식별자로 z-ordered되었지만, 파티션에 걸쳐 분할된 수많은 작은 파일 때문에 거의 실시간으로 query할 수 없었습니다. 또한 데이터를 query하기 전에 Z-ordering으로 OPTIMIZE를 실행해야 했기 때문에 데이터는 지난 24시간 이외의 시간대에만 사용할 수 있었습니다.

그때에도 데이터가 늦게 도착하여 성능 문제가 지속되었습니다. 이는 시스템이 데이터를 전송하기 전에 오프라인 상태가 될 때 발생하며, 이로 인해 새 데이터가 이전 파티션에 배치되어 성능에 영향을 미치게 됩니다.

오래된 데이터는 저희의 가시성을 떨어뜨립니다. 이러한 지연은 공격자를 억제하는 것과 공격자의 측면 이동을 허용하는 것 사이의 차이를 만듭니다.

이러한 성능 문제를 완화하고 필요한 데이터 최신성을 제공하기 위해, 저희는 데이터 가속기에 핫 데이터를 복제하고 데이터 레이크의 데이터와 쿼리 블렌딩하여 비즈니스 요구 사항을 충족해야 했습니다. 이 시스템은 운영 비용이 많이 들고 유지 관리에 상당한 엔지니어링 노력이 필요했습니다.

데이터 가속기 사용에 따른 이러한 문제를 해결하기 위해, 저희는 데이터를 고르게 분산하고 지연 도착 데이터를 지원하도록 데이터 layout을 재설계했습니다. 이는 query 성능을 최적화하고 현재 및 새로운 에이전틱 AI 사용 사례에 대해 거의 실시간 액세스를 가능하게 합니다.

리퀴드 클러스터링으로 스트리밍 데이터 기반 구축

새��로운 아키텍처의 핵심 목표는 가장 최신 데이터를 쿼리하고, 다양한 고객 규모에 걸쳐 일관된 쿼리 성능을 제공하며, 쿼리가 몇 초 내에 반환되도록 하는 것입니다.

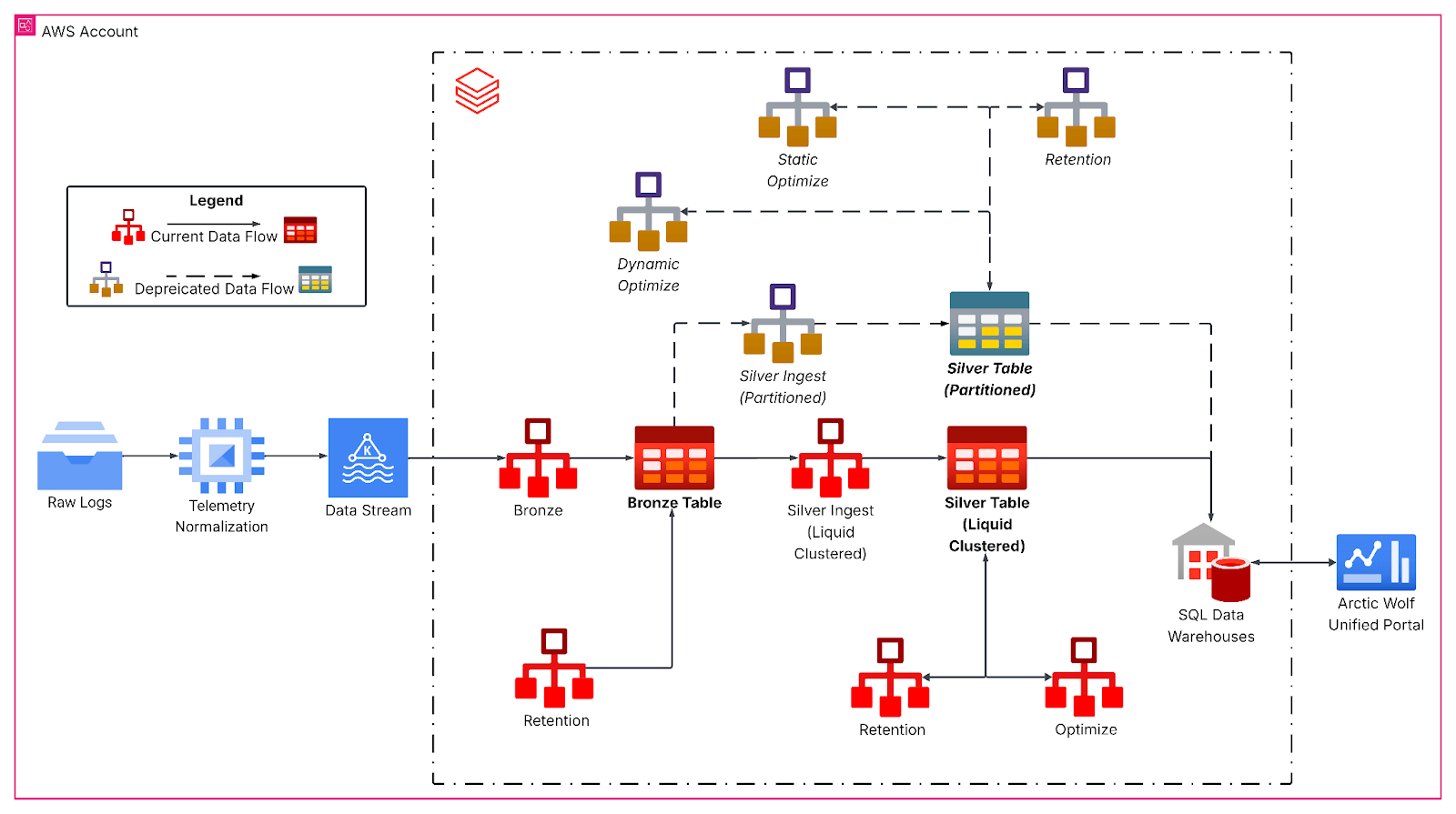

재설계된 파이프라인은 메달리온 아키텍처를 따르며, 원시 이벤트 데이터에 대한 브론즈 레이어로의 지속적인 Kafka 수집으로 시작됩니다. 그런 다음 시간별 Structured Streaming 작업이 중첩된 JSON 페이로드를 평면화하고 리퀴드 클러스터링을 사용하여 실버 테이블에 쓰면서 기본 분석 기반을 형성합니다. 여기서 브론즈-실버 변환은 스키마 변화를 처리하고, 파생된 시간 열을 생성하며, 엄격한 지연 시간 SLA를 가진 다운스트림 분석 워크로드를 위해 데이터를 준비합니다.

특히 테넌트 식별자 및 날짜 세분성, 테이블 크기, 데이터 도착 특성에 맞춰 쿼리 패턴에 정렬된 리퀴드 클러스터링 은 워크로드를 인식하는 다차원 클러스터링 키로 경직된 파티셔닝 체계를 대체했습니다. 데이터를 더 고르게 분산시키고, 이 경우 평균 파일 크기를 1GB 이상으로 늘려 테이블에 대한 일반적인 시간 창 쿼리 중에 스캔되는 파일 수를 크게 줄였습니다.

산업을 재편하는 데이터 인텔리전스

심층 분석: 쓰기 시 클러스터링(Clustering on Write)

또한, Structured Streaming 작업은 쓰기 시 클러스터링을 활용하여 새 데이터가 도착할 때 파일 레이아웃을 유지합니다. 이는 새로 수집된 데이터에만 클러스터링을 적용하는 로컬라이즈된 OPTIMIZE 운영처럼 작동합니다. 따라서 수집된 데이터는 이미 최적화되어 있습니다. 그러나 수집 배치는 너무 작으면 작지만 잘 클러스터링된 파일이 많이 생성되어 이상적인 데이터 layout을 달성하기 위해 전역 OPTIMIZE 중에 클러스터링되어야 합니다. 반면 수집 시 배치 크기가 전역 Optimize에 필요한 배치 크기에 가까워지면 추가 최적화가 필요하지 않은 경우가 많습니다.

테라바이트와 같이 매우 많은 양의 데이터를 수집하는 워크로드의 경우, 효율적인 클러스터링과 파일 레이아웃을 보장하기 위해 maxBytesPerTrigger와 함께 foreachBatch를 사용하는 등 소스에서 배치 처리를 하는 것을 권장합니다. maxBytesPerTrigger를 사용하면 배치 크기를 제어하여 OPTIMIZE 작업을 통해 조정해야 하는 수많은 작은 클러스터형 섬을 제거할 수 있습니다. OPTIMIZE 작업이 처리하는 크기에 가까운 크기로 최적의 배치를 생성하여 OPTIMIZE에 필요한 추가 작업을 줄일 수 있었습니다.

Arctic Wolf의 보안 분석에 미치는 영향

Arctic Wolf의 리퀴드 클러스터링으로의 마이그레이션은 성능, 데이터 최신성, 운영 효율성에서 상당하고 정량화 가능한 개선을 가져왔습니다. 예측 최적화(Predictive Optimization) 기능이 포함된 UC 관리형 테이블(UC Managed Tables)은 유지 관리 일정을 잡을 필요성도 줄여주었습니다.

파일 수가 400만 개 이상에서 200만 개로 감소하여 쿼리 중 파일 I/O를 최소화하면서도 우수한 클러스터 품질을 유지했습니다. 그 결과 query 성능이 대폭 향상되어 보안 애널리스트가 사건을 더 빠르게 조사할 수 있게 되었습니다. 백분위수 전반에서 ~50% 더 빨라졌고 , 다수 고객의 경우 ~90% 더 빨라졌으며, 90일 query는 51초에서 6.6초로 단축되었습니다.

쓰기 시 클러스터링을 구현하여 데이터 최신성을 몇 시간에서 몇 분으로 단축했으며, 인사이트 확보 시간을 약 90% 가속화했습니다. 이러한 개선을 통해 Arctic Wolf의 데이터 레이크에서 거의 실시간에 가까운 위협 탐지 가 가능해졌습니다.

리퀴드 클러스터링 및 Unity Catalog 관리 테이블로 전환하면서 레거시 파티셔닝을 제거하고 기술 부채를 줄였으며 고급 거버넌스 및 성능 기능을 활용할 수 있게 되었습니다. 매일 2,600억 개 이상의 행을 처리하고 쿼리할 수 있는 아키텍처를 통해 이러한 모든 소스의 중요한 보안 데이터에 더 빠르고 효율적으로 액세스할 수 있습니다. 연중무휴 24시간 운영되는 Concierge Security® 팀과 실시간 위협 탐지를 결합하여 더 빠르고 정확한 위협 대응 및 완화를 지원합니다. 이러한 차별화 요소는 고객 이 더 강력하고 민첩한 보안 태세를 달성하고 환경을 보호하고 지속적인 비즈니스 성공을 지원하는 Arctic Wolf의 능력에 대한 더 큰 신뢰를 갖도록 돕습니다.

(이 글은 AI의 도움을 받아 번역되었습니다. 원문이 궁금하시다면 여기를 클릭해 주세요)

게시물을 놓치지 마세요

다음은 무엇인가요?

공공 부문

2026년 2월 12일/1분 이내 소요