Présentation du nouveau programme partenaire Databricks et du Framework Well-Architected pour les ISV et les fournisseurs de données

Placer la barre plus haut pour les ISV et les fournisseurs de données en partenariat avec Databricks

Summary

- Présentation d'un programme de partenariat Databricks unifié et à plusieurs niveaux qui récompense l'impact sur les architectures Connected Products, Delta Sharing et Built-On.

- Lancement du Partner Well-Architected Framework (PWAF) avec des conseils prescriptifs et prêts pour l'IA pour aider les Partenaires à créer plus rapidement des intégrations sécurisées, mesurables et évolutives.

- Des avantages, des normes et des outils plus clairs qui relient les choix d'architecture à la classification, aux avantages des stratégies de lancement sur le marché et à la réussite commune des clients.

Plus de 20 000 clients, dont plus de 60 % des entreprises du Fortune 500, font confiance à Databricks pour détecter la fraude, découvrir de nouveaux médicaments, optimiser leur chaîne d'approvisionnement, personnaliser l'expérience client, et bien plus encore. Et tandis que les clients nous demandent d'étendre notre produit, ils nous demandent également d'élargir notre réseau de partenaires pour les aider à démocratiser les données et l'IA dans leur entreprise… Quelle que soit la vitesse à laquelle nous innovons, nous ne pourrons jamais répondre seuls à tous les besoins de nos clients.

C'est là que vous - nos partenaires ISV et fournisseurs de données - entrez en jeu. Ensemble, nous aspirons à offrir aux clients tous les outils, modèles, datasets ou agents dont ils ont besoin, et à vous aider à développer votre activité.

Seul on va plus vite, ensemble on va plus loin. —Proverbe africain

Au cours des 10 mois qui ont suivi mon arrivée chez Databricks pour m'occuper de notre écosystème de produits, j'ai eu le privilège de rencontrer des centaines d'éditeurs de logiciels indépendants, de fournisseurs de données et de startups. Vous nous avez indiqué ce qui fonctionne bien et les points à améliorer, et nous vous réservons de nombreuses nouveautés pour prendre en compte vos retours.

Aujourd'hui, lors de notre Partner Kickoff à Vegas, je suis ravi d'annoncer les deux premières améliorations (parmi de nombreuses autres) de notre programme partenaire pour les ISV et les fournisseurs de données : un nouveau programme de niveaux de partenariat (Partner Tiering Program) pour mieux récompenser les partenaires pour l'impact qu'ils ont sur les clients à travers plusieurs architectures partenaires, et un Framework Well-Architected pour les partenaires qui fournit des directives techniques claires et prêtes pour l'IA pour créer des intégrations de classe mondiale avec Databricks.

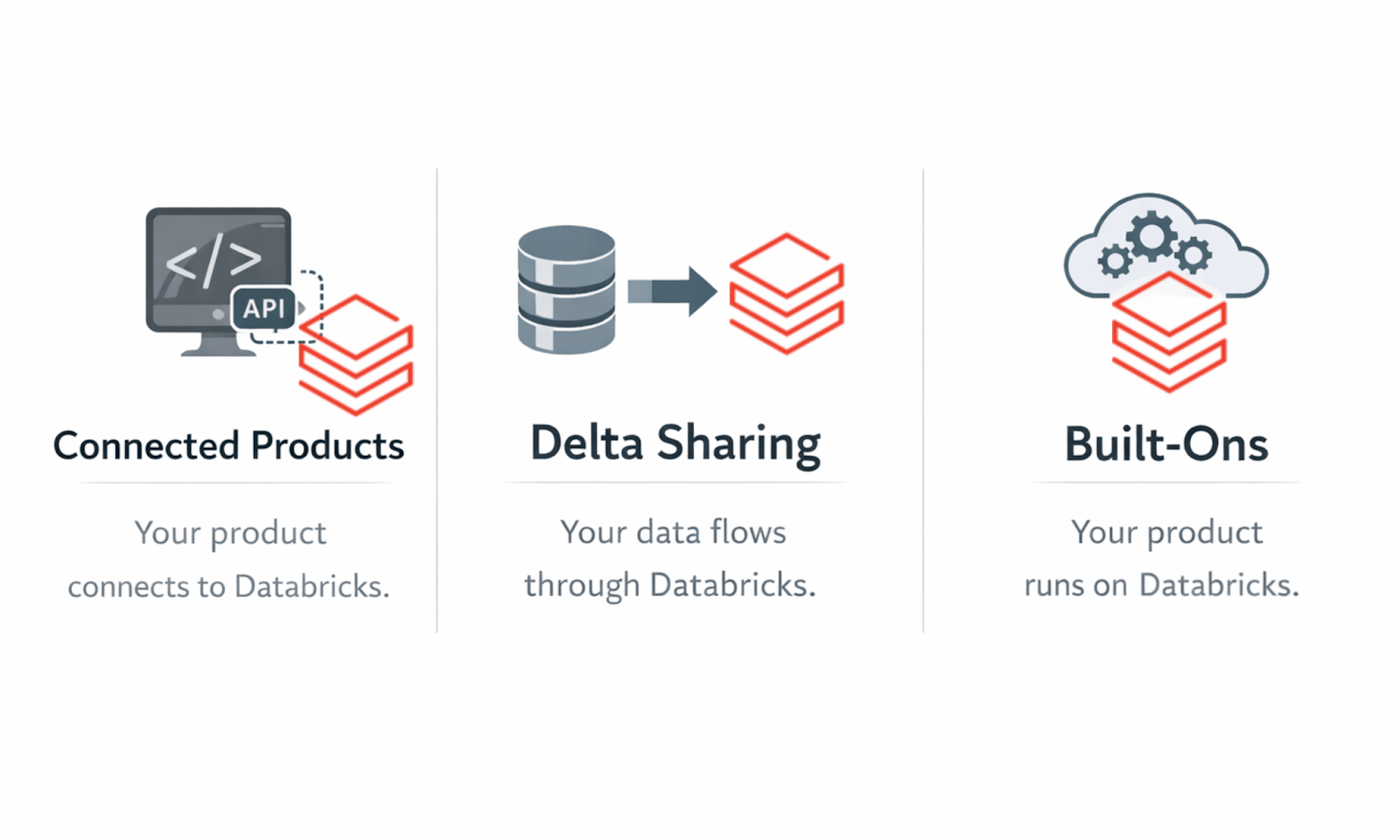

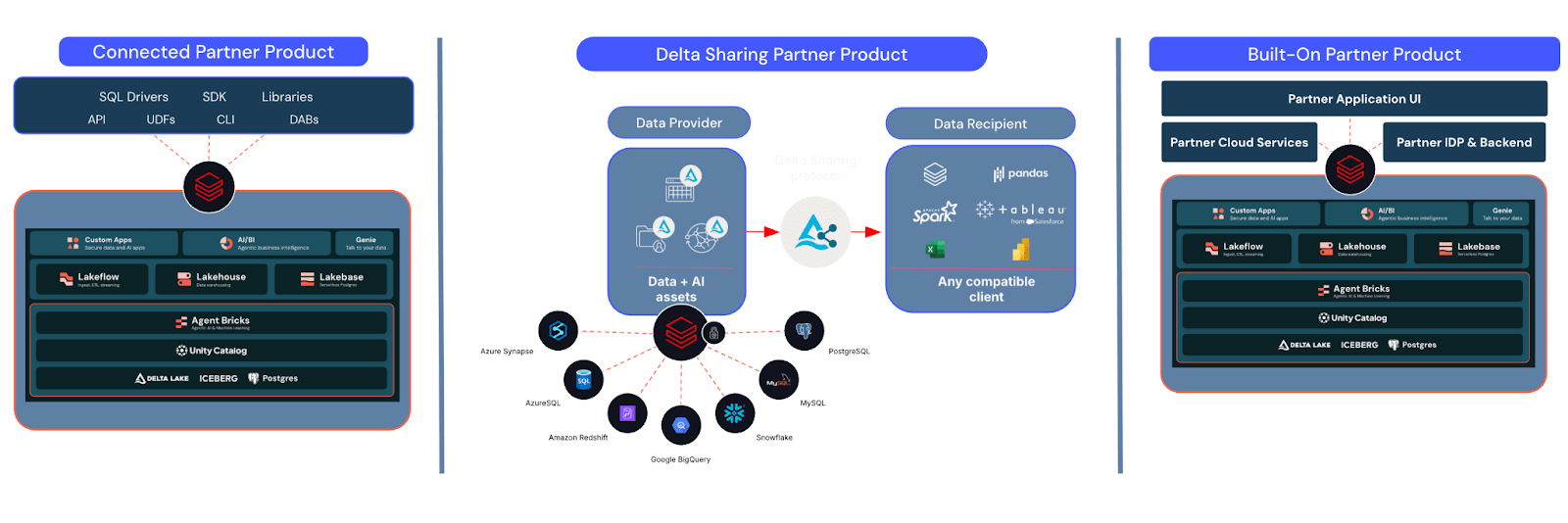

Trois architectures partenaires pour les ISV et les fournisseurs de données sur Databricks

À la base de ces annonces se trouvent les trois architectures que vous co-construisez avec nous.

1. Les Produits Connectés sont des produits créés par des partenaires qui s'intègrent à la plateforme Databricks du client pour analyser, traiter, transformer et générer des insights à partir de ses données. Ces drivers (par ex., JDBC, ODBC, Python) et API sont le plus souvent développés par des outils d'IA, de BI, de gouvernance des données, de transformation des données ou d'autres outils de traitement intensif des données, et incluent désormais également les serveurs MCP qui peuvent être publiés sur notre marketplace MCP.

2. Delta Sharing est le seul « protocole de partage universel » qui permet aux fournisseurs de données de partager leurs données avec leurs clients sur n'importe quelle plateforme, avec n'importe quel outil et pour alimenter n'importe quel modèle. Il fonctionne sans copie, vous n'avez donc pas à répliquer vos données, et nous gérons toute la complexité de la sécurité et des réseaux cross-cloud. Contrairement aux approches de type "jardin clos" proposées par d'autres plateformes de données, nous continuerons à faire en sorte que les partages Delta fonctionnent avec tous les outils souhaités par les clients. Si le destinataire accepte le partage dans Databricks, celui-ci apparaît simplement dans son Unity Catalog pour être utilisé/joint/interrogé avec le reste de ses données, et il fonctionnera également dans Excel, n'importe quel outil de BI majeur, Snowflake et autres. C'est probablement la raison pour laquelle les partages Delta ont connu une croissance de plus de 140 % au sein de l'écosystème cette année.

3. Les Built-Ons sont des solutions développées sur Databricks, Databricks servant d'implémentation fondamentale derrière le propre front-end/la propre API/la propre propriété intellectuelle du partenaire. C'est notre plus récente initiative, et celle pour laquelle nous observons la plus forte demande, notamment lorsque les ISV développent des agents et des applications avec Agent Bricks, Lakebase et Databricks Apps.

Auparavant, nous avions différentes équipes avec des motivations différentes qui cherchaient à établir des partenariats sur ces architectures. C'était logique à chaque lancement de nouvelle architecture, car nous devions tester, mesurer et apprendre ce qui fonctionnait. Ce que nous avons appris, c'est que beaucoup d'entre vous utilisent plus d'une de ces architectures et méritent d'être récompensés en conséquence, et que vous souhaitez de meilleures directives sur la *manière* de créer vos intégrations pour répondre aux attentes des clients et obtenir le soutien de nos équipes sur le terrain.

Un seul programme, trois architectures partenaires

Notre nouveau programme de niveaux de partenariat utilise la même structure de niveaux que notre programme Consultant/Intégrateur système, et mesure l'impact combiné des trois architectures partenaires (nombre de clients communs, impact de la consommation Databricks ($DBU), engagement envers Databricks, adoption de services stratégiques et préparation aux stratégies de lancement sur le marché) pour déterminer le placement dans les niveaux et les récompenses dans un système holistique basé sur le mérite.

Ce que cela signifie pour vous :

- Soyez récompensé pour tout ce que vous créez sur les produits connectés, Delta Sharing et les Built-Ons

- Obtenez des crédits « supplémentaires » en développant avec Lakebase, Genie et/ou Agent Bricks.

- Découvrez comment vos choix d'architecture se traduisent en niveaux, avantages et assistance en matière de stratégies de lancement sur le marché

Nous vous en dirons plus sur les niveaux et avantages spécifiques tout au long du premier trimestre (février-avril) et nous continuerons à les affiner en fonction de vos retours avant notre déploiement officiel au plus tard au deuxième trimestre.

Partenaires Well Architected Framework : construire mieux, plus vite, ensemble

Afin de vous fournir de meilleures instructions techniques et une plus grande cohérence et transparence dans la manière dont nous validons toutes les intégrations de partenaires, nous publions le Partner Well-Architected Framework (PWAF).

PWAF fournit aux partenaires des conseils prescriptifs prêts pour l'IA pour créer des intégrations sécurisées et fiables, et inclut les exigences d'instrumentation qui nous permettent de mesurer l'adoption par les clients et l'impact des $DBU, certains des indicateurs clés qui déterminent votre positionnement dans le programme partenaire.

Mieux encore, nous avons conçu PWAF pour qu'il soit compatible avec l'IA dès sa conception. En quelques clics, vous pouvez utiliser ces conseils avec Cursor, Claude Code, Replit ou votre IDE/outil de développement assisté par IA préféré et utiliser des prompts pour créer des intégrations Databricks well-architected.

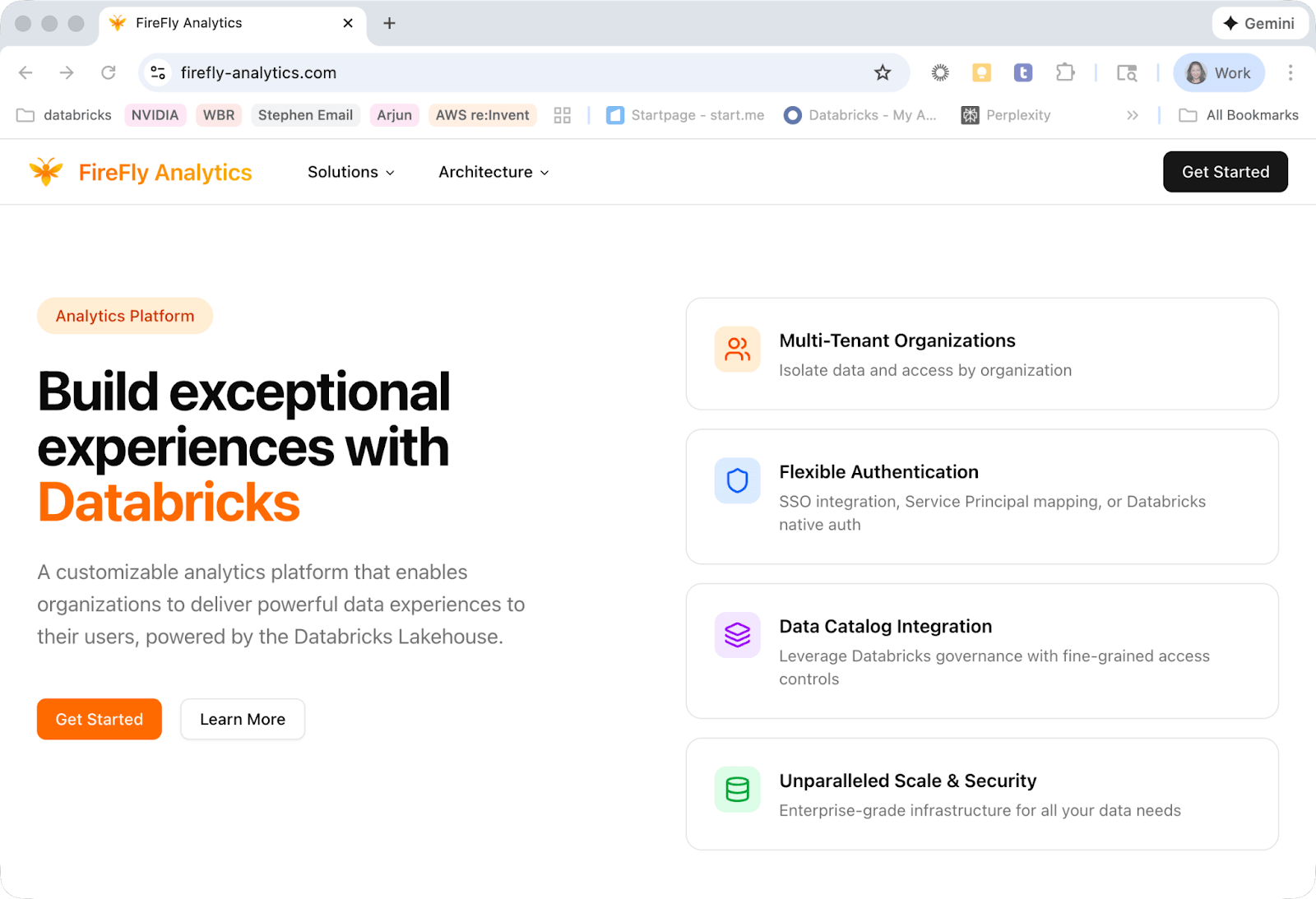

Et, plutôt que de simplement vous dire quoi faire, nous voulons vous montrer comment. Pour accompagner PWAF, nous avons créé une entreprise fictive, « Firefly analytique », qui a été conçue pour suivre les bonnes pratiques de PWAF et vous fournir la structure pour démarrer à partir d'un exemple pratique. Codé 100 % au feeling, et (bientôt) 100 % open source.

Pointez vos outils sur PWAF et le dépôt Firefly (bientôt disponible) et commencez à développer !

Et ce n'est qu'un début

Ce ne sont là que les premières des nombreuses améliorations sur lesquelles nous travaillons pour vous aider à développer des capacités transformatrices et à faire croître votre activité en ravissant nos clients communs.

Merci pour tous vos retours qui nous aident à améliorer notre programme. Nous avons hâte de continuer à grandir et à construire ensemble cette année !

Continuez à développer,

— Stephen

(Cet article de blog a été traduit à l'aide d'outils basés sur l'intelligence artificielle) Article original