Des pipelines de données fiables en toute simplicité

Simplifiez l'ETL par batch et en streaming en automatisant la fiabilité et la qualité des donnée

LES ÉQUIPES LES PLUS PERFORMANTES CHOISISSENT DES PIPELINES DE DONNÉES INTELLIGENTSEncoder les bonnes pratiques des pipelines de données

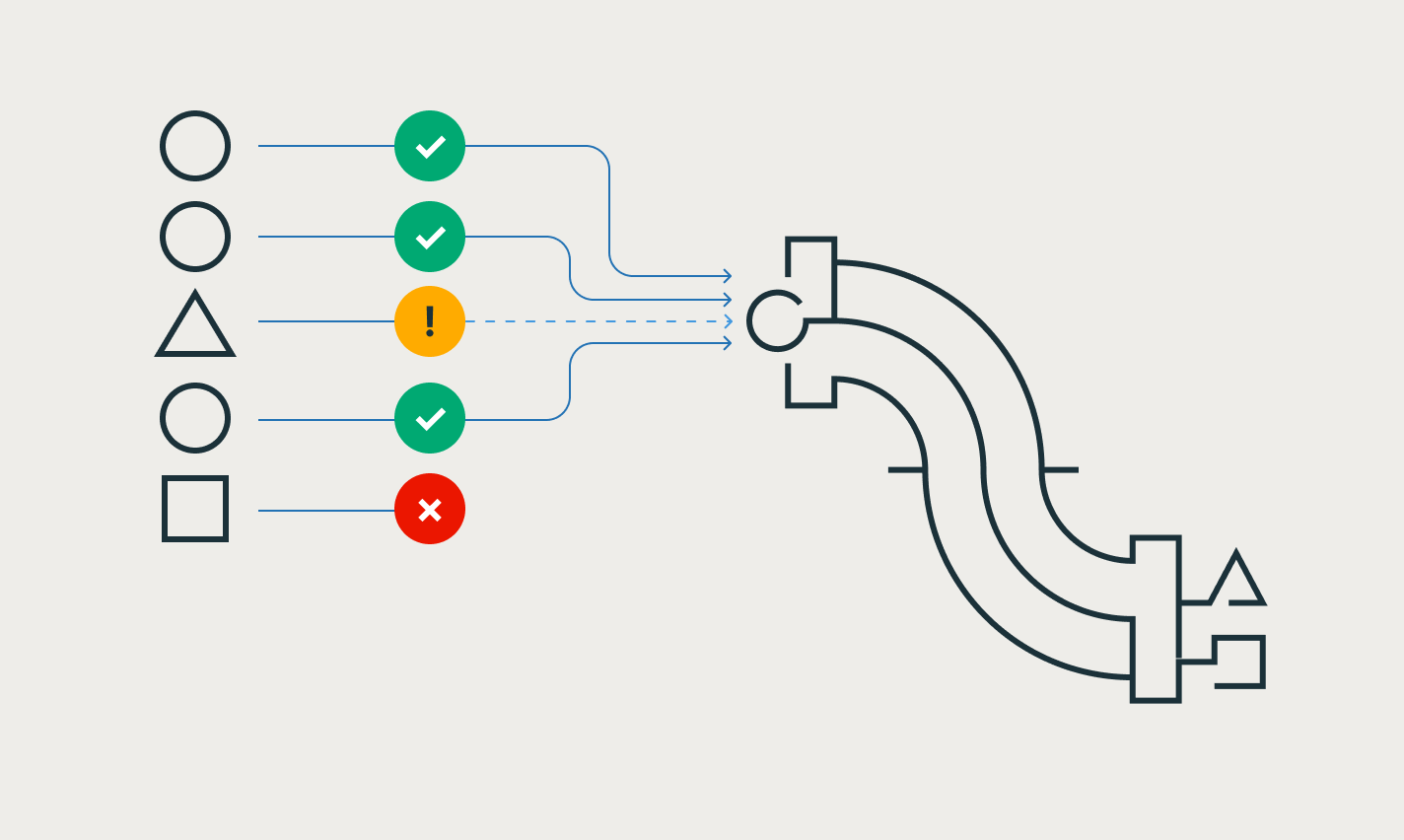

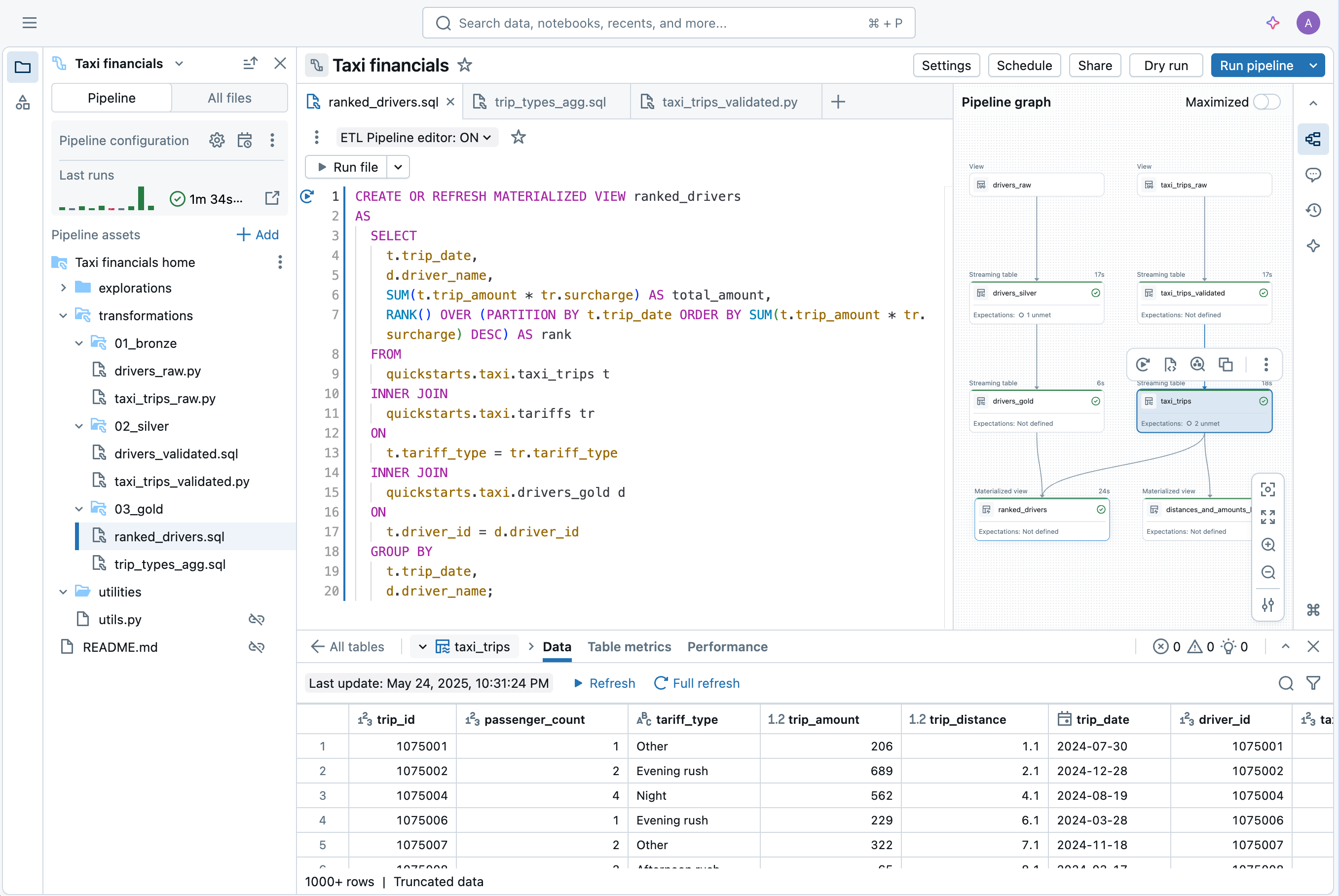

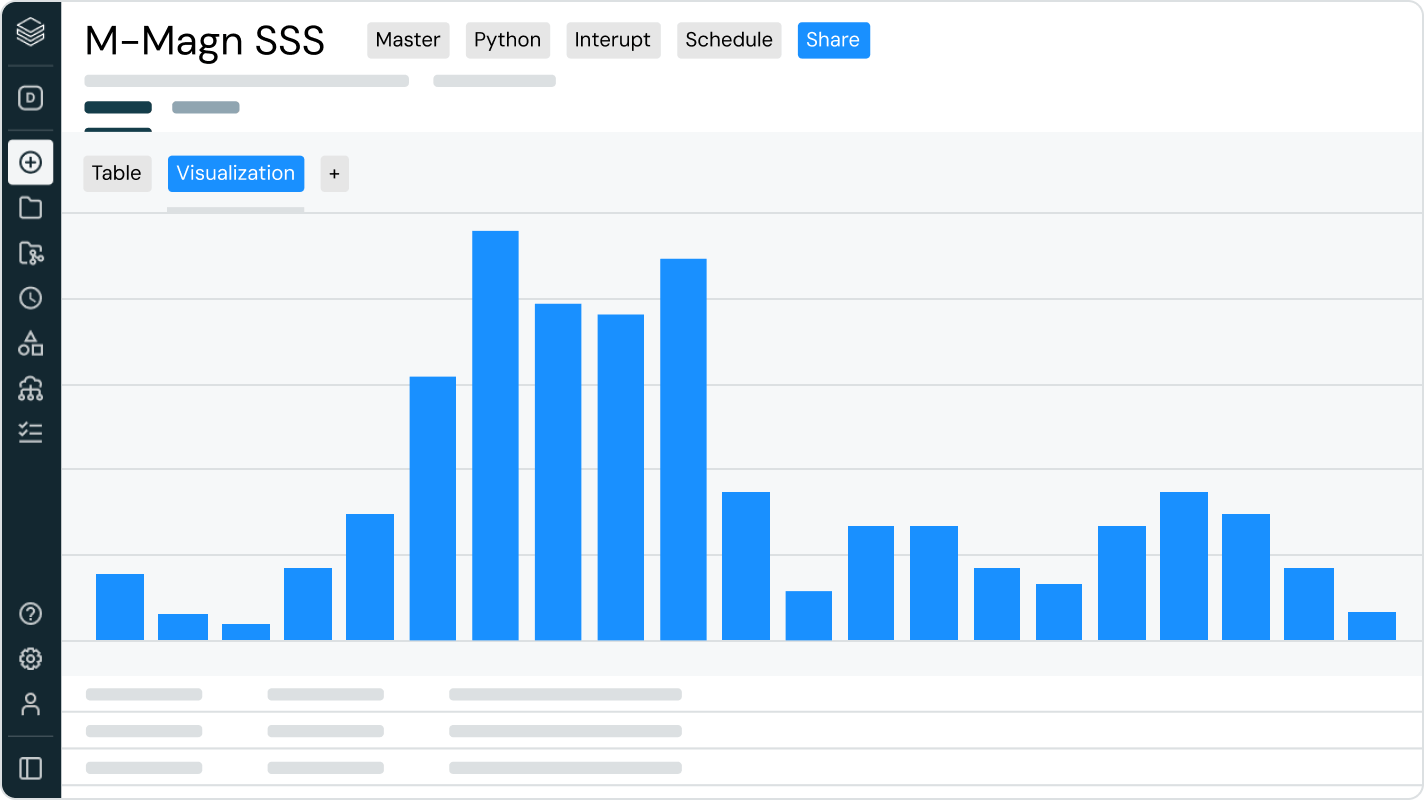

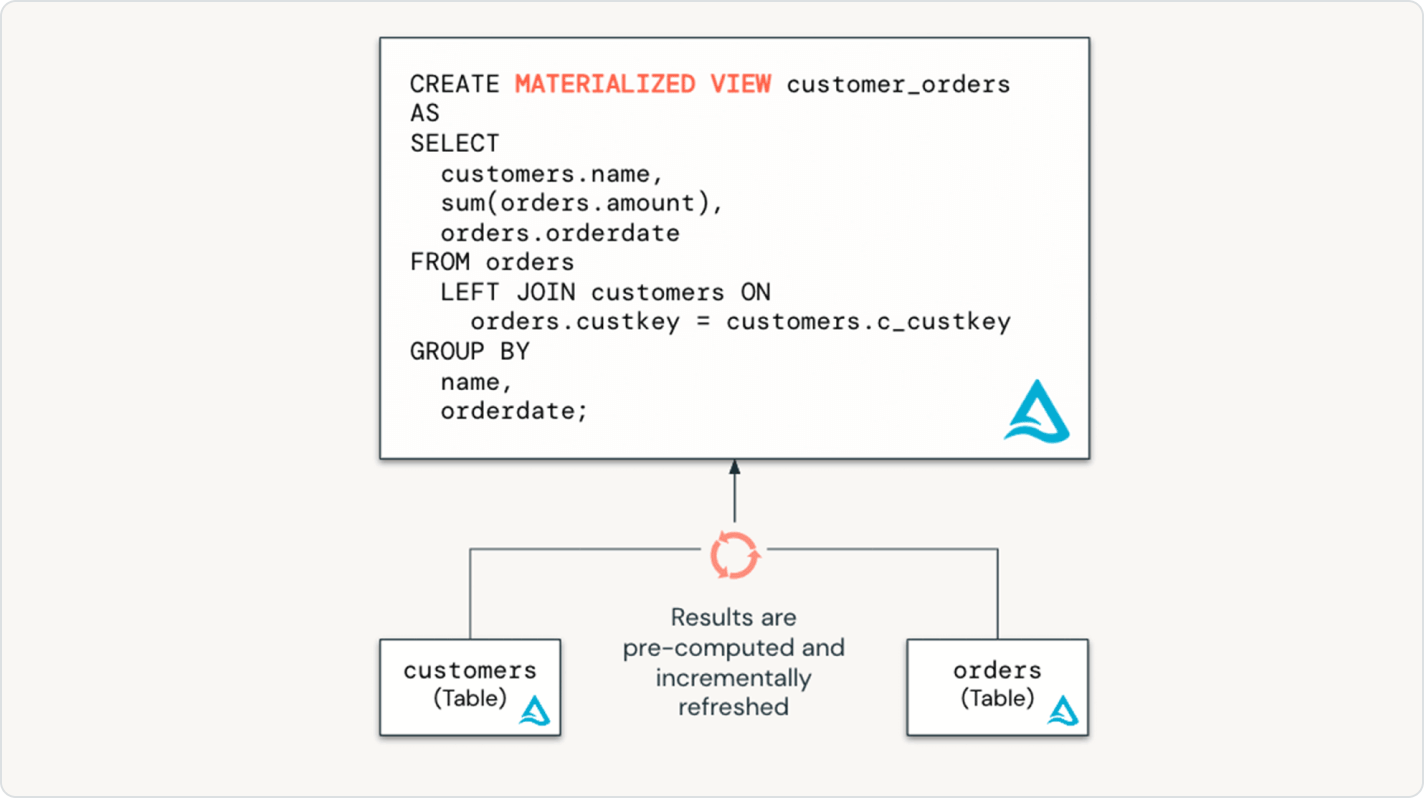

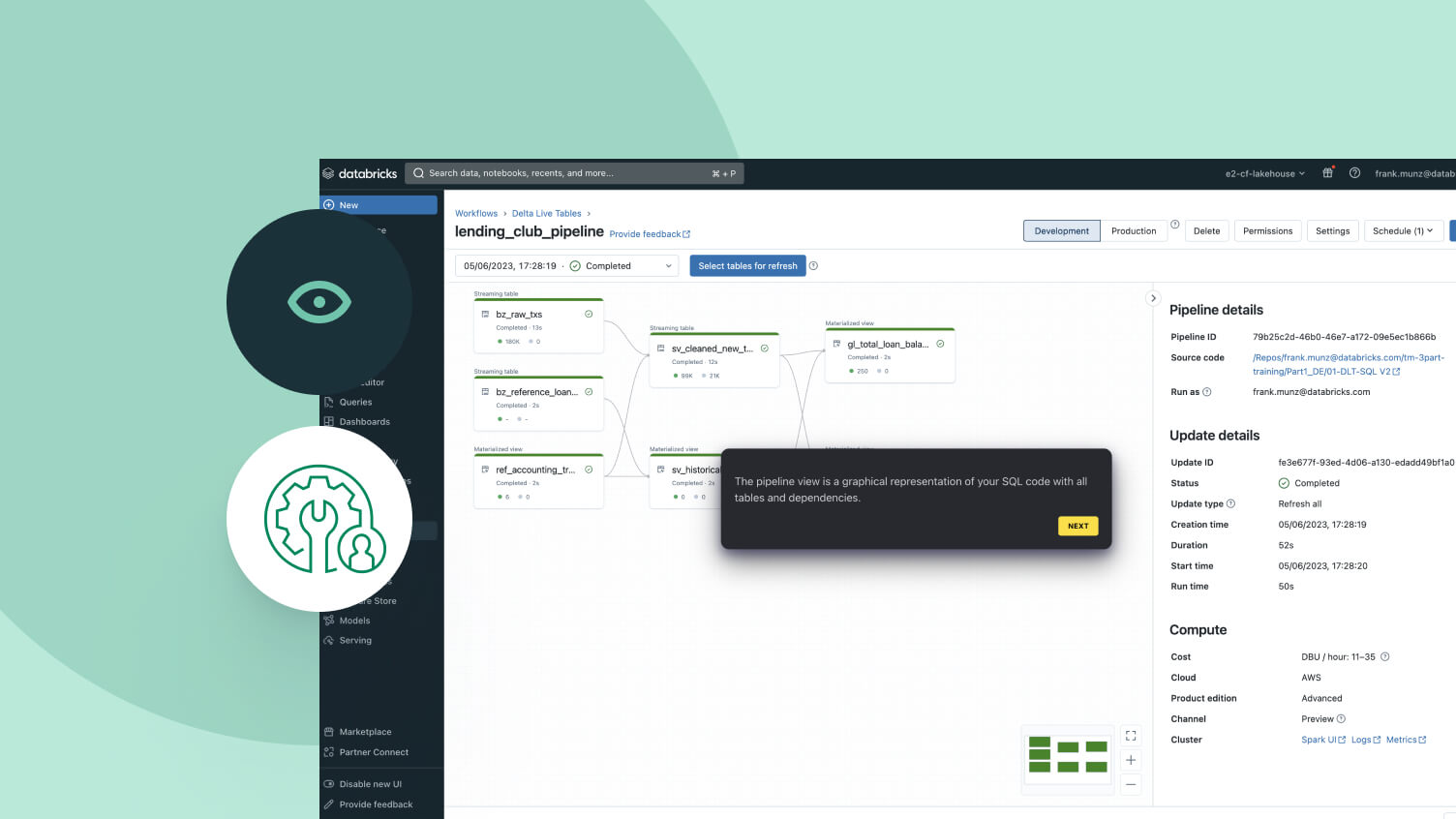

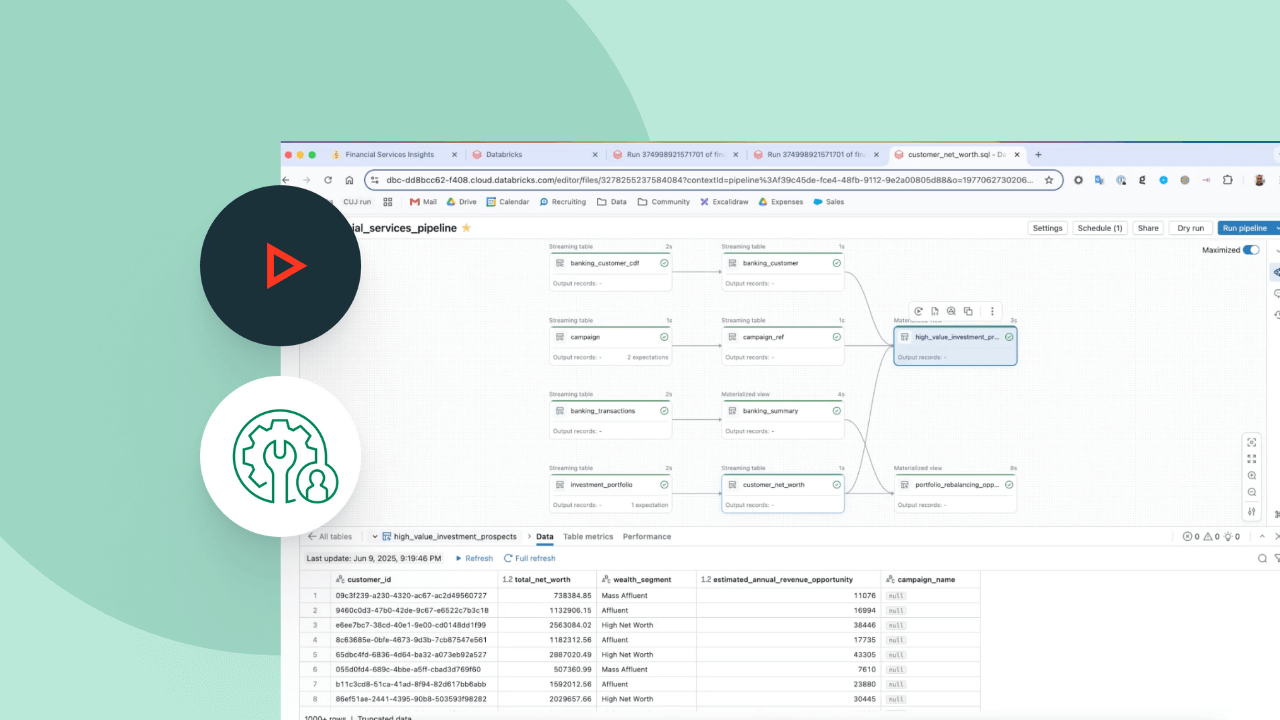

Déclarez simplement les transformations de données dont vous avez besoin, et laissez les Spark Declarative Pipelines faire le reste.Pensé pour simplifier la création de pipeline de données

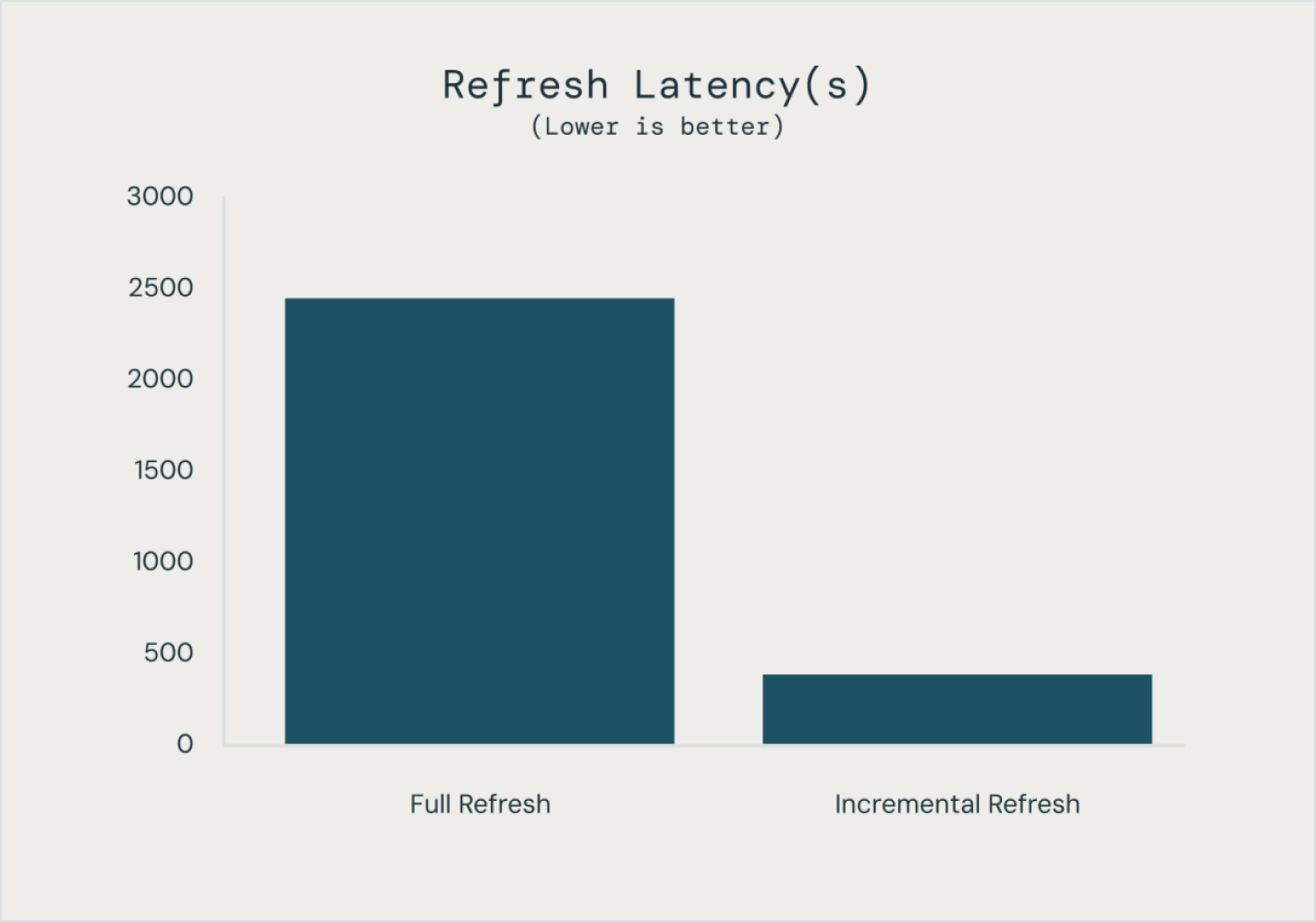

Créer et exploiter des pipelines de données n'a rien de simple, mais ce n'est pas une fatalité. Les Spark Declarative Pipelines sont conçus pour conjuguer simplicité et puissance pour mettre sur pied un ETL robuste en quelques lignes de code.Grâce à l'API unifiée de Spark pour le traitement par batch et en streaming, les Spark Declarative Pipelines vous permettent d'alterner facilement entre les modes de traitement.

Autres fonctionnalités

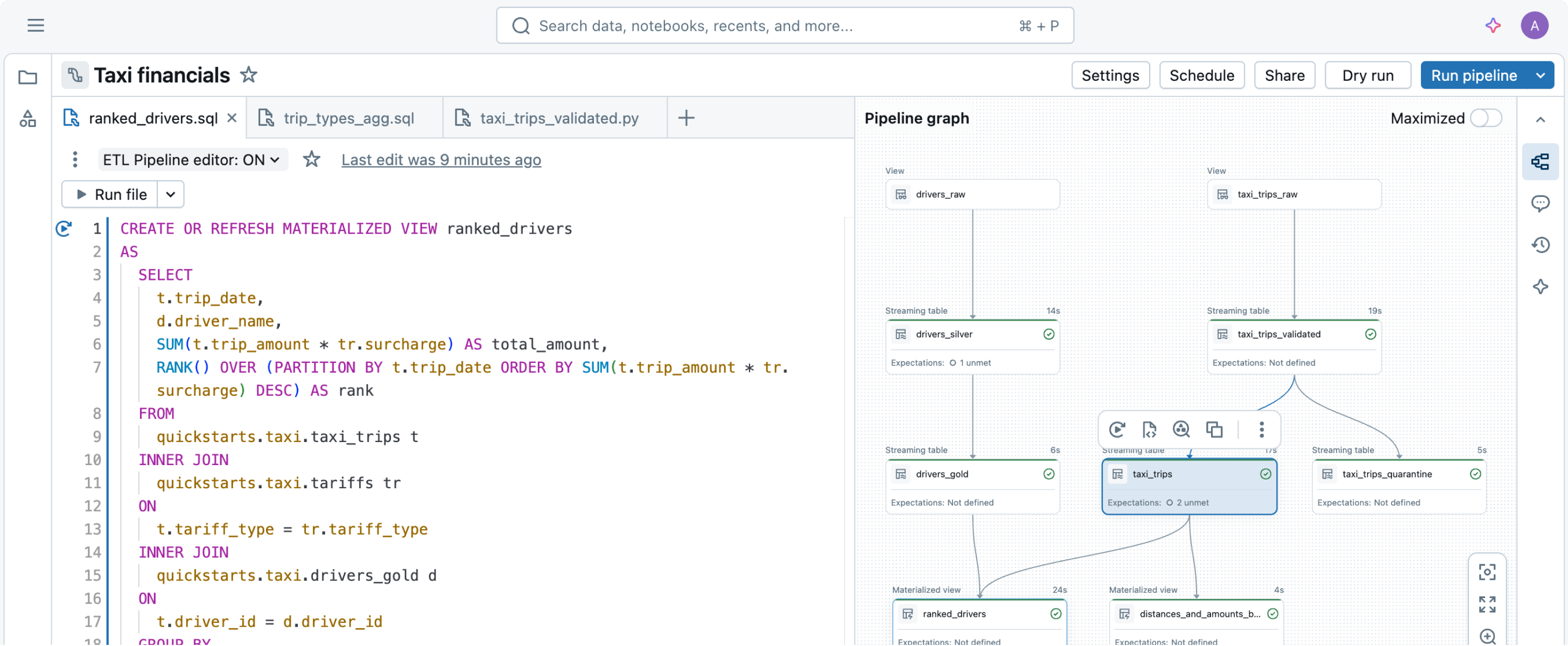

Rationalisez vos pipelines de données

Simplifiez la gestion des sources, des transformations et des destinations simples

Grâce à la programmation déclarative, vous pouvez exploiter la puissance de l'ETL sur la Data Intelligence Platform en quelques lignes de code.

Explorez les démos des Spark Declarative Pipelines

Les tarifs basés sur l'utilisation permettent de maîtriser les dépenses

Ne payez que les produits que vous utilisez, à la seconde près.En savoir plus

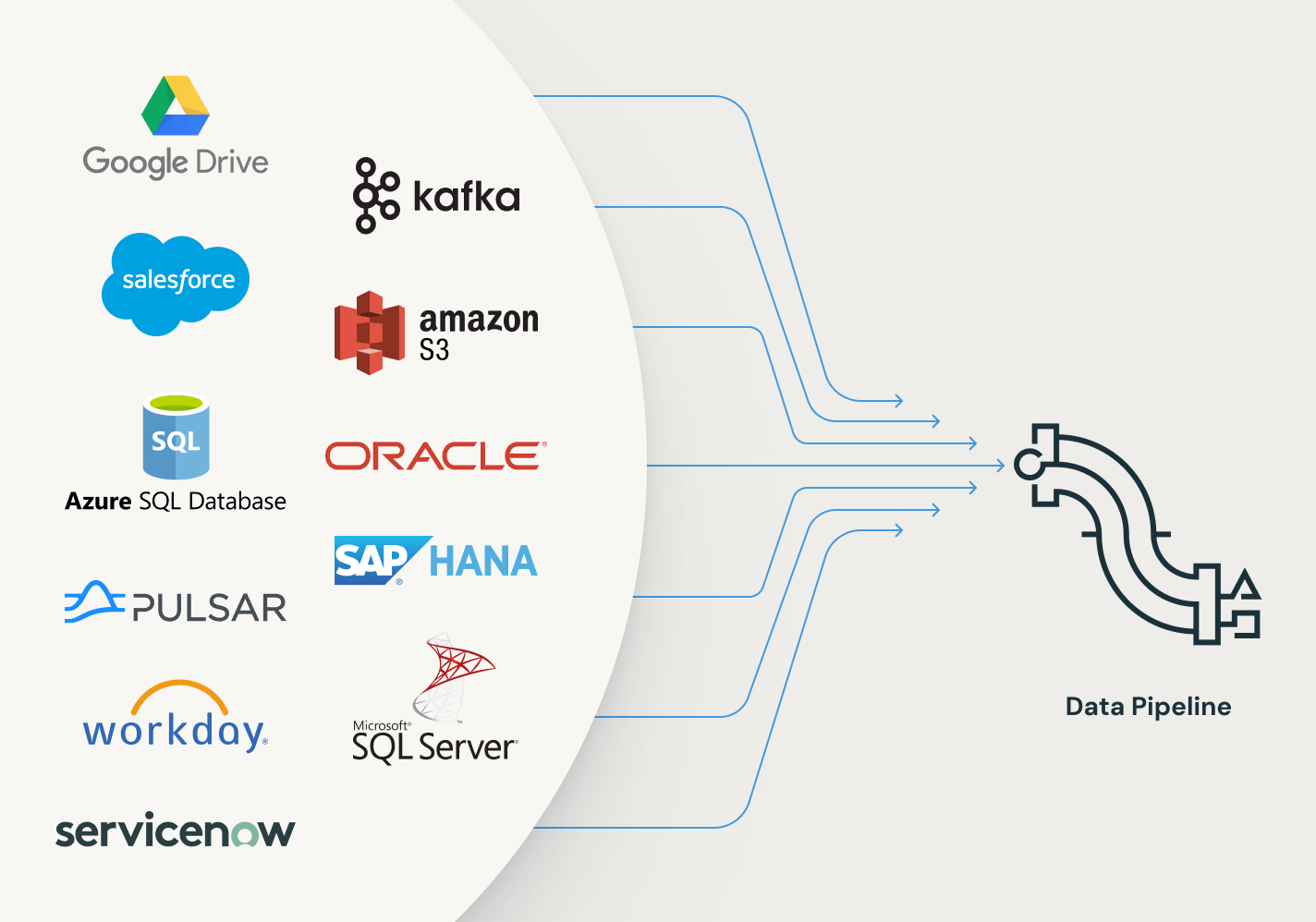

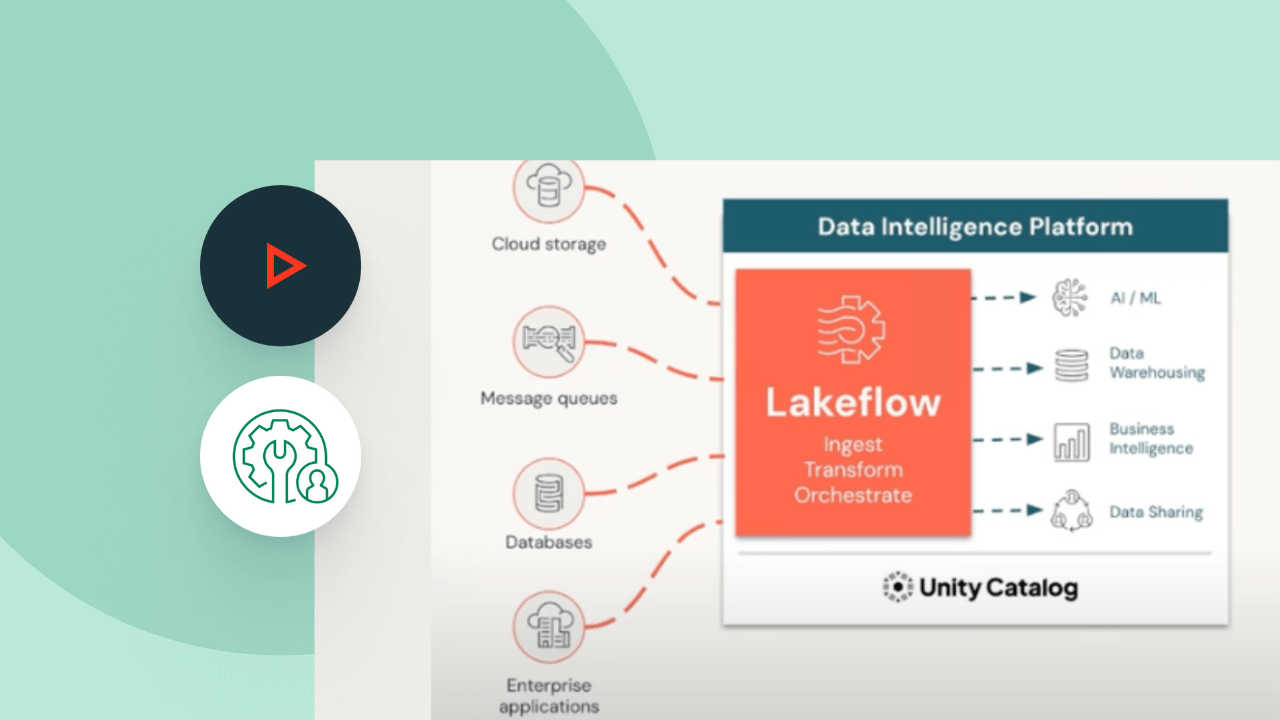

Explorez d'autres offres intelligentes et intégrées sur la Data Intelligence Platform.LakeFlow Connect

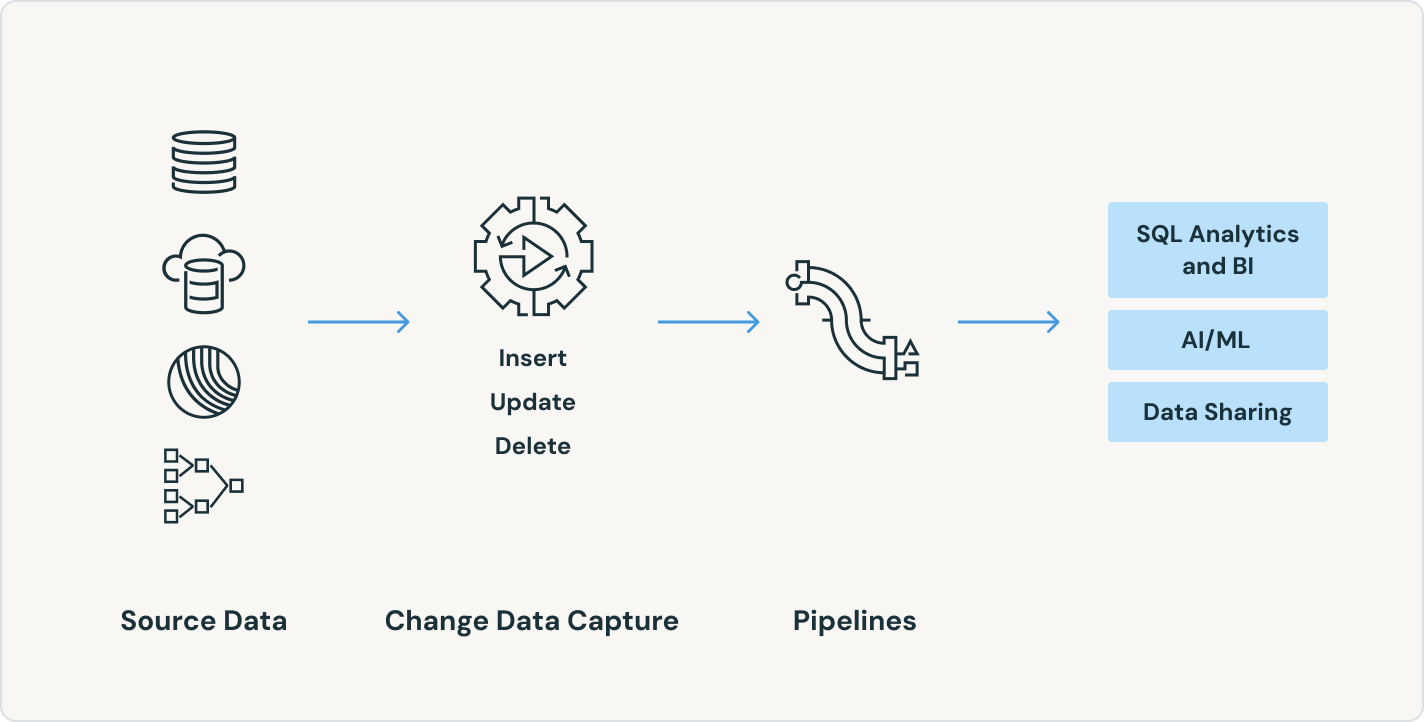

Avec des connecteurs d'ingestion de données efficaces pour tous les types de source et une intégration native à la Data Intelligence Platform, les équipes accèdent en toute simplicité à l'analytique et à l'IA avec une gouvernance unifiée.

Tâches Lakeflow

Définissez, gérez et supervisez en toute simplicité des workflows multitâche pour vos pipelines ETL, d'analytique et de machine learning. Grâce à la prise en charge d'un large éventail de types de tâches, une observabilité approfondie et une grande fiabilité, vos équipes sont en mesure de mieux automatiser et orchestrer tout type de pipeline pour gagner en productivité.

Stockage en lakehouse

Unifiez les données du lakehouse, quels que soient leur format et leur type, pour les mettre à disposition de toutes vos charges d'analytique et d'IA.

Unity Catalog

Encadrez sans problème tous vos assets de données avec la seule solution de gouvernance unifiée et ouverte de l'industrie pour les données et l'IA, intégrée à la Databricks Data Intelligence Platform

La Data Intelligence Platform

Découvrez les avantages de la Databricks Data Intelligence Platform pour vos charges de données et d'IA.

Passez à l'étape suivante

Explorez la documentation des Spark Declarative Pipelines

Tout ce dont vous avez besoin pour commencer à utiliser des Spark Declarative Pipelines sur les environnements AWS, Microsoft Azure ou Google Cloud Platform.

Démarrez votre essai gratuit

Essayez gratuitement la plateforme Databricks dans son intégralité.

FAQ SUR LES Spark Declarative Pipelines

Prêts à devenir une entreprise axée sur les données et l'IA ?

Faites le premier pas de votre transformation