데이터브릭스 모델 서빙을 사용하여 프라이빗 LLM 배포하기

발행일: 2023년 10월 16일

작성자: 아흐메드 빌랄, 안킷 마투르, Kasey Uhlenhuth , Joshua Hartman

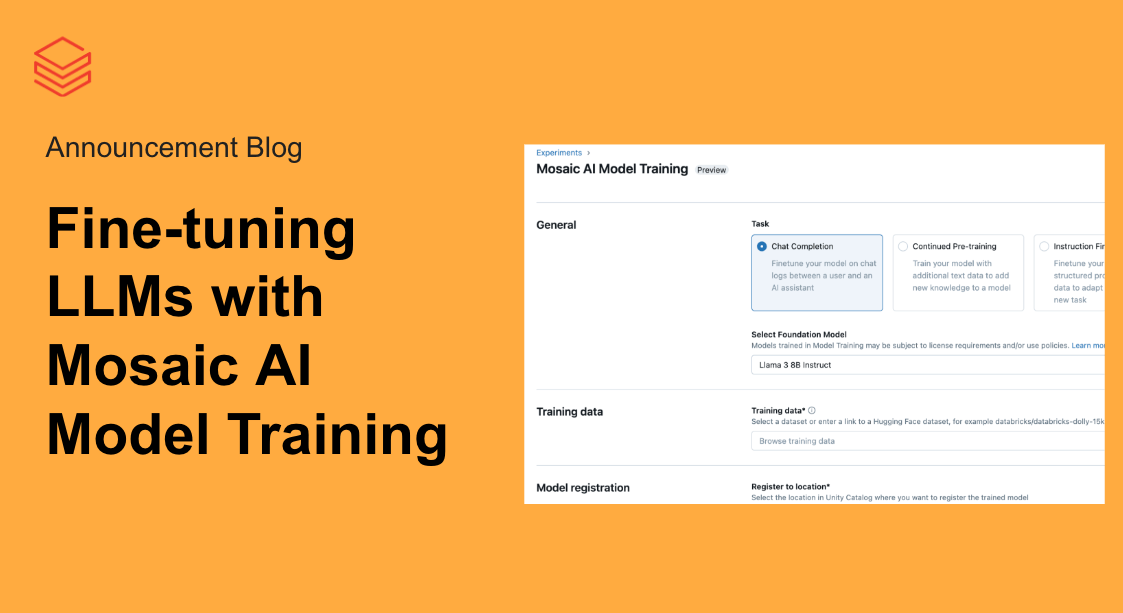

데이터브릭스 모델 서빙에 대한 GPU 및 LLM 최적화 지원의 공개 프리뷰를 발표하게 되어 기쁘게 생각합니다! 이번 출시를 통해 LLM 및 비전 모델을 포함한 모든 유형의 오픈 소스 또는 자체 커스텀 AI 모델을 레이크하우스 플랫폼에 배포할 수 있습니다. 데이터브릭스 모델 서빙은 LLM 서빙에 맞게 모델을 자동으로 최적화하여 별도의 설정 없이도 동급 최고의 성능을 제공합니다.

데이터브릭스 모델 서빙은 통합 데이터 및 AI 플랫폼에서 개발된 최초의 서버리스 GPU 서빙 제품입니다. 이를 통해 데이터 수집 및 미세 조정부터 모델 배포 및 모니터링에 이르는 모든 GenAI 애플리케이션을 단일 플랫폼에서 구축하고 배포할 수 있습니다.

Azure를 사용하는 사용자는 가입 양식을 작성하여 모델 서빙을 위한 GPU 및 LLM 최적화 지원을 사용하도록 설정해야 합니다.

MLOps의 Big Book

데이터브릭 모델 서빙으로 생성형 AI 앱 구축

"데이터브릭스 모델 서빙을 통해 생성형 AI를 프로세스에 통합하여 고객 경험을 개선하고 운영 효율성을 높일 수 있습니다. Model Serving을 사용하면 데이터와 모델을 완벽하게 제어하면서 LLM 모델을 배포할 수 있습니다.." — Ben Dias, easyJet 데이터 과학 및 분석 담당 이사 - 더 알아보기

인프라 관리에 대한 걱정 없이 안전하게 AI 모델 호스팅

데이터브릭스 모델 서빙은 복잡한 인프라를 이해할 필요 없이 모든 AI 모델을 배포할 수 있는 단일 솔루션을 제공합니다. 즉, 처음부터 구축했든, 오픈 소스에서 소싱했든, 독점 데이터로 미세 조정했든, 학습 방식에 관계없이 모든 자연어, 시각, 오디오, 표 형식 또는 사용자 지정 모델을 배포할 수 있습니다. MLflow로 모델을 로깅하기만 하면 CUDA와 같은 GPU 라이브러리가 포함된 프로덕션 지원 컨테이너를 자동으로 준비하여 서버리스 GPU에 배포합니다. 완전 관리형 서비스가 모든 작업을 대신 처리하므로 인스턴스 관리, 버전 호환성 유지, 패치 버전 관리가 필요 없습니다. 이 서비스는 트래픽 패턴에 맞게 인스턴스를 자동으로 확장하여 인프라 비용을 절감하는 동시에 지연 성능을 최적화합니다.

"데이터브릭스 모델 서빙은 의미 있는 시맨틱 검색 애플리케이션부터 미디어 트렌드 예측에 이르기까지 다양한 사용 사례에 인텔리전스를 불어넣을 수 있는 역량을 가속화하고 있습니다. 데이터브릭스��는 CUDA 및 GPU 서버 확장의 복잡한 작업을 추상화하고 단순화함으로써 인프라의 번거로움과 부담 없이 Condé Nast의 모든 애플리케이션에서 AI 사용을 확대하는 등 실제 전문 분야에 집중할 수 있게 해줍니다." — Ben Hall, Condé Nast 시니어 ML 엔지니어

최적화된 LLM 제공으로 지연 시간 및 비용 절감

이제 데이터브릭스 모델 서빙에 대규모 언어 모델을 효율적으로 제공하기 위한 최적화가 포함되어 지연 시간과 비용을 최대 3~5배까지 절감할 수 있습니다. 최적화된 LLM Serving을 사용하는 방법은 매우 간단합니다. 모델을 OSS 또는 미세 조정된 가중치와 함께 제공하기만 하면 나머지 작업은 최적화된 성능으로 모델이 제공되도록 자동으로 처리됩니다. 따라서 모델 최적화를 위한 low 레벨 라이브러리를 작성하는 대신 LLM을 애플리케이션에 통합하는 데 집중할 수 있습니다. 데이터브릭스 모델 서빙은 MPT 및 Llama2 클래스 모델을 자동으로 최적화하며, 향후 더 많은 모델을 지원할 예정입니다.

레이크하우스 AI 통합을 통한 배포 가속화

LLM을 프로덕션할 때는 단순히 모델을 배포하는 것만이 아닙니다. Retrieval Augmented Generation(RAG), Parameter-Efficient Fine-Tuning(PEFT) 또는 표준 미세 조정과 같은 기술을 사용하여 모델을 보완해야 합니다. 또한 LLM의 품질을 평가하고 성능과 안전성을 위해 모델을 지속적으로 모니터링해야 합니다. 이로 인해 팀은 서로 다른 툴을 통합하는 데 상당�한 시간을 소비하게 되고, 이로 인해 운영 복잡성이 증가하고 유지 관리 오버헤드가 발생하게 됩니다.

데이터브릭스 모델 서빙은 통합 데이터 및 AI 플랫폼을 기반으로 구축되어 데이터 수집 및 미세 조정부터 배포 및 모니터링에 이르는 전체 LLM을 단일 플랫폼에서 관리할 수 있으며, AI 수명 주기 전반에 걸쳐 일관된 뷰를 생성하여 배포를 가속화하고 오류를 최소화할 수 있습니다. 모델 서빙은 레이크하우스 내의 다양한 LLM 서비스와 통합됩니다:

- 미세 조정: 레이크하우스에서 직접 독점 데이터로 기본 모델을 미세 조정하여 정확도를 높이고 차별화할 수 있습니다.

- 벡터 검색 통합: 검색 증강 생성 및 시맨틱 검색 사용 사례를 위해 벡터 검색을 통합하고 원활하게 수행하세요. 여기에서 미리 보기에 등록하세요.

- 내장 LLM 관리: 모든 LLM 호출을 위한 중앙 API 계층으로 데이터브릭스 AI 게이트웨이와 통합됩니다.

- MLflow: MLflow의 PromptLab을 통해 LLM을 평가, 비교 및 관리하세요.

- 품질 및 진단: 델타 테이블에서 요청과 응답을 자동으로 캡처하여 모델을 모니터링하고 디버그할 수 있습니다. 또한 Labelbox와의 파트너십을 통해 이 데이터를 레이블과 결합하여 학습 데이터 세트를 생성할 수 있습니다.

- 통합 거버넌스: 모델 서빙에서 소비 및 생성된 에셋을 포함한 모든 데이터와 AI 에셋을 Unity 카탈로그로 관리하고 거버넌스하세요.

LLM 서비스에 안정성과 보안 제공

데이터브릭스 모델 서빙은 데이터, 모델, 배포 구성을 완벽하게 제어하면서 대규모 추론을 지원하는 전용 컴퓨팅 리소스를 제공합니다. 선택한 클라우드 리전에서 전용 용량을 확보하면 오버헤드 지연 시간이 짧고, 예측 가능한 성능과 SLA가 보장되는 이점을 누릴 수 있습니다. 또한 서비스 워크로드는 여러 계층의 보안으로 보호되므로 가장 민감한 작업도 안전하고 신뢰할 수 있는 환경을 보장합니다. 규제가 엄격한 업계의 고유한 규정 준수 요구 사항을 충족하기 위해 여러 가지 제어 기능을 구현했습니다. 자세한 내용은 이 페이지를 방문하거나 데이터브릭스 계정 팀에 문의하세요.