Unity Catalog와 Delta Sharing을 이용하여 여러 클라우드와 지역에 걸쳐 사이버 보안 데이터 관리하기

(번역: Youngkyong Ko) Original Blog Post

Enterprise Search Group의 2023년 보고서에 따르면, 85%의 조직이 2개 이상의 IaaS 제공업체에 애플리케이션을 배포한다고 답해 멀티 클라우드 시대가 공식적으로 도래했음을 입증했습니다. 이러한 분산형 모델을 구성하는 일반적인 이유는 데이터 보존 요건에 따라 데이터가 특정 지역에 로컬로 유지되어야 하는 경우가 많기 때문입니다. 예를 들어 독일과 프랑스의 국가 데이터 레지던시 법은 특정 민감한 데이터(예: 건강, 금융)를 해당 국가 내에 보관하도록 의무화하고 있습니다. 조직이 온프레미스와 클라우드 모두에서 시스템을 관리해야 하는 상황이 되면서 데이터 보존 요건은 더욱 복잡해집니다.

사이버 보안 운영을 위해 관련 팀은 여러 클라우드와 지역에 있는 애플리케이션과 인프라에서 생성되는 로그와 메트릭을 모니터링해야 합니다. 클라우드 제공업체가 부과하는 데이터 전송 비용으로 인해 데이터를 단일 물리적 위치로 통합하는 것은 데이터 집약적인 조직에서는 실현하기 어려운 일입니다.

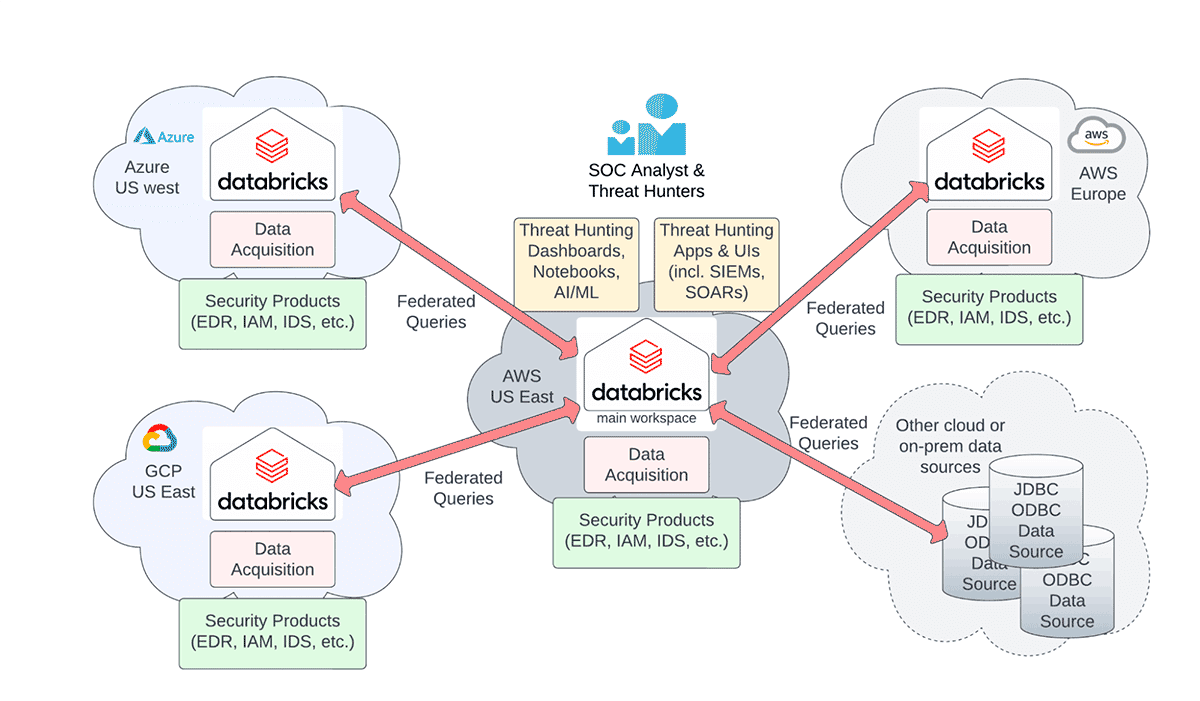

이전 블로그 'Cybersecurity in the Era of Multiple Clouds & Regions'에서는 데이터 주권법을 준수하고 전송 비용을 최소화하면서 여러 클라우드와 지역에서 사이버 보안 로그를 쿼리하는 문제를 해결하기 위한 쿼리 페더레이션 접근 방식을 강조했습니다(아래 그림 참조). 하지만 여전히 해결해야 할 데이터 거버넌스 영역이 세 가지 더 남아 있었습니다:

- 여러 데이터브릭스 워크스페이스에서 테이블 페더레이션을 쉽게 구

- 페더레이션된 테이블에 대한 액세스 제어 관리를 쉽게 구현

- 페더레이션을 코드로 배포하는 방식(federation as code)을 쉽게 구현

이 블로그에서는 Unity Catalog, Delta Sharing과 Lakehouse Federation을 이용하여 데이터브릭스 레이크하우스 플랫폼에서 멀티 클라우드, 멀티 지역 사이버 보안 기능을 쉽게 구성하고 클라우드와 지역에 관계없이 모든 사이버 보안 데이터를 손쉽게 거버넌스하는 방법을 설명합니다.

여기서는 구체적인 활용 사례로 사이버 보안 위협 헌팅을 예로 들지만, 이 블로그에서 설명하는 접근 방식은 서로 다른 클라우드, 서로 다른 지역, 서로 다른 데이터 저장소에 사일로화된 모든 유형의 엔터프라이즈 데이터에 광범위하게 적용할 수 있습니다. 멀티 클라우드 및 멀티 리전 데이터 거버넌스는 위험 기반 제어(risk-based control)를 유지하면서도 사일로화된 엔터프라이즈 데이터의 가치를 실현하는 열쇠입니다. 실제로 AWS MIT CDO Agenda 2023 Report에 따르면, CDO의 45%가 엔터프라이즈 데이터에서 가치를 창출하기 위한 여정에서 최우선 순위로 '명확하고 �효과적인 데이터 거버넌스 구축'을 꼽았습니다.

위에서 설명한 거버넌스 과제를 해결하기 위해 다음과 같은 방법을 시연합니다.

- Delta Sharing 이용하여 여러 데이터브릭스 워크스페이스의 테이블들을 원활하게 페더레이션할 수 있습니다

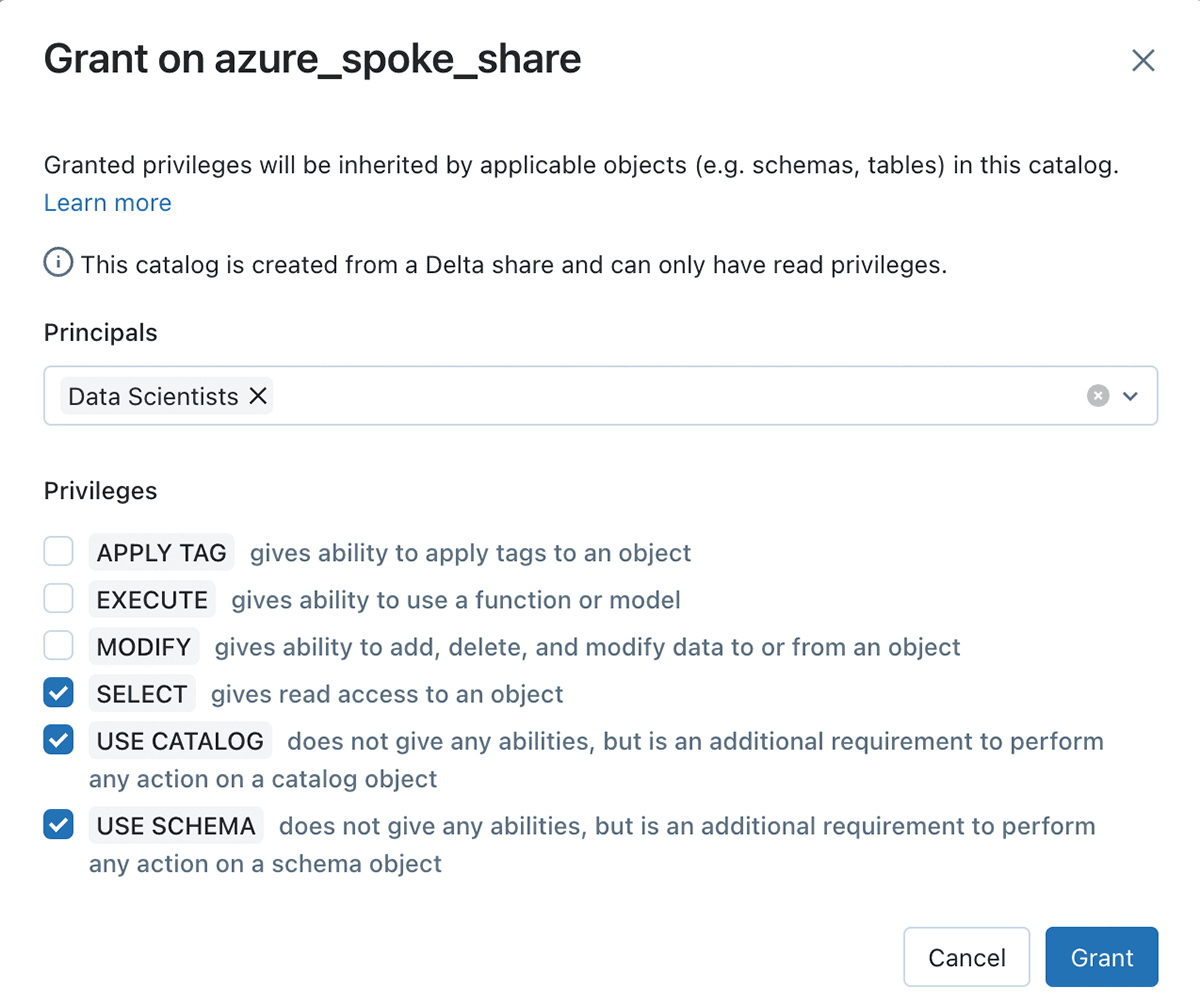

- Unity Catalog를 이용하여 페더레이션된 테이블에 대한 액세스 제어를 쉽게 관리할 수 있습니다.

- 테라폼 기반 배포 프레임워크를 사용하여 페더레이션을 코드로 배포할 수 있습니다.

거버넌스는 목적을 위한 수단일 뿐입니다. 이 데모에서는 이러한 기능들을 함께 이용하여 클라우드와 여러 지역에 분산 로깅 기능을 배포하는 동시에, 보안 분석가가 위협 탐지 및 헌팅을 위해 데이터를 중앙에서 관리하고 쿼리할 수 있도록 지원하는 방법을 보여줍니다. 이 데모는 위협 탐지 규칙 또는 AI 모델의 기본 구성 요소인 분산 침해 지표(IOC) 매칭 사용 사례를 기반으로 합니다. 데이터브릭스에서는 이미 IOC 사용 사례를 구현하는 솔루션 액셀러레이터를 제공하고 있으며, 레이크하우스 페더레이션 서비스를 활용하여 클라우드 간 쿼리(cross-cloud query)를 쉽게 통합할 수 있도록 구현해 왔습니다.

멀티 클라우드 아키텍처 구축하기

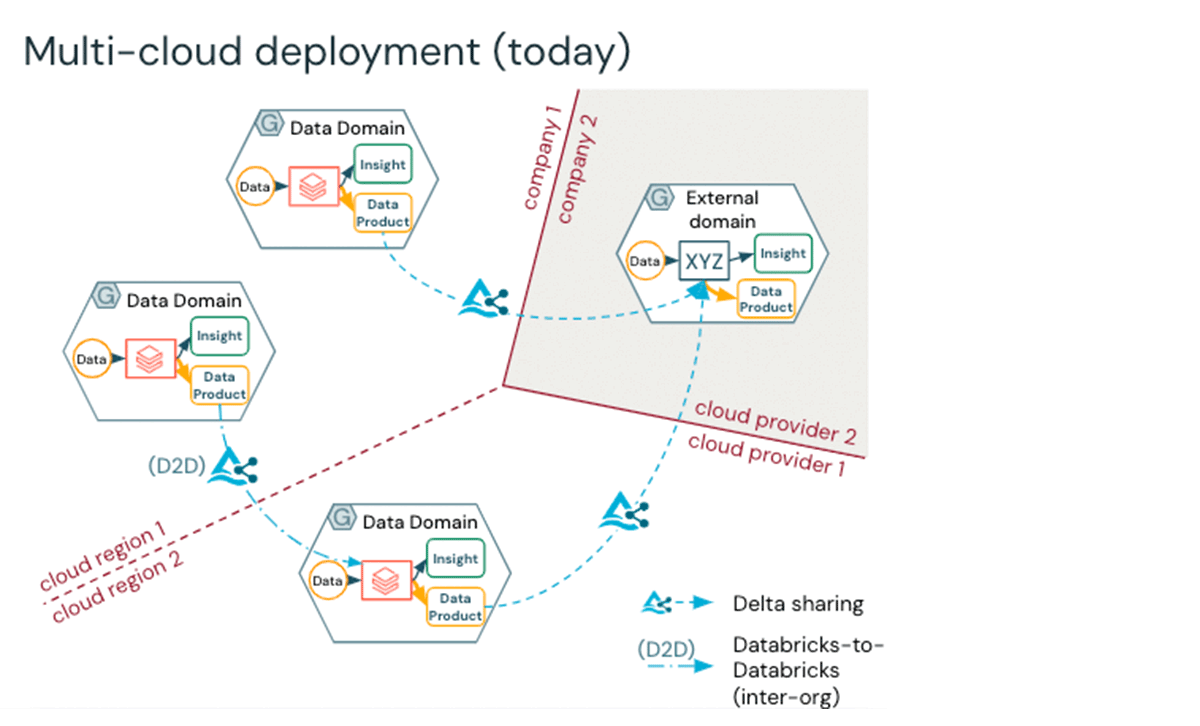

이 블로그의 나머지 부분에서는 산업별 Lakehouse Blueprints와 테라폼을 활용하여 몇 분 안에 멀티 클라우드, 멀티 리전 데이터브릭 환경을 빠르게 설정하는 방법을 보여드리겠습니다. Delta Sharing은 멀티 클라우��드 데이터 액세스 패턴의 기반이며, 아래에서는 이를 메시 형태로 표현했습니다. Unity Catalog를 사용하여 데이터를 관리할 때 얻을 수 있는 핵심 이점은 다음과 같습니다:

- 데이터에 정교한 액세스 제어 적용

- end-to-end 데이터 계보 이해

- 간단하고 끊김없는 방식으로 데이터 배포 가능

데이터가 Delta share라는 컨테이너에 담기면 엔터프라이즈 거버넌스 팀은 공유 데이터에 대한 액세스를 관리할 수 있습니다. 또한 허브 앤 스포크(hub-and-spoke) 아키텍처와 같이 데이터가 중앙 집중화되면 데이터를 통합하는 메인 허브에서 액세스 제어를 적용하여 전사적으로 데이터를 보호합니다.

1단계 - 기존 사이버 카탈로그에서 테이블 가져오기

IOC 매칭을 위한 사이버 소스 테이블에 대한 기존 카탈로그가 있다고 가정하면(예: IOC 매칭 솔루션의 DNS, HTTP 로그 데이터), 데이터 소스 변수를 사용하여 이를 로드하면 나중에 Delta Share 개체를 만들 수 있습니다.

산업을 재편하는 데이터 인텔리전스

2단계 - 사이버 blueprint 모듈을 호출하여 IOC, IDS 및 기타 데이터 소스의 공유 생성을 자동화

데이터 유출 방지 hub and spoke 모델을 기반으로 모든 스포크 워크스페이스를 연결할 수 있는 모듈을 만들었습니다. 이 모듈을 사용하려면 hub and spoke 워크스페이스에서 검색한 글로벌 메타스토어 ID가 필요합니다.

3단계 - 미리 생성된 공유를 사용하여 여러 클라우드에 걸쳐 쿼리 페더레이션하기

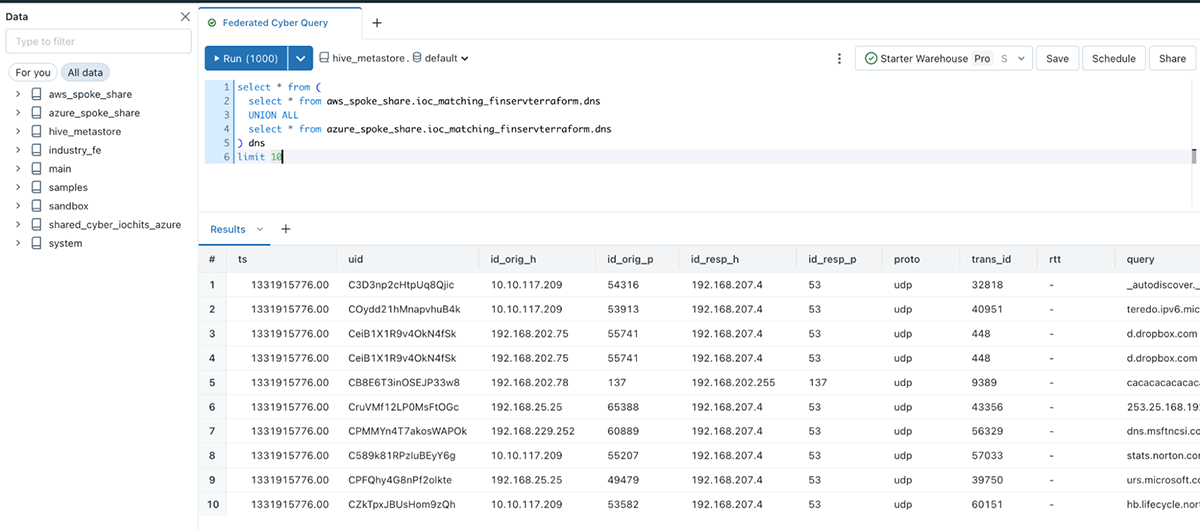

One of the major challenges to federate queries for cybersecurity use cases is cross-cloud querying. Organizations want to avoid replicating data across clouds, which incurs high costs both from the data movement and the egress cost perspective. For this reason, it is ideal to query the data in place where it lives. We called out some of these challenges from the cyber log data perspective in the IOC matching accelerator.사이버 보안 사용 사례에 대한 쿼리 페더레이션의 주요 난제 중 하나는 클라우드 간 쿼리(cross-cloud query)입니다. 기업은 데이터 이동과 송신 비용 측면에서 모두 높은 비용이 발생하는 클라우드 간 데이터 복제를 피하고 싶어합니다. 따라서 데이터가 있는 곳에서 데이터를 쿼리하는 것이 이상적입니다. 우리는 IOC 매칭 가속기에서 아래와 같은 사이버 로그 데이터 관점의 도전과제를 해결해야 했습니다.

- 로그 데이터를 단일 작업 공간으로 통합하는 것은 데이터 주권 규정으로 인해 불가능합니다.

- 한 클라우드 또는 지역에서 중앙 작업 공간으로 데이터를 통합하는 데 드는 데이터 전송 비용이 매우 큽니다.

이 페더레이션 패턴에서는 데이터가 있는 위치를 참조하고, 데이터 접근이 필요한 위협 헌터와 데이터 과학자들에게만 액세스를 허용하도록 설정합니다. 예를 들어, 델타 쉐어에 해당하는 카탈로그는 일반적인 ANSI SQL 액세스 제어로 제어할 수 있습니다.

Delta Sharing 패러다임을 사용하여 기존 사이버 IOC 매칭 가속기에서 아래 단계들을 생략할 수 있게 됩니다:

- Simba 드라이버 jar 경로가 포함된 초기화 스크립트 설정

- 클러스터에서 기존 ODBC 바이너리 유효성 검사

- 개인 액세스 토큰(Personal Access Token) 관리

- 페더레이션을 실행하기 위해 컴퓨팅 클러스터에서 ODBC 설정

- 자격 증명(credential)을 사용하여 외부 테이블 생성

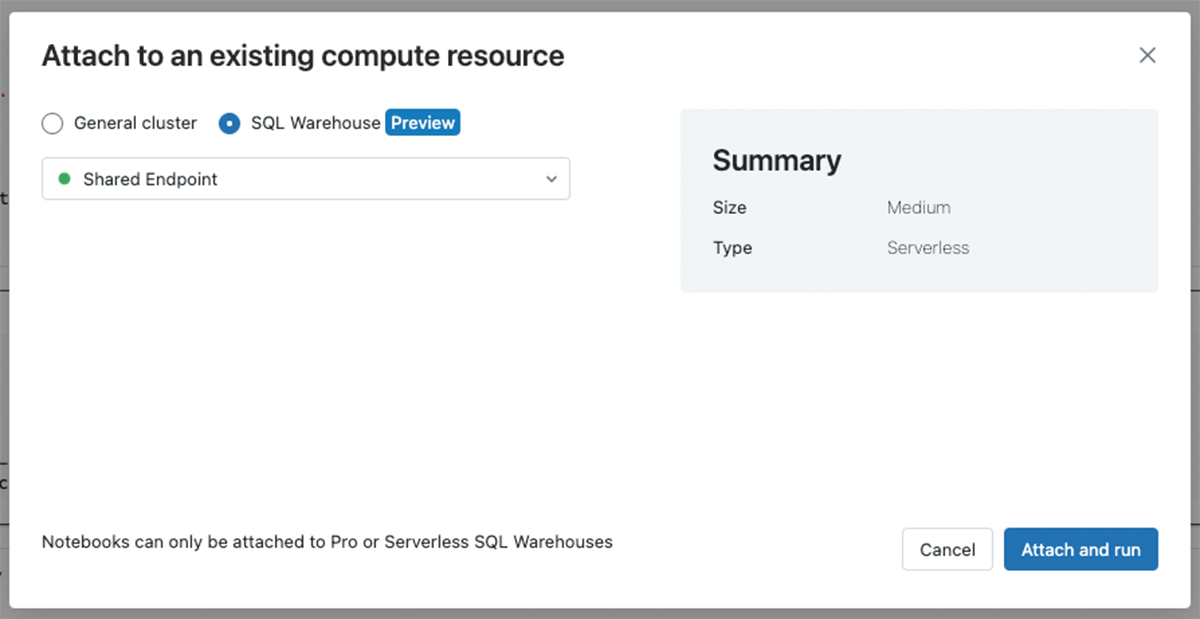

Now, you can just query tables in place from your existing catalog. Below, we are seeing the result of applying our automation - querying all Delta shared log tables from the hub workspace, which runs against Serverless compute for simplified security and data access. 이제 기존 카탈로그에서 테이블을 쿼리할 수 있습니다. 위와 같이 자동화를 적용하여 허브 워크스페이스에서 Delta share로 공유된 모든 로그 테이블을 쿼리할 수 있도록 한 결과를 아래에서 볼 수 있습니다. 이 작업은 서버리스 컴퓨트 클러스터를 이용하여 보안과 데이터 접근을 간소화했습니다.

데이터 액세스를 대폭 간소화하고 값비싼 데이터 복사 단계를 생략했습니다. 이 외에도 데이터 공유를 쉽게 지원하는 개방적이고 확장 가능한 형식인 Delta Lake를 통해 이 모든 작업을 수행했습니다.

결론

오늘날 멀티 클라우드는 중요한 기로에 서 있습니다. 고객은 복제 비용, 클라우드 데이터 저장소 종속성, 데이터 관리 전략 사이에서 균형을 맞추고 있습니다. 데이터 로컬리티가 중요한 사이버 보안 사용 사례의 경우, 공유 전략을 신중하게 실행해야 합니다. 여기에는 총소유비용(TCO), 쿼리 페더레이션, 거버넌스가 중요한 요소입니다.

TCO ensures customers keep costs in line, particularly in enhancing security measures. Query federation is vital for real-time threat analysis, all while avoiding the security risks associated with copying data across geographic boundaries. Finally, stringent governance protocols ensure that all data sharing complies with regional and global security regulations. These three tenets are non-negotiable for securing a multi-cloud environment effectively and efficiently and are enabled by Unity Catalog and Delta Sharing, as shown above. Discover the Cybersecurity Lakehouse solutions to understand how to enable more use cases in the cybersecurity ecosystem today. TCO는 고객이 특히 보안 조치를 강화하는 데 드는 비용을 적절하게 유지하도록 보장합니다. 쿼리 페더레이션은 실시간 위협 분석에 필수적이며, 동시에 지리적 경계를 넘어 데이터를 복사하는 것과 관련된 보안 위험을 방지합니다. 마지막으로, 엄격한 거버넌스 프로토콜은 모든 데이터 공유가 지역 및 글로벌 보안 규정을 준수하도록 보장합니다. 이 세 가지 원칙은 멀티 클라우드 환경을 효과적이고 효율적으로 보호하는 데 있어 타협할 수 없는 원칙이며, 위에서 살펴본 바와 같이 Unity Catalog와 Delta Sharing을 통해 구현됩니다. 오늘날 사이버 보안 에코시스템에서 활용되는 다양한 사례들을 Cybersecurity Lakehouse 솔루션에서 보실 수 있습니다.

더 자세한 내용은 "멀티 클라우드 및 지역 시대의 사이버 보안" 블로그에서 확인할 수 있습니다.

게시물을 놓치지 마세요

다음은 무엇인가요?

공공 부문

2026년 2월 12일/1분 이내 소요