TOP 팀들은 지능형 데이터 파이프라인으로 성공합니다데이터 파이프라인의 모범 사례, 코딩화

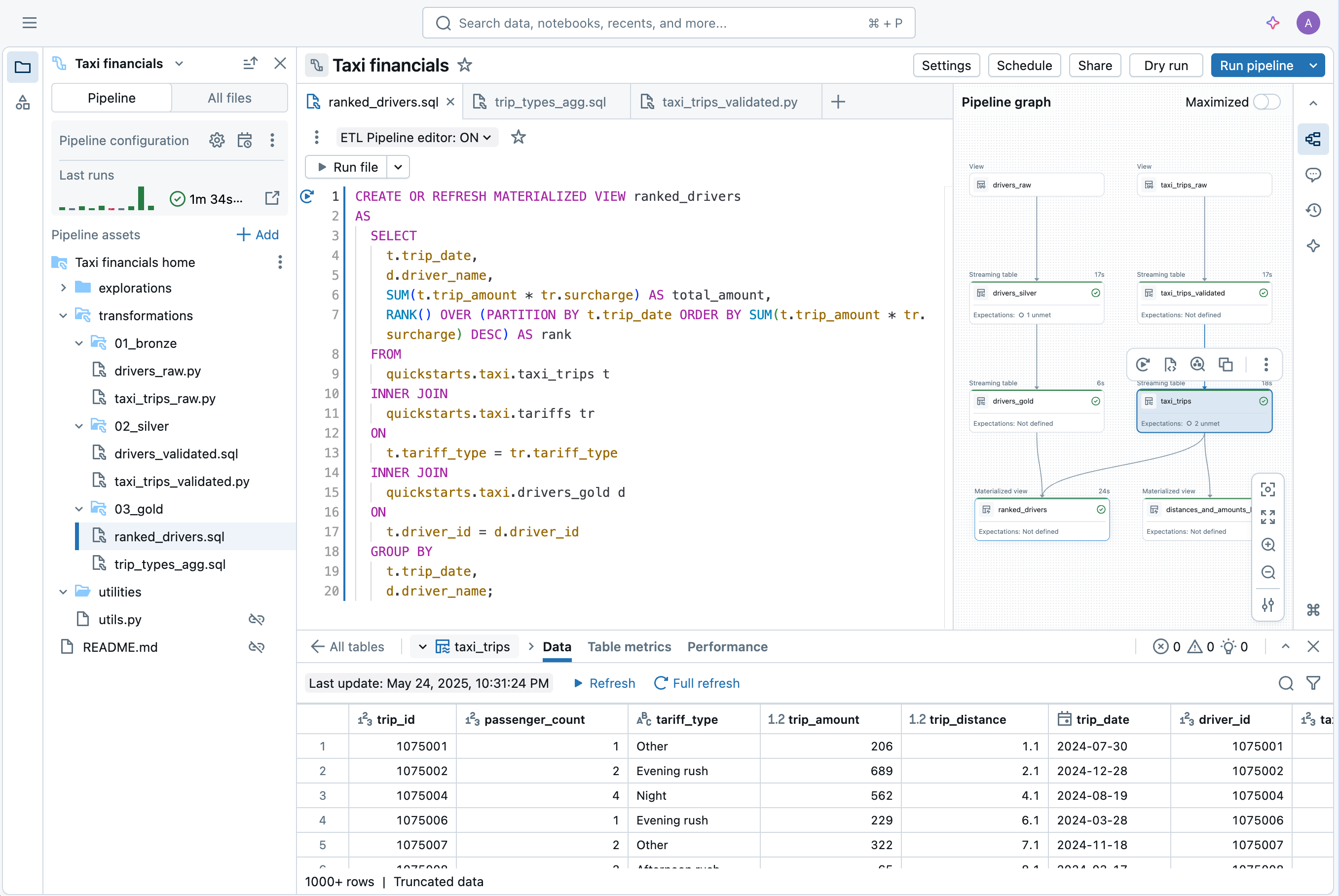

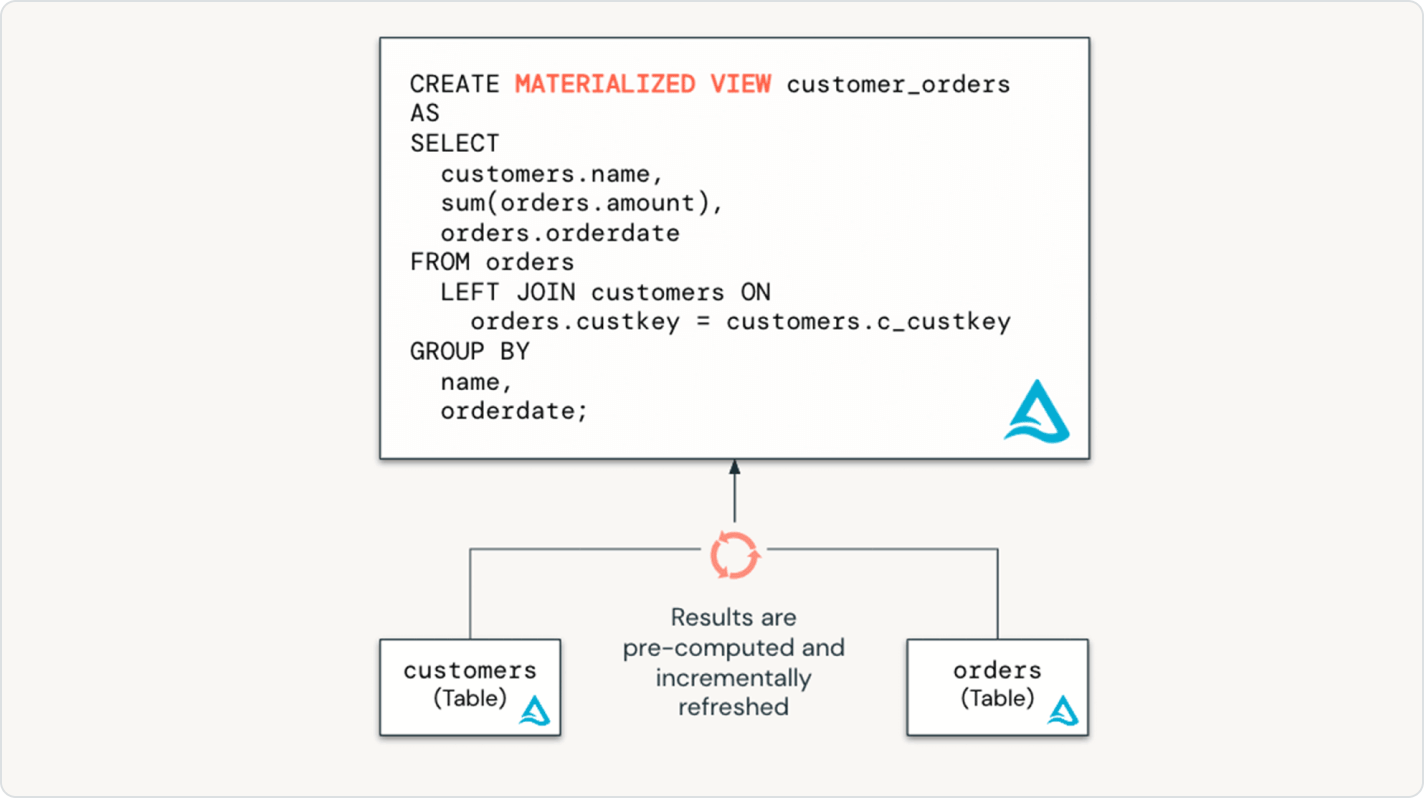

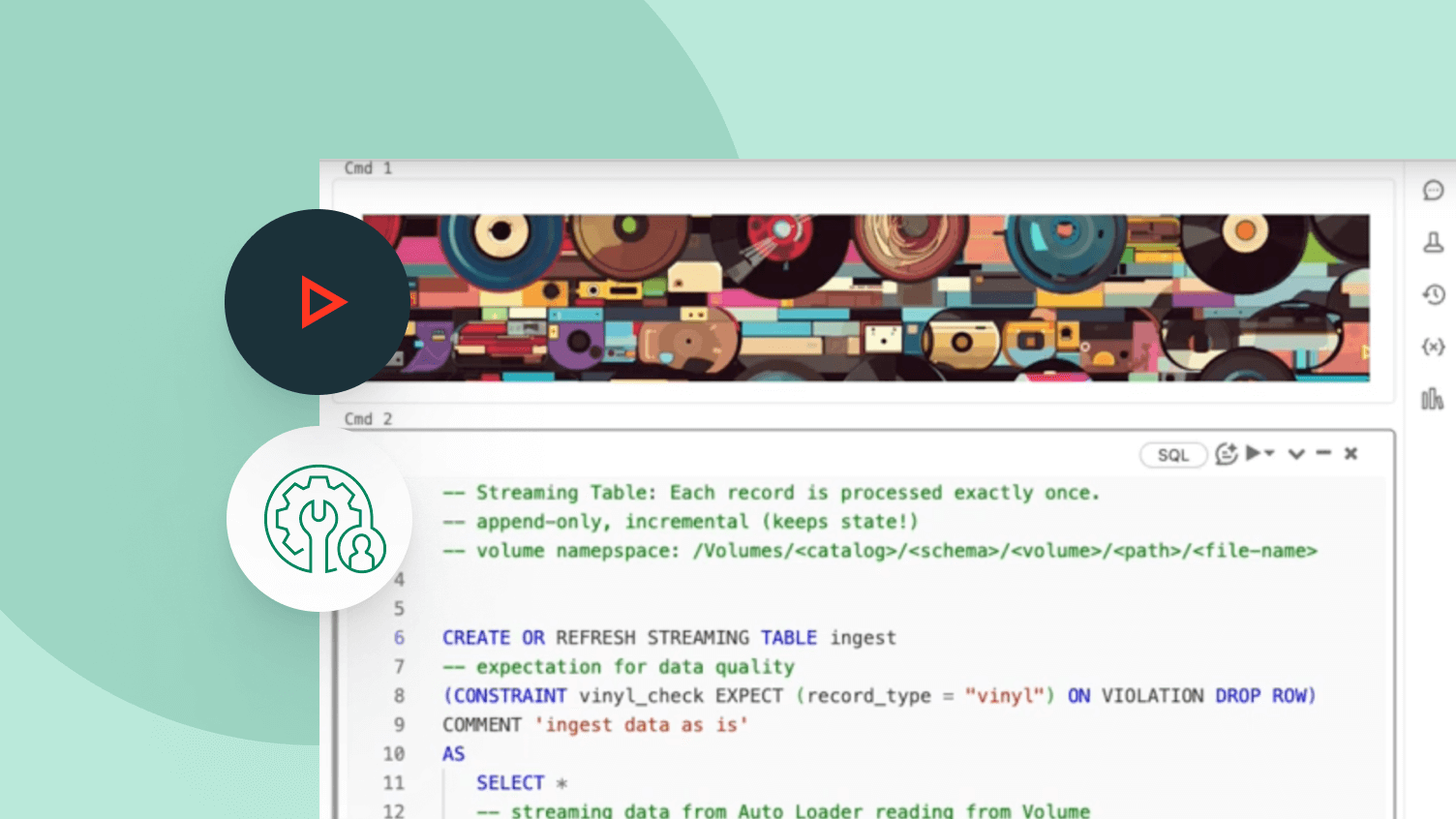

필요한 데이터 변환을 간단히 선언하십시오 - Spark 선언형 파이프라인이 나머지를 처리합니다.데이터 파이프라이닝을 단순화하기 위해 구축됨

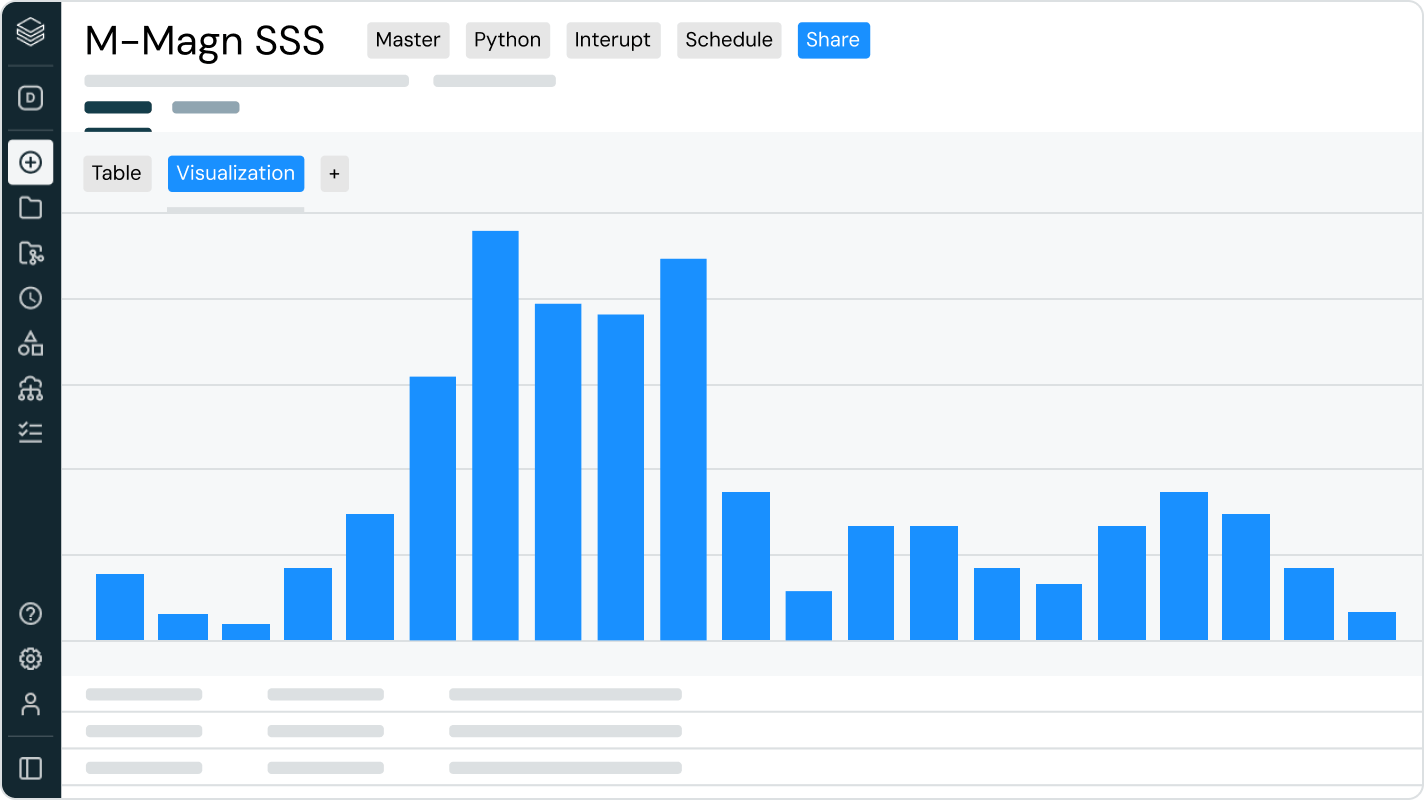

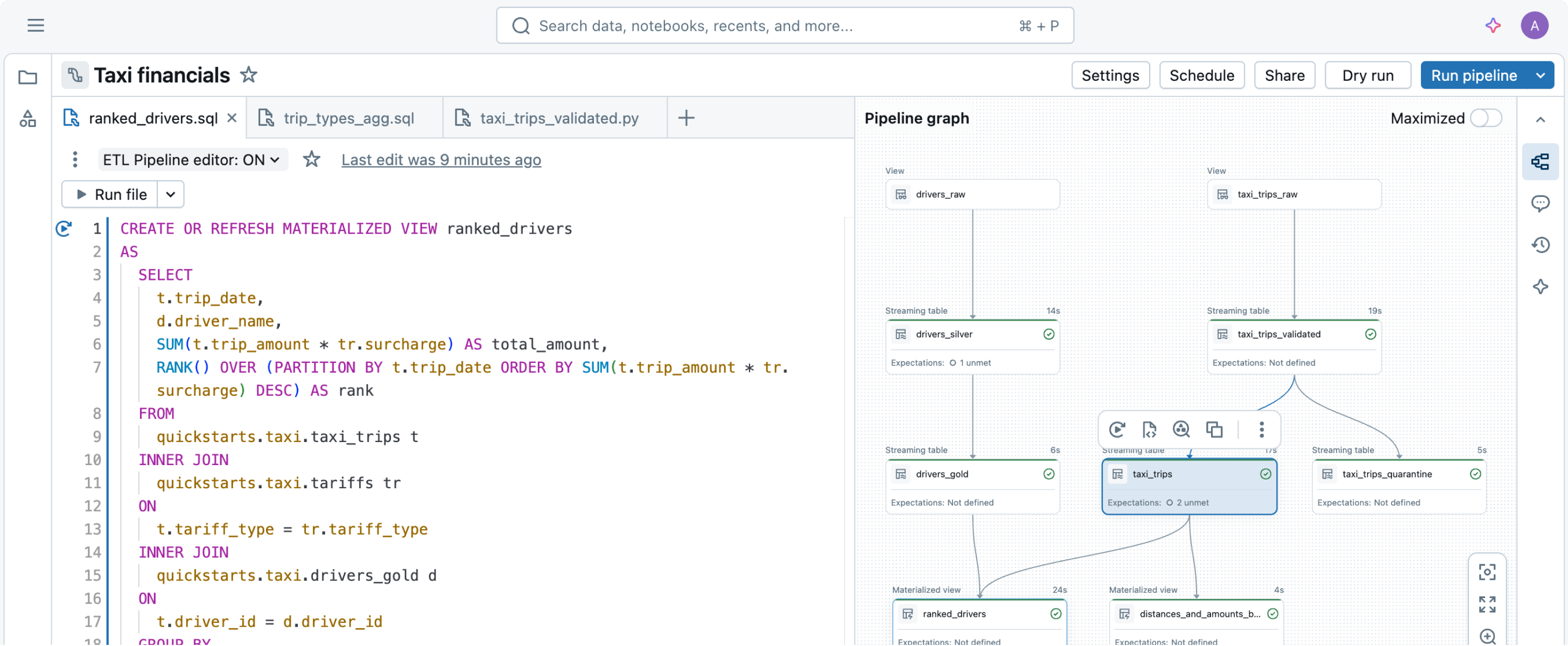

데이터 파이프라인을 구축하고 운영하는 것은 어려울 수 있지만, 그렇게 되지 않아도 됩니다. Spark 선언형 파이프라인은 강력한 단순성을 위해 만들어졌으므로, 몇 줄의 코드만으로 강력한 ETL을 수행할 수 있습니다.

기타 기능

데이터 파이프라인을 간소화하세요

Spark 선언형 파이프라인 데모 탐색

사용량 기반 가격 책정으로

지출 통제

사용 제품에 대해 초 단위로 지불합니다.더 자세히 알아보기

데이터 인텔리전스 플랫폼에서 다른 통합된 지능형 제공을 탐색하세요.LakeFlow Connect

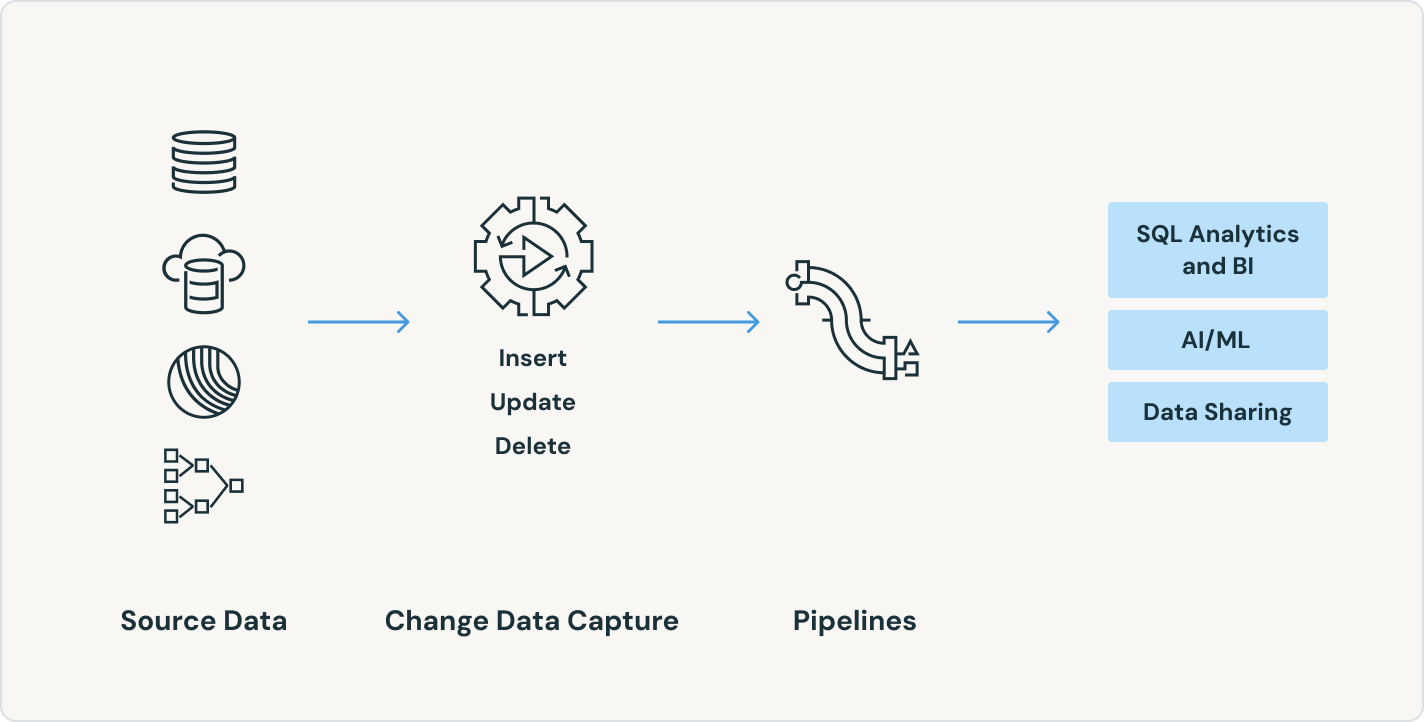

어떤 소스에서든 효율적인 데이터 수집 커넥터와 데이터 인텔리전스 플랫폼과의 기본 통합은 통합된 거버넌스와 함께 분석 및 AI에 쉽게 접근할 수 있게 해줍니다.

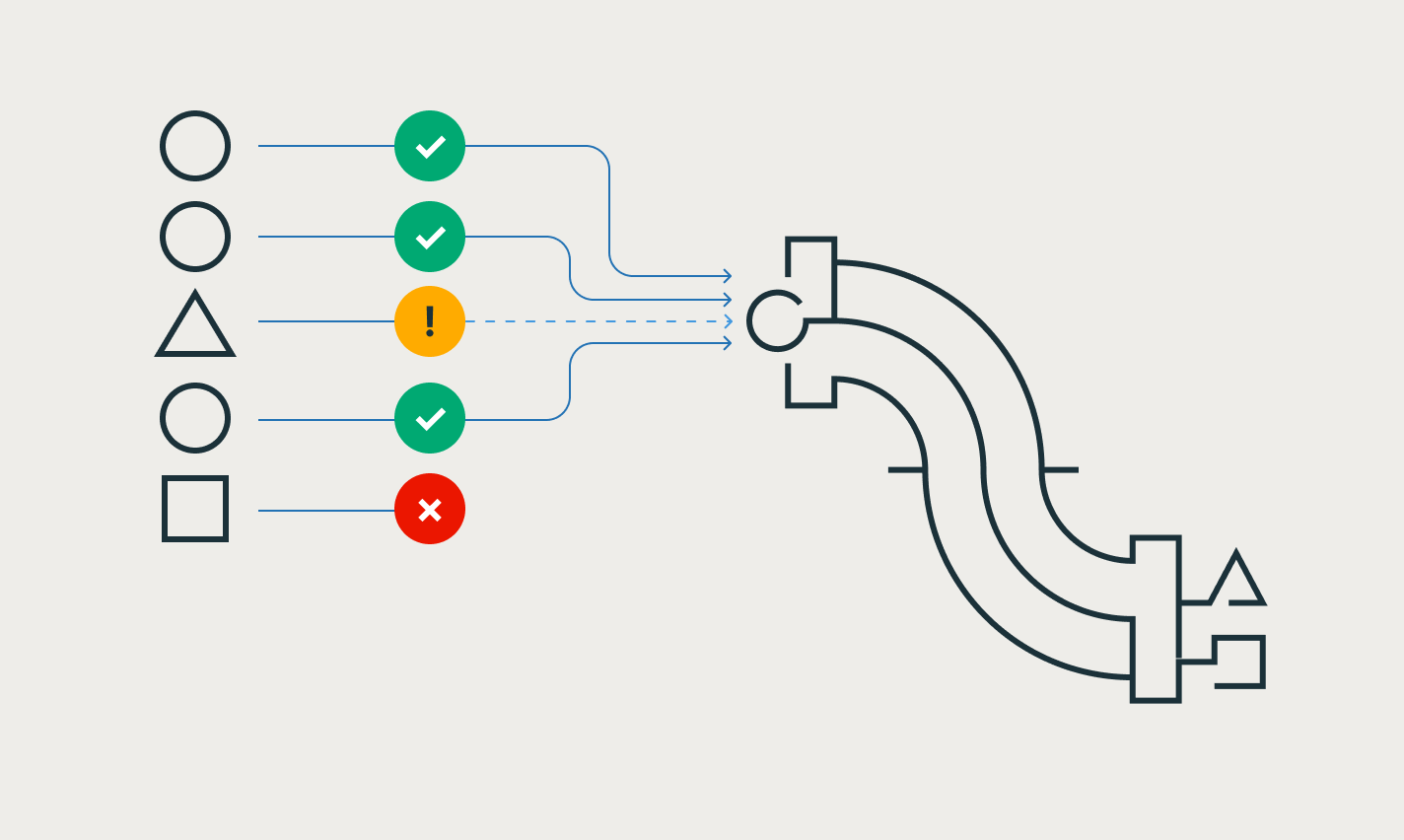

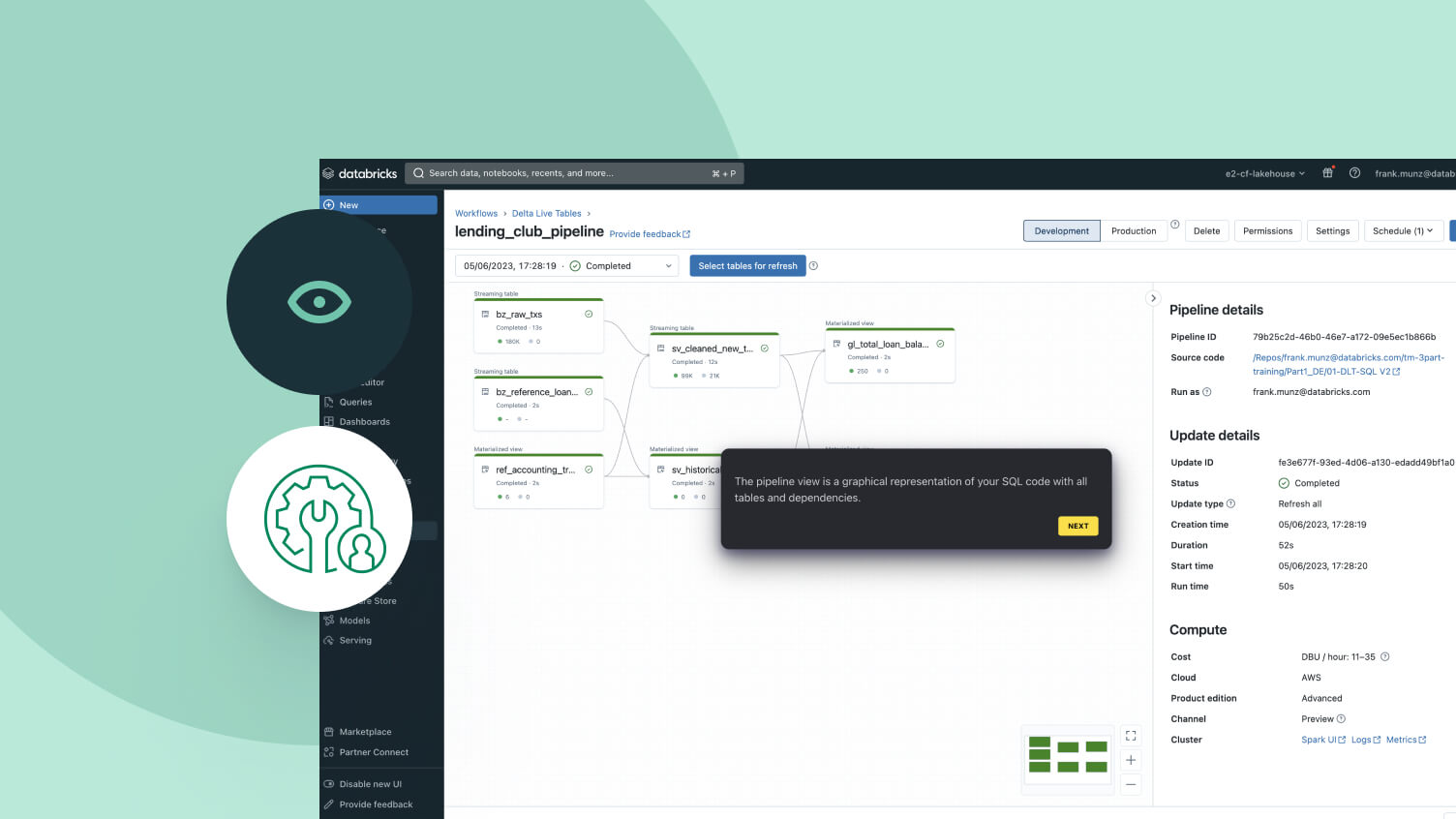

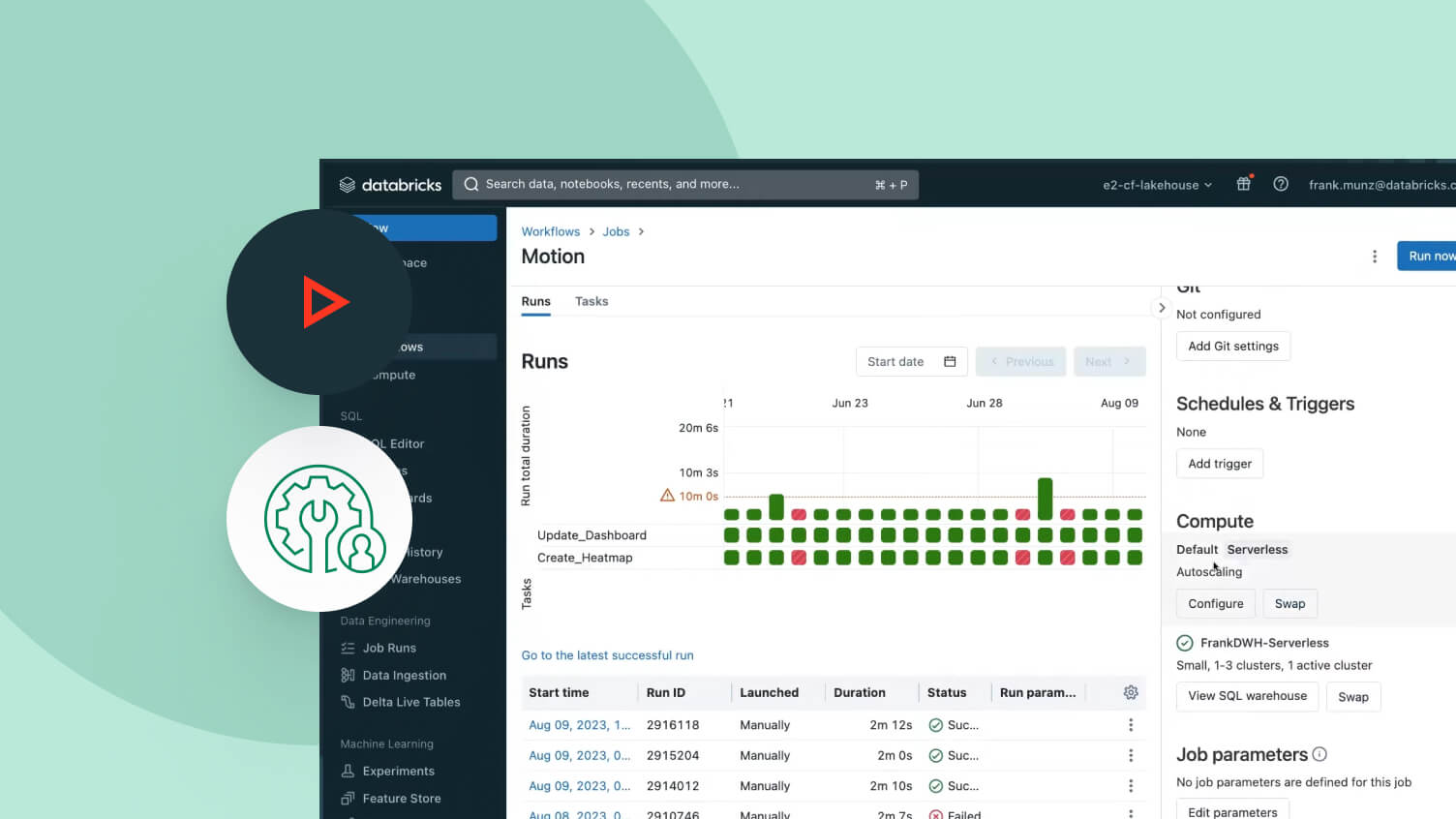

Lakeflow 작업

ETL, 분석 및 머신러닝 파이프라인��에 대한 다중 작업 워크플로우를 쉽게 정의, 관리 및 모니터링합니다. 데이터 팀은 다양한 지원 작업 유형, 심층적인 관측 기능 및 높은 안정성을 기반으로 모든 파이프라인을 보다 효과적으로 자동화 및 오케스트레이션하고 생산성을 높일 수 있습니다.

레이크하우스 스토리지

레이크하우스의 모든 형식과 유형의 데이터를 통합하여 모든 분석 및 AI 작업에 사용합니다.

Unity Catalog

업계 유일의 통합된 오픈 거버넌스 솔루션을 통해 모든 데이터 자산을 원활하게 관리하십시오. 이 솔루션은 Databricks Data Intelligence Platform에 내장되어 있습니다.

Data Intelligence Platform

Databricks Data Intelligence Platform을 통해 데이터 및 AI 워크로드를 지원하는 방법에 대해 자세히 알아보세요