몇 가지 간단한 단계로 데이터에��서 가치를 찾아내세요

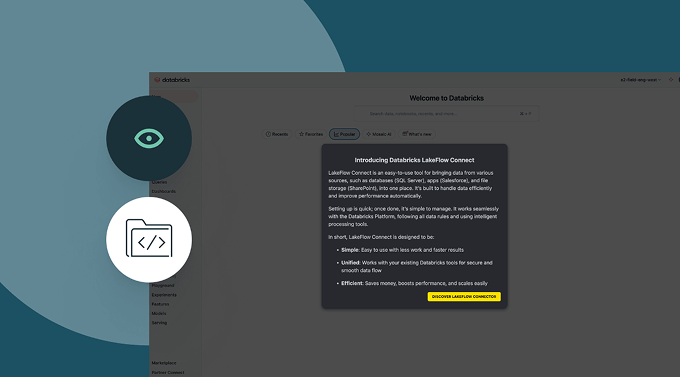

인기 있는 엔터프라이즈 애플리케이션, 파일 소스 및 데이터베이스를 위한 내장 데이터 커넥터가 제공됩니다.인기 있는 데이터 소스에 대한 강력한 수집 기능

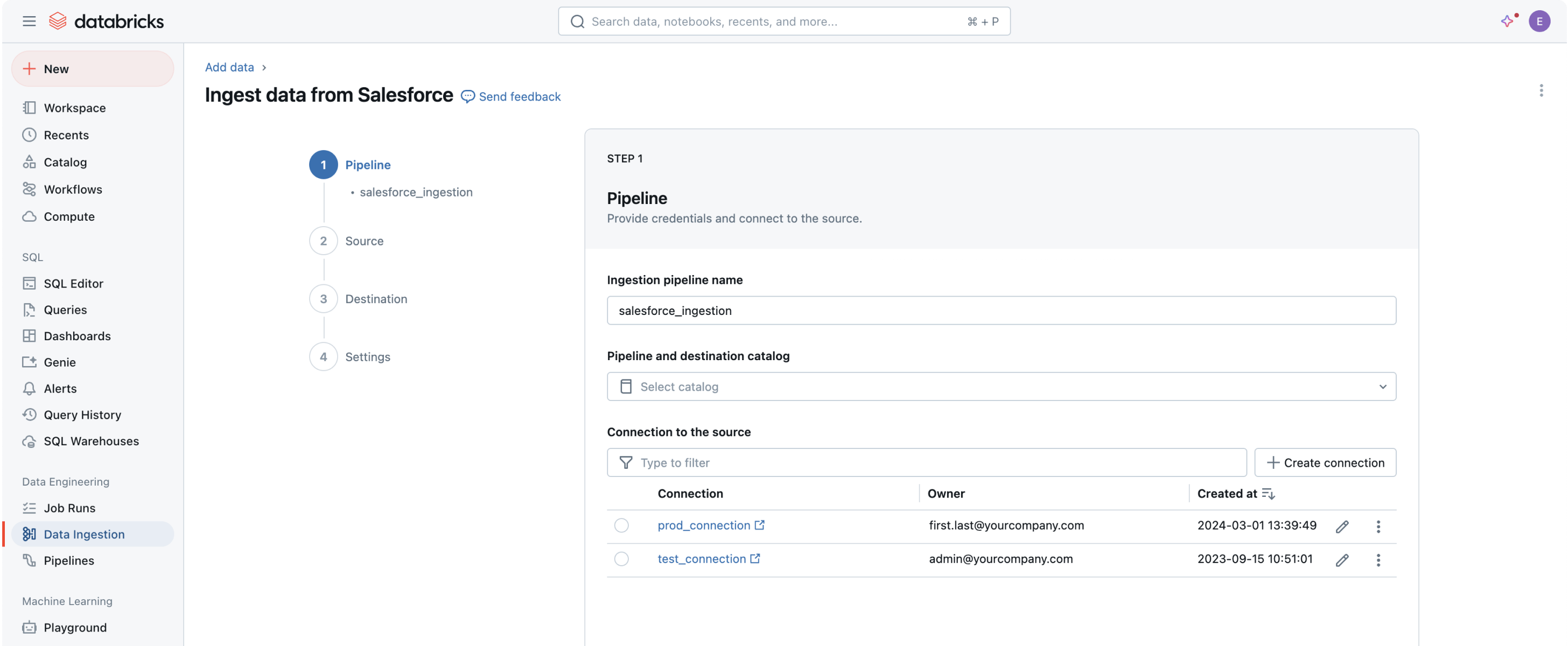

모든 데이터를 데이터 인텔리전스 플랫폼에 가져오는 것은 가치를 추출하고 귀사의 가장 도전적인 데이터 문제를 해결하는 첫 단계입니다.코드 없는 사용자 인터페이스(UI) 또는 간단한 API는 데이터 전문가가 자체 서비스를 제공하게 하여 프로그래밍 시간을 절약합니다.

Databricks를 이용한 데이터 인제스션

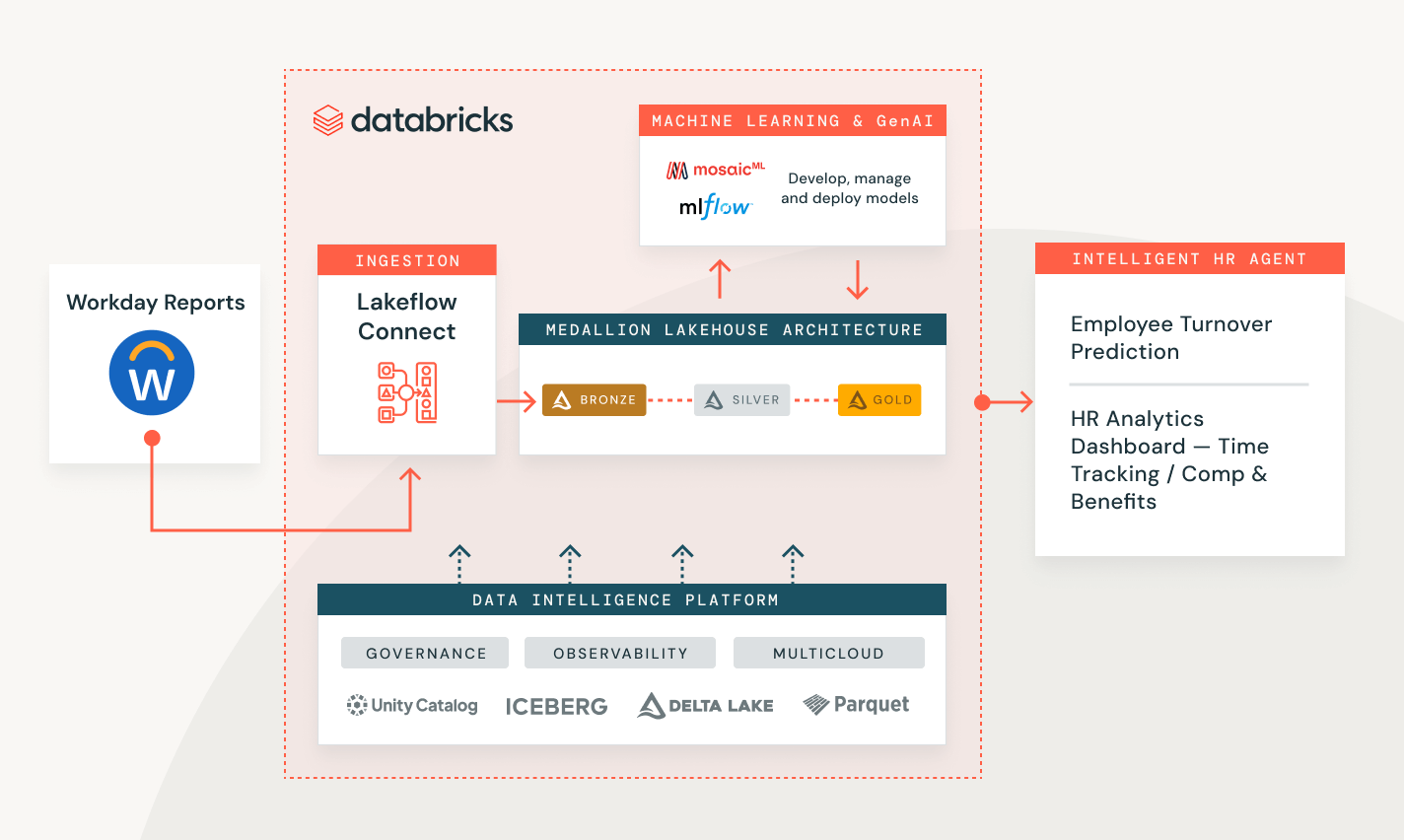

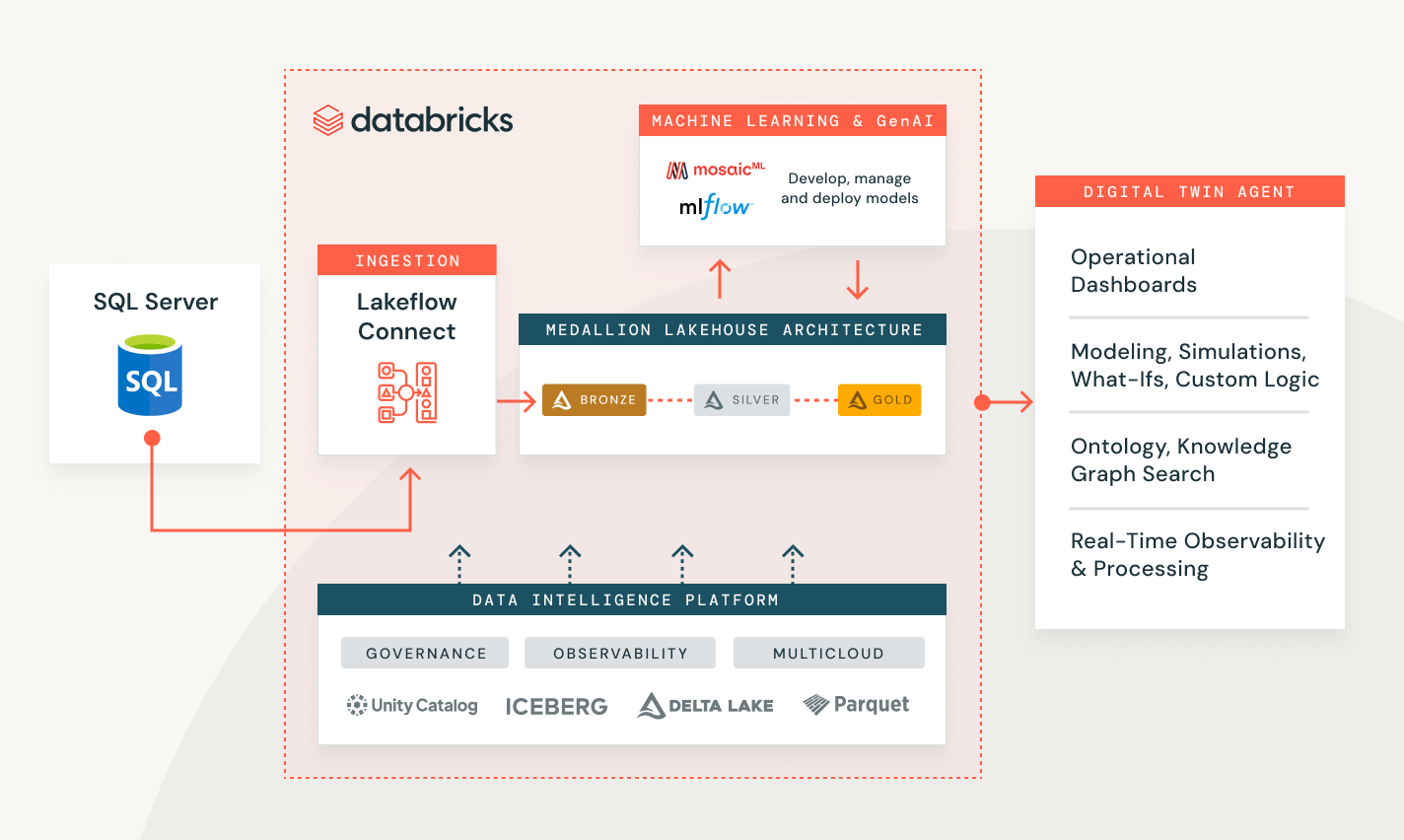

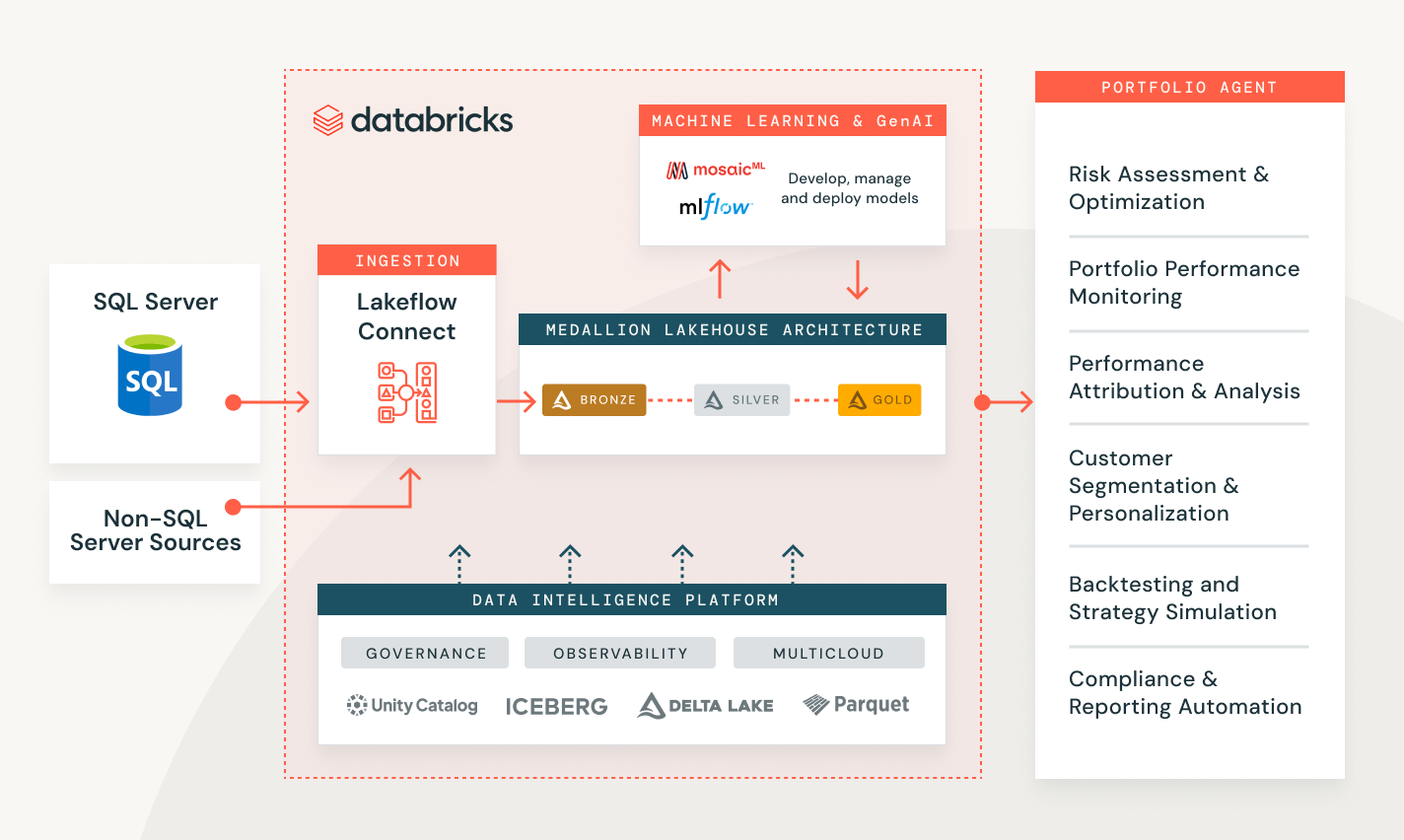

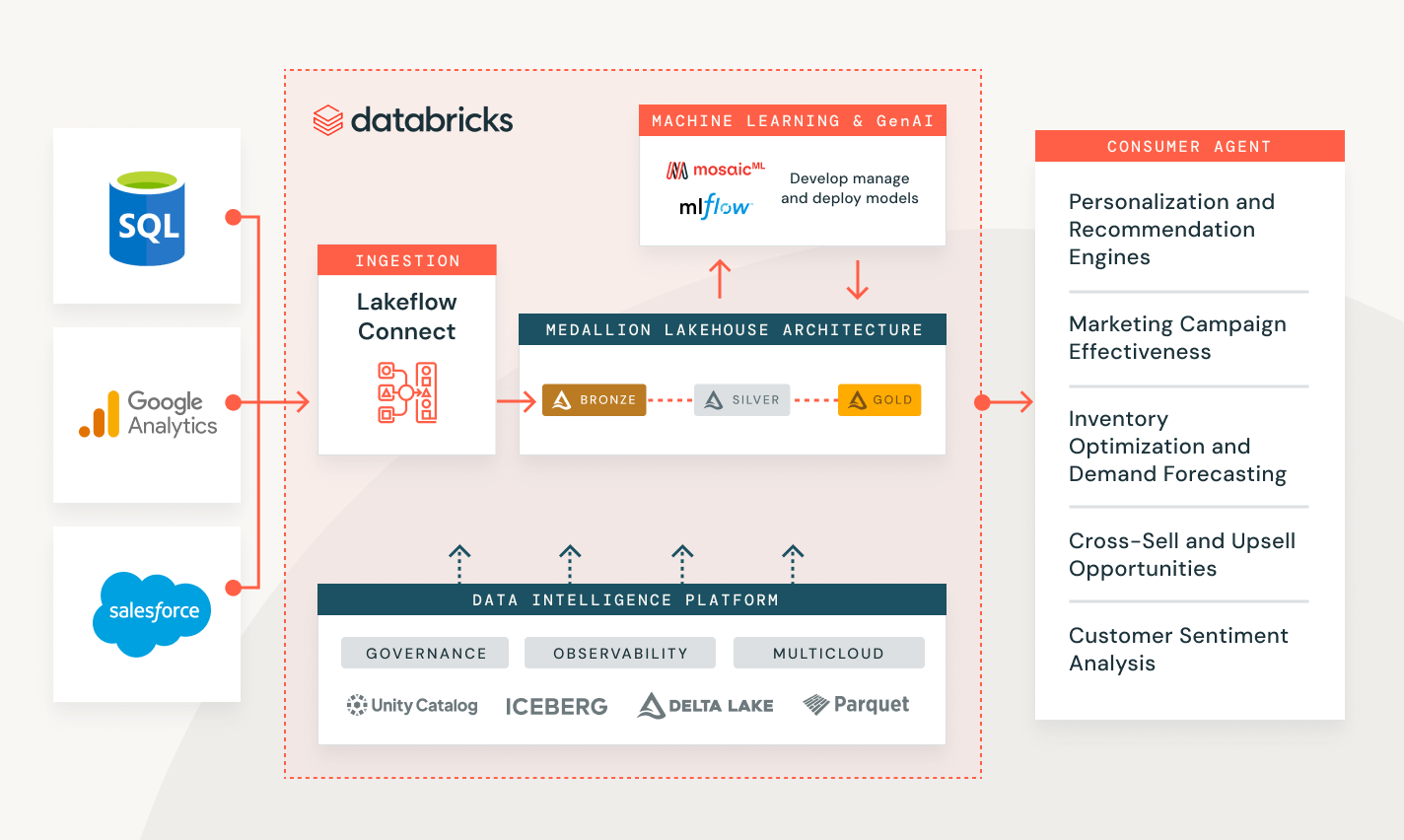

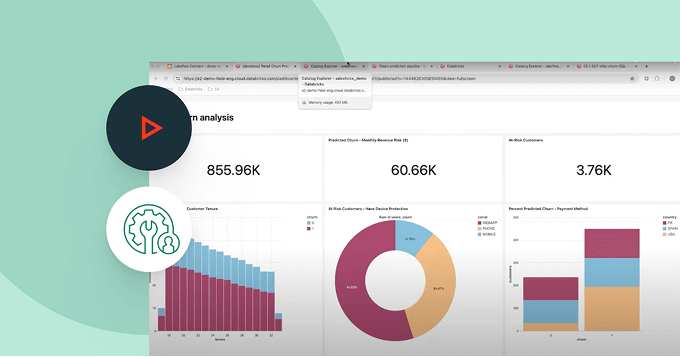

다양한 산업 분야에서 고객 문제 해결

데이터 수집 데모 탐색

사용량 기반 가격 책정으로

지출 통제

사용한 제품에 대해서만 초 단위로 비용을 지불하세요.더 자세히 알아보기

데이터 인텔리전스 플랫폼에서 다른 통합된, 지능형 제공물을 탐색해보세요.Lakeflow 작업

깊은 관찰 가능성, 높은 신뢰성, 그리고 넓은 작업 유형 지원을 통해 ETL, 분석, AI 워크플로우를 더 잘 자동화하고 조정할 수 있도록 팀을 갖추십시오.

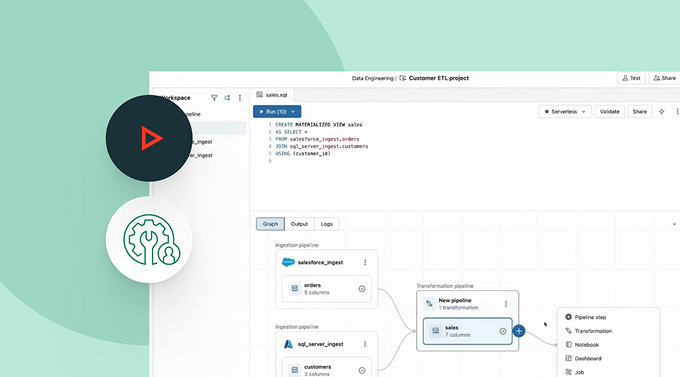

Spark 선언적 파이프라인

자동화된 데이터 품질, 변경 데이터 캡처(CDC), 데이터 수집, 변환 및 통합 거버넌스를 통해 배치 및 스트리밍 ETL을 단순화하세요.

Unity Catalog

당신의 모든 데이터 자산을 산업에서 유일하게 통합되고 개방된 거버넌스 솔루션을 통해 원활하게 관리하세요. 이 솔루션은 데이터와 AI를 위해 만들어졌으며, Databricks 데이터 인텔리전스 플랫폼에 내장되어 있습니다.

Delta Lake

모든 형식과 유형에 걸쳐 레이크하우스의 데이터를 통합하여 모든 분석 및 AI 작업 부하를 위해 사용합니다.