Bonnes pratiques de gouvernance de l'IA : comment créer des programmes d'IA responsables et efficaces

Summary

- La gouvernance de l'IA d'entreprise gère le risque, la conformité et la confiance à mesure que les systèmes d'IA sont mis en production pour des cas d'usage à enjeux élevés, en fondant les décisions sur des principes tels que l'équité, la transparence, la responsabilité, la confidentialité, la sécurité et des garde-fous intégrés.

- Les cadres de gouvernance efficaces alignent la supervision sur le risque commercial, définissent des rôles et des politiques interfonctionnels clairs, intègrent des points de contrôle tout au long du cycle de vie de l'IA et s'appuient sur des évaluations structurées des risques, un monitoring, une réponse aux incidents et une documentation standardisée.

- Les programmes évolutifs utilisent des normes centralisées avec une exécution fédérée, une intervention humaine pour les décisions à haut risque, un suivi proactif de l'évolution des réglementations et un solide parrainage de la part de la direction (C-suite), afin que la gouvernance devienne un catalyseur pour l'innovation responsable en matière d'IA plutôt qu'un goulot d'étranglement.

Pourquoi la gouvernance de l'IA en entreprise est importante aujourd'hui

L'adoption de l'IA en entreprise s'accélère rapidement, stimulée par les avancées de l'IA générative. Ces modèles apprennent à partir des données, évoluent au fur et à mesure que les entrées changent et progressent avec les techniques d'entraînement et les datasets.

Mais même si les modèles deviennent plus sophistiqués et précis, les LLM et les projets d'IA de pointe présentent toujours des risques pour l'entreprise, surtout lorsqu'ils sont déployés en production. La conséquence est que la gouvernance de l'IA est plus importante que jamais et que les entreprises doivent mettre en place une stratégie solide et multidimensionnelle.

Les principaux piliers de la gouvernance sont les suivants :

- Contrôles d'accès aux données et autorisations

- Data lineage et observabilité complète

- Garanties d'IA intégrées pour protéger les PII et bloquer les contenus dangereux

- Conformité et exigences réglementaires

Quels sont les objectifs d'un cadre de gouvernance de l'IA ?

Les bonnes pratiques de gouvernance de l'IA fournissent un moyen structuré de garantir que les systèmes d'IA sont développés, déployés et exploités de manière responsable. De plus, ces pratiques s'alignent sur les objectifs de l'entreprise, gèrent les risques tout au long du cycle de vie de l'IA et instaurent la confiance avec les utilisateurs et les parties prenantes.

La pression réglementaire sur l'utilisation de l'IA augmente également. Les gouvernements et les organismes de normalisation lancent de nouvelles discussions autour de la transparence, de la responsabilité et de la surveillance des systèmes d'IA, offrant aux utilisateurs un ensemble de cadres théoriques et pratiques sur lesquels fonder leur gouvernance. Par exemple, les principes de l'OCDE sur l'IA fournissent une base fondée sur des valeurs pour un cadre de gouvernance de l'IA, tandis que la législation sur l'IA de l'Union européenne établit un cadre fondé sur les risques avec des exigences renforcées pour les cas d'utilisation de l'IA à haut risque.

Au-delà de la conformité, la gouvernance de l'IA a une valeur commerciale directe. Les organisations dotées de structures de gouvernance claires sont mieux placées pour :

- Gagner la confiance des parties prenantes dans les décisions basées sur l'IA

- Réduire les risques opérationnels et juridiques

- Monter en charge les systèmes d'IA plus efficacement au sein des équipes et pour les différents cas d'usage

- Démontrer la responsabilité et le contrôle à mesure que les programmes d'IA évoluent

Défis courants qui soulignent la nécessité de la gouvernance

De nombreuses entreprises rencontrent des défis similaires à mesure que l'adoption de l'IA se développe :

- Manque de clarté sur la responsabilité: la responsabilité des résultats de l'IA est souvent fragmentée entre les équipes chargées des données, de Data Engineering, des affaires juridiques et commerciales. Les équipes peuvent livrer des modèles, mais aucune équipe n'est responsable des résultats.

- Des outils en évolution rapide: les nouvelles IA et GenAI s'améliorent rapidement, et le rythme effréné de leur développement signifie qu'elles peuvent manquer de contrôles et de processus adéquats.

- Données et processus fragmentés: les données, l'entraînement, le déploiement et le monitoring peuvent se trouver dans des systèmes distincts, ce qui rend la supervision et la documentation cohérente difficiles.

- Auditabilité limitée: prouver comment un système d'IA a été entraîné, évalué et déployé peut prendre beaucoup de temps, voire être impossible, sans artefacts de gouvernance.

Ces défis soulignent pourquoi la gouvernance doit être intentionnelle et intégrée aux processus centraux dès le début, plutôt qu'ajoutée après l'apparition de problèmes.

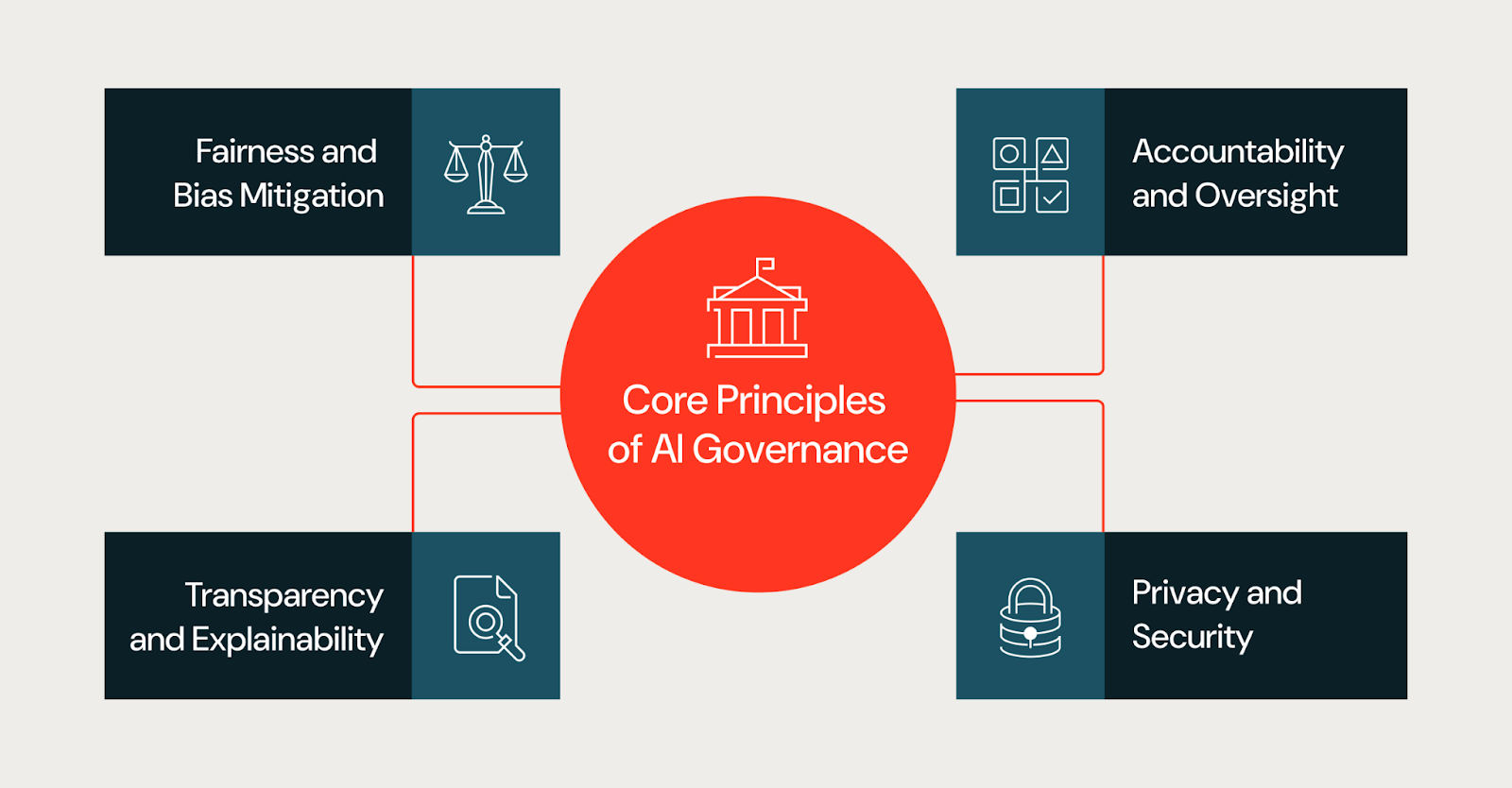

Principes fondamentaux d'une gouvernance efficace de l'IA

La gouvernance s'applique aux systèmes d'IA dans leur ensemble, y compris les données, les prompts, les workflows, les points de décision humains et les applications en aval, et pas seulement aux modèles individuels. De nombreux risques pour l'entreprise découlent de la manière dont ces composants interagissent, plutôt que du modèle lui-même. Les bonnes pratiques en matière de gouvernance de l'IA reposent sur un ensemble cohérent de principes fondamentaux. Ces principes guident les décisions tout au long du cycle de vie de l'IA et fournissent un cadre commun aux équipes ayant des responsabilités différentes.

Équité et atténuation des biais

Le biais peut être introduit par les données d'entraînement, la sélection de caractéristiques ou le contexte de déploiement et entraîner des résultats disparates au sein des populations. Les programmes de gouvernance devraient exiger des équipes qu'elles évaluent les risques liés à l'équité à un stade précoce, qu'elles documentent les limites connues et qu'elles surveillent les biais non intentionnels à mesure que les modèles évoluent en production.

En pratique, les équipes évaluent l'équité en examinant les données d'entraînement pour déceler les lacunes de représentation, en testant les résultats des modèles sur différents groupes démographiques et en définissant des métriques d'équité avant le déploiement. Les approches courantes incluent l'évaluation désagrégée, les audits de biais pendant le développement et le monitoring continu du drift en production. Les équipes doivent également documenter les limites connues et les cas limites où le modèle pourrait être moins performant.

Transparence et explicabilité

La transparence aide les parties prenantes à comprendre comment les systèmes d'IA sont conçus et comment ils influencent les résultats. Cela ne signifie pas qu'il faille exiger une visibilité totale sur l'architecture du modèle propriétaire d'un fournisseur ou sur ses données d'entraînement, car les fournisseurs de modèles fermés ne divulguent généralement pas ces informations. Au lieu de cela, la transparence se concentre sur ce qu'une organisation peut contrôler et documenter.

Cela permet de savoir clairement quels modèles et versions une équipe peut utiliser, quelles données elle leur transmet, comment elle les prompte ou les affine, et quels critères d'évaluation une équipe peut appliquer avant le déploiement. Les équipes doivent également documenter la logique de décision au niveau de la couche applicative pour expliquer comment les résultats du modèle sont utilisés, filtrés ou remplacés dans les workflows en aval. Pour les parties prenantes qui ont besoin d'explications, telles que les organismes de réglementation, les dirigeants ou les utilisateurs concernés, l'objectif est de fournir un contexte approprié sur la manière dont le système parvient à ses résultats, même lorsque le modèle sous-jacent est une boîte noire.

Responsabilité et supervision

Une gouvernance efficace définit une responsabilité claire pour les systèmes d'IA. Chaque modèle ou application d'IA devrait avoir des personnes ou des équipes responsables chargées des résultats, de la gestion des risques et de la conformité avec les politiques internes. Les mécanismes de surveillance garantissent que la responsabilité perdure après le déploiement au lieu de disparaître une fois qu'un modèle est mis en production.

Confidentialité et sécurité

Les systèmes d'IA traitent souvent des données sensibles ou réglementées et la gouvernance doit garantir que les protections de la confidentialité et les contrôles de sécurité sont appliqués de manière cohérente, y compris la gestion des accès basée sur les rôles, les filtres PII et le filtrage des résultats dangereux. Les considérations de confidentialité et de sécurité devraient être intégrées tout au long du cycle de vie de l'IA, et non traitées uniquement au moment du déploiement.

Garde-fous intégrés

Les systèmes d'IA ont besoin de garde-fous pour empêcher les résultats nuisibles ou non intentionnels. Les garde-fous intégrés comprennent la validation des entrées pour détecter les queries malformées ou malveillantes, des filtres de sortie qui bloquent le contenu dangereux ou inapproprié, la détection des PII pour empêcher l'exposition de données et la modération de contenu pour les applications destinées aux utilisateurs. Ces contrôles devraient être configurables par niveau de risque ; un outil interne à faible risque peut nécessiter des garde-fous plus légers qu'un agent destiné aux clients.

Accès unifié pour les modèles et les projets d'IA

À mesure que les organisations montent en charge l'adoption de l'IA, l'accès aux modèles et aux projets d'IA devrait être régi par un cadre centralisé. Les contrôles d'accès unifiés garantissent des autorisations cohérentes dans les environnements de développement, de préproduction et de production. Cela inclut un accès basé sur les rôles pour déterminer qui peut consulter, modifier ou déployer des modèles, des pistes d'audit qui suivent les modifications et l'utilisation, et l'intégration avec les systèmes de gestion des identités. L'accès centralisé réduit le risque de projets d'IA de l'ombre et facilite la démonstration de la conformité. Sans contrôles d'accès unifiés, les organisations sont souvent confrontées à l'« IA de l'ombre » (modèles et applications déployés sans supervision officielle), qui devient l'un des plus grands obstacles à une gouvernance cohérente à grande échelle.

Créer un cadre de gouvernance de l'IA pratique

Alors que les principes de gouvernance peuvent définir ce qu'est une bonne gouvernance, les cadres (frameworks) définissent la manière dont les organisations mettent en œuvre leurs processus. En d'autres termes, un cadre de gouvernance de l'IA pratique traduit des objectifs de haut niveau en rôles, politiques et contrôles spécifiques qui s'intègrent dans la structure globale et la tolérance au risque d'une organisation.

Consultez le Databricks AI Governance Framework pour obtenir un exemple d'approche structurée visant à définir les piliers de la gouvernance et les considérations clés.

Aligner la gouvernance avec les objectifs de l'entreprise

Les organisations obtiennent de meilleurs résultats lorsque la gouvernance est alignée sur l'impact commercial et le risque. Tous les systèmes d'IA n'ont pas besoin du même niveau de supervision. Un chatbot qui résume des documents externes présente un risque différent de celui d'un modèle qui approuve des prêts ou hiérarchise des cas médicaux.

Établir les rôles et les structures de gouvernance

Pour que la gouvernance de l'IA soit la plus efficace possible, elle doit être interfonctionnelle. Cela implique une collaboration continue et intentionnelle entre les équipes de données et d'IA, les services juridiques et de conformité, les équipes de confidentialité et de sécurité et les parties prenantes de l'entreprise. Les structures courantes incluent :

- Comités de gouvernance interfonctionnels

- Des modèles RACI clairement définis

- Exigences d'intervention humaine (human-in-the-loop) pour les décisions à haut risque

- Contrôle d'accès basé sur les rôles

Ces structures clarifient les droits de décision et réduisent l'ambiguïté à mesure que les programmes d'IA montent en charge.

Définir les politiques, normes et contrôles de l'IA

Des normes claires réduisent les frictions. Les cadres de gouvernance efficaces précisent :

- Documentation et artefacts requis

- Critères de classification des risques liés à l'IA

- Seuils d'approbation par niveau de risque

- monitoring, réponse aux incidents et attentes en matière d'audit

Lorsque les normes restent vagues, les équipes inventent des interprétations locales. Lorsque les normes sont concrètes, les équipes avancent plus vite avec moins de surprises.

Opérationnalisation de la gouvernance de l'IA

La gouvernance de l'IA doit être intégrée à la structure même du workflow, notamment la manière dont les équipes conçoivent, livrent et exploitent les systèmes d'IA. Cependant, elle doit être plus qu'une simple théorie ; la gouvernance opérationnelle doit répondre à des questions pratiques, telles que qui décide, quelles preuves les équipes doivent produire et comment les systèmes restent conformes dans le temps. Le résultat est un processus explicite que les équipes peuvent suivre pour intégrer la gouvernance de l'IA dans leurs workflows.

Intégrer la gouvernance au cycle de vie du développement de l'IA

La plupart des organisations ne créent pas de modèles de fondation à partir de zéro. Elles combinent des modèles existants avec des données propriétaires pour créer des projets, des agents et des applications d'IA. La gouvernance devrait refléter cette réalité en intégrant des points de contrôle directement dans le cycle de vie du développement. Par exemple, un assistant IA interne qui résume des documents externes peut être initialement classé comme présentant un faible risque. Si ce même système est ensuite exposé aux clients ou utilisé pour éclairer des décisions réglementées, son profil de risque change, ce qui nécessite de nouvelles approbations, garanties et monitoring.

- Définir la portée et l'intention. Avant le début du développement, documentez l'utilisation prévue du système, les utilisations interdites et le contexte de décision. Cela évite la dérive des objectifs, où les systèmes sont réutilisés dans des scénarios à plus haut risque sans examen.

- Documenter les sources de données. Consigner la propriété des données, les contraintes de consentement et les limitations connues. Si les équipes ne peuvent pas expliquer d'où proviennent les données et pourquoi elles sont appropriées, elles ne devraient pas les utiliser pour créer ou affiner un système.

- Établir des critères d'évaluation. Se mettre d'accord sur les métriques, le seuil et les compromis acceptables avant les tests. Les équipes doivent documenter pourquoi elles ont choisi des métriques spécifiques et quels modes de défaillance elles ont observés. Cela transforme l'évaluation en un registre de décisions pour référence future.

- Mettre en place des portes de validation avant mise en production. Exigez des propriétaires désignés, une documentation complète et une approbation correspondant au niveau de risque du système. Définissez des critères de rollback afin que les équipes sachent quand retirer un système de la production.

- Surveiller et examiner. Après le déploiement, examinez le comportement en production, en validant les hypothèses par rapport à l'utilisation réelle et en documentant les changements au fil du temps.

Effectuer des évaluations des risques de l'AI

L'évaluation des risques est au cœur de la gouvernance pratique. Elle détermine le niveau de contrôle dont un système a besoin et où les équipes doivent concentrer leur attention. Lorsque les équipes déploient des évaluations efficaces, elles doivent se concentrer sur un petit ensemble de questions :

- Qui est concerné par ce système ?

- Quelles décisions influence-t-elle ou automatise-t-elle ?

- Que se passe-t-il en cas d'échec ?

- Avec quelle facilité les humains peuvent-ils intervenir ?

- Quel est le niveau de sensibilité des données impliquées ?

Une fois que les équipes ont rassemblé les réponses à ces questions, elles peuvent alors attribuer un niveau de risque, ce qui est une façon de traduire le jugement en action. Par exemple, un outil interne à faible risque peut nécessiter une documentation allégée et un examen périodique, tandis qu'un système à haut risque peut nécessiter une surveillance humaine fréquente, une approbation formelle et un monitoring continu.

Les évaluations des risques doivent être effectuées tôt et faire l'objet de mises à jour continues. Lorsque des systèmes sont étendus à de nouveaux utilisateurs ou cas d'utilisation, leur profil de risque change souvent. Les processus de gouvernance doivent être conçus pour tenir compte de cette évolution.

Définir les circuits d'approbation et d'escalade

La gouvernance opérationnelle dépend de processus de décision clairs. Les équipes doivent savoir qui peut approuver un système, quand une escalade est requise et comment résoudre les désaccords. Par conséquent, les organisations définissent généralement les parcours décisionnels suivants :

- Autorités d'approbation par niveau de risque

- déclencheurs d'escalade pour les problèmes non résolus

- échéanciers pour l'examen et la réponse

- critères d'arrêt ou de restauration des systèmes

Sans parcours définis, la gouvernance peut devenir déroutante et les équipes peuvent être paralysées lorsque les décisions stagnent, que la responsabilité se dilue et que les équipes contournent les contrôles pour continuer à avancer. L'établissement de parcours clairs réduit l'ambiguïté et augmente la conformité, car les équipes comprennent comment aller de l'avant.

Mettre en œuvre des contrôles de monitoring et de conformité

Compte tenu du développement rapide et continu des systèmes d'IA, la gouvernance de l'IA ne peut être statique. Avec le temps, les données changent, les modèles d'utilisation évoluent et les performances se dégradent. Il est essentiel que les équipes surveillent le comportement de l'IA en production en se concentrant sur :

- Performance par rapport à des métriques définies

- Drift des données et changements de distribution

- entrées ou sorties inattendues

- l'utilisation du système en dehors du cadre prévu

La gouvernance définit ce que les équipes doivent surveiller, la fréquence à laquelle elles examinent les résultats et les mesures qu'elles prennent lorsque les seuils sont dépassés. Ces mesures peuvent inclure le réentraînement, la restriction de l'utilisation, l'escalade vers des comités d'examen ou l'arrêt des systèmes. En transformant le monitoring en une boucle de rétroaction, les organisations peuvent s'assurer qu'elles maximisent les avantages de leurs processus internes.

Établir des processus de réponse aux incidents et de remédiation

En plus de créer une culture de la rétroaction et de la responsabilité, les cadres de gouvernance solides doivent prendre en compte les défaillances. Même les systèmes bien conçus tombent en panne ou se dégradent avec le temps.

Une autre étape de la gouvernance consiste à définir la manière dont une équipe réagit aux incidents liés à l'IA, y compris les résultats biaisés, les comportements dangereux, l'exposition de données ou les problèmes de réglementation. Les équipes ont besoin de guides prédéfinis qui spécifient :

- Comment identifier et classifier les incidents

- Qui est responsable de la réponse et de la communication

- Comment limiter les dommages

- Comment documenter les causes profondes et les mesures correctives

Les examens post-incident peuvent aider à intégrer de nouveaux apprentissages ou mises à jour dans la gouvernance établie, contribuant à mettre à jour les évaluations des risques, à améliorer les contrôles et à affiner les politiques. Cette boucle garantit que la gouvernance évolue avec l'expérience du monde réel.

Standardiser les artefacts de gouvernance

À mesure que les équipes développent leur gouvernance, une documentation standardisée est importante pour garantir la traçabilité et la cohérence dans l'ensemble du système. Une documentation cohérente peut également faciliter les audits et réduire la duplication des efforts lors de la reproduction des documents. Les organisations privilégient les documents normalisés suivants :

- Résumés du système qui définissent l'objectif et la portée

- Documentation des données qui enregistre les sources et les contraintes

- Des résumés d'évaluation qui rendent compte des performances et des limites

- Plans de monitoring définissant une supervision continue

Monter en charge la gouvernance à l'échelle des équipes et des domaines

À mesure que l'adoption de l'IA continue de croître, la gouvernance d'une organisation doit monter en charge sans créer de goulots d'étranglement. De nombreuses équipes utilisent un modèle centralisé-fédéré, dans lequel un groupe central définit les normes, les cadres de risque et les politiques, tandis que les équipes de domaine les appliquent localement et restent responsables des résultats. Ce modèle permet de trouver un équilibre entre la cohérence et la rapidité.

Le déploiement à grande échelle nécessite également une formation. À mesure que les systèmes de gouvernance évoluent et se développent, les équipes doivent comprendre ce qu'exige la gouvernance et comment se conformer au mieux à ses exigences.

Gartner® : Databricks, leader des bases de données cloud

Garantir la transparence, la confiance et l'explicabilité

La confiance est un résultat central d'une gouvernance efficace de l'IA. Les parties prenantes sont plus susceptibles d'adopter les systèmes d'IA et de s'y fier lorsqu'elles comprennent comment les décisions sont prises et comment les risques sont gérés tout au long du cycle de vie de l'IA.

Supervision avec intervention humaine

Pour les cas d'usage à haut risque ou sensibles, les humains doivent conserver l'autorité finale sur les décisions prises par l'IA. Les cadres de gouvernance doivent définir quand un examen humain est requis, comment les interventions se produisent et comment les décisions sont documentées.

Communiquer les décisions de l'IA aux parties prenantes

Les différentes parties prenantes ont besoin de différents niveaux d'explication. Les équipes techniques peuvent avoir besoin de métriques d'évaluation détaillées, tandis que les dirigeants et les régulateurs peuvent se fier à des résumés, des fiches de modèle ou des justifications de décision. Une communication claire renforce la confiance et favorise la responsabilité.

Suivre le rythme de l'évolution réglementaire et des secteurs d'activité

La gouvernance de l'IA n'est jamais terminée. Les lois et réglementations évoluent, les normes mûrissent et les capacités de l'IA progressent plus vite que les cycles politiques.

Rester à jour sur les normes et les mises à jour

Les organisations se tiennent à jour en attribuant une responsabilité claire pour le monitoring des changements réglementaires et normatifs. Les programmes efficaces créent un petit groupe interfonctionnel qui comprend des juristes, des responsables de la conformité, de la confidentialité, de la sécurité et des praticiens de l'IA, plutôt que de se fier à des mises à jour ad hoc.

Le monitoring est plus efficace lorsqu'il est effectué à une cadence fixe, par exemple trimestrielle, plutôt que par des mises à jour réactives. Pour rester proactives, les équipes doivent �évaluer chaque changement en se posant la question suivante :

- Cela affecte-t-il les systèmes d'IA existants ou seulement les nouveaux ?

- Cela introduit-il de nouvelles attentes en matière de documentation ou de supervision ?

- S'applique-t-il à l'échelle mondiale ou uniquement dans certaines régions ?

Ces vérifications d'impact aident les équipes à utiliser et à affiner les processus de gouvernance existants au lieu de créer des contrôles parallèles.

Se préparer aux futures exigences en matière de gouvernance de l'IA

Les futures exigences en matière de gouvernance de l'IA étendront probablement les attentes en matière d'explicabilité, d'auditabilité et de documentation. Les organisations peuvent préparer leurs processus dès maintenant sans attendre de mandats détaillés.

Traçabilité et explicabilité : Les équipes doivent définir les explications dont elles ont besoin par niveau de risque et par public, depuis les examens techniques jusqu'aux résumés pour les dirigeants et la réglementation.

Auditabilité : Il est important de conserver les enregistrements des décisions qui montrent ce pour quoi un système a été conçu, comment il a été évalué, qui l'a approuvé et comment il a changé après le déploiement.

Documentation : La standardisation de votre documentation est cruciale. Assurez-vous que vos équipes de gouvernance documentent les résumés des systèmes, les évaluations des risques, les rapports d'évaluation et les plans de monitoring, et les maintiennent continuellement à jour.

Surmonter les obstacles courants à l'adoption de la gouvernance de l'IA

Malgré ses avantages, la gouvernance de l'IA présente son propre lot de défis au sein des organisations. Les obstacles courants sont les suivants :

Durabilité. Lorsque les incitations organisationnelles récompensent la mise en production de modèles le plus rapidement possible, les équipes peuvent percevoir la gouvernance comme un obstacle. Les équipes de données et d'IA se concentrent sur le déploiement rapide des modèles, tandis que les exigences de gouvernance apparaissent plus tard sous la forme de cycles de révision inattendus ou de travail de documentation.

Propriété fragmentée. Lorsque la responsabilité des résultats de l'IA est répartie entre plusieurs équipes, les responsabilités en matière de gouvernance peuvent être floues. Aucune équipe n'est propriétaire du résultat, donc personne n'est propriétaire des contrôles.

Dette technique héritée. Les pipelines et modèles plus anciens manquent souvent des métadonnées, du monitoring ou de la documentation attendues par la gouvernance. La modernisation de ces systèmes nécessite un effort qui entre en concurrence avec les nouvelles priorités de développement.

Stratégies pour augmenter l'adoption

Les programmes de gouvernance efficaces se concentrent sur la proactivité, et non sur des réformes réactives. Il devrait y avoir un message cohérent de la part de la direction sur l'importance de la gouvernance. Une communication et une formation claires aident les praticiens à comprendre comment la gouvernance s'intègre dans les flux de travail existants, plutôt que d'ajouter des processus parallèles. Parallèlement, les initiatives pilotes jouent un rôle essentiel en démontrant que la gouvernance réduit les reprises, prévient les incidents de production et accélère les approbations une fois que les normes sont en place. Ensemble, ces stratégies font passer la gouvernance d'un obstacle perçu à une base pratique pour mettre à l'échelle l'IA de manière responsable.

Comment démarrer l'élaboration d'une stratégie de gouvernance de l'IA

Une gouvernance de l'IA solide aide les organisations à faire monter en charge l'adoption de l'IA en toute confiance. Des attributs tels qu'une responsabilité claire, des contrôles basés sur les risques et une surveillance continue réduisent les surprises et maintiennent les systèmes en adéquation avec les attentes commerciales et réglementaires.

Les équipes doivent commencer par une base pratique : inventorier les cas d'usage actuels de l'IA, les classer par risque et leur assigner des responsables. Pilotez les contrôles de gouvernance sur un petit ensemble de systèmes à fort impact pour établir des normes et affiner les processus. À mesure que les équipes acquièrent de l'expérience, elles peuvent étendre la gouvernance à d'autres cas d'usage et domaines, renforçant ainsi la surveillance tout en préservant la vitesse et la flexibilité nécessaires pour soutenir l'innovation en matière d'IA.

(Cet article de blog a été traduit à l'aide d'outils basés sur l'intelligence artificielle) Article original

Ne manquez jamais un article Databricks

Et ensuite ?

IA

7 janvier 2025/8 min de lecture