Applications Spark

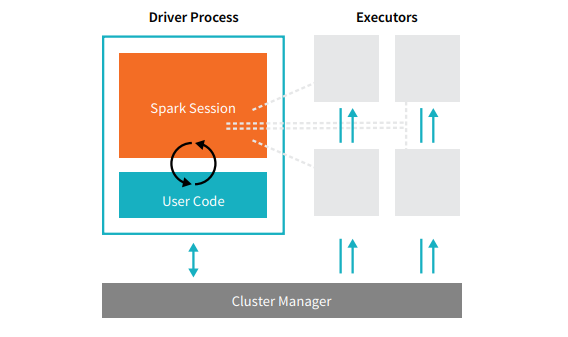

Les applications Spark se composent d’un processus driver et d’un ensemble de processus exécuteurs. Le processus driver exécute votre fonction main(), tourne sur un nœud du cluster et prend en charge trois tâches : gérer les informations sur l’application Spark ; répondre au programme ou à l’entrée d’un utilisateur ; et analyser, distribuer et planifier le travail à travers les exécuteurs (définis momentanément). Le processus driver est absolument essentiel, il constitue le cœur d’une application Spark. Il maintient toutes les informations pertinentes pendant la durée de vie de l’application. Les exécuteurs sont chargés d’exécuter le travail que le driver leur confie. Cela signifie que chaque exécuteur est responsable de deux tâches uniquement : l’exécution du code qui lui est assigné par le driver et la communication de l’état du calcul, sur cet exécuteur, au nœud du driver.  Le gestionnaire de clusters contrôle les machines physiques et alloue des ressources à l'application Spark. Il peut s’agir de l’un des principaux gestionnaires de clusters : Spark, YARN ou Mesos. Cela signifie que plusieurs applications Spark peuvent fonctionner en même temps sur un cluster. Nous parlerons plus en détail des gestionnaires de clusters dans la partie IV de ce livre intitulée « Applications de production ». Dans l’illustration ci-dessus, nous voyons à gauche notre driver et à droite les quatre exécuteurs. Nous n’y avons pas schématisé le concept de nœuds de clusters. L’utilisateur peut effectuer des configurations pour spécifier le nombre d’exécuteurs devant se trouver sur chaque nœud. [glossary-cta]

Le gestionnaire de clusters contrôle les machines physiques et alloue des ressources à l'application Spark. Il peut s’agir de l’un des principaux gestionnaires de clusters : Spark, YARN ou Mesos. Cela signifie que plusieurs applications Spark peuvent fonctionner en même temps sur un cluster. Nous parlerons plus en détail des gestionnaires de clusters dans la partie IV de ce livre intitulée « Applications de production ». Dans l’illustration ci-dessus, nous voyons à gauche notre driver et à droite les quatre exécuteurs. Nous n’y avons pas schématisé le concept de nœuds de clusters. L’utilisateur peut effectuer des configurations pour spécifier le nombre d’exécuteurs devant se trouver sur chaque nœud. [glossary-cta]