Architecture de référence pour une Lakehouse de sécurité

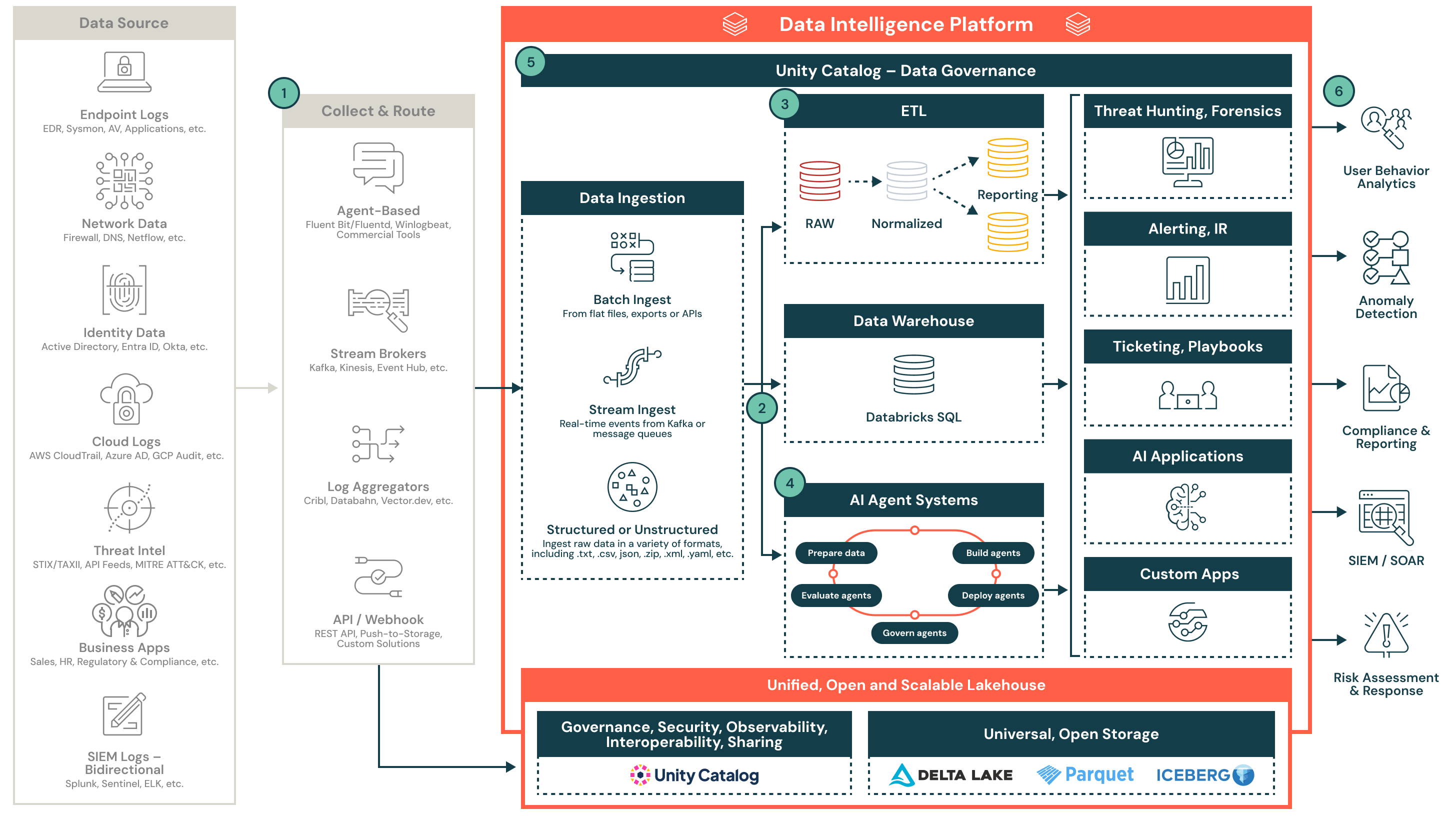

Cette architecture démontre comment centraliser les données de sécurité et opérationnaliser la détection, la réponse et les rapports avec l'écosystème lakehouse de Databricks.

Opérationnalisation de la télémétrie de sécurité à grande échelle avec la lakehouse Databricks

Cette architecture de référence démontre comment les équipes de sécurité peuvent collecter, normaliser et opérationnaliser diverses télémétries à grande échelle en utilisant le lakehouse Databricks. Elle prend en charge l'analytique en temps réel, l'ingénierie de détection, les rapports de conformité et l'intégration avec les outils SOC en aval.

Aperçu de l'architecture

La télémétrie de sécurité est complexe, de haut volume et provient de nombreux systèmes. Les architectures héritées ont souvent du mal avec le coût, la rétention et la corrélation entre différentes sources. Le lac de données de sécurité Databricks aide les équipes de sécurité à centraliser et à opérationnaliser ces données en utilisant des formats ouverts, des pipelines réglementés et un moteur de calcul flexible.

Cette architecture décrit une conception modulaire et native du cloud pour l'ingestion de données de sécurité structurées et non structurées provenant de points de terminaison, de systèmes d'identité, de fournisseurs de cloud, de flux de menaces, de SIEMs et d'applications commerciales. Une fois ingérées et normalisées, ces données alimentent des cas d'utilisation en aval, y compris la détection de menaces, le triage, l'investigation pilotée par l'IA et la production de rapports.

1. Collecter et acheminer

Les données de sécurité sont collectées à partir de plusieurs sources, y compris les points d'extrémité, les plateformes cloud, les systèmes d'identité et les flux de menaces. Les données sont acheminées par des collecteurs basés sur des agents, des courtiers de flux, des agrégateurs de journaux ou des API directes. Ces outils prennent en charge les formats structurés et non structurés et peuvent fonctionner en temps réel ou par lots.

Quelques exemples :

- Fluentd, Vector ou expéditeurs de logs commerciaux

- Kafka, Event Hub ou Kinesis

- Cribl, Databahn ou pipelines basés sur des webhooks

2. Ingestion et atterrissage

Les données entrent dans le lac de données via l'ingestion par lots structurés ou le streaming en temps réel. Les données ingérées sont écrites dans les tables Delta Lake Bronze pour préserver la fidélité et la traçabilité. Unity Catalog garantit que les données sont régies et découvrables dès le début du pipeline.

Les caractéristiques clés incluent :

- Support pour les fichiers plats, JSON, CSV et les formats imbriqués

- Ingestion de flux à partir de Kafka ou d'autres courtiers

- Gouvernance et découvrabilité grâce au Catalogue Unity

3. Normaliser et transformer

Les données brutes sont analysées, aplaties et enrichies en formats structurés pour l'analyse et la détection. Cette étape utilise l'architecture de médaille (Bronze, Argent, Or) pour créer des tables réutilisables et interrogeables qui alimentent l'ingénierie de détection et la production de rapports.

Les tâches de normalisation comprennent :

- Alignement de schéma (par exemple, OCSF ou modèles personnalisés)

- Enrichissement avec des métadonnées ou des renseignements sur les menaces

- Dé-duplication, analyse syntaxique et alignement des horodatages

4. Activer l'IA et les analyses avancées

Les flux de données normalisés alimentent les cadres d'agents IA natifs de Databricks qui prennent en charge les cas d'utilisation de la sécurité. Ces agents peuvent détecter des anomalies, trier les alertes et automatiser les workflows d'investigation. La plateforme prend en charge la gestion du cycle de vie des agents, du développement à la production.

Les capacités incluent :

- Préparation des données pour l'entraînement et l'inférence

- Déploiement et gestion des agents de détection

- Évaluation et notation de la performance du modèle en production

5. Alimenter les opérations de sécurité

La lakehouse permet des fonctions essentielles du SOC telles que la chasse aux menaces, l'alerte, la réponse aux incidents et l'automatisation. Les sorties structurées alimentent les tableaux de bord, les tickets, les flux de travail SOAR et les systèmes en aval.

Les résultats incluent :

- Enquêtes plus rapides et réduction de la fatigue des alertes

- Vue unifiée de la télémétrie à travers les sources

- Collaboration améliorée grâce aux carnets de notes et SQL

6. Livrer des résultats de sécurité

Les informations sélectionnées sont transmises aux outils et aux équipes qui en ont besoin. Les produits de données soutiennent la conformité, les rapports, l'analyse du comportement des utilisateurs, la détection d'anomalies et l'évaluation des risques. Le SIEM devient un consommateur en aval des alertes affinées et du contexte.

Exemples de consommation en aval :

- Tableaux de bord de rapports de conformité

- Pipelines de détection d'anomalies et UEBA

- Enrichissement du SIEM et playbooks SOAR