Che cos'è il Model Context Protocol (MCP)? Guida pratica all'integrazione dell'AI

Introduzione: comprendere il Model Context Protocol

Il Model Context Protocol (MCP) è uno standard aperto che consente alle applicazioni di AI di connettersi senza problemi a sorgenti di dati, strumenti e sistemi esterni. Pensa al Model Context Protocol come a una porta USB-C per i sistemi di intelligenza artificiale: così come una porta USB-C standardizza il modo in cui i dispositivi si collegano ai computer, l'MCP standardizza il modo in cui gli agenti di intelligenza artificiale accedono a risorse esterne come database, API, file system e basi di conoscenza.

Il protocollo di contesto affronta una sfida fondamentale nella creazione di agenti IA: il "problema di integrazione N×M". Senza un protocollo standardizzato, ogni applicazione di IA deve integrarsi direttamente con ogni servizio esterno, creando N×M integrazioni separate, dove N rappresenta il numero di strumenti e M il numero di client. Questo approccio diventa rapidamente impossibile da scalare. Il Model Context Protocol (MCP) risolve questo problema richiedendo a ogni client e a ogni server MCP di implementare il protocollo una sola volta, riducendo le integrazioni totali da N×M a N+M.

Consentendo ai sistemi di IA di accedere a dati in tempo reale che vanno oltre i dati di addestramento del loro LLM, MCP aiuta i modelli di IA a fornire risposte accurate e aggiornate invece di fare affidamento esclusivamente sui dati di addestramento statici della loro fase di apprendimento iniziale.

Ecco altre informazioni utili

Che cos'è un Model Context Protocol?

Il Model Context Protocol è uno standard unificato e open-source per l'interoperabilità che consente agli sviluppatori di creare applicazioni di IA contestuali. MCP integra LLMOps esponendo controlli di integrazione runtime, osservabilità e governance che semplificano la distribuzione, il monitoraggio e la gestione del ciclo di vita delle applicazioni LLM.

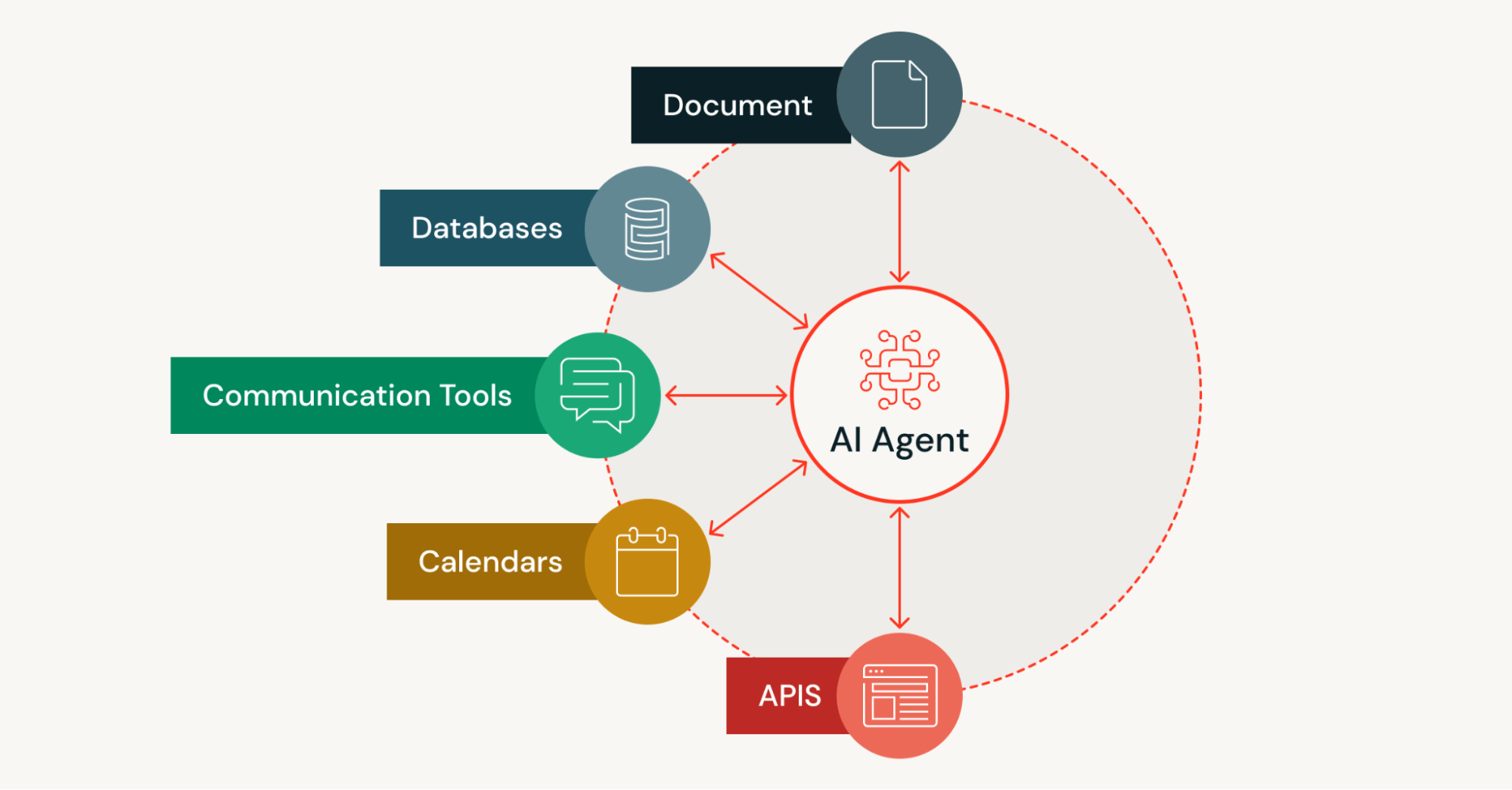

Le applicazioni di IA necessitano dell'accesso ad asset come risorse locali, database, pipeline di dati (in streaming/batch), motori di ricerca, calcolatori e flussi di lavoro per il condizionamento dei prompt e la generazione di grounding. Il protocollo di contesto standardizza il modo in cui le applicazioni si connettono a tali asset in modo strutturato, riducendo il codice di integrazione boilerplate.

Il problema di scalabilità implica che i modelli di IA (in particolare i modelli linguistici di grandi dimensioni) in genere devono basarsi su dati preesistenti e statici per l'addestramento. Ciò può portare a risposte imprecise o non aggiornate perché i modelli addestrati su set di dati statici necessitano di aggiornamenti aggiuntivi per integrare nuove informazioni. Risolvendo il problema della scalabilità, MCP consente alle applicazioni di AI di essere consapevoli del contesto e di fornire output aggiornati non vincolati dalle limitazioni dei dati di addestramento statici.

Cos'è l'MCP e perché viene utilizzato?

Il Model Context Protocol (MCP) funge da metodo standardizzato per consentire alle applicazioni di AI di individuare e interagire con strumenti e sorgenti di dati esterne in fase di esecuzione. Invece di codificare in modo fisso le connessioni a ogni servizio esterno, gli agenti di IA che utilizzano l'MCP possono scoprire dinamicamente gli strumenti disponibili, comprenderne le capacità tramite chiamate strutturate e richiamarli con le autorizzazioni appropriate.

MCP è utilizzato perché trasforma il modo in cui gli strumenti basati sull'AI accedono alle informazioni. I sistemi di IA tradizionali sono limitati dai loro dati di addestramento, che diventano obsoleti rapidamente. Il protocollo di contesto consente agli sviluppatori di creare agenti IA in grado di eseguire attività utilizzando dati in tempo reale da diffusi sistemi enterprise, ambienti di sviluppo e altre fonti esterne, il tutto tramite un unico protocollo standardizzato.

Il protocollo aperto riduce anche il codice di integrazione boilerplate. Invece di scrivere connettori personalizzati per ogni nuova integrazione, gli sviluppatori implementano MCP una sola volta sia lato client che lato server. Questo approccio è particolarmente prezioso per i sistemi di AI agentivi che devono scoprire e utilizzare autonomamente molteplici strumenti in contesti diversi.

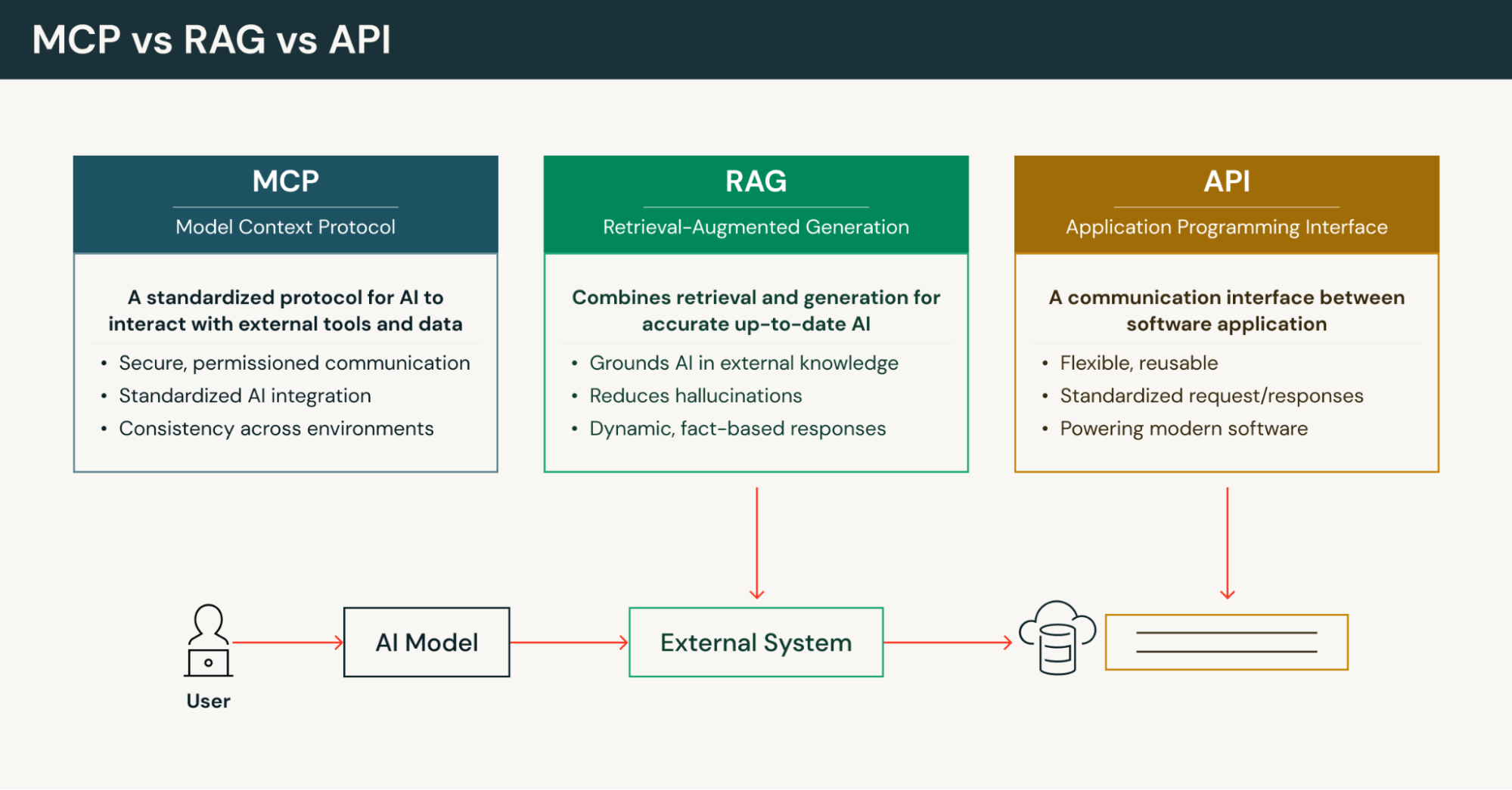

MCP e API a confronto

Limitazioni delle API tradizionali

Le API tradizionali espongono endpoint con parametri tipizzati che i client devono codificare in modo rigido e aggiornare ogni volta che un'API cambia. L'assemblaggio del contesto diventa responsabilità del client poiché le APIs forniscono una guida semantica minima su come i dati restituiti dovrebbero essere utilizzati. Una richiesta API in genere segue un semplice pattern richiesta-risposta senza mantenere lo stato o il contesto tra le chiamate.

In cosa si differenzia il Model Context Protocol

L'MCP definisce un approccio diverso rispetto alle API tradizionali. Invece di endpoint hardcoded, i server MCP espongono una superficie di funzionalità leggibile dalla macchina e rilevabile in fase di runtime. I sistemi di intelligenza artificiale possono interrogare strumenti, risorse e prompt disponibili invece di fare affidamento su connessioni predefinite. Il Model Context Protocol standardizza le forme delle risorse (documenti, righe di database, file), riducendo la complessità della serializzazione in modo che i modelli di intelligenza artificiale ricevano un contesto pertinente ottimizzato per il ragionamento.

Le implementazioni MCP supportano la comunicazione bidirezionale e stateful con semantica di streaming. Ciò consente ai server MCP di inviare aggiornamenti e notifiche di avanzamento direttamente nel ciclo di contesto di un agente AI, supportando flussi di lavoro a più passaggi e risultati parziali che le APIs tradizionali non possono fornire nativamente. Questa architettura client-server consente modelli di utilizzo degli strumenti più sofisticati nei sistemi agentivi.

MCP e RAG: approcci complementari

La Retrieval-Augmented Generation (RAG) migliora l'accuratezza dell'IA convertendo i documenti in embedding, memorizzandoli in database vettoriali e recuperando informazioni pertinenti durante la generazione. Tuttavia, il RAG si basa in genere su fonti statiche e indicizzate provenienti da repository di contenuti. Il Model Context Protocol fornisce accesso on-demand ad API, database e stream in tempo reale, restituendo un contesto autorevole e aggiornato quando la tempestività dei dati è importante.

A differenza di RAG, che restituisce principalmente un contesto di sola lettura, il protocollo di contesto separa le risorse dagli strumenti in modo che gli agenti IA possano sia recuperare dati che eseguire attività su sistemi esterni con schemi controllati. MCP risponde a esigenze di integrazione più ampie, abilitando flussi di lavoro agentivi, orchestrazione multi-turno, individuazione delle capacità di runtime e governance multi-tenant, che RAG non fornisce in modo nativo.

L'MCP può integrare le implementazioni RAG. Le organizzazioni possono utilizzare RAG per indicizzare contenuti evergreen per un rapido recupero, utilizzando al contempo il Model Context Protocol per ricerche transazionali, esecuzione di query SQL e azioni che richiedono il contesto corretto da sistemi attivi. Questo approccio ibrido garantisce velocità e accuratezza.

Il valore della standardizzazione nell'ecosistema MCP

In quanto protocollo bidirezionale e rilevabile in fase di runtime, il Protocollo di Contesto del Modello trasforma strumenti e dati esterni eterogenei in risorse indirizzabili e azioni richiamabili. Un singolo client MCP può individuare in modo uniforme file, righe di database, snippet di vettori, stream live ed endpoint API. Coesistendo con le cache RAG indicizzate, MCP offre ricerche autorevoli e just-in-time e semantica delle azioni.

Il risultato pratico è un minor numero di connettori personalizzati, meno codice custom, integrazioni più rapide e sistemi agentivi più affidabili con una gestione degli errori e percorsi di audit adeguati. Questo modo standardizzato di connettere gli assistenti IA a risorse remote accelera i cicli di sviluppo, mantenendo al contempo i controlli di sicurezza aziendali. L'ecosistema MCP beneficia di questa standardizzazione man mano che un numero maggiore di implementazioni di server MCP diventa disponibile per i sistemi aziendali più diffusi.

Architettura di base di MCP: comprendere il modello client-server

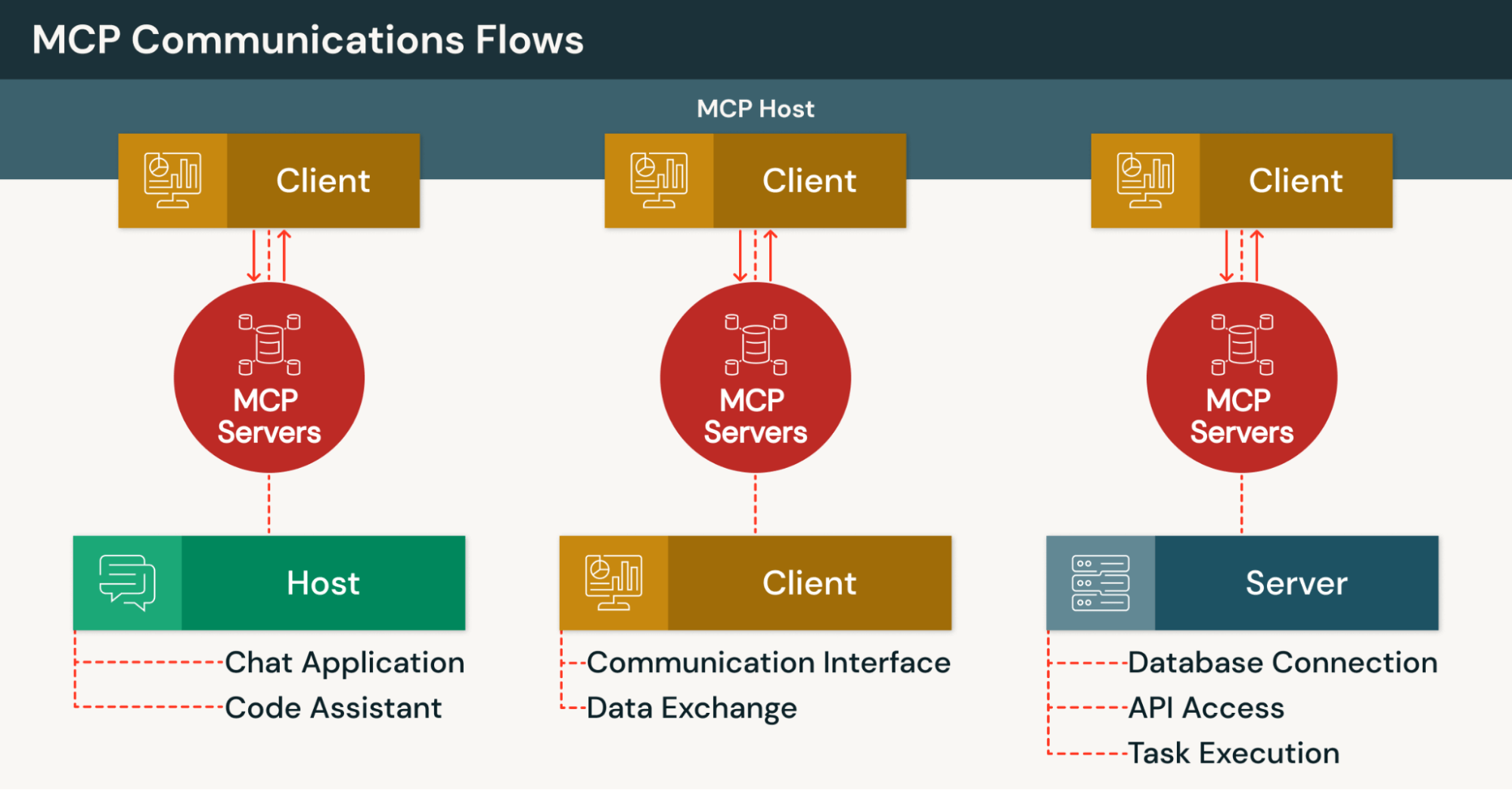

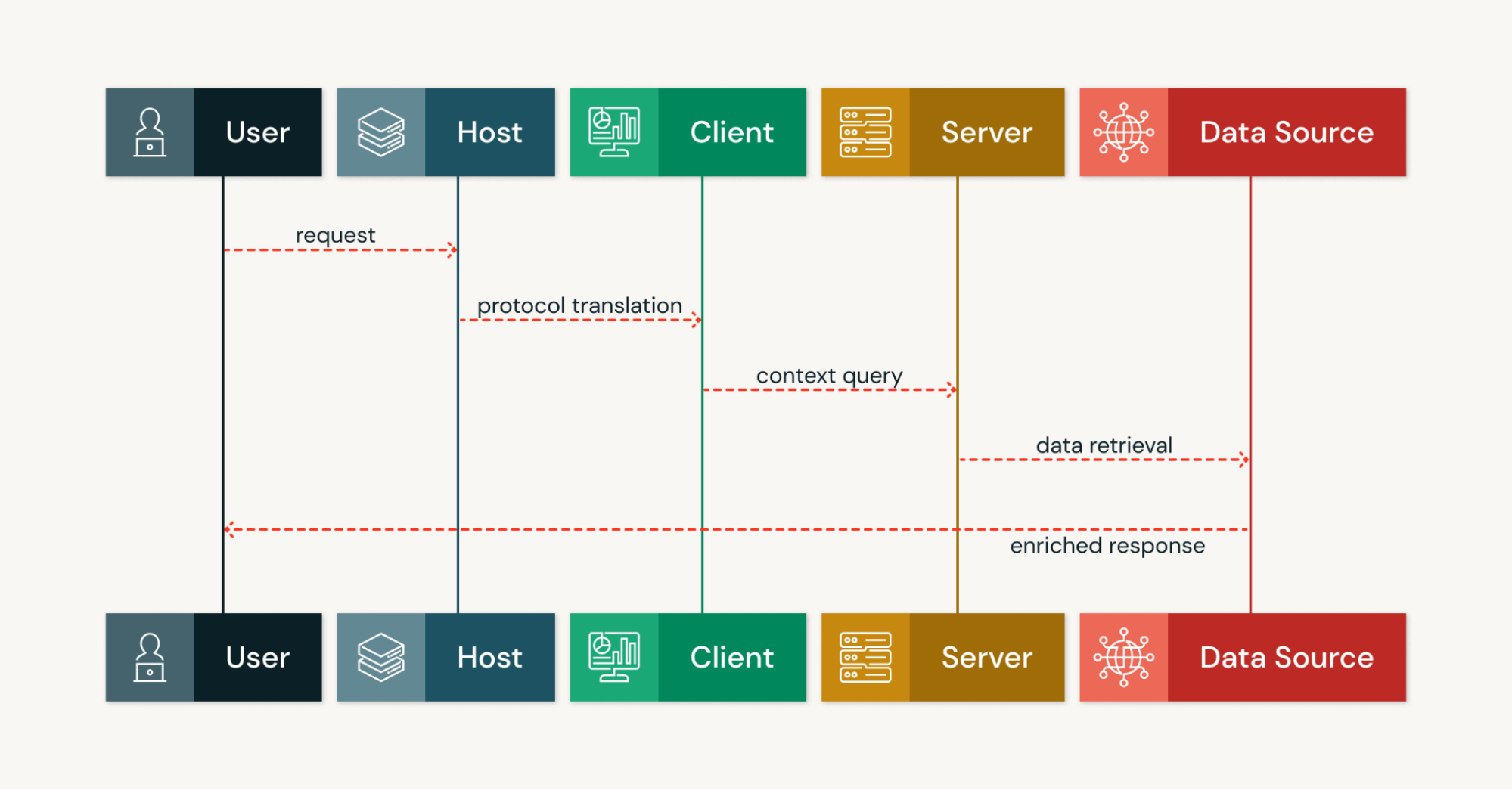

L'architettura MCP organizza le integrazioni attorno a tre ruoli chiave (server MCP, client MCP e host MCP) connessi tramite canali di comunicazione persistenti. Questa architettura client-server consente agli strumenti di IA di eseguire flussi di lavoro stateful a più passaggi anziché interazioni isolate di tipo richiesta-risposta.

Cosa fanno i server MCP

I server MCP espongono dati e strumenti tramite interfacce standardizzate e possono essere eseguiti in ambienti cloud, on-premise o ibridi. Ogni server pubblica una "capability surface" di risorse denominate, strumenti richiamabili, prompt e hook di notifica. Le risorse possono includere documenti, righe di database, file e output di pipeline.

Le implementazioni dei server MCP utilizzano metodi e notifiche JSON-RPC 2.0, supportano lo streaming per operazioni a lunga esecuzione e forniscono un rilevamento leggibile dalla macchina tramite il livello di trasporto. Ciò consente agli host MCP e ai modelli di AI di eseguire query sulle funzionalità in fase di esecuzione senza richiedere una conoscenza predefinita degli strumenti disponibili.

Le implementazioni più diffuse di server MCP collegano i sistemi di AI a servizi esterni come Google Drive, Slack, GitHub e i database PostgreSQL. Questi server MCP gestiscono l'autenticazione, il recupero dei dati e l'esecuzione degli strumenti, presentando al contempo un'interfaccia coerente attraverso il protocollo standardizzato. Ogni server nell'ecosistema MCP può servire più client contemporaneamente.

Come funzionano i client MCP

I client MCP sono componenti all'interno di applicazioni host che traducono gli intenti dell'utente o del modello in messaggi di protocollo. Ogni client in genere mantiene una connessione uno-a-uno con un server MCP e gestisce i dettagli del ciclo di vita, dell'autenticazione e del trasporto in modo strutturato.

I client MCP serializzano le richieste come chiamate strutturate utilizzando JSON-RPC, gestiscono le notifiche asincrone e gli stream parziali e presentano un'API locale unificata per ridurre la complessità dell'integrazione. Più client possono operare dallo stesso host MCP, ciascuno collegandosi contemporaneamente a diversi server MCP.

Questi client consentono agli agenti AI di interagire con sorgenti di dati esterne senza comprendere i dettagli di implementazione di ogni servizio esterno. Il client gestisce automaticamente tutti i protocolli di comunicazione, la gestione degli errori e la logica di ripetizione.

Il ruolo degli host MCP

Gli host MCP forniscono il livello applicativo di IA che coordina i client MCP e le capacità del server. Gli esempi includono Claude Desktop, Claude Code, IDE basati sull'IA e altre piattaforme in cui operano agenti IA. L'host MCP aggrega prompt, stato della conversazione e risposte del client per orchestrare flussi di lavoro multi-strumento.

L'host MCP decide quando richiamare gli strumenti, richiedere input aggiuntivo o visualizzare notifiche. Questa orchestrazione centralizzata consente ai modelli di IA di funzionare su server MCP eterogenei senza codice personalizzato per ogni servizio, supportando l'obiettivo dell'ecosistema MCP di interoperabilità universale nel collegare gli assistenti di IA a sistemi diversi.

Flusso di contesto e comunicazione bidirezionale

La comunicazione client-server nel Model Context Protocol è bidirezionale e basata su messaggi, utilizzando JSON-RPC 2.0 sul livello di trasporto. I client MCP richiamano metodi per recuperare risorse o invocare strumenti, mentre i server MCP restituiscono risultati, trasmettono in streaming output parziali e inviano notifiche con informazioni pertinenti.

I server MCP possono anche avviare richieste, chiedendo agli host MCP di campionare opzioni o di sollecitare l'input dell'utente tramite meccanismi di chiamata di funzione. Questa funzionalità bidirezionale distingue il protocollo di contesto dai tradizionali modelli API unidirezionali. Le ricerche autorevoli in tempo reale dell'MCP integrano il RAG fornendo record just-in-time con metadati di provenienza per la tracciabilità.

I trasporti persistenti preservano l'ordine dei messaggi e abilitano aggiornamenti in tempo reale, consentendo ai sistemi di IA di iterare su output intermedi ed eseguire cicli agentici che rendono possibili gli agenti IA autonomi.

Quali sono i requisiti per il Protocollo di Contesto del Modello?

Requisiti di sicurezza e protezione dalle minacce

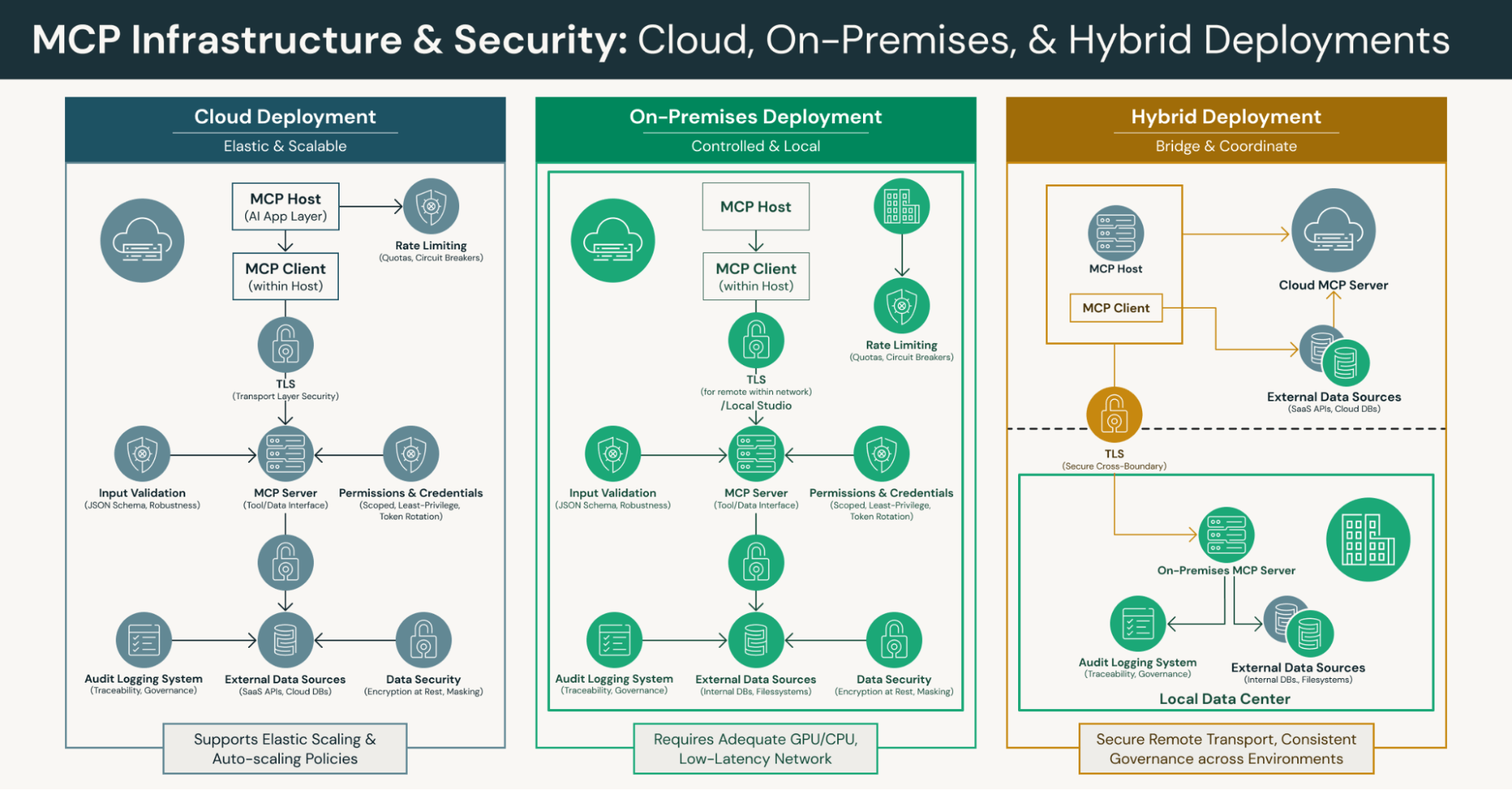

Le implementazioni MCP devono applicare la Transport Layer Security (TLS) per i trasporti remoti, autorizzazioni rigorose per gli strumenti e credenziali con ambito definito per proteggersi dalle minacce alla sicurezza. Il protocollo richiede il rate limiting e una solida convalida degli input tramite l'applicazione di uno schema JSON sia sui client che sui server MCP per prevenire attacchi di tipo injection e richieste malformate.

La registrazione degli audit, la rotazione dei token e le concessioni del privilegio minimo sono requisiti essenziali per la governance dei canali a lunga durata. Queste misure di sicurezza proteggono dall'accesso non autorizzato, preservando al contempo le funzionalità di integrazione rilevabili abilitate dal Protocollo di Contesto del Modello. Le organizzazioni devono implementare la crittografia in transito e a riposo, il mascheramento e autorizzazioni con ambito definito per i canali MCP a lunga durata per garantire la sicurezza dei dati.

Infrastruttura e requisiti di sistema

Le organizzazioni che implementano l'MCP necessitano di un'infrastruttura di compute e di rete in grado di ospitare modelli linguistici di grandi dimensioni, server MCP e sorgenti di dati collegate. Ciò include un'adeguata capacità di GPU/CPU, memoria, I/O su disco e percorsi di rete a bassa latenza tra i componenti dell'architettura client-server.

Le piattaforme cloud dovrebbero supportare il dimensionamento elastico delle istanze dei modelli e dei server MCP. I team devono definire policy di dimensionamento automatico per Stream simultaneo e attività operative di lunga durata. Il livello di trasporto dovrebbe supportare sia STDIO locale per i componenti integrati sia canali di streaming remoti come HTTP/SSE o WebSocket per le implementazioni distribuite.

Requisiti di implementazione per il funzionamento di MCP

Il lavoro su MCP richiede l'implementazione della messaggistica JSON-RPC 2.0, degli endpoint di rilevamento e degli schemi di risorse/strumenti. I server MCP devono pubblicare le loro funzionalità in un formato leggibile dalla macchina tramite il protocollo standard. Ciò consente agli sviluppatori di creare integrazioni basate sul rilevamento che supportano il rilevamento degli strumenti senza connessioni hardcoded.

La gestione degli errori, le strategie di riconnessione e la gestione della contropressione (backpressure) sono requisiti di implementazione critici per l'affidabilità in produzione. Le organizzazioni dovrebbero implementare l'osservabilità per Stream persistenti, latenze dei metodi e utilizzo delle risorse utilizzando metriche, tracce e log. Rate limiter, circuit breaker e quote proteggono i sistemi downstream dal sovraccarico.

Vantaggi pratici: accesso ai dati in tempo reale e riduzione delle allucinazioni

Con il Model Context Protocol, i modelli di IA recuperano record in tempo reale, output di pipeline, risposte di API e file on-demand invece di basarsi esclusivamente su embedding memorizzati nella cache o sui dati di addestramento statici degli LLM. Questo basa le risposte su sorgenti di dati attuali e autorevoli e riduce le allucinazioni in cui i sistemi di IA generano informazioni errate.

Le risorse restituite al momento della query includono metadati di provenienza come ID di origine e Timestamp, consentendo agli host MCP di registrare le origini e rendere gli output tracciabili. Questa trasparenza è fondamentale quando gli agenti di IA eseguono attività che richiedono auditabilità nei settori industriali regolamentati. Il protocollo di contesto garantisce che il contesto pertinente sia sempre disponibile da sistemi esterni autorevoli.

Supporto per flussi di lavoro di IA agentiva

Poiché i server MCP pubblicano risorse, strumenti e prompt in modo standardizzato, i modelli di IA possono individuare e richiamare servizi senza Endpoint hardcoded. Lo standard aperto supporta l'elicitazione avviata dal server e le risposte in streaming dai server MCP, abilitando il ragionamento multi-passo, la chiarificazione dell'input e l'iterazione sui risultati parziali.

Gli strumenti espongono input/output definiti da JSON Schema con autorizzazioni limitate per gli strumenti, consentendo agli agenti IA di eseguire azioni controllate come la creazione di ticket, l'esecuzione di query SQL o l'esecuzione di flussi di lavoro. Questa scoperta autonoma degli strumenti, l'interazione bidirezionale e i guardrail integrati forniscono le basi per un'IA agentiva affidabile su sistemi esterni.

Il Model Context Protocol (MCP) abilita esplicitamente flussi di lavoro agentici che si basano sul rilevamento dinamico degli strumenti e su primitive di azione per percepire, decidere e agire su più sistemi. Questo rende possibile creare agenti IA che operano in modo autonomo, mantenendo al contempo adeguati controlli di governance.

Sviluppo semplificato con integrazioni standardizzate

Il protocollo di contesto consente agli sviluppatori di implementare un'unica superficie server che gli host MCP e i modelli di IA possono riutilizzare con semantiche di discovery e di chiamata coerenti. Ciò elimina la necessità di connettori separati per i servizi comuni, riducendo lo sforzo ingegneristico necessario per connettere gli assistenti IA a nuove sorgenti di dati.

Le risorse tipizzate e lo schema JSON riducono il codice personalizzato di serializzazione, validazione e gestione degli errori che altrimenti sarebbe necessario. I trasporti locali STDIO o di streaming remoto consentono ai team di scegliere distribuzioni on-premise, cloud o ibride senza modificare la logica dell'host MCP. Questa flessibilità accelera il modo in cui i team creano agenti IA in diversi ambienti di sviluppo.

L'MCP offre un modo pratico per standardizzare le integrazioni una sola volta, invece di creare adattatori personalizzati per ogni nuova integrazione. Questo approccio basato su un protocollo standardizzato avvantaggia l'intero ecosistema MCP man mano che sempre più organizzazioni adottano lo standard.

Maggiore potenziale di automazione per flussi di lavoro complessi

I canali persistenti e stateful dell'MCP consentono ai sistemi di intelligenza artificiale di combinare ricerche, trasformazioni ed effetti collaterali su più servizi esterni in un unico ciclo continuo. Per le attività operative a esecuzione prolungata, i server MCP possono trasmettere in streaming i risultati parziali in modo che gli agenti di IA prendano decisioni intermedie, biforchino i flussi di lavoro o richiedano l'intervento umano quando necessario.

La combinazione del recupero indicizzato per repository di contenuti evergreen con le ricerche autorevoli on-demand del Model Context Protocol supporta risposte rapide e accurate. Questo approccio ibrido mantiene i controlli di governance, consentendo al contempo agli strumenti basati sull'IA di accedere sia a basi di conoscenza statiche sia a fonti di dati esterne dinamiche.

Il supporto del protocollo di contesto per l'orchestrazione multi-turn consente ai sistemi agentivi di gestire flussi di lavoro complessi che richiedono il coordinamento tra più strumenti e fonti di dati. Questo potenziale di automazione trasforma il modo in cui le organizzazioni distribuiscono le applicazioni di IA negli ambienti di produzione.

Best practice di implementazione: preparazione del sistema

Verifica che la tua infrastruttura possa supportare l'hosting di LLM, i server MCP e le sorgenti di dati connesse. Garantire risorse GPU/CPU, allocazione di memoria e larghezza di banda di rete adeguate per l'architettura client-server. Scegliere piattaforme cloud che supportano la scalabilità elastica per utenti simultanei e definire policy di scalabilità automatica.

Standardizzare i trasporti sicuri utilizzando il TLS per tutte le connessioni remote tra client e server MCP. Documentare la gestione del ciclo di vita della connessione, incluse le strategie di riconnessione e le metriche osservabili sullo stato degli stream. Implementare limiti di velocità, circuit breaker e quote per proteggere dal sovraccarico i sistemi esterni downstream.

Le organizzazioni dovrebbero standardizzare i canali di streaming (HTTP/SSE, WebSocket) oltre allo STDIO locale per i componenti integrati. Convalidare i payload e lo schema JSON sia sul server che sul client per prevenire attacchi di tipo injection e garantire una corretta gestione degli errori in tutto il sistema.

Sfruttare le risorse open source nei linguaggi di programmazione

L'ecosistema MCP include SDK della community in più linguaggi di programmazione che accelerano lo sviluppo di client e server. Questi SDK forniscono pattern consolidati per la messaggistica JSON-RPC, lo streaming e la convalida dello schema, eliminando la necessità di reimplementare i meccanismi di base del protocollo.

Gli sviluppatori possono riutilizzare le implementazioni di server MCP esistenti per i sistemi aziendali più diffusi ed estenderle a casi d'uso specifici del dominio attraverso lo standard aperto. La creazione di simulatori che imitano notifiche, stream a esecuzione prolungata e condizioni di errore aiuta i team a testare i sistemi agentici prima dell'implementazione in produzione.

Adotta le risorse della community per accelerare il lavoro su MCP ed evitare di ricreare funzionalità comuni. Questi strumenti open-source consentono agli sviluppatori di concentrarsi sulla logica di business piuttosto che sui dettagli di implementazione del protocollo.

Strategia di integrazione per l'implementazione in produzione

Start con casi d'uso ad alto impatto che dimostrano un ROI misurabile, come assistenti di AI sensibili al contesto o flussi di lavoro automatizzati che utilizzano agenti di AI. Limita gli ambiti e le autorizzazioni iniziali degli strumenti, raccogli dati di telemetria e feedback degli utenti, quindi espandi le funzionalità dopo aver stabilizzato le funzionalità principali.

Bilanciare latenza e attualità combinando i lookup in tempo reale di MCP con RAG per grandi corpora statici da repository di contenuti. Definire SLA, audit trail e procedure di escalation prima di un rollout di produzione su vasta scala. Questo approccio graduale riduce il rischio, aumentando al contempo la fiducia dell'organizzazione nelle implementazioni di IA agentiva.

L'MCP risponde all'esigenza di piani di integrazione strutturati che siano scalabili man mano che vengono aggiunti più server e client MCP all'ecosistema. Le organizzazioni dovrebbero documentare la loro architettura di integrazione e le policy di governance nelle fasi iniziali del processo di deployment.

Idee sbagliate comuni: MCP non è solo un altro framework API

In realtà: il Model Context Protocol standardizza l'integrazione a livello di protocollo con la gestione persistente del contesto e la scoperta dinamica delle capacità. A differenza delle chiamate REST o RPC, MCP definisce come gli agenti di IA scoprono le capacità, si iscrivono ai flussi (stream) e mantengono lo stato contestuale durante le interazioni attraverso il protocollo standard.

Questo protocollo standardizzato significa che è possibile creare strumenti una sola volta ed esporli in modo uniforme a più agenti di AI e fornitori di modelli attraverso l'ecosistema MCP. Invece di trattare il contesto del modello come un payload effimero, il protocollo di contesto tratta il contesto come una risorsa di prima classe e versionata, con una gestione del ciclo di vita adeguata.

Strumenti e agenti sono componenti diversi

Realtà: gli strumenti sono funzionalità discrete esposte tramite server MCP, come l'accesso a database, le attività operative sui file o le integrazioni API. Gli agenti IA sono programmi computer decisionali che scoprono, orchestrano e invocano gli strumenti disponibili per eseguire attività in modo autonomo.

Il protocollo di contesto consente agli agenti di IA di scoprire dinamicamente i metadati degli strumenti, richiamare in modo sicuro le interfacce degli strumenti con la semantica di chiamata di funzione e integrare gli output nelle conversazioni tramite i client MCP. Questa separazione consente a diversi sistemi di agenti di utilizzare lo stesso catalogo di strumenti, mentre i proprietari degli strumenti aggiornano le interfacce indipendentemente dalla logica dell'agente.

L'MCP gestisce una connettività dati completa

In realtà: il Model Context Protocol gestisce una connettività completa a sorgenti di dati esterne che va oltre il semplice utilizzo di strumenti. Supporta notifiche in streaming, accesso autenticato a repository di contenuti e database vettoriali, e semantica coerente per le attività operative a lunga esecuzione e la gestione degli errori.

MCP offre un modo pratico per unificare l'accesso a risorse locali, risorse remote, query di dati in tempo reale e azioni operative in modo strutturato. Questo approccio unificato favorisce la scalabilità di governance, osservabilità e controllo degli accessi di pari passo con le funzionalità di IA negli ambienti aziendali. Il protocollo di contesto gestisce altri strumenti e servizi esterni attraverso un'interfaccia coerente.

Direzioni di ricerca future ed evoluzione

Man mano che lo standard aperto matura, le future direzioni di ricerca includono framework di sicurezza avanzati per le implementazioni multi-tenant, semantiche di streaming migliorate per flussi di lavoro agentivi complessi e modelli standardizzati per l'integrazione con altri linguaggi di programmazione e ambienti di sviluppo.

L'ecosistema MCP in crescita continua a espandersi con nuove implementazioni di server MCP per strumenti e piattaforme esterni emergenti. I contributi della community a SDK, adattatori e architetture di riferimento accelerano l'adozione, mantenendo l'obiettivo principale del protocollo: consentire a qualsiasi applicazione di intelligenza artificiale di connettersi con qualsiasi servizio esterno in modo standardizzato.

Le organizzazioni che esplorano il Protocollo di Contesto del Modello dovrebbero monitorare gli sviluppi dell'ecosistema, contribuire alle implementazioni di MCP e partecipare a gruppi di lavoro che definiscono l'evoluzione della connessione degli assistenti AI a sistemi esterni. Questo approccio collaborativo garantisce che le implementazioni di MCP rimangano interoperabili man mano che i sistemi di IA e i servizi esterni continuano a progredire. Le future direzioni di ricerca si concentreranno probabilmente sull'espansione delle capacità del protocollo, mantenendo al contempo la sua semplicità di base.

Conclusione: il Model Context Protocol come fondamento per l'IA moderna

Il Model Context Protocol rappresenta un cambiamento fondamentale nel modo in cui le applicazioni di IA accedono a sorgenti di dati e strumenti esterni. Fornendo un protocollo aperto per l'integrazione basata sul rilevamento, il protocollo di contesto consente agli sviluppatori di creare agenti di IA consapevoli del contesto in grado di eseguire attività utilizzando dati in tempo reale provenienti da sistemi aziendali diffusi, senza un esteso codice di integrazione boilerplate.

Il protocollo standardizzato riduce la complessità attraverso l'architettura client-server, accelera i cicli di sviluppo e consente ai sistemi di IA di superare i limiti dei dati di addestramento statici degli LLM. Attraverso la sua comunicazione bidirezionale tra client MCP e server MCP e il supporto per i flussi di lavoro di IA agentiva, il Model Context Protocol (MCP) pone le basi per strumenti di IA più capaci e autonomi in ambienti diversi.

Man mano che l'ecosistema MCP cresce con nuove implementazioni e integrazioni di server MCP, le organizzazioni possono creare agenti IA sofisticati che scoprono e orchestrano molteplici servizi esterni, mantenendo al contempo le autorizzazioni corrette per gli strumenti, i controlli di sicurezza e gli audit trail. Questo approccio standardizzato per connettere i sistemi di AI a strumenti e sorgenti di dati esterni continuerà a plasmare il modo in cui le aziende implementano le applicazioni di AI di produzione. Il protocollo di contesto fornisce l'infrastruttura essenziale che consente agli sviluppatori di creare applicazioni di IA di nuova generazione con sicurezza.