新しいLLMOps機能を備えたMLflow 2.7のご紹介

プロンプト・エンジニアリングとAIゲートウェイのアップデートのための新しいUI

翻訳:Junichi Maruyama. - Original Blog Link

MLflow 2のLLMOpsサポートの一環として、MLflow 2.7のプロンプト・エンジニアリングをサポートする最新のアップデートをご紹介します。

インタラクティブなプロンプト・インターフェイスでLLMプロジェクトの実行可能性を評価する

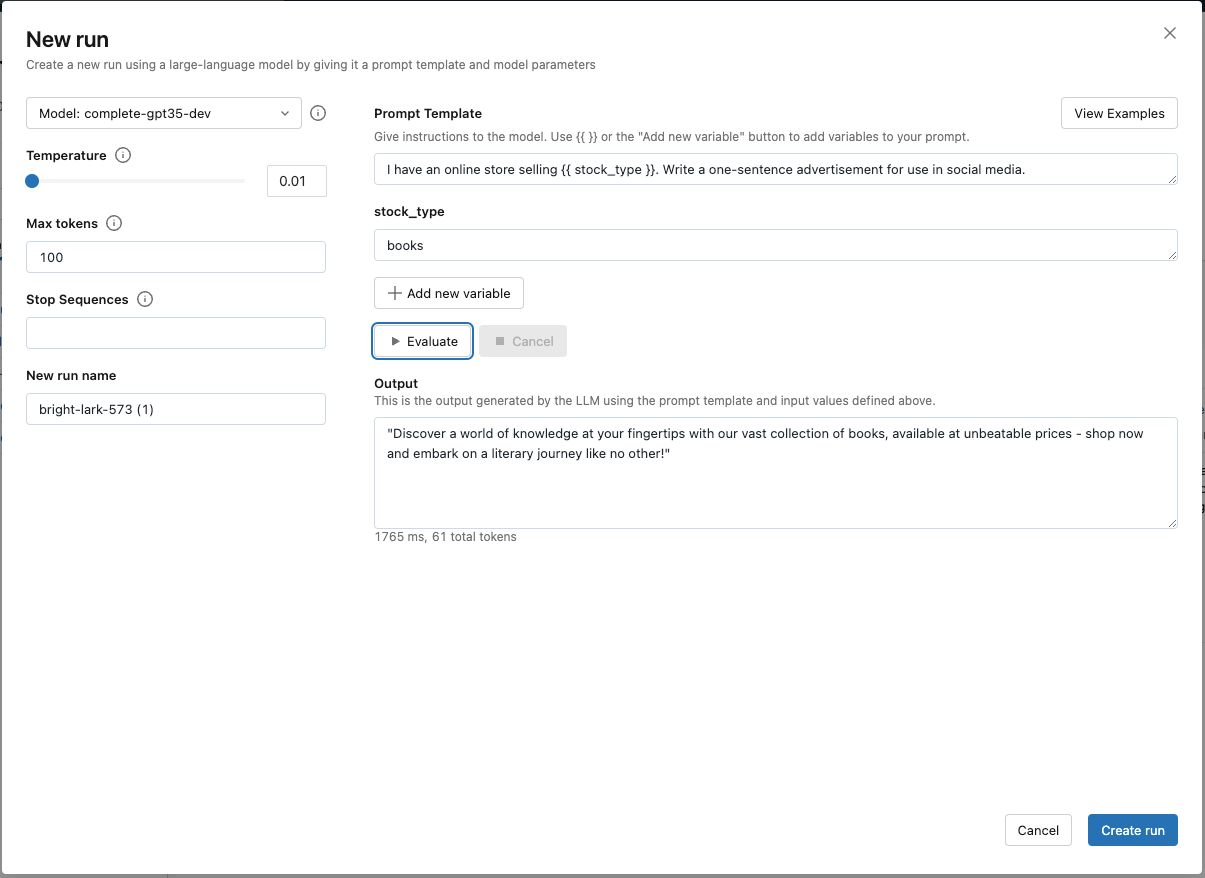

プロンプトエンジニアリングは、ユースケースが大規模言語モデル(LLM)で解決できるかどうかを迅速に評価するための優れた方法です。MLflow 2.7 の新しいプロンプト・エンジニアリング UI を使用すると、ビジネス関係者はさまざまなベースモデル、パラ メータ、プロンプトを試して、出力が新しいプロジェクトを開始するのに十分有望かどうかを確認できます。新規のブランク・エクスペリメントを作成するか(既存のエクスペリメントを開く)、「新規実行」をクリックするだけで、インタラクティブなプロンプト・エンジニアリング・ツールにアクセスできます。プレビューに参加するには、こちらからサインアップしてください。

プロンプトエンジニアリング実験を自動的に追跡して評価データセットを構築し、最適なモデル候補を特定する

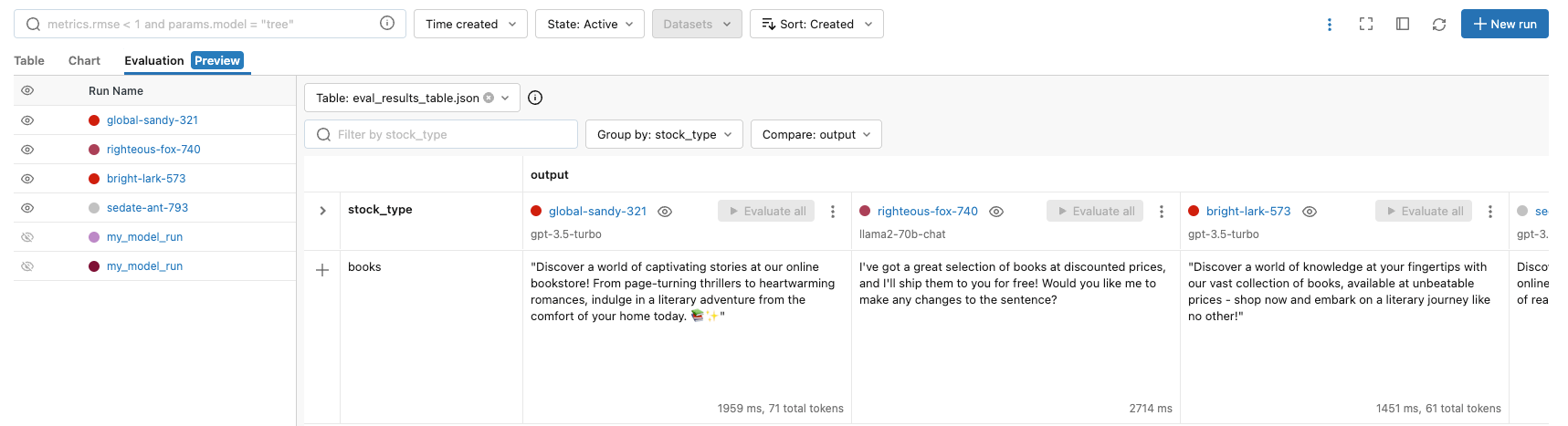

新しいプロンプト・エンジニアリング UI では、ユーザーは「Create run」をクリックして結果を MLflow に記録することで、評価ランを明示的に追跡することができます。このボタンは、パラメータ、ベースモデル、およびプロンプトのセットを MLflow モデルとして追跡し、出力は評価テーブルに保存されます。このテーブルは、手動評価に使用したり、SQL でのより深い分析のために Delta テーブルに変換したり、CI/CD プロセスのテストデータセットとして使用することができます。

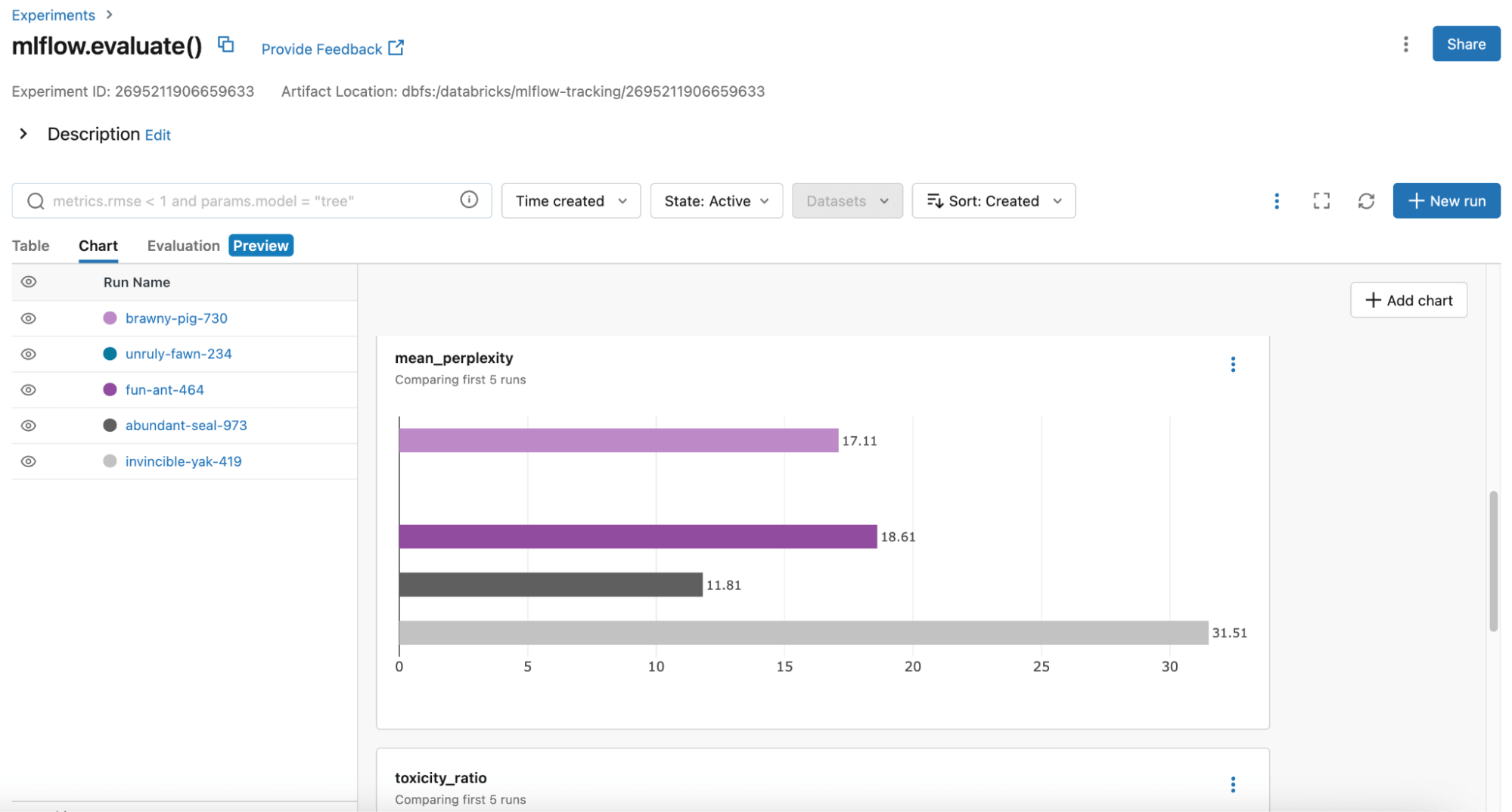

MLflow は、本番環境に最適なモデル候補を特定するために、MLflow 評価 API に毒性と当惑度を含むより多くのメトリッ クスを常に追加しています。ユーザーは、MLflow Table または Chart ビューを使用してモデルのパフォーマンスを比較できます:

MLflow は、本番環境に最適なモデル候補を特定するために、MLflow 評価 API に毒性と当惑度を含むより多くのメトリッ クスを常に追加しています。ユーザーは、MLflow Table または Chart ビューを使用してモデルのパフォーマンスを比較できます:

ETL を実行する

パラメータ、プロンプト、およびベースモデルのセットは MLflow モデルとして記録されるため、これはバッチ推論でパラメータを設定したベースモデル用の固定プロンプトテンプレートをデプロイしたり、Databricks Model Serving を使用して API として提供したりできることを意味します。LangChainユーザーにとっては、MLflowがモデルのバージョニングを備えているため、これは特に有用です。

ガードレールにより、組織全体でアドホックな実験を民主化する

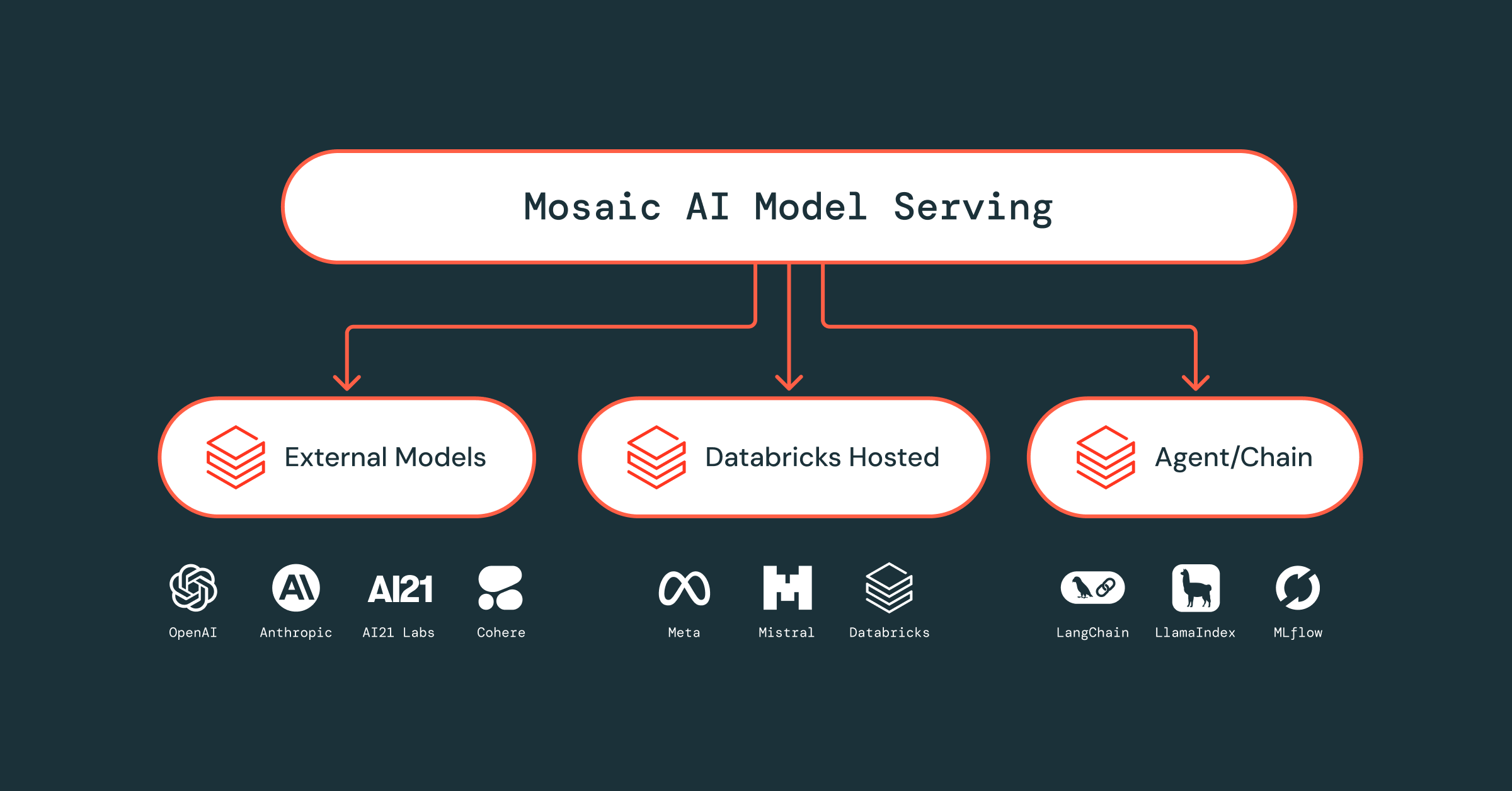

MLflow のプロンプト エンジニアリング UI は、どの MLflow AI Gateway ルートとも連動します。例えば、OpenAIのGPT-3.5-turboをGatewayルートの後ろに置くことで、どのユーザーがルートを照会できるかを管理し、安全なクレデンシャル管理を提供し、レート制限を提供することができます。これは悪用から保護し、プラットフォームチームが実験のために組織全体でLLMへのアクセスを民主化する自信を与えます。

MLflow AI Gateway は、OpenAI、Cohere、Anthropic、Databricks Model Serving のエンドポイントをサポートしています。しかし、一般化されたオープンソースのLLMは、プロプライエタリな一般化されたLLMとますます競争力を増しており、あなたの組織は、これらのオープンソースモデルを迅速に評価し、実験したいと思うかもしれません。MosaicMLがホストするLlama2-70b-chatにChatすることもできます。

あなたのLLM開発のために、今すぐMLflowをお試しください!

LLM開発のための最も一般的なワークフローをMLflowでサポートし、標準化するために迅速に取り組んでいます。このデモ・ノートブックで、MLflow の使用例をご覧ください。その他のリソース

- MLflow AI Gateway プレビューへのサインアップ(プロンプトエンジニアリング UI を含む) here.

- プロンプトエンジニアリングUIを使い始めるには、MLflowのバージョンをアップグレードし(pip install -upgrade mlflow)、MLflow Experimentを作成し、"New Run "をクリックするだけです。

- 同じ質問セットで様々なモデルを評価するには、MLflow Evaluation APIを使用します。

- MLflow AI Gateway, でサポートしたい SaaS LLM エンドポイントがある場合は、MLflow リポジトリの貢献ガイドラインに従ってください。貢献は大歓迎です!