AI ��에이전트 정확도를 위한 맞춤형 LLM 심사위원 구축

MLflow에서 도메인별 심사위원 생성을 간소화하고 Agent Bricks를 향상시키는 새로운 LLM-as-a-Judge 기능을 소개합니다.

Summary

- 조정 가능한 심사위원을 사용하여 도메인 전문가와 의견이 일치하는 도메인별 평가자를 체계적으로 조정하세요

- 심사위원으로서의 에이전트는 자연어를 사용하여 복잡한 심사위원을 생성하는 프로세스를 간소화합니다

- 심사위원 생성 및 유지를 단순화하는 직관적인 시각적 워크플로인 Judge Builder에서 이 모든 기능과 그 이상을 사용하세요

AI 에이전트가 프로토타입에서 프로덕션으로 전환됨에 따라, 조직은 에이전트가 예측 불가능하게 행동할 때 평판 위험을 방지하기 위해 품질을 보장하고 평가 프로세스를 확장해야 합니다. MLflow는 정확성, 관련성, 안전성과 같은 주요 차원을 평가하는 연구 기반의 기본 내장 LLM 심사위원을 통해 이러한 문제를 해결하는 데 도움이 됩니다. 하지만 많은 실제 애플리케이션에서는 일반적인 품질 지표 이상의 것을 요구하며, 고유한 컨텍스트에 맞는 도메인별 평가가 필요합니다. 예를 들어 고객 지원 챗봇을 심사하는 기준은 의료 진단 어시스턴트나 금융 자문 봇을 평가하는 데 사용되는 기준과 크게 다릅니다.

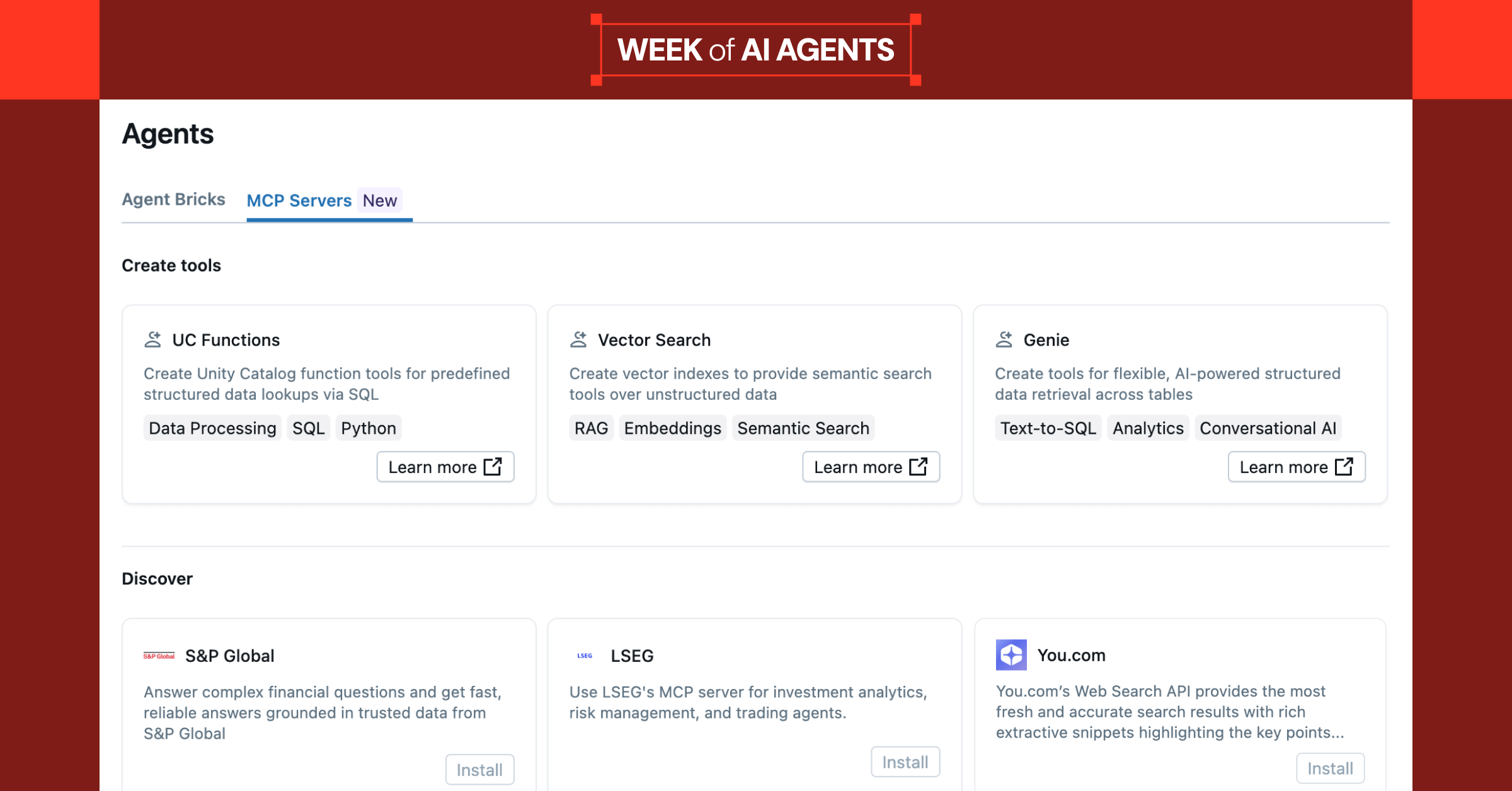

이전에는 맞춤형 평가 로직을 구축하는 데 시간이 많이 걸리고 개발자와 도메인 전문가(비즈니스 컨텍스트, 규정 및 품질 표준에 대한 깊은 지식을 갖춘 전문가) 간의 긴밀한 협업이 필요하여 개발 주��기에 병목 현상이 발생했습니다. Databricks Week of Agents의 일환으로 Agent Bricks 에서 이 프로세스를 더 빠르고 확장 가능하게 만들기 위해 설계된 MLflow 기반의 새로운 기능 세 가지를 소개합니다.

- Tunable Judges 는 도메인 전문가와의 체계적인 조정을 지원합니다

- Agent-as-a-Judge 는 평가할 트레이스 부분을 자동으로 결정하여 복잡한 메트릭에 대한 수동 구현 오버헤드를 제거합니다

- Judge Builder 는 이 모든 기능을 직관적인 시각적 워크플로로 제공하여 개발자와 도메인 전문가 간의 협업을 간소화합니다.

이러한 MLflow 기반 기능들을 통해 Agent Bricks는 팀이 고품질 AI 에이전트를 구축, 모니터링하고 지속적으로 개선하는 방식을 간소화할 수 있습니다.

조정 가능한 평가자 만들기

MLflow 3.4.0에 도입된 새로운 make_judge SDK를 통해 복잡한 프로그래밍 방식의 로직 대신 자연어 지침을 사용하여 특정 사용 사례에 맞는 맞춤형 LLM 심사위원을 손쉽게 만들 수 있습니다. 평가 기준을 정의하기만 하면 MLflow가 구현 세부 정보를 처리합니다.

첫 번째 심사위원을 생성하고 나면 MLflow의 튜닝 및 정렬 도구를 사용하여 주제 전문가의 피드백을 루프에 인코딩할 수 있습니다. 도메인 전문가의 의견이나 채점 데이터를 가져와 맞춤형 심사위원에게 직접 입력할 수 있으며, 이를 통해 평가 로직이 특정 사용 사례에 대해 '좋음'이 무엇을 의미하는지 학습하게 됩니다. 품질 개선은 일회성 작업이 아니라 루프입니다. 피드백을 수집하여 심사위원을 재학습시키거나 조정할 때마다 심사위원은 더욱 일관성을 갖게 되며 실제 사용자가 성공을 측정하는 방식에 더 가까워집니다. 시간이 지남에 따라 이러한 꾸준한 튜닝을 통해 평가의 신뢰성을 유지하고 에이전트를 대규모로 개선할 수 있습니다.

“미래의 마케팅 최적화를 실현하기 위해서는 AI 에이전트에 대한 절대적인 신뢰가 필요합니다. `make_judge` API는 도메인별 심사위원을 지속적으로 정렬할 수 있는 프로그래밍 방식의 제어를 제공하여 어트리뷰션 모델링에서 최고 수준의 정확성과 신뢰성을 보장합니다.”— Tjadi Peeters, Billy Grace CTO

시작하려면 첫 번째 맞춤형 심사위원을 만드세요:

심사위원을 인간 전문가의 지식과 일치시키려면 사람의 피드백이 포함된 trace를 수집한 다음 MLflow의 정렬 최적화를 사용하세요:

전체 설명서를 통해 자신만의 조정 가능한 LLM 평가자 를 정의하고 평가자를 조정하는 방법을 알아보세요. 그런 다음 평가자를 Experiment에 등록하고 프로덕션에서 품질을 모니터링하는 데 사용할 수 있습니다.

오프라인 평가에서도 평가자를 마찬가지로 쉽게 사용할 수 있습니다.

평가 시 스코어러 사용 및 프로덕션에서의 지속적인 품질 모니터링 에 대해 자세히 알아보세요.

Agent-as-a-Judge 시작

Agent-as-a-Judge는 추적의 어떤 부분이 관련 있는지 자동으로 식별하여 평가 프로세스에 인텔리전스를 더함으로써 복잡한 수동 추적 순회 로직의 필요성을 없애줍니다! 심사위원 지침에 {{ trace }} 변수를 포함하기만 하면 Agent-as-a-Judge가 평가에 적합한 데이터를 가져옵니다.

특정 도구가 호출되었는지, 인수가 유효한지 또는 중복 호출이 발생했는지 확인하는 등 여러 평가 시나리오에서 기존 평가 프레임워크는 추적 구조를 수동으로 검색하고 필터링하기 위한 맞춤형 코드를 작성해야 합니다. 에이전트나 평가 요구사항이 발전함에 따라 이 코드는 복잡하고 취약해질 수 있습니다. agent-as-a-judge를 사용하면 심사위원은 수동 데이터 처리가 아니라 의도와 결과에 직접 집중할 수 있습니다:

이러한 선언적 접근 방식을 통해 judge를 읽기 쉽고 적응 가능하게 유지할 수 있습니다. 동일한 패턴을 확장하여 인수 유효성, 중복 도구 호출 또는 기타 사용자 지정 로직을 확인할 수 있습니다. 예를 들어 '이전 컨텍스트를 고려할 때 도구 호출 인수가 합리적인지 확인하고 도구가 중복 호출되지 않도록 하세요'와 같은 조건을 추가할 수 있습니다.

심사위원으로서의 에이전트는 다른 모든 심사위원과 동일한 정렬 기능을 지원하므로 이전에 표시된 구문을 사용하여 사람의 피드백으로 조정할 수 있습니다.여기에서 심사위원으로서의 에이전트 에 대해 자세히 알아보세요.

Gartner®: Databricks 클라우드 데이터베이스 리더

Judge Builder 소개

judge 생성 및 조정 프로세스를 더욱 간소화하기 위해 Judge Builder는 전체 judge 수명 주기를 관리할 수 있는 시각적 인터페이스를 제공합니다. 도메인 전문가는 직관적인 검토 환경을 통해 직접 피드백을 제공할 수 있으며, 개발자는 이 피드백을 사용하여 judge를 도메인 표준에 맞게 자동으로 조정합니다. 이는 기술적 구현과 도메인 전문 지식 간의 격차를 해소하고 피드백 수집, judge 조정, 수명 주기 관리를 간소화하며, 이 모든 것은 기존 MLflow 기능을 기반으로 구축되고 기존 MLflow Experiment와 통합됩니다.

Judge Builder를 start하려면 Databricks Marketplace로 이동하여 Judge Builder 앱을 workspace에 설치하세요. 자세한 정보는 여기를 클릭하거나 Databricks 담당자에게 문의하세요.

결론

Tunable Judges, Agent-as-a-Judge, Judge Builder를 사용하여 전문가 표준에 부합하고 사람의 피드백으로 지속적으로 개선되는 도메인별 LLM judge를 구축할 수 있습니다. 이러한 기능들이 함께 작용하여 MLflow로 고품질 AI 에이전트를 대규모로 더 쉽게 구축할 수 있게 해줍니다. 특히, 바로 이 기능들이 Agent Bricks를 구동하는 포괄적인 평가 엔진을 구성합니다.

프로토타이핑 초기 단계에 있든 수백만 명의 사용자에게 서비스를 제공하는 프로덕션 에이전트를 관리하든, MLflow와 Agent Bricks는 고품질 에이전트를 구축하고 자신 있게 프로덕션에 배포하는 데 필요한 도구를 제공합니다.

지금 시작해 보세요!

- 11월 11일에 Sam Altman 및 Ali Ghodsi와 함께하는'AI의 미래: 제대로 작동하는 에이전트 구축' 에 참여하세요.

- 조정 가능한 심사위원 둘러보기

- Agent-as-a-Judge 에 대해 알아보기

- Judge Builder 시작하기

- 저희가 발표한 다른 공지사항 보기: Week of Agents

(이 글은 AI의 도움을 받아 번역되었습니다. 원문이 궁금하시다면 여기를 클릭해 주세요)