성공적인 Mosaic AI 상위 활용 사례

에이전트 시스템을 위한 독보적인 통합 플랫폼

일반 AI 모델에 의존하지 마세요. Databricks는 데이터에 기반한 정확한 결과물을 제공하는 에이전트 시스템을 구축할 수 있는 도구를 제공합니다.정확도 44% 향상

96%의 응답 정확도

엔드투엔드 AI 에이전트 시스템 도구

Agent Bricks

당신의 기업 데이터에 기반을 둔 AI 에이전트를 구축하세요. Databricks Agent Bricks는 합성 데이터, 사용자 정의 평가, 그리고 자동 튜닝을 통해 품질과 비용을 최적화할 수 있게 해줍니다.

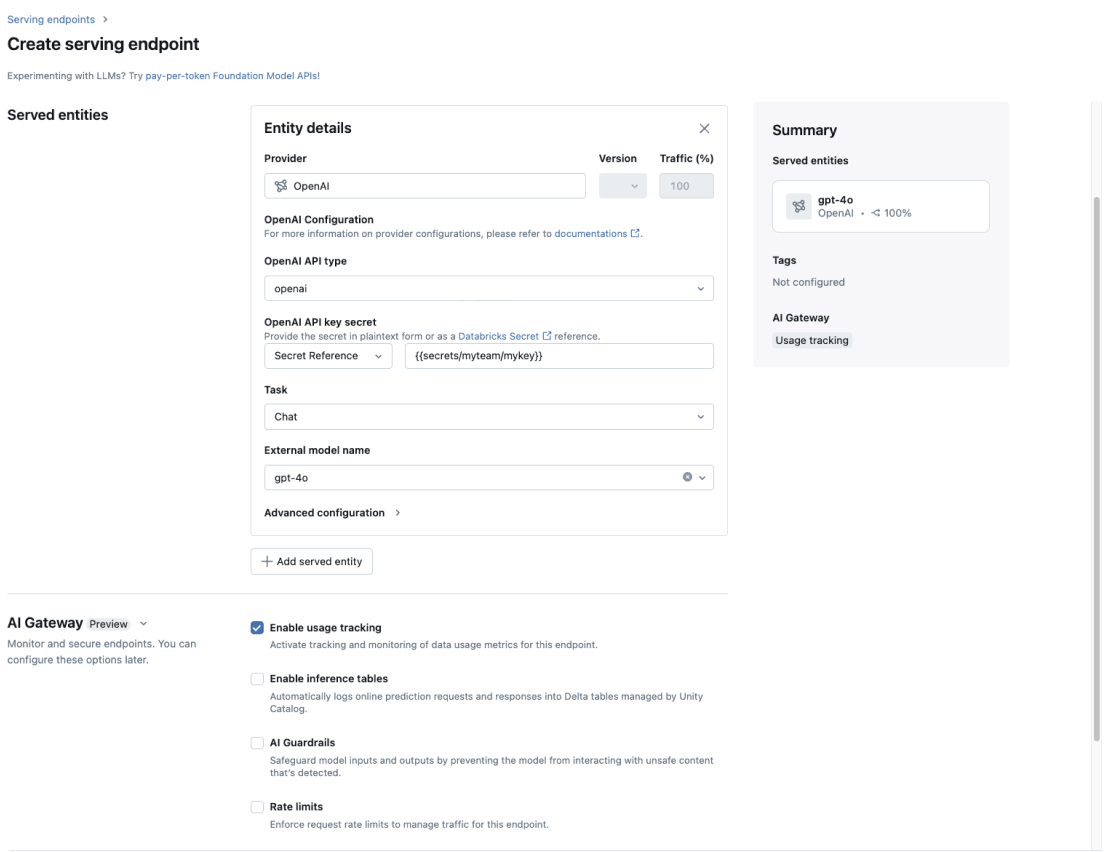

AI 게이트웨이

기업의 �모든 GenAI 모델에 데이터 거버넌스를 일관되게 적용하세요.

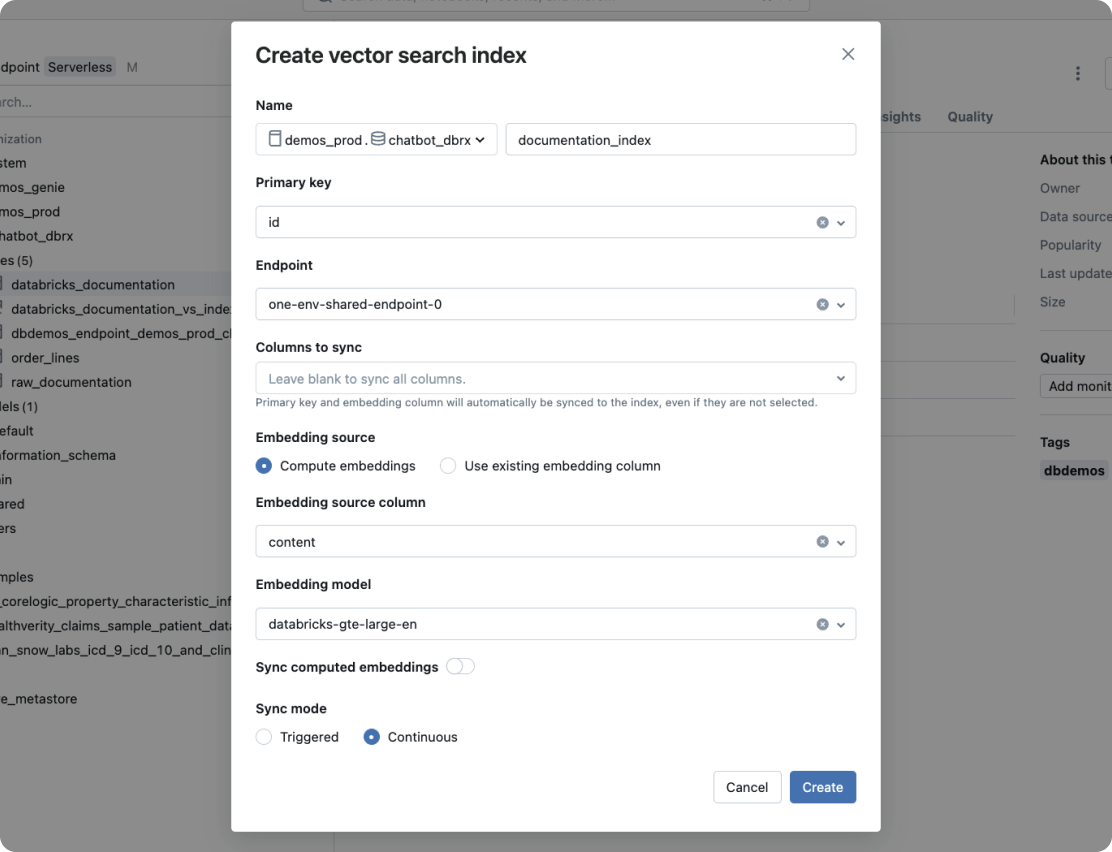

Vector Search

소스 데이터의 실시간 동기화를 지원하는 고성능의 벡터 데이터베이스입니다.

Agent Framework와 Agent Evaluation

Agent Framework를 사용하여 프로덕션 품질의 AI 에이전트를 구축하세요. 프레임워크의 필수 기능인 Agent Evaluation은 AI 지원 평가를 통해 에이전트 출력의 품질을 보장하고 인간 이해 관계자의 피드백을 위한 직관적인 UI를 제공합니다.

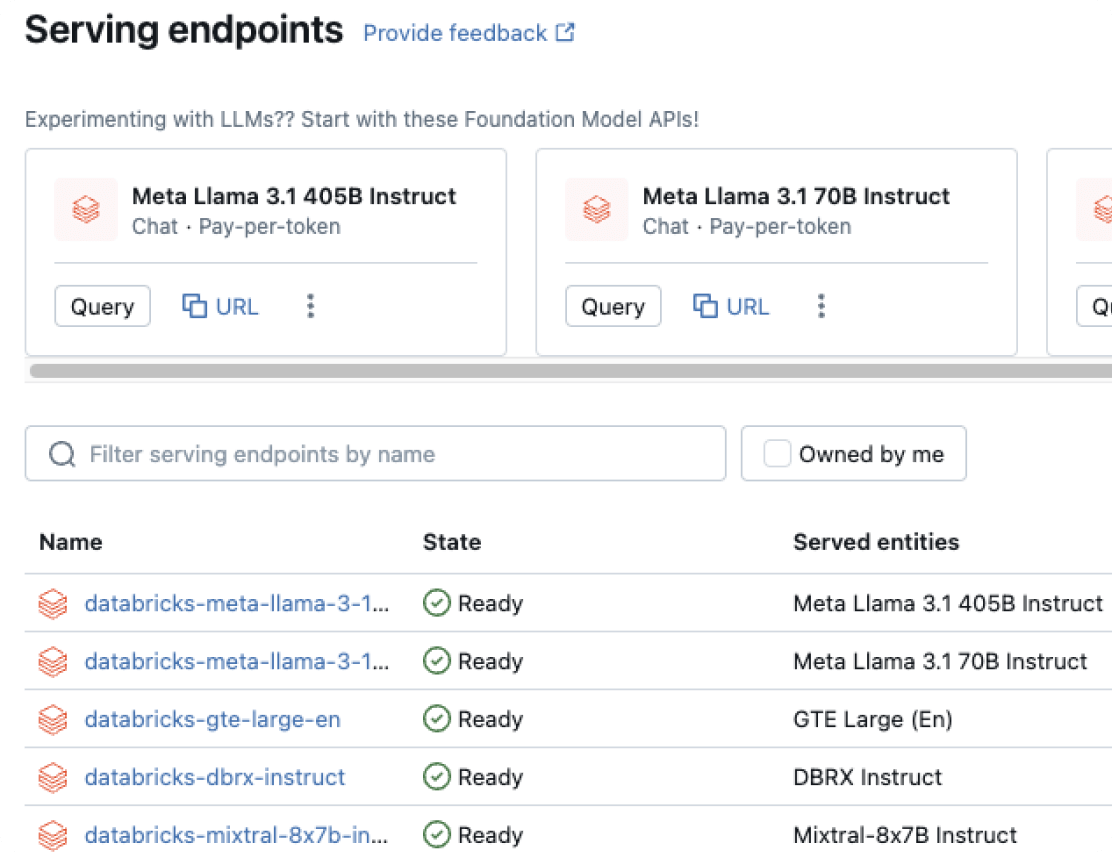

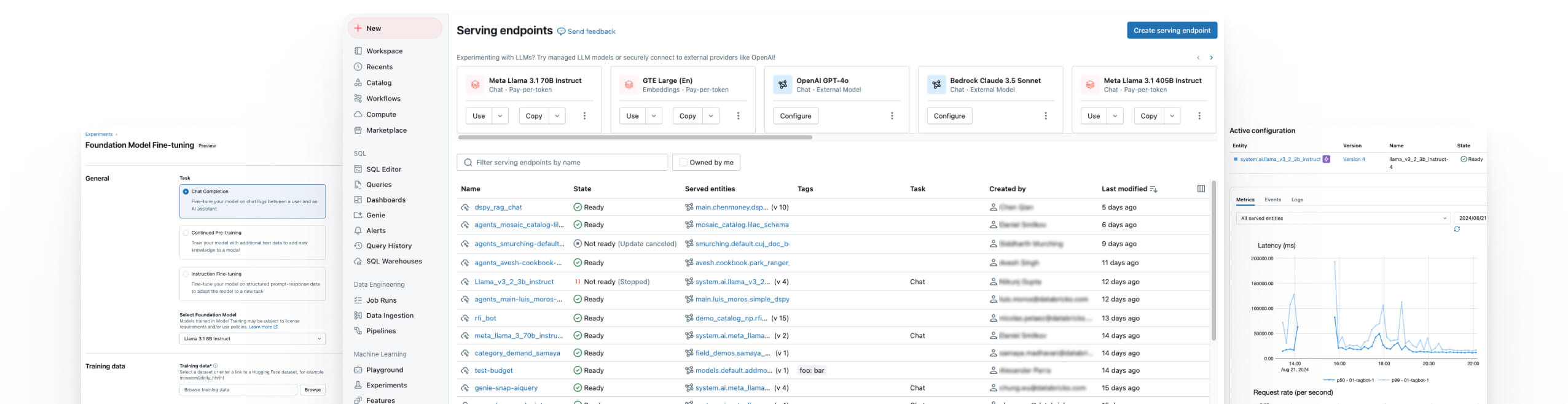

모델 제공

에이전트, GenAI 및 기존 ML 모델을 통합 배포할 수 있는 제품입니다.

모델 훈련

오픈 소스 LLM을 세부 조정하거나, 맞춤�형 LLM을 사전 학습시키거나, 기존 ML 모델을 구축하세요.

Databricks 노트북

실시간 협업과 간소화된 데이터 사이언스 워크플로를 지원하는 Databricks 협업용 노트북으로 팀 생산성을 높이세요.

관리형 MLFlow

더 나은 모델과 생성형 AI 앱을 구축하기 위한 통합 MLOps 플랫폼으로, 엔터프라이즈급 안정성, 보안, 확장성을 갖춘 오픈 소스 MLflow의 기능을 확장하세요.

데이터 품질 모니터링

간단하고 확장 가능한 모니터링으로 이상 징후를 감지하고 최신 상태를 추적하며, AI 자산 전반에 걸쳐 일관된 품질 신호를 제공합니다.

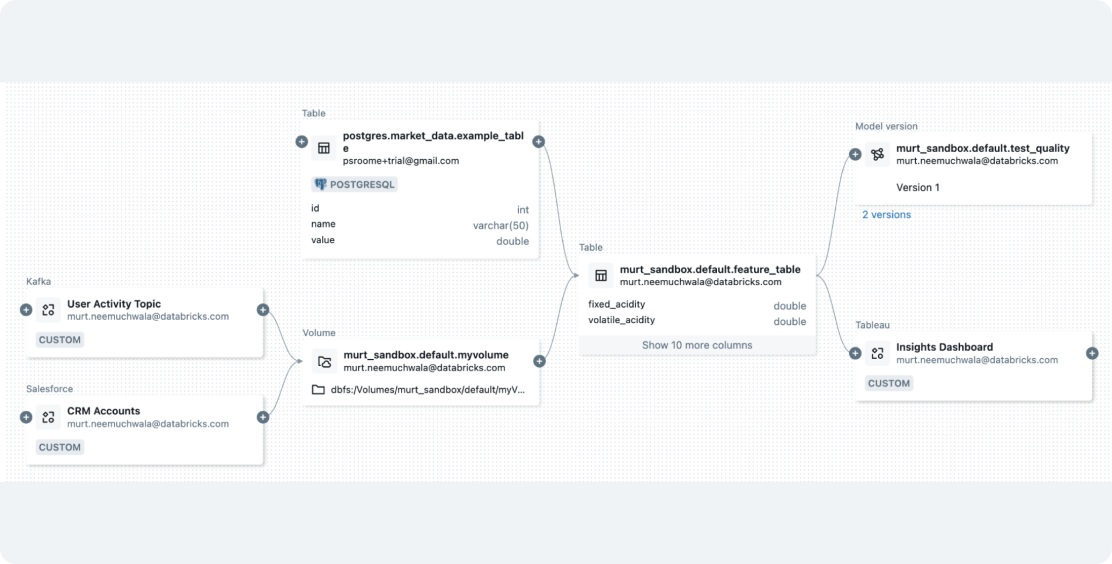

Databricks 데이터 인텔리전스 플랫폼

Databricks 데이터 인텔리전스 플랫폼에서 제공하는 다양한 도구를 활용하여 조직 전체에서 데이터와 AI를 원활하게 통합하세요.

고품질 에이전트 시스템 구축

손쉬운 데이터 변환

GenAI 및 ML 워크플로의 원활한 통합으로 데이터 준비

Databricks는 모든 데이터 유형을 수집하고 작업을 오케스트레이션하여 GenAI 또는 ML 애플리케이션에 맞게 준비할 수 있도록 지원합니다. 내장된 거버넌스를 통해 ��데이터 기능 개발을 단순화하고, Mosaic AI Vector Search를 사용하여 RAG용 벡터 인덱스를 생성하며, 데이터와 모델 파이프라인을 통합해 워크플로를 간소화하고 비용을 절감합니다.