Mosaic AI 에이전트 프레임워크

프로덕션 품질의 검색 증강 생성(RAG) 앱 구축

검색 증강 생성(RAG)은 질문이나 작업과 관련된 데이터/문서를 찾고 보다 정확한 응답을 제공하도록 이를 대규모 언어 모델(LLM)에 대한 컨텍스트로 제공하는 생성형 AI 애플리케이션 패턴입니다.

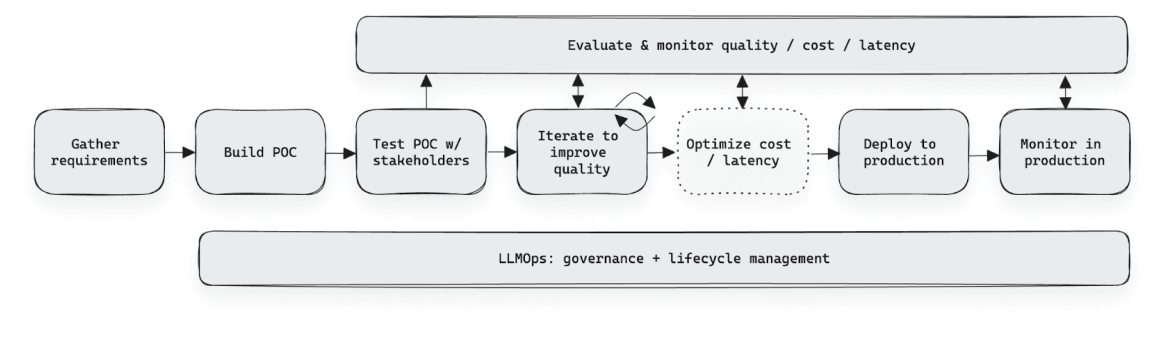

Mosaic AI 에이전트 프레임워크는 정확성, 안전성, 관리 여부가 일관되게 측정 및 평가되는 RAG를 활용하여 고품질의 생성형 AI 애플리케이션을 빌드하고 배포할 수 있도록 설계된 도구 모음입니다. Mosaic AI 에이전트 프레임워크를 사용하면 개발자는 RAG 애플리케이션의 품질을 손쉽게 평가하고, 가설을 테스트하는 반복 작업을 빠르게 수행하고, 애플리케이션을 간편하게 재배포할 수 있습니다. 또한, 적절한 거버넌스와 가드레일을 통해 안정적으로 유지할 수 있습니다.

최고의 프로덕션 품질

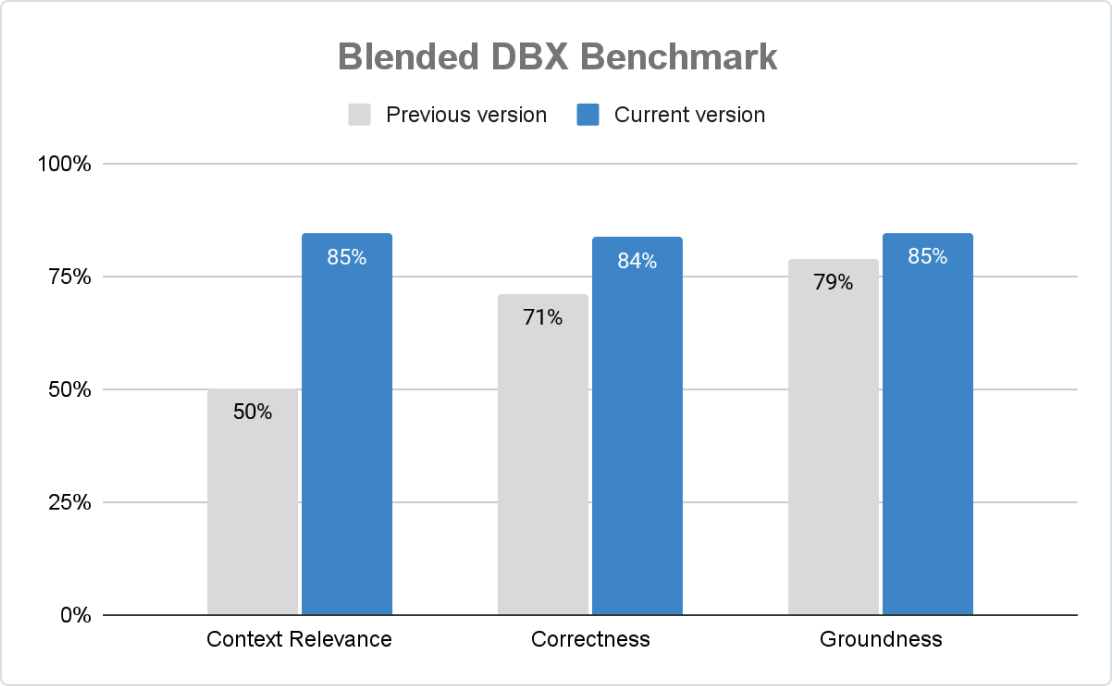

Agent Framework은 정확하고 안전하며 통제된 GenAI 애플리케이션을 대규모로 보장합니다. Mosaic AI Agent 평가를 통해 조직은 규칙 기반 검사, LLM 판사, 인간의 피드백으로 점수를 맞춤 설정할 수 있으며, 내장된 AI 지원 평가와 직관적인 UI는 지속적인 개선을 촉진합니다.

신속한 반복 개발 작업

Agent Framework은 피드백 수집과 평가를 간소화함으로써 GenAI 개발을 가속화합니다. Agent Evaluation Review App은 도메인 전문가가 평가하고, 라벨을 붙이고, 기준을 정의할 수 있게 해줍니다—스프레드시트나 맞춤 도구가 필요 없습니다. 구조화된 피드백은 팀이 성능을 개선하고, 정확성을 향상시키고, 코드 변경 없이 원활하게 재배포할 수 있도록 돕는 동시에 거버넌스와 보안을 보장합니다.

거버넌스 및 가드레일

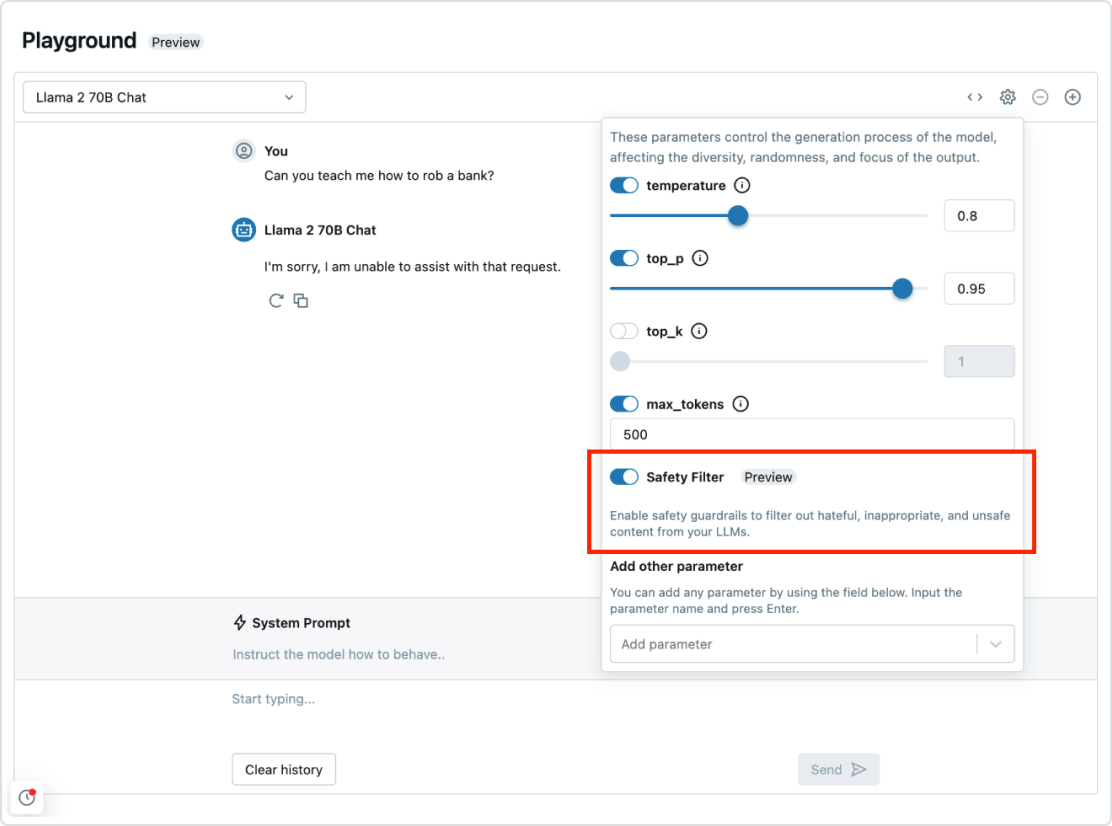

Mosaic AI 에이전트 프레임워크는 다른 Databricks 데이터 인텔리전스 플랫폼과 원활하게 통합됩니다. 즉, 보안 및 관리 체계부터 데이터 통합, 벡터 데이터베이스, 품질 평가 및 원클릭 최적화 배포에 이르기까지, 엔드투엔드 RAG 시스템을 배포하는 데 필요한 모든 것을 갖추고 있습니다. 거버넌스와 가드레일을 통합하여 애플리케이션의 유해한 응답이나 정책 위반을 사전에 방지할 수 있습니다.

모든 유형의 데이터에 대해 자동화된 실시간 파이프라인

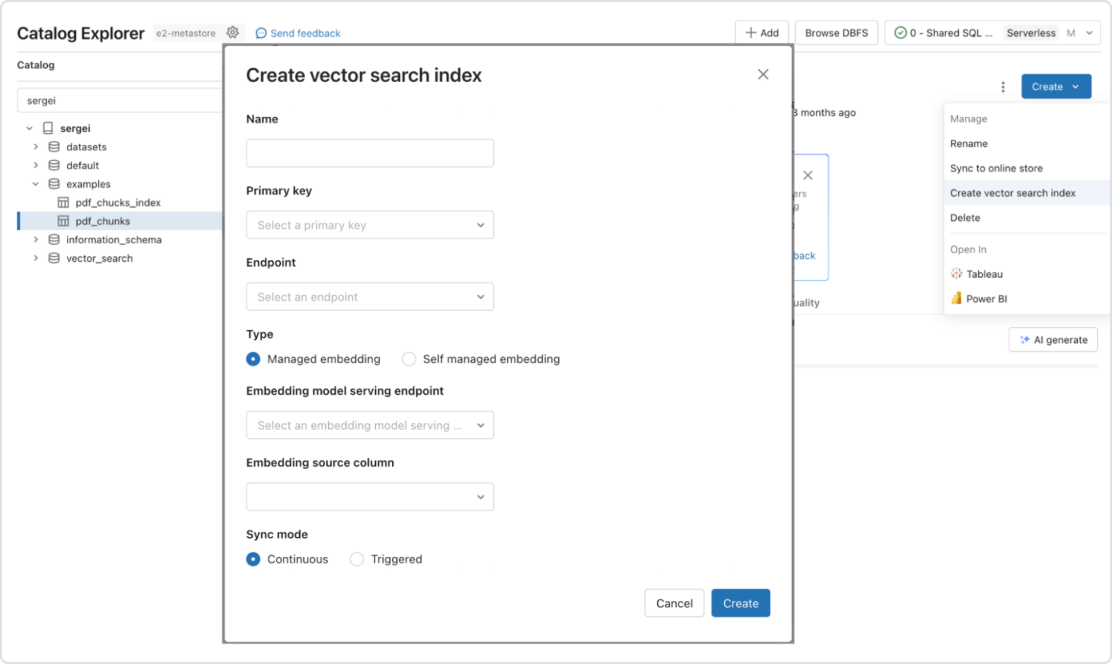

Mosaic AI는 기본적으로 온라인 검색을 위한 데이터 제공 및 색인화를 지원합니다. 비정형 데이터(텍스트, 이미지, 비디오)의 경우 Vector Search는 자동으로 데이터를 색인화하여 제공하므로 별도의 데이터 파이프라인을 생성할 필요 없이 RAG 애플리케이션에서 해당 데이터에 액세스할 수 있습니다. 내부적으로 Vector Search는 오류를 관리하고 재시도를 처리하며 배치 크기를 최적화하여 성능과 처리량을 극대화하고 비용을 대폭 절감합니다. 정형 데이터의 경우 특성 및 기능 제공을 통해 기업이 사용자 정보를 기반으로 맞춤 설정하기 위해 프롬프트에 삽입하는 사용자 또는 계정 데이터와 같은 상황별 데이터에 대한 밀리초 규모의 쿼리를 제공합니다.