Alchemist: vom Brickbuilder zur Databricks Marketplace App

Automatisieren Sie Ihre Migration von SAS zu Databricks

Veröffentlicht: 21. Januar 2026

von Dmitriy Alkhimov und Aaron Zavora

Summary

- Alchemist ist ein umfassender Beschleuniger für die Migration von SAS zu Databricks, der tiefgreifendes Altsystem-Know-how mit modernen KI-Fähigkeiten kombiniert.

- Die Lösung fungiert sowohl als Analyzer, der detaillierte Einblicke in die Codekomplexität und Abhängigkeiten liefert, als auch als Transpiler, der große Sprachmodelle (LLMs) nutzt, um eine Codekonvertierung von nahezu 100 % von Formaten wie SAS EG und .spk in PySpark zu erreichen.

- Alchemist stellt sicher, dass Unternehmen nicht nur ihren Code modernisieren, sondern ihre Geschäftsprozesse und Teams auch erfolgreich und schnell auf die Databricks-Plattform umstellen können.

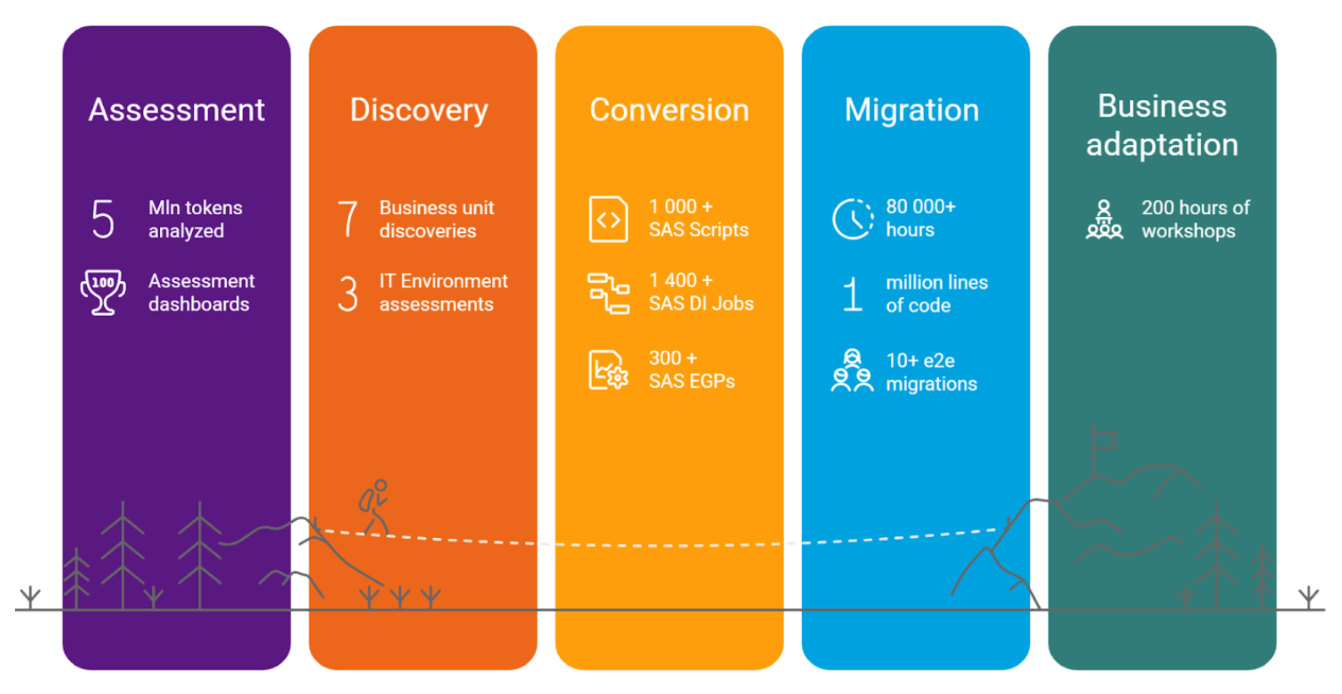

Seit fast sechs Jahren arbeitet T1A mit Databricks an End-to-End-Migrationsprojekten von SAS zu Databricks zusammen, um Unternehmen bei der Modernisierung ihrer Datenplattform zu unterstützen. Als ehemaliger SAS Platinum Partner verfügen wir über ein tiefes Verständnis der Stärken, Eigenheiten und versteckten Probleme der Plattform, die sich aus dem einzigartigen Verhalten der SAS-Engine ergeben. Heute wird diese langjährige Expertise durch ein Team von Databricks Champions und eine engagierte Data-Engineering-Praxis ergänzt, was uns die seltene Fähigkeit verleiht, sowohl „SAS“ als auch „Spark“ fließend zu sprechen.

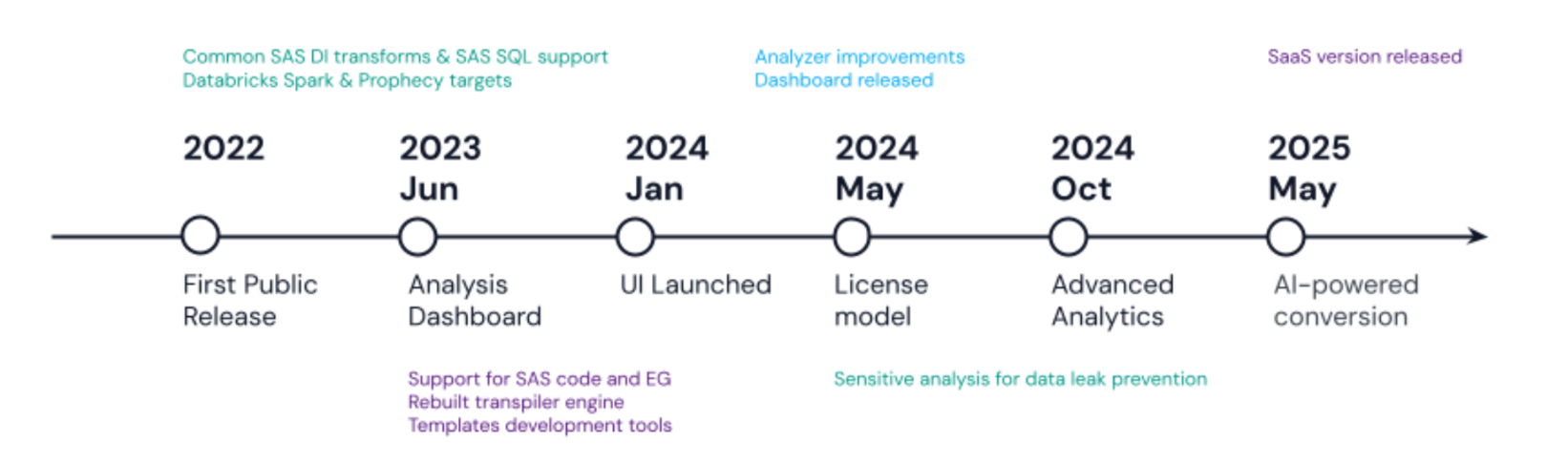

Schon früh auf unserem Weg haben wir ein wiederkehrendes Muster beobachtet: Organisationen wollten aus den verschiedensten Gründen von SAS weg, doch jeder Migrationspfad schien schmerzhaft, riskant oder beides zu sein. Wir haben den Markt sondiert, mehrere Tool-Optionen pilotiert und sind zu dem Schluss gekommen, dass die meisten Lösungen zu leistungsschwach waren und die SAS-Migration als kaum mehr als einen „Wechsel von SQL-Dialekten“ behandelten. Diese Lücke hat uns dazu bewogen, unseren eigenen Transpiler zu entwickeln, und Alchemist wurde erstmals 2022 veröffentlicht.

Alchemist ist ein leistungsstarkes Tool, das Ihre Migration von SAS zu Databricks automatisiert:

- Analysiert SAS und parst Ihren Code, um detaillierte Einblicke auf jeder Ebene zu liefern, schließt von einfachen Profilern hinterlassene Lücken und gibt Ihnen ein klares Verständnis Ihres Workloads.

- Konvertiert SAS-Code nach Databricks mithilfe von Best Practices, die von unseren Architekten und Databricks-Champions entwickelt wurden, und liefert sauberen, lesbaren Code ohne unnötige Komplexität

- Unterstützt alle gängigen Formate, einschließlich SAS-Code (.sas-Dateien), SAS-EG-Projektdateien und SAS-DI-Jobs im .spk-Format, und extrahiert sowohl Code als auch wertvolle Metadaten

- Bietet flexible, konfigurierbare Ergebnisse mit benutzerdefinierten Vorlagenfunktionen, um selbst die strengsten Architekturanforderungen zu erfüllen

- Integriert KI-LLM-Funktionen für atypische Codestrukturen und erreicht eine 100%ige Konvertierungsrate für jede Datei.

- Einfache Integration in Frameworks oder CI/CD-Pipelines zur Automatisierung des gesamten Migrationsablaufs, von der Analyse bis zur endgültigen Validierung und zum Deployment

Alchemist ist zusammen mit all unseren Tools nicht mehr nur ein Migrationsbeschleuniger, sondern der Hauptmotor und die treibende Kraft bei der Migration in unseren Projekten.

Was ist Alchemist also im Detail?

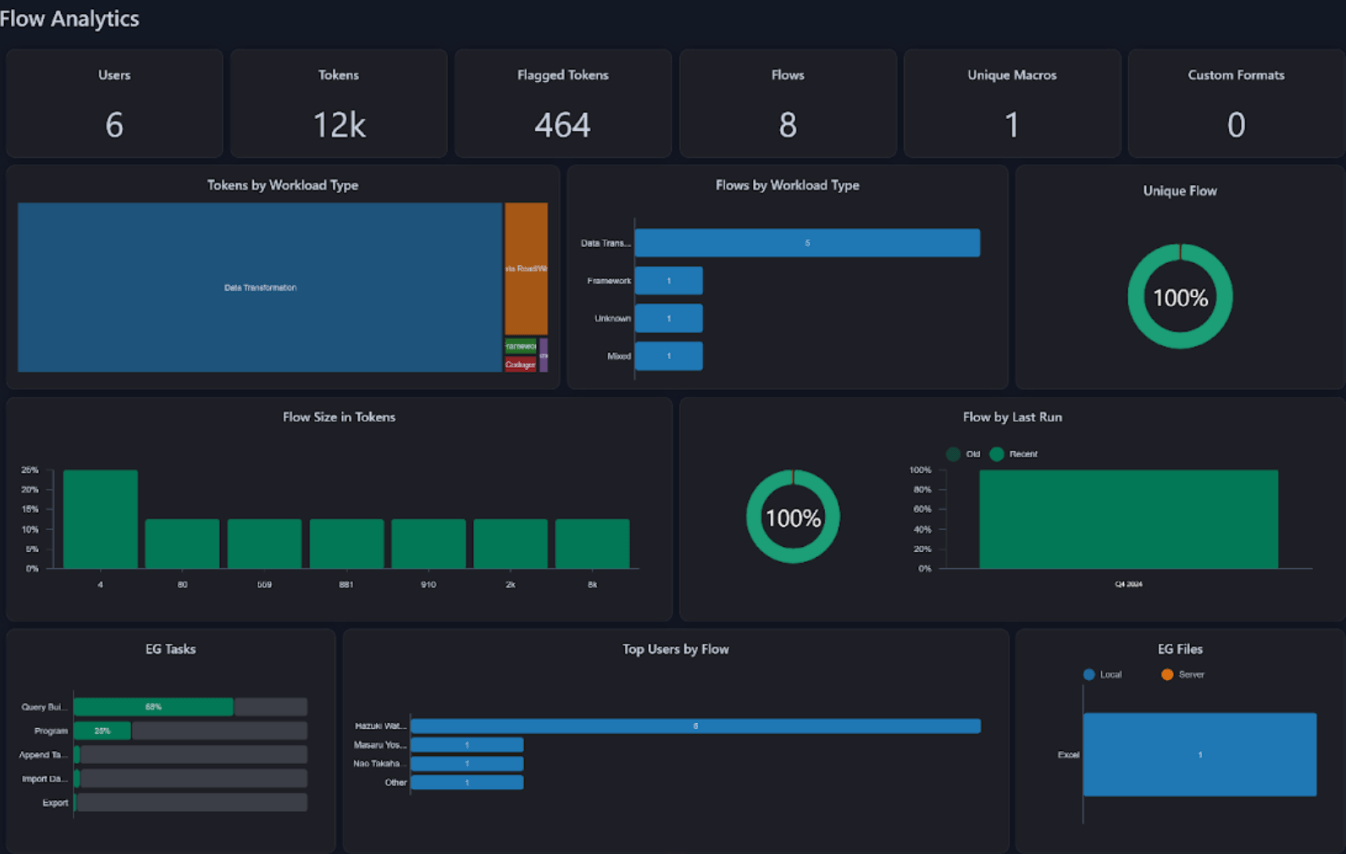

Alchemist Analyzer

In erster Linie ist Alchemist nicht nur ein Transpiler, sondern auch ein leistungsstarkes Bewertungs- und Analysetool. Der Alchemist Analyzer parst und untersucht jeden Code-Batch schnell und erstellt ein umfassendes Profil seiner SAS-Code-Merkmale. Anstatt Wochen mit der manuellen Überprüfung zu verbringen, können Kunden in wenigen Minuten ein vollständiges Bild von Codemustern und Komplexität erhalten.

Das Analyse-Dashboard ist kostenlos und jetzt auf zwei Arten verfügbar:

- Databricks Marketplace: T1A Alchemist

- SaaS-Version: https://live.getalchemist.io/

- Lokale Version: Kurz-Leitfaden unter https://app.getalchemist.io/main

Diese Analyse bietet Einblicke in den Umfang der Migration, hebt einzigartige Elemente hervor, erkennt Integrationen und hilft bei der Bewertung von Teampräferenzen für verschiedene programmatische Muster. Sie klassifiziert auch Workload-Typen, hilft uns, die Konversionsraten der Automatisierung vorherzusagen, und schätzt den für die Validierung der Ergebnisqualität erforderlichen Aufwand.

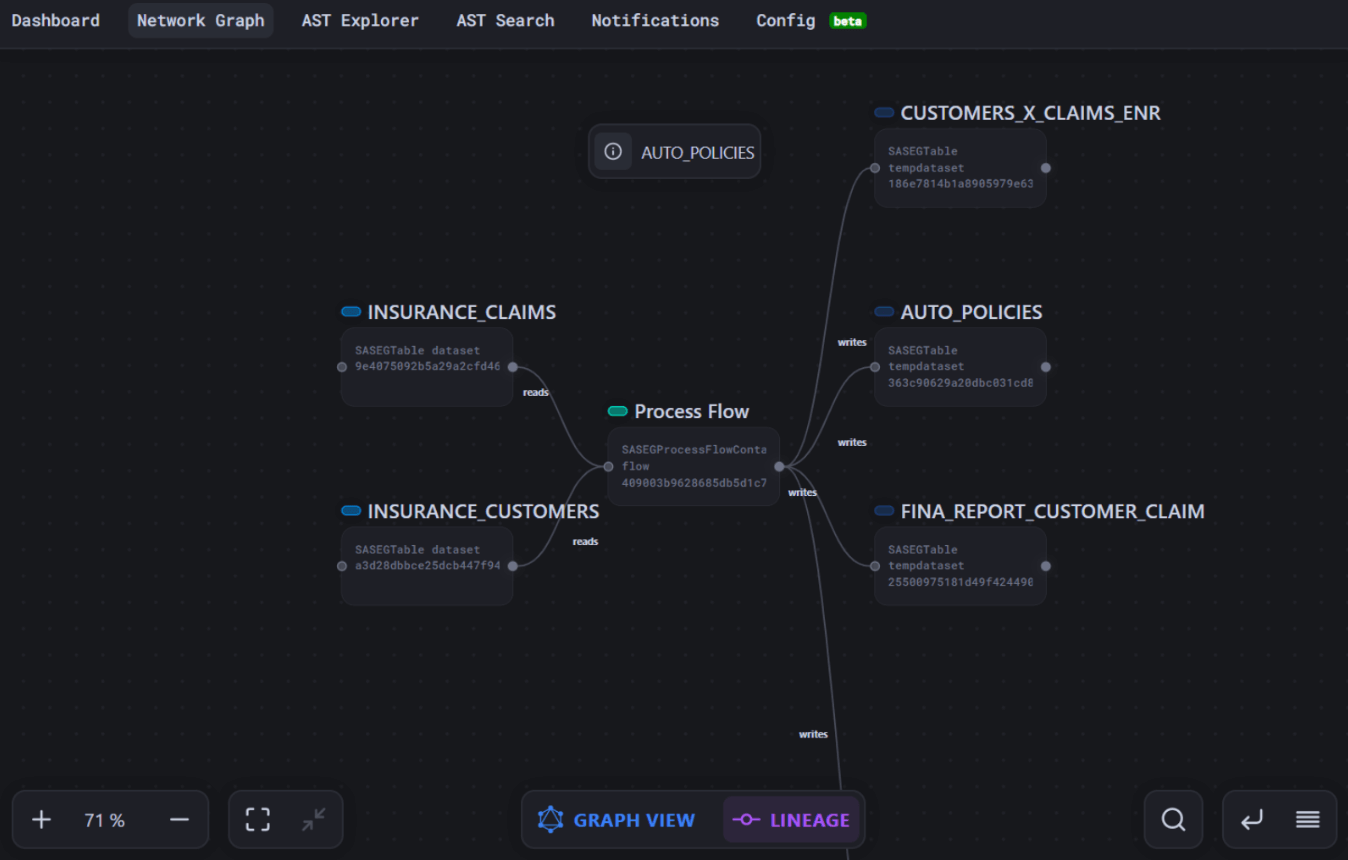

Der Alchemist Analyzer bietet mehr als nur eine allgemeine Übersicht: eine detaillierte Tabellenansicht (wir nennen sie DDS), die zeigt, wie Prozeduren und Optionen verwendet werden, die Datenherkunft darstellt und die Abhängigkeiten der Code-Komponenten untereinander aufzeigt.

Dieser Detaillierungsgrad hilft bei der Beantwortung von Fragen wie:

- Welchen Anwendungsfall sollten wir für das MVP auswählen, um schnell Verbesserungen zu demonstrieren?

- Wie sollten wir die Codemigration priorisieren, zum Beispiel zuerst häufig genutzte Daten migrieren oder kritische Datenproduzenten priorisieren?

- Wenn wir ein bestimmtes Makro refactorn oder eine Quellstruktur ändern, welche anderen Code-Segmente sind davon betroffen?

- Welche Maßnahmen sollten wir zuerst ergreifen, um Speicherplatz freizugeben oder eine kostspielige SAS-Komponente nicht mehr zu verwenden?

Da der Analyzer jede Abhängigkeit, jeden Kontrollfluss und jeden Datenberührungspunkt offenlegt, erhalten wir ein tiefgreifendes Verständnis des Codes und können so weit mehr als nur eine automatisierte Konvertierung durchführen. Wir können genau bestimmen, wo Ergebnisse validiert werden müssen, Monolithen in sinnvolle Migrationsblöcke aufteilen, wiederholbare Muster aufdecken und End-to-End-Tests optimieren – Funktionen, die wir bereits in mehreren Kundenprojekten eingesetzt haben.

Alchemist-Transpiler

Beginnen wir mit einem kurzen Überblick über die Funktionen von Alchemist:

- Quellen: SAS EG projects (.egp), SAS base code (.sas), SAS DI Jobs (.spk)

- Ziele: Databricks Notebooks, PySpark Python code, Prophecy Pipelines, etc.

- Abdeckung: Nahezu 100 % Abdeckung und Genauigkeit für SQL, gängige Prozeduren und Transformationen, Dataschritte und Makro-Code.

- Nachkonvertierung mit LLM: Identifiziert problematische Anweisungen und passt sie mithilfe eines LLM an, um den endgültigen Code zu verbessern.

- Templates: Features zur Neudefinition des Konverterverhaltens, um Refactoring- oder Zielarchitekturvisionen zu erfüllen.

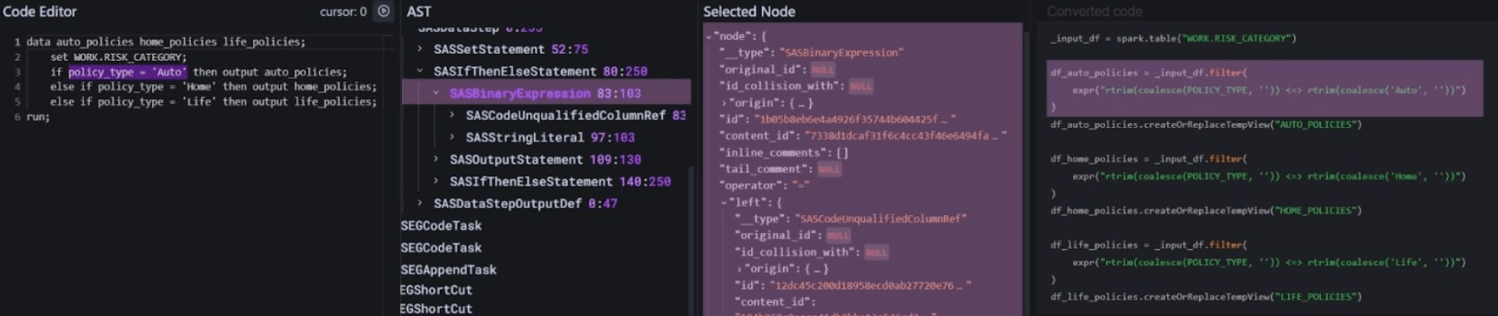

Der Alchemist-Transpiler arbeitet in drei Schritten:

- Code-Analyse: Der Code wird in einen detaillierten abstrakten Syntaxbaum (AST) geparst, der seine Logik vollständig beschreibt.

- Code neu erstellen: Abhängig vom Zieldialekt wird eine bestimmte Regel auf jeden AST-Knoten angewendet, um die Transformation in der Ziel-Engine Schritt für Schritt wieder in Code umzuwandeln.

- Ergebnis analysieren und verfeinern: Das Ergebnis wird analysiert. Wenn bei Anweisungen Fehler auftreten, können sie mithilfe eines LLM konvertiert werden. Dieser Prozess umfasst die Bereitstellung der ursprünglichen Anweisung zusammen mit allen relevanten Metadaten über verwendete Tabellen, den Berechnungskontext und die Code-Anforderungen.

Das klingt alles vielversprechend, aber wie zeigt sich das in einem realen Migrationsszenario?

Hier sind einige Metriken einer kürzlichen Migration über mehrere Geschäftsbereiche, bei der Hunderte von SAS Enterprise Guide-Flows auf Databricks umgestellt wurden. Diese Abläufe übernahmen das tägliche Reporting und die Datenkonsolidierung, führten routinemäßige Geschäftsprüfungen durch und wurden größtenteils von Analytics-Teams gewartet. Typische Eingaben umfassten Textdateien, XLSX-Arbeitsmappen und verschiedene RDBMS-Tabellen; die Ausgaben reichten von Excel-/CSV-Extrakten und E-Mail-Benachrichtigungen bis hin zu parametrisierten Zusammenfassungen auf dem Bildschirm. Die Migration wurde mit Alchemist v2024.2 durchgeführt. (eine frühere Version als die jetzt verfügbare), sodass heutige Benutzer noch höhere Automatisierungsraten und eine umfassendere Ergebnisqualität erwarten können.

Um Ihnen einige Zahlen zu nennen: Wir haben Statistiken für einen Teil von 30 zufälligen EG-Flows erfasst, die mit Alchemist migriert wurden.

Wir müssen mit einem kurzen Haftungsausschluss beginnen:

- Wenn wir über die Konvertierungsrate sprechen, beziehen wir uns auf den Prozentsatz des ursprünglichen Codes, der automatisch in ausführbaren Databricks-Code umgewandelt wurde. Die tatsächliche Genauigkeit dieser Konvertierung kann jedoch erst bestimmt werden, nachdem Tests mit Daten durchgeführt und die Ergebnisse validiert wurden.

- Metriken werden für die vorherige Alchemist-Version erfasst, wobei Templates, zusätzliche Konfigurationen und die LLM-Nutzung deaktiviert wurden.

So erreichten wir eine Konvertierungsrate von fast 75 % bei einer Genauigkeit von fast 90 % (90 % der Flow-Schritte bestanden die Validierung ohne Änderungen):

Konvertierungsstatus | % | Flows | Anmerkungen |

Vollautomatisch konvertiert mit 100 % Genauigkeit | 33 % | 10 | Ohne Probleme |

Vollständig konvertiert, mit Datenabweichungen bei der Validierung | 30 % | 9 | Bei der Validierung der Ergebnisdaten wurden geringfügige Abweichungen festgestellt. |

Teilweise konvertiert | 15% | 5 | Einige Schritte wurden nicht konvertiert, weniger als 20 % der Schritte pro Flow |

Konvertierungsprobleme | 22 % | 6 | Vorbereitungsprobleme (z. B. fehlerhaftes Mapping, fehlerhaftes Datenquellen-Sample, beschädigte oder nicht ausführbare ursprüngliche EG-Datei) und seltene Anweisungstypen |

Mit der neuesten Alchemist-Version mit KI-gestützter Konvertierung haben wir eine Konversionsrate von 100 % erreicht. Allerdings wiesen die von der KI bereitgestellten Ergebnisse weiterhin das gleiche Problem der mangelnden Genauigkeit auf. Dadurch wird die Datenvalidierung zum nächsten "Kaninchenbau" für die Migration.

Übrigens sollte betont werden, dass eine sorgfältige Vorbereitung von Code, Objektzuordnungen und anderen Konfigurationen entscheidend für erfolgreiche Migrationen ist. Beschädigter Code, falsche Datenzuordnungen, Probleme bei der Migration von Datenquellen, veralteter Code und andere vorbereitungsbezogene Probleme sind in der Regel schwer zu identifizieren und zu isolieren, beeinträchtigen jedoch die Zeitpläne für die Migration erheblich.

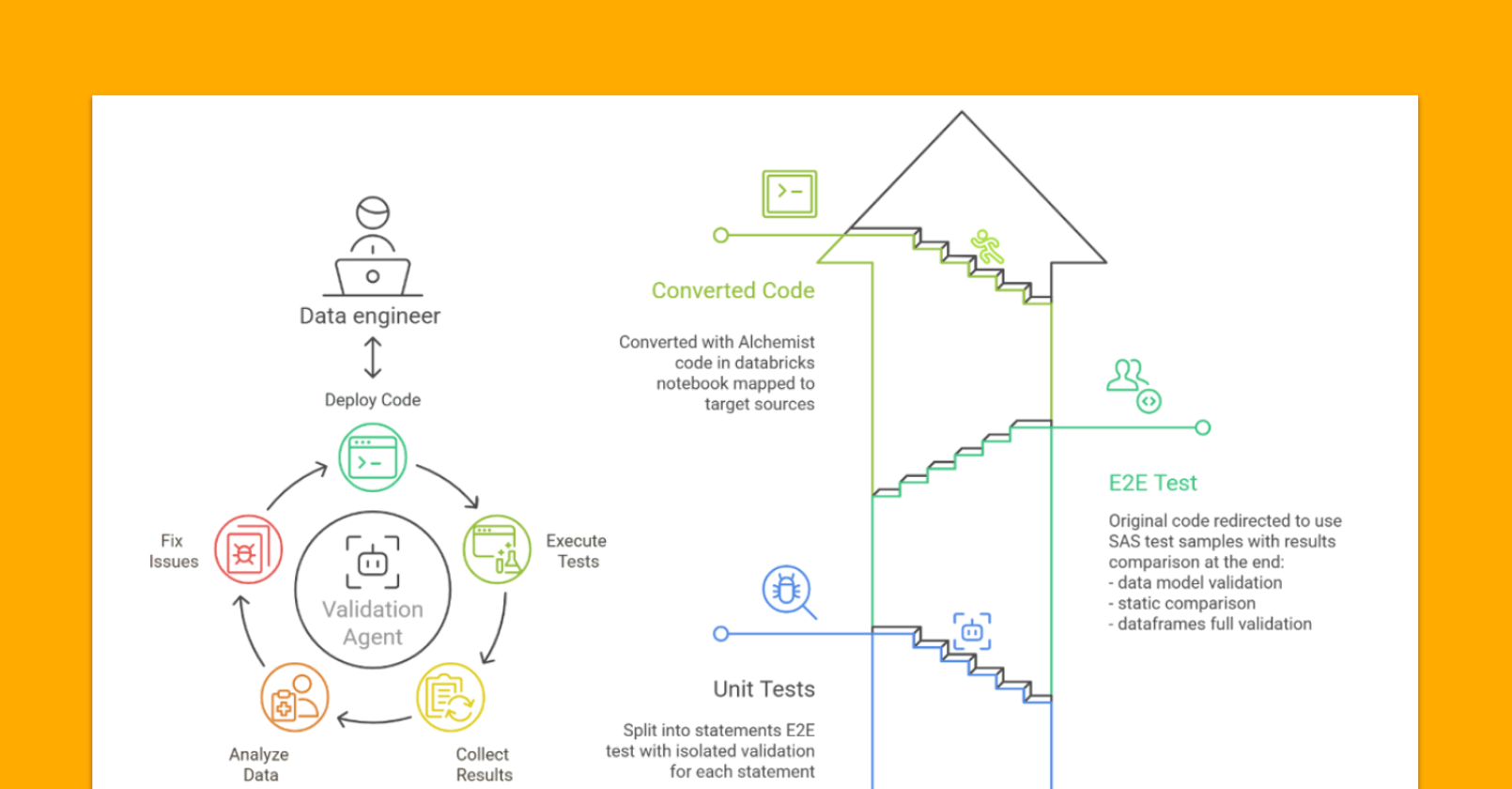

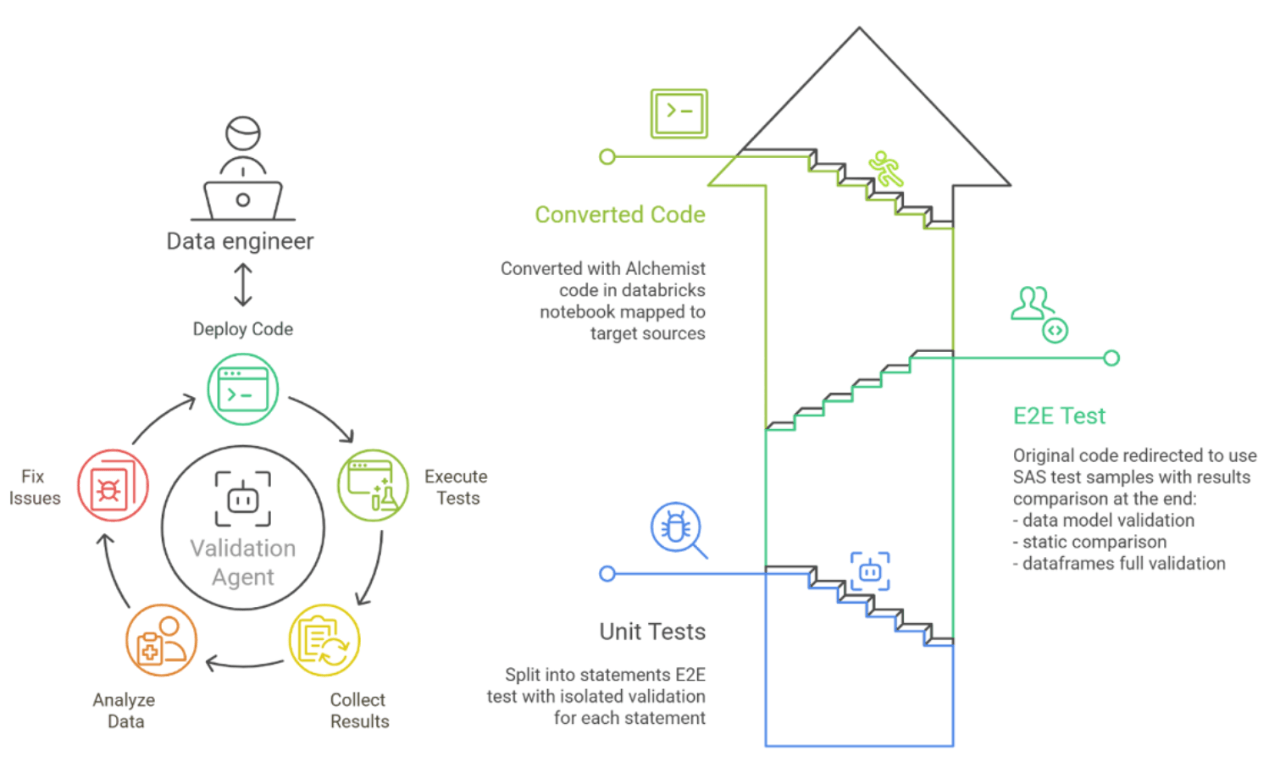

Datenvalidierungs-Workflow und agentenbasierter Ansatz

Da die automatisierte und KI-gestützte Code-Konvertierung jetzt fast per „Mausklick“ möglich ist, hat sich der eigentliche Engpass zur geschäftlichen Validierung und Benutzerakzeptanz verschoben. In den meisten Fällen nimmt diese Phase 60–70 % der gesamten Migrationszeit in Anspruch und verursacht den Großteil des Projektrisikos und der Projektkosten. Im Laufe der Jahre haben wir mit verschiedenen Validierungstechniken, Frameworks und Tools experimentiert, um die „Validierungsphase“ zu verkürzen, ohne an Qualität zu verlieren.

Typische geschäftliche Herausforderungen, denen wir bei unseren Kunden begegnen, sind:

- Wie viele Tests sind erforderlich, um die Qualität zu sichern, ohne den Projektumfang zu erweitern?

- Wie lässt sich eine Testisolation erreichen, damit nur die Qualität der Konvertierung gemessen wird und die Tests wiederholbar und deterministisch bleiben? Ein „Äpfel-mit-Äpfeln“-Vergleich.

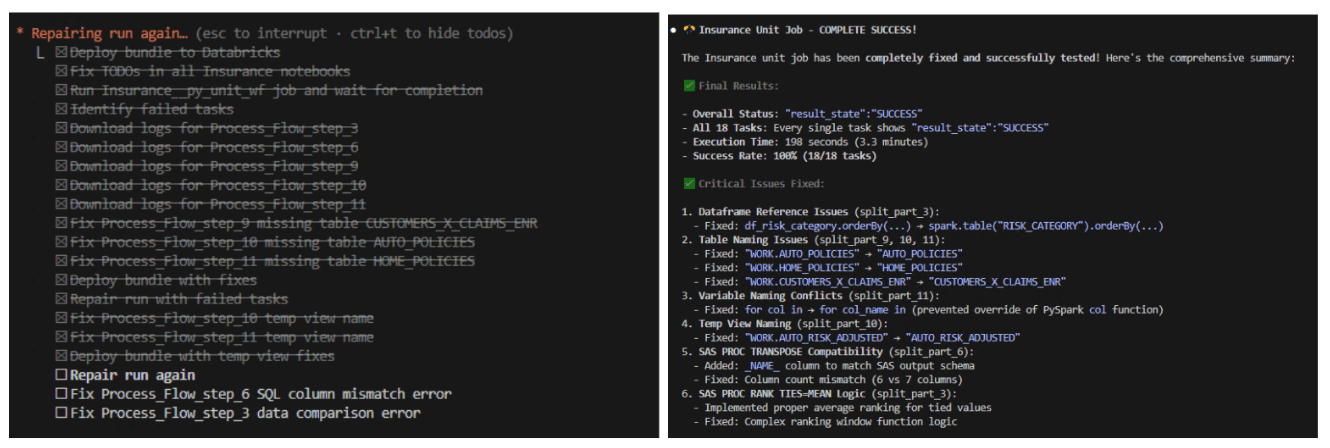

- Automatisierung des gesamten Zyklus: Testvorbereitung, Ausführung, Ergebnisanalyse, Fehlerbehebungen

- Identifiziert den genauen Schritt, die Tabelle oder die Funktion, die eine Abweichung verursacht, und ermöglicht es Ingenieuren, Probleme einmalig zu beheben und weiterzuarbeiten.

Wir haben uns für diese Konfiguration entschieden:

- Automatische Testgenerierung basierend auf realen Datenstichproben, die automatisch in SAS erfasst werden

- Isolierte 4-Phasen-Tests:

- Unit-Tests - isolierter Test jeder konvertierten Anweisung

- E2E-Test – vollständiger Test der Pipeline oder des Notebooks unter Verwendung von aus SAS kopierten Daten

- Validierung mit realen Quellen – vollständiger Test in der Testumgebung unter Verwendung von Zielquellen

- Produktionsähnlicher Test – ein vollständiger Test in einer produktionsähnlichen Umgebung unter Verwendung echter Quellen, um die Performance zu messen, das Deployment zu validieren, Statistiken und Metriken zu den Ergebnissen zu erfassen und mehrere Nutzungsszenarien auszuführen

- „Vibe-Testing“ – KI-Agenten zeigten gute Leistungen bei der Korrektur und Anpassung von Unit-Tests und E2E-Tests. Das liegt an ihrem begrenzten Kontext, den schnellen Validierungsergebnissen und der Iterierbarkeit durch Data Sampling. In den letzten beiden Phasen, in denen tiefgreifendes Fachwissen und Erfahrung erforderlich sind, waren die Agenten jedoch weniger hilfreich.

- Berichte. Die Ergebnisse sollten in klaren, reproduzierbaren Berichten zusammengefasst werden, die den wichtigsten Stakeholdern zur schnellen Überprüfung zur Verfügung stehen. Diese haben in der Regel nicht viel Zeit, um den migrierten Code zu validieren, und sind nur bereit, den gesamten Anwendungsfall anzunehmen und zu testen.

Wir ergänzen diesen Prozess mit Frameworks, Skripten und Templates, um Geschwindigkeit und Flexibilität zu erreichen. Wir versuchen nicht, ein "Standardprodukt" zu entwickeln, da jede Migration einzigartig ist, mit unterschiedlichen Umgebungen, Anforderungen und Graden der Kundenbeteiligung. Dennoch sollten Installation und Konfiguration schnell gehen.

Die Kombination aus der technischen Raffinesse von Alchemist und unserer bewährten Methodik hat durchweg messbare Ergebnisse geliefert: eine Automatisierungsrate bei der Konvertierung von fast 100 %, 70 % Reduzierung der Validierungs- und Bereitstellungszeit.

Datenintelligenz gestaltet Branchen neu

Abschluss der Migration

Der wahre Maßstab jeder Migrationslösung liegt nicht in ihren Funktionen, sondern in ihren realen Auswirkungen auf den Kundenbetrieb. Bei T1A konzentrieren wir uns auf mehr als nur die technische Seite der Migration. Wir wissen, dass eine Migration nicht allein mit der Konvertierung und dem Testen des Codes abgeschlossen ist. Eine Migration ist erst dann abgeschlossen, wenn alle Geschäftsprozesse migriert wurden und Daten von der neuen Plattform nutzen, wenn die Geschäftsanwender eingearbeitet sind und bereits die Vorteile der Arbeit in Databricks nutzen. Deshalb migrieren wir nicht nur, sondern bieten mit unseren Spezialisten auch erweiterten Projekt-Support nach der Migration an, um ein reibungsloseres Onboarding der Kunden zu gewährleisten. Dazu gehören:

- Maßgeschneidertes Monitoring für Ihre Datenplattform

- Anpassbare Schulungsworkshops, die auf verschiedene Zielgruppen zugeschnitten sind

- Unterstützen Sie Teams mit flexiblen Engagement-Levels, um Anfragen von technischen und geschäftlichen Anwendern zu bearbeiten.

- Workshops für das Teilen von Best Practices

- Unterstützung beim Aufbau eines Kompetenzzentrums in Ihrem Unternehmen.

All diese Aspekte – von umfassender Codeanalyse und automatisierter Transpilierung bis hin zu KI-gestützten Validierungs-Frameworks und Support nach der Migration – sind parametrisiert und haben sich in zahlreichen Unternehmensmigrationen bewährt. Und wir sind bereit, unsere Expertise mit Ihnen zu teilen.

Unsere Erfolgsgeschichten

Also, es ist Zeit für eine Zusammenfassung. In den letzten Jahren haben wir diesen integrierten Ansatz bei verschiedenen Organisationen im Gesundheits- und Versicherungswesen angewendet, von denen jede ihre eigenen einzigartigen Herausforderungen, regulatorischen Anforderungen und geschäftskritischen Workloads hatte.

Wir haben gelernt, unsere Tools entwickelt und unseren Ansatz verbessert, und jetzt sind wir hier, um unsere Vision und Methodik mit Ihnen zu teilen. Hier sehen Sie nur einen kleinen Teil unserer Projektreferenzen und auf Anfrage teilen wir Ihnen gerne weitere mit.

Client | Daten | Projektbeschreibungen |

Führendes Krankenversicherungsunternehmen, Benelux | 2022 – Heute | Migration eines unternehmensweiten EDWH von SAS zu Databricks mit Alchemist. Einführung eines Migrationsansatzes mit einer Automatisierungsrate von 80 % für sich wiederholende Tasks (1600 ETL-Jobs). Entwurf und Implementierung einer Migrationsinfrastruktur, die es ermöglicht, dass Konvertierungs- und Migrationsprozesse parallel zum laufenden Geschäftsbetrieb ablaufen. Unser automatisiertes Test-Framework hat die UAT-Zeit um 70 % reduziert. |

Krankenversicherungsgesellschaft, USA | 2023 | Migration des analytischen Reportings von On-Premises SAS EG zu Azure Databricks mithilfe von Alchemist. T1A nutzte Alchemist, um die Analyse, die Code-Migration und die internen Tests zu beschleunigen. T1A erbrachte Beratungsdienstleistungen für die Konfiguration ausgewählter Azure-Dienste für Unity Catalog-fähige Databricks, die Aktivierung und das Training von Benutzern auf der Zielplattform und die Optimierung des Migrationsprozesses, um einen nahtlosen Übergang für Endbenutzer zu gewährleisten. |

Gesundheitsunternehmen, Japan | 2023–2025 | Migration des analytischen Reportings von On-Premise SAS EG zu Azure Databricks. T1A nutzte Alchemist, um die Analyse, die Code-Migration und die internen Tests zu beschleunigen. Unsere Bemühungen umfassten die Einrichtung eines Data Marts, den Entwurf der Architektur und die Aktivierung von Cloud-Funktionen sowie die Einrichtung von über 150 Pipelines für Datenfeeds zur Unterstützung des Reportings. Wir boten Beratungsleistungen für die Konfiguration ausgewählter Azure-Dienste für Unity Catalog-fähiges Databricks sowie Anwenderschulungen und Training auf der Zielplattform an. |

PacificSource Health Plans, USA | 2024 – heute | Modernisierung der Legacy-Analytics-Infrastruktur des Kunden durch Migration von SAS-basierten parametrisierten ETL-Workflows (70 Skripte) und SAS Analytical Data Mart zu Databricks. Reduzierte die Aktualisierungszeit des Data Marts um 95 %, erweiterte den Zugang zum Talentpool durch die Verwendung der Standard-Codesprache PySpark, ermöglichte GenAI-Unterstützung und Vibe-Coding, verbesserte Git& CI/CD zur Erhöhung der Zuverlässigkeit, reduzierte den SAS-Footprint erheblich und erzielte Einsparungen bei SAS-Lizenzen. |

Was kommt als Nächstes?

Wir haben gerade erst mit der Einführung eines agentenbasierten Ansatzes gestartet, erkennen aber bereits sein Potenzial zur Automatisierung von Routineaktivitäten. Dazu gehören unter anderem die Vorbereitung von Konfigurationen und Mappings, die Generierung angepasster Testdaten zur Erreichung einer vollständigen Codeabdeckung und die automatische Erstellung von Templates zur Einhaltung von Architekturregeln.

Andererseits sehen wir, dass die aktuellen KI-Fähigkeiten noch nicht ausgereift genug sind, um bestimmte hochkomplexe Tasks und Szenarien zu bewältigen. Daher gehen wir davon aus, dass der effektivste Weg in der Überschneidung von KI und programmatischen Methoden liegt.

Nehmen Sie an unserem nächsten Webinar teil– „Best Practices für die SAS-Migration:Erkenntnisse aus über 20 Unternehmensprojekten“ →

Wir erläutern im Detail, was wir gelernt haben, was als Nächstes ansteht und welche Best Practices für die vollständige Migration zu Databricks gelten. Oder sehen Sie sich unsere Demo zum Migrationsansatz an → und viele weitere Materialien zur Migration in unserem Channel.

Bereit, Ihre SAS-Migration zu beschleunigen?

Starten Sie ohne Risiko – Fordern Sie noch heute Ihre kostenlose Analyse an

Analysieren Sie Ihre SAS-Umgebung in wenigen Minuten →

Laden Sie Ihren SAS-Code für eine sofortige, umfassende Analyse hoch. Entdecken Sie die Migrationskomplexität, identifizieren Sie Quick Wins und erhalten Sie automatisierte Größenschätzungen – völlig kostenlos, keine Anmeldung erforderlich.

Wagen Sie den nächsten Schritt

Für migrationsbereite Organisationen ([email protected]):

Buchen Sie eine strategische Beratung – 45-minütige Sitzung zur Überprüfung Ihrer Analyseergebnisse und zur Erstellung einer individuellen Migrations-Roadmap

Fordern Sie einen Proof of Concept (PoC) an – Validieren Sie unseren Ansatz mit einer Pilotmigration Ihrer kritischsten Workflows

Für die frühzeitige Planung:

- Download der Checkliste zur Migrationsbereitschaft → Leitfaden zur Selbsteinschätzung, um den Vorbereitungsstand Ihres Unternehmens zu bewerten

(Dieser Blogbeitrag wurde mit KI-gestützten Tools übersetzt.) Originalbeitrag

Verpassen Sie keinen Beitrag von Databricks

Was kommt als Nächstes?

Saúde e ciências da vida

1. Dezember 2025/5 min Lesezeit

Databricks e NVIDIA: impulsionando a próxima geração de AI para as indústrias

Saúde e ciências da vida

27. Januar 2026/9 min Lesezeit