C'est le moment de faire le point sur votre relation avec Hadoop

Les entreprises ayant été contraintes de s'adapter au télétravail et à des équipes distribuées au cours de l'année écoulée, l'adoption du cloud s'est accélérée à un rythme sans précédent de +14 %, soit 2 % ou 13 milliards de dollars de plus que les prévisions pré-pandémiques pour 2020, avec potentiellement plus de 600 milliards de dollars de migrations on-prem vers le cloud dans les prochaines années. Cette transition vers le cloud accorde une importance croissante à une nouvelle génération de plateformes de données et d'analytique pour stimuler l'innovation et mettre en œuvre les stratégies de transformation digital des entreprises. Cependant, de nombreuses organisations peinent encore avec la complexité, l'infrastructure non évolutive et les lourdes charges de maintenance de leurs environnements Hadoop existants. Elles finissent par sacrifier la valeur de leurs données et, par conséquent, risquent de perdre leur avantage concurrentiel. Pour relever ce défi et exploiter davantage d'opportunités (parfois cachées) dans leurs données, les organisations se tournent vers des plateformes de données et d'analytique cloud ouvertes, simples et collaboratives comme la Databricks Lakehouse Platform. Dans ce blog, vous découvrirez les défis qui poussent les organisations à explorer des solutions cloud modernes et le rôle que joue l'architecture lakehouse pour stimuler la prochaine vague d'innovations data-driven.

Les promesses non tenues de Hadoop

Le système de fichiers distribués d'Hadoop (HDFS) était une technologie révolutionnaire lors de son lancement et restera une icône dans les annales de l'histoire des données. Grâce à son avènement, les organisations n'étaient plus limitées par les contraintes des bases de données relationnelles, et cela a donné naissance au stockage Big Data moderne et finalement aux data lakes dans le cloud. Malgré tout le battage médiatique qui a précédé 2015, Hadoop peinait à exploiter le potentiel évolutif de tous les types de données, en particulier à l'échelle de l'entreprise. Finalement, à mesure que le paysage des données et les besoins métiers qui l'accompagnent ont évolué, Hadoop a eu du mal à continuer à tenir ses promesses. Par conséquent, les entreprises ont commencé à explorer des alternatives basées sur le cloud et le taux de migration de Hadoop vers le cloud ne fait qu'augmenter.

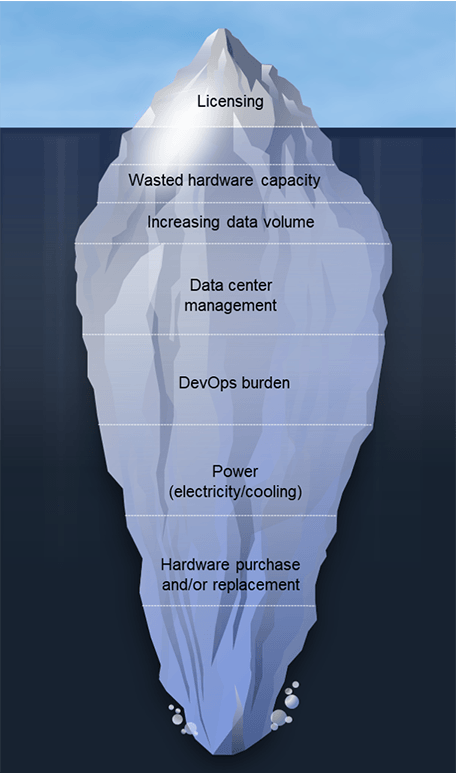

Les équipes migrent depuis Hadoop pour diverses raisons ; il s'agit souvent d'une combinaison de facteurs de « push » et de « pull ». Les limitations des systèmes Hadoop existants et les coûts élevés de licence et d'administration poussent les équipes à explorer des alternatives. Elles sont également attirées par les nouvelles possibilités offertes par les architectures de données cloud modernes. Bien que les exigences en matière d'architecture varient d'une organisation à l'autre, nous observons plusieurs facteurs communs qui amènent les clients à réaliser qu'il est temps de start à dire au revoir. selon les besoins :

- Capacité matérielle gaspillée : la surcapacité est une évidence dans les implémentations on-premise, car elle permet de monter en charge pour vos besoins de pointe. Le résultat est qu'une grande partie de cette capacité reste inactive, mais continue d'alourdir les coûts opérationnels et de maintenance.

- Les coûts de mise à l'échelle augmentent rapidement : le découplage du stockage et du compute n'est pas possible dans un environnement Hadoop on-premise, les coûts augmentent donc avec les ensembles de données. Ajoutez à cela la numérisation rapide résultant de la pandémie de COVID-19 et le taux de croissance mondial. Les recherches indiquent que la quantité totale de données créées, capturées, copiées et consommées dans le monde devrait augmenter de 152,5 % entre 2020 et 2024 pour atteindre 149 zettaoctets. Dans un monde où les données connaissent une croissance exponentielle, les coûts peuvent rapidement s'envoler.

- Charge DevOps: d'après l'expérience de nos clients, vous pouvez compter entre 4 et 8 employés à temps plein pour 100 nœuds.

- Augmentation des coûts énergétiques : attendez-vous à payer jusqu'à 800 $ par serveur et par an en fonction de la consommation et du refroidissement. Cela représente 80 000 $ par an pour un cluster Hadoop de 100 nœuds !

- Coûts du matériel neuf et de remplacement : cela représente environ 20 % du TCO, ce qui équivaut aux coûts d'administration des clusters Hadoop.

- Mises à niveau des versions logicielles : ces mises à niveau sont souvent obligatoires pour conserver le contrat de support. Ces projets durent des mois, n'apportent que peu de nouvelles fonctionnalités et mobilisent la précieuse bande passante des équipes de données.

Outre l'ensemble des défis mentionnés ci-dessus, la viabilité à long terme de Hadoop suscite une réelle inquiétude. En 2019, le monde a assisté à un bouleversement massif au sein de la sphère Hadoop. Google, dont l' article fondateur de 2004 sur MapReduce a servi de base à la création d'Apache Hadoop, a complètement cessé d'utiliser MapReduce, comme l'a tweeté Urs Hölzle, SVP de l'infrastructure technique de Google. Il y a également eu des fusions et acquisitions très médiatisées dans le monde de Hadoop. En outre, en 2020, l'un des principaux fournisseurs Hadoop a réorienté sa gamme de produits pour qu'elle ne soit plus centrée sur Hadoop, car Hadoop est désormais considéré comme « plus une philosophie qu'une technologie ». Enfin, en 2021, l'Apache Software Foundation a annoncé le retrait de dix projets de l'écosystème Hadoop. Cet ensemble croissant de préoccupations, combiné au besoin accéléré de transformation numérique, a encouragé de nombreuses entreprises à réévaluer leur relation avec Hadoop.

Gartner® : Databricks, leader des bases de données cloud

La transition vers l'architecture lakehouse

Une architecture lakehouse est l'architecture de données idéale pour les organisations data-driven. Il combine les meilleures qualités des data warehouse et des data lake pour fournir une solution unique et hautement performante pour toutes les charges de travail liées aux données. L'architecture lakehouse prend en charge divers cas d'usage, tels que l'analytique des données en streaming, la BI, la science des données et l'IA. Pourquoi les clients aiment-ils la Databricks Lakehouse Platform ?

- C'est simple. Unifiez vos données, votre analytique

et votre IA sur une seule plateforme - Elle est ouverte. Unifiez votre écosystème de données avec des standards et des formats ouverts.

- Elle est collaborative. Unifiez vos équipes data pour collaborer sur l'ensemble des workflows de données et d'IA

Une architecture lakehouse peut apporter des gains significatifs par rapport aux environnements Hadoop traditionnels, qui « attirent » les entreprises vers l'adoption du cloud. Cela inclut également les clients qui ont essayé d'utiliser Hadoop dans le cloud, mais qui n'obtiennent pas les résultats escomptés ou souhaités. Comme l'explique R. Tyler Croy, directeur de l'ingénierie des données chez Scribd, « Databricks promettait une optimisation de 30 à 50 % pour la plupart des charges de travail Apache Spark™ traditionnelles. Par curiosité, j'ai remanié mon modèle de coûts pour tenir compte du prix de Databricks et des optimisations potentielles des tâches Spark. Après avoir ajusté les chiffres, j'ai découvert qu'avec un taux d'optimisation de 17 %, Databricks réduirait tellement les coûts de notre infrastructure Amazon Web Services (AWS) qu'il couvrirait le coût de la plateforme Databricks elle-même. Après notre première évaluation, j'étais déjà convaincu par les fonctionnalités et les améliorations de la vélocité des développeurs que Databricks offrirait. Lorsque j'ai fait les calculs dans mon modèle, j'ai compris que je ne pouvais pas me permettre de ne pas adopter Databricks ! »

Scribd n'est pas un cas isolé ; parmi les autres clients qui ont migré de Hadoop vers la Databricks Lakehouse Platform figurent :

- H&M traite chaque jour des volumes massifs de données provenant de plus de 5 000 magasins sur plus de 70 marchés et de millions de clients. Leur architecture basée sur Hadoop a créé des difficultés pour les données. Elle est devenue gourmande en Ressources et coûteuse à monter en charge, a posé des problèmes de sécurité des données, a eu du mal à faire monter en charge les Opérations pour soutenir les initiatives de Data Science issues de diverses sources de données en silo, et a ralenti la mise sur le marché en raison de retards DevOps importants. Il fallait parfois une année entière pour passer de l'idée à l'aboutissement du produit. Avec Databricks, H&M bénéficie d'une efficacité opérationnelle améliorée en réduisant les coûts d'exploitation de 70 %, en améliorant la collaboration inter-équipes et en augmentant l'impact commercial grâce à un délai d'obtention d'insights plus rapide.

- Viacom18 doit traiter des téraoctets de données quotidiennes sur les téléspectateurs afin d'optimiser la programmation Leur data lake Hadoop on-premise n'était pas en mesure de traiter 90 jours de données glissantes au sein des SLA, limitant ainsi leur capacité à répondre aux besoins de l'entreprise Avec Databricks, ils ont considérablement réduit les coûts grâce à des temps de requête plus rapides et moins de DevOps, malgré l'augmentation des volumes de données. Amélioration de la productivité de l'équipe de 26 % grâce à une plateforme entièrement managée qui prend en charge l'ETL, l'analytique et le ML à grande échelle

- Reckitt Benckiser Group (RB) a été confronté à la complexité de la prévision de la demande pour 500 000 magasins. Ils traitent chaque jour plus de 2 TO de données sur 250 pipelines L'infrastructure Hadoop existante s'est avérée complexe, lourde, coûteuse à monter en charge et peu performante. Avec Databricks, RB a obtenu une capacité 10 fois supérieure pour prendre en charge le volume d'activité, une compression des données de 98 % (passant de 80 To à 2 To), réduisant ainsi les coûts opérationnels, et des performances de pipeline de données 2 fois plus rapides pour les Jobs 24h/24 et 7j/7.

Hadoop n'a jamais été conçu pour fonctionner dans des environnements cloud. Bien que les services Hadoop basés sur le cloud apportent des améliorations progressives par rapport à leurs équivalents on-premise, les deux restent à la traîne par rapport à l'architecture lakehouse. Les deux types d'instances Hadoop se caractérisent par de faibles performances, une faible productivité, des coûts élevés et leur incapacité à traiter des cas d'utilisation des données plus sophistiqués à grande échelle.

Pérenniser vos données, votre analytique et votre croissance basée sur l'IA

Les décisions de migration vers le cloud sont des décisions métier. Elles obligent les entreprises à examiner de près la réalité des performances de leurs systèmes actuels et à évaluer ce dont elles ont besoin pour atteindre leurs objectifs à court et à long terme. Alors que les investissements dans l'IA continuent de prendre de l'ampleur, les responsables des données, de l'analytique et de la technologie doivent jouer un rôle essentiel en pensant au-delà de l'architecture Hadoop existante et en se posant la question : « Cela nous mènera-t-il là où nous devons aller ? »

Une fois les objectifs clairement définis, il faut s'attarder sur les détails techniques essentiels, tels que le mappage de la Technologie, l'évaluation de l'utilisation des Ressources cloud et du rapport coût/performance, ainsi que la structuration d'un projet de migration qui minimise les erreurs et les risques. Mais plus important encore, vous devez avoir la conviction, data-driven, qu'il est temps de réévaluer votre relation avec Hadoop. Apprenez-en plus sur la façon dont la migration depuis Hadoop peut accélérer les résultats métier pour tous vos cas d'utilisation des données.

1. Source : Gartner Market Databook, Goldman Sachs Global Investment Research

(Cet article de blog a été traduit à l'aide d'outils basés sur l'intelligence artificielle) Article original

Ne manquez jamais un article Databricks

Et ensuite ?

Líder de dados

16 octobre 2025/8 min de lecture

Como a 7-Eleven, Inc. Criação de um assistente criativo de GenAI revolucionário para marketing com o Mosaic AI

Líder de dados

6 novembre 2025/8 min de lecture